大数据技术与国际舆情研判

聂书江

国际舆情研判是指对国际舆论场中的舆情进行价值和趋势的一种分析与判断过程,主要由两部分构成:一是对国际舆论场中舆情进行日常性、持续性的跟踪、收集,形成舆情库,进而提出报告;二是针对具体的国际危机或议题的舆情进行针对性研判,形成报告。前者具有系统性、稳定性和长期性,后者具有临时性、突发性和专题性特征。

国际舆情研判是否准确不但影响国际危机管理的水平,而且也影响国家决策的制定与执行,在国际危机管理的过程中具有非常重要的作用。国际危机公关坚持“决策未出,研判先行”就是对国际舆情研判的生动说明。而在传统意义上,国际舆情研判主要是通过人工浏览、文档精选或案例库比对等方法,不过,这些方法能够奏效的一个前提是数据库的可控性或者数据体量的可计算性。但是,在大数据时代,信息体量的几何指数级增加意味着建立在可控假设的舆情研判方法难以解决大数据舆情状况,因此,如何在大数据时代提升国际舆情的研判质量就成为学界和业界思考的问题。

一、大数据时代传统舆情研判的不足

20世纪90年代,面对纷繁复杂的国际舆论场,为了保证政策执行的准确性,我国国际舆情研判得到长足发展,当时采取的主要手段是人海浏览法,即,通过对国际主流报刊和广播进行人工查阅以了解该国舆情的发展方向,然后撰写报告,如国外动态参考之类。21世纪初,随着信息技术的发展,国际舆情研判手段发展到多文档精选法和模板因子法。如今,基于网络技术发展,又发展出关键词搜索法、网络实验法和数据库比对法。以上各种方法,在舆情研判的工作中曾经发挥着重要的作用,也取得了一定的成效。但是,新的大数据挖掘技术的发展,以上几种方法在舆情研判上的不足逐渐暴露出来。

1.样本代表性不足。传统舆情研判的数据基础思想是样本的随机性采集,但这些样本并不是全样本,而是小样本,小数据量。之所以如此,一方面是受制于统计工具,另一方面是因为随机性统计方法认为,采样分析的精确性随着采样随机性的增加而大幅提高,这种提高跟样本数量关系不大,也就是,样本随机性比样本数量更加重要。然而,祝建华教授在一次讨论中明确表示,如果抽样的对象过于复杂,比如大数据,那么,人们根本找不到一个最优抽样的标准。一旦随机性出现偏差,分析结果就会相去甚远。2016年,美国总统大选,不但美国相关机构预测失败,而且我国的统计机构也预测认为候选人希拉里会获胜,日本统计机构甚至认为希拉里大胜,从而建议首相提前结好希拉里。但是,印度的人工智能系统MogIA却通过对Google、Facebook、Twitter等平台上2000万个数据点分析后认为,特朗普能够当选美国总统,于是我们看到,当特朗普当选后,日本首相不被待见,而印度总理却很受美国总统特朗普欢迎。这一事例说明,小样本已经不能够满足大数据时代的舆情研判,如果还基于小样本提供舆情研判,极易出现失误。

2.缺乏包容性。在信息缺乏时代,信息的精确性就意味着研判的精确性。人们不但执迷于获取精确的信息,而且也为如何消除噪音而苦恼。在线性传播模式中,噪音是一个影响传播效果的主要因素,传播学者为此制定出很多降噪的策略,如设备降噪、传播重复、扩大音量等。但是,信息爆炸的时代,噪音与数据并存,人们获得有用数据的同时,也就意味着噪音的获得,“我们掌握的数据库越来越全面,它不再只包括我们手头现象的一点点可怜的数据,而是包括了与这些现象相关的大量甚至全部数据。我们不再需要那么担心某个数据点对整套分析的不利影响。我们要做的就是要接受这些纷繁的数据并从中受益,而不是以高昂的代价消除所有的不确定性。”①但是,小样本为了精确性而排斥这些数据。

3.效率低下。无论是人工浏览法还是文档精选法,它们不但耗费巨大的人力物力,而且在面对危机事件时,也不能立即总结出可行的报告,其效率低下的缺点暴露无遗。危机管理对时间的要求非常高,20世纪90年代,管理者提出24小時的黄金法则,后来针对新环境,又提出5小时原则,如今在社交媒体时代,5小时显然不能适应舆情处理的要求。但不管是5小时,或者2小时,传统舆情研判的方法都不能满足这些需求,而利用大数据挖掘技术,却能够在极短的时间内,保质保量地完成这些舆情分析和研判。

二、“脏数据”与数据清洗

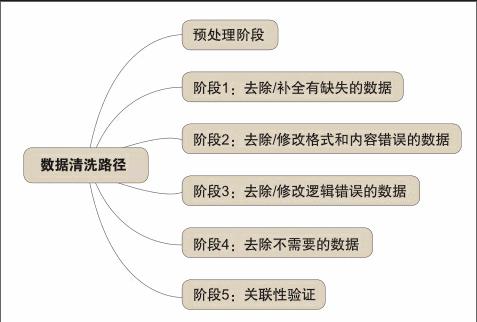

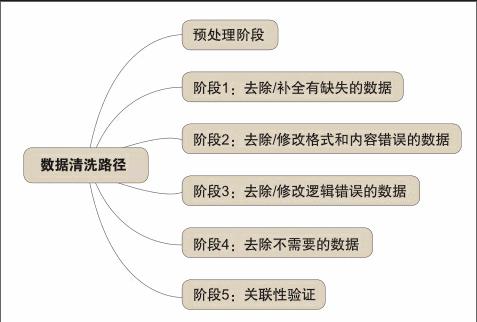

虽然大数据在面对全样本时,比人工浏览法、文档精选法等舆情研判更有优势,比如现在流行的Google搜索和百度搜索,但是,他们并不意味着大数据挖掘技术就一定能够准确预测舆情。因为,在舆情产生的过程中,异常数据、不一致数据、重复数据、缺失数据等噪音数据和一些因数据结构设计不合理和属性约束不够等产生的“脏数据”,也就是前文提到的包容性数据,都能够影响到舆情研判的精确度。所谓“脏数据”指的是在数据收集阶段,源系统中的数据不存在给定范围或对实际业务毫无意义,或是数据格式非法以及在源系统中存在不规范的编码和含糊的业务逻辑。在国际舆情的收集过程中,由于语言逻辑的转换、文化理解的不同,甚至数据源的获取不正规,噪音数据和“脏数据”普遍存在。从过去舆情研判失败的案例中可以看出,如果无法对噪音数据或“脏数据”进行清洗,这些获得的舆情研判结果还需要人工进行进一步检验,这样就浪费人力物力。为了解决这个问题,数据清洗就成为解决“脏数据”的主要手段。

数据清洗技术主要应用于数据质量管理、数据库和数据挖掘三个方面,不同的应用领域认知不尽相同。到目前为止,数据清洗技术在学术界还没有一个公认的定义,但是其内容已经达成了初步共识。一般认为,只要有助于解决数据质量问题的处理过程就被认为是数据清洗,其原理是通过分析“脏数据”的产生原因及存在形式,对数据流的过程进行考察、分析,并总结出数理统计、数据挖掘或预定义规则等方法,从而将“脏数据”转化成满足数据质量要求的数据。对于国际舆情研判而言,在国际舆情的大数据管理中,根据作者设置的定义、属性、值域等对字段进行语义分析,发现隐藏在字段间的关联关系,并进一步得到数据集中的字段存在的函数依赖关系,基于函数依赖发现数据集中的不一致值问题和隐藏的噪声数据。然后根据函数依赖关系对数据集中的不一致值和缺失值进行清洗和修复。基于字段间的函数依赖关系还可以发现可信度较低的字段,通过分析可信度低的原因并反馈至数据采集阶段,可以从数据源处减少国际舆情的“脏数据”。②具体见下图:endprint

三、国际危机事件中的数据清洗

当危机事件发生时,能够在时间压力下获取相对准确的信息是危机管理者的核心需求。然而,国际危机事件的舆情往往通过新媒体在国际舆论场中快速传播,这些信息能够在瞬间传播至全国范围乃至全世界的各个角落,各种态度、观点通过媒体在舆论场中传播,其中既有主流舆情的因素,也有一些“脏数据”。在此过程中,能够排除“脏数据”,准确获取国际危机事件中影响事件发展方向的舆情就成为数据挖掘的关键。

首先,数据清洗技术需要建立约束处理机制。约束处理机制是大数据清洗的准备工作,也是数据清洗的开端。第一步是利用大数据技术对国际危机事件的所有数据进行收集,这些数据也被称为待清洗数据。需要注意的是,信息收集需要一个时间限制,虽然危机事件具有潜伏期、爆发期、蔓延期和恢复期四个阶段的发展过程,但是,对于突发事件管理者而言,最重要的是爆发之后几小时的数据,这里参考我国发布的突发事件新闻发布要求中的5小时反应规定。时间确定后,就需要根据大数据技术设置约束要素,如政治、经济、思想等。

其次,数据清洗设置。清晰设置就是根据约束处理机制对数据进行辨析的过程。首先是对数据进行解析,从传播学的角度看,就是对数据进行解码,因为,在搜集到的数据中除了文字文档外,还有图片、视频等多媒体文件,这些数据需要按照大数据挖掘格式进行解析,否则,就会出现“脏数据”。数据解析后,通过规则逻辑如信息交互、重复识别和合并清洗等进行计算机选择,从而根据规则进行清洗。该过程是一种技术处理的过程,既需要大数据的算法库,也需要危机事件舆情的主体参与进来。具体而言,就是在收集到危機事件的舆情数据后,针对“脏数据”进行数据清洗,这种清洗的最终目的是保留清洁数据,为舆情研判做好准备。

最后,数据验证。数据清洗完毕后,并不能够保证舆情研判的准确性。为了保证数据清洗后的数据具有价值,还需要对这些数据进行价值和趋势的验证,如果发现数据清洗后出现缺失,就需要对数据进行补全。然后,根据清洗后的数据进行分析和研判,从而能够最大程度地保证研判的准确性。

四、小结

随着大数据技术的发展,数据清洗技术也越来越成熟,如今已经被谷歌、脸谱等公司应用于舆情研判工作中。对于国际舆情研判工作来说,信息的复杂性、多样性和全样本性,又决定了传统意义上信息处理方法的不适应性,故而,数据清洗技术的使用显得尤为必要。

「注释」

①维克托·迈尔·舍恩伯格、肯尼思·库克耶著,盛杨燕、周涛译:《大数据时代》,浙江人民出版社2013年版,第56页。

②谭晖、廖振松、周小翠、贺凡:《大数据的数据清洗方法研究》,《信息通信》2017年第1期。endprint