颜色不变量与AKAZE特征相结合的无人机影像匹配算法

梁焕青,谢 意,付四洲

1. 南宁市国土测绘地理信息中心,广西 南宁 530021; 2. 广西业恒勘测设计有限公司,广西 南宁 530021

颜色不变量与AKAZE特征相结合的无人机影像匹配算法

梁焕青1,谢 意1,付四洲2

1. 南宁市国土测绘地理信息中心,广西 南宁 530021; 2. 广西业恒勘测设计有限公司,广西 南宁 530021

基于特征的影像匹配方法是无人机影像匹配中较为实用的一类方法。针对传统特征匹配方法主要以灰度影像作为输入量,难以利用颜色特征高效区分同名点这一问题,本文结合颜色不变量,设计了一种运用AKAZE特征的匹配算法,克服了传统无人机影像匹配忽略彩色信息的缺点;然后通过灰度级变换,使特征点数目大量减少而又不失其可靠性。试验表明,该方法不仅能够准确识别同名点,而且还提高了运行效率。

无人机影像;颜色不变量;AKAZE特征检测算法;灰度级变换;影像匹配

无人机遥感平台因灵动性强、成本低廉而成为获取高质量空间数据的重要途径之一。影像配准技术能弥补无人机单幅影像地面覆盖范围较小的不足,是获取目标区域全景图的基础性和关键性问题。覆盖完整测区的无人机影像具有几何畸变较大、重叠度高以及数据量大等特点[1-2],是无人机影像配准技术的瓶颈问题。

目前无人机影像配准主要采用基于特征点的匹配方法,其核心是特征点检测[3]。特征点检测可分成两部分:一是提取特征点,二是编码特征信息形成描述符。SIFT[4]算法依托于信号的尺度空间理论[5],通过曲面拟合精确求解DOG尺度空间特征点坐标,在噪声、视角变化等复杂情况下只能保持一定的抗差性。后有学者将SIFT特征和灰度特征[6]作为相似测度,或者改进SIFT描述符的主方向[7]和构造单元[8]以实现有较大差异的影像同名点识别,引入基于贝叶斯抽样一致性算法[9]来提高运算时间。CenSurE算法[10]汲取SIFT和SURF[11]算法的优势,通过双层滤波器生成全尺度空间,使用积分图像高速计算Haar小波响应来检测极值点,具备较高的定位精度和匹配稳定性,但整体运算时间过长。ORB[12](oriented FAST and rotated BRIEF)算法依托基于模板的FAST[13](features from accelerated segment test)算法快速提取特征点,通过BRIEF[14](binary robust independent elementary features)算法编码形成执行效率较高的二值描述符,但是其精确定位精度较低,在尺度变化条件下,匹配效果也不理想。BRISK[15]算法通过自适应通用加速分割算法(AGAST[16])使运算速度超越了ORB算法。AKAZE(accelerated-KAZE,加速的KAZE)算法[17]通过快速显式扩散算法FED(fast explicit diffusion)[18-19]来提高非线性空间的构造速度,其二值描述符M-LDB(modified-local difference binary)囊括了旋转因子和尺度插值,兼顾了算法的执行效率、特征匹配的稳定性和精度。以上这些算法在特征点匹配性能和执行效率上不断探索,但只针对灰度影像,忽略了彩色影像原有的颜色特征。

由于颜色特征易受光源和成像设备硬件的影响,即使面对同一场景,在不同的摄像机和拍摄时间下也会出现差别。因此,本文将颜色不变量[20]与AKAZE特征检测算法相结合以研究无人机影像匹配技术,从尺度变换、旋转变换、模糊、亮度以及综合变换等方面分析匹配性能,探索一种既能利用彩色信息,又能在保持精度的基础上提高运行效率的新方法。

1 AKAZE特征检测算法

在传统线性尺度空间中,各向同性的高斯滤波使影像整体以无差别的方式进行平滑,减弱了影像局部的识别力度,可能使部分重要的细节信息变得模糊。为了解决这个问题,AKAZE特征检测算法以各向异性的非线性滤波来构造尺度空间,顾及到影像局部纹理结构和细节清晰度,进行不同程度的平滑,能自适应地保留图像边缘和细节。非线性扩散滤波原理可由非线性偏微分方程来表述

(1)

特征检测主要步骤如下:

(1) 构建非线性尺度空间。与SIFT类似,非线性尺度空间也分为O组金字塔影像,每组有S层,则尺度参数与影像组、子层级的关系满足式(2),σ0是尺度初始值,n为尺度空间影像总数目。首先对原始影像重复降采样,获得O组金字塔影像,再对每组影像按照不同参数滤波生成S层尺度影像,按式(3)计算进化时间ti

o∈[0,O-1],s∈[0,S-1],i∈[0,n-1]

(2)

(3)

利用FED算法解算式(1)的偏微分方程从而生成非线性尺度影像,其表达如下

Li+1=(I+τA(Li))Lii=0,…,n-1

(4)

式中,I是单位阵,A(Li)是图像在维度i上的传导矩阵,由高斯滤波后的尺度影像的梯度直方图构造,τ为时间步长,为进化时间的差值ti+1-ti。

(2) 探测并定位特征点。与SIFT算法求解极值方式类似,寻找不同尺度归一化后的Hessian局部极大值点。把采样点的响应值与同层的8个邻域点及上下邻近层级的2×9个点相比取极值,利用尺度空间函数在候选点处拟合二次曲线以获取精确的空间位置,如式(5)。

(5)

式中,σi是尺度参数;o为对应的组;Lxx和Lyy分别为二阶横向和纵向微分;Lxy为二阶交叉微分。

(3) 划定特征点主方向。与SURF求解主方向方法相似,明显变化之处是统计函数替换成影像导数信息。在梯度图像上以特征点为中心,以半径6σ为统计范围,取特征点邻域的一阶微分值Lx和Ly进行高斯赋权运算,然后以π/3的扇形为单位旋转,主方向选取单位向量和中最长矢量方向。

(4) MLDB描述符。局部差分描述符M-LDB和BRIEF描述符原理相似,只是把二值测试单元扩大为一个子区域,以提高抗噪性能。同时,M-LDB描述符划分子区域为格网,以尺度σ为间隔重采样得到离散点,以离散点的水平和竖直方向的导数均值信息近似代表子区域的导数信息,使其描述符维度增加到3比特,以达到旋转不变性和增强描述符的可区分性。

由于重采样的离散点计算的值只是各个子区域的近似值,不能满足测试单元之间是严格独立的关系。为了减弱单元之间的相关性,可效仿ORB算法选用贪婪搜索方法,或者随机选择部分二值字符串来减少描述符的尺寸。

2 彩色影像的颜色不变量模型

文献[21]研究了描述物体光谱辐射特性的Kubelka-Munk理论,得出针对非透明物体的光谱辐射特性表达模型[21]如下

E(λ,x)=e(λ,x)[1-ρf(x)]2R(λ,x)+e(λ,x)ρf(x)

(6)

式中,λ为波长;x是一个二维矢量,表示成像平面的位置;e(λ,x)为光谱强度。ρf(x)是在位置x的Fresnel反射系数,R(λ,x)是材料反射率,E(λ,x)表征在波长λ在位置x的反射光谱。当处于能量相等而光照均匀条件下,光谱强度e(λ,x)不受波长影响,只与平面位置有关,所以可将其简写为i(x),则式(6)变为

E(λ,x)=i(x)[(1-ρf(x))2R(λ,x)+ρf(x)]

(7)

对式(7)求波长λ的一阶以及二阶导数得

Eλ=i(x)[1-ρf(x)]2∂R(λ,x)/∂λ

(8)

Eλλ=i(x)[1-ρf(x)]2∂2R(λ,x)/∂2λ

(9)

而定义颜色不变量H为式(8)与(9)的商

(10)

由此,得到的颜色不变量H表征材料的反射属性,不受物体表面的朝向、平面观测位置、反射系数、光照强度大小影响,且在尺度缩放、背景变化、旋转变换下都是一个不变量,完全具备局部不变特征的性质。

通常彩色影像用RGB三原色空间表示,采用线性变化与高斯滤波器相结合的方式来获取几何不变性和光照不变性。经过高斯颜色模型和线性变换得到符合人眼视觉系统和CIE 1964 XYZ标准下的RGB分量和(E,Eλ,Eλλ)的近似关系[22]

(11)

式中,E、Eλ、Eλλ分别代表高斯颜色模型中的灰度通道:强度、黄-蓝颜色通道以及红-绿颜色通道,到此RGB值的相关性就消失了。结合上述的式(10)与(11)得到H的表达式为

(12)

3 结合颜色不变量的AKAZE特征匹配算法

AKAZE算法灵敏度较高,在窄幅影像上能提取到较多的特征点。然而,特征点数量过多必然使构造描述符和搜索匹配阶段的时间增加。在实际应用中,普遍采取3种方法对特征点进行稀疏均匀化处理:一是对图像分块[23],用阈值控制每块特征匹配对的数量和分布;二是以特征点为中心[24],计算一定范围内的特征匹配对总数是否大于设定阈值来删选;三是在特征提取阶段,增大极值点探测步长以减少特征点提取数量[25]。前两种方法的共同点是在匹配过程中或者匹配后用阈值限制特征点显示的总数,并没有从初始状态改变特征点提取数量,即不能减小特征提取、描述和匹配阶段的计算量。第三种方法虽然减少了特征提取数量和匹配时间,但是在无法预估特征点分布情况下,盲目增大探测步长,可能会漏掉大量可靠的特征点,导致匹配对可靠性较低,精度不高。因此,如何减小特征点提取数量的同时增加配对成功比例是提高算法实时性和有效性的方法之一。

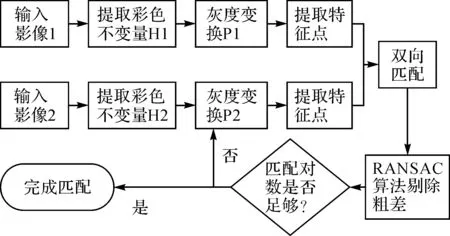

AKAZE算法对亮度变化有较强的适应能力,而颜色不变量具有与尺度、旋转和光照等因素无关的特点。基于以上两点性质,本文对颜色不变量进行灰度级量化,把有效信息高度集中到更小的区间。首先按式(12)求出颜色不变量作为输入信息,以增强算法对光照的抗差性。其次,采取分段线性变换的方法对颜色不变量进行处理。颜色不变量的值多数小于1,而极大值相对较大。为了保持输入信息的特点,统计颜色不变量的极值和直方图,选取直方图两峰值间的最低点作为分段点,以目标灰度最大值的83.3%作为分段点变换后的灰度值。通过设定一较小的目标灰度最大值,使输入信息差异缩小化,从而减小特征点数量的同时又能保持可靠性,避免大量冗余的特征点消耗时间。如果预设灰度最大值偏小,匹配对数较少,则挑选出相应影像,灰度最大值自动增加10再进行特征点提取和匹配。经过两次运算后,一般匹配对数会增加10~100对,满足匹配要求。若两次运算后未能满足要求,则程序会弹出对话框,由人工指定合适的值代入运算,本文采用的灰度最大值为60~80。经过灰度变换后的信息可依照AKAZE算法流程进行特征提取和描述,其特征匹配流程如图1所示。

图1 改进算法特征匹配流程图Fig.1 Flow chart of the proposed feature matching algorithm

4 试验与分析

本文设计了5组试验:第1组测试改进算法在尺度变化条件下的有效性;第2组测试改进算法在旋转变换情况下的可区分性; 第3组探究改进算法在模糊因子变化下的匹配稳定性;第4组分析改进算法在明暗变化条件下的可重复性;第5组

用真实无人机数据检测算法在综合变换下的可行性。正确匹配数量和匹配率能反映算法的可区分性,运行时间能反映算法的效率,正确匹配对数的中误差和最大误差是算法可行的必要条件。因此,本文选择这几个指标来综合评价算法的适用性。

本文选取如图2所示的2组包含典型地物的无人机影像作为试验对象,(1)代表原始影像,(2)为文中改进后的输入影像。A组为SONY相机DSC-RX1拍摄典型的平原郊区影像,航高约为435m,幅面大小为6000×4000,焦距35mm,农作物覆盖率较大;B组试验数据为SONY相机ILCE-7R拍摄的城市影像,航高约为300m,幅面大小为7360×4912,焦距35mm,道路和房屋信息较多。为了获取具有先验信息的左右影像对,前4组试验中左影像均以原始影像中央为中心点,截取1/3尺寸而得,而右影像是根据试验条件对原始影像进行单一变换后进行裁剪的结果。

图2 试验图像Fig.2 Test images

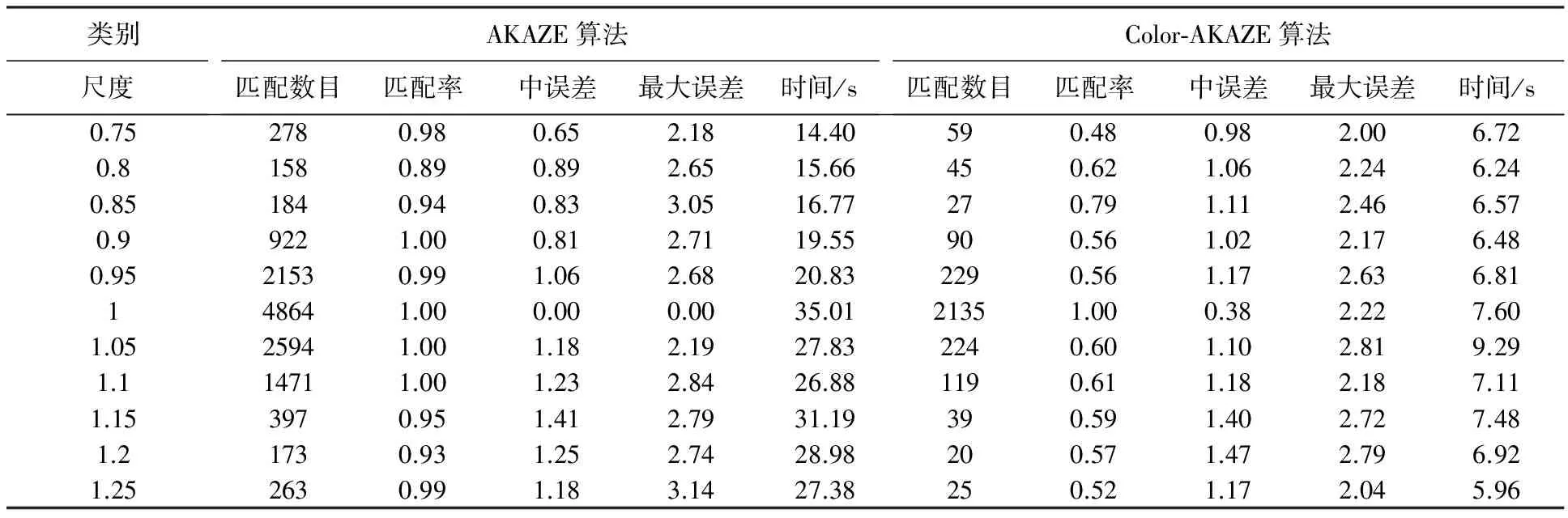

4.1 尺度变化试验

为了模拟无人机航高变化带来影像尺度改变的效果,用尺度系数乘以左影像像幅得到截取范围,以中心点截取获得“比例影像”,对“比例影像”重采样成与左影像大小相同的右影像,即原始尺寸的1/3。此时,影像中的地物尺寸发生改变,而又不会出现黑色边缘。试验中以0.1为增幅,尺度从0.75升至1.25,共11组像对。

A、B组获取匹配对数最少的情形如图3所示。由表1与2可知,A组影像改进算法获取的匹配数目适量,匹配率相差不大,满足变换矩阵解算要求,且用时皆小于4s。改进算法中误差增加幅度仅为0.02~0.12像素,而最大误差以0.8~2.48幅度降低。B组改进算法的匹配对为原算法的8%~28%,匹配率有所降低,而时间比为21%~46%,中误差变化范围仅为-0.08~0.33像素,且最大误差多数有所减小。

图3 改进算法尺度变化部分匹配图Fig.3 The partial matching image in different scale using the proposed algorithm

类别AKAZE算法Color⁃AKAZE算法尺度匹配数目匹配率中误差最大误差时间/s匹配数目匹配率中误差最大误差时间/s0.757870.710.652.1825.33260.720.981.471.610.85480.760.782.2627.78190.860.771.903.510.856630.790.892.6527.88190.680.881.872.570.916320.740.872.7724.41660.890.721.392.280.9531800.910.833.0525.96760.850.812.242.19151280.990.372.4830.485961.000.000.002.141.0532500.910.812.7126.191010.910.901.621.341.122420.890.882.7024.71680.781.051.811.411.1511270.961.062.6823.46440.761.011.881.401.25240.841.213.8423.12340.871.191.971.441.255550.911.133.0821.47450.961.262.181.46

表2 改进算法B组尺度因素对比结果

由试验结果可知,改进算法将具备尺度不变性的颜色信息作为输入量,在尺度变换中基本上保持原有算法的匹配精度。灰度级量化使影像对比度降低,致使改进算法以小幅度降低匹配率为代价,很大程度上缩短了匹配时间,提高了算法的执行效率。

4.2 旋转角度试验

为了模拟航向变化及平台不稳定带来影像的旋偏角变化,右影像以原始影像中央为中心点逆时针旋转角度α得到“旋转影像”,以中心点截取“旋转影像”的1/3尺寸为右影像。试验中以5°为增幅,获得从0°到355°的共71组影像对。

改进算法旋转变化部分匹配图如图4所示,分析图见图5。匹配数目比和匹配时间比分别为改进算法与原算法的对应项相除。据图5可知,A组改进算法配准率大部分集中在70%~90%,而用时仅为原算法的4%~7%。改进算法中误差增加0.5像素左右,但多数都小于1像素,且最大误差和原算法相差不大。B组改进算法匹配数目比不超过10%,配准率较低,但匹配时间比仅为6%~15%。改进算法中误差大约增加0.3像素,最大误差变化不大。

图4 改进算法旋转变化部分匹配图Fig.4 The partial matching image in different rotation angle using the proposed algorithm

图5 旋转变化对比分析图Fig.5 The contrast analysis in different rotation angle

由以上分析可知,引入与位置无关的颜色不变量,在旋转角度变化下具有良好的匹配稳定性,调整灰度级分布范围既可提取高质量的特征点,又能减小多余特征点的数量,从而节省了时间,大幅度提高了运算效率。

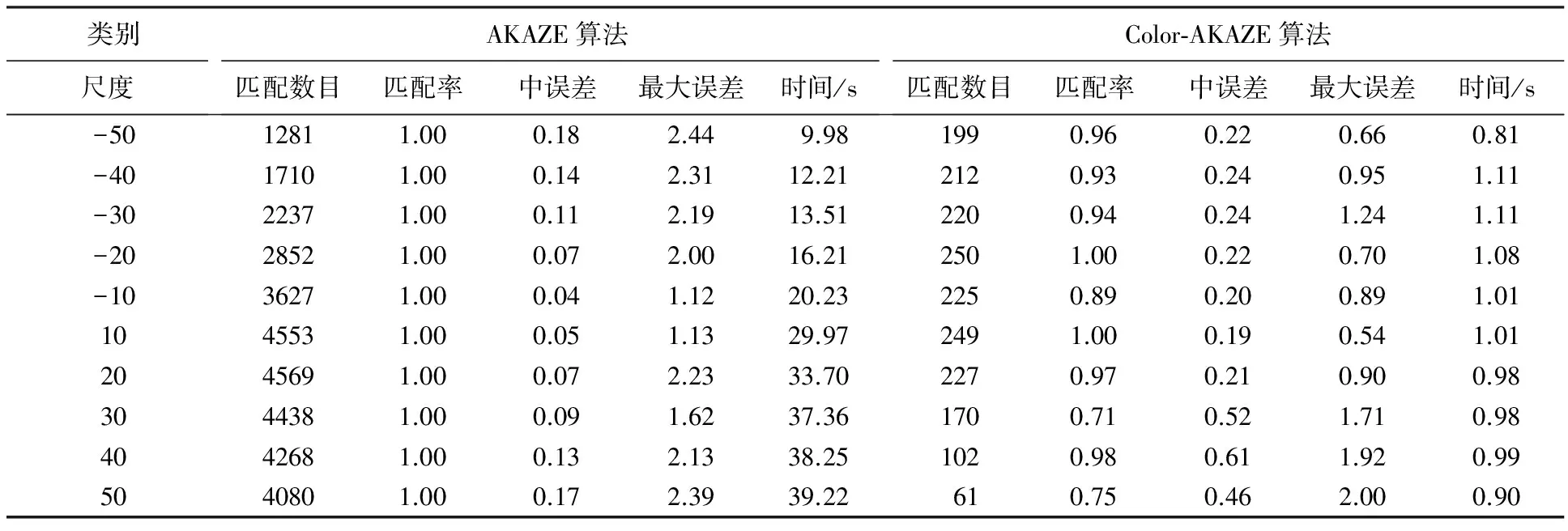

4.3 亮度因素试验

为了模拟天气改变、时间不同或者飞行区域转移可能出现亮度不均匀的现象,对左影像以10为幅度逐渐增加亮度,得到变化范围从-50到50的11组影像作为右影像。

从表3和表4可知,改进算法把与光照无关的颜色不变量作为输入信息,使原始数据具备几何和颜色的双重特征,因此在亮度变化时能检测到足够数量的特征点。如图6,A组在亮度参数为-50、50时分别有199和61对匹配点。此外,灰度级的调整又能减少特征点,加快算法执行速率。例如A组匹配时间控制在2 s以内,不到原算法的10%,速度提升了一个数量级,虽然中误差增加幅度为0.04~0.48像素,但最大误差减小0.09~1.78像素。B组影像获取的匹配数目小于原算法的10%,匹配时间仅为原算法的15%~40%,配准率保持在65%以上,中误差增加0.6像素左右,但最大误差在影像变暗时减小,变亮时增加。

表3 A组亮度因素对比结果

表4 B组亮度因素对比结果

图6 改进算法亮度因素部分匹配图Fig.6 The partial matching image in different luminance factor using the proposed algorithm

4.4 模糊因子试验

为了模拟雾霾、噪声等因素可能导致影像清晰度降低现象,对左影像进行高斯模糊处理,以1像素为增幅,得到半径值从1到5的5组像对。

由表5、6可知,改进算法在各模糊半径下都能获取匹配对。模糊因素和农作物相似的纹理信息会使颜色不变量图像的对比度降低,从而导致提取的特征点质量降低,因此需要动态增大灰度级量化区间以获取足够数量的匹配对,相应的匹配时间也会随着模糊半径增大而增加,但还是节省了时间。改进算法的A组影像匹配对占原算法的12%~58%,配准率变化不大,中误差增大0.01~0.34像素,而最大误差变化范围为-0.34~0.37像素。B组影像改进算法用原算法4%~43%的时间成功获取5%~17%的匹配对,中误差在2像素以内,且最大误差降低幅度为0.12~0.48像素。综上所述,改进算法在模糊条件变化下不仅能保持原算法的匹配精度,还缩短了运行时间,具备良好的可分区性和实时性。

表5 A组模糊因素对比结果

表6 改进算法B组模糊因素对比结果

图7 改进算法模糊变化部分匹配图Fig.7 The partial matching image in different blur factor using the proposed algorithm

4.5 综合变换试验

两组综合变换的影像试验统计结果见表7和图8。改进算法获取A组的匹配对数为23,为原算法的2%,匹配率相差不大,而用时小于原算法30%,中误差仅增加0.15像素,且最大误差减小0.03像素。B组也用原算法30%的时间获取了2%的匹配对,且中误差和最大误差分别减小0.08与1.15像素。由上可知,改进算法在综合变化条件下与原算法匹配精度相当,运行时间大幅度减少。

综上所述,改进算法在尺度缩放、旋转变换、模糊变换、亮度变化和综合变换时具有良好的匹配稳定性,具备在减小特征点数量的同时保障匹配质量的能力,是一种有效可行的提高运行效率的特征匹配算法。

表7 综合变换试验对比结果

图8 综合变换部分匹配对比图Fig.8 The comparison of partial matching image in composite factor

5 结 论

本文设计了一种颜色不变量与AKAZE特征检测算法相结合的无人机影像匹配方法。该方法首先从彩色影像提取与尺度、旋转以及光照因素不敏感,且能反映地物自身色彩的颜色不变量,然后实施灰度级变换以替代传统灰度影像作为算法输入量,最后进行AKAZE特征提取和匹配。试验表明,该方法能够在尺度缩放、明暗变化、旋转剧烈、模糊抖动和综合变换等条件下高效率地获取足够数量的匹配对,并且精度和原AKAZE算法相差不大。但该方法灰度范围参数只能根据经验值预定,不能实现自动分析影像划定最佳范围。因此为了提高方法的运算效率和自动化程度,下一步将研究智能解析影像灰度级变换的最佳参数。

[1] 刘有. 无人机序列影像匹配及拼接方法研究[D]. 长沙: 中南大学, 2012. LIU You. Research on Matching and Mosaicing Methods for UAV Image Sequences[D]. Changsha: Central South University, 2012.

[2] 王勃. 基于特征的无人机影像自动拼接技术研究[D]. 郑州: 信息工程大学, 2011. WANG Bo. Automatic Mosaic Technique of UAV Images Based on Features[D]. Zhengzhou: Information Engineering University, 2011.

[3] 吕金建, 文贡坚, 李德仁, 等. 一种新的基于空间关系的特征匹配方法[J]. 测绘学报, 2008, 37(3): 367-373. LÜ Jinjian, WEN Gongjian, LI Deren, et al. A New Method Based on Spatial Relations for Feature Matching[J]. Acta Geodaetica et Cartographica Sinica, 2008, 37(3): 367-373.

[4] LOWE D G. Object Recognition from Local Scale-invariant Features[C]∥Proceedings of the Seventh IEEE International Conference on Computer Vision. Kerkyra: IEEE, 1999, 2: 1150-1157.

[5] WITKIN A P. Scale-space Filtering[M]∥FISCHLER M A, FIRSCHEIN O. Readings in Computer Vision: Issues, Problem, Principles, and Paradigms. Los Altos, CA: Morgan Kaufmann, 1987: 329-332.

[6] 张卡, 盛业华, 叶春. 基于数字视差模型和改进SIFT特征的数字近景立体影像匹配[J]. 测绘学报, 2010, 39(6): 624-630. ZHANG Ka, SHENG Yehua, YE Chun. Digital Close Range Stereo Image Matching Based on Digital Parallax Model and Improved SIFT Feature[J]. Acta Geodaetica et Cartographica Sinica, 2010, 39(6): 624-630.

[7] 岳春宇, 江万寿. 几何约束和改进SIFT的SAR影像和光学影像自动配准方法[J]. 测绘学报, 2012, 41(4): 570-576. YUE Chunyu, JIANG Wanshou. An Automatic Registration Algorithm for SAR and Optical Images Based on Geometry Constraint and Improved SIFT[J]. Acta Geodaetica et Cartographica Sinica, 2012, 41(4): 570-576.

[8] ZHENG Mingguo, WU Chengdong, CHEN Dongyue. UAV Image Identification in Urban Region Satellite Image Using Global Feature and Local Feature[C]∥Proceedings of the 2016 Chinese Control and Decision Conference (CCDC). Yinchuan: IEEE, 2016: 5377-5382.

[9] 贾丰蔓, 康志忠, 于鹏. 影像同名点匹配的SIFT算法与贝叶斯抽样一致性检验[J]. 测绘学报, 2013, 42(6): 877-883. JIA Fengman, KANG Zhizhong, YU Peng. A SIFT and Bayes Sampling Consensus Method for Image Matching[J]. Acta Geodaetica et Cartographica Sinica, 2013, 42(6): 877-883.

[10] AGRAWAL M, KONOLIGE K, RUFUS BLAS M. CenSurE: Center Surround Extremas for Realtime Feature Detection and Matching[C]∥Proceedings of the 2008 European Conference on Computer Vision. Marseille: Springe, 2008: 102-115.

[11] LI Qiaoliang, WANG Guoyou, LIU Jianguo, et al. Robust Scale-invariant Feature Matching for Remote Sensing Image Registration[J]. IEEE Geoscience and Remote Sensing Letters, 2009, 6(2): 287-291.

[12] ROSTEN E, PORTER R, DRUMMOND T. Faster and Better: A Machine Learning Approach to Corner Detection[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2010, 32(1): 105-119.

[13] ROSTEN E, DRUMMOND T. Machine Learning for High-speed Corner Detection[C]∥Proceedings of the 9th European Conference on Computer Vision. Graz: Springer, 2006: 430-443.

[14] CALONDER M, LEPETIT V, STRECHA C, et al. BRIEF: Binary Robust Independent Elementary Features[C]∥Proceedings of the 11th European Conference on Computer Vision. Heraklion: Springer, 2010: 778-792.

[15] LEUTENEGGER S, CHLI M, SIEGWART R Y. BRISK: Binary Robust Invariant Scalable Keypoints[C]∥Proceedings of 2011 IEEE International Conference on Computer Vision. Barcelona, Spain: IEEE, 2011: 2548-2555.

[16] MAIR E, HAGER G D, BURSCHKA D, et al. Adaptive and Generic Corner Detection Based on the Accelerated Segment Test[C]∥Proceedings of the 11th European Conference on Computer Vision. Heraklion: Springer, 2010: 183-196.

[17] ALCANTARILLA P F, NUEVO J, BARTOLI A. Fast Explicit Diffusion for Accelerated Features in Nonlinear Scale Spaces[C]∥British Machine Vision Conference (BMVC). Bristol: British Machine Vision Association, 2013: 13.1-13.11.

[18] GREWENIG S, WEICKERT J, BRUHN A. From Box Filtering to Fast Explicit Diffusion[C]∥Proceedings of the 32th DAGM Conference on Pattern Recognition. Darmstadt: Springer-Verlag, 2010: 533-542.

[19] WEICKERT J, GREWENIG S, SCHROERS C, et al. Cyclic Schemes for PDE-Based Image Analysis[J]. International Journal of Computer Vision, 2016, 118(3): 275-299.

[20] JING Huiyun, HE Xin, HAN Qi, et al. CBRISK: Colored Binary Robust Invariant Scalable Keypoints[J]. IEICE Transactions on Information and Systems, 2013, E96(2): 392-395.

[21] GEUSEBROEK J M, VAN DEN BOOMGAARD R, SME-ULDERS A W M, et al. Color Invariance[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2001, 23(12): 1338-1350.

[22] ABDEL-HAKIM A E, FARAG A A. CSIFT: A SIFT Descriptor with Color Invariant Characteristics[C]∥Proceedings of 2006 IEEE Computer Society Conference on Computer Vision and Pattern Recognition. New York: IEEE, 2006: 1978-1983.

[23] 刘景正. 无人飞行器影像场景配准与目标监视技术研究[D]. 郑州: 信息工程大学, 2011. LIU Jingzheng. Research on Techniques in Scene Registration and Object Surveillance for UAV Imagery[D]. Zhengzhou: Information Engineering University, 2011.

[24] 宋丽华. 基于无人飞行器序列影像的定位技术研究[D]. 郑州: 信息工程大学, 2010. SONG Lihua. The Study of Target Positioning Technology Based on UAV Image Sequence[D]. Zhengzhou: Information Engineering University, 2010.

[25] 牛俊伟, 郝向阳, 刘松林. 一种改进的SIFT特征提取算法[J]. 测绘科学技术学报, 2014, 31(2): 173-176. NIU Junwei, HAO Xiangyang, LIU Songlin. An Improved SIFT Feature Extraction Algorithm[J]. Journal of Geomatics Science and Technology, 2014, 31(2): 173-176.

[26] 梁焕青, 范永弘, 万惠琼, 等. 一种运用AKAZE特征的无人机遥感影像拼接方法[J] 测绘科学技术学报, 2016, 33(1): 71-75. LIANG Huanqing, FAN Yonghong, WAN Huiqiong, et al. Mosaic Algorithm of UAV Images Based on AKAZE Features[J]. Journal of Geomatics Science and Technology, 2016, 33(1): 71-75.

(责任编辑:宋启凡)

UAV Image Registration Algorithm Using Color Invariant and AKAZE Feature

LIANG Huanqing1,XIE Yi1,FU Sizhou2

1. Nanning Land Surveying, Mapping and Geoinformation Center, Nanning 530021,China; 2. Guangxi YeHeng Surveying Design Co. Ltd., Nanning 530021, China

Image matching based on feature was one of practical methods in UAV image matching. Since the conventional methods of image registration mainly used gray image as input that it could not take color features into account to distinguish the identical point. To address this problem, this paper designed a matching algorithm combined color invariant with AKAZE feature, which overcame the shortcoming of ignoring color information in traditional UAV image matching. Then gray level transformation was utilized to reduce the number of feature points and remain its reliability. Experimental results demonstrate that the proposed method can find the identical point accurately and enhance the efficiency.

UAV image; color invariant; AKAZE feature extraction algorithm; gray level transformation; image matching

LIANG Huanqing(1990—), female, postgraduate, majors in UAV image processing.

梁焕青,谢意,付四洲.颜色不变量与AKAZE特征相结合的无人机影像匹配算法[J].测绘学报,2017,46(7):900-909.

10.11947/j.AGCS.2017.20160436. LIANG Huanqing,XIE Yi,FU Sizhou.UAV Image Registration Algorithm Using Color Invariant and AKAZE Feature[J]. Acta Geodaetica et Cartographica Sinica,2017,46(7):900-909. DOI:10.11947/j.AGCS.2017.20160436.

P237

A

1001-1595(2017)07-0900-10

2016-09-02

梁焕青(1990—),女,硕士,研究方向为无人机影像处理。

E-mail: lhqamber@126.com

修回日期: 2017-06-12