分组排序多特征融合的图像检索方法

刘胜蓝 冯 林 孙木鑫 刘 洋

(大连理工大学电子信息与电气工程学部 辽宁大连 116024)(大连理工大学创新实验学院 辽宁大连 116024)(liusl@mail.dlut.edu.cn)

分组排序多特征融合的图像检索方法

刘胜蓝 冯 林 孙木鑫 刘 洋

(大连理工大学电子信息与电气工程学部 辽宁大连 116024)(大连理工大学创新实验学院 辽宁大连 116024)(liusl@mail.dlut.edu.cn)

在图像检索中,多特征图融合方法大多仅对最近邻域进行融合.当每个特征的近邻图排序结果较差时,融合后的新图难以得到理想的检索效果.为了解决该问题,提出一种新的多特征图融合图像检索方法——分组排序融合(group ranking fusion, GRF),该方法将数据集合中的相似图片划分为图片组,利用相似图片组对近邻图的检索结果进行改进,在保持精度的前提下扩充了融合范围.最后,在3个标准数据集上的实验结果表明:多特征融合方法能够有效地利用多特征图提高图像检索效果.

多特征融合;基于内容的图像检索;规范最小割;图学习;检索重排

近年来随着互联网和移动终端上图像数据的急剧增长,如何快速有效地从图像库中检索用户需要的图像已成为计算机视觉领域的热点问题.图像检索[1]可分为3类:基于文本[2]、图像内容[3]和图像语义[4]的图像检索.基于文本和基于语义的检索效果尚不理想;而基于内容的图像检索(CBIR)技术近些年取得了很多成果,其检索效果也较为理想.因此,CBIR成为图像检索的主流方式.CBIR主要研究图像特征提取和图像排序两方面的工作,图像特征提取的方法和图像排序都对图像检索的效果有很大的影响,好的图像特征配合与之相适应的图像排序方法才能得到理想的图像检索效果.

在图像排序方面,已有很多优秀的成果.如刘广海等人[5]发现1范数排序比欧氏距离排序效果更好.然而1范数排序存在排名方式独立的问题.因此,在后续的研究中,图学习在图像检索中起着至关重要的作用.He等人[6]将流形排序(manifold ranking,MR)应用于图像检索,取得了较好效果.He等人[6]进一步提出了广义的MR,利用K-NN初始化得分向量,该方法在数据分布不复杂的情况下可以获得比MR更优的结果,但容易因K-NN选取不当造成误差扩散.王斌等人[7]将图结构中的K-NN利用样本节点的度和权值的最小化改进为K-RNN,提升图像检索的效果.在图结构方面,Huang等人[8]利用超图实现MR,节点之间的权值由概率决定,由于不同节点对有多个权值,所以在图像检索中可以取得比较好的排序结果.除了超图,多图也是样本点间多权值的一种实现手段.Zhao等人[9]利用图像的不同特征构建多图加强样本点之间的关系实现图像检索,Zhang等人[10]利用Graph PageRank和Graph Density方法将多图进行融合,实现图像的排序.

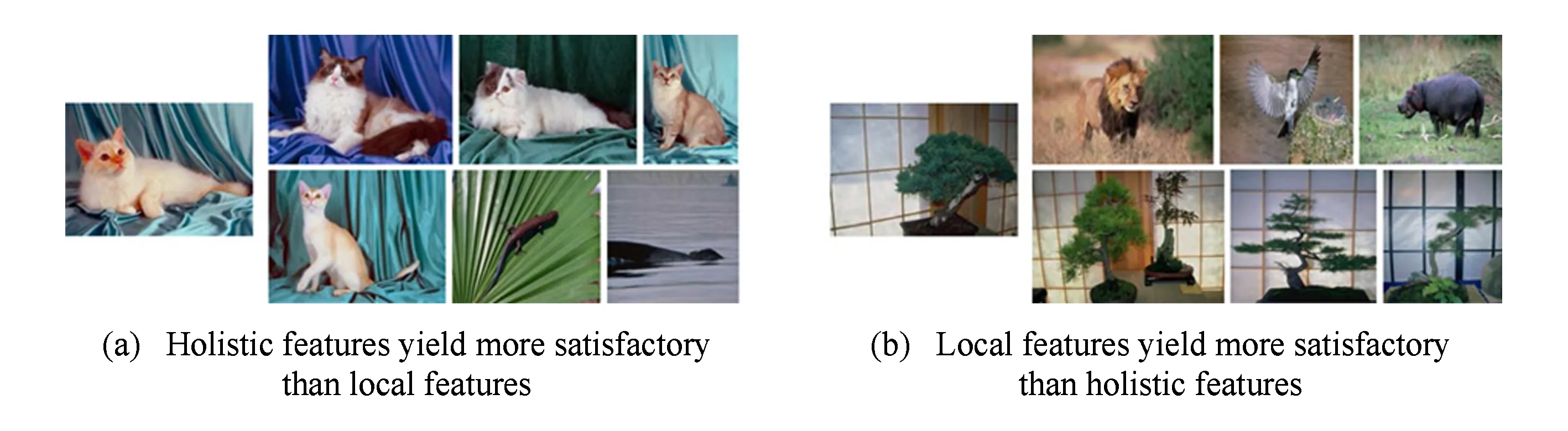

Graph Density[10]方法为目前主流的图学习方法之一.该方法通过融合差异性大的特征组来提高检索结果的准确性.但Graph Density方法在多特征图融合上依然存在限制.Graph Density方法要求至少一个特征对待检索图片表现良好,才能取得较理想的检索结果如图1[10]所示.若单特征的检索结果不理想,则Graph Density方法难得得到理想的效果.

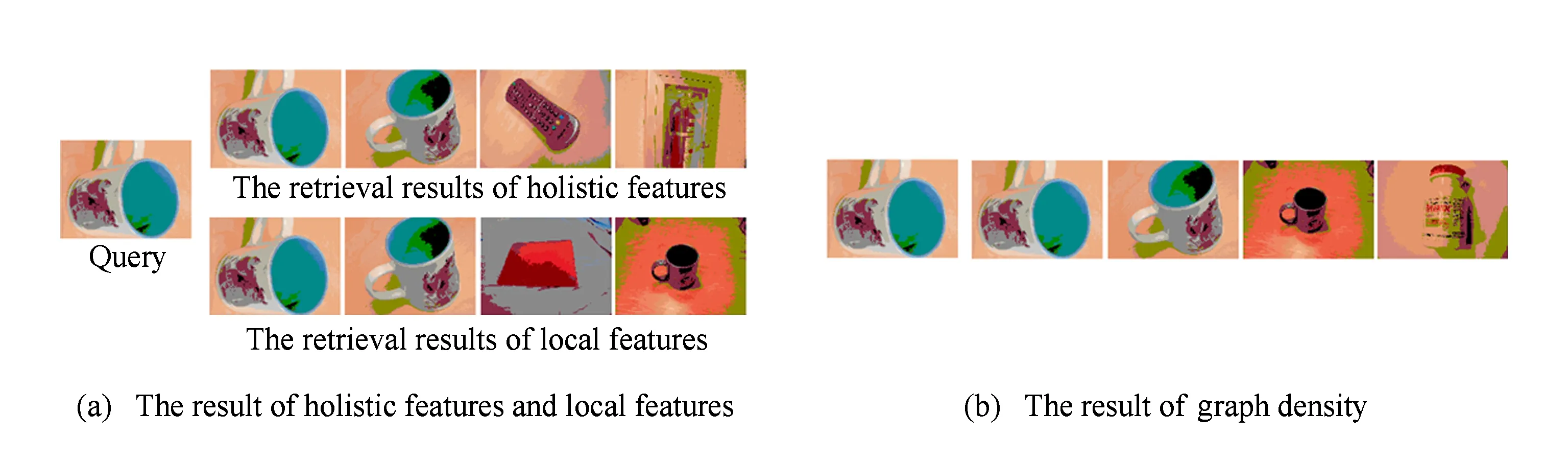

例如,在局部特征和全局特征都没有得到理想检索结果的情况下,如图2所示的Graph Density方法的检索结果不会得到改善.在图2(a)中,对待检图片而言,不同特征的检索结果均不理想,导致Graph Density方法没有获取到充分的信息,改善待检图片的检索结果如图2(b)所示.

Fig. 1 The performance of holistic features and local features on the same data-set图1 全局特征和局部特征在同一个数据集上的检索结果

Fig. 2 Retrieval result of one query images in UK-bench图2 UK-bench数据集中一张图片的检索结果

为了获取足够的信息,本文将待检图片的检索结果视为新的待检图片组,利用该图片组的检索结果获取原始待检图片的信息,将检索结果的范围扩大到数据集中与检索图片相似的图片组,若图片组中能够获取足够的信息,就可以提升检索效果.

为了从相似图片组中获取足够的信息解决Graph Density方法对特征要求过高的问题,本文提出分组排序的图融合(group ranking fusion, GRF)方法.该方法主要分为4个步骤:

1) 将图像检索数据集,获取特征的排序结果(第2节),例如HSV[11],BOW[12];

2) 建立权重图(第3节),权重图中节点为数据集合中的图片,其中节点之间权重和图像之间的相似度成正比,对于不同特征的权重图采用图融合(3.1节)的方法;

3) 将权重图中节点分为n个独立的集合(集合大小等于图像检索输出图像的个数),n个大小相同的集合满足规范最小割[13];

4) 将最近邻域中与检索图片不在同一个图片组中的近邻删除,余下的近邻就是本文方法的检索结果,具体过程如图3所示.

权重图的规范最小割是一个NP完全问题[13],为了求解规范最小割,本文(3.2节)设计一种求解规范最小割极值的随机算法.

Fig. 3 Group and rank fusion method图3 分组排序的图融合方法

1 图像特征提取

图像特征提取很大程度上决定了图像检索的效果,也是多特征图融合方法的重要步骤.本节主要简单介绍实验中GRF使用到的图像特征提取方法.

1.1 全局图像特征

全局特征主要是通过图片整体特性来描述图片所携带的信息.例如统计颜色信息的颜色直方图(HSV[11])、统计纹理信息的局部二值模式(LBP)等.

HSV为统计颜色信息直方图,它能够描述一幅图像中颜色的全局分布,即不同色彩在整幅图像中所占的比例,特别适用于描述那些难以自动分割的图像和不需要考虑物体空间位置的图像,但是它无法描述图像中颜色的局部分布及每种色彩所处的空间位置,即无法描述图像中的某一具体的对象或物体.

LBP为统计纹理信息的局部二值模式,它也描述了图像或图像区域所对应景物的表面性质,但是它无法完全反映高层次图像内容.

除此之外还有许多全局图像方法,例如基于局部敏感度Hash(LSH[14]),以及在LSH上改进马氏(Mahalanobis)距离[15]等.本文的实验主要使用HSV特征.

1.2 局部图像特征

局部图像特征通过描述图片的区域来描述图片特征,其中图片区域的描述子通常满足不变性(鲁棒性)和可区分性,例如尺度不变性特征(SIFT[16-17],SURF[18]).

SIFT是应用广泛的局部特征,它对尺度、旋转以及一定视角和光照变化等图像变化都具有不变性,并且SIFT具有很强的可区分性.

SURF是对SIFT的改进版本,它利用Haar小波来近似SIFT方法中的梯度操作,同时利用积分图技术进行快速计算,SURF的速度是SIFT的3~7倍,大部分情况下它和SIFT的性能相当.

近期很多二值特征描述子被提出,例如ORB[19],BRISK[20],FREAK[21]等.局部特征描述子结合词汇树[22](VOC)或词袋[12](BOW)转化为图像的局部特征.本文的实验主要使用SIFT特征+BOW方法以及CNN特征.

2 特征图构建

要在排序阶段实现不同特征的图融合,首先需构建一个好的特征图.一般的想法是构建出来图的边的权重是图片之间为相似图片的概率,但它是不可计算的.同本文类似的替代方案是文献[10,23]等,本节将会介绍GRF算法特征图的构建方式.

(1)

边权函数w定义为

(2)

(3)

其中,α为常量(α∈[0.1,0.3]).基于式(2)(3),对于任意的检索结果可以构建出有向图G=(V,E,w).由式(2)(3)可以得出,节点i和i′(i′∈Nk(i))的J(i,i′)大于常数α的数量越多,则w(q,i)值越大.

为了利用相似图片组的检索信息,本文将图像检索数据集划分为n个集合S={S1,S2,…,Sn},集合Si的大小为k(一般为检索出的相似图像的个数),且集合之间满足关系:

(∀i∀j)Si∩Sj=∅,

(4)

(5)

(6)

定义1. 函数f(i,i′)为

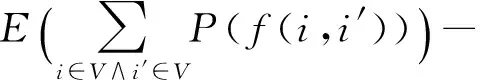

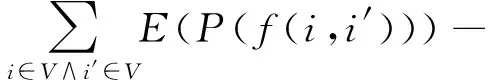

由定义1可知,对于数据集合V的划分S={S1,S2,…,Sn}的准确率(precision)期望为

E(precision)=

(7)

(8)

从式(8)可以得出,求任意的划分集合S={S1,S2,…,Sn}对应的E(precision)关键是P(f(i,i′)=1),由于P(f(i,i′)=1)的准确值是不可知的.因此,如果w(q,i)越大,则P(f(i,i′)=1)越大,此时,可用w(q,i)近似代替P(f(i,i′)=1),求出在不同划分集合条件下E(precision)的大小关系.

3 分组排序的图融合

分组排序的图融合(GRF)方法主要包括:多特征图融合方法以及分组排序方法.在本节中,将分别对以上内容进行详细介绍.

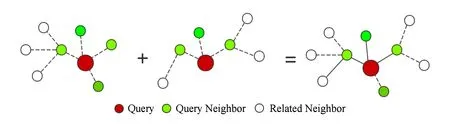

3.1 图融合

为了获取图像特征互补信息,提高图像检索的准确率,需要设计多种图像特征融合方法.现有的多特征融合方法主要有:在特征提取阶段的融合方法和在排序阶段的融合方法.在特征提取阶段的融合方法在效率和可靠性方面表现一直不佳,尤其是融合特征越多效率越难以保证.对于要求高效的图像检索,在特征提取阶段的融合方法存在严重缺陷.因此,在排序阶段的融合方法成为图像检索中多特征融合的主要研究方向.目前在排序阶段的融合方法主要是Dwork等人[25]提出的图融合方法,但该方法仍然存在一定的限制.为了避免上述多特征融合出现的问题,本文进行如下融合方式,本文方法同文献[10,26-27]相似.

Fig. 4 Fusion of two graphs图4 2种不同的Gm=(Vm,Em,wm)融合成G=(V,E,w)

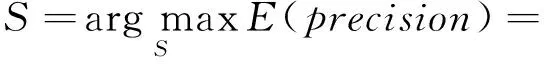

3.2 分组排序方法

通过上述优化方法,可保证集合划分S={S1,S2,…,Sn}的E(precision)逐渐增大,当不存在交换2个点能够使E(precision)增大时,则认为集合划分S={S1,S2,…,Sn}的E(precision)达到极值点.迭代的具体方式如下:

算法1. 主要迭代过程.

输入:结构图G=(V,E,w);

输出:划分集合S={S1,S2,…,Sn}.

While True

Swap(i,i′);

Else Return;

End If

End While

Return

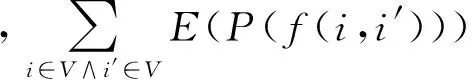

不难发现,每次迭代需要计算集合的总权值的变化情况.总权值的计算速度直接影响算法的运行效率,对于给定节点i和i′,由式(8)可得:

(9)

同理,可得交换之后:

(10)

由式(9)(10)可知交换之后:

E(precision)-E′(precision)=

(11)

输入:i,i′(i,i′∈V);

输出:d.

d=0;

For (i,v)∈E

Ifv∈Sj∧i∈Sj

dd+w(i,v);

Else Ifv∈Sj′∧i′∈Sj′

dd-w(i,v);

End If

End For

For (i′,v)∈E

Ifv∈Sj∧i∈Sj

dd-w(i′,v);

Else Ifv∈Sj∧i∈Sj

dd+w(i′,v);

End If

End For

Return

本文已给出最大化E(precision)的迭代方法,并且可以通过本文方法对任何候选集合进行优化,进而得到更加合理的候选图像集合.

4 实验结果分析

本节首先说明数据集和实验的方法,然后详细说明在每一个数据集合上的实验结果,对每个数据集的结果进行分析.

4.1 数据集

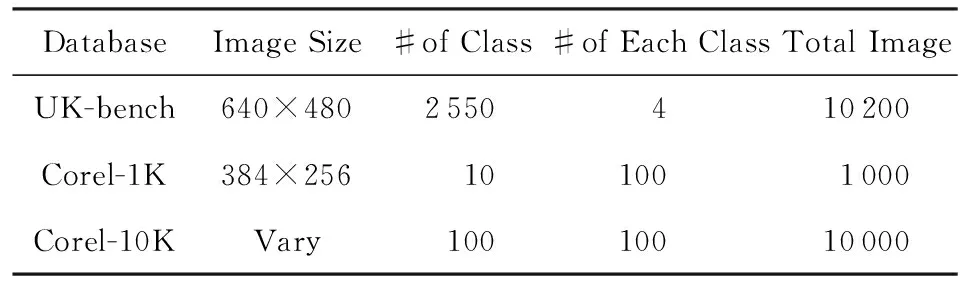

本文评估采用3个标准数据集:UK-bench,Corel-10K,Corel-1K.其中,UK-bench具有图片旋转和尺度变化、图片类别多和数据集合相对较大等特点;Corel-10K具有每类图片个数多和数据集合相对较大等特点;Corel-1K具有每类图片个数多和数据集合大相对较小等特点.通过以上数据集,验证本文算法的有效性.数据集详细参数如表1所示:

Table 1 Attributes of Experimental Data Set表1 实验数据集的属性

UK-bench[28]包含2 550个不同的数据种类的图片,每类图像包含4张相似的图片.10 200张图片同时包含数据集合和询问集合.每张图片返回4张候选图片,采用N-S(改成斜体)评估.

Corel-1K[29]包含10个不同的数据种类的图片,每类图像包含100张图片.1 000张图片包含数据集合和询问集合.每张图片寻找20张候选图片,并评估候选图片的准确率.

Corel-10K[29]包含100个不同的数据种类的图片,每类图像包含100张图片.1 000张图片包含数据集合和询问集合.每张图片寻找12张候选图片,并评估候选图片的准确率.

4.2 特征选取及融合方法

基础的图像检索方式包括:VOC,HSV,BOW等.本文将会应用单特征优化方法对GVOC,GHSV,GBOW进行优化,并应用图融合方法对GVOC,GHSV和GHSV,GBOW进行融合优化.

1) VOC.本文采用基于图像检索的词汇树,每张图片使用VLFeat-library提取出2500 SIFT特征.词汇树包含7层,每层10个分支,在image-net上进行训练,最后应用到UK-bench数据集上.

2) HSV.本文采用对于检索图像的每个像素点计算出11维向量:黑、蓝、棕、灰、绿、橙、粉、紫、红、白、黄.对于检索图像,本文以平均向量为颜色描述符作为图片的描述向量,最后应用到UK-bench,Corel-1K,Corel-10K数据集上.

3) BOW.本文采用基于图像检索的词袋,每张图片使用VLFeat-library提取出密集SIFT特征.词袋采用1000个词汇,进行kmeans聚类,最后应用到Corel-1K和Corel-10K数据集上.

4.3 UK-bench数据集

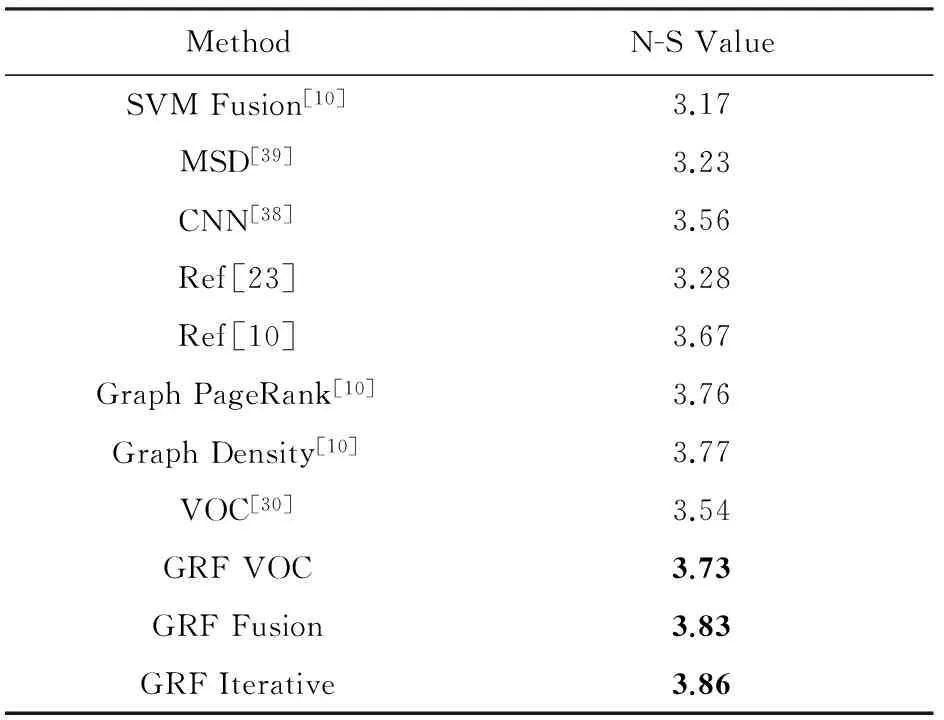

为了说明GRF方法在多特征图融合上的效果.在UK-bench数据集上,GRF方法采用VOC和HSV方法作为基础特征,进行多特征图融合,并同目前的主流的其他多特征图融合方法进行比较,比较结果详如表2所示:

Table 2 Comparisons of N-S Score on the UK-bench Data Set表2 在UK-bench 数据集多特征图融合方法的N-S值结果

结果较VOC(N-S值为3.54)偏低.经过不同的图融合方法都得到不同的提高.本文的单特征优化,使HSV的N-S值提高了0.12,VOC结果的N-S值提高了0.29,造成HSV和VOC差异的主要原因是:VOC和HSV的P(f(i,i′)=1)的大小不同,导致VOC的特征图相对于HSV的特征图更接近于真实的概率.因此,GRF算法对VOC较HSV的N-S值效果提高更大.

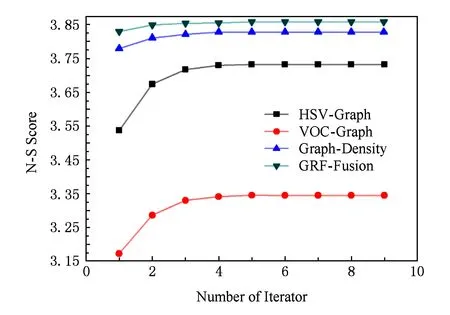

本文的图融合方法可以将UK-bench数据集合的N-S值提高到3.83.通过HSV,VOC采用文献[31]的方法进行迭代.在迭代之后HSV(N-S值为3.35)和VOC(N-S值为3.73),进行GRF方法的多特征图融合可以将UK-bench数据集的N-S分数提高到3.86,GRF算法的迭代效果如图5所示:

Fig. 5 N-S Score on the UK-bench data set after iterative building graphs图5 UK-bench数据集上不同方法迭代之后的N-S值

4.4 Corel-1K和Corel-10K数据集

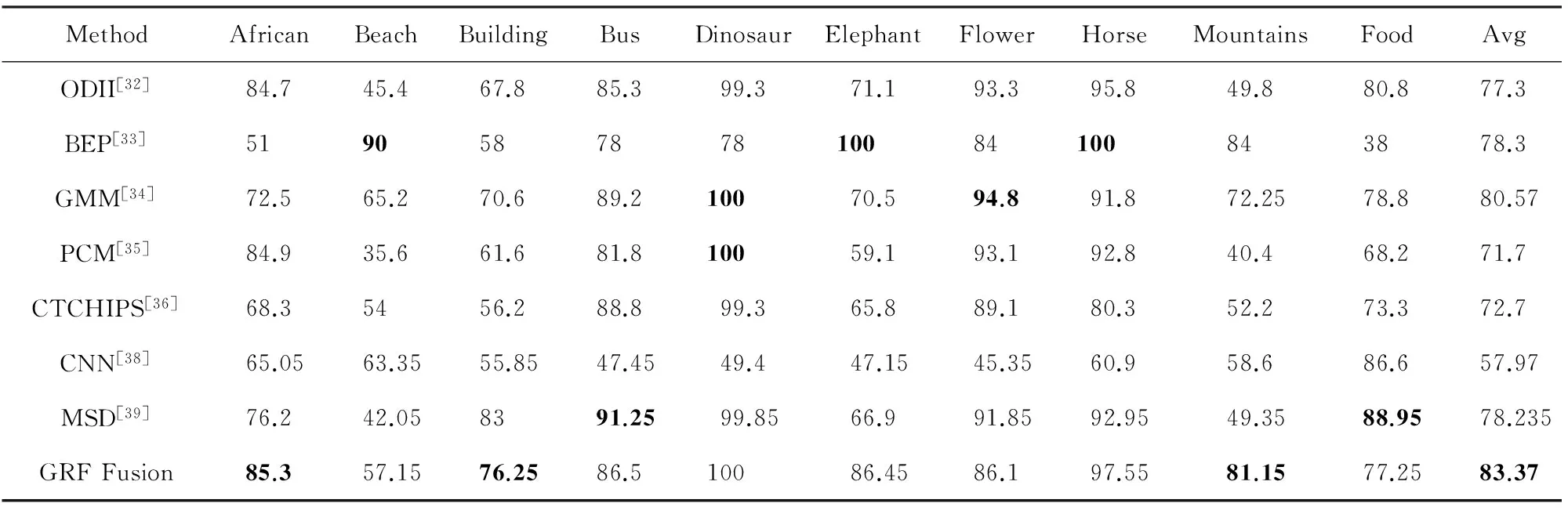

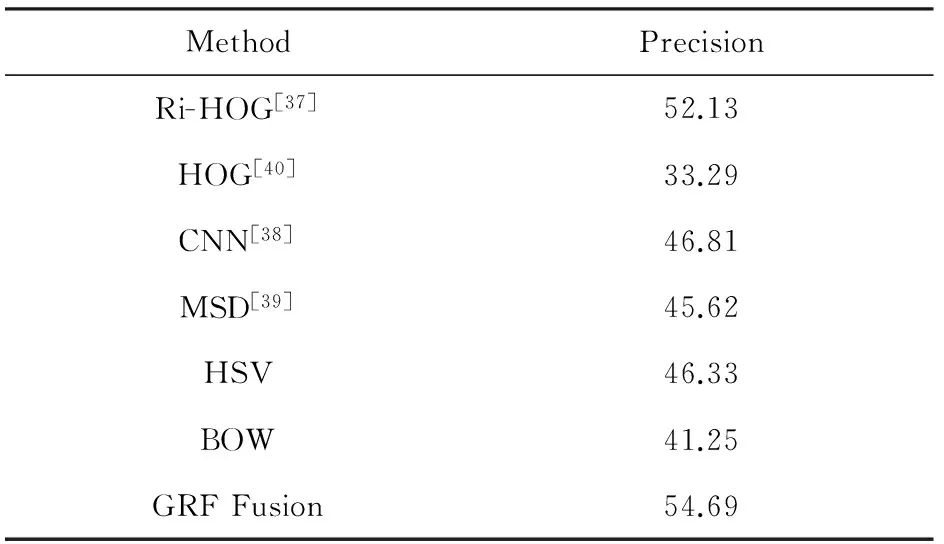

为了说明GRF在不同数据集上具有良好效果,本文在Corel-1K和Corel-10K数据集上采用BOW和HSV方法作为基础特征进行实验,并同目前在这2个数据集上具有较好效果的其他方法进行比较.在Corel-1K和Corel-10K数据集中每类图片包含100幅图片.在Corel-1K数据集中,本文比较前20幅图片的准确率;在Corel-10K数据集上,本文比较前12幅图片的准确率;采用BOW和HSV进行特征融合.相对于基本BOW和HSV准确率提高了11.70%,具体的准确率如表3所示.在Corel-10K数据集上,本文采用BOW和HSV进行特征融合前12幅图片的准确率可以提升8.36%.相对于Corel-1K提升幅度差异主要由于P(f(i,i′)=1)的大小,导致提升幅度减少,具体GRF算法的准确率如表4所示.

Table 3 Comparison of Different Image Retrieval Methods on Corel-1K

Table 4 Comparison of Different Image Retrieval Methods on Corel-10K

表4 不同算法在Corel-10K数据集上的准确率 %

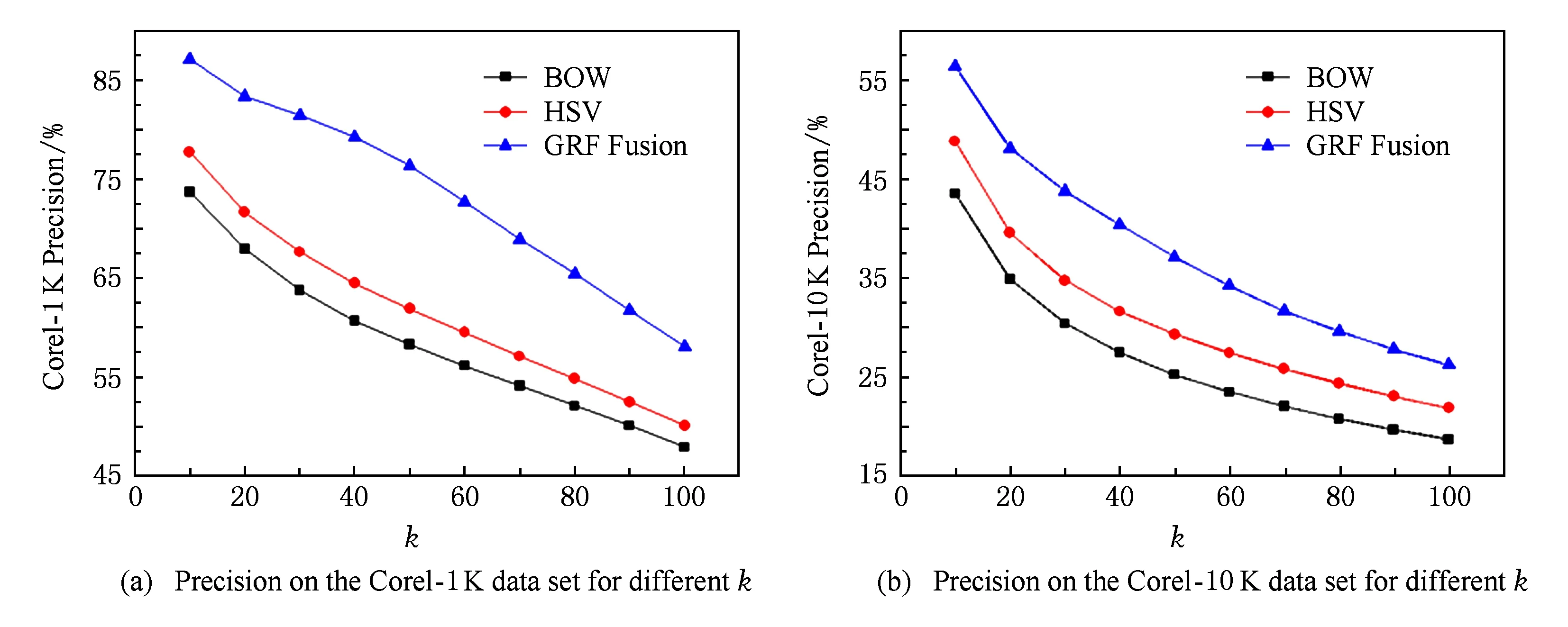

表3和表4的准确率结果说明,GRF方法利用全局图像检索信息使BOW和HSV方法的结果得到了较大的提升.由于不同方法的融合更加准确地求出w(i,i′),使本文方法在图融合方面表现出了很大的优势.对于前k幅图片准确率的提升并不相同,当k接近50时在Corel数据集上的效果最明显,在Corel-1K数据集上可以提高15%的准确率,在Corel-10K数据集上可以提高9%的准确率,不同的k值的准确率如图6所示.

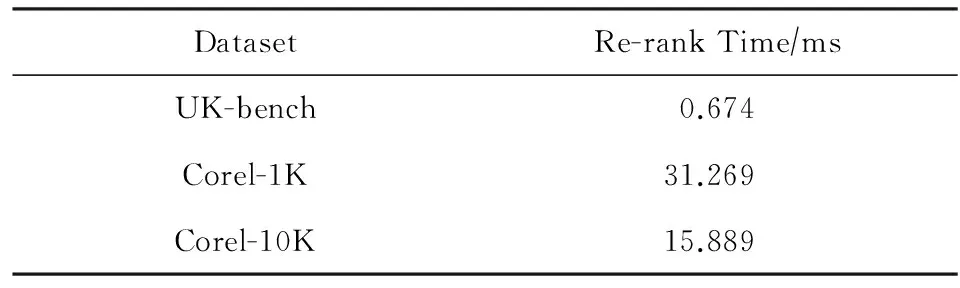

4.5 时间复杂度分析

Fig. 6 Precision on the Corel data set for different k图6 Corel数据集的前k幅图片准确率情况

在本文实验中,k根据实际要求的候选图片数量取值为4~30;分组方法固定迭代5次,每次迭代的时间复杂度为O(k2|V|),如果数据集较大可以采用离线的方式预先计算结果;每张检索图像重排方法的时间复杂度为O(klogk).本文方法计算检索图像排序结果的时间复杂度明显小于提取图像特征的时间复杂度.尤其当k的取值较小时(k=4),本文方法的检索时间小于1 ms,由此可见本文方法不影响图像检索的时间复杂度.在本文实验的数据集上重排时间如表5所示:

Table 5 The Re-rank Time on the Test Datasets

5 结 论

本文利用全局候选图片的信息,提出GRF图像排序融合方法.该方法利用不同特征图,将图像检索数据集划分为相似图片组以提升图像检索的效果.从实验结果可以看出,本文多特征图融合方法优于已有的方法;此外,通过融合图像的局部和全局特征,能够更全面地刻画图像的颜色、尺度及旋转等信息,可以较原特征(全局或局部特征)获得更高的精度,且原特征的效果越优,多特征图融合的检索效果越好.当所有特征对该图片检索结果存在较大偏差时,GRF方法依然能够提升图像检索的效果.该方法还存在一些不足,当相似图片组对检索图像整体没有较好的检索结果时,GRF方法难以提升图像检索的效果.在今后的工作中,可以通过研究此问题的解决办法,进一步提升多特征图融合方法对图像检索效果.

[1]Datta R, Joshi D, Li Jia, et al. Image retrieval: Ideas, influences, and trends of the new age[J]. ACM Computing Surveys, 2008, 40(2): No.5

[2]Zhang Chen, Joyce Y C, Rong Jin. User term feedback in interactive text-based image retrieval[C] //Proc of the 28th Annual Int ACM SIGIR Conf on Research and Development in Information Retrieval. New York: ACM, 2005: 51-58

[3]Li Xiangyang, Zhuang Yueting, Pan Yunhe. Content-based image retrieval techniques and systems[J]. Journal of Computer Research and Development, 2001, 38(3): 344-354 (in Chinese)(李向阳, 庄越挺, 潘云鹤. 基于内容的图像检索技术与系统[J]. 计算机研究与发展, 2001, 38(3): 344-354)

[4]Wang Huifeng, Sun Zhengxing, Wang Jian. Semantic image retrieval: Review and ResEearch[J]. Journal of Computer Research and Development, 2002, 39(5): 513-523 (in Chinese)(王惠锋, 孙正兴, 王箭. 语义图像检索研究进展[J]. 计算机研究与发展, 2002, 39(5): 513-523)

[5]Liu Guanghai, Yang Jingyu. Content-based image retrieval using color difference histogram[J]. Pattern Recognition, 2013, 46(1): 188-198

[6]He Jingrui, Li Mingjing, Zhang Hongjiang, et al. Generalized manifold-ranking-based image retrieval[J]. IEEE Trans on Image Processing, 2006, 15(10): 3170-3177

[7]Wang Bin, Pan Feng, Hu Kaimo, et al. Manifold-ranking based retrieval usingk-regular nearest neighbor graph[J]. Pattern Recognition, 2012, 45(4): 1569-1577

[8]Huang Yuchi, Liu Qingshan, Zhang Shaoting, et al. Image retrieval via probabilistic hyper graph ranking[C] //Proc of the 23rd IEEE Conf on Computer Vision and Pattern Recognition. Piscataway, NJ: IEEE, 2010: 3376-3383

[9]Zhao Sicheng, Yao Hongxun, Yang You, et al. Affective image retrieval via multi-graph learning[C] //Proc of the ACM Int Conf on Multimedia. New York: ACM, 2014: 1025-1028

[10]Zhang Shaoting, Yang Ming, Cour T, et al. Query specific rank fusion for image retrieval[J]. IEEE Trans on Pattern Analysis and Machine Intelligence, 2015, 37(4): 803-815

[11]Zheng Liang, Wang Shengjin, Liu Ziqiong, et al. Packing and padding: Coupled multi-index for accurate image retrieval[C] //Proc of the IEEE Conf on Computer Vision and Pattern Recognition. Piscataway, NJ: IEEE, 2014: 1939-1946

[12]Christian W, Matthijs D, Hervé J. Bag-of-colors for improved image search[C] //Proc of the 19th ACM Int Conf on Multimedia. New York: ACM, 2011: 1437-1440

[13]Shi Jianbo, Jitendra M. Normalized cuts and image segmentation[J]. IEEE Trans on Pattern Analysis and Machine Intelligence, 2000, 22(8): 888-905

[14]Mayur D, Nicole I, Piotr I, et al. Locality-sensitive hashing scheme based on p-stable distributions[C] //Proc of the 20th Annual Symp on Computational Geometry. New York: ACM, 2004: 253-262

[15]De Maesschalck R, Jouan-Rimbaud D, Massart D L. The mahalanobis distance[J]. Chemometrics and Intelligent Laboratory Systems, 2000, 50(1): 1-18

[16]Lowe D G. Object recognition from local scale-invariant features[C] //Proc of the 7th IEEE Int Conf on Computer Vision, Vol2. Piscataway, NJ: IEEE, 1999: 1150-1157

[17]Lindeberg T. Scale invariant feature transform[J]. Scholarpedia, 2012, 7(5): 10491-10491

[18]Bay H, Ess A, Tuytelaars T, et al. Speeded-up robust features (SURF)[J]. Computer Vision and Image Understanding, 2008, 110(3): 346-359

[19]Rublee E, Rabaud V, Konolige K, et al. ORB: An efficient alternative to SIFT or SURF[C] //Proc of IEEE Int Conf on Computer Vision (ICCV). Piscataway, NJ: IEEE, 2011: 2564-2571

[20]Leutenegger S, Chli M, Siegwart R Y. BRISK: Binary robust invariant scalable keypoints[C] //Proc of IEEE Int Conf on Computer Vision (ICCV). Piscataway, NJ: IEEE, 2011: 2548-2555

[21]Alahi A, Ortiz R, Vandergheynst P. Freak: Fast retina keypoint[C] //Proc of IEEE Conf on Computer Vision and Pattern Recognition (CVPR). Piscataway, NJ: IEEE, 2012: 510-517

[22]Chen D, Tsai S S, Chandrasekhar V, et al. Robust image retrieval using multiview scalable vocabulary trees[C/OL] //Proc of SPIE Electronic Imaging, 2009[2014-08-18]. http://citeseerx.ist.psu.edu/viewdoc/download?doi=10.1.1.142.8937&rep=rep1&type=pdf

[23]Jegou H, Schmid C, Harzallah H, et al. Accurate image search using the contextual dissimilarity measure[J]. IEEE Trans on Pattern Analysis and Machine Intelligence, 2010, 32(1): 2-11

[24]Niwattanakul S, Singthongchai J, Naenudorn E, et al. Using of Jaccard coefficient for keywords similarity[C] //Proc of the Int Multi-Conf of Engineers and Computer Scientists, 2013[2014-10-11]. http://www.iaeng.org/publication/IMECS2013/IMECS2013_pp380-384.pdf

[25]Dwork C, Kumar R, Naor M, et al. Rank aggregation methods for the Web[C] //Proc of the 10th Int Conf on World Wide Web. New York: ACM, 2001: 613-622

[26]Jing Yushi, Baluja S. Visualrank: Applying pagerank to large-scale image search[J]. IEEE Trans on Pattern Analysis and Machine Intelligence. 2008, 30(11): 1877-1890

[27]Duygulu P, Barnard K, De Freitas J F G, et al. Object recognition as machine translation: Learning a lexicon for a fixed image vocabulary[C] //Proc of the 7th European Conf on Computer Vision. Berlin: Springer, 2002: 97-112

[28]Nister D, Stewenius H. Scalable recognition with a vocabulary tree[C] //Proc of IEEE Computer Society Conf on Computer Vision and Pattern Recognition. Los Alamitos, CA: IEEE Computer Society, 2006: 2161-2168

[29]Li Jia, Wang J Z. Automatic linguitic indexing of pictures by a statistical modeling approach[J]. IEEE Trans on Pattern Analysis and Machine Intelligence, 2003, 25(9): 1075-1088

[30]Wang Xiaoyu, Yang Ming, Timothee C, et al. Contextual weighting for vocabulary tree based image retrieval[C] //Proc of the 13th IEEE Int Conf on Computer Vision. Piscataway, NJ: IEEE, 2011: 209-216

[31]Wang Meng, Li Hao, Tao Dacheng, et al. Multimodal graph-based reranking for Web image search[J]. IEEE Trans on Image Processing, 2012, 21(11): 4649-4661

[32]Guo Jingming, Heri P, Su Huaisheng. Image indexing using the color and bit pattern feature fusion[J]. Journal of Visual Communication and Image Representation, 2013, 24(8): 1360-1379

[33]Walia E, Pal A. Fusion framework for effective color image retrieval[J]. Journal of Visual Communication and Image Representation, 2014, 25(6): 1335-1348

[34]Zeng Shan, Huang Rui, Wang Haibing, et al. Image retrieval using spatiograms of colors quantized by Gaussian mixture models[J]. Neurocomputing, 2016, 17: 673-684

[35]Yu F X, Luo Hao, Lu Z M. Colour image retrieval using pattern co-occurrence matrices based on BTC and VQ[J]. Electronics Letters, 2011, 47(2): 100-101

[36]Lin C, Chen R, Chan Y. A smart content-based image retrieval system based on color and texture feature[J]. Image and Vision Computing, 2009, 27(6): 658-665

[37]Chen Jinhui, Toru N, Tetsuya T, et al. Content-based image retrieval using rotation-invariant histograms of oriented gradients[C] //Proc of the 5th ACM on Int Conf on Multimedia Retrieval. New York: ACM, 2015: 443-446

[38]Babenko A, Slesarev A, Chigorin A, et al. Neural codes for image retrieval[C] //Proc of European Conf on Computer Vision. Berlin: Springer, 2014: 584-599

[39]Liu Guanghai, Li Zuoyong, Zhang Lei, et al. Image retrieval based on micro-structure descriptor[J]. Pattern Recognition, 2011, 44(9): 2123-2133

[40]Dalal N, Triggs B. Histograms of oriented gradients for human detection[C] //Proc of IEEE Computer Society Conf on Computer Vision and Pattern Recognition. Los Alamitos, CA: IEEE Computer Society, 2005: 886-893Liu Shenglan, born in 1984. PhD. Post doctor at Dalian University of Technology. His main research interests include pattern recognition and machine learning.

Group and Rank Fusion for Accurate Image Retrieval

Liu Shenglan, Feng Lin, Sun Muxin, and Liu Yang

(Faculty of Electronic Information and Electrical Engineering, Dalian University of Technology, Dalian, Liaoning 116024)(School of Innovation Experiment, Dalian University of Technology, Dalian, Liaoning 116024)

Single feature is not discriminative to describe informational content of an image, which is always a shortcoming in traditional image retrieval task. It can be seen that one image can be described by different but complemented features. So multi-feature fusion ranking methods should be further researched to improve the ranking list of query in image retrieval. Most existing multi-feature fusion methods only focus on the nearest neighbors in image retrieval. When the ranking result of each neighbor graph is poor, it is hard to get ideal image retrieval result after graph fusion. In order to solve the problem, this paper proposes a novel multi-feature fusion method for image retrieval—GRF(group ranking fusion). The proposed method divides similar images of a data set into the same group, and improves the retrieval result of neighbor graph through similar images group. The GRF method expands the fusion scope in the premise of guaranteeing retrieval precision premise. At last, the experimental results on three standard data sets demonstrate that GRF can effectively utilize multi-feature graph to improve the performance of image retrieval.

multi-feature fusion; content-bases image retrieval; minimizing normalized cut; graph learning; retrieval re-rank

Feng Lin, born in 1969. Professor and PhD supervisor at Dalian University of Technology. His main research interests include intelligent image processing, robotics, data mining, and embedded systems.

Sun Muxin, born in 1989. Master candidate at Dalian University of Technology. His main research interests include pattern recognitionand machine learning.

Yang Liu, born in 1992. PhD candidate at Dalian University of Technology. His main research interests include video analysis and machine learning.

2015-10-29;

2016-07-05

国家自然科学基金项目(61602082,61672130,61370200);中国博士后科学基金面上资助基金项目(2015M581331) This work was supported by the National Natural Science Foundation of China (61602082, 61672130, 61370200) and the General Program of the Postdoctoral Science Foundation of China (2015M581331).

TP391.41