基于多因素贝叶斯的遮挡目标检测

牛玉婷 张丽华 吴克伟 谢 昭 杨兴明

(合肥工业大学计算机与信息学院 安徽 合肥 230009)

基于多因素贝叶斯的遮挡目标检测

牛玉婷 张丽华 吴克伟 谢 昭 杨兴明

(合肥工业大学计算机与信息学院 安徽 合肥 230009)

复杂场景中的遮挡现象会造成目标外观信息损失,致使检测过程中容易出现目标遗漏。通过分析目标表示对特定布局的依赖性,提出一种基于多因素贝叶斯的遮挡目标检测方法。首先,使用部件模型提供目标局部区域的候选提议,然后,根据空间布局关系估计部件的可见性概率,并同时考虑目标部件的外观特征和形变位置,最后,构建基于外观、形变、可见性因素的贝叶斯模型,并采用最大化曲线下方面积设计目标检测评价函数,完成多因素权重学习。实验结果证明在PASCAL数据集中的有效性,优于目标检测的现有方法。

遮挡目标检测 可见性 多因素 贝叶斯

0 引 言

目标检测是通过提取目标的可判别特征,训练获得区分目标和背景的分类器,在图像中确定目标位置的过程[1]。目标检测在视频监控[2]、图像检索[3]等领域有着广泛的应用价值。然而,由于真实世界中多目标之间复杂的空间位置关系,成像过程中存在大量的遮挡现象,致使目标检测丢失。

现有方法在处理遮挡先验,通常使用位置和遮挡类型,如规则网格的区域外观验证[4]、网格二值可见性标记[5]等。然而,上述模型的网格约束较强,无法泛化到不同目标类别的验证中。

目标的组成结构关系,成为目标检测的重要线索,基于结构化表示的部件模型[6]PbM(Part based Model)提供了重要区域的潜在位置估计方法,该方法考虑部件位置偏移作为目标形变处理的数据依据。然而,部件模型在处理遮挡问题时,仍然会出现大量漏检,部件模型及其演化模型Branch-and-Bound(BB)[7], Histogram Sparse Code (HSC)[8], Local Structure HOG and LBP(LS-HOGLBP)[9]等都缺乏对局部部件遮挡的解释能力。

针对部件模型遮挡处理能力的不足,需要部件重构关系,扩展的部件模型研究被展开。例如Grammar[10]模型中支持遮挡情况下的部件推理关系,Ouyang等[11]提出的检测模型中多个目标区域之间的重叠可以通过联合遮挡配置关系验证。但是,上述方法仍然是基于外观的,本质上无法回避外观歧义性。

进一步多目标在成像过程中的空间投影关系,成为部件遮挡评价的重要依据。通过考虑遮挡图像与真实空间的物理投影关系,验证场景布局的遮挡配置,可以实现部件可见性概率的估计,例如3D注释[12]、Poselet[13]、3D Aspectlets[14]等,其中Hsiao等[15]使用物理世界假设,实现局部兴趣点遮挡概率估计,改善了遮挡估计的准确性。但是,上述方法是针对特定的目标类别,在遮挡检测中不具有通用性,并且这些方法缺乏验证部件可见性的结构信息。因此,本文关注在利用部件外观,形变信息的基础上,加入可见性评价来进一步扩展对目标的描述,并采用贝叶斯框架融合多个因素,通过权重优化学习实现多因素贝叶斯的遮挡检测模型。本文的主要创新点如下:

(1) 针对遮挡情况下的部件外观描述不足,提出一种基于目标外观、形变、可见性的多因素目标检测模型,同时考虑可见性所具有的统计特性,采用贝叶斯框架评价各个因素的重要性,实现多因素融合。

(2) 针对外观、形变与可见性特征分布不同,权重难以估计,采用最大化曲线下面积方法,实现了多因素贝叶斯模型的权重优化学习。

(3) 在PASCAL数据上,验证了本文算法在通用目标检测上的执行性能,优于当前先进算法。

1 多因素贝叶斯模型

1.1 目标评价的能量函数

基于部件的模型将目标划分成多个关键部件,并通过对部件之间引入几何约束,使模型在处理目标检测中的形变目标更加鲁棒[6]。然而,该模型并没有考虑遮挡情况下的部件评价。Hsiao等[15]采用物理统计可见性对目标进行遮挡评价,但是该方法缺乏验证部件可见性的结构信息,并且没有对描述部件的多个因素形成统一的目标检测框架。因此我们在结构化表示的基础上提出采用贝叶斯框架评价外观、形变、可见性因素的重要性,并通过权重优化学习获得可靠的目标检测模型。

可见性项被用来估计由遮挡引起的信息不充分,但是它的统计特性不适用于部件模型。为此我们采用贝叶斯框架来评价外观、形变和可见性因素的重要性,并提出一种新的遮挡布局检测评价:

p(Y|d)= pa(Y|da)·pe(Y|de)·pv(Y)=

(1)

其中Y是目标部件的可见性标记,用于描述遮挡配置。yi是第i个部件外观评价下的可见性标记,其数值为1表示该部件外观可见,Npt为目标被划分的部件个数,p(yi|da,i)是外观项的概率,p(yi|de,i)是形变项的概率,p(yi)是可见项的概率。d=(da,de)是外观和形变概率化过程中使用的参数。为了便于模型参数的优化求解,进一步将贝叶斯概率转化为能量函数形式:

ψ(Y;d,ω)=ψa(Y;da)+ψe(Y;de,ωe)+ψv(Y;ωv)=

(2)

其中ψa是外观项,对应为p(yi|da,i)的能量形式,ψe是形变项,对应为p(yi|de,i)的能量形式,ψv为可见性项,对应为p(yi)的能量形式。因为各个因素在目标检测中的贡献不同,我们使用系数ω=(ωe,ωv)来确定各项的重要性。当系数降为0时,表示不需要考虑相应的项,原始的部件模型可以被视为可见项系数极小情况下的模型。在合适的系数下,根据式(2)计算的能量越低的候选框代表越可靠的检测结果。

本文的多因素贝叶斯模型包括3项,分为是外观项ψa(Y;da),形变项ψe(Y;de,ωe),可见性项ψv(Y;ωv)。不同项的能量,使用不同的目标部件描述子进行计算。

(1) 外观项是用来分析目标的外观相似度。我们在部件模型的基础上,采用相似于文献[10]的方法对外观项建模,即p(yi|da,i)=sigmoid(si-da,i),其中si为训练获得的分类边界阈值,da,i∈d是sigmoid函数的平移参数,通过经验期望获得。在能量函数中进一步将外观概率转化为能量形式ψ(yi;da,i)=-log(p(yi|da,i))。

(2) 目标形变项是用来分析目标部件的偏离程度。我们考虑部件位移信息对形变项建模,p(yi|de,i)=sigmoid(de,i-ei),其中ei是部件位置偏移量,平移参数使用训练集的期望平移量de,i=E(ei)。 同时,在式(2)中引入因素权重ωe,将形变项转化为的能量函数形式ψ(yi;de,i,ωe)=ωe·-log(p(yi|de,i))。

(3) 可见性项是用来描述目标部件在遮挡情况下可能引起的目标损失,我们借助物理投影约束对目标可见性建模,采用文献[15]的方法获得可见性概率p(yi),同时在能量函数中引入参数ωv表示该因素的重要性。可见项的能量形式为ψ(yi;ωv)=ωv·(1-yi)·(-log(p(yi)))。显然当部件可见时,即yi=1,该能量为ψ(yi;ωv)=0,即不考虑外观退化因素。

1.2 多因素权重优化

本文模型考虑能量函数中的每个因素为一个弱检测器。为了权衡各个因素的价值,我们在估计各个因素权重的过程中,采用最大化曲线下方面积学习混合模型中的系数[16]。根据式(2),注意到能量最小化与目标判定单调性相反,因此,曲线下方面积评价的求解方式可以定义为:

(3)

本文使用贪婪策略对多因素权重进行优化,并考虑正则项避免权重不均衡,从而有目标函数G(Ψ;f,ω)=‖ω‖2/2-φ(Ψ;F,ω)。训练数据集来自PASCAL数据集并且优化混合权重为ω*=argminωG(Ψ;F,ω)。我们将在实验中进一步分析本文所提出的模型相较其他模型的优势。

2 实 验

为了评价本文所提出的多因素贝叶斯遮挡目标检测模型MFB(Multi-factorBayesianModel)在通用目标中的检测效果,我们在PASCAL2007 数据集上进行实验,并与Grammar[10]、Poselet[13]、部件模型[6]、HSC[8]和LS-HOGLBP[9]作对比,其中Grammar和Poselet模型能够有效处理目标检测中的遮挡现象,而部件模型、HSC、LS-HOGLBP是当前先进的基于部件的目标检测模型。PASCAL2007训练集包含2 501张真实场景的图像,测试集包含4 952张真实场景的图像,测试时目标是预测图像中给定类别的所有目标的GroundTruth窗口。本文中,只有预测窗口与GroundTruth窗口面积重叠超过50%,才判定为正确检测。为了保证公平对比,本文程序和对比方法的程序在同一台PC上在单线程条件下运行,本文PC的配置为IntelCPUi5-3470。所有方法都使用文章的缺省设置。

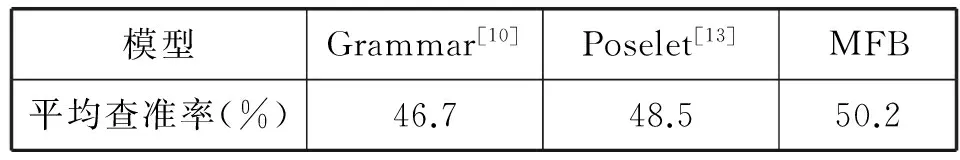

为了验证本文方法能够有效处理目标检测中的遮挡现象,表1给出了MFB模型与Grammar,Poselet在人体类别中的遮挡目标检测结果,可以看出本文方法的表现优于当前先进的遮挡检测方法。进一步具体分析可以得到如下结论:(1)Poselet模型的检测精度比Grammar模型高出1.8%。这是因为Grammar模型在处理遮挡时仅关注部件的外观评价。而Poselet模型从空间布局中入手利用3D点注释选择一致的动作部件,避免了外观本身所具有的歧义性。(2)MFB模型在行人检测上的表现比Poselet模型提高了1.7%。这是因为不同于以上两种模型,MFB模型不仅考虑了部件可见性的物理度量,且通过贝叶斯框架将其与外观,形变因素相结合,采用权重优化学习,发挥了各个因素之间互补作用,从而能够更加有效地处理遮挡情况下的目标检测。

表1 PASCAL数据集中不同模型的人体检测结果

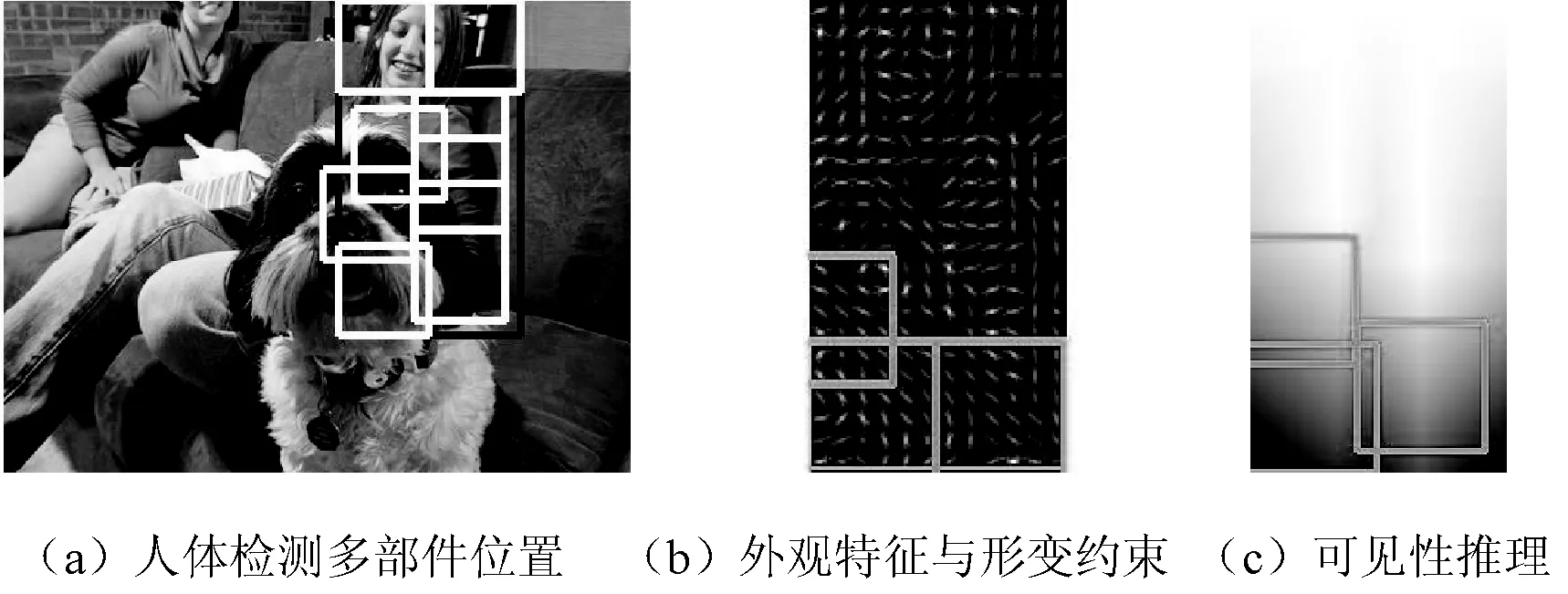

图1给出了PASCAL数据集中遮挡人体检测示例,图中(a)中人体被动物遮挡,部分外观信息丢失。MFB模型采用结构化描述,检测获得目标人体的多部件位置,对应(a)中8个白色的检测框。针对被遮挡严重部件,对应(a)中的左下角三个检测框,(b)中的灰色检测框给出了外观特征与形变约束,在此基础上MFB模型根据空间布局关系进行了可见性推理,如(c)所示,其中从黑色到白色对应可见性从弱到强。

图1 MFB的遮挡人体检测示例

为了进一步评价本文方法在通用目标类别检测上的表现,我们在PASCAL数据库中的20个类别上进行实验,并将MFB模型与部件模型、HSC、LS-HOGLBP作对比。其中HSC和LS-HOGLBP是为了改善低层特征表达。我们同样与Hsiao[15]的模型进行了对比。Hsiao提出使用线性模型将密集的HOG检测与物理统计可见性结合提高遮挡检测表现。为了进行有效的对比,我们转变Hsiao的模型为基于部件的检测,记作可见性的贝叶斯表达BwV(Bayesian with Visibility),也是MFB模型的特殊形式。与此同时,MFB模型可以变化成不同的子模型在特定项的权重为0时,外观的贝叶斯表达BwA(Bayesian with Appearance),形变的贝叶斯表达BwD(Bayesian with Deformation)。我们将部件模型选为基准。

通过在PASCAL数据库上的对比,实验数据说明本文算法在通用目标检测上优于当前先进检测算法。表2给出了不同算法在20类目标中的检测结果,具体分析可以得到以下结论:(1) 本文方法在所有类别上的平均检测精度为41.2%,高于所有比较的模型,这一表现说明了我们提出的模型是有效的,多种因素之间具有互补性。(2) MFB比基准部件模型提高了9.9%,而比HSC和LS-HOGLBP只提高了6.9%,这是因为HSC和LS-HOGLBP模型有效的特征表达使其表现优于部件模型。我们进一步对一些特定类分析,发现在类别如鸟和狗,MFB模型比HSC和LS-HOGLBP只高出1%,这是因为这些类别有较多的变形以及部件等分位点置信度低。而在类别船、自行车和沙发上,MFB提高了9%,这是因为这些目标是刚性的,部件位置更加准确并导致更加可靠的可见性图估计和贝叶斯评价。(3) 为了进一步说明MFB中各个因素的重要性,我们分析了BwD、BwA和BwV在目标检测中的表现,其中BwD的表现比BwV高出了10.3%,BwV的表现比BwA高出了2.9%,可以看出形变因素最重要,外观因素和可见性因素仍有提升空间。而MFB比BwA高出了20%,比BwA高出了17.1%和比BwV高出了6.8%的表现,说明多因素模型和权重估计都是有效的,遮挡目标可以通过多因素贝叶斯模型被有效地检测出。(4) 在时间效率上,基准部件模型每幅图花费2.51秒,HSC模型为4.71秒,MFB模型为5.13秒。这是因为MFB模型中特征的获取需要大量时间。

表2 在20个类别上不同模型的平均查准率

续表2

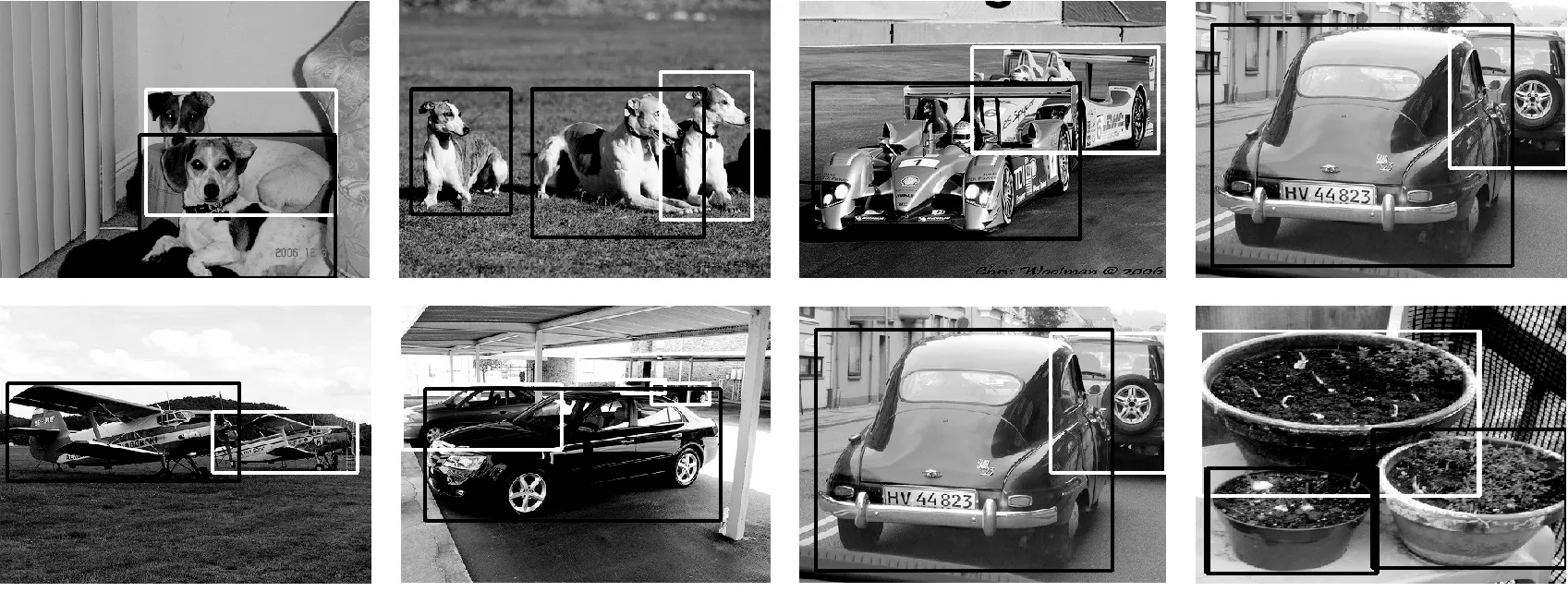

图2进一步给出了MFB与HSC的检测结果。为了公平比较,图2给出的是在每张图像虚警率为0.1情况下的检测结果。黑色框为HSC检测结果,白色框为HSC丢失的检测结果,MFB能够成功检测出所有位置,即相同虚警率情况下遗漏的目标被MFB模型找出。这一结果说明本文提出的多因素贝叶斯模型能够实现多因素的有效融合和遮挡检测的准确性提升。

图2 MFB和HSC在PASCAL上的目标检测结果

3 结 语

针对遮挡检测不准确的情况,提出使用布局关系估计部件可见性,并融合外观,形变因素扩展对目标的描述,解决遮挡情况下由信息损失造成的漏检。本文方法采用贝叶斯框架将外观、形变、遮挡多因素融合,并使用目标检测中的最大化曲线下方面积的评价指标对多因素的权重进行联合优化。实验结果说明在PSACAL数据库上,能够实现优于现有方法的目标检测效果。但是由于场景混杂,导致局部梯度特征无法完全描述目标及其部件,造成漏检情况,因此下一步将集中在利用卷积神经网络特征学习目标部件的外观表示,提高部件定位的准确性,完成更有效的可见性估计,减低由于外观信息丢失,引起的遮挡检测错误。

[1] Pedersoli M,Vedaldi A,Gonzàlez J,et al.A coarse-to-fine approach for fast deformable object detection[J].Pattern Recognition,2015,48(5):1844-1853.

[2] 黄凯奇,陈晓棠,康运锋,等.智能视频监控技术综述[J].计算机学报,2015,38(6):1093-1118.

[3] 黎向阳,吴敏华,施智平.基于Gabor变换域的积分直方图鞋印图像检索[J].计算机应用与软件,2015,32(3):215-219.

[4] Kwak S,Nam W,Han B,et al.Learning occlusion with likelihoods for visual tracking[C]//2011 IEEE International Conference on Computer Vision (ICCV), 2011:1551-1558.

[5] Gao T,Packer B,Koller D.A segmentation-aware object detection model with occlusion handling[C]//2011 IEEE Conference on Computer Vision and Pattern Recognition,Providence,RI,USA,2011:1361-1368.

[6] Felzenszwalb P F,Girshick R B,McAllester D,et al.Object detection with discriminatively trained part-based models[J].IEEE Transactions on Pattern Analysis and Machine Intelligence,2010,32(9):1627-1645.

[7] Kokkinos I.Bounding part scores for rapid detection with deformable part models[C]//Proceedings of the 2012 European Conference on Computer Vision,Florence,Italy,2012:41-50.

[8] Ren X,Ramanan D.Histograms of sparse codes for object detection[C]//2013 IEEE Conference on Computer Vision and Pattern Recognition,Portland,OR,USA,2013:3246-3253.

[9] Zhang J,Huang K,Yu Y,et al.Boosted local structured HOG-LBP for object localization[C]//2011 IEEE Conference on Computer Vision and Pattern Recognition,Providence,RI,USA,2011:1393-1400.

[10] Girshick R B,Felzenszwalb P F,McAllester D A.Object detection with grammar models[C]//Advances in Neural Information Processing Systems 24,Granada,Spain,2011:442-450.

[11] Ouyang W,Zeng X,Wang X.Modeling mutual visibility relationship in pedestrian detection[C]//2013 IEEE Conference on Computer Vision and Pattern Recognition,Portland,OR,USA,2013:3222-3229.

[12] Pepikj B,Stark M,Gehler P,et al.Occlusion patterns for object class detection[C]//2013 IEEE Conference on Computer Vision and Pattern Recognition,Portland,OR,USA,2013:3286-3293.

[13] Zia M Z,Stark M,Schindler K.Explicit occlusion modeling for 3D object class representations[C]//2013 IEEE Conference on Computer Vision and Pattern Recognition,Portland,OR,USA,2013:3326-3333.

[14] Bourdev L,Maji S,Brox T,et al.Detecting people using mutually consistent poselet activations[C]//Proceedings of the 11th European Conference on Computer Vision.Springer,2010:168-181.

[15] Hsiao E,Hebert M.Occlusion reasoning for object detection under arbitrary viewpoint[J].IEEE Transactions on Pattern Analysis and Machine Intelligence,2014,36(9):1803-1815.

[16] Paisitkriangkrai S,Shen C,Hengel A V D.Efficient pedestrian detection by directly optimize the partial area under the ROC curve[C]//2013 IEEE Conference on Computer Vision and Pattern Recognition (ICCV),2013:1057-1064.

DETECTION OF OCCLUSION TARGET BASED ON MULTI-FACTOR BAYES

Niu Yuting Zhang Lihua Wu Kewei Xie Zhao Yang Xingming

(SchoolofComputerandInformation,HefeiUniversityofTechnology,Hefei230009,Anhui,China)

Occlusion in complex scenes can result in loss of target appearance information, which leads to the loss of target in the detection process. By analyzing the dependence of the target representation on a particular layout, a multi-factor Bayesian method for occlusion target detection is proposed. First, a candidate proposal for the target local region is provided using the component model. Then, the visibility probability of the components is estimated according to the spatial layout, and the appearance characteristics and the deformation position of the target components are also considered. Finally, to complete the multi-factor weight learning,a Bayesian model based on appearance, deformation and visibility factors is constructed, and the area under the maximum curve is used to design the target detection and evaluation function. The experimental results demonstrate the effectiveness of the PASCAL data set, which outperforms the existing methods of target detection.

Occlusion target detection Visibility Multi-factor Bayes

2016-01-19。国家自然科学基金项目(61273273,61503111,61501467)。牛玉婷,硕士生,主研领域:计算机视觉。张丽华,副教授。吴克伟,讲师。谢昭,副研究员。杨兴明,副教授。

TP391.41

A

10.3969/j.issn.1000-386x.2017.04.032