缩微智能车目标检测系统的设计与仿真

刘衍珩,高思伟,王 健,邓伟文

(1.吉林大学计算机科学与技术学院,长春 130012;2.吉林大学符号计算与知识工程教育部重点实验室,长春 130012;3.吉林大学汽车仿真与控制国家重点实验室,长春 130012)

缩微智能车目标检测系统的设计与仿真

刘衍珩1,2,3,高思伟1,2,王 健1,2,3,邓伟文3

(1.吉林大学计算机科学与技术学院,长春 130012;2.吉林大学符号计算与知识工程教育部重点实验室,长春 130012;3.吉林大学汽车仿真与控制国家重点实验室,长春 130012)

为实现对车辆前方目标检测,提出并模拟了一种对缩微智能车前方目标进行检测的方案.在交通沙盘中,搭载ARM9开发板的缩微智能车,通过多种传感器数据融合采集缩微智能车的前方目标信息,然后再对数据进行集中处理.处理过程包括对视觉数据进行行人识别、对雷达数据进行目标状态分析,以及对通信数据进行分包,最后将数据包发送到监控平台完成前方运动目标信息的实时显示.仿真结果表明:该系统实现了对缩微智能车前方目标信息的实时采集,其采集精度和系统稳定性优于传统的目标运动信息采集系统.

前方目标检测;缩微智能车;目标检测;多传感器

随着嵌入式系统、智能控制技术的发展,缩微智能车已被广泛应用于智能交通系统.缩微智能车在将真实车辆按一定比例缩小的基础上,集中运用了自动控制、人工智能、计算机视觉等技术以实现信息采集、数据处理、数据融合,最终达到车辆的自主驾驶,包括超车、避障、识别交通标志、车道线以及自主泊车等目的.文献[1]将系统划分为五大模块:激光数据处理、视觉数据处理、传感器融合、信息决策和控制,各模块通过数据接口进行数据通信.国外有关智能车的研究设计[2-6]也提出了相似的层次系统.在国内,清华大学研制的THMR-V[7]和国防科技大学研制的CITAVT-IV[8]都分别设计了不同的子系统架构.相较于传统的软件模拟方式,该技术具有更强的真实性和可展示性,提供了更贴近真实环境的车体模型和道路模型,同时兼具了软件模拟的可重复性、可评价性、易修改性的优势.相较于实车场地实验,该技术具有实验成本较低、易于维护、风险低、可模拟大规模车辆等优点.

目标检测是缩微智能车的重要组成部分之一,交通参数(车流量、车速等)采集、车型识别分类以及车辆目标的跟踪等都直接依赖于车辆目标的检测识别结果[9].通过传感器的环境感知,可以实现对车辆行驶前方的障碍物的检测.由于单一传感器获取的信息受限,因此在缩微智能车中引入多传感器融合技术,避免单一传感器的信息盲区,提高了多源信息处理结果的质量,有利于对事物的判断和决策[10].在融合算法的实现过程中,来自不同传感器的信息在时间和空间上存在差异,因此该技术的难点在于如何将零散的多源碎片信息整合成为一帧紧密关联的信息数据.

本文提出并实现了一种合理、高效和真实的缩微智能车实验平台的方案,选用激光雷达、摄像头以及无线通信等多种传感器采集行驶前方目标的数据,对数据进行融合处理并产生可视化的数据实时显示.实验数据表明,该方案能通过对多传感器数据融合达到对缩微智能车前方目标实时检测的目的.

1 系统设计

1.1系统架构

该平台的架构如图1所示,搭载ARM9开发板的缩微智能车通过摄像头、激光雷达采集行驶前方的目标信息,通过车辆内部控制器采集智能车的行驶参数.这些信息和参数通过简单的数据预处理后,视觉数据用于行人检测,雷达数据用于障碍物信息提取,最后经过处理的传感器数据按照规定的数据格式通过基于IEEE802.11a协议的WiFi路由器发往服务器数据处理系统.最后,服务器数据处理系统对接收的数据进行解码,并将来自同一辆小车的多个数据源的数据融合成一帧完整的目标检测信息并保存于数据存储系统.除此之外,服务器数据处理系统还提供数据分析和可视化显示道路目标信息的功能.

1.2客户端数据采集系统

数据采集模块分为3个部分:摄像头模块、雷达模块和车辆内部信息模块.摄像头模块不断捕获小车正前方的视频信息,并对每帧图像数据进行行人等检测处理.雷达模块利用激光雷达不断扫描小车正前方4 m范围内的障碍物信息,并对获得的连续多帧数据进行目标信息提取,包括计算目标障碍物的速度矢量、移动方向、物体宽度以及距离等信息.车辆内部信息模块通过智能车内部信息采集接口,周期性地向智能车内部控制器发送请求,控制器返回车辆当前的状态信息.缩微智能车和传感器如图2所示.

1.2.1视频模块与行人识别算法

采用V4L2(video four Linux two)方式采集视频数据,它是Linux操作系统提供的用于采集图片、音频和视频的API接口.并使用内存映射方式(memory map,MMAP)来获取连续多帧图像,作为行人识别的数据源.方向梯度直方图(histogram oforiented gradient,HOG)特征是一种在图像处理中用来进行物体检测的特征描述子.它通过计算图像局部区域的梯度方向直方图来构成特征.HOG特征结合SVM分类器已经被广泛应用于图像识别中,尤其在行人检测中获得了极大的成功.HOG+SVM进行行人检测的方法[11]由法国研究人员Dalal在2005年的CVPR上提出,而如今虽然有很多行人检测算法不断提出,但基本都是以HOG+SVM的思路为主.该方法的优点在于:1)由于HOG是在图像的局部方格单元上操作,因此它对图像几何的形变和光学的形变都能保持很好的不变性.2)在粗的空域抽样、精细的方向抽样以及较强的局部光学归一化等条件下,只要行人大体上能够保持直立的姿势,可以容许行人有一些细微的肢体动作,这些细微的动作可以被忽略而不影响检测效果.HOGDescriptor类型变量用以保存提取的HOG特征矢量,然后调用hog描述子的setSVMDetector方法给对HOG特征进行分类的SVM模型的系数赋值,最后调用hog类的方法detectMultiScale对图像变量进行多尺度检测.经过多次实验验证,行人检测的最佳参数设置是,3×3细胞/区间、6×6像素/细胞、9个直方图通道.行人目标阈值设置为最大值0,滑动窗口每次移动的距离为8×8,图像的扩充大小为32×32.实验结果表明,该算法在区分行人与障碍物和多行人检测的情况下均有良好的检测效果.

1.2.2激光雷达模块与目标信息提取算法

本系统采用的激光雷达为HOKUYO AUTOMATIC公司的型号为URG-04LX的二维激光扫描测距仪,参数如表1所示.

表1 URG-04LX激光雷达参数Table 1 URG-04LX's parameters

激光雷达模块需要完成障碍物判断,计算障碍物的宽度信息、速度信息以及运动方向等功能.障碍物判断可以通过对距离信息进行区域分割法完成[12].首先将距离信息分割成不同的区域,如果连续2个扫描点的距离信息小于某个阈值,就认为这2个扫描点属于同一个区域.反之,数据帧就视为从该处不再连续,从而实现在场景中判断障碍物的目的.阈值计算公式为

式中:threshold为阈值(mm);max_dis为雷达最大精确距离,可达4 000 mm.

程序中还定义了结构体Object用来保存被检测出的物体的信息,包括如下参数:first_ang:逆时针方向第一个点的角度,相对于右侧0度;last_ang:逆时针方向最后一个点的角度;shortest_ang:垂直距离最近的那个点的角度;first_dis:逆时针方向第一个点与本车的直线距离;last_dis:逆时针方向最后一个点与本车的直线距离;shortest_dis:垂直距离最近的点与本车的直线距离;first_offset:逆时针方向第一个点在数组中的序列;last_offset:逆时针方向最后一个点在数组中的序列;shortest_offset:最近点在数组中的序列;object_width:物体的宽度;longitudinal_ speed:相对于小车的纵向速度;lateral_speed:相对于小车的横向速度;max_points:扫描点的总数.利用三角函数和距离公式计算出障碍物的宽度、方位以及速度信息.物体宽度的计算公式为

障碍物的速度矢量需要通过比较连续2帧数据的信息来计算,设在pre_stamp时间捕获第1帧数据D1,在last_stamp时间捕获第2帧数据D2.若D1和D2中存在一对障碍物object1和object2的宽度数据分别为object_width1和object_width2,若满足

则object1和object2为同一物体.然后利用该物体的位移变化计算出相对小车的纵向速度longitudinal_ speed以及横向速度Lateral_speed:

1.2.3车辆内部信息模块

智能车的光电编码器可以计算小车当前速度的信息.首先测出智能车程序中中断时间内的累加脉冲量,然后通过计算单位时间内的编码输出脉冲来计算小车的速度.在程序中,中断时间被设置为0.01 s,则可设x为这0.01 s的雷达脉冲量.令智能车轮胎齿轮和光电编码器齿轮的传动比为a,轮胎的周长为c,采用的光电编码器为b脉冲/s,于是速度υ(m/s)为

传动比a为定值0.342 1,b为100,轮胎周长c为0.157 m,因此可以将智能车的速度公式简化为

1.2.4通信协议

根据传输数据的类型可以定义3个数据包类型:MyProtocolCarData类、MyProtocolCameraData类和MyProtocolUrgData类,分别对应车内部信息数据、摄像头信息数据、激光雷达信息数据,它们继承了一个共同父类MyProtocol类,MyProtocol类包含了客户端数据包的基本信息.协议数据类如图3所示.

1.3服务器数据处理系统

首先,服务器数据处理系统实时接收来自不同小车客户端的数据,并统一来自不同传感器的数据包的时间信息,修正与时间相关的距离信息.其次,完成激光雷达的检测目标与摄像头识别目标的融合.最后,将完全融合的一帧基于时间戳的局部交通信息显示并同时保存在数据库.

1.3.1时间统一与数据纠正

在进行多传感器数据融合之前,系统需要统一多种传感器的时间信息.为了实现数据显示的实时性,本系统采用接收时间戳作为数据帧的时间戳,因此会产生收发时延.假设3种数据源的收发时延分别为Δturg、Δtcamera、Δtcar.收发时延包括采集与处理时延和传输时延,在保证实验环境无线网络稳定的前提条件下,传输速率具有极高的效率,一般情况传输时延小于0.1 s,因此需要纠正激光雷达获取的目标位置信息.设传输时延为Δt,纠正后的目标距离信息为distance′,则distance′可以表示为其中FirstAng变量描述了目标的方位信息,可以通过目标偏移量left_offset和right_offset计算.位移的改变也会影响目标的方位信息,因此也需要对FirstAng变量进行纠正,设纠正后的目标方位信息为FirstAng′,且

因为反正切函数会得到2个结果,所以还需要对纠正后的角度信息进行判断:FirstAng≥90°,则FirstAng′≥90°;FirstAng<90°,则FirstAng′<90°.

再考虑采集与处理时延对系统的影响,假设激光雷达目标信息检测时延、摄像头行人检测时延以及智能车光电编码器信息采集时延分别为Δturg′、Δtcamera′、Δtcar′,经过反复实验验证,Δturg′=0.1 s、Δtcamera′=0.3 s、Δtcar′<0.01 s.因此Δturg=Δturg′+ Δt=0.2 s、Δtcamera=Δtcamera′+Δt=0.4 s、Δtcar=Δtcar′+Δt=0.11 s,在接收端分别设置了3个数据缓冲区urg_data、camera_data和car_data,接收线程将不同类型的数据包分类并不断刷新缓冲区中的数据,同时采集线程每隔Δtget从3个缓冲区中各取走最近一次更新的数据.为了减小收发时延带来的时间误差,在不影响系统性能的前提下本文选取Δturg、Δtcamera和Δtcar的公倍数作为Δtget,这里分别将Δtget设置为0.2、0.4、0.8、1.2 s来进行性能分析,将每隔Δtget从3个缓冲区取得的数据的时间戳进行比较,任意一次取得的任意2个时间戳的差值大于0.1 s的一帧数据视为错误帧,经过反复实验,得到的错误帧率分别为100%、21.7%、1.2%、0.6%.由此可见,将Δtget设置为0.8 s既可以达到降低误帧率的目的,又可以不影响系统的性能.

1.3.2激光雷达数据与摄像头数据融合

为了融合激光雷达获取的目标信息与摄像头获取的视觉信息,需要完成对这2种传感器到车辆坐标系的转化,推导出激光雷达和摄像头坐标系之间的转换关系.采用了一种摄像机和单线激光雷达联合标定的新方法,只需要将特定标定板摆放在载体正前方,利用激光雷达和摄像机采集一次数据就可实现摄像头、激光雷达和车体构成的整个系统的标定[13].首先需要确定激光雷达坐标系Curg与车辆坐标系Ccar的转换关系,设激光雷达坐标下有一点Purg=(xurg,yurg,zurg)T,在车辆坐标系中有对应坐标Pcar=(xcar,ycar,zcar)T,它们之间的转换关系满足

式中:Turg→car为激光雷达的安装位置在车体坐标系中的坐标,可以通过简单的测量获取;Rurg→car为Curg相对于Ccar的旋转矩阵,依次由绕x轴旋转的俯仰角α和绕z轴旋转的偏转角φ构成,该矩阵可表示为

俯仰角α、偏转角φ的说明和具体计算方法见文献[13].

设摄像头坐标下一点Pcam=(xcam,ycam,zcam)T,在车辆坐标系中有对应坐标Pcar=(xcar,ycar,zcar)T,它们之间的转换关系满足

式中Tcam→car为摄像头的安装位置在车体坐标系中的坐标,可以通过简单的测量获取.

Rcam→car是Ccam相对于Ccar的旋转矩阵,它由旋转矩阵Rpla→car和Rpla→cam组成,Rpla→car表示棋盘格坐标系到车辆坐标系的旋转矩阵,Rpla→cam表示棋盘格坐标系到摄像头坐标系的旋转矩阵.Rpla→car和Rpla→cam的说明和具体计算方法见文献[13].

根据激光雷达到车辆坐标系的转换参数[Rurg→car,Turg→car]和摄像头到车辆坐标系的转换参数[Rcam→car,Tcam→car]可以对2个传感器进行联合标定,获取摄像机和激光雷达坐标系的转换参数.由式(12)可以推导出

把式(10)和式(11)代入式(13),可以推导出激光雷达到摄像头坐标系的转换关系

得到激光雷达到摄像头坐标系的转换参数Rurg→cam和Turg→cam分别为

通过式(14)激光雷达检测的目标可以投影到摄像头的坐标系中,在行人检测的检测集合中找到相应目标,实现摄像头数据与激光雷达数据的融合.

1.3.3车辆定位

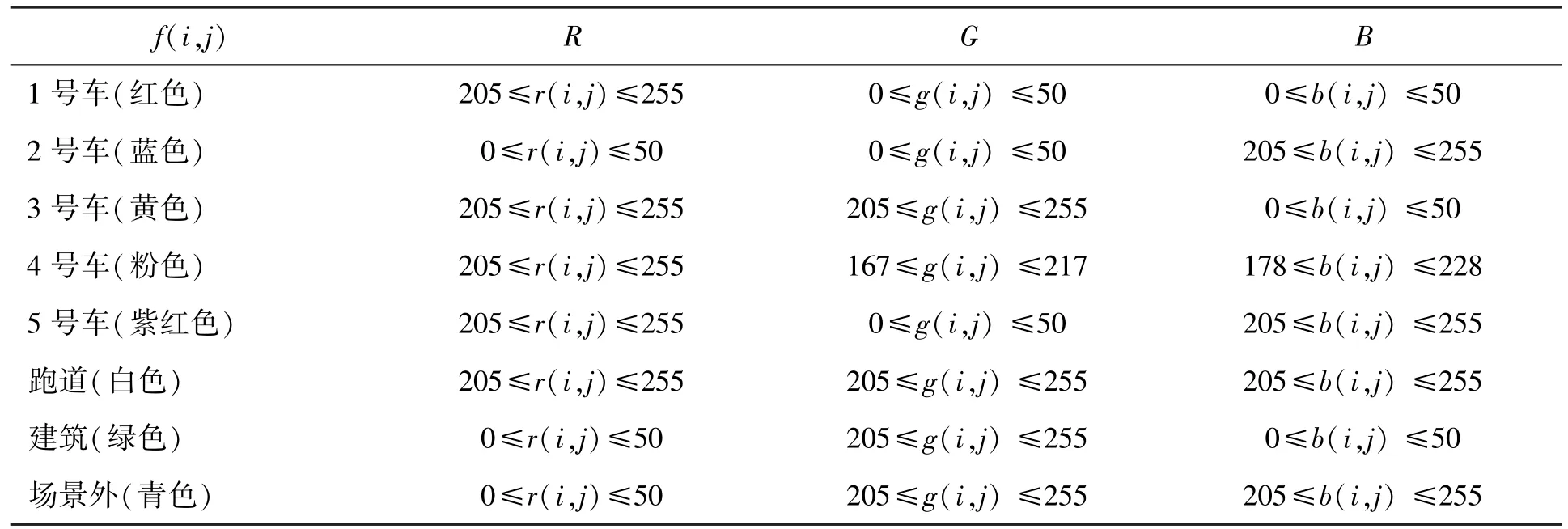

借助摄像头和雷达传感器可以获取图像数据和扫描数据,但为了获取缩微车在实验场景中的位置、速度及姿态等信息,还需要辅之以导航定位系统,常用的有GPS导航和惯性导航系统(inertial navigation system,INS).但导航定位系统并不适用于缩微实验平台,因此本系统提供了一种通过摄像头识别确定缩微车在沙盘中位置的方法.通过一部架设在沙盘正上方3 m高处的摄像头,获取整个实验环境的图像数据.实验场景分为3个部分:青色部分为场景外区域,是不可通行区域;白色部分为车辆跑道,分为十字路口区域和道路区域,都为可通行区域;绿色部分为建筑区域,为不可通行区域.首先用摄像头捕获一张没有小车的背景图片;然后将每部缩微车都用一种特定的颜色标识,分别选用红色、蓝色、黄色、粉色以及紫红色作为缩微车的颜色标识;最后通过设置合适Iplimage图像数据中像素的RGB值将特定颜色的小车从整个图像中识别出来,并定位出小车在轨道中的坐标.通过循环读取每张图像中每个像素点f(i,j)的RGB值r(i,j)、g(i,j)、b(i,j)与事先设定好的RGB阈值比较来达到识别的效果,表2显示了实验场景和缩微车的RGB阈值.通过记录识别出所有像素点的坐标值的平均值,得到待识别缩微车的当前坐标并将其画在背景图上.测试的过程中将一个红色标记物放置在待检测小车的车头,识别出的小车用红色方块表示,右侧为顶部摄像头捕获的视频,左侧为识别效果.识别的对比图如图4所示,检测精度为±8 mm.

表2 实验场景与缩微车的RGB阈值Table 2 RGB of experimental environment and miniature cars

2 实验

实验场景以真实城市车道为原型按比例缩放而成,场景内还可放置小人和障碍物.实验环境与真实环境的参数对比如表3所示,按比例缩放保证了模拟实验获取的数据的真实性和准确性.

表3 实验环境与真实环境参数对比Table 3 Comparison of the parameters of experimental environment and real environment

如表2所见,缩微智能车和实验场景的车道宽度按1∶10的比例缩放了真实车辆和真实环境.而根据《中华人民共和国道路交通安全法实施条例》,城市公路机动车的最高行驶速度约为40 km/h,即10 000 mm/s,按照比例本文将缩微智能车的最高行驶速度设定为1 000 mm/s.当机动车以40 km/h的速度行驶时的最大行车视距约为40 m,即40 000 mm,按照比例本文将缩微智能车的最大行车视距设定为4 000 mm.

启动程序之后,服务器可以实时显示整个沙盘和当前小车的目标检测信息和车辆状态信息,如图5(a)所示,表4展示了融合后的一帧数据在服务器上的数据显示效果,红色色块代表当前小车,黑色圆形色块代表障碍物,黑色三角形色块代表行人.图5(b)的曲线为当前小车的速度变化曲线,纵坐标表示小车当前时间的车速,横坐标表示当前时间,该曲线每隔0.8 s进行一次重绘,可以反映连续时间段小车的速度的变化情况.

交通沙盘除了显示当前缩微车的目标检测信息和车辆状态信息,还可以动态显示场景中全部缩微车的局目标检测信息和车辆状态信息,该模式下实验车队的全部实验车的目标检测信息都将显示在交通沙盘中,如图6所示.红色色块、蓝色色块、黄色色块、粉色色块以及紫红色色块分别代表5辆实验小车,黑色圆形色块代表非行人目标,黑色三角形色块代表行人目标.与文献[14]所提供的车载雷达目标跟踪方法相比,该系统不仅能获得前方目标的运动状态信息,还可以获得传感器缩微车的运动状态信息,同时在区分静止目标与运动目标的基础上利用摄像头与雷达融合后的数据更能区分行人目标和非行人目标,使局部交通信息更加全面.

表4 当前小车的局部交通信息Table 4 Local traffic information for current car

上述实验结果验证了该设计方案的正确性,实现了对1辆或多辆缩微车行驶道路前方目标的状态信息采集与显示.通过连续多帧的激光雷达数据计算得到的检测目标的类型信息(行人目标或非行人目标)、距离信息、宽度信息、速度矢量以及方位信息与真实情况相符,相较于常用的毫米波雷达目标检测具有更高的检测精度和更广的检测范围.融合后的数据帧相较于多数据源的单纯叠加,去除了大量数据冗余,提高了系统实时显示的效率.

实验中,一方面,采用搭载多传感器的采集缩微车(后车)跟踪正前方的缩微车(前车)得到跟踪算法的测量值;另一方面,利用前后车光电编码器返回的相对大地坐标系的绝对运动状态信息可以计算前车在后车坐标系中的相对运动状态,并以该结果作为跟踪算法的真实值,最后通过比较前后车相对运动状态信息的真实值与跟踪算法的测量值验证算法的测量精度.本文实现了文献[14]提出的利用ESR毫米波雷达的跟踪算法,比较了ESR跟踪算法和本文提出的URG跟踪算法的检测精度.

采用该算法检测0~20 s内目标的运动轨迹如图7所示.通过顶部摄像头获取的前车真实的运动轨迹在图7中用蓝线表示,而通过ESR和URG采集的距离信息和运动方向信息绘制的运动轨迹在图7中分别用绿线和红线表示.

在前车跟踪的过程中,ESR算法的最大距离测量误差为13.65%,平均距离测量误差为7.47%,URG算法的最大距离测量误差为6.41%,平均距离测量误差为2.96%.

算法采集的宽度信息与实际测量的缩微车宽度信息的对比效果如图8所示.

ESR算法对运动中的宽度为170.77 mm的缩微车的宽度检测最大误差值为20.22 mm,最大误差为11.84%,宽度检测平均误差值为12.83 mm,平均误差为7.51%.URG算法的宽度检测最大误差值为8.99 mm,最大误差为5.26%,宽度检测平均误差值为4.88 mm,平均误差为2.86%.

算法采集的前后车相对横纵向速度信息与前后车实际的相对速度信息的对比效果如图9所示.

ESR算法采集的相对纵向速度与前后车实际的相对纵向速度的最大误差值为6.23 mm/s,最大误差为20.31%,平均误差为12.46%.URG算法的相对纵向速度的最大误差值为3.13 mm/s,最大误差为8.31%,平均误差为5.75%.ESR算法采集的相对横向速度与前后车实际的相对横向速度的最大误差值为1.53 mm/s,最大误差为10.28%,平均误差为8.81%.URG算法的相对横向速度的最大误差值为1.05 mm/s,最大误差为6.72%,平均误差为5.54%.

由此可见,本文提出的算法相较于文献[14]具有更高的检测精确度,同时还能获取更详细的目标信息用于局部环境感知中的目标分类.

最后还需要考虑检测环境的变化对算法精确度的影响,例如:对多目标的检测、缩微车的速度变化以及样本距离的变化.算法采集的距离信息是目标状态信息的最基本信息之一,可以通过分析目标检测算法的距离测量误差来验证系统的稳定性.在缩微车静止时对不同距离的单个检测样本的检测情况如图10(a)所示,在不同车速下对同距离的单个检测样本的检测情况如图10(b)所示,在缩微车静止时对同距离的不同检测样本个数的检测情况如图10(c)所示.

如图10(a)所示,当样本距离大于4 000 mm时,由于超出激光雷达的理论测距范围,算法的测距误差将持续升高,但在4 000 mm之内都具有良好的稳定性,满足了缩微智能车对行车视距的要求.如图10(b)所示,尽管测距误差随着缩微车车速的增加而持续升高,但当缩微车车速达到实验要求的最高车速1 000 mm/s时,测距误差仅为6.24%.如图10(c)所示,将检测样本的个数从0个逐渐提高至15个,测距误差的值并未出现较大波动,故可说明在0~15个检测样本的范围内,该算法具有良好的稳定性.而15个检测样本已经可以满足真实环境中对道路目标的检测.综上所述,该算法在目标检测方面具有较好的稳定性,且相对于单传感器目标检测的精确度有较大提升.

3 结论

1)提出了一种缩微智能车环境感知系统的设计方案:利用激光雷达、摄像头以及智能车光电编码器这3类传感器各自优点,使采集的数据更加全面,并对采集的数据进行了简单的处理与融合,形成一帧基于时间的局部交通环境数据包并保存在数据库中,最后实现了可视化的局部交通信息的显示.

2)实验结果表明:采用URG激光雷达的检测算法获取的运动目标状态信息精确度更高,在改变检测目标的距离和数量以及采集缩微车的运动速度的情况下,检测结果均稳定收敛.

[1]PATZ B J,PAPELIS Y,PILLAT R,et al.A practical approach to robotic design for the DARPA urban challenge[J].Journal of Field Robotics,2008,25(8):528-566.

[2]KAMMEL S,ZIEGLER J,PITZER B,et al.Team annie way's autonomous system for the 2007 DARPA urban challenge[J].Journal of Field Robotics,2008,25(9): 615-639.

[3]BOHREN J,FOOTE T,KELLER J,et al.Little Ben:the Ben Franklin racing team's entry in the 2007 DARPA urban challenge[J].Journal of Field Robotics,2008,25(9):598-614.

[4]THRUN S,MONTEMERLO M.Stanley:the robot that won the DARPA grand challenge[J].Journal of Field Robotics,2006,23(9):661-692.

[5]RAUSKOLB F W,BERGER K,LIPSKI C,et al.Caroline:anautonomouslydrivingvehicleforurban environments[J].Journal of Field Robotics,2008,25(9):674-724.

[6]URMSONC,ANHALTJ,BAGNELLD,etal.Autonomous driving in urban environments:boss and the urban challenge[J].Journal of Field Robotics,2008,25(8):425-466.

[7]张朋飞,何克忠,欧阳正柱,等.多功能室外智能移动机器人实验平台-THMR-V[J].机器人,2002,24(2): 97-101.ZHANG PF,HEKZ,OUYANGZZ,etal.Multifunctional intelligent outdoor mobile robot testbed-THMR-V[J].Robot,2002,24(2):97-101.(in Chinese)

[8]孙振平,安向京,贺汉根.CITAVT-IV——视觉导航的自主车[J].机器人,2002,24(2):115-121.SUN Z P,AN X J,HE H G.CITAVT-IV—a autonomous land vehicle navigated by machine vision[J].Robot,2002,24(2):115-121.(in Chinese)

[9]刘志宇,王冠军.智能交通检测系统中动态目标检测方法研究[J].计算机应用与软件,2010,27(1):29-31.LIU Z Y,WANG G J.On moving object detection in intelligent transportation detecting system[J].Computer Applications and Software,2010,27(1):29-31.(in Chinese)

[10]周锐,申功勋,房建成,等.多传感器融合目标跟踪[J].航空学报,1998,19(5):536-540.ZHOU R,SHEN G X,FANG J C,et al.Target tracking based on fusion of multi-sensor[J].Acta Aeronautica et Astronautica Sinica,1998,19(5):536-540.(in Chinese)

[11]TRIGGS N D B.Histograms of oriented gradients for human detection[J].Cvpr,2005,1(12):886-893.

[12]陈凤东.基于认知地图的移动机器人自主导航技术研究[D].哈尔滨:哈尔滨工业大学,2009.CHEN F D.Mobile robot autonomous navigation based on cognitivemap[D].Harbin:HarbinInstituteof Technology,2009.(in Chinese)

[13]彭梦,蔡自兴.一种基于双平行平面的激光雷达和摄像机标定方法[J].中南大学学报(自然科学版),2012,43(12):4735-4742.PENG M,CAI Z X.A practical method for calibration of laser radar and camera based on double parallel planes[J].Journal of Central South University(Science and Technology),2012,43(12):4735-4742.(in Chinese)

[14]高振海,王竣,严伟,等.车载雷达目标跟踪及运动状态分类方法[C]//中国汽车工程学会.中国汽车工程学会年会论文集:2015年卷.上海:中国汽车工程学会,2015:491-494.GAO Z H,WANG J,YAN W,et al.Development of target tracking and motion state classification algorithm for vehicle-borne radar[C]//2015 SAE-China Congress& Exhibition.Shanghai:SAECCE,2015:491-494.(in Chinese)

(责任编辑 吕小红)

Design and Implementation of Target Detection System for Miniature Intelligent Vehicles

LIU Yanheng1,2,3,GAO Siwei1,2,WANG Jian1,2,3,DENG Weiwen3

(1.College of Computer Science and Technology,Jilin University,Changchun 130012,China;2.Key Laboratory of Symbolic Communication and Knowledge Engineering of Ministry of Education,Jilin University,Changchun 130012,China;3.State Key Laboratory of Automotive Simulation and Control,Jilin University,Changchun 130012,China)

In order to realize forward target detection,a detecting system for miniature intelligent vehicles has been proposed.On traffic sand table,miniature intelligent vehicles based on ARM9 gather the forward target information through various sensors,and then utilize these data for various purposes.The visual data is used for the pedestrian recognition,and the radar data is used for target motion analysis.Finally,ARM9 send the collected data to the monitor for real-time processing and demonstration.The simulation results show that the miniature intelligent vehicles realize the real-time context-awareness and it can get higher precision and stability than traditional system.

forward target detection;miniature intelligent vehicle;target detection;various sensors

TP 399

A

0254-0037(2016)10-1509-10

10.11936/bjutxb2016030027

2016-03-13

国家自然科学基金资助项目(61572229)

刘衍珩(1958—),男,教授,博士生导师,主要从事网路通信与安全方面的研究,E-mail:yhliu@jlu.edu.cn