结合GLCM与三阶张量建模的在线目标跟踪

金广智 石林锁 崔智高 刘 浩 牟伟杰

结合GLCM与三阶张量建模的在线目标跟踪

金广智 石林锁 崔智高*刘 浩 牟伟杰

(第二炮兵工程大学502教研室 西安 710025)

为提高目标跟踪算法对多种目标表观变化场景的自适应能力和跟踪精度,论文提出一种结合灰度共生(GLCM)与三阶张量建模的目标优化跟踪算法。该算法首先提取目标区域的灰度信息,通过GLCM的高区分度特征对目标进行二元超分描述,并结合三阶张量理论融合目标区域的多视图信息,建立起目标的三阶张量表观模型。然后利用线性空间理论对表观模型进行双线性展开,通过在线模型特征值描述与双线性空间的增量特征更新,明显降低模型更新时的运算量。跟踪环节,建立二级联合跟踪机制,结合当前时刻信息通过在线权重估计构建动态观测模型,以真实目标视图为基准建立静态观测模型对跟踪估计动态调整,以避免误差累积出现跟踪漂移,最终实现对目标的稳定跟踪。通过与典型算法进行多场景试验对比,表明该算法能够有效应对多种复杂场景下的运动目标跟踪,平均跟踪误差均小于9像素。

目标跟踪;灰度共生;三阶张量;线性空间;在线跟踪

1 引言

目标跟踪是计算机视觉的重要领域,也是智能视频监控的重要环节,具有重要的研究意义和良好应用前景。然而,在实际的动目标跟踪过程中,随着时间的推移目标表观往往会出现遮挡、光照、尺度等各种复杂的变化,对跟踪算法的稳定性和准确性均带来了极大的挑战,因此,需要寻求一种跟踪精度高且适用多场景的目标跟踪算法[1]。

针对该需求,许多学者开展了深入的研究,提出了一系列的跟踪算法,其中粒子滤波跟踪框架由于精度高、不受系统线性和噪声高斯假设的限制,也受到了越来越多的关注。在该框架下,文献[2]提出了利用在线观测数据学习自适应子空间外观模型的方法,较传统的观测数据学习方法能更好地适应目标表观的变化。文献[3]和文献[4]研究数据均值对在线子空间表观模型的影响,寻找到了在线表观模型合适的特征值,有效降低了算法在模型更新时的运算量。文献[5]将高阶张量的阶数定义为数据模型的索引数目,每一个索引被看作张量的一个子模式,并将其成功地应用到了计算机视觉领域。文献[6,7]基于多重线性空间元理论,提出的模型增量更新方式能更真实地反映目标表观的实时变化,成功应用到了目标跟踪领域。但是,以上方法使用的是单视图的目标表观模型,容易受外界环境变化的影响,难以应对目标的姿态、尺度等多种表观变化场景,且无论模型是否更新都易导致跟踪漂移。

本文以灰度共生矩阵(Gray-Level Co- occurrence Matrix, GLCM)与三阶张量理论为基础,通过三阶张量表观模型、双线性空间下的增量学习更新及粒子滤波下的二级联合跟踪来最终锁定目标位置。该算法可以在保证跟踪精度的基础上,有效应对遮挡、光照、尺度变化等多种复杂场景下的动目标跟踪。

2 基于GLCM的三阶张量表观模型

建立目标表观模型,主要包括目标线索特征提取、目标表观模型的构建与目标的模型更新共3部分。与跟踪领域的其他方法不同,本文利用灰度共生矩阵对目标区域的代表性特征进行二元超分描述,进一步提高表观模型的稳定性,并结合三阶张量的理论优势,集成目标的多视图信息,同时借助双线性空间理论,提出建立在线表观模型的方法,以更好地描述跟踪过程中表观的动态变化。

2.1 二元GLCM特征超分提取

构建目标表观模型,应选取稳定性好、辨识度高的特征,而灰度特征运算方便,在光照无剧烈变化时可以较好地描述目标表观,但在光照强度发生较大变化时,其对目标与背景的区分能力显著下降。与之相反,纹理特征受光线变化影响较小。GLCM[8]以灰度特征为基础,反映了图像灰度关于方向、相邻间隔、变化幅度等多方面的综合信息,可通过多种角度来对目标的纹理特征进行描述,同时兼具了灰度特征运算方便的优点。

熵ENT表示图像包含信息量的随机性度量,代表了纹理的复杂程度,无纹理时,熵为0,满纹理时,熵值最大;对比度CON表示图像纹理的清晰程度,代表沟纹的深浅,其值越大纹理越清晰。

(2)对细分后的像素块分别提取灰度信息,通过运算得到其灰度共生矩阵GLCM,并进行归一化;

(4)当/5,/5余数不足5时,即图像边缘像素块,令余数为,当取值为3到5时,空缺像素用最邻近像素补齐,当取值为1到2时,舍弃对该像素的超分运算。

2.2 三阶张量表观模型的构建

在对目标进行特征提取后,需通过恰当的方式对目标进行表示。本文使用三阶张量描述跟踪序列图像中的目标,张量的前两个模式是空域模式,本文即指超分矩阵与,在描述独立线索的同时,也融合了基于该目标线索的空域信息;第3个模式则可索引目标的其他有效信息,进一步拓展该线索的有效信息量,本文通过引入目标有限时刻的连续观测数据,引入基于该目标线索的多视图信息,组成表观模型的第3个模式。

假设共提取种线索对目标进行建模,那么在各帧图像中相对的第条线索的观测信息可记为,,另取连续时间内的帧图像得到第条线索的连续观测信息集,表示为三阶张量形式,则可得到第条线索的目标三阶张量表观模型,并分别建立关于熵ENT和对比度CON的三阶张量表观模型。以对比度CON为例,如图1所示。

图1 三阶张量表观模型

2.3 双线性空间下的增量特征更新

引入多维线索建立的三阶张量表观模型势必会带来运算量的大幅提升,为缓解该不足,利用双线性空间[12]理论对表观模型进行展开,并对其进行模型增量特征更新。

(1)双线性空间展开:实际场景中的目标表观变化在有限时间内可认定其服从线性变化理论,可引入双线性空间,对目标模型进行展开,这样便可利用线性空间的正交基对模型进行特征表示。因此,为了便于利用线性空间正交基作为三阶张量表观模型的特征值,应对目标观测数据进行双重线性空间展开,得到两个子模式。算法实际操作中,我们结合线性空间理论的特点做了以下改进:

首先,为避免样本数据均值弱化模型的更新,我们利用去均值化后的样本数据,即,对其展开后分别得到两个子模式,如图2所示;正交基的表示形式是,为更好地对训练样本中的数据变化信息进行表示,子模式的正交基可通过对样本均值进行奇异值递推分解(RSVD)得到,并取其前个最大值对应的数值,来表示线性空间元模型的维度,可通过式(3)进行判定。

图2 观测数据双重线性空间展开

(2)模型增量特征更新:由于三阶张量表观模型及多线索的引入更加重了该环节的运算负担。另外,跟踪中亦存在较多影响目标表观的因素,通过跟踪过程中不断获得的新增数据来在线更新目标表观模型[14],可以更真实地描述目标表观变化。因此,专门提出一种基于双线性空间模型的增量特征更新方法。

该方法以前帧包含目标的连续序列图像为基础,利用后面紧跟的间隔时间内连续的帧新增图像对目标双线性空间模型进行增量学习更新。令为时刻第条线索元的双线性空间元模型的有效数据集,为相隔时间后连续录入的帧新增目标图像的数据集,则时刻表观模型的有效数据集为。模型更新问题则转化为获得时刻有效数据集对应模型的描述问题,即如何有效求得增量模型的数据均值和正交基的问题。流程如下:

(b)引入新增样本后对模型均值进行更新(为消逝系数);

(c)为避免直接引入样本均值对数据即时变化信息的影响,先对新增样本去均值处理:,然后对模型再进行双线性展开,可得;

(e)通过RSVD方式,得到新模型的正交基。

3 二级联合判别跟踪

除了建立目标表观模型及更新方式外,还需要对目标的运动状态进行跟踪估计。本文以粒子滤波作为目标跟踪算法的框架对目标进行跟踪预测,它主要包括状态模型与观测模型,前者采用常规的描述形式,但由于后者观测模型是保证跟踪效果的关键,因此,需对其重点考虑,结合本文目标表观建模特点对其进行如下改进:(1)以建立的双线索的三阶张量表观模型为基础,结合当前时刻信息分别进行在线权重估计,融合二元超分特征线索,进而建立目标自适应观测模型;(2)以真实目标视图为基准,建立目标的静态观测模型;(3)通过两个模型的联合匹配,实现对目标的跟踪。

3.1自适应观测模型

令共有条独立线索进行目标表示,可通过如下方式实现多线索的融合,得到观测模型:

3.2 静态观测模型

以三阶张量表观模型为基础建立的自适应观测模型尽管具有巨大优势,但在模型更新过程中难以避免会录入含有噪声的观测数据,一旦场景突变,极易导致跟踪漂移。在基于滤波理论的跟踪框架下,首帧图像标定的目标状态信息是唯一的目标真实视图,对其他时刻目标状态的预测估计均存在一定的误差,为进一步提高跟踪算法的精度,以首帧真实目标视图为基准,建立静态观测模型。具体步骤如下:

(1)通过人工标定或自动化标定初始化首帧图像中的目标视图,并提取特征信息与;

(2)以连续张目标首帧视图信息为原型,建立目标首帧视图的三阶张量表观模型;

(3)以首帧视图的表观模型为基础,建立目标的静态观测模型,方法如3.1节,线索的初始权重令为1/。

3.3 二级联合判别

目标表观与背景在跟踪过程中很容易受各种因素的影响,给观测数据带来误差干扰,因此,我们通过二级联合跟踪[15],对目标进行跟踪预测。第1步:使用带有自适应观测模型的粒子滤波跟踪算法对目标进行跟踪预测,因为连续的目标帧视图代表的表观变化通常较小,可以通过自适应观测模型的小幅度调整来克服;第2步,以静态观测模型为基准,当其与自适应观测模型特征偏差超过20%时,则立即对观测模型进行更新,防止长时跟踪过程中误差累积出现跟踪漂移,最终实现对目标的长时鲁棒跟踪。

4 实验分析

4.1 评价指标与测试视频

运动目标跟踪算法评价体系中平均跟踪误差(ATE)与帧均处理耗时(FPT)是两个非常具有代表性的评价指标。平均跟踪误差分别由ATE与ATE两个指标决定;令表示测试视频的总帧数,表示跟踪算法的处理时间。则ATE与FPT计算方式如式(7)和式(8)所示。

测试视频选取的是目标跟踪常用数据集Tracker Benchmark v1.0中的序列视图[16],分别是FaceOcc1, Tiger1, Soccer, Car4。这4组视频序列所代表的测试场景及视频数据如表1所示。

表1 对比测试视频

4.2 对比实验

为了更好地测试本文算法的优越性,特选择以下算法进行对比实验:多线索融合的目标跟踪算法(MAPF),增量对数线性空间学习的跟踪算法(IRST)与增量线性空间学习的跟踪算法(IVT)。3种对比算法均以粒子滤波为跟踪框架,且对比算法均采用与本文算法相同的状态模型。其中,MAPF算法采用灰度和纹理LBP特征双线索融合来对目标进行建模, IRST算法和IVT算法均是利用在线线性空间学习理论对目标进行表观建模,区别之处在于IRST是利用目标区域的COV特征对目标进行表示,而IVT算法是利用目标区域整体像素的灰度对目标进行表示。因此,对比算法具有较高相关性,针对性较强。测试视频选取的是多种目标表观存在复杂变化的标准视频序列。

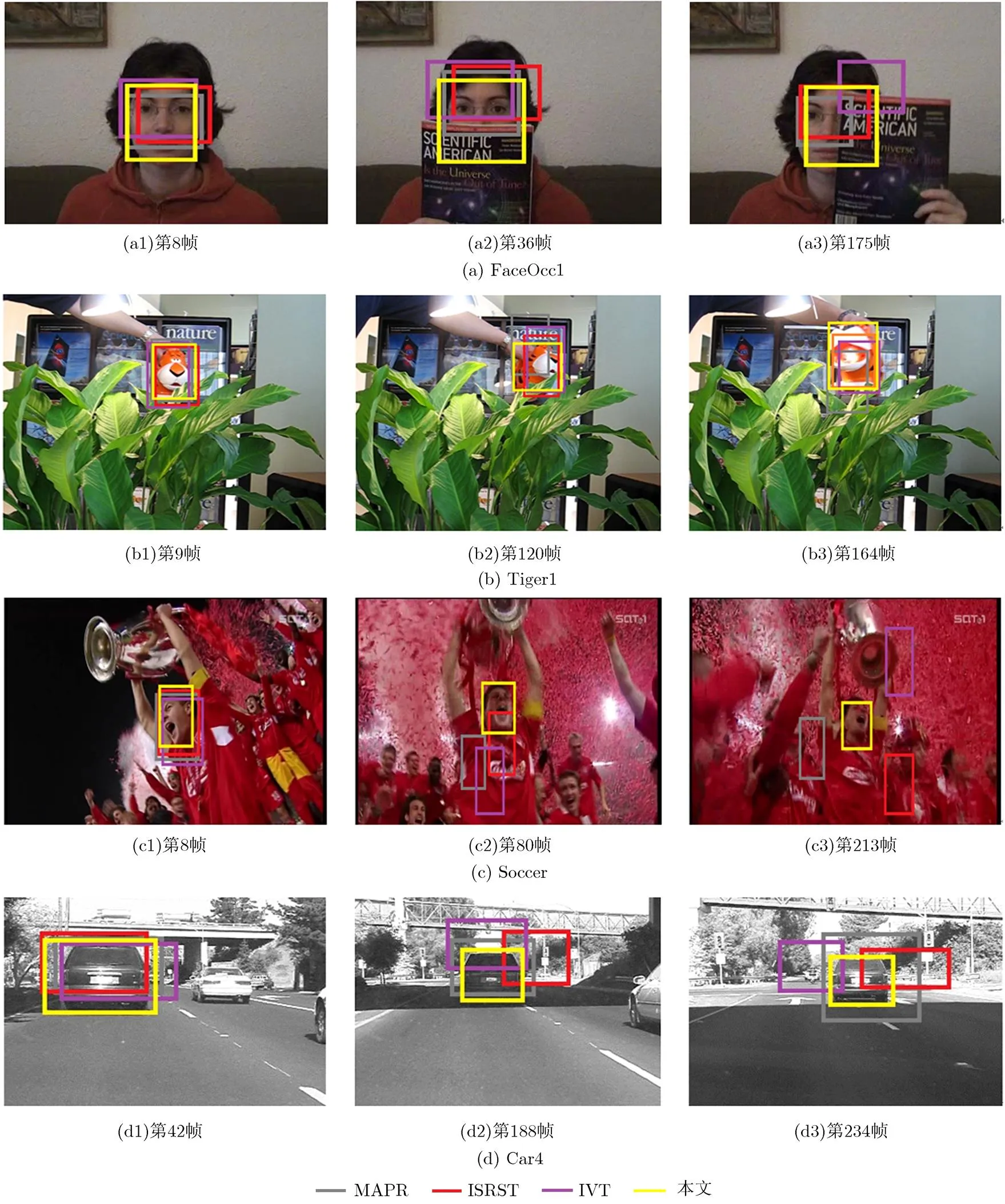

图3为多种表观变化场景实验的对比结果。图3(a)中,FaceOcc1视频场景下,IVT算法逐渐跟踪失败,说明单纯基于灰度的表观模型难以应对频繁的局部遮挡;MAPF算法虽然存在误差偏大的情况,基本还是成功地对目标进行了跟踪,说明引入纹理LBP特征后,对算法处理此种场景有益;IRST算法取得了与MAPF算法类似的跟踪结果;而本文算法跟踪精度明显高于前两者,说明本文引入的三阶张量表观模型对处理遮挡场景效果较好。图3(b)为旋转扰动遮挡场景下的Tiger1视频。图3(b1)中,本文算法与对比算法均可以准确地跟踪到Tiger,图3(b2)与图3(b3)Tiger分别发生旋转与形变,表观视图发生较大变化,MAPF算法逐渐跟丢目标难以适应目标表观大幅变化场景,IRST算法由于基于对数线性空间建模,对目标表观变化更加敏感优于IVT算法,而本文算法由于引入目标连续视图信息建立更新表观模型,可以更好地适应目标表观的大幅度变化,且由于引入了二级联合跟踪机制,也避免了跟踪漂移的出现。

图3 多种表观变化场景实验对比

4.3 定量评估

为了定量评估上述算法的跟踪效果,通过平均跟踪误差(ATE)与帧均处理耗时(FPT)两个指标作为评估依据,如表2所示,可以看出在ATE指标上,本文算法明显优于对比算法,具有较高的跟踪精度,跟踪误差平均保持在小于9像素;在FPT指标上,IVT算法由于仅基于灰度建模,运算量小,实时性优于前两个对比算法;MAPF方法由于采用的是普通的多线索融合方式,运算量较大,实时性明显低于其他算法;本文算法每帧的处理速度优于对比算法,进一步印证了本文的模型及其更新方法对提高跟踪效率的良好效果。

表2 算法定量对比评估

5 结束语

本文针对视频跟踪过程中目标表观变化的的复杂性,提出了一种基于GLCM与三阶张量的目标优化跟踪算法。以灰度共生理论为基础,利用高辨识度特征对目标区域分别进行超分提取,从空域和时域角度分别对跟踪目标进行三阶张量表观建模,保证了目标与背景的区分度;通过基于双重线性空间的在线增量学习更新方式对模型进行动态更新,进一步提高了算法的运算效率;二级联合判别跟踪方式有效避免跟踪漂移,保证了目标跟踪的精度。实验表明,该算法在多种包含剧烈表观变化的跟踪环境中,可取得良好的跟踪效果。下一步研究考虑结合背景信息进行表观建模,以提高跟踪算法应对复杂动态背景的能力。

[1] YANG H, SHAO L, ZHENG F,. Recent advances and trends in visual tracking: A review[J]., 2011, 74(18): 3823-3831.

[2] HO J, LEE K C, YANG M H,. Visual tracking using learned linear subspaces[C]. IEEE Conference on Computer Vision and Pattern Recognition, Rhode Island, USA, 2012: 782-789.

[3] LEE K C and KRIEGMAN D. Online learning of probabilistic appearance manifolds for video-based recognition and tracking[C]. IEEE Conference on Computer Vision and Pattern Recognition, Portland, USA, 2013: 852-859.

[4] ROSS D, LIM J, LIN R S,. Incremental learning for robust visual tracking[J]., 2013, 77(3): 125-141.

[5] LATHAUWER L, MOOR B, and VANDEWALLE J. On the best rank-1 andapproximation fhigherorder tensors[J]., 2000, 21(4): 1324-1342.

[6] LI X, HU W, ZHANG Z,. Visual tracking via incremental Log-Euclidean Riemannian sub-space learning [C]. IEEE Conference on Computer Vision and Pattern Recognition, Portland, USA, 2013: 578-585.

[7] LI X, HU W, ZHANG Z,. Robust visual tracking based on incremental tensor subspace learning[C]. IEEE International Conference on Computer Vision, Barcelona, Spain, 2012: 1008-1016.

[8] 钟桦, 杨晓鸣, 焦李成. 基于多分辨率共生矩阵的纹理图像分类[J]. 计算机研究与发展, 2014, 48(11): 1991-1999.

ZHONG Ye, YANG Xiaoming, and JIAO Licheng. Texture classification based on multiresolution co-occurrence matrix [J]., 2014, 48(11): 1991-1999.

[9] 薄华, 马缚龙, 焦李成. 图像纹理的灰度共生矩阵计算问题的分析[J]. 电子学报, 2006, 34(1): 155-158.

BO Hua, MA Fulong, and JIAO Licheng. Research on computation of GLCM of image texture[J]., 2006, 34(1): 155-158.

[10] CLAUSI D A and DENG H. Design-based texture Feature using Gabor filters and co-occurrence probabilities[J]., 2005, 14(7): 925-936.

[11] 吴光文, 张爱军, 王昌明. 一种用于压缩感知理论的投影矩阵优化算法[J]. 电子与信息学报,2015, 37(7): 1681-1687. doi: 10.11999/JEIT141450.

WU Guangwen, ZHANG Aijun, and WANG Changming. Novel optimization method for projection matrix in compress sensing theory[J].&, 2015, 37(7): 1681-1687. doi: 10.11999/JEIT 141450.

[12] KHAN Z H and GUI Y H. Online domain-shift learning and object tracking based on nonlinear dynamic models and particle filters on Riemannian manifolds[J]., 2014, 15(6): 97-114.

[13] 齐苑辰, 吴成东, 陈东岳, 等. 基于稀疏表达的超像素跟踪算法[J]. 电子与信息学报, 2015, 37(3): 529-535. doi: 10.11999/ JEIT140374.

QI Yuanchen, WU Chengdong, CHEN Dongyue,. Superpixel tracking based on sparse representation[J].&, 2015, 37(3): 529-535. doi: 10.11999/JEIT140374.

[14] CHENG X, LI N, ZHOU T,Object tracking via collaborative multi-task learning and appearance model updating[J].g, 2015, 31: 81-90.

[15] ZHONG W, LU H, and YANG M H. Robust object tracking via sparse collaborative appearance model[J]., 2014, 23(5): 2356-2368.

[16] WU Y, LIM J, and YANG M H. Online object tracking: A benchmark[C]. IEEE Conference on Computer Vision and Pattern Recognition, Portland, USA, 2013: 2411-2418.

Online Object Tracking Based on Gray-level Co-occurrence Matrix and Third-order Tensor

JIN Guangzhi SHI Linsuo CUI Zhigao LIU Hao MU Weijie

(502,,,710025,)

In order to improve the stability and accuracy of the object tracking under different conditions, an online object tracking algorithm based on Gray-Level Co-occurrence Matrix (GLCM) and third-order tensor is proposed. First, the algorithm extracts the gray-level information of target area to describe the two high discrimination features of target by GLCM, the dynamic information about target changing is fused by third-order tensor theory, and the third-order tensor appearance model of the object is constructed. Then, it uses bilinear space theory to expand the appearance model, and implements the incremental learning. Updating of model by online model’s characteristic value description, thus computation of the model updating is greatly reduced. Meanwhile, the static observation model and adaptive observation model are constructed, and secondary combined stable tracking of object is achieved by dynamic matching of two observation models. Experimental results indicate that the proposed algorithm can effectively deal with the moving object tracking on a variety of challenging scenes, and the average tracking error is less than 9 pixels.

Object tracking; Gray-Level Co-occurrence Matrix (GLCM); Third-order tensor; Linear space; Online tracking

TP391

A

1009-5896(2016)07-1609-07

10.11999/JEIT151108

2015-09-29;改回日期:2016-03-03;网络出版:2016-05-05

崔智高 cuizg10@126.com

国家自然科学基金(61501470)

The National Natural Science Foundation of China (61501470)

金广智: 男,1987年生,博士生,研究方向为机器视觉与模式识别.

石林锁: 男,1958年生,教授,研究方向为机器视觉、机电设备故障诊断等.

崔智高: 男,1985年生,讲师,研究方向为机器视觉、自动控制等.

刘 浩: 男,1985年生,博士生,研究方向为机电设备状态诊断与脑电信号分析等.

牟伟杰: 男,1984年生,博士生,研究方向为机电设备故障诊断.