基于多尺度选择性学习和探测-收缩机制的PSO 算法

夏学文,桂 凌,戴志锋,谢承旺,魏 波

(1.华东交通大学软件学院,江西南昌,330013;2.华东交通大学智能优化与信息处理研究所,江西南昌,330013;

基于多尺度选择性学习和探测-收缩机制的PSO 算法

夏学文1,2,桂凌3,戴志锋4,谢承旺1,2,魏波1,2

(1.华东交通大学软件学院,江西南昌,330013;2.华东交通大学智能优化与信息处理研究所,江西南昌,330013;

3.华东交通大学经济管理学院,江西南昌,330013;4.湖北经济学院信息管理学院,湖北武汉,430205)

针对粒子群算法逃离局部最优能力差、易早熟收敛、求解精度低等缺点,提出了一种具有多尺度选择性学习和探测-收缩机制的PSO 算法.在多尺度选择性学习机制中,粒子根据其自身进化状态在拓扑结构、邻居个体、目标变量维等多个尺度上进行选择性学习,提升粒子个体的学习效率;在探测-收缩机制中,算法利用历史信息指导种群最优解进行探测,提高其逃离局部最优的能力,当判断种群历史最优解处于全局最优解附近时,执行空间收缩策略,将种群的搜索空间限定在较小的一个区域,增强算法的开采能力,提高算法的求解精度.通过和其它PSO算法在22个典型测试函数的实验对比表明,本算法能有效克服早熟收敛、加快收敛速度、提高求解精度.

粒子群算法;早熟收敛;多尺度学习;探测策略

1 引言

粒子群算法(Particle Swarm Optimization,PSO)是Kennedy[1]等人于1995年提出的一种群智能优化算法,由于其理论简单、易于实现,因此,PSO算法在提出后被迅速应用于许多领域.影响PSO算法性能的主要因素是粒子位置迭代公式中的参数以及粒子邻域的拓扑结构,因此众多学者在这两方面进行了广泛的研究和改进.第一类改进是通过调整PSO的参数来提升算法性能.如Shi和Eberhart[2]对PSO算法的速度项引入了惯性权重来平衡全局搜索性能和收敛速度,Asanga Ratnaweera[3]则引入时变的加速因子(Time-Varying Acceleration Coefficients)调节粒子的自我学习和社会学习的强度.Ioan[4]和Jiang[5]先后对标准粒子群算法进行了收敛性分析,并提出了收敛性和稳定性较好的一组参数选择.Zhan[6]则对惯性因子、加速因子及其它多个参数进行自适应调整以改善算法综合性能;第二类改进是通过采用不同类型的邻域拓扑结构来提高种群的多样性、改善算法性能.如Suganthan[7]和Peram[8]分别利用粒子间欧式距离和粒子适应值来确定粒子的学习模式,通过这种动态选择学习对象的策略,改善种群的多样性.Rui[9]和Liang[10]先后提出了完全感知PSO算法和综合学习PSO算法,这两种算法的共同特点是通过丰富粒子的社会学习模式,改善种群多样性.众多研究结果也表明动态、多样的邻域拓扑结构对于多峰函数优化具有很好的效果[11,12].需要指出的是,对PSO算法的改进并非局限于某一方面的改进,很多时候是对参数、拓扑结构等同时进行改进[13~17].

上述对PSO算法的改进的目的主要是在防止早熟收敛的同时尽量提高求解精度,但当种群已经陷入局部最优时,却没有先验知识指导种群跳出局部最优.因此,本文提出了一种具有多尺度选择性学习和探测-收缩机制的PSO 算法(Multiscale-selective-learning hybrid with Detecting-shrinking PSO,MDPSO),MDPSO算法根据不同进化阶段时种群和个体生存环境的不同,在多个尺度上进行了学习模式的选择.同时,MDPSO还利用探测机制对粒子个体的历史信息进行周期采样与统计,利用统计结果指导种群进行探测和搜索空间的收缩.实验结果表明,上述改良机制有效地提升了PSO算法的综合性能.

2 PSO算法

(1)

(2)

其中,ω为惯性权重,表示前一时刻的速度对本次移动的影响,用于平衡算法的收敛速度和全局搜索能力,较大的ω有利于全局搜索,而较小的ω则可以提高算法的局部开采能力和求解精度[2,6];c1和c2为学习因子,表示粒子自我学习和社会学习的强度,即用来调节粒子向pBesti和gBest的学习强度;r1和r2为[0,1]内均匀分布的随机数,用来增强算法搜索的随机性.

3 MDPSO算法

PSO算法在复杂多峰函数优化中较易出现早熟收敛,因此很多学者通过不同的策略来增强种群多样性,从而避免算法陷入局部最优,但这也使得算法的收敛速度变慢.同时,当种群已陷入局部最优后,缺少具有指导意义的逃逸策略来帮助种群跳出局部最优并找到更优位置.为此,本文提出了一种具有多尺度选择性学习和探测-收缩机制的PSO算法(Multiscale-selective-learninghybridwithDetecting-shrinkingPSO,MDPSO).在MDPSO中,种群中的粒子个体将种群进化过程和自身进化状态相结合,在拓扑结构、领域个体以及不同的变量维等多个尺度上进行选择性学习.此外,为了增强算法跳出局部最优的能力,还赋予了种群历史最优解gBest探测学习的能力.同时,根据gBest以及pBesti的统计信息,对种群的搜索空间进行收缩,以提高算法的求解精度.

3.1多尺度选择性学习机制

3.1.1邻域拓扑结构的选择

为了改善PSO算法综合性能,必须保证算法在进化初期具有更好的全局搜索能力,尽可能地“勘探”到全局最优解所在区域,避免“早熟”收敛;而在进化后期,则希望种群能以较快的速度收敛到最优解附近,提高求解精度.因此,本文提出了一种随进化过程依概率选择不同邻域拓扑结构的策略.该策略可描述如下:

(3)

其中,TOPneighbor表示种群的邻域拓扑结构;topstar和topring分别为星型和环形邻域拓扑结构;rand是[0,1]间均匀分布的随机数.从式(3)可看出:在进化初期,种群选择topring的概率较大,有利于算法保持种群多样性,避免“早熟”收敛;而在进化后期,种群选择topstar的概率变大,种群的收敛速度得到提升,从而提高了算法的收敛速度和求解精度.

3.1.2邻域粒子与目标变量维的选择

本文对粒子个体设置了一个最大连续“停滞”代数MaxStagind,当粒子i在进化过程中连续“停滞”次数stayi达到该阈值时,将重新选择学习对象及学习方式,具体策略如下:

(1)当pBesti是其邻域内粒子的历史最优解中最优,则粒子i在进行社会学习时,从现有邻域粒子中获取有益信息的概率较低,此时应考虑重新选择合适的粒子作为其邻域粒子,选择策略可描述如下:

(4)

(5)

3.2探测-收缩机制

3.2.1探测机制

在复杂多维函数的优化过程中,gBest的每维变量一般很难同时处于全局最优解附近,这时就需要gBest有目的地探测该维空间的其它区域,以便能跳出当前的局部最优.

为方便探测行为的操作,每维变量空间被等分为多个互不相交的子区间,即:

(6)

其中,Si为第i维(1≤i≤D)变量的搜索空间;si,j为第i维的第j个 (1≤j≤M)搜索子区间;M 为第i维变量空间划分为的子区间个数.对搜索空间进行划分后,就可以确定gBest每维变量所在的子区间,同时,gBest将以子区间为单位进行探测.为了使gBest的探测更有目的性,本文将利用粒子群的pBesti和gBest的统计信息来确定各子区间的优势度,结合当前gBest所处的子区间来选择合适的目标子区间进行探测.具体为:通过每隔Cycle代对种群中pBesti进行周期采样和统计,获取每维变量在各个子区间上的优势度,gBest将利用子区间的优势度来指导其探测过程.

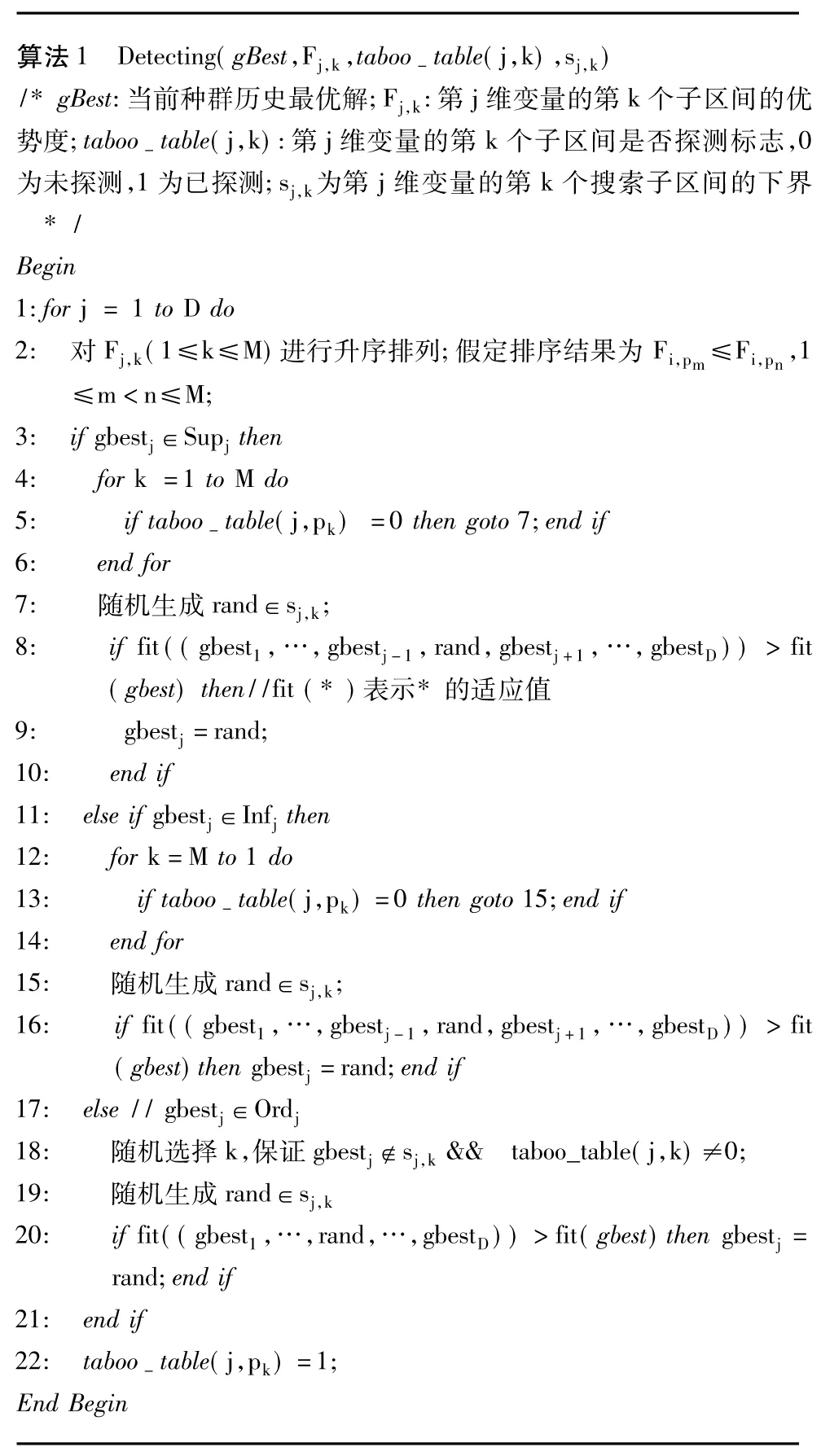

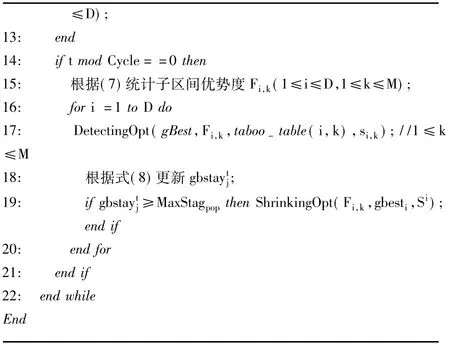

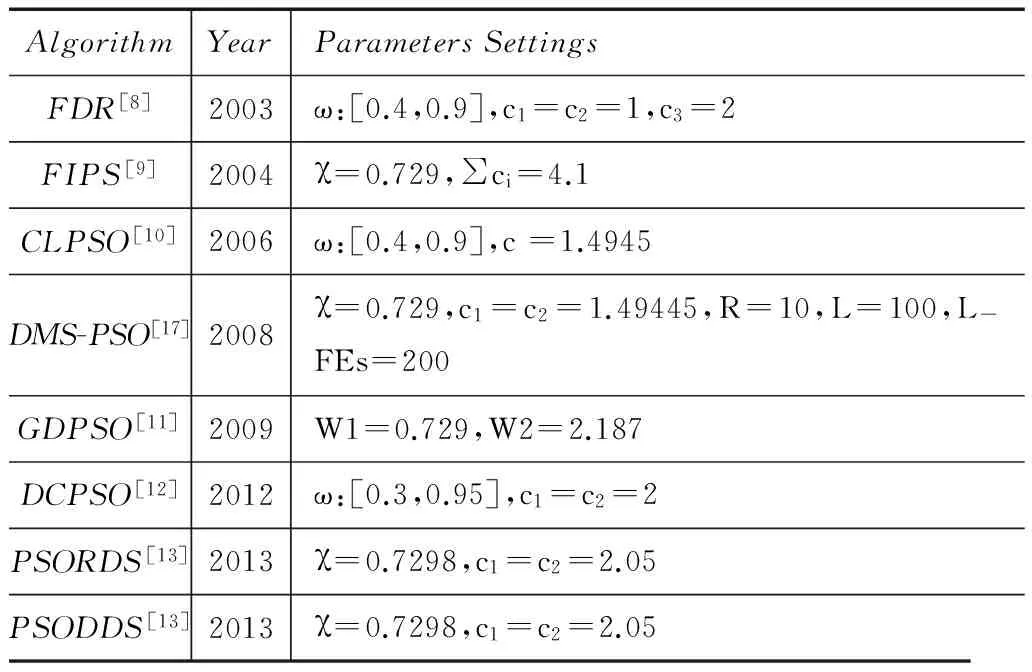

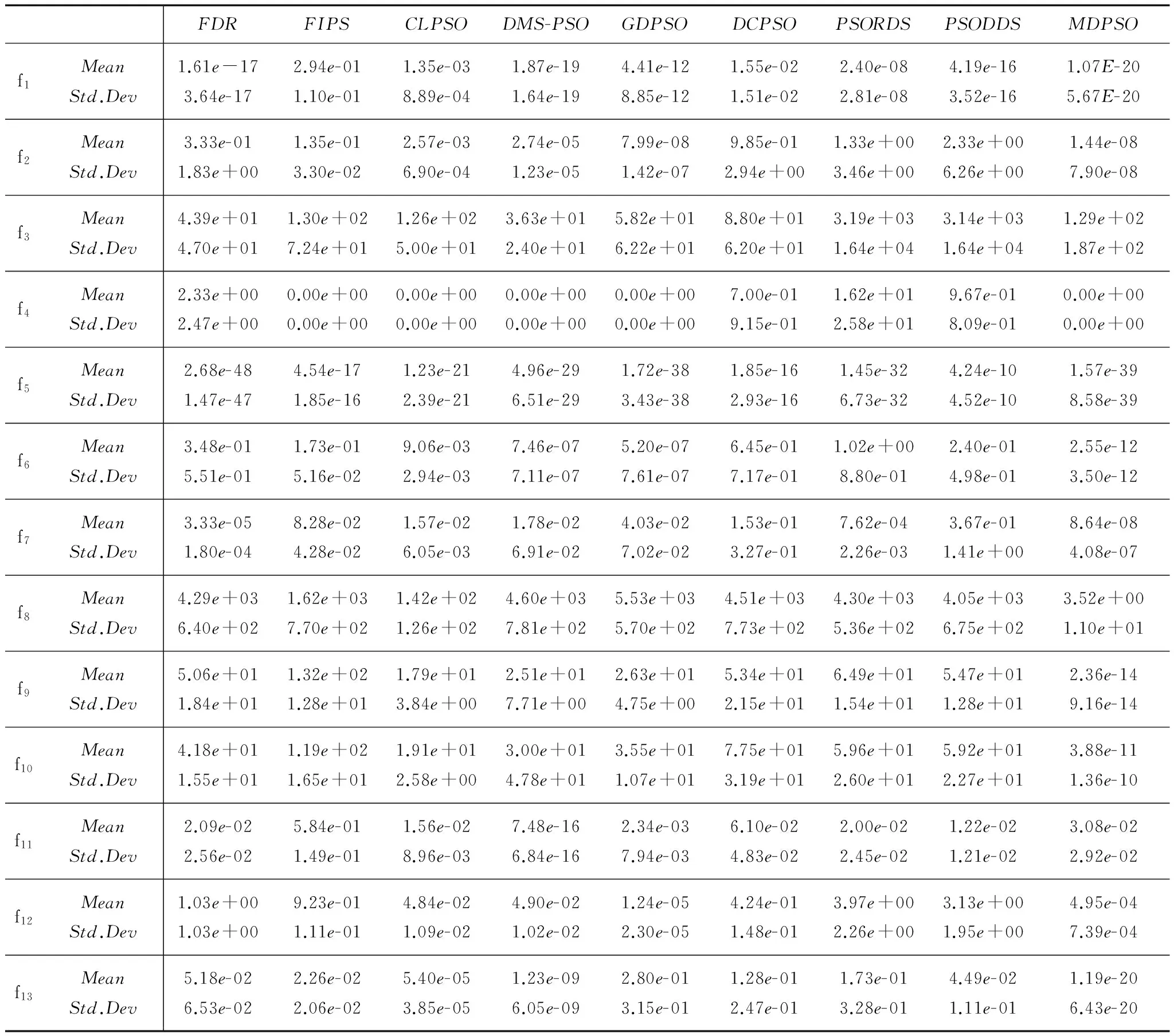

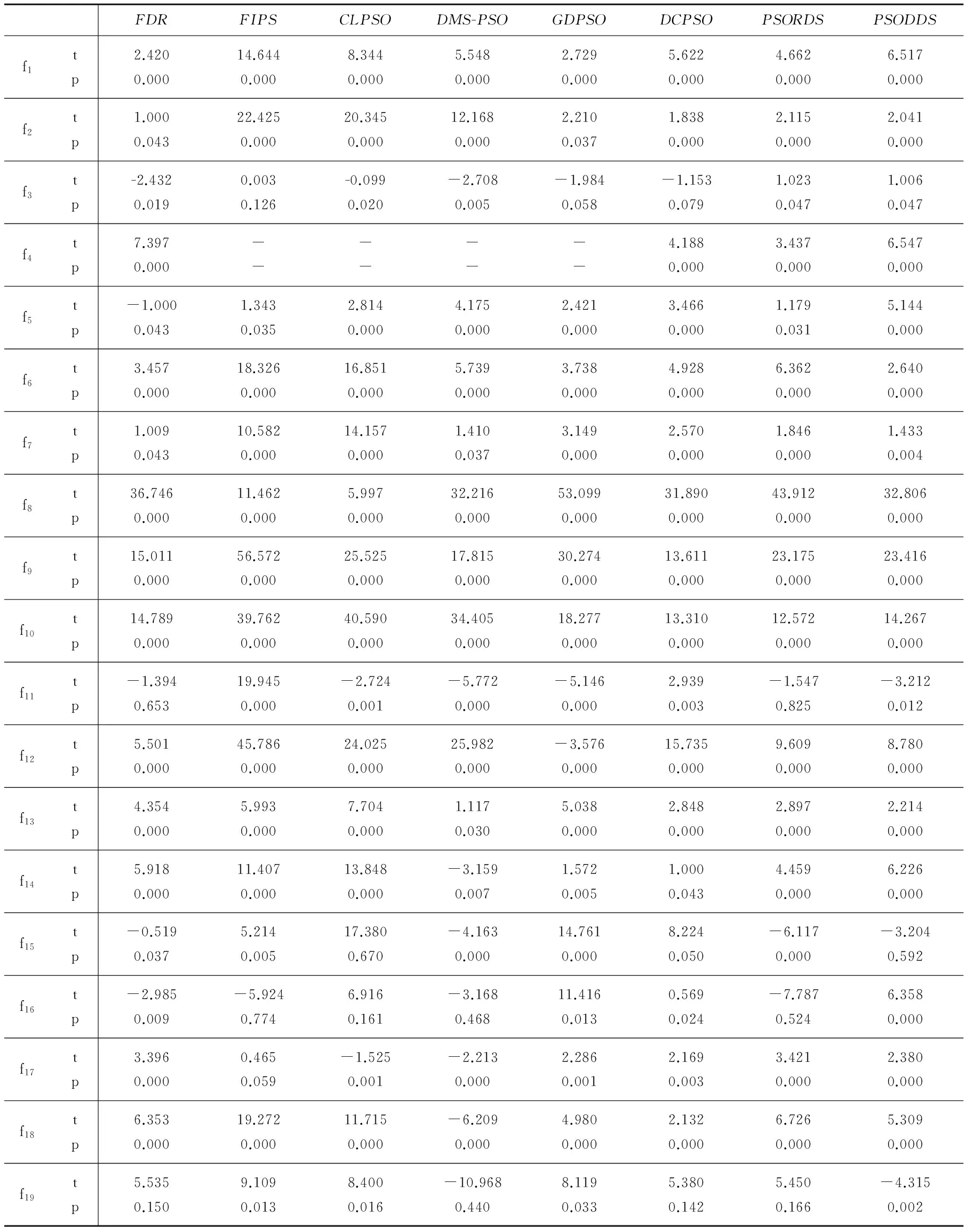

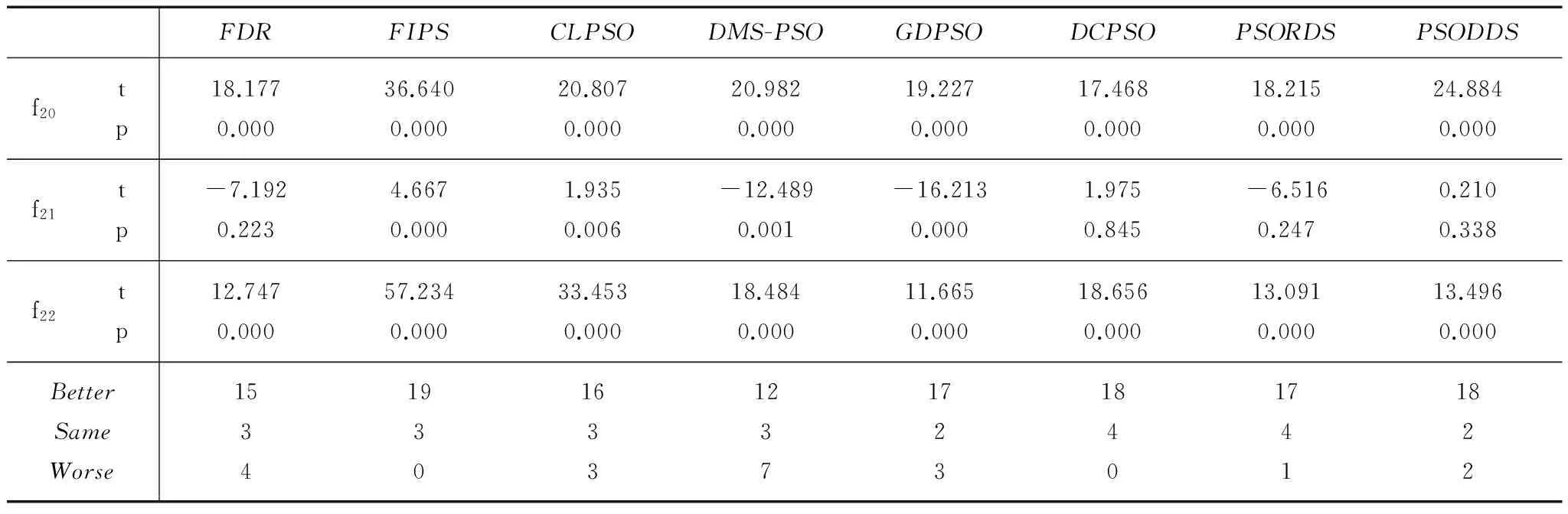

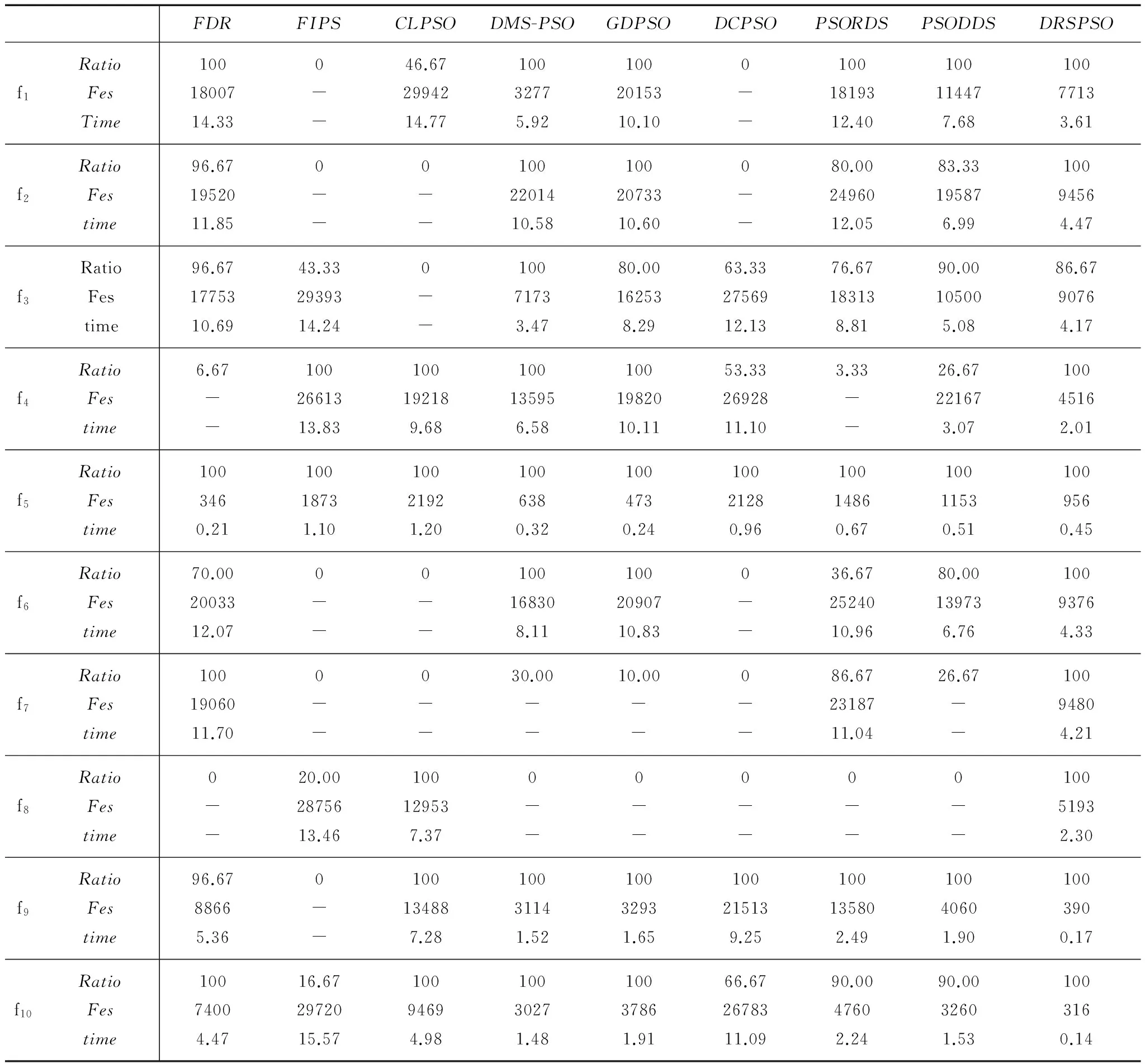

定义1子区间优势度.若pbesti,j为第i个粒子的历史最优解在第j维变量上的取值,sj,k为第j维变量第k个子区间,则当前种群第j维变量第k个子区间的优势度Fj,k(1≤j≤D,1≤k (7) 根据Fj,k值的大小,可将每维变量的子区间分为三类:优势子区间(superiorsubregion)、劣势子区间(inferiorsubregion)和平凡子区间(ordinarysubregion). 定义2优势子区间.第j维变量优势子区间为: Supj={sj,k|max{Fj,k}},(1≤j≤D,1≤k 定义3劣势子区间.第j维变量劣势子区间为: Infj={sj,k|min{Fj,k}},(1≤j≤D,1≤k 定义4平凡子区间.第j维变量平凡子区间为: Ordj=Sj-(Supj+Infj),(1≤j≤D,1≤k gBest根据第j维变量取值所属的子区间类别进行相应的探测.相应的探测过程如下: (1)若gbestj∈Supj,说明此时gbestj对种群第j维变量的影响很大,大部分粒子的pbesti,j取值都在gbestj附近,而在Infj内的取值则很少(甚至没有),若在Infj中存在第j维变量的全局最优解,则粒子群在后续飞行的过程中发现该维全局最优解的概率非常低或者需要更多次迭代.因此,gBest应该首先选择对Infj进行探测,以跳出当前的局部最优. (2)若gbestj∈Infj,说明此时gbestj与当前种群中大部分粒子的pbesti,j不在同一子区间.出现这种现象有三种可能性:第一种是大部分pbesti,j陷入了局部最优,而当前的gbestj处于第j维的全局最优解附近,这种情况下,不必进行探测;第二种是大部分的pbesti,j均集中在全局最优解附近,而gbestj则远离该区域,这时gBest可以选择在Supj内进行探测;第三种情况是当前粒子种群在该维的取值都不在全局最优区间,此时也不必进行探测.综合考虑以上几种情况,为了提高算法的收敛速度,此时选择向Supj进行探测. (3)若gbestj∈Ordj,gBest选择在其它任一子区间内进行探测.此时的探测过程和一般的变异操作类似,目的是为了增强种群的多样性. gbestj在进行上述3种探测操作时均采用的贪心策略,即在相应子区间随机选择值x,若将x替换gbestj后能改善gBest的适应值,则保留x,并替换原gBest,否则将抛弃x.为防止gBest对同一子区间进行连续多次探测,本文采用了禁忌探测机制,即每次探测完某个子区间后,为该子区间置“已探测”标志,下次再进行探测时则不再将该子区间纳为探测对象,而是选择剩余子区间中符合要求的子区间.当所有子区间都已被置为“已探测”,则清除所有子区间的“已探测”标志.这样,就保证了gBest在对重点子区间进行探测的同时,也满足了gBest对整个搜索空间的遍历性,增强了其搜索能力.综上所述,gBest在第j维的探测过程可描述为算法1. 3.2.2收缩机制 当算法在第j维进行多次探测后,确定全局最优解存在于某个或某些子区间中,就有必要将第j维的搜索限定在一定的有效区域内(本文称此过程为空间收缩),以加快算法收敛速度,提高求解精度.本文将以gBest在第j维上进行多次探测后,其适应值连续停滞代数作为执行空间收缩的指标.这里,首先有如下定义: (8) 3.3MDPSO算法 综合3.1~3.2中提出的策略,MDPSO算法可描述为算法3. MDPSO算法的参数设置:种群规模N=20,粒子最大连续停滞代数MaxStagind=5,每维变量分割为的子区间数M=8;统计周期Cycle为3;种群停滞阈值MaxStagpop将随着进化代数线性递增,其取值范围为[20,100].实验环境为:Inteli3CPU2.93GHz.RAM4.00GB,Windows7操作系统,MATLAB2009a. 4.1测试函数 本文选取了22个Benchmark函数进行了对比测试,各函数简要说明如下: ·f1:Sphere,x∈[-100,100]D,Accept-error:0.001 ·f2:Schwefel’sP2.22,x∈[-10,10]D,Accept-error:0.001 ·f3:Rosenbrock,x∈[-30,30]D,Accept-error:100 ·f4:Step,x∈[-100,100],Accept-error:0 ·f5:Sumofdifferentpower,x∈[-1,1]D,Accept-error:0.001 ·f6:Ackley,x∈[-32,32]D,Accept-error:0.001 ·f7:Alpine,x∈[-10,10],Accept-error:0.001 ·f8:Schwefel’sP1.2,x∈[-500,500]D,Accept-error:1000 ·f9:Rastrigin,x∈[-5.12,5.12]D,Accept-error:100 ·f10:Rastrigin-noncont,x∈[-5.12,5.12]D,Accept-error:100 ·f11:Griewank,x∈[-600,600]D,Accept-error:0.01 ·f12:Weierstrass,x∈[-0.5,0.5]D,Accept-error:0.01 ·f13:GeneralizedPenalized,x∈[-50,50]D,Accept-error:0.001 ·f14:ShiftedSphere,x∈[-100,100]D,Accept-error:0.001 ·f15:ShiftedSchwefelP1.2,x∈[-100,100]D,Accept-error:1000 ·f16:ShiftedSchwefelP1.2withNoise,x∈[-100,100]D,Accept-error:1000 ·f17:ShiftedRosenbrock,x∈[-100,100]D,Accept-error:1000 ·f18:ShiftedRotatedGriewank,x∈[-600,600]D,Accept-error:1000 ·f19:ShiftedRotatedAckley,x∈[-32,32]D,Accept-error:1000 ·f20:ShiftedRastrigin,x∈[-5,5]D,Accept-error:1000 ·f21:ShiftedRotatedRastrigin,x∈[-5,5]D,Accept-error:1000 ·f22:ExpandedExtendedGriewank’splusRosenbrock,x∈[-3,1]D,Accept-error:1000 其中,f1~f5为单峰函数,主要用来检验算法的求解精度;f6~f13为多峰函数,主要用来检验算法的全局搜索能力.f14~f22为shifted、rotated以及复合函数.本文实验中,变量维数D=30,最大评价次数maxFEs=1000*D.每个函数独立测试30次,取其统计结果(均值Mean、标准方差Std.Dev)进行比较,加粗数据表示对比算法在相应函数上得到的最优结果. 4.2不同策略的效果 为了检验本文提出的不同策略对算法不同性能方面的贡献度,我们选取了部分函数进行了测试(f1,f4为单峰函数,f6,f8,f9,f12为多峰函数),实验结果见表1.PSO-1和PSO-2分别表示从MDPSO算法中移除了多尺度选择性学习机制和探测-收缩机制后得到的算法. 表1 不同策略的实验结果对比 从表1中可以看出,本文提出的策略有效改善了算法的性能,MDPSO在测试的6个函数中除f8外,都取得到最优的结果.从表中也看出:移除了探测-收缩机制后,算法的性能急剧下降,这说明合理利用种群的历史信息来指导粒子有目的地进行探测是有效、可行的;移除了多尺度选择性学习机制后,算法对大部分测试函数的求解精度都有所下降,从对f9优化的结果可以看出,该策略提高了算法的学习效率,大大提升了求解精度.实验结果表明:本文提出的策略都对原PSO算法在不同性能指标上进行了优化与提升. 4.3求解精度 为了进一步说明本文算法的效果,这里选取了近年来的较为优秀的一些PSO算法进行实验对比,相关算法及其参数设置见表2.其中,DMS-PSO算法的种群规模设置为10个子种群,每个子种群规模为3,其它算法的种群规模均为20.其中,Merits表示该算法在测试函数上表现最优的次数.加粗数值表示对比算法在相应函数上得到的最优结果.具体结果如表3所示. 表2 相关PSO算法的参数设置 表3 9种算法在22个测试函数上的实验结果对比 续表 从表3可以看出,本文提出的MDPSO在11个函数上都取得了最优表现,尤其是在f6、f9、f10、f13和f20等几个多峰函数上取得了非常明显的优势,这说明本文提出的几种策略可以有效地帮助算法跳出局部最优;DMS-PSO则在7个函数上取得了最优表现,这也说明利用小规模子种群间的协作是提升群智能算法的有效途径之一.需要指出的是,尽管CLPSO只在1个函数上取得最优表现,但其在所有多峰函数上均取得了前3名的表现,在多峰函数优化上表现出良好的性能. 4.4t-检验 为了验证数据的置信度,本文还进一步对上述算法的优化结果进行了t-检验,置信水平α=0.05,检验结果如表4所示.表中,MDPSO显著优于对比算法的用黑体标出,显著劣于对比算法的用方框标出,Better、Same和Worse分别表示MDPSO比相应的对比算法在t-检验结果中具有显著更优、相同和显著更劣的函数个数.尽管MDPSO和FIPS、CLPSO、DMS-PSO、GDPSO等在各自的30次独立测试中,均在函数f4上取得了全局最优解(表中用-表示),但MDPSO能以最少的评价次数和时间耗费取得全局最优解(结果见表5).t-检验的结果表明,MDPSO算法的综合性能最优,该结论也验证了表3的实验结果. 4.5收敛速度 表5给出了对比算法在达到设定精度(Accept-error)时所需的评价次数及耗时,其中“-”表示该算法在相应函数上未能在最大评价次数内达到所需精度.表中数据均为独立运行30次的平均值,其中平均评价次数Fes和耗时Time均为算法达到设定精度时的取值,Ratio表示在30次独立运行中算法能在最大评价次数内获得精度误差要求的解的比例. 从表5可看出,MDPSO在大部分函数上均能以最少的评价次数和耗时取得设定精度的解.尽管本文提出的MDPSO算法中引入了多种不同的策略,在算法描述上较为复杂,但这三种策略本身耗时其实很少.一方面是因为这些策略并非每轮迭代都执行,而是种群进化到一定时期是才执行一次;另一方面,每个策略本身的运算也很简单,耗时较少,因此,加入这些策略后的算法在性能提升的同时,运算量增加很少.不同算法在测试函数上的收敛曲线也说明了MDPSO具有较快的速度,由于篇幅有限,本文省略了算法收敛曲线对比图. 表4 均值的t-检验结果(α=0.05) 续表 表5 设定误差精度下的成功率及收敛速度对比 续表 本文提出了多尺度选择性学习和探测-收缩机制来提高PSO的性能.在多尺度选择性学习机制中,当个体进化出现停滞现象时,该个体根据其自身与邻居个体间适应值的相对优劣关系对拓扑结构、邻居个体、目标变量维等多个尺度上进行变化与调整,实现多尺度上的自适应学习,从而帮助个体更有效地进行学习;探测-收缩策略则首先利用粒子个体的历史最优解的统计信息指导种群历史最优解进行探测,提高算法的全局搜索能力和跳出局部最优的能力,当种群历史最优解长期在某局部区域搜索时,则执行空间收缩策略,将整个种群的搜索过程限定在更小的空间内,以提高算法的求解精度和收敛速度.通过和其它8个优秀的PSO算法在22个测试函数上的实验对比表明,本文提出的策略能提高了算法的综合性能,可以有效地帮助算法逃离局部最优,同时也具有较快的收敛速度.由于本文提出的改进策略具有较好的通用性,下一步将利用该思想对其它群智能算法,如蚁群算法、蜂群算法等开展相关的研究. [1]Kennedy J,Eberhart R C.Particle swarm optimization[A].Proceedings of IEEE International Conference on Neural Networks[C].Piscataway:IEEE Press,1995.1942-1948. [2]Shi Y,Eberhart R C,Fuzzy adaptive particle swarm optimization[A].Proceedings of IEEE Congress on Evolutionary Computation[C].Seoul,Korea:IEEE Press,2001.1011-106. [3]Asanga Ratnaweera,Saman K Halgamuge.Self-organizing hierarchical particle swarm optimizer with time-varying acceleration coefficients[J].IEEE Transactions on Evolutionary Computation,2004,8(3):240-255. [4]Ioan Cristian Trelea.The particle swarm optimization algorithm:convergence analysis and parameter selection[J].Information Processing Letters,2003,85(6):317-325. [5]M Jiang,et al.Stochastic convergence analysis and parameter selection of the standard particle swarm optimization algorithm[J].Information Processing Letters,2007,102(1):8-16. [6]Zhan Z H,Zhang J,Li Y,et al.Adaptive particle swarm optimization[J].IEEE Transaction on Systems,Man,and Cybernetics-Part B:Cybernetics,2009,39(6):1362-1381. [7]Suganthan P N,Particle swarm optimizer with neighborhood operator[A].Proceedings of IEEE Congress on Evolutionary Computation[C].Washington,D C,USA:IEEE Press,1999.1958-1962. [8]T Peram,K Veeramachaneni,C K Mohan.Fitness-distance-ratio based particle swarm optimization[A].Proceedings of Swarm Intelligence Symp.[C].Indianapolis,Indiana,USA:IEEE Press,2003.174-181. [9]Rui Mendes,James Kennedy,José Neves.The fully informed particle swarm-simpler,maybe better[J].IEEE Transactions on Evolutionary Computation,2004,8(3):204-210. [10]Liang J J,Qin A K,Suganthan P N,et al.Comprehensive learning particle swarm optimizer for global optimization of multimodal functions[J].IEEE Transaction on Evolutionary Computation,2006,10(3):281-295. [11]倪庆剑,等.一种基于可变多簇结构的动态概率粒子群优化算法[J].软件学报,2009,20(2):339-349. NI Qing-Jian,ZHANG Zhi-Zheng,WANG Zhen-Zhen,et al.Dynamic probabilistic particle swarm optimization based on varying multi-cluster structure[J].Journal of Software,2009,20(2):339-349.(in Chinese) [12]汤可宗,柳炳祥,杨静宇,等.双中心粒子群优化算法[J].计算机研究与发展,2012,49(5):1086-1094. Tang Kezong,et al.Double center particle swarm optimization algorithm[J].Journal of Computer Research and Development,2012,49(5):1086-1094.(in Chinese) [13]Xin Jin,Yongquan Liang,Dongping Tian,et al.Particle swarm optimization using dimension selection methods[J].Applied Mathematics and Computation,2013,219(10):5185-5197. [14]喻飞,李元香,魏波 等,透镜成像反学习策略在粒子群算法中的应用[J].电子学报,2014,42(2):230-235.YU Fei,LI Yuan-xiang,WEI Bo et al.The application of a novel OBL based on lens imaging principle in PSO[J].Acta Electronica Sinica,2014,42(2):230-235.(in Chinese) [15]Xuewen Xia,et al.A quantum genetic algorithm based on cellular automata model,International Journal of Modelling[J].Identification and Control,2013,18(3):243-250. [16]Xuewen Xia,Jingnan Liu,Zhongbo Hu.An improved particle swarm optimizer based on tabu detecting and local learning strategy in a shrunk search space[J].Applied Soft Computing,2014,23(10):76-90. [17]Zhao S Z,Liang J J,Suganthan P N.Dynamic multi-swarm particle swarm optimizer with local search for large scale global optimization[A].Proceedings of IEEE Congress on Evolutionary Computation[C].Hong Kong,China:IEEE Press,2008.3845-3852. 夏学文男,1974年出生,博士,华东交通大学副教授,研究方向:计算智能及其应用 E-mail:laughkid@163.com;xwxia@whu.edu.cn 桂凌女,1977年出生,本科,华东交通大学交通运输与经济研究所实验师,研究方向:计算机应用. 戴志锋男,1968年出生,博士,湖北经济学院副教授,研究方向:智能算法. 谢承旺男,1974年出生,博士,华东交通大学副教授,研究方向:多目标优化算法. 魏波男,1983年出生,博士,华东交通大学讲师,研究方向:智能算法. A PSO Algorithm Based on Multiscale-Selective-Learning and Detecting-Shrinking Strategies XIA Xue-wen1,2,GUI Ling3,DAI Zhi-feng4,XIE Cheng-wang1,2,WEI Bo1,2 (1.SchoolofSoftware,EastChinaJiaotongUniversity,Nanchang,Jiangxi330013,China; 2.IntelligentOptimization&InformationProcessingLab,EastChinaJiaotongUniversity,Nanchang,Jiangxi330013,China; 3.SchoolofEconomicsandManagement,EastChinaJiaotongUniversity,Nanchang,Jiangxi330013,China4.SchoolofInformationManagement,HubeiUniversityofEconomics,Wuhan,Hubei430205,China) To overcome the shortcomings the traditional particle swarm optimization algorithm (PSO),such as poor ability to escape a local optimal,premature convergence and low precision,we proposed a new PSO based on multiscale-selective-learning and detecting-shrinking strategies,which called MDPSO in short.In the multiscale-selective-learning strategy,a particle executes a multiscale learning process to improve its studying efficiency by adopting its topology,selecting neighbors,and choosing target variable dimensions.In the detecting-shrinking strategy,particles′ historical best solutions are periodic sampling and some useful information,which extracting from the sampling results,is used to direct the best solutions to carry out a detecting operation.The aims of the strategy are to improve PSO′s global searching ability and to help the population escape a local optimal solution.While the best solution situating around a global optimal solution,the algorithm implements the shrinking strategy to confine the search space to a small one the aims of which are to improve the PSO′s exploitation ability and to increase the accuracy of the solutions.The proposed method was applied to twenty-two typical benchmark functions,and the comparisons of the performance between MDPSO and other eight PSO algorithms were experimented.The results suggest that the proposed strategies can effectively overcome the premature convergence,speed up the convergence and improve solutions accuracy. particle swarm optimization;premature convergence;multiscale learning;detecting strategy 2014-09-05; 2014-11-12;责任编辑:马兰英 国家自然科学基金 (No.41231174,No.61165004,No.61562028);华东交通大学校立科研项目(No.14JG03);江西省教育厅科研项目(No.GJJ150539);江西省自然科学基金(N0.2015BAB207022);新疆维吾尔自治区高校科研计划青年教师科研启动基金(No.2014JYT041606) TP301 A 0372-2112 (2016)05-1090-11 电子学报URL:http://www.ejournal.org.cn10.3969/j.issn.0372-2112.2016.05.012

4 仿真实验及结果分析

5 结束语