结合显著性与GrabCut的无角毛类浮游植物显微图像分割*

于 堃, 赵红苗, 姬光荣, 郑海永

(中国海洋大学信息科学与工程学院, 山东 青岛 266100)

结合显著性与GrabCut的无角毛类浮游植物显微图像分割*

于堃, 赵红苗, 姬光荣, 郑海永**

(中国海洋大学信息科学与工程学院, 山东 青岛 266100)

摘要:针对无角毛类浮游植物显微图像,结合显著区域检测和GrabCut算法,提出一种新颖的浮游植物细胞自动分割方法。首先,基于视觉注意机制的计算模型,检测输入图像的显著区域;然后,对生成的显著图进行预分割以获得浮游植物细胞的位置;再把细胞的位置信息用于初始化GrabCut算法,并迭代执行GrabCut;最后,应用去噪和平滑技术来输出细胞。实验表明该方法提取的前景目标形态完整、轮廓清晰、边缘规则。

关键词:浮游植物; 显微图像分割; 显著图; GrabCut

YU Kun, ZHAO Hong-Miao, JI Guang-Rong, et al. Combining saliency with GrabCut for phytoplankton microscopic image segmentation of non-setae species[J].Periodical of Ocean University of China, 2016, 46(3): 126-133.

海洋浮游植物(藻类)是海洋生态系统中的初级生产者,也是重要的海洋生物资源。快速有效的优势藻种鉴定是藻类监测的一个关键性环节。

传统的藻种鉴定主要依赖藻类学工作者借助显微镜观察其形态以确定物种,这也是目前公认准确的分类手段。但是这一技术不但需要经验丰富的藻类学专家,而且耗时费力,难以满足对大量样品和现场及原位实时快速分析的要求。随着现场及原位浮游植物成像系统的发展[1],藻类显微图像分析研究越来越受到重视[2]。

准确有效的图像细胞分割对于藻类分析来说至关重要。根据显微图像中角毛的特征,我们将浮游植物划分为2类:角毛藻和无角毛类藻[3]。针对角毛藻,本课题组提出了一种灰度曲面方向角模型实现了有效的角毛分割[4];本文针对无角毛类藻,结合显著性与GrabCut算法,提出一种新颖的藻细胞自动分割方法,为进一步的藻类分析奠定基础。

近年来,国内外在浮游植物显微图像细胞分割方面已开展了相关的研究。Jalba等[5]提出了一种标记控制的分水岭算法用于硅藻显微图像自动分割,该方法改进了ADIAC项目的初始分割结果[6],并且被应用于硅藻图像分类系统中[7]。Blaschko等[8]针对流式影像仪采集的浮游生物图像采用基于snake的分割方法得到轮廓和基于亮度的分割方法得到细节。Rodenacker等[9]利用阈值方法分割显微图像中的浮游生物。Sosik等[10]针对流式细胞仪采集的显微图像将基于阈值的边缘检测应用于相位一致性方法中提取细胞特征。Luo等[11]采用Canny边缘检测及回归方法作为分割校准从显微图像中寻找圆形硅藻。Verikas等[12]应用模糊c均值聚类算法来分割显微图像中的圆形微小原甲藻。

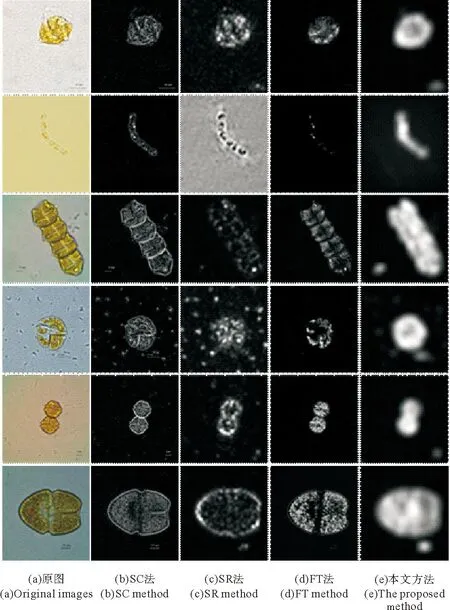

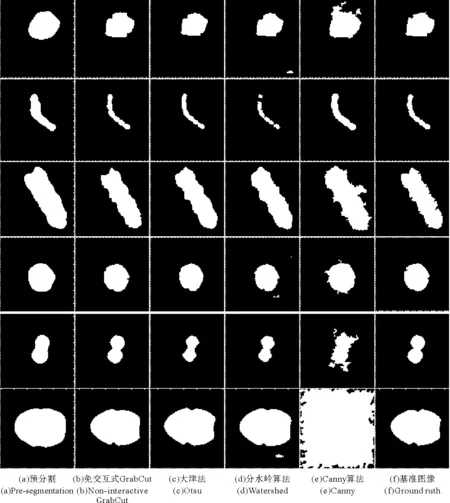

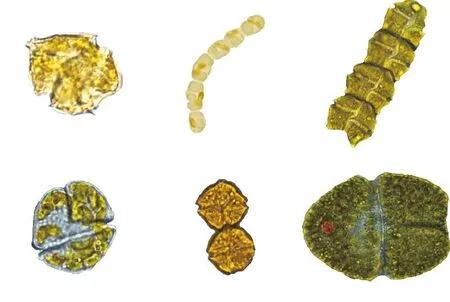

综上可知,目前浮游植物显微图像细胞分割大多基于基本的边缘(如Canny)和区域(如阈值和聚类)方法,并针对某些特定藻种类别开展研究。在无角毛类藻显微图像中(如图1(a)),藻细胞个体微小(通常达微米级),呈半透明状,具有横纵沟、尖顶刺等结构特征,形态细节复杂多样,以单体或细胞链形态生活;培养液背景经常存在细胞残骸、泥沙等杂质;背景区域与前景目标往往颜色相近;图像拍摄时藻细胞的自由活动易使其周围产生涡旋状的水渍噪声。这些特点导致分割过程中容易出现“欠分割”或“过分割”现象,难以实现快速、准确、高效的浮游植物显微图像细胞自动分割。

交互式分割由于人为主观因素的介入使得分割效果更加细致准确,其中基于图割理论的GrabCut算法因其简洁的交互性和良好的分割效果而得到广泛应用。对于交互式GrubCut算法而言,如果通过前景目标的外边界来初始化,就能够得到更佳的自动分割效果;而这种初始化可通过视觉注意的方式实现。浮游植物显微成像过程中大多有人类视觉系统(Human Visual System,HVS)参与,而视觉注意的计算建模(显著性检测)则是模拟HVS而设计的计算机视觉模型。

(从上到下依次是具刺膝沟藻、丹麦细柱藻、链状裸甲藻、米氏凯伦藻、塔玛亚历山大藻、血红阿卡藻。From top to bottom:Gonyaulaxspinifera,Leptocylindrusdanicus,Gymnodiniumcatenatum,Kareniamikimotoi,Alexandriumtamarense,Akashiwosanguinea.)

图1无角毛类藻显微图像及其视觉显著图

Fig.1Microscopic images and the corresponding saliency

maps of non-setae phytoplankton

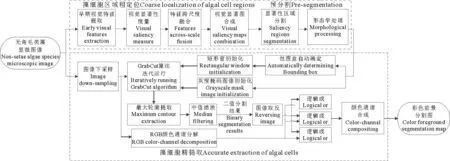

本文根据显微图像特点设计了一种结合显著区域检测的免交互式GrabCut分割算法,用于无角毛类藻显微图像细胞的自动提取(如图2),实验验证了该方法的有效性。

1基于视觉注意机制的藻细胞区域定位

人类的眼睛可以在复杂的视觉场景中快速地注意到显著或者感兴趣的区域,而忽略不太重要的对象,称为视觉注意机制,是HVS的内在属性[13]。视觉注意的方式可分为自底向上和自顶向下2种[14]:前者由图像数据驱动;后者由特定的视觉任务驱动。

由于不同种类的藻细胞在形态特征上并无统一性,无法预设视觉任务,因此应采用自底向上的视觉注意方式进行建模。目前该领域的研究主要集中在显著性(saliency)检测方面。图1(b)~(d)列举了我们利用3种代表性算法针对浮游植物显微图像所做的显著性检测的结果(其中藻细胞图像采集自暨南大学赤潮与水环境研究中心藻种室)。可以发现,SR法[15]得到的显著图视觉效果最差,细胞被隔离成许多孤立的碎块,骨架也无法看清。FT法[16]的结果中,细胞内部较暗,部分已湮没在背景中,这是因为该法只计算一阶平均颜色,用某个像素和整个图像平均色的色差来直接定义显著性值,对于待检测区域和背景对比度小的情况,可能会出现误判,如链状裸甲藻的细胞链连接处、血红阿卡藻的横沟处均出现了断裂。SC法[17]效果相对较好,能判断出藻的大致形态,但细胞内部明暗不均,孔洞众多,这是由于检测时只保留了亮度信息,未考虑其他颜色通道的显著性线索;另外SC法计算的是像素级显著性,并不注重全局,在遇到横沟和底刺等微小结构时,生成的轮廓线极易断裂。

图2 整体算法流程图

可见,针对生物形态学特点复杂的藻类显微图像,上述方法的检测结果并不理想。考虑到目前的成像系统大多根据人眼视觉原理研制,如果能够充分利用藻类图像中的视觉感知信息,并结合其生物形态特征,就可完整定位藻种目标,为后续分割提供可靠的保障。

1980年,Treisman和Gelade提出了著名的特征整合理论。认为在视觉注意初期,输入信息被拆分为若干个特征,视网膜平行地加工处理各种特征;之后各特征将会逐步整合,形成显著性图。后来,Koch和Ullman根据选择性视觉注意原理构造出显著性生物启发模型,有效模拟了HVS的神经机制。Itti将这一生物启发模型和特征整合理论巧妙地结合起来,成功实现了视觉注意的计算模型[18-19]。通过构建生物神经框架来解释人类视觉注意,将视觉生理功能适当简化并用计算模型表示出来,从生物学角度模拟了人眼的视觉搜索过程。

本文在Itti计算模型的基础上对其进行了改进。首先模拟视网膜与初级视皮层,提取藻种图像的亮度、颜色和方向等早期视觉特征,生成底层特征图;然后模拟中央-周围拮抗感受野,通过“中央-周围”差分(Center-surround difference)算子和归一化操作,对这些底层特征图进行视觉显著性度量,得到对应的特征显著图;再模拟特征融合机制,对同一类特征的显著图进行跨尺度融合,分别获得亮度、颜色和方向特征的总体显著图;最后将各幅总体显著图叠加成最终的视觉显著图,如图1(e)。

图中最大的显著区域即为藻细胞所在区域,亮度高且均匀,包含了完整的连通区域,比实际尺寸略大,可防止因检测偏差导致的细胞轮廓缺失。图中还有少量噪声引起的伪显著区域,但这不会影响最终分割,因为检测只是为了确定细胞位置并保留其完整轮廓,后面会进一步精确处理。

2预分割

对于被判定为“显著区域”的非藻种区域,可通过显著性区域分割和形态学处理加以修正,排除不符合条件的候选区域。

首先采用灰度阈值分割对显著图进行二值化,剥离显著区域和非显著区域。考虑到固定阈值分割不能对所有待处理图像都适用,这里采用大津法[20],依据概率统计和最小二乘法原理,自适应地确定最佳阈值。显著区域和非显著区域之间灰度特性相差越大,两部分间的类间方差就越大,反之,则越小。若误把显著区域像素划分成非显著区域像素,类间方差会比较小。当类间方差取得最大值时,两部分区域被错误划分的概率最小,此时的灰度值即最佳阈值。

然后相继进行形态学闭、开运算,获得的图像将只显示场景中的主要物体。实际拍摄的显微照片中,藻体一般是最大的可分辨物体,所以再对二值图像使用最大轮廓提取法,用白色填充轮廓内部,消除较大的噪声。

此时,背景中只残留少量弧形的细链状噪声,可通过形态学腐蚀加以去除,同时收缩原本较大的前景区域,使之趋近于实际大小。预分割结果见图3(a)。

3利用免交互式GrabCut的目标自动提取

根据用户是否参与分割过程,图像分割算法分成有监督和无监督两大类。无监督分割没有高层信息介入,很难准确提取目标。基于人机交互的有监督分割,通过人为提供指示性线索进行引导,可显著提高分割质量。

GraphCuts[21]是基于图的全局最优的有监督分割算法。用户需要手动标记一些前景和背景像素点作为种子点,分别用来建立颜色模型;然后算法将图像映射成有向图;再利用最大流最小割方法求解有向图的最优解。对于简单图像,少量标记就能取得不错的分割结果。可当图像内容复杂时,就需多次标记,并且若标记的种子点不能完全确定前景和背景,分割精度会大为降低。

为弥补GraphCuts的不足之处,Carsten等提出了GrabCut[22]分割算法。它的基本思路与GraphCuts类似,最大的创新在于通过迭代来优化同时包含了边缘和区域信息的能量方程,把交互减少到只需在目标外围选取一个矩形窗。交互方式变得简便,但是仍需用户参与。

为免去人工选取矩形窗的繁琐,并改善分割效果,本文借鉴并优化了GrabCut算法,将其应用到藻细胞目标的精提取。

3.1 算法初始化

对于有监督图像分割算法,初始化指的是通过人机交互,标记出前景和背景像素。现已存在的人机交互方式有:(1)轮廓绘制前景物体的边界;(2)画笔标记种子点;(3)确定目标所在几何区域。针对数量巨大的藻种图像库,单一的交互方式并不能奏效,并且手工输入的效率低下,不能实时分割,更无法自动批处理。本文采用掩码图像和矩形窗同时自动初始化GrabCut,替代原有的人机交互,可称之为“免交互式”(Non-interactive)模式。

具体而言,预分割结果中包含丰富的像素位置信息,可直接用来自定义初始掩码图像。掩码图像是和源图像大小相同的单通道灰度图,每个像素只能取“确定属于背景”、“确定属于前景”、“可能为背景”、“可能为前景”四种枚举值。这里将二值图像的白色区域像素设置为“可能为前景”,将黑色区域像素指定为“确定属于背景”。GrabCut执行时,掩码图像用来约束分割。

矩形窗的初始化,首先需要计算预分割结果中前景目标的包围盒。包围盒定义为正好包含物体形状且边平行于坐标轴的最小外接矩形,它可以紧密的描述和展现前景目标所对应的连通区域的范围。通过逐行逐列遍历二值图像,可以找到目标轮廓沿坐标轴方向的4个切点,再利用其各自坐标即可求取包围盒的位置和尺寸。在包围盒基础上略微扩大其外延即可确定矩形窗,默认窗外区域全部为背景,窗内区域为可能的前景。适当宽泛的矩形窗有助于避免误分割。

GrabCut算法的耗时与输入图像的大小、场景复杂度以及提取对象的大小等因素有关,对大尺寸图像的分割效率较低,而实验采用的藻类图片都是由高分辨率显微成像设备拍摄的。因此,可对输入图像进行下采样。

3.2 创建高斯混合模型

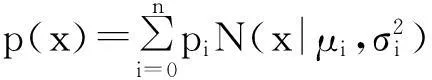

算法初始化后,需要依据标记好的信息创建可描述前景和背景的高斯混合模型,并在迭代过程中及时更新该模型。

在RGB颜色空间下,设一幅图像中任意像素点x=(r,g,b)T。那么单高斯模型的概率密度函数为:

(1)

其中μ、σ2为均值和方差,分别取值如下:

μ=E(x)

(2)

σ2=E[(x-E(x))2]=E[(x-μ)2]=E(xxT)-μμT

(3)

高斯混合模型可表示为n个单高斯模型的概率密度加权之和:

(4)

其中pi为第i个高斯模型的权值。

设前文被标记的背景区域和可能的前景区域的像素点集分别为B、U,那么利用B、U可分别训练背景和前景的高斯混合模型。

高斯混合模型可全面表征图像各像素点的特征。除均值和方差外,每个单高斯模型所占的权值也是重要的参数,表征了其在整个高斯混合模型中的比重。要建立包含n个单高斯模型的高斯混合模型,需要把图像分成n类,每一类拟合成一个单高斯模型,每个单高斯模型的权值就等于对应类中的像素个数与像素总数的比值。这里选取K均值聚类法对图像进行类的划分,步骤为:

(1)选取n个像素点作为初始聚类中心。

(2)计算剩余像素点到n个聚类中心的距离,基于最小距离原则把它们归入不同类中。

(3)更新当前聚类中心的位置和总的误差和。

(4)依据新的聚类中心,检测哪些样本需要移动,计算其移动后产生的误差。

(5)判断总体移动后的误差是否大于事先设定的阈值,如果是,返回第(3)步重新计算,否则直接退出。

K均值聚类是周而复始的聚类过程,在执行中不断优化分类结果,这也说明GrabCut是迭代的算法。结合大量的实验论证,本文选取的迭代次数为2。

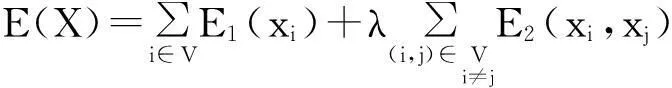

3.3 Gibbs能量函数最小化

GrabCut把带有标记信息的图像映射成有向图,利用Gibbs能量函数描述有向图中的区域和边界性能:

(5)

式中xi、xj为节点i和j的标记值(前景为1,背景为0);E1为相似能量,表示各像素点和背景或者前景间的相似性;E2为优先能量,表示相邻像素间的相似关系。

由于每个高斯混合模型均可视为1个K维的协方差,可引入向量k=(k1,…,kn,…,kN)作为每个像素点的独立高斯混合模型参数,其中kn∈{1,2,…,K}。于是,Gibbs能量函数可改写为:

E(α,k,θ,z)=U(α,k,θ,z)+V(α,z)。

(6)

式中α为不透明度,α∈[0,1],α=0时为背景,α=1时为前景;θ为前景与背景的灰度直方图,θ={h(z,α),α=0,1};z为灰度值数组,z=(z1,…,zn,…,zN)。

当Gibbs能量函数取得最小值时,根据区域和边界间的关系,设置有向图中边上的权值,可将图像分割转化为求解有向图的二元划分问题,再利用最大流最小割方法求取有向图的最优解,得到最优分割结果。

4实验结果及分析

执行GrabCut后,可得到二值分割图像,其前景含有少量椒盐噪点,需重新提取最大轮廓并填充内部。此时内部变得干净,但轮廓粗糙,边缘也不规整,可加入中值滤波器滤除轮廓的毛刺,同时保留边缘锐利度。

图3(b)是二值分割最终结果,提取的目标形态细节完整,轮廓精细,边缘平滑而清晰。无论是背景噪声,还是藻体(如血红阿卡藻)自身延伸出的虚拟边界阴影,均被毫无保留地去除。对于前景和背景对比度较低的情况(如丹麦细柱藻),分割效果也不错。

该二值结果能够准确反映细胞的位置、大小、形状和边缘,但是缺乏颜色等其他重要的特征信息。于是本文又对颜色信息进行了还原。为便于观察,这里只截取藻细胞感兴趣区域(ROI),并对其尺寸做了标准化处理(见图4)。

图3 二值分割结果

图4 彩色前景分割图

本文将免交互式GrabCut与3种应用成熟的分割方法进行了实验对比,分别是大津法(Otsu)、分水岭算法[23](Watershed)和Canny[24]边缘检测算法,其中,在应用大津法和Canny算子时,还采用了flood-fill算法和最大面积提取以进行后续处理。结果示于图3(c)~(e)。可以看出,Canny法分割效果最差,“过分割”严重;3种对比方法在分割丹麦细柱藻等横纵沟特征复杂的藻种时,均出现了明显的形态细节丢失。

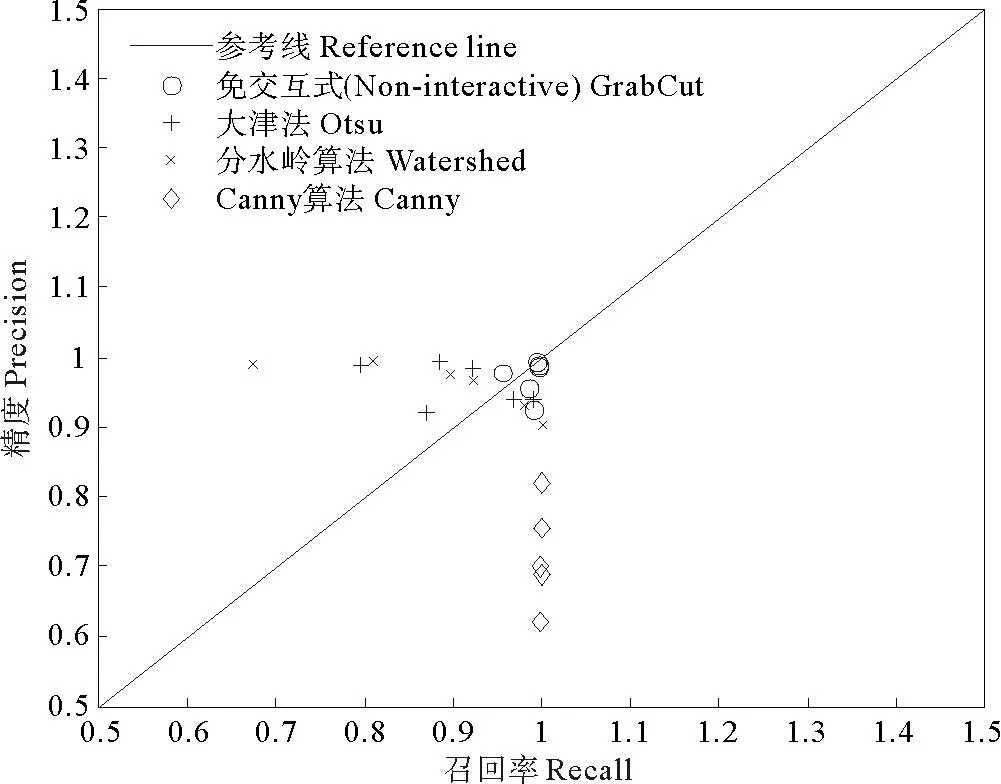

为定量分析各方法的实验结果,以图3(f)基准图像为依据,绘制离散点形式的PR曲线图。PR曲线,指的是精度-召回率(Precision-Recall)曲线,精度P(0≤P≤1)可描述分类准确率,召回率R(0≤R≤1)可衡量分类完整性,两者结合能全面评价分类器性能和分类优劣。对图像分割而言,只有精度和召回率尽可能大,分割质量才越高。反映在PR曲线上,坐标点离(1,1)点更近,分割效果越好。但精度和召回率之间会相互抑制,一味提高一方,反而可能降低另一方。为解决二者间的矛盾,可采用F1-Measure作为综合评价标准:

(7)

当F1值较高时,说明分割很有效。

如图5,将分割结果以点的形式直观地标记在PR曲线图上,每个标记点都代表一幅二值分割图像,不同方法的分割结果用了不同的标记以示区分。仔细观察各个标记点的位置,可发现“○”比其他标记点的分布更为集中,且更接近于右上角的(1,1)点。

图5 PR曲线图

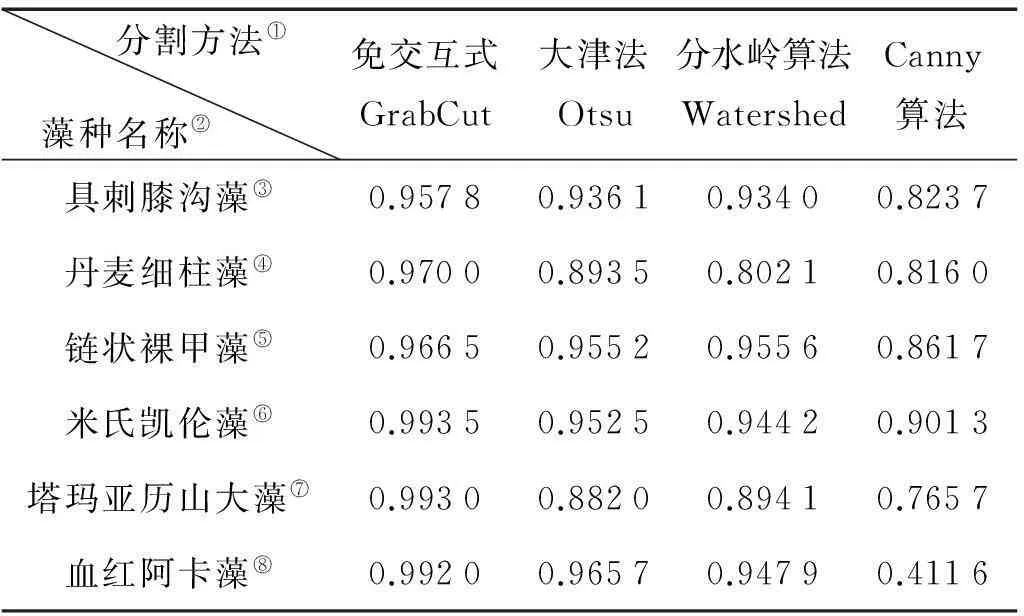

表1给出了每种方法的F1-Measure以进行全面细致的横向比较。免交互式GrabCut的F1-Measure明显高于其他方法,并一直保持较高数值。这说明其分割效果更佳,能够完整而准确地分割不同种类和场景复杂度的藻种图像;并且分割性能稳定,应对噪声干扰的鲁棒性较强。其他方法则发生了不同程度的波动,如Canny法在分割血红阿卡藻图像时,出现了0.411 6的极低值。

表1 不同方法的F1-Measure值

Note: ①Segmentation methods;②Algal names;③Gonyaulaxspinifera;④Leptoculindrusdanicus;⑤Gymnodihiumcatenatum;⑥Kareniamikimotoi;⑦Alexandriumtamarense;⑧Akashiwosanguinea

5结语

经典GrabCut算法需要用户手动选择包含物体的矩形窗,难以实现精确分割的自动化。本文借助基于目标定位的预分割,对GrabCut进行双初始化,省去了人机交互的繁琐。免交互式GrabCut比传统方法在分割稳定性和精准度方面均有明显提高,能有效实现藻细胞全程自动提取,为藻种图像现场原位实时处理及大规模样本自动处理提供了可能。

参考文献:

[1]Erickson J S, Hashemi N, Sullivan J M, et al. In situ phytoplankton analysis:there’s plenty of room at the bottom [J]. Analytical Chemistry, 2012, 84(2): 839-850.

[2]Culverhouse P F, Williams R, Benfield M, et al. Automatic image analysis of plankton: future perspectives [J]. Marine Ecology Progress Series, 2006, 312: 297-309.

[3]郭春锋, 姬光荣, 郑海永. 有害赤潮显微图像识别的三级分类器设计 [J]. 中国海洋大学学报(自然科学版), 2012, 42(11): 117-122.

Guo C, Ji G, Zheng H. The design of three levels Classifiers on microscopic images recognition of harmful algae blooms [J]. Periodical of Ocean University of China, 2012, 42(11): 117-122.

[4]Zheng H, Zhao H, Sun X, et al. Automatic setae segmentation from chaetoceros microscopic images [J]. Microscopy Research and Technique, 2014, doi: 10. 1002/jemt. 22389.

[5]Jalba A C, Wilkinson M H F, Roerdink J B T M. Automatic segmentation of diatom images for classification [J]. Microscopy Research and Technique, 2004, 65: 72-85.

[6]Fischer S, Gilomen K, Bunke H. Identification of diatoms by grid graph matching [J]. Lecture Notes in Computer Science, 2002, 2396: 94-103.

[7]Dimitrovski I, Kocev D, Loskovska S, et al. Hierarchical classification of diatom images using ensembles of predictive clustering trees [J]. Ecological Informatics, 2012, 7(1): 19-29.

[8]Blaschko M B, Holness G, Mattar M A, et al. Automatic in situ identification of plankton [C]. Breckenridge: IEEE Computer Society, 2005: 79-86.

[9]Rodenacker K, Hense B, Jutting U, et al. Automatic analysis of aqueous specimens for phytoplankton structure recognition and population estimation [J]. Microscopy Research and Technique, 2006, 69(9): 708-720.

[10]Sosik H M, Olson R J. Automated taxonomic classification of phytoplankton sampled with imaging-in-flow cytometry [J]. Limnology and Oceanography: Methods, 2007, 5: 204-216.

[11]Luo Q, Gao Y, Luo J, et al. Automatic identification of diatoms with circular shape using texture analysis [J]. Journal of Software, 2011, 6(3): 428-435.

[12]Verikas A, Gelzinis A, Bacauskiene M, et al. Phase congruency-based detection of circular objects applied to analysis of phytoplankton images [J]. Pattern Recognition, 2012, 45(4): 1659-1670.

[13]Filipe S, Alexandre L A. From the human visual system to the computational models of visual attention: A survey [J]. Artificial Intelligence Review, 2013(6): 1-47.

[14]Borji A, Itti L. State-of-the-art in visual attention modeling [J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2013, 35(1): 185-207.

[15]Hou X, Zhang L. Saliency detection: a spectral residual approach [C]. Minneapolis: IEEE Computer Society, 2007: 1-8.

[16]Achanta R, Hemami S, Estrada F, et al. Frequency-tuned salient region detection [C]. Miami: IEEE Computer Society, 2009: 1597-1604.

[17]Zhai Y, Shah M. Visual attention detection in video sequences using spatiotemporal cues [C]. Santa Barbara: Association for Computing Machinery, 2006: 815-824.

[18]Itti L, Koch C. A saliency-based search mechanism for overt and covert shifts of visual attention [J]. Vision Research, 2000, 40(10): 1489-1506.

[19]Itti L, Koch C. Computational modelling of visual attention [J]. Nature Reviews Neuroscience, 2001, 2(3): 194-203.

[20]Otsu N. Threshold selection method from gray-level histograms [J]. IEEE Transactions on Systems, Man and Cybernetics, 1979, SMC-9(1): 62-66.

[21]Boykov Y, Jolly M P. Interactive graph cuts for optimal boundary and region segmentation of objects in N-D images [C]. Vancouver: Institute of Electrical and Electronics Engineers, 2001: 105-112.

[22]Rother C, Kolmogorov V, Blake A. “Grabcut” - Interactive foreground extraction using iterated graph cuts [J]. ACM Transactions on Graphics, 2004, 23(3): 309-314.

[23]Vachier C, Meyer F. The viscous watershed transform [J]. Journal of Mathematical Imaging and Vision, 2005, 22(2-3): 251-267.

[24]Canny J. A computational approach to edge detection [J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 1986, 8(6): 679-698.

责任编辑陈呈超

Combining Saliency with GrabCut for Phytoplankton Microscopic Image Segmentation of Non-Setae Species

YU Kun, ZHAO Hong-Miao, JI Guang-Rong, ZHENG Hai-Yong

(College of Information Science and Engineering, Ocean University of China, Qingdao 266100, China)

Abstract:For automatically identifying the species of phytoplankton by microscopic images, it is necessary to segment the phytoplankton cells. The segmentation effect of the cells directly determines the accuracy of identification result. In this paper, a novel non-interactive GrabCut method for automatic segmentation of non-setae phytoplankton cells from the microscopic images is proposed, which integrates saliency region detection with improved GrabCut algorithm. Firstly, through the computational model based on the visual attention mechanism, the visual features of the input image are measured and then fused into one saliency map. The generated saliency map reflects the salient region of the input image and can be used to establish the approximate position of the cell. Secondly, threshold segmentation and some morphological processing are carried out for this saliency map to produce the binary pre-segmentation result, so the rough outline of the cell is preliminarily obtained. Thirdly, the bounding box that surrounds the cellular region of the pre-segmentation image is automatically determined and then extended to a rectangular window. Meanwhile, because the black part of the pre-segmentation image must be background pixels, whereas the white part may belong to the foreground pixels, a grayscale mask image including the location information of the cell can be constructed by making different regional markers. Next, the rectangular window and grayscale mask image are both used to initialize GrabCut algorithm. GrabCut is executed through the iterations. However, the output image of GrabCut cannot be directly used as binary segmentation result. It needs to re-extract the largest contour to eliminate the sporadic noise, and apply the median filtering technique to smooth the boundary of the cell. Besides binary segmentation result, the color information of the input image is further restored to form colorful foreground segmentation result. All the regions of interest (ROI) in the two types of segmentation results are cut and made standardized treatment of their sizes. Finally, the segmentation effect of non-interactive GrabCut is qualitatively compared with that of three state-of-the-art segmentation methods. In order to quantitatively analyze the segmentation effect of various methods, Precision- Recall (PR) curve is drawn in the form of discrete points. In addition, this paper also gives the F1-Measure value of each method to implement a comprehensive and detailed horizontal comparison. The extensive experimental results demonstrate that the proposed method can accurately extract complete-morphology, clear-contour and regular-edge foreground objects, own stable segmentation performance for the microscopic images with different species and scene complexity, and have strong robustness to resist noise interference. Especially for the phytoplankton images with the cingulum or sulcus, the segmentation accuracy is very high. Overall, non-interactive GrabCut obviously outperforms the other common methods on microscopic image segmentation of non-setae phytoplankton species, and can realize real-time and in-situ automatic processing of massive sample images.

Key words:phytoplankton; microscopic image segmentation; saliency map; GrabCut

DOI:10.16441/j.cnki.hdxb.20140214

中图法分类号:TP391.4

文献标志码:A

文章编号:1672-5174(2016)03-126-08

作者简介:于堃(1986-),男,博士生,主要从事计算机图像处理研究。E-mail:yukunemail@163.com**通讯作者:E-mail:zhenghaiyong@ouc.edu.cn

收稿日期:2014-05-10;

修订日期:2015-02-13

*基金项目:国家自然科学基金项目(61301240;61271406)资助

引用格式:于堃, 赵红苗, 姬光荣, 等. 结合显著与GrabCut的无角毛类浮游植物显微图像分割[J].中国海洋大学学报(自然科学版), 2016, 46 (3): 126-133.

Supported by National Natural Science Foundation of China (61301240, 61271406)