基于RGB-D的人脸表情识别研究

吴会霞,陶青川,龚雪友

(四川大学电子信息学院,成都 610065)

基于RGB-D的人脸表情识别研究

吴会霞,陶青川,龚雪友

(四川大学电子信息学院,成都 610065)

针对二维人脸表情识别在复杂光照及光照条件较差时,识别准确率较低的问题,提出一种基于RGB-D的融合多分类器的面部表情识别的算法。该算法首先在图像的彩色信息(Y、Cr、Q)和深度信息(D)上分别提取其LPQ,Gabor,LBP以及HOG特征信息,并对提取的高维特征信息做线性降维(PCA)及特征空间转换(LDA),而后用最近邻分类法得到各表情弱分类器,并用AdaBoost算法权重分配弱分类器从而生成强分类器,最后用Bayes进行多分类器的融合,统计输出平均识别率。在具有复杂光照条件变化的人脸表情库CurtinFaces和KinectFaceDB上,该算法平均识别率最高达到98.80%。试验结果表明:比较于单独彩色图像的表情识别算法,深度信息的融合能够更加明显的提升面部表情识别的识别率,并且具有一定的应用价值。

表情识别;RGB-D;深度信息;AdaBoost

0 引言

一直以来在计算机视觉领域,人脸表情识别有着重要的研究意义,在过去的十几年里,众多研究学者为此做出了大量的努力,在二维人脸表情识别方面取得了一些研究成果[1],涌现了一大批优秀的算法。但是由于二维图像的局限性,在实际应用环境中当某些因素发生改变时,例如姿态、光照、遮挡物和面部整形,对于同一个人的两张RGB图像,这些可变因素可以引起图像表达信息的不同,从而导致识别算法性能降低,很难再有突破性的进展。因此,研究学者开始使用对光照和姿态具有鲁棒性的三维数据进行表情识别。

在BU-3DFE上,Wang等人[2]通过提取原始面部特征,使用LDA分类器进行表情识别,平均识别率最高达83.6%;在同样的表情库上,Soyel和Demirel[3]采用从面部特征点的三维分布反演得到六个距离向量,然后通过神经网络(PNN)分类表情使平均识别率最高达到87.8%;在FEEDB上,Mariusz[4]对数据库使用两种不同的标准分别进行描述,从而创建了两种不同的格式的RGB-D图像表达,使表情识别率达到90%;在Curtin-Face上,Billy Y.L.Li[5]采用多模态的稀疏编码后重建误差,从而计算测试图像与训练图像的相似度量,并通过Z得分技术进行表情识别,最终平均识别率为91.3%。目前,由于用Kinect采集的人脸库没有面向公众使用,所以只有少数人在表情识别领域使用深度信息完成了一定程度上的表情识别。

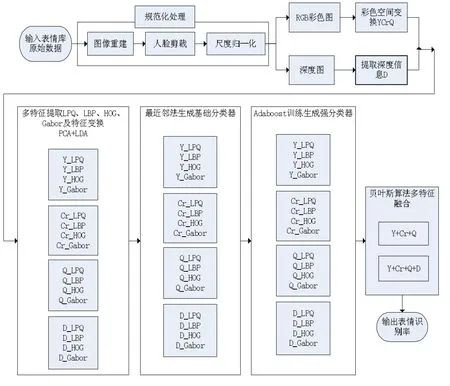

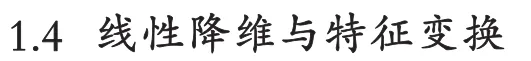

通过以上的分析,在低质量低成本且复杂光照条件下,为了有效地解决因姿势、表情变化导致三维表情识别识别率较低的问题,提出了一种基于RGB-D的多特征融合的表情识别算法,首先,为了获得更全面的表情信息,在提取彩色图像信息(RGB)的同时,提取图像深度信息(D),从而在不同条件下保存了更多的面部细节信息,使得到的图像信息能够提供一个相对弹性表示的人脸表情;然后在转换后的色彩空间(YCrQ)及深度信息(D)上分别单独提取其LPQ,Gabor,LBP以及HOG特征,并对提取的高维特征信息做线性降维(PCA)及特征空间转换(LDA),把同一类表情在各分量上提取的单特征均值作为一种表情模板,分别计算测试样本到各表情模板的欧氏距离;再利用最近邻距离比较生成弱分类器,通过AdaBoost权重分配训练弱分类器形成强分类器,最后用Bayes融合多特征多分类器,统计得出最终的表情识别率。本文算法系统框图如图1所示。

图1 算法系统框图

1 算法分析

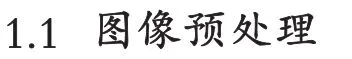

采用Kinect得到的图像数据以6 D点云(XYZRGB)形式保存,本文提出的预处理方法使给定的6 D点云生成RGB图像和深度图,RGB图像提供纹理信息和表面信息,而深度图提供每个像素到传感器的距离,深度信息是每个像素点到传感器的距离的表示,用几何形状与灰度值表征。预处理过程如图2所示[4]。

(1)图像重建:在给定6D点云上提取第4、5及6通道即R、G、B分量三维重建彩色图像,并提取第3通道即D分量重建深度图像。

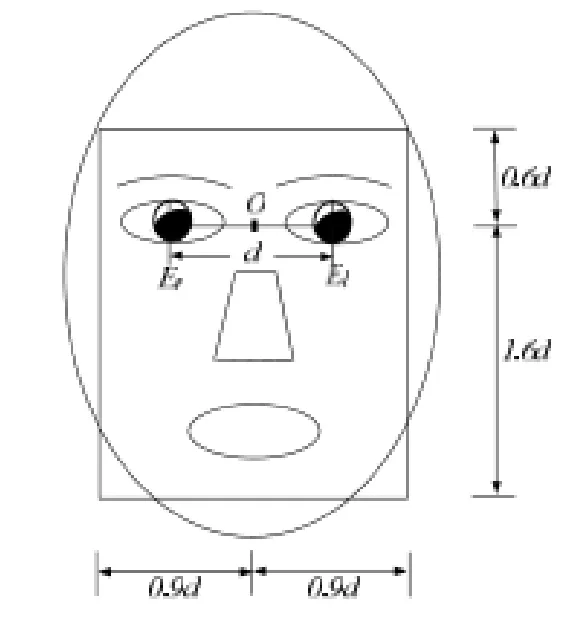

(2)图像裁剪:三维重建得到的彩色图像及深度图像有480×640个像素点,首先需要手工标定左右眼的位置,从而计算出左右两眼之间的距离d,再根据图3所示的人脸各个部分比例关系可以裁剪得到人脸表情区域,设左右眼间距离为d,则纯表情区域矩形宽为1.8d,高为2.2d,两眼分别位于(0.6d,0.4d)、(0.6d,1.4d)处。这样可以有效地避免颈部和头发等区域的干扰,另一方面也保证了人脸特征位置的一致性,最终合理裁剪得出人脸表情区域。

图2 图像预处理过程

图3 脸部特征比例关系

(3)尺度归一化:虽然裁剪之后的表情图像长宽比例一致,但其大小不一,因此需要通过放缩变换将所有的图像变换为大小一致的图像,即尺度归一化。其思想是把尺寸各不相同的人脸图像变换为统一的标准尺寸图像以便于人脸特征的提取。基于此,本文采用了速度较快、效果较好的双线形插值方法[4],将彩色图像和深度图像尺度归一化为64×64大小的图像。

研究表明,基于彩色信息的面部特征能够有效降低人脸识别和表情识别的错误率[6-7]。S.M.Lajevardi等人基于R、G、B彩色分量的表情识别有效地提高了表情识别率,但却缺少考虑多种光照条件下表情的变化;Hong Ren Wu等人的研究表明在不同的光照条件变化下基于YCrCb空间下的识别率要高于RGB色彩空间,且YIQ空间对彩色信息进行编码后所得的信息冗余最少[8]。根据以上研究,本文选择在YCrQ空间提取特征信息[9],且图像由RGB空间线性转化到YCrQ空间的公式如(1)所示:

LPQ是具有图像模糊不变性的特征算子[11-12],LBP是用来反映图像区域信息的特征算子[13-14]。HOG是描述图像的局部梯度方向特征信息的特征算子[15]。Gabor变换是加Gauss窗的傅里叶变换,Gabor函数能够在频域的不同方向、不同尺度上提取特征信息[16-17]。经过预处理之后的样本均归一化为64×64像素大小,然后将彩色图像和深度图划分为8×8的互不重叠的子区域,然后对每个子区域做窗口大小为5×5的LPQ与LBP变换。把分区域统计的LPQ直方图与LBP直方图分别串联起来,每个样本表情即可表示为64×256=16384维列向量。HOG提取特征时,每个子区域又包含4个4×4大小的胞,将其表示为一个9维的向量,每个样本表情图像即可表示为4×9×64=2304维列向量。Gabor变换时,用40个滤波器提取的Gabor特征的维数为40×64×64=163840,经下采样之后得到的样本特征向量维数为7840维。

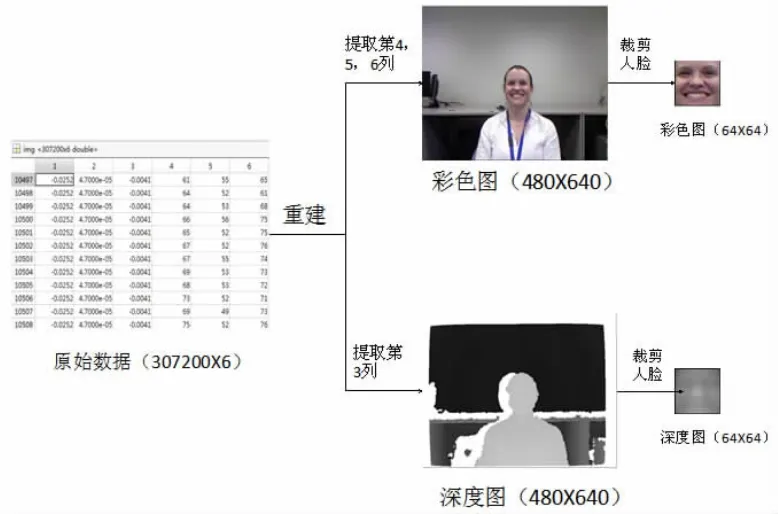

根据上述算法本文在各分量(YCrQ-D)上,提取LPQ、LBP、HOG和Gabor等16种特征,提取特征示意图如图4所示。

人脸表情图像经提取特征后得到的高维度特征,通过主成分分析法(PCA)进行线性降维。PCA算法通过计算LPQ等特征矩阵的最大相关向量组,即取p个特征值贡献率为99%时对应的特征向量组(p称为特征维数),本文中通过在验证集上的相关实验分析得到各个分量在各个特征下的特征维数p。然后采用线性鉴别准则(LDA)将PCA降维后的样本进行空间转换,使投影在子空间的样本具有高内聚且低耦合,从而使样本数据有最好的分类效果。

图4 各分量特征提取示意图

实验中在训练样本集上对高维特征向量做PCA和LDA处理,用每类表情平均向量作为模板向量,且对测试样本特征向量也做相同的降维处理,并计算与每类表情模板之间的欧氏距离,最后用最近邻法得到表情基础分类结果。

2 分类器的选择及分类器融合

研究表明,多分类器融合的表情识别比单分类器识别具有更好的性能。本文首先在最近邻法产生的基础分类器的基础上用通过AdaBoost权重分配弱分类器形成强分类器,最后用Bayes融合多特征多分类器,统计得出最终的识别率。

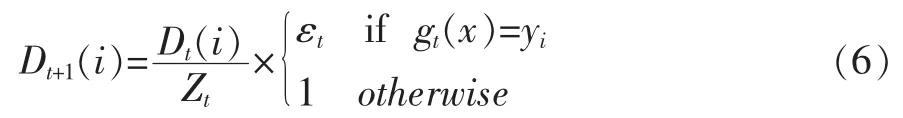

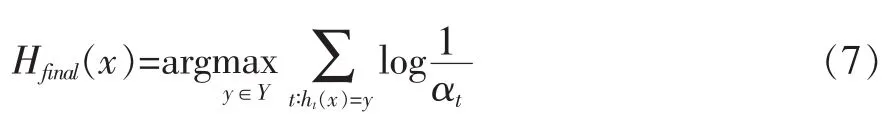

AdaBoost算法通过训练弱分类器迭代分配样本权重形成强分类器。AdaBoost算法迭代训练详细过程如下:

假设给定一组样本(x1,y1),…,(xm,ym),xi∈X,yi∈Y,xi为表情图像,yi为表情图像的类别号。yi∈(1,…,6),m为总的表情数,实验中首先将每个样本的权重初始化为(3)式:

其中,每次迭代过程中的样本权重为Dt,t为训练次数,t=1,…,T。

(1)针对某一弱分类器可知样本和相应类别号的对应关系ht∶X→Y,ht为分类器。

(2)计算样本集在当前分类器及权重下的分类错误率,如果着t>1/2或是t=T-1则跳出迭代:

(3)由(4)式可得到参数琢t满足(5)式

(5)得到最终的分类器满足(6)式:

本文中通过在验证集上的相关实验分析各个分量在各个特征下取迭代次数T等于10。

实验中将AdaBoost生成的强分类器作为贝叶斯分类器的输入样本进行分类。在进行贝叶斯融合之前,先计算各分类器的先验概率值和条件概率值。首先,本文中假设各特征属性相互独立,则可以得到各分类器的先验概率;其次,通过在训练样本集上的训练,得到在每个分类器下的各个表情图像的条件概率密度。最后,要获得某一样本的条件概率密度时,运用贝叶斯算法计算以上各分类器的分类结果,其计算过程是通过混淆矩阵来实现的。

3 实验结果与分析

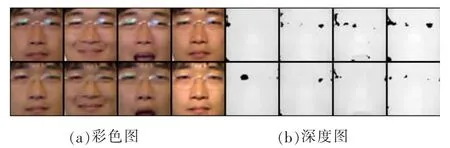

CurtinFace人脸库由52名不同的受试者组成,其中男性42名,女性10名。分别拍摄每位受试者在不同光照、不同表情及不同姿态下的人脸图像共5000多张。在本文实验中,分别选取每个受试者的7张表情图像进行实验分析,即7种表情为微笑、惊讶、悲伤、厌恶、生气、恐惧及中性表情,共计364张,预处理后的表情如图5所示,验证该算法在多种不同条件变化下的识别性能。

实验中按照十折交叉验证随机选取训练样本集、验证样本集与测试样本集,且在训练样本集上训练得到实验相关参数,通过验证样本集进行验证参数的有效性,在测试样本集上测试表情识别算法的识别率。

图5 CurtinFace人脸表情示意图(a)彩色图像(b)深度图像

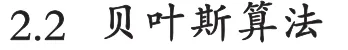

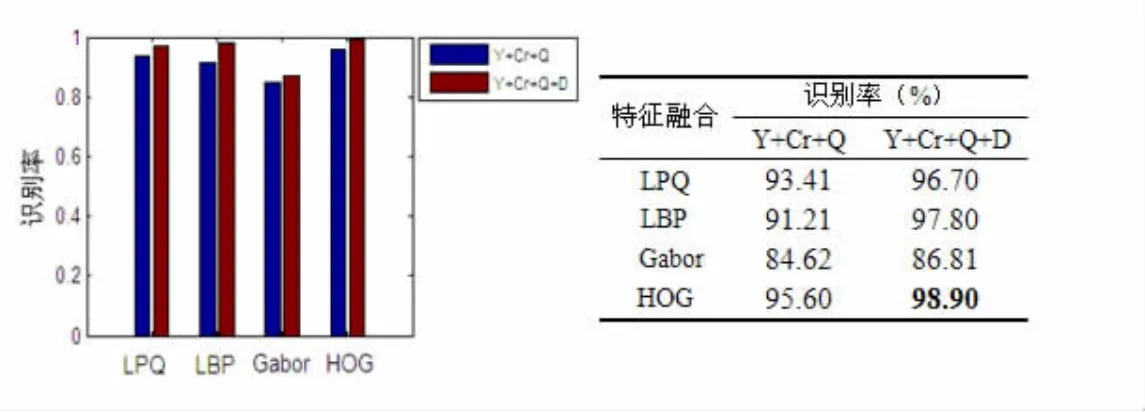

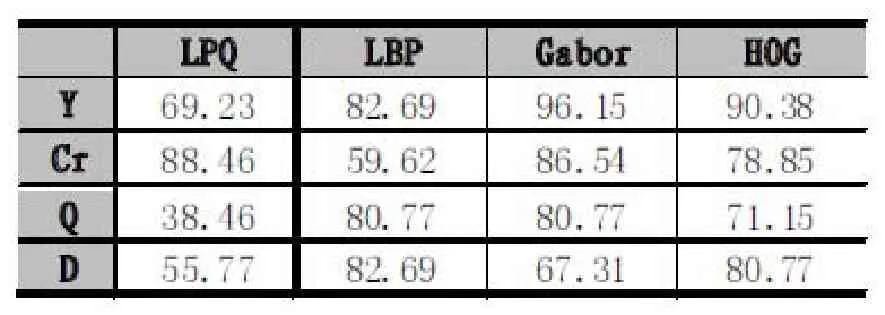

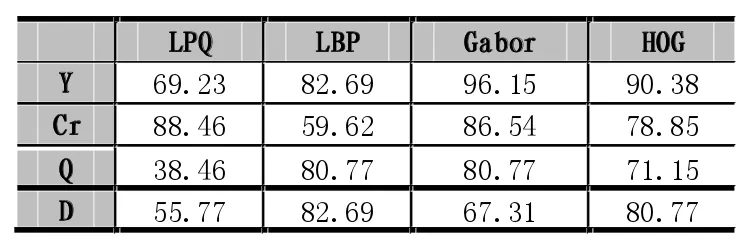

对于不同的色彩分量(YCrQ)和深度信息分量(D),实验中提取的4类特征分别用最近邻分类法形成的16种弱分类器,各自识别率如表1所示。

表1 CurtinFaces各分量单特征的识别率(%)

然后将各分量单特征的基础分类器用AdaBoost算法形成强分类器,实验中通过在验证样本集上验证得到迭代次数T选取10次识别效果最好。从而统计各强分类器的识别率,如下表2。

表2 AdaBoost算法下各强分类器的识别率(%)

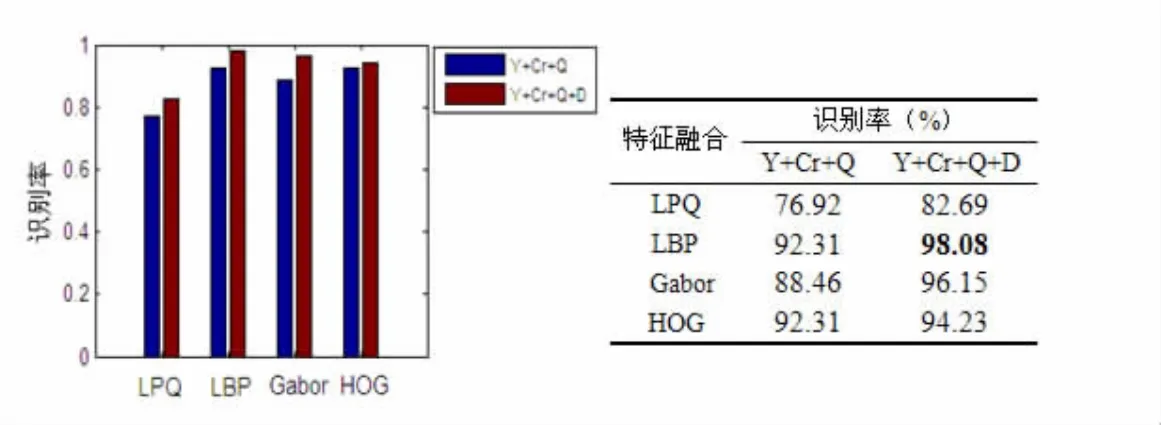

将用AdaBoost算法得到的每个特征下的强分类器再用传统贝叶斯算法进行多分类器融合,分别为彩色分量融合(Y+Cr+Q)和彩色分量结合深度信息分量融合(Y+Cr+Q+D)两种情况,并加以比较,如图6所示。

在本文实验中,我们评估系统对面部表情的变化,基于每个人的一个RGB-D测试图像进行识别。上表中列出彩色分量Y、Cr、Q融合以及彩色分量结合深度信息D的融合,表明深度信息的融合能使算法识别率得到明显的改善。识别精度最好的为HOG特征下的各分类器融合,达到98.90%的识别率;而不包含深度信息D的识别时,可以看到,在Gabor特征下的识别率仅为84.62%。此外,预处理过程对基于RGB-D的表情识别也起到了至关重要的作用,且图像的深度信息对RGB数据有对称填充作用[4]。

图6 CurtinFace库上多分量融合识别率

KinectFaceDB[18]由EURECOM研究所用Kinect拍摄获得,人脸库由包含52人(其中男性38名,女性14名)组成。在相隔半个月的两个时间阶段,分别采集受试者在不同的光照条件下的不同的面部表情和不同遮挡物下的人脸图像,由此得到S1样本和S2样本集。即在每一阶段,拍摄得到中性表情、微笑、张嘴、左侧面、右侧面、遮挡眼睛、遮挡鼻子、用纸遮挡和强光照。因本文实验需要,只选取其中一部分照片作为实验图像,如图7所示,从左到右依次为中性表情、微笑、张嘴、强光照表情以及每个表情相对应的深度图。

图7 KinectFaceDB人脸库示例

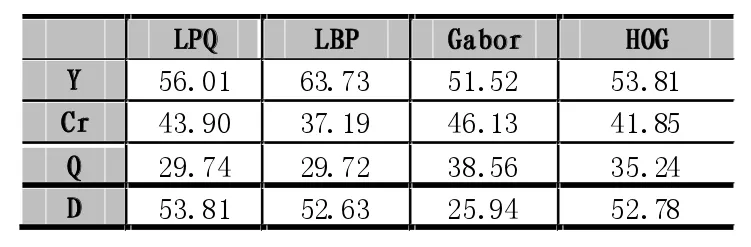

本文实验中选取受试者两个时间阶段下的面部表情图像和光照图像共计416张。参照算法在CurtinFace人脸库上的处理及实验步骤,在KinectFaceDB上的实验结果如表3、表4及图8、图9所示:

表3 KinectFaceDB-S1库各分量上单特征识别率(%)

图8 KinectFaceDB-S1库上各特征识别率

表4 KinectFaceDB-S2库各分量上单特征识别率(%)

图9 KinectFaceDB-S2上各特征识别率

实验结果表明:在KinectFaceDB上,彩色信息分量结合深度信息分量的表情识别也能有效地改善算法的识别率,由此也说明了该算法的优越性。

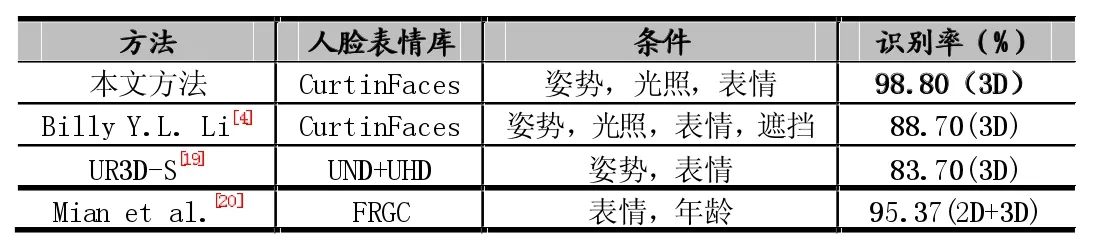

据了解,近几年使用CurtinFaces和KinectFaceDB进行表情识别相关的研究较少,各算法之间没有直接的可比性。下表5中,简单总结了一些相关人脸表情识别的方法。

表5 现有相关方法的性能对比

上表中,UR3D-S采用了面部对称性的方法进行表情识别,与本文方法不同之处在于他们使用高分辨率的三维数据,且在UND+UHD库上表情识别的平均识别率为83.70%。Mian等人在FRGC库上提出了一种基于2D+3D的表情识别,使得识别率达到95.37%。由此,通过比较可知,本文算法的识别精度98.90%均优于上述方法。

4 结语

图像的深度信息是对三维人脸表情识别研究和分析的一个重大突破,可以在一定程度上解决由于光照和姿态等因素带来的识别率较低的问题。本文提出的一种基于RGB-D的融合多分类器的面部表情识别算法,通过在CurtinFaces和KinectFaceDB人脸库上的实验表明,该算法的表情识别精度明显高于传统表情识别算法。对于基于深度信息的人脸表情识别系统的设计将是本文下一步的研究工作,从而使系统更具有实用性。

[1]Sherin Aly,Andrea Trubanova,Lynn Abbott,Susan White,Amira Youssef.A Kinect-based RGBD+Time Dataset for Spontaneous and Non-Spontaneous Facial Expression Recognition.

[2]J.Wang,L.Yin,X.Wei,Y.Sun.3D Facial Expression Recognition Based on Primitive Surface Feature Distribution.Computer Vision Pattern Recognition,2:1399-1406,2006.

[3]Hamit Soyel,Hasan Demirel.3D Facial Expression Recognition with Geometrically Localized Facial Features,23rd International Symposium on ISCIS,2008.

[4]Mariusz Szwoch.On Facial Expressions and Emotions RGB-D Database

[5]Billy Y.L.Li,Ajmal S.Mian,Wanquan Liu,Aneesh Krishna.Using Kinect for Face Recognition Under Varying Poses,Expressions, Illumination and Disguise.

[6]Lee S H,Choijy,Roym,et al.Local Color Vector Binary Patterns from Multichannel Face Images for Face Recognition.IEEE Transactions on Image Processing,2012,21(4):2347-2353.

[7]Lajevardi S M,Wu HR.Facial Expression Recognition in Perceptual Color Space.IEEE Transactions on Image Processing,2012,21(8):3721-3733.

[8]Liu Z,Liu C.Fusion of Complementary Discrete Cosine Features in the YIQ Color Space for Face Recognition.Computer Vision and Image Understanding,2008,111(3):149-262.

[9]Gonzalez R C,Woods R E,Eddins S L.Digital Image Processing using MATLAB.Pearson Education India,2004.

[10]Liu Z,Wu W,Tao Q,et al.Facial Expression Recognition Using a New Image Representation and Multiple Feature Fusion.Intelligent Science and Intelligent Data Engineering.Springer Berlin Heidelberg,2013:441-449.

[11]Ojansivu V,Heikkil.Blur Insensitive Texture Classification Using Local Phase Quantization.Image and Signal Processing 2008:236-243.

[12]Nanni L,Lumini A.Heterogeneous Bag of Features for Object/Scene Recognition.Applied Soft Computing,2013;13(4):2171-2178.

[13]Ojala T,Pietikainen M,Maenpaa T.Multiresolution Gray-Scale and Rotation Invariant Texture Classification with Local Binary Patterns.IEEE Transactions on Pattern Analysis and Machine Intelligence,2002,24(7):971-987.

[14]Guo Y,Zhao G,Pietikinen M.Discriminative Features for Texture Description.Pattern Recognition,2012,45(10):3834-3843.

[15]Liu H,Xu T,Wang X,et al.Related HOG Features for Human Detection Using Cascaded AdaBoost and SVM Classifiers.Advances in Multimedia Modeling.Springer Berlin Heidelberg,2013:345-355.

[16]Gu W,Xiang C,Venkatesh Y V,et al.Facial Expression Recognition Using Radial Encoding of Local Gabor Features and Classifier Synthesis.Pattern Recognition,2012,45(1):80-91.

[17]Bairagi B K,Chatterjee A,Das S C,et al.Expressions Invariant Face Recognition Using SURF and Gabor Features.2012 Third International Conference on Emerging Applications of Information Technology(EAIT),IEEE,2012:170-173.

[18]Rui Min,Neslihan Kose,Jean-Luc Dugelay,KinectFaceDB:A Kinect Database for Face Recognition,Systems,Man,and Cybernetics: Systems,IEEE Transactions on,vol.44,no.11,pp.1534,1548,Nov.2014,doi:10.1109/TSMC.2014.2331215

[19]G.Passalis,P.Perakis,T.Theoharis,I.Kakadiaris.Using Facial Symmetry to Handle Pose Variations in Real-World 3D Face Recognition.IEEE Trans.on Pattern Anal.and Machine Intel.,33(10):1938-1951,2011.

[20]A.Mian,M.Bennamoun,R.Owens.An Efficient Multimodal 2D-3D Hybrid Approach to Automatic Face Recognition.IEEE Trans. on Pattern Anal.and Machine Intel.,29(11):1927-1943,2007.

Facial Expression Recognition Based on RGB-D

WU Hui-xia,TAO Qing-chuan,GONG Xue-you

(College of Electronic Information,Sichuan University,Chengdu 610065)

For two-dimensional facial expression recognition complex when poor lighting and illumination conditions,a low recognition rate of prob-lem,proposes a facial expression recognition algorithm based on multi-feature RGB-D fusion.Extracts their LPQ,Gabor,LBP and HOG feature information in image color information(Y,Cr,Q)and depth information(D)on,and the extraction of high-dimensional feature in-formation does linear dimensionality reduction(PCA)and feature space conversion(LDA),and then gives each face of weak classifiers nearest neighbor classification,and with AdaBoost algorithm weight distribution of weak classifiers to generate strong classifier,and finally with Bayes multi-classifier fusion,statistical output average recognition rate.With complex changes in lighting conditions and facial ex-pression libraries CurtinFaces KinectFaceDB,the algorithm average recognition rate of up to 98.80%.The results showed that:compared to a separate color image expression recognition algorithm,the fusion depth information can be more significantly improved the recognition rate of facial expression recognition,and has a certain value.

Expression Recognition;RGB-D;Depth Information;AdaBoost

1007-1423(2016)08-0066-07

10.3969/j.issn.1007-1423.2016.08.014

吴会霞(1993-),女,河北邯郸市人硕士,研究方向为计算机应用与图像识别

2016-01-28

2016-03-05

陶青川(1972-),男,四川南充人,副教授,研究方向为模式识别与智能系统、计算机应用与图像识别

龚雪友(1991-),女,四川泸州人,硕士,研究方向为电子与通信工程