改进的混合动静态背景的分割方法

刘天良,郑海红,罗圣美,梁玮,邓硕

(1.西安电子科技大学计算机学院,710071,西安;2.清华大学计算机学院,100084,北京;3.中兴通讯股份有限公司,518057,广东深圳)

改进的混合动静态背景的分割方法

刘天良1,郑海红1,罗圣美2,3,梁玮1,邓硕3

(1.西安电子科技大学计算机学院,710071,西安;2.清华大学计算机学院,100084,北京;3.中兴通讯股份有限公司,518057,广东深圳)

针对动静态背景场景下背景分割虚警率高的问题,提出了一种基于块直方图特征的Zivkovic混合高斯模型改进算法—BHZ-MoG。该算法设计了图像的块观测向量,并根据块观测向量的统计规律将图像块分类为动态、半动态、静态块,由此给出了结合块观测向量与块分类的块直方图特征提取算法,同时结合块直方图特征与Zivkovic混合高斯模型对不同类型的块分别进行背景分割与模型更新。实验结果表明,相较于Zivkovic混合高斯模型,BHZ-MoG算法能够在保证查全率不变的情况下,有效提高背景分割结果的查准率;Zivkovic混合高斯模型及BHZ-MoG的最大F1分数分别为0.758和0.790,说明了BHZ-MoG算法可以获得较佳的前、背景分割效果。另外,BHZ-MoG算法还可有效降低Zivkovic混合高斯模型在动态背景下的虚警率。

背景分割;图像块分类;颜色直方图特征;混合高斯模型

背景建模是解决许多机器视觉问题的基础步骤,目前存在许多不同的静态背景建模方法,例如混合高斯模型[1](mixture of Gaussians, MoG)、码本[2]、ViBe[3]等,但对动态背景处理效果不佳。Zivkovic的混合高斯模型(Zivkovic-mixture of Gaussians, Z-MoG)[4]因能较好地分割静态背景且不会产生“鬼影”而被广泛使用,然而现实中混合高斯模型对于动态背景虚警率偏高。据此,许多文献提出了针对动态背景的分割方法。文献[5]将图像划分成块,运用归一化矢量距离来度量块的相关性,从而实现动态场景的分割,但分割结果较粗糙。文献[6]使用自回归移动平均模型取得了较好的效果,但只针对高度规律的动态场景。文献[7-8]将混合高斯模型扩展到邻域,并使用马尔可夫随机场进行前、背景分割,但算法的时间复杂度急剧升高。文献[9]对视频帧进行前后双向分析,再利用马尔可夫随机场分配标签、通过高斯混合模型进行背景建模,但需要一定延迟以获得前向信息。与静态背景建模方法相比,动态背景处理方法通常会降低静态背景下前景分割的准确率,特别是在混合动静态背景的场景中。

为解决现有方法在混合动静态背景中存在的问题,本文基于对背景中动静态块分类分治的思想,设计了基于块内随机采样的具有时域特性的块观测向量;根据块观测向量,推导出动态、半动态、静态块的分类规律,提出了分类标准,并给出分类算法;给出了基于块分类与块直方图特征相结合的混合高斯改进算法(block histogram with Zivkovic-mixture of Gaussians, BHZ-MoG)。实验表明,BHZ-MoG算法可以有效提高混合场景中背景分割的效果。

1 Zivkovic的混合高斯模型[4]

视频I中包含背景GB和前景GF,x(i)表示第i帧的单像素HSV(hue,saturation,value)颜色空间三通道值。选择某个时间长度T,若当前帧的时间为t,则It={I(t),I(t-1),…,I(t-T)}为I的训练集,Xt={x(t),x(t-1),…,x(t-T)}为像素x的训练集。

用M(M≤4)个高斯分量模拟像素分布,则有

(1)

Z-MoG更新计算如下

(2)

(3)

(4)

(5)

(6)

(7)

(8)

2 改进的混合高斯模型

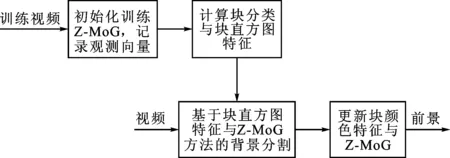

Z-MoG分割静态背景时效果较好,分割动态背景时虚警率较高;直方图特征法分割静态背景时准确性较差,分割动态背景时虚警率低。因此,背景图像需要进行动、静态块分类,再按类别进行分治,具体算法如下:①对动态、半动态块,结合块直方图颜色特征与Z-MoG进行背景分割;②对静态块,使用Z-MoG进行背景分割。该算法由两部分组成:①记录块的观测向量,对块进行分类;②根据块类型,利用观测向量计算块的直方图特征,再结合Z-MoG得到背景,然后分别对颜色特征及Z-MoG进行更新。算法流程如图1所示。

图1 BHZ-MoG背景分割算法流程图

2.1 背景图像的块分类

(9)

式中:ζ1为阈值,取值为10~15。

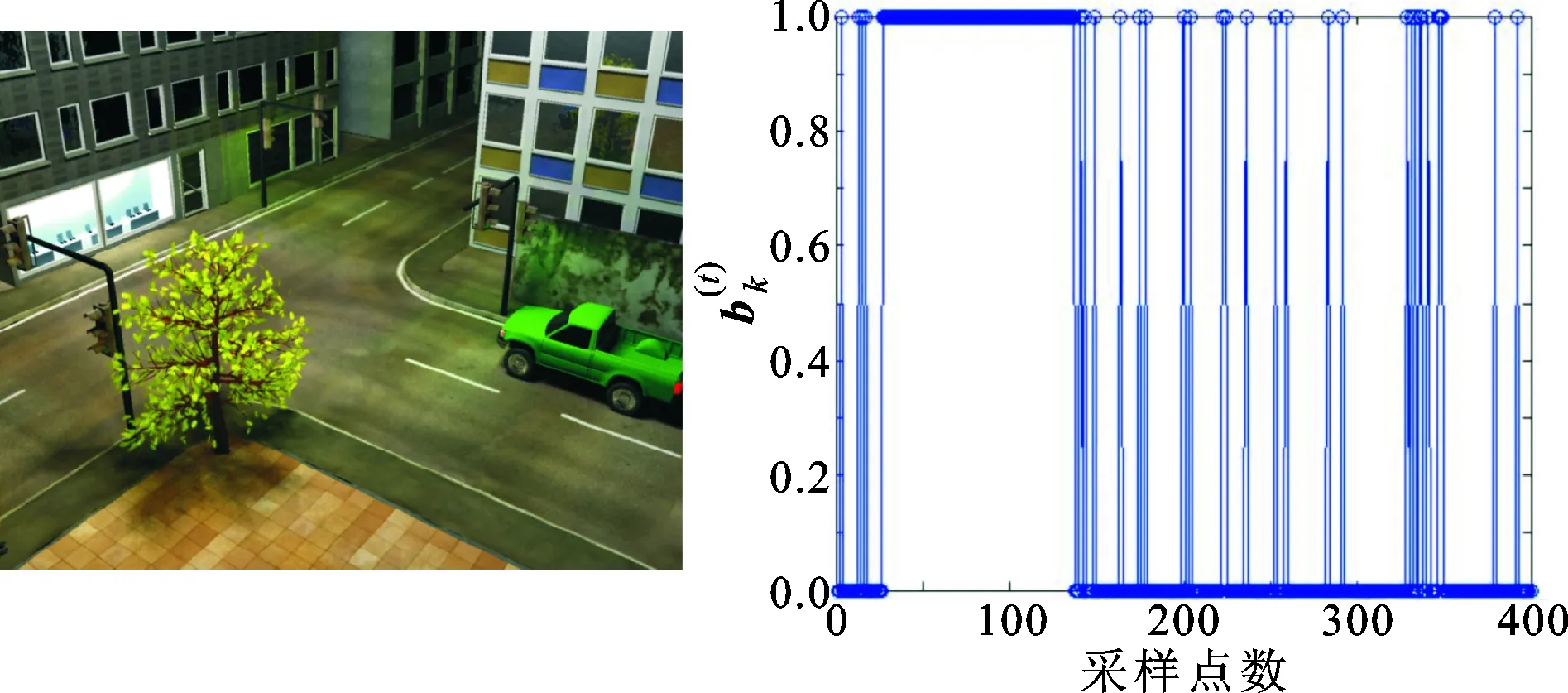

1:动态块;2:半动态块 (a)背景 (b)背景块划分N1=10

(c)前景覆盖背景(d)图c块的二值观测向量分布图2 背景分块与观测向量分布

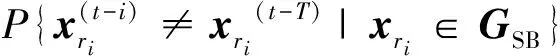

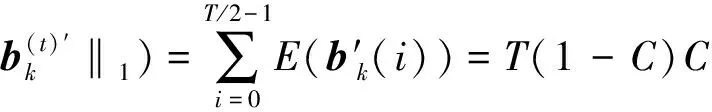

已知动态背景不断随时间变化[6],即概率上满足

(10)

(11)

i=0,1,…,T/2-1

(12)

由式(12)得

(13)

阈值ζ2不应过小,否则会因噪声产生误判。当动态背景所占块的比例大于1/20时,即C>1/20可区别噪声,由式(13)可得,h2=0.05。定义动态背景所占块的比例大于等于3/4,即C≥3/4为动态块,由式(11)、式(13)得h3=4。块的分类结果见图2b。

2.2 结合块直方图特征的分割算法BHZ-MoG

综上所述,已知描述块颜色特征的组号集合为H={hi,hj,…,hz},hi的组距为d、中点为ξi,ψi为块的第i组的颜色,块中像素x在时间T时的帧训练的混合模型个数为M(M≤4),BHZ-MoG背景分割算法为:x∈k,若块k是动态或半动态块,则x(t+1)∈[ψi-dM/8,ψi+dM/8],x(t+1)∈GB;否则,利用式(8)进行判断。

2.3 BHZ-MoG更新算法

H←H(t)+α(H(t+1)-H(t))

初始时,α是更新因子,代表颜色特征的可信度,当hi的可信度大于0.9时,颜色特征可信。

3 实验与分析

实验的测试视频序列为SABS-BASIC[11]、overpass[12]、fall[12]和water[6]。实验在AMD4400+/2.31 GHz计算机上使用Matlab仿真。实验中Z-MoG参数取自文献[11],其中a=0.001 3,DMahalan=80,Rf=0.1,ct=0.01。本实验选取参数T=800 帧,N1=10,N2=6,ζ1=15,HSV颜色空间直方图分为512组。本实验的对比算法为MoG、ViBe、G-MoG[7]、T2FMRF[8]及Z-MoG。

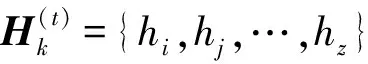

实验从前景分割测评指标与前景分割结果两方面对BHZ-MoG及各对比算法进行了比较。对视频序列SABS-BASIC,使用查全率与查准率映射关系及最大F1分数[11]比较,实验结果如图3和表1所示。为减少算法在动态背景下的虚警数,MoG、ViBe、G-MoG、T2FMRF均以牺牲前景查全率为代价。由图3可知,当查全率大于0.7时,上述算法的查准率呈指数下降,而Z-MoG和BHZ-MoG可以在获得高查全率(0.9)的基础上,保持较高查准率(大于0.7)。由于BHZ-MoG对背景中动、静态块分类分治,因此其在提高查准率的同时,并未降低查全率,图3中BHZ-MoG的查全率查准率曲线位于Z-MoG之上即可验证此结论。如文献[11]所述,使用最大F1分数可综合评定算法前景分割效果。由表1可知,BHZ-MoG算法可以得到较好的前景分割效果。

图3 各算法查全率查准率映射图

最大F1分数MoGG⁃MoGViBeT2FMRFZ⁃MoGBHZ⁃MoG079907630761065507580790

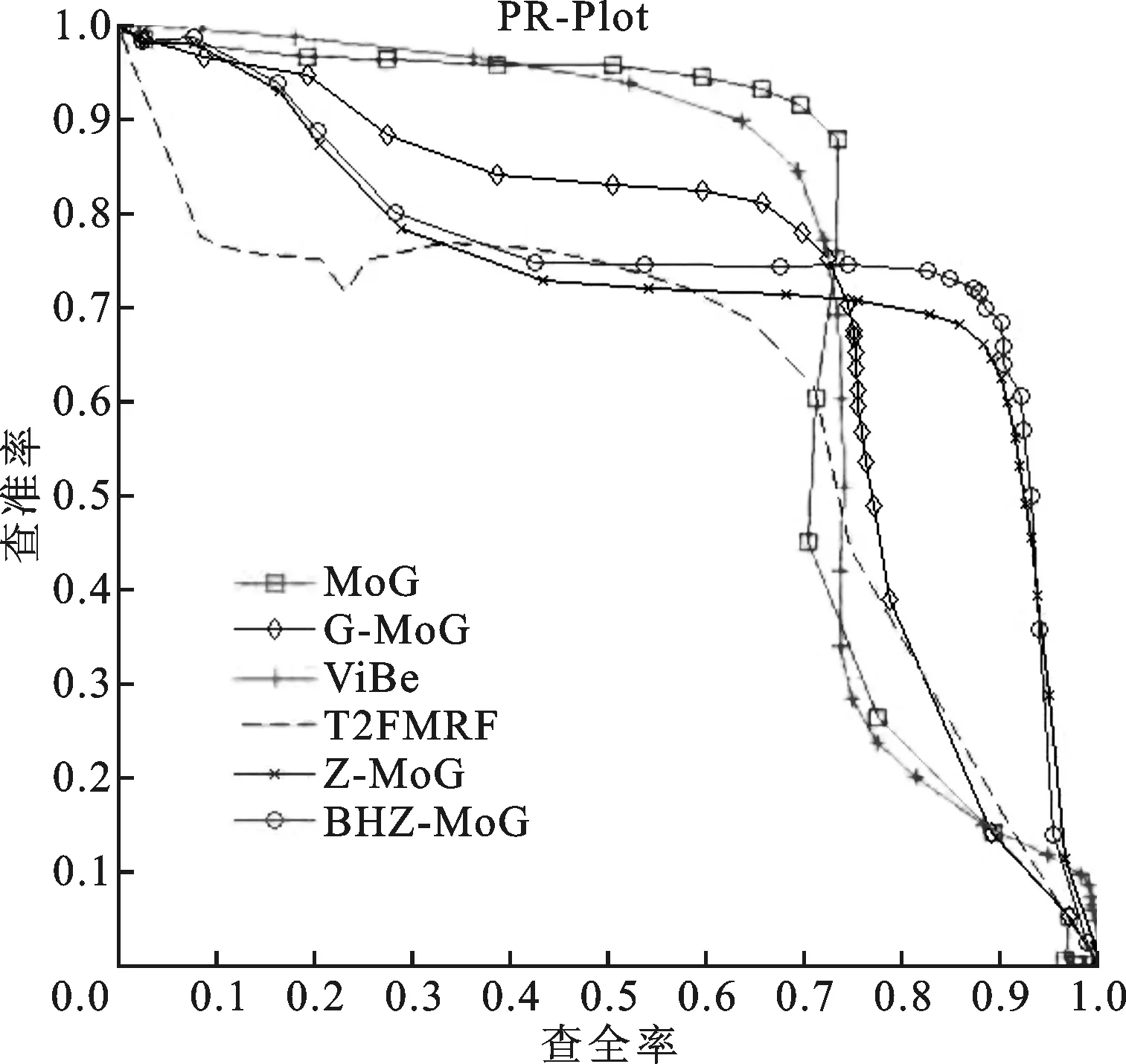

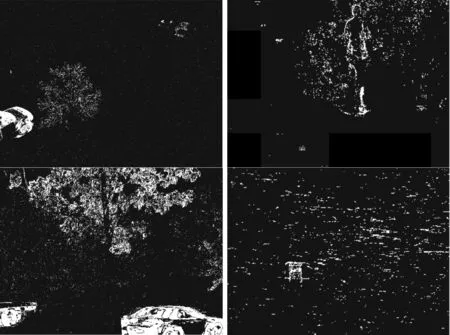

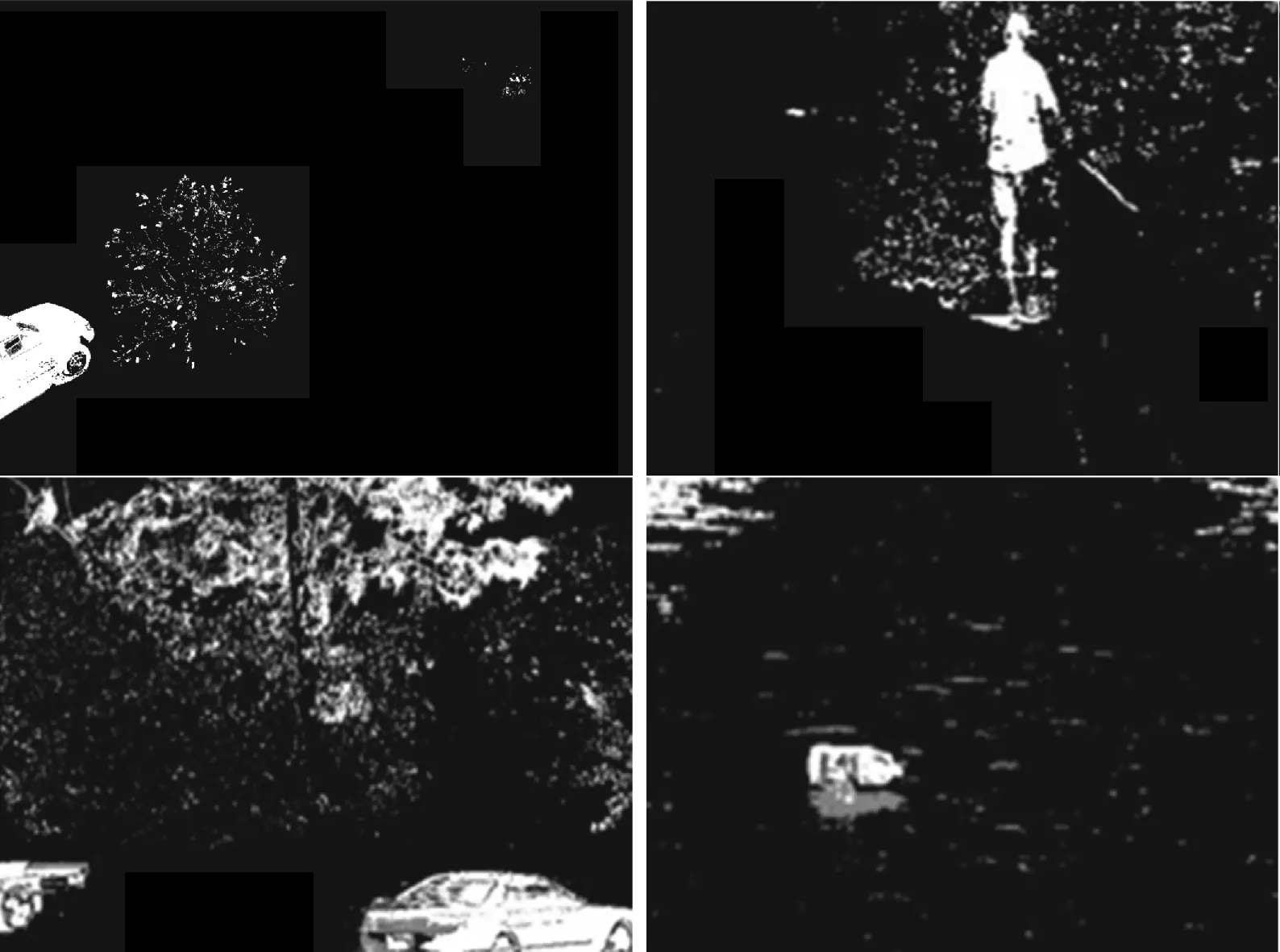

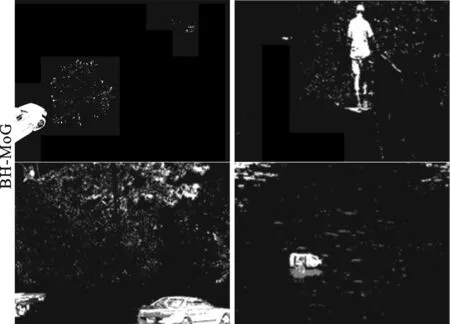

各测试视频序列的前景分割结果与算法运算速度比较如图4和表2所示。由图4可知,MoG、G-MoG、T2FMRF算法在降低了前景命中率的同时仍会产生较高虚警。原因是MoG高斯分量过少,G-MoG与T2FMRF算法利用马尔可夫随机场进行前景平滑分割时降低了前景命中率,同时由于动态背景颜色特征丰富,因而虚警率较高。ViBe与Z-MoG算法通过增加背景分量虽然保证前景命中率,但虚警率也较高。BHZ-MoG由于利用动静态块分类,避免了前景命中率的下降,同时利用块颜色直方图特征,降低动态颜色特征丰富的影响。图4显示, BHZ-MoG 算法可在获得较完整前景的基础上,有效降低树和水运动产生的虚警,因而验证了算法的有效性。由于图4a中动态背景较稀疏,图4b、图4c中动态背景存在大幅运动,因而BHZ-MoG算法分割前景仍会产生少量噪声。图4d的背景训练集仅173帧,当训练集帧数较低时,观测向量采样点较少,因此不能很好表达动态背景颜色分布,只能减少部分前景噪声。由表1可知,相较于MoG、G-MoG、ViBe与Z-MoG,BHZ-MoG并不会大幅增加处理时间,且处理速度远高于T2FMRF与G-MoG。原因在于T2FMRF与G-MoG利用时间复杂度极高的马尔可夫随机场逐像素分割前背景,而BHZ-MoG是结合块直方图特征计算前背景,并且每帧每块只随机采样一个像素点进行块更新。

(a)SABS-BASIC (b)overpass

(c)fall (d)water

(e)GroundTruth

(f)MoG

(g)G-MoG

(h)ViBe

(i)T2FMRF

(j)Z-MoG

(k)BH-MoG

表2 各算法单帧处理时间比较

4 结 语

本文针对Z-MoG对混合动静态背景虚警率高的问题,提出了利用观测向量进行块分类,同时考虑了像素在动态、半动态块上的联系,由此提出了块直方图颜色特征与Z-MoG相结合的BHZ-MoG改进算法,该算法可以使得分割背景的虚警率有效降低,前、背景分割质量提高。

[1] STAUFFER C, GRIMSON W. Adaptive background mixture models for real-time tracking [C]∥Proceed-ings of the IEEE Conference on Computer Vision and Pattern Recognition. Piscataway, NJ, USA: IEEE, 1999: 246-252.

[2] KIM K, CHALIDABHONGSE T H, HARWOOD D, et al. Real-time foreground background segmentation using codebook model [J]. Real-Time Imaging, 2005, 11: 172-185.

[3] BARNICH O, VAN DROOGENBROECK M. ViBe: a powerful random technique to estimate the background in video sequences [C]∥Proceedings of the IEEE Conference on Acoustics, Speech and Signal Processing. Piscataway, NJ, USA: IEEE, 2009: 945-948.

[4] ZIVKOVIC Z. Improved adaptive Gaussian mixture model for background subtraction [C]∥Proceeding of the 17th International Conference on Pattern Recognition. Piscataway, NJ, USA: IEEE, 2004: 28-31.

[5] MATSUYAMA T, OHYA T, HABE H. Background subtraction for non-stationary scene [C]∥Proceeding of the Asian Conference on Computer Vision. Berlin, Germany: Springer, 2000: 622-667.

[6] ZHONG J, SCLAROFF S. Segmenting foreground objects from a dynamic textured background via a robust Kalman filter [C]∥Proceedings of the 9th IEEE International Conference on Computer Vision. Piscataway, NJ, USA: IEEE, 2003: 44-50.

[7] DALLEY G, MIGDAL J, GRIMSON W. Background subtraction for temporally irregular dynamic textures [C]∥Proceedings of the IEEE Workshop on Applications of Computer Vision. Piscataway, NJ, USA: IEEE, 2008: 1-7.

[8] ZHAO Zhenjie, THIERRY B, ZHANG Xuebo, et al. A fuzzy background modeling approach for motion detection in dynamic backgrounds [C]∥Proceedings of the Multimedia and Signal Processing Communications in Computer and Information Science. Berlin, Germany: Springer, 2012: 175-178.

[9] SHIMADA A, NAGAHARA H, TANIGUCHI R. Background modeling based on bidirectional analysis [C]∥Proceedings of the IEEE International Conference on Computer Vision and Pattern Recognition. Piscataway, NJ, USA: IEEE, 2013: 1979-1986.

[10]KIM W J, KIM C. Background subtraction for dynamic texture scenes using fuzzy color histograms [J]. IEEE Signal Processing Letters, 2012, 19(3): 127-130.

[11]BRUTZER S, HÖFERLIN B, HEIDEMANN G. Evaluation of background subtraction techniques for video surveillance [C]∥Proceedings of the IEEE International Conference on Computer Vision and Pattern Recognition. Piscataway, NJ, USA: IEEE, 2011: 1937-1944.

[12]GOYETTE N, JODOIN P, PORIKLI F, et al. Changedetection.net: a new change detection benchmark dataset [C]∥Proceedings of the 2012 IEEE Computer Society Conference on Computer Vision and Pattern Recognition Workshops. Piscataway, NJ, USA: IEEE, 2012: 16-21.

(编辑 武红江)

An Improved Subtraction Algorithm of Backgrounds with Stationary and Non-Stationary Scenes

LIU Tianliang1,ZHENG Haihong1,LUO Shengmei2,3,LIANG Wei1,DENG Shuo3

(1. School of Computer Science and Technology, Xidian University, Xi’an 710071, China; 2. School of Computer, Tsinghua University, Beijing 100084, China; 3. Zhongxing Telecommunication Equipment Corporation, Shenzhen, Guangdong 518057, China)

An improved algorithm—BHZ-MoG of Zivkovic-mixture of Gaussians (Z-MoG) based on block histogram feature is proposed to solve the problem that the background subtraction has a high false alarm rate in the mixture of stationary and non-stationary scenes. Observation vectors for image blocks are designed and blocks are classified into static, dynamic and half-dynamic blocks according to the statistical regularities of the observation vectors. A method that combines the observation vector and the classified information of a block is presented to extract block histogram feature. Block background models are constructed and updated from the combination of Z-MoG and histogram features. The BHZ-MoG can effectively reduce the high false alarm rate of Z-MoG under dynamic backgrounds. Experimental results show that the precision of the BHZ-MoG is higher than that of Z-MoG while the recall keeps the same. The maximal F1-scores of the Z-MoG is 0.758 and that of the BHZ-MoG is 0.790, and it shows that the proposed algorithm can provide better subtraction results.

background subtraction; image block classification; color histogram feature; mixture of Gaussians

2014-06-06。

刘天良(1989—),男,硕士生;郑海红(通信作者),女,副教授。

国家“十二五”预研项目(513160702);中央高校基本科研业务费专项资金资助项目(K5051303013,K5051303014);中兴通讯股份有限公司研究基金资助项目(HX0114030318)。

时间:2015-01-07

10.7652/xjtuxb201502005

TP391

A

0253-987X(2015)02-0025-06

网络出版地址:http:∥www.cnki.net/kcms/detail/61.1069.T.20150107.1647.002.html