面向真实监控环境的前视步态识别方法*

姜颖军 王建新 郭克华

(中南大学 信息科学与工程学院, 湖南 长沙410083)

人们行走的方式结合行走的姿态,形成了步态.由于步态特征各异,且具有非入侵(不需接触)、难以伪装和欺骗、可远距离获取等优点,故步态在监控和访问控制中拥有了强大的生物识别潜力[1-2].特别是在刑事案件侦查中,由于一个人的步态具有时不变性,使得通过犯罪现场监控视频获取的步态成为重要、甚至是唯一的生物识别依据.目前,步态识别系统已成为取证工具之一,通过步态分析获取的证据也已用于法庭起诉[3].

当利用计算机系统识别行人步态时,由于侧视步态相对于前视步态能更好地反映人体行走的周期运动特性(如步幅、步频、相位及移动速度等运动参数),使得侧视步态的识别率明显高于前视步态.然而,前视步态相对于侧视步态更能体现行人的身体轮廓、双手左右摆动姿势、头部和肩部晃动幅度等时空特性及行人着装的颜色分布特征,这些特性更有利于人类肉眼识别、跟踪他人.因此,在真实的室外环境下,监控摄像机一般安装在离地面3~5m的高度,监控头光心轴线水平投影方向与行人来往方向基本一致,以获取行人前视步态.笔者随机对CSUPD 数据库[4]中1785 位行人的视频序列进行统计,为前视步态序列的有1 481 位,占总数的83%.因此,在真实监控环境下,前视步态识别研究具有重要的实际意义.

近年来,结合行人行走的时空特性,人们针对前视步态主要提出了两类识别方法:基于前视步态轮廓图像边缘特征的识别方法[5-6]和基于前视步态轮廓图像区域特征的识别方法[7-8].

针对步态轮廓图像边缘,边缘曲率分布法(CSM)[5]用边缘曲率来描述行人轮廓边缘的凹凸特性,以此描述行人躯干和四肢横向运动特征,从而实现前视步态识别.该方法经轮廓图像边缘检测后,指定轮廓边缘上某一像素点为起点,根据当前像素点和下一相邻像素点的相对位置,计算当前像素点的梯度值,其中正梯度值表示边缘凸起,负梯度值表示边缘凹陷.CSM 在运动前景轮廓边缘清晰、测试者行走方向固定不变的前提下能取得良好的步态识别效果.矩形特征法(IIFRSD)通过提取覆盖在二值行人轮廓图像上的系列最大矩形的特征来实现前视步态识别[6].该方法提取由系列最大矩形的宽和3 种高组成的3 种几何特征,采用超树降维,并通过基于时间窗口的主投票策略来提高分类准确性.在实际的监控环境中,背景的复杂多变导致前景图像难以清晰分离、轮廓图像边缘不能准确提取而极大影响了识别效率.

与基于轮廓图像边缘特征的识别方法不同,基于轮廓图像区域特征的识别方法则提取覆盖行人轮廓的所有像素的统计特征.该方法提取一个步态周期内多帧步态轮廓图像的统计特征,对噪声和形变具有鲁棒性.Jegoon 等[7]采用球型空间坐标系统(ρ,θ,φ)(0≤ρ≤R,0≤θ≤ ,0≤φ≤2 )来描述立体监控下获取的人体步态点云(为适用于前视步态识别,作者根据几何投影原理,将三维人体点云投影至行人前进方向,得到二维前视步态点云),将一个步态周期形成的步态点云序列图(MIP)划分成5×12×24 个盒子,然后计算每个盒子内的像素密度(点分布强度)并作为识别特征.Kusakunniran 等[8]基于视角不变转换(VTM)模型,利用直方图技术将步态能量图(GEI)分割成6 个区域,并在步态图的下肢运动区域选取感兴趣区域(ROI),然后利用已知的同一对象不同视角间ROI 像素的对应关系,确定步态图从一个视角转换至另一个视角的转换矩阵.这两种方法针对前视步态识别都取得了较好的识别效果,但都需要已知行人步态视角,而在真实监控环境下,行人步态视角是变化的.针对以上方法存在的问题,文中在VTM 模型[8]基础上,针对真实环境下的行人步态,提出了一种视角不变的前视步态识别方法:先利用行人步态图质心轨迹计算行人步态视角,再通过视角转化来达到良好的前视步态识别效果.

1 前视步态识别方法

文中通过背景减除与行人检测确定视频序列中的行人,然后利用GEI 分别计算行人头部和躯干的质心,对系列轮廓质心进行分段直线拟合,获取运动迹线,确定行人运动视角并规范视角转换,最后采用主成分分析(PCA)和Fisher 判别法对规范后的步态图进行特征提取和识别.前视步态识别的基本流程如图1所示.

为便于问题描述,文中将行人移动路线与监控头光心轴线的夹角θ 定义为视角(如图2所示),视角小于或等于60°的步态为前视步态,视角大于60°的步态为侧视步态.

图1 前视步态识别的流程图Fig.1 Flowchart of front-view gait recognition

图2 步态视角示意图Fig.2 Schematic diagram of gait view angle

1.1 基于步态能量图的质心计算

文献[9]通过计算序列帧中行人的头和脚的质心位置来确定行人的运动方向.这种方法存在以下不足:对于实际环境下的视频图像,无论采用背景减除法或光流法,都难以良好地将运动前景与背景分割,且分割后的行人轮廓存在大量毛刺,边缘不清晰(如图3(a)所示),因此根据单幅图像难以确定行人头、脚等身体部位,进而得到头、脚的质心位置.文献[10]中采用无接触方法,利用Haar 小波算子检测膝盖和脚踝的位置,但在真实环境下的检测极为困难.

图3 不同行人的步态能量图Fig.3 Gate energy images of different pedestrians

文中充分利用行人行走时的时空特性,采用文献[11]的步态能量图计算方法,针对系列二值化轮廓图像Bt(x,y),计算一个周期内的步态能量图:

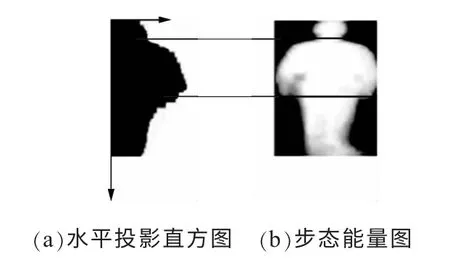

式中,N 为一个步态周期内的视频帧数,t 为该周期内视频帧的序列号,(x,y)为像素坐标.根据式(1)所产生的步态能量图如图3(b)所示.步态能量图能很好地反映行人的轮廓以及一个周期内轮廓的变化情况,区域像素值越大,肢体在该区域内运动越频繁.通过直方图技术,可将步态能量图分割出头部、躯干部、下肢部[8].如图4所示,直方图的值表示GEI 每行像素值的累加和,通过均值滤波平滑直方图后,从上至下位于第1 个峰值(极小值)的水平线为头部与躯干部的分割线,位于第2 个极值(最大值)的水平线为躯干与下肢部分的分割线.从GEI 水平投影直方图可知:对于前视步态能量图,由于正常情况下下肢运动主要为前后运动,其左右运动的区域远小于上肢左右摆动的区域,因此,行走过程中双脚是否被遮挡都不会影响图中上肢的位置.

图4 步态能量图的分割Fig.4 Division of the gait energy images

针对每一分割后的步态能量图,文中采用文献[12]中的质心计算方法,分别得到头部质心位置Ch=(Chx,Chy)和躯干部质心位置Cb=(Cbx,Cby),然后求两个质心位置的均值,得到行人轮廓质心S=(Sx,Sy),如图5所示.

图5 行人质心位置图Fig.5 Centroid position image of a pedestrian

质心计算方法如下:

式中,Mhpq为步态图头部矩,Mbpq为躯干部矩,p、q 为阶数,Ght(i,j)为位于第t 个步态能量图头部(i,j)位置的像素值,Gbt(i,j)为位于第t 个步态能量图躯干部(i,j)位置的像素值.

1.2 步态图视角计算与视角转换

人们在室外行走过程中,一般会沿直线行走,但由于道路方向和道路上障碍物的影响,往往需要改变行走方向,因此监控画面中行人的行走路线往往是由多条直线段组成的一条折线.为了计算行人步态视角,文中根据文献[13]方法,先通过该行人系列轮廓质心拟合出行走过程中的每一条直线段,然后分别计算每条直线段与摄像头光心轴线的夹角.拟合出前后相连的直线段的关键是寻找直线段与直线段的结合点,若代表结合点位置的轮廓质心已确定,则只需将这些轮廓质心按顺序前后相连,即为行人行走迹线.设行人k 的轮廓质心集为Sk={Ski|i=1,2,…,n},则确定结合点(其示意图见图6)的具体步骤如下:

(1)初始化集合L={1},b=1,e=n;

(2)用直线连接Skb和Ske;

(3)分别计算点Skb+1,Skb+2,…,Ske-1到直线SkbSke 的距离;

(4)确定到直线SkbSke 距离最大的点Skd(b (5)如果Di大于设定阈值T,则L=L∪{d},并令b=1,e=d 和b=d,e=e,返回步骤(2); (6)L=L∪{n}. L 即为行人k 行走迹线结合点的集合.图6中的Skb→Skd→Ske即为拟合后的行走迹线.阈值T 不同,拟合后的行走迹线也不同,本实验针对迹线中的所有线段,采用同一阈值进行结合点判别. 图6 结合点确定示意图Fig.6 Schematic diagram of linked point determination 通过上述方法即可计算出行人在行走过程中每条直线段的视角,这是自动进行步态能量图视角转换并重建步态能量图像序列的基础.在获取步态能量图视角后,根据VTM 模型[8]将行人k 在视角θi下的步态能量图gθki转换成视角θj下的步态能量图,即 为通过步态能量图提取由行人身体轮廓和运动方式差异决定的步态特征,而不是由亮度等差异决定的特征,文中采用PCA 降维后结合Fisher 方法进行特征提取与对象识别,该方法实质上是对原始样本数据进行两次投影,即PCA 降维投影和Fisher最优鉴别投影.由于PCA 降维形成的特征投影子空间没有区分亮度(灰度)差异,故亮度不同的同一行人步态在该子空间投影后,投影值会不同.为克服此缺点,文中利用Fisher 线性判别法,通过最大化步态类间距离与步态类内距离的比值获取最优鉴别的投影矩阵,从而实现不同行人间的步态识别.为衡量不同视角下两个步态能量图的相似性,先将步态能量图转换至同一视角,再利用最优鉴别矩阵进行投影并计算投影后的两步态能量图矢量间的欧氏距离,距离值越小,则相似度越高. 在两类数据库上对CSM、IIFRSD、SSM-HPC[7]及文中方法进行对比测试.第1 类数据库是中国科学院自动化研究所建立的CASIA 数据库[14];第2 类数据库是中南大学建立的CSUPD 数据库,其数据来自湖南省“平安城市”监控视频,包括街道、路口、公交车站等处的监控数据.CSUPD 数据为不同参数的相机在不同角度和不同光照条件下获得的行人视频.文中根据以下条件在两类数据库内进行样本数据选择: (1)从CASIA-B 步态数据库中选取124 个行人样本,每个样本由4 个不同视角(0°、18°、36°、54°)下的前视步态的视频序列组成,每个视角对应4 个视频序列. (2)从CSUPD 步态数据库中选取120 个行人样本,每个样本对应两个步态视角小于60°的视频序列.这两个视频序列由两个不同监控摄像机获取,记录了同一行人样本先后经过两个相应的监控摄区域,每个视频序列的时长为6~10 s,含4 个以上步态周期.两个监控摄像机位于同一街道,相距约100 m.文中将第1 个摄像机获取的视频序列作为目标序列,第2 个摄像机获取的视频序列作为查询序列.每个视频序列中的步态视角采用前面方法进行计算. 为对比CSM、IIFRSD、SSM-HPC 及文中方法的前视步态识别能力,以视角为36°的行人视频序列为查询集,分别在视角为0°、18°、36°、54°的目标集中查找目标,结果如图7所示.根据图可知:当查询集与目标集的视角相同,即目标集为36°的视频序列时,4 种方法都取得了良好的识别效果,相似度等级排名前5 的目标查中率(识别率)都超过90%,而随着查询集与目标集的视角差的增大,前3 种方法的识别率下降很快.当目标集为18°和54°的视频序列时,前3 种方法的正确识别率低于80%,文中方法的正确识别率则高于90%;当目标集为0°的视频序列时,前3 种方法的正确识别率低于70%,而文中方法的正确识别率为85%.导致前3 种方法识别率下降的原因主要是:当目标集的视角与查询集的视角不同时,算法未在比对识别前对视频序列进行视角转换,而文中方法则将目标集中的视频序列统一转换成视角为36°的视角不变视频序列后再进行相似性度量. 该测试以第2 个摄像机所获取的视频序列为查询集,以第1 个摄像机所获取的视频序列为目标集,通过比较“查询序列”中步态图像在“目标序列”中步态图像的查中率(识别率)来衡量各种前视步态识别方法的优劣.因同一行人是在短时间内通过两个监控摄像机的监控范围,着装保持不变,故无需考虑着装对步态轮廓的影响.根据图8(a),以相似度等级排名前5 的目标正确识别率作为对比依据,前3 种方法的正确识别率低于70%,而文中方法的正确识别率为81%.4 种方法在CSUPD 上的识别率低于在CASIA 上的识别率,原因是:CSUPD 中视频序列的成像背景比CASIA 的更复杂;CASIA的摄像机采用平视方法进行拍摄,行人轮廓在像平面内无形变,而CSUPD 摄像机采用俯视方法进行拍摄,行人轮廓在像平面内存在形变.此外,CSM[5]、IIFRSD[6]的识别率明显低于其他两种方法,主要是由于这两种方法未进行步态视角转换,且提取的特征是基于行人轮廓边界.由于人体是一个立体而非平面,视角不同,行人物平面内容不同,像平面内容也随之不同,视角差越大,物平面轮廓边界差别越大,像平面轮廓边界差别也越大,比对识别率也越低,如图8(b)所示. 图7 在CASIA 数据库上4 种方法的角前视步态识别效果比较Fig.7 Comparison of front-view gait recognition effect on CASIS database among four methods 图8 在CSUPD 数据库上4 种方法的前视步态识别比较Fig.8 Comparison of front-view gait recognition effect on CSUPD database among four methods 以上实验结果表明,相比现有的前视步态识别方法,文中方法的正确识别率有了较大的提高.特别是在真实监控环境下,文中基于步态能量图的步态视角计算和自动视角转换,在步态视角差超过45°的情况下,仍对前视步态保持稳定的识别率,CSUPD上13 对视角差大于45°的视频序列(共计3 917 帧)的测试结果表明,文中方法的正确识别率为77%,而其他3 种方法都低于52%.实验在酷睿i7、四核1.7GHz 台式机上完成,文中算法的识别速度达每秒21 帧,基本上实现了视频序列图像的实时识别. 步态特征作为一种可远程且隐蔽获取的生物特征,已激起人们持续的研究兴趣,但现有的步态识别方法主要针对45°~90°的侧视步态,并需要摄像机参数校正.针对真实监控环境下的步态识别,识别系统应该做到不依赖相机参数校正、自适应前视或侧视步态.为此,文中根据GEI 质心计算行人运动迹线并确定行人步态视角,根据视角将待识别步态规范成前视步态或侧视步态.测试结果表明,相对于其他方法,文中方法在未知相机参数的前提下,对难以识别的前视步态图取得了更好的识别效果.今后将根据单目监控视频的二维特性寻找更优的、不受环境条件控制的步态时空特性模型,通过快速且准确的方向计算和视角转换使步态识别具备更吸引人的通用性能. [1]Bashir Khalid,Xiang Tao,Gong Shaogang.Gait recognition without subject cooperation [J].Pattern Recognition Letters,2010,31(13):2052-2060. [2]Jean Frédéric,Albu Alexandra,Bergevin Rorbet.Towards view-invariant gait modeling:computing view-normalized body part trajectories [J].Pattern Recognition,2009,42(11):2936-2949. [3]Bouchrika Imed,Goffredo Michaela,Carter John,et al.On using gait in forensic biometrics [J].Journal Forensic Science,2011,56(4):882-889. [4]中南大学信息科学与工程学院.CSUPD pedestrian database [DB/OL].(2013-06-07)[2014-01-22].http://netlab.csu.edu.cn/bioinformatics/web/csupd.htm. [5]Soriano Maricor,Araullo Alessandya.Curve spreads:a biometric from front-view gait video [J].Pattern Recognition Letters,2004,25(14):1595-1602. [6]Barnich Olivier,Droogenbroeck Marc.Frontal-view gait recognition by intra- and inter-frame rectangle size distribution [J].Pattern Recognition Letters,2009,30(10):893-901. [7]Jegoon Ryu,Kamata Sei-ichiro.Front view gait recognition using spherical space model with human point clouds[C]//Proceedings of the 18th International Conference on Image Processing.Brussels:IEEE,2011:3209-3212. [8]Kusakunniran Worapan,Wu Qiang,Zhang Jian,et al.Support vector regression for multi-view gait recognition based on local motion feature selection [C]//Proceedings of the 23rd IEEE Conference on Computer Vision and Pattern Recognition.San Francisco:IEEE,2010:974-981. [9]Jean Frederic,Bergevin Rorbet,Albu Alexandra Branzan.Body tracking in human walk from monocular video sequences [C]//Proceedings of the 2nd Canadian Conference on Computer and Robot Vision.Victoria:IEEE,2005:144-151. [10]Goffredo Michaela,Carter Jhon,Nixon Mark.Front-view gait recognition[C]//Proceedings of the 2nd International Conference on BTAS.Washington D C:IEEE,2008:1-6. [11]Han Ju,Bhanu Bir.Individual recognition using gait energy image [J].IEEE Transactions on Pattern Analysis and Machine Intelligence,2006,28(2):316-322. [12]Hu Ming-Kuei.Visual pattern recognition by moment invariants [J].IEEE Transactions on Information Theory,1962,8(2):179-187. [13]Jean Frédéric,Bergevin Rorbet,Albu Alexandra.Computing view-normalized body parts trajectories [C]//Proceedings of the 4th Canadian Conference on Computer and Robot Vision.Montreal:IEEE,2007:89-96. [14]中国科学院自动化研究所.CASIA gait database[DB/OL].(2005-01-10)[2014-02-25].http://www.cbsr.ia.ac.cn/china/Gait%20Databases%20CH.asp.

1.3 比对识别

2 实验结果与分析

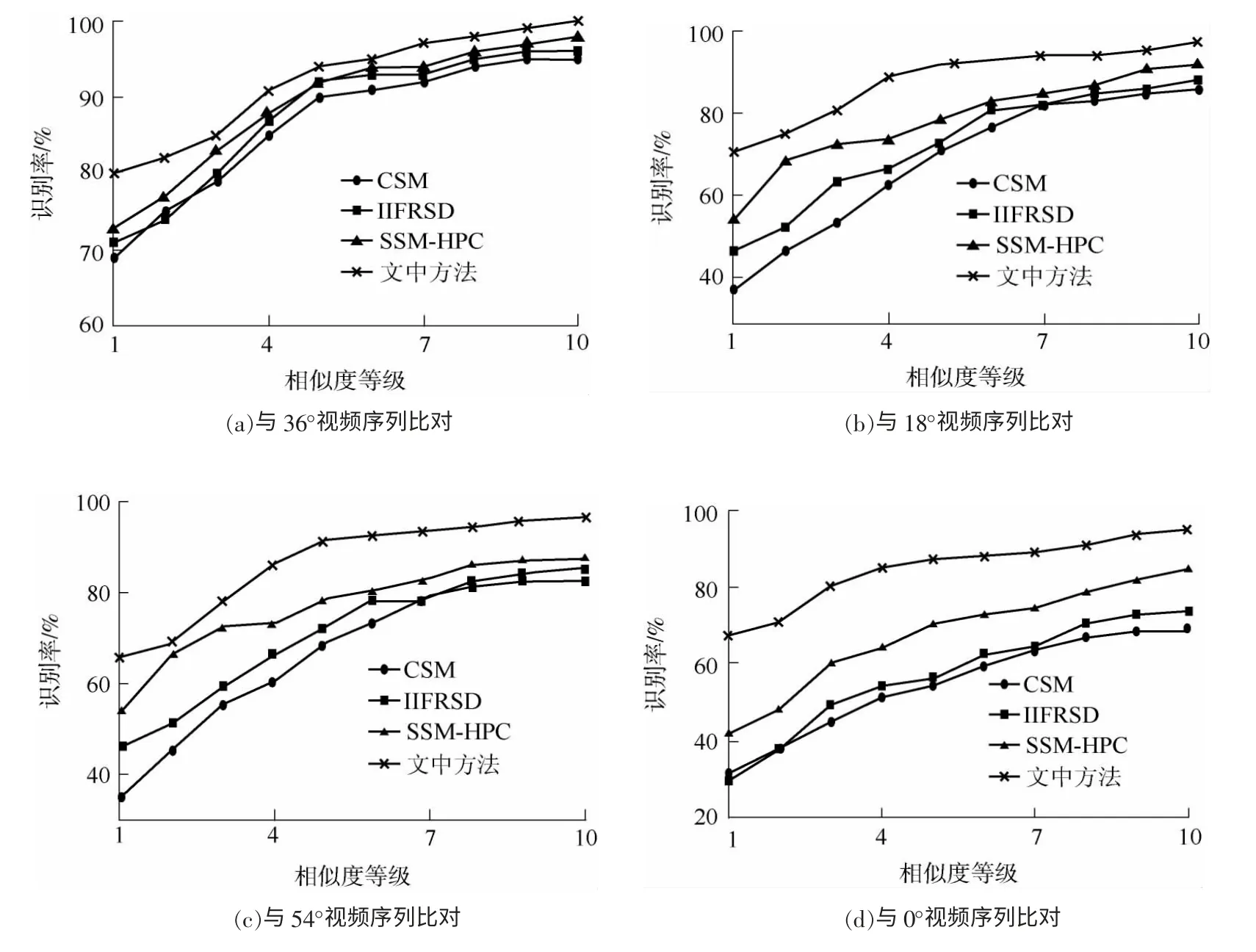

2.1 在CASIA 上的测试

2.2 在CSUPD 上的测试

3 结论