自适应PCA稀疏基底的分布式视频压缩感知重构

武明虎,李 然,陈 瑞,朱秀昌

(1.湖北工业大学 a.电气与电子 工程学院;b.太阳能高效利用湖北省协同创新中心,湖北 武汉 430068;2.南京邮电大学 江苏省图像处理与图像通信重点实验室,江苏 南京 210003;3.南京工程学院 通信工程学院,江苏 南京 211167)

自适应PCA稀疏基底的分布式视频压缩感知重构

武明虎1a,1b,李 然2,陈 瑞3,朱秀昌2

(1.湖北工业大学 a.电气与电子 工程学院;b.太阳能高效利用湖北省协同创新中心,湖北 武汉 430068;2.南京邮电大学 江苏省图像处理与图像通信重点实验室,江苏 南京 210003;3.南京工程学院 通信工程学院,江苏 南京 211167)

为了提高分布式视频压缩感知(Distributed Video Compressive Sensing,DVCS)的率失真性能,提出利用自适应稀疏基底进行联合重构。算法利用帧间运动信息形成样本数据矩阵,再利用主成分分析(Principle Components Analysis,PCA)训练出其显著主成分构成稀疏字典,该稀疏字典不仅可根据视频时空统计特征自适应变化而且可有效地抑制噪声。仿真实验表明,该联合重构算法可有效地改善主客观视频重构质量,能够以一定的计算复杂度为代价提高DVCS系统的率失真性能。

压缩感知;分布式视频压缩感知;主成分分析;自适应稀疏基底

压缩感知(Compressive Sensing,CS)的基本思想是以欠奈奎斯特速率采样信号,通过直接降维的方式在采样的同时压缩信号,并充分利用信号的稀疏先验知识复原信号[1-2]。CS测量方式以线性内积方式实现,具有较低的计算复杂度,但重构时却需要利用高计算负担的非线性优化算法,这种“轻编码、重解码”的特点使得CS理论与分布式视频编码(Dis⁃tributed Video Coding,DVC)[3]相结合,形成了一种新的视频压缩技术——分布式视频压缩感知(Distributed Video Compres⁃ sive Sensing,DVCS)[4-6],获得了广泛关注。

将CS应用到三维视频压缩中时,需要先克服视频CS测量所需内存巨大的问题,目前存在两种方案可有效解决该问题,第一种是采用结构化随机测量矩阵(Structurally Radom Matrices,SRMs)[7-8]实现视频帧CS测量,SRMs矩阵可利用快速正交变换算法以算子形式等价实现,从而避免构造需耗费大量内存的测量矩阵;另一种是采用分块压缩感知(Block Compressed Sensing,BCS)方式测量视频帧[9],这种测量方式不仅可实现低内存CS测量,且可逐块测量逐块发送,十分适合实时应用场合,因此其在DVCS中普遍获得使用[10-11]。在DVCS中,视频流被拆分为关键帧和非关键帧,关键帧可使用传统帧内视频编码技术(例如H.264)进行编解码或者以高测量率采样视频,并利用静止图像CS重构算法[12-14]进行复原。由于非关键帧的测量率较低,所以需要充分利用帧间和帧内相关性进行联合重构。文献[5]利用前后参考帧运动补偿内插出非关键帧的边信息SI(Side Information),再利用GPSR算法[15]重建非关键帧;文献[6]利用在时间上相邻的块,构造出基于关键帧的稀疏字典,再利用适当的算法预测出SI,最后使用静止图像CS重建算法重构出SI与原始帧的残差以增强重构精度;文献[16]首先使用CS重构算法进行独立帧内重构,再联合前后参考帧采用运动估计和运动补偿预测出SI,最后复原残差;文献[17]利用传统视频编码中的多假设(Multiple Hypotheses,MH)概念构造出各块的候选块集合,并以L2范数形式的Tikhonov正则化项代替L1范数形式的稀疏正则化项预测出非关键帧的SI,有效提升了重建速度和预测精度。

虽然上述方法获得了较好的视频重建质量,但是视频时空统计特性随时间变化,非关键帧的稀疏基底无法根据参考帧重建质量自适应变化和消除噪声。针对这个缺陷,本文提出一种自适应稀疏基底构造方法,该方法利用相邻帧间的运动信息寻找到非关键帧各块在参考帧的匹配块,并抽取其邻近块形成数据矩阵,由于参考帧往往包含噪声,因此利用主成分分析(Principle Components Analysis,PCA)计算出数据矩阵的主成分,挑选出其中较显著的主成分形成最终的稀疏字典。利用PCA训练得到的稀疏字典与待重构块具有较大相关性,所以可充分地发掘非关键帧的稀疏性,从而提高了其重建精度。在进行大量的仿真并分析其结果后,可以表明本文提出的CS重构算法,对分布式视频压缩感知系统的率失真性能有明显的提升,可得到较好的主客观视频重建效果。

1 分布式视频压缩感知框架

本文所提出的DVCS框架如图1所示。

图1 分布式视频压缩感知框架

首先,将原始视频分为关键帧和非关键帧,并对关键帧和非关键帧都利用分块压缩感知BCS[9]进行测量

式中:ytn为长度为MB的观测值向量;ΦB为高斯随机测量矩阵;xtn为第n个子块的列向量。定义测量率S=MB/B2。

针对非关键帧,利用参考帧和当前非关键帧xt的各块CS观测值ytn,形成相对应的自适应PCA稀疏基底正则化项,构造出CS重构模型并求解之,可得到当前非关键帧的预测帧(即SI)xSI。为了进一步提高非关键帧的重构质量,最后再进行残差重构。

2 自适应PCA稀疏基底重构算法

视频帧的统计特性是非平稳的,并不存在最优的固定稀疏基底(例如DCT基、小波基等)。为了能够充分发掘视频的稀疏性,应构造出与视频帧内容相关的自适应稀疏基底。文献[6,17]均直接利用待重构块在参考帧中的时间邻域块构造出稀疏字典,这种基于时间邻域块的稀疏字典虽然可随视频统计特性自适应变化,但其并不能始终保持与待重构块的高相关性,主要原因有两点:1)帧间存在运动;2)重构参考帧含有一定噪声。为了克服这两个缺陷,本文提出首先利用待重构块的CS观测值进行运动估计,搜索到其在相邻帧的最佳匹配块,并利用最佳匹配块的空间邻域块生成数据矩阵,由于数据矩阵包含噪声,再利用PCA训练出数据矩阵的主成分,挑选出较显著的主成分作为最终的稀疏基底以抑制噪声。以P帧情形为例,具体的构造步骤如下:

步骤1:设当前非关键帧待重构块xtn的CS观测值为ytn,由于高斯随机测量矩阵ΦB具有受限等距性(Restricted Isome⁃try Property,RIP)[18],因此xtn与其相邻帧的候选匹配块xcj之间的残差能量在测量域近似保持不变

那么,基于块匹配的运动估计可在测量域中直接进行

式中:S是尺寸为2S1×2S1的搜索窗口。如图2所示,以最佳匹配块xbn为中心,作半径为S2的搜索窗口,在窗口内逐像素抽取尺寸为B×B的块xpk,然后拉成列向量并按列排序为数据矩阵Xp=[xp1,xp2,…,xpK],其中K=2S2×2S2。

图2 数据矩阵Xp的构造示意图(P帧情形)

步骤2:由于构成数据矩阵Xp的各块xpk含有噪声,因此直接使用其作为稀疏字典并不是最优方案。采用PCA技术可训练出能够消除块xpk像素间统计冗余的正交变换矩阵P,利用该矩阵对图像子块作变换,可有效地分离数据矩阵Xp的有用信息和噪声。

首先,计算Xp的d×d(d=B2)协方差矩阵Ωp,即

再计算出协方差矩阵Ωp的d个特征值η1≥η2≥…≥ηd和相对应的规范化特征向量(主成分)p1,p2,…,pd,则可知正交变换矩阵P=[p1,p2,…,pd]。

步骤3:为了能够有效地分离数据矩阵Xp的噪声和有用信息,应寻找到能尽可能稀疏表示Xp中所有块xpn的稀疏字典Dn,即满足如下公式

式中:Λn是Xp在Dn上的系数矩阵;||·||F为Frobenius范数。可从正交变换矩阵P中分离出r个最显著的主成分形成字典Dnr=[p1,p2,…,pr],且在Dnr下的系数矩阵Λnr可简便地计算,即Λnr=DnrT·Xp。在式(6)中的重构误差||Xp-DnrΛnr||F2将随着r的升高而降低,而项||Λnr||1则会升高,所以r的最优值r*可由式(7)决定

最后,得到待重构块xtn的稀疏字典Dn=[p1,p2,…,pr*]。

步骤4:利用通过PCA学习到的稀疏字典Dn,构造如下的CS重构模型

该式可利用GPSR算法求解出xtn在Dn下的稀疏表示系数αtn,最后重构出预测块

3 实验结果与分析

实验采用的标准测试序列为:News,Bus,Foreman和Mo⁃bile。本文将偶数帧假设为非关键帧(P帧或B帧),奇数帧假设为关键帧(I帧)。本文所提出算法将在I-P-I模式和I-B-I模式两种不同的预测模式下进行。关键帧采用MH-BCS-SPL算法[14]进行独立帧内重建;针对非关键帧,分别采用文献[6]和文献[16]的算法进行重建,并与本文所提出的联合CS重建算法进行比较。本文算法,即重构模型(8),命名为APCA。具体参数设置如下:关键帧的测量率SK=0.7,B=16,搜索窗口半径S1=S2=B;图像子块半径b=3;挑选图像子块的阈值t=20;正则化因子λ1=0.2和λ2=0.5/k;c=10。评价性能的指标分别为PSNR、SSIM[22]和重构时间。

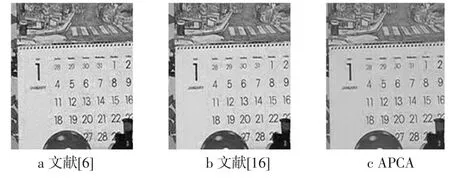

在模式为I-P-I时,各种算法重构出所有非关键帧的平均PSNR值和SSIM值如表1所示。分析表1的数据可得出,APCA重构出视频的SSIM值和PSNR值均高于文献[6]和文献[16]的算法。图3中显示了Foreman第8帧,测量率SNK=0.3时,各算法重构出的主观效果,通过主观视觉上的对比,可看出所提出算法可消除重构视频的模糊和块效应现象(嘴唇处),获得良好的主观视觉质量。

表1 I-P-I模式下,不同测量率下各视频重构算法的性能比较

图3 主观视觉对比图(Foreman第8帧)

表2列出了预测模式为I-B-I时,3种算法重构出所有非关键帧的平均PSNR值和SSIM值。首先,与I-P-I预测模式对比,视频的重构质量均得到改善,这是因为B帧情形不仅利用到了先前重构帧的信息,而且利用了未来重构帧的信息。各算法之间的性能差异与I-P-I预测模式相似,APCA算法重构出视频的PSNR值和SSIM值均高于文献[6]和文献[16]的算法。图4显示了测量率SNK=0.3时,各算法重构出的Mobile第4帧,可看出所提出算法能够获得良好的主观视觉质量。

表2 I-B-I模式下,不同测量率下各视频重构算法的性能比较

图4 主观视觉对比图(Mobile第4帧)

表3显示当测量率SNK=0.3时,重构Foreman序列的每一帧所需的平均时间。首先,可看出,I-P-I模式下所有算法的重构时间低于I-B-I模式,因此可知I-B-I模式重构质量的改善是以增加一定计算复杂度为代价的。另外,在任一预测模式下,本文所提出算法均加大了计算复杂度以获得视频重构质量的升高,这主要因为无论是在重构预测帧时还是在重构残差时,都引入了一定迭代。这也说明了本文算法的良好性能也是以增加一定计算复杂度为代价的。

表3 重构Foreman序列的时间对比(SNK=0.3)

4 结束语

本文利用视频帧间相关性构造出自适应PCA稀疏基底,提出了提高DVCS系统率失真性能的联合CS重构算法。由于视频帧的时空统计特性随时间变化,使用固定的稀疏基底无法有效地对视频帧进行稀疏表示,而直接从邻近参考帧抽取样本形成的字典虽然可随视频内容自适应改变,但却并不是最优方案,其原因是基于样本的稀疏字典缺乏帧间运动估计和参考帧包含噪声。本文所提出的稀疏基底构造法首先利用当前帧的CS观测值在测量域进行运动估计,再利用运动信息在相邻参考帧抽取样本形成数据矩阵,然后利用PCA计算出数据矩阵的显著主成分组成最终的稀疏字典以抑制噪声。本文所提出的算法在损失一定计算复杂度的前提下,有效地提高了分布式视频压缩感知系统的率失真性能,获得较好的主客观视频重建质量。

[1] BARANIUK R G.Compressive sensing[J].IEEE Signal Process⁃ing Magazine,2007,24(4):118-121.

[2]ELDAR Y C,KUTYNIOK G.Compressed sensing:theory and ap⁃plications[M].Cambridge:Cambridge University Press,2012:1-5.

[3]GIROD B,ARON A M,RANE S,et al.Distributed video coding [J].Proceedings of the IEEE,2005,93(1):71-83.

[4]BARON D,DUARTEM F,WAKIN M B,et al.Distributed com⁃pressive sensing[EB/OL].[2014-02-12]. www. arxiv.org/abs/ 0901.3403.

[5] KANG L W,LU C S.Distributed video compressive sensing[C]// Proc.IEEE International Conference on Acoustics,Speech and Signal Processing.Taipei:IEEE Press,2009:1169-1172.

[6] DO T T,CHEN Y,NGUYEN D T,et al.Distributed com⁃pressed video sensin[C]//Proc.IEEE International Conference on Image Processing.Cario,Egypt:IEEE Press,2009:1393-1396.

[7] DO T,GAN L,NGUYEN N,et al.Fast and efficient compres⁃sive sensing using structurally random matrices[J].IEEE Trans.Signal Processing,2012,60(1):139-154.

[8] LIKezhi,GAN Lu,LING Cong.Convolutional compressed sens⁃ing using deterministic sequences[J].IEEE Trans.Signal Process⁃ing,2013,61(2):740-752.

[9] GAN L.Block compressed sensing of natural images[C]//Proc.In⁃ternational Conference on Digital Siagnal Processing.Cardiff,UK:IEEE Press,2007:403-406.

[10]OECHARD G,ZHANG J,SUO Y,et al.Real time compres⁃sive sensing video reconstruction in hardware[J].IEEE Journal on Emerging and Selected Topics in Circuits and Systems,2012,2(3):604-614.

[11] HOLLOWAY J,SANKARANARAYANAN A C,VEERA⁃RAGHAVAN A,et al.Flutter shutter video camera for compres⁃sive of videos[C]//Proc.IEEE International Conference on Com⁃putational Photography.Seattle,WA:IEEE Press,2012:1-9.

[12]WU X L,DONGW S,ZHANG X J,et al.Model-assisted adap⁃tive recovery of compressed sensing with imaging application[J].IEEE Trans.Image Processing,2012,21(2):451-458.

[13] MUN S,FOWLER JE.Block compressed sensing of images us⁃ing directional transforms[C]//Proc.International Conference on Image Processing.Cario,Egypt:IEEE Press,2009:3021-3024.

[14]CHEN C,TRAMEL E W,FOWLER J E.Compressed sensing recovery of images and video using multihypothesis predictions [C]//Proc.Conference Record of the Forty Fifth Asilomar Confer⁃ence.Pracific Grove,CA:IEEE Press,2011:1193-1198.

[15]FIGUEIREDO M A T,NOWAK R D,WRIGHT S J.Gradient projection for sparse reconstruction:application to compressed sensing and other inverse problems[J].IEEE Journal Selected Topics in Signal Processing,2007,1(4):586-597.

[16] MUN S,FOWLER JE.Residual reconstruction for block-based compressed sensing of video[C]//Proc.Data Compression Confer⁃ence.Snowbird,UT:IEEE Press,2011:183-192.

[17]TRAMEL E W,FOWLER J E.Video compressed sensing with multihypothesis[C]//Proc.Data Compression Conference.Snow⁃bird,UT:IEEE Press,2011:193-202.

[18] CANDES E,WAKIN M.An introduction to compressive sam⁃pling[J].IEEE Signal Processing Magazine,2008,25(2):21-30.

[19] REN Jie,ZHUO Yue,LIU Jiaying,et al.Illumination-invariant non-localmeans based video denoising[C]//Proc.19th IEEE In⁃ternational Conference on Image Processing.Orlando,FL:IEEE Press,2012:1185-1188.

[20]SHEN Y C,WANG P S,WU J L.Progressive side information refinement with non-local means based denoising process for Wyner-Ziv video coding[C]//Proc.Data Compression Confer⁃ence.Snowbird,UT:IEEE Press,2012:219-226.

[21]KIM D,KEUM B,AHN H,et al.Empirical non-local algorithm for image and video denoising[C]//Proc.IEEE International Con⁃ference on Consumer Electronics.Las Vegas,NV:IEEE Press,2013:498-499.

[22]WANG Z,BOVIK A C,SHEIKH H R,et al.Image quality as⁃sessment:from error visibility to structural similarity[J].IEEE Trans.Image Processing,2004,13(4):600-611.

责任编辑:时 雯

Distributed Video Com p ressive Sensing Reconstruction Based on Adaptive PCA Sparse Basis

WU Minghu1a,1b,LI Ran2,CHEN Rui3,ZHU Xiuchang2

(1a.School of Electrical and Electronic Engineering;1b.Hubei Collaborative Innovation Center for High-efficiency Utilization of Solar Energy,Hubei University of Technology,Wuhan 430068,China;2.Image Processing&Image Communication Key Lab,Nanjing University of Posts and Telecommunications,Nanjing 210003,China)3.School of Communication Engineering,Nanjing Institute of Technology,Nanjing 211167,China)

To improve the rate-distortion performance of distributed video compressive sensing(DVCS),the adaptive sparse basis is proposed to reconstruct the video signal in this paper.The proposed algorithm firstly generates the example-based data matrix using the motion information between frames,and then uses principle components analysis(PCA)to train its some significant principle components from which the sparse dictionary is constructed.This sparse dictionary can not only adaptively change in terms of the spatial-temporal characteristics,but also has ability to suppress noises.The simulation experiments show that the proposed joint reconstruction algorithm can effectively improve the objective and subjective quality of video,and enhance the rate-distortion performance of DVCS system at the cost of a certain computational complexity.

compressive sensing;distributed video compressive sensing;principle components analysis;adaptive sparse basis

TN911.73

A

10.16280/j.videoe.2015.02.017

2014-04-06

国家自然科学基金项目(61471162;61201160);湖北省自然科学基金(面上)项目(2014CFB589);湖北省教育厅科学研究计划资助项目(D20141406);江苏省自然科学基金(面上)项目(BK 20131377;BK 20141389)

【本文献信息】武明虎,李然,陈瑞,等.自适应PCA稀疏基底的分布式视频压缩感知重构[J].电视技术,2015,39(2).