基于光谱融合的掌纹精细纹路提取

康 冰,刘 富,魏祺韡

(吉林大学 通信工程学院,长春130022)

0 引 言

手掌上的纹线有三类:主线、褶皱和其他细小纹路。主线和褶皱是手掌上较深的纹线,具有稳定性,一般不随时间发生变化,常作为身份识别的稳定特征;手掌上的其他细小纹路,是与后天的生存环境,手掌的活动量和疾病的发生发展有着密切关系的,是缓慢变化的,很多疾病可以使这些细小的手纹从无到有,从有到无。因此,从手掌上错综复杂的各种纹线中提取出这些包含病理纹的浅而细小的掌纹精细纹路是实现自动手掌诊病[1]的核心。

现有的提取出掌纹线特征的算法并不多,主要有以下几种:①使用Canny、Robert、Sobel和Prewitt算子检测图像边缘并后续处理,用这种方法获得的纹线较少,依赖阈值设置和后续处理,鲁棒性差;②模板匹配算法。Zhang等[2]用12个模板提取掌纹线,然后用若干条直线段近似掌纹线,这种方法丢失了很多掌纹细节信息,得到的掌纹线易受噪声影响而断裂;③方向滤波法。Wu等[3]设计一组方向线检测器检测各个方向的纹线并融合在一起,用这种方法检测出的纹线都是较深的主线和褶皱,检测出的细小纹线较少。掌纹图像是纹理图像,具有多分辨率的特性,Li等[4]发现可用频域内能量聚集的紧密程度来反映空间域内掌纹图像中纹理的疏密和深浅。小波变换很适合描述多分辨率下的图像边缘特征,但不具有平移不变性。相比小波变换,NSCT 不仅能进行多尺度分析,还提供了几何方向的表示,弱边缘能作为一种几何结构,但噪声点不成为一种几何线条[5];NSCT 还具有平移不变性,每个变换后的像素对应于原图像的位置不变,可以通过分析各子带系数来直接分析图像的像素信息,为基于像素的光谱图像融合提供了便利条件。

本文采用NSCT 变换从不同分辨率和不同方向的子带对掌纹图像的边缘进行提取,有效地捕获浅而细小的掌纹线边缘特征,结合不同光谱特点设计基于像素的融合规则融合图像,通过形态学细化处理后能得到更加清晰丰富的掌纹精细纹路。

1 NSCT 变换与数学形态学

1.1 NSCT变换原理

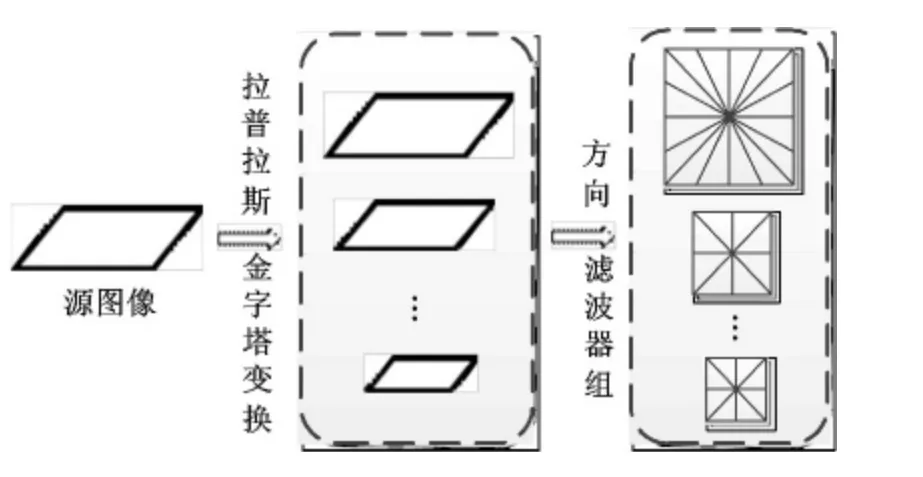

Do和Vetterli[6]于2002年提出了一种多分辨率、局域的、方向性的影像表示方法,即Contourlet变换,该变换首先对图像进行多尺度分析,迭代使用Laplacian 金字塔变换对低通子带进行分解;高通部分则使用方向滤波器组对其进行多方向分解,对各个方向上的不同奇异点进行组合,提取出该方向奇异点系数,得到该方向分解子图像。因此,Contourlet变换能够很好地表示出图像的纹理信息和轮廓信息。图1 是Coutourlet变换框架原理。

图1 Coutourlet变换框架原理Fig.1 Coutourlet transformation framework principles

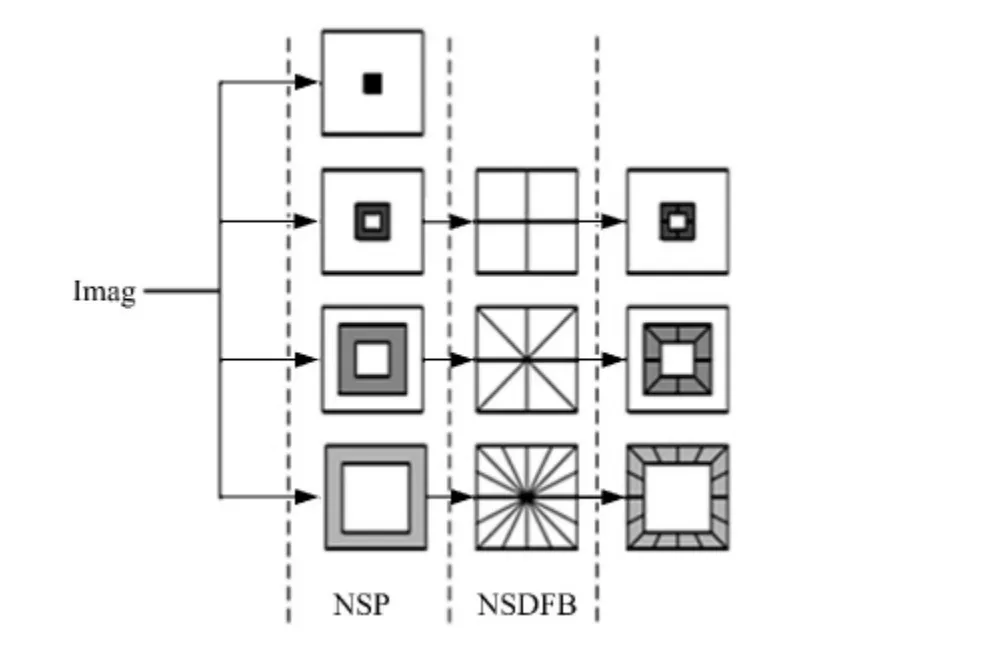

NSCT(非下采样Contourlet变换)取消了Contourlet变换分解和重构中的下采样环节,由非下采样金字塔滤波器组(NSPFB)和非下采样方向滤波器组(NSDFB)构成[7]。由于NSPFB和NSDFB这两部分满足完全重构的条件式(1)(2),具有平移不变的性质,因此NSCT 也具备平移不变性且分解后所获得的子带图像与原始图像的大小是一致的。图2是NSCT 分解示意图。

式中:H0(z)、H1(z)分别为NSPFB 的低通、高通分解滤波器;G0(z)、G1(z)分别为NSPFB 的低通、高 通 重 建 滤 波 器;U0(z)、U1(z)分 别 为NSDFB的低通、高通分解滤波器;V0(z)、V1(z)分别为NSDFB的低通、高通重建滤波器。

图2 NSCT分解示意图Fig.2 Schematic diagram of NSCT decomposition

1.2 数学形态学细化

细化是在图像中将二值物体和形状减小为单个像素宽度的线,在掌纹二值图像中,则是将具有一定宽度的掌纹线用一条单个像素宽度的曲线来表示。

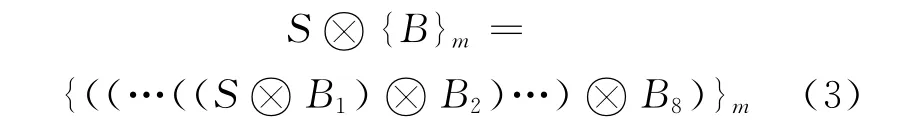

将集合S 被{B}结构元素序列(见图3)细化定义为[8]:

式中:{B}={B1,B2,…,B8}是8个方向的结构元素序列;m 是进行图像细化时的总循环次数,它的大小取决于目标图像的大小和边缘粗细。

细化过程是先用B1细化一遍,然后再用B2对B1的结果进行迭代细化,如此往复直到用B8细化一遍,整个过程可以再重复直到没有变化为止。

图3 结构元素序列Fig.3 Structural element sequences

1.3 掌纹图像的NSCT分解

将非下采样Contourlet变换应用于掌纹图像,对某个光谱下的掌纹图像IX进行3层非下采样Contourlet变换分解,得到1幅低频子带图像和14幅高频子带图像,其分解图像如图4所示。本实验中的LP 尺度分解滤波器组采用“9-7”小波滤波,DFB方向分解时使用的是“pkva”格型滤波器组,分解层数为3 层,设置参数levels=[1,2,3],分解得到的低频子带矩阵为,分解得到的高频子带矩阵为DXlevels,k,第i层分解得到的高频子带图像数目为2levels(i),其中levels(i)是分解的层数,k是第i层第k 个方向的高频信息。图像上像素位置为(x,y)表示最低频子带系数,和分别表示第一层分解出的“水平”方向高频子带系数和“垂直”方向高频子带系数。

由图4可见,第一层分解出2个高频子带图像,是对掌纹图像的掌纹主要纹理信息分别进行“垂直”和“水平”方向的分解,这一层的子带图像包含掌纹主线和较深较长的掌纹线;第二层分解出4个高频子带图像,是对前一尺度分解出来的表示掌纹图像基本轮廓信息的低频分量进行4个方向的再次分解,选择其中的奇异点作为高频细节分量,这一层的子带图像中包含大量浅而细碎的掌纹线;第三层分解出8个高频子带图像,是对前一尺度分解出来的低频分量进行8个方向的再分解,选择其中的奇异点作为高频细节分量,这一层的子带图像中不仅包含了大量短浅细碎的掌纹线,同时也将掌纹图像中的噪声光照的影响显著地反映在子带图像中。掌纹图像经过NSCT 变换分解后,子带图像的尺寸与原图像相同,使子带图像间的对应关系一目了然,有利于对子带系数进行进一步的处理。根据对掌纹图像NSCT 分解出的高频子带图像的纹理特点,继续对NSCT变换在多光谱掌纹特征提取中的应用进行研究。

图4 掌纹NSCT变换高频子带图Fig.4 High-frequency sub-bands of palmprint image NSCT

2 基于NSCT 的光谱掌纹特征融合

2.1 融合方法

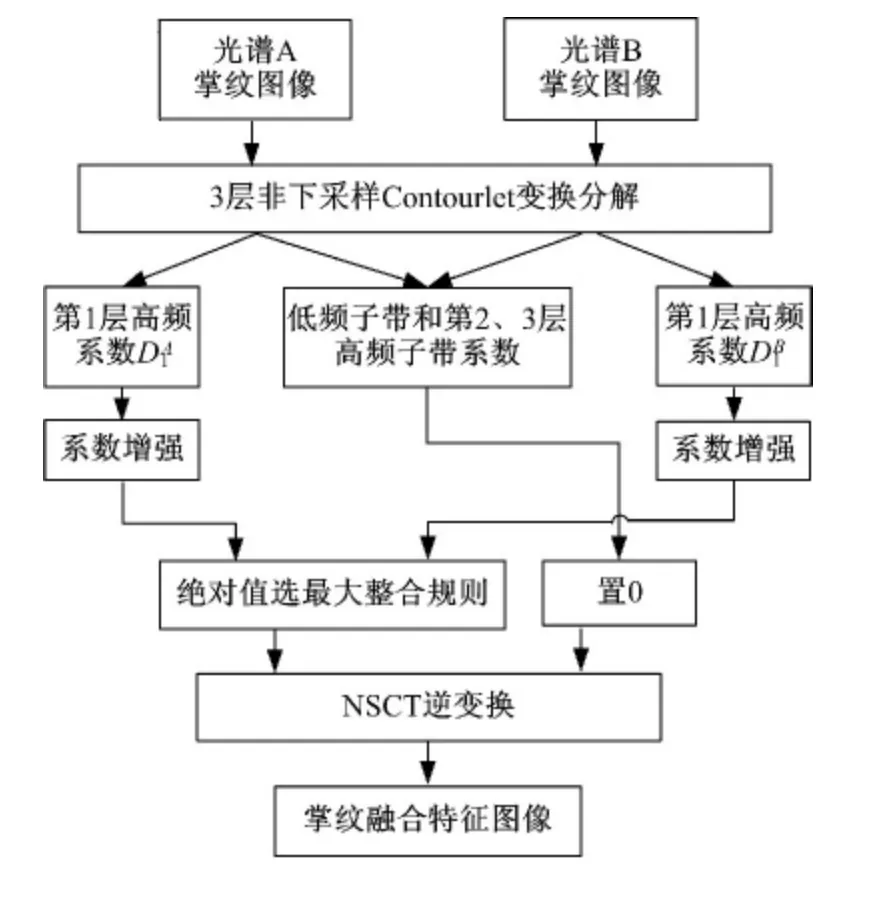

基于NSCT 的光谱掌纹特征融合框图如图5所示。为了提取掌纹的精细纹路特征,就要先使用NSCT 变换对各个光谱下的掌纹图像进行分解,然后根据精细纹路特点设计融合规则,将不同光谱分解出的高频部分和低频部分分别进行融合,最后使用NSCT 逆变换对融合后的系数矩阵进行重构得到融合后的掌纹精细纹路特征图像。

图5 基于NSCT的光谱掌纹特征融合Fig.5 Palmprint spectral characteristics fusion based on NSCT

2.2 融合规则

2.2.1 单光谱图像系数增强

直接融合像素点的方法无法区分噪声和线边缘,融合结果很容易受噪声的影响,因此在进行多光谱掌纹特征融合前,需要进行单光谱图像系数增强,除去噪声和弱边缘,保留掌纹线强边缘。对掌纹图像来说,图像分解的低频部分是背景,掌纹主线和精细纹路及噪声点是图像分解的高频部分,随着分解层数的增加,第2、3层高频子图所反映的纹线更细碎,所含噪声点干扰更多(见图4(c)(d)),而所要提取的包含异常病理纹的掌纹精细纹路和主线都是强边缘,主要反映在第1层分解出的高频子图上(见图4(b)),因此,在对高频系数增强处理时,只增强第1层高频系数,其他层的高频系数对病理纹线提取贡献很小,且受噪声干扰大,做置0处理。

(1)低频系数处理

由于低频子带描述的是图像的概貌,对掌纹精细纹路特征提取没有贡献,因此将低频子带系数矩阵各系数(x,y)置0。

(2)高频系数增强处理

最后,将第2、3层分解出的所有高频子带系数均置0。

2.2.2 多光谱图像系数融合

高频系数的绝对值越大,表明此像素所在的线边缘强度越强,所以在高频融合的过程中,选择各光谱中绝对值较大的高频系数作为融合结果,可以有效突出掌纹线边缘,各光谱信息达到取长补短的效果。

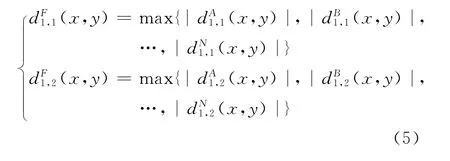

将不同光谱下的待融合图像IA、IB、IC、…、IN经单光谱图像系数增强处理后,把各自第1层“水平”方向高频子带系数(x,y(x,y)、…(x,y)相融合,各自第1层“垂直”方向高频 子 带 系 数(x,y)、(x,y)、…(x,y)相融合。

第1层高频系数融合采用系数绝对值选最大融合规则,即选取对应位置上系数的绝对值大的系数作为融合后的系数,如式(5)所示。

3 仿真实验

3.1 实验流程

手掌皮肤对不同光谱的反射吸收特性不同,不同光谱下掌纹图像各有特点,一般来讲,波长越长,射线对人体皮肤的穿透性越强,手掌皮肤下面的静脉纹路越清晰,波长越短,成像越针对某一表层,得到手掌表面细小纹线越清晰[9]。现有的多光谱掌纹融合中所选择的融合光谱有三类:蓝光,绿光,红光与近红外光融合[10-11];可见光与近红外光融合[12];黄绿光(580nm)、红光(760nm)与近红外光(990nm)融合[13]。由于现有的多光谱掌纹融合都是为了提高掌纹身份识别的准确度,因此都将可见光与红外光进行了融合,而本文是为了更清晰地提取手掌表面的精细纹路,因此本实验选择能使手掌表面纹路更清晰的黄绿光谱下的掌纹图像与自然光下的掌纹图像相融合,以增强自然光下掌纹图像中浅而细小的精细纹路。实验流程如图6所示。对于3个以上光谱的融合,也可以按照本文方法进行处理,但是实验提取结果差别不大,而且处理数据量增大,处理速度变慢,因此黄绿光谱与自然光的双光谱融合效率最高。

图6 实验流程框图Fig.6 Experimental flow diagram

将经过NSCT 逆变换后的掌纹融合图像进行数学形态学处理:

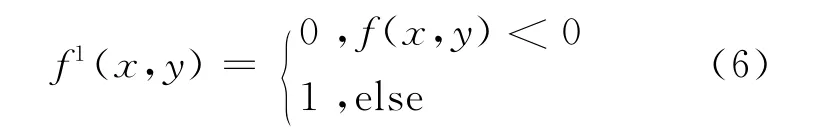

(1)二值化。NSCT 逆变换后图像F 的每个像素值都是有正有负的系数f(x,y),其中系数大于1的像素点在图像上显示为白色,系数小于0的像素点在图像上显示为黑色,系数值在0~1区间的像素点在图像上显示为灰色。因此,为了清晰地显示融合后掌纹纹线特征,则按照式(6)对图像先进行二值化处理,即将所有系数值小于0的像素点置黑,将所有系数值大于等于0的像素点置白,得到二值化后的图像F1。

(2)图像取反。将图像中黑色像素(像素值为0)转换成了白色(像素值为1),将图像中白色像素(像素值为1)转换成了黑色(像素值为0),即得到反色后的图像F2,掌纹纹路为白色,背景为黑色。

(3)数学形态学细化处理。直接融合后的掌纹线是有宽度且互相重叠的狭长区域,不利于后续识别特殊形状病理纹,也不利于与文献[3]的实验结果相对比分析,因此对图像进行数学形态学细化处理,用单个像素宽度的线表示掌纹线的位置和走向,即将图像F2中的白色掌纹纹路细化成单个像素宽度的掌纹线,掌纹线更加清晰,有利于后续对异常病理纹形状的分析和识别。

本文采用8方向的形态结构元,采用循环删除像素点的方式进行细化,直到图像中掌纹线宽度变成单像素,图像结果不发生变化为止。

3.2 实验结果和分析

为了验证本文方法的有效性,选取了配准后的自然光下和黄绿光谱(580nm[13])下的掌纹图像进行精细纹路提取实验,并与邬向前教授[3]提出的构造方向线检测器提取掌纹线的算法进行了对比。

图7 双光谱图像特征融合过程Fig.7 Double-spectral image characteristics fusion process

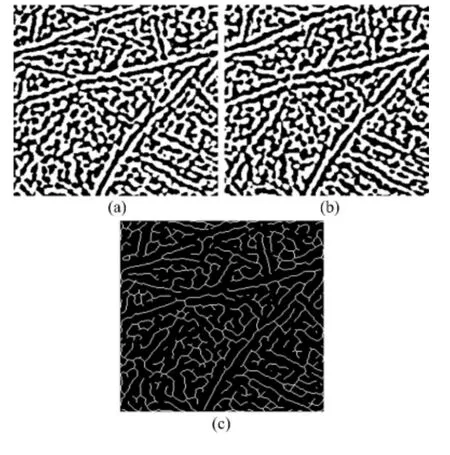

图8 形态学处理过程Fig.8 Morphological processing

图7 (a)和图7(b)分别是自然光和黄绿光谱下的掌纹图像。图7(c)和图7(e)分别是图7(a)经过NSCT 分解后的第1 层“垂直”方向高频子图和“水平”方向高频子图。图7(d)和图7(f)是图7(b)经过NSCT 分解后的第1层“垂直”方向高频子图和“水平”方向高频子图。图7(g)是两种光谱融合后NSCT 逆变换后的图像。图8 是对掌纹融合图像进行数学形态学处理,其中图8(a)是二值化结果,图8(b)是图像反色结果,图8(c)是形态学细化结果。文献[3]提出设计一组θ方向线检测器算子,分别将0°、45°、90°和135°方向线检测器算子与图像作卷积,检测各个方向的纹线并叠加融合在一起,再进行形态学闭操作和细化得到掌纹线提取结果。将实验图像用文献[3]的方法处理得到结果如图9所示。将图8(c)与图9相比较可以看出,用文献[3]的方法只清晰地提取出了1条最长最深的“智慧线”,周围还有很多平行或交错的纹线,但这些纹线大多数为手掌上较深的褶皱,对于手掌心主线周围较浅的细纹并没提取出来;由于文献[3]所使用的方向算子是4个特定方向的检测,检测出的纹线的方向具有局限性;本文方法不仅能较清晰连贯地提取出3条主线边缘,而且对于主线周围各个方向的细小纹路位置和走向都能准确显示,对于后续分析细小纹线的交联和形状,识别手掌上特定形状的异常病理纹如“十字纹”、“米字纹”提供了很好的前期处理效果。因此,本文方法能够有效地提取手掌上的精细纹路,尤其对于手掌中心主线周围浅而细小的精细纹路提取效果更为清晰突出,提取纹线细节丰富,主观目视效果好。

图9 文献[3]算法的掌纹线提取结果Fig.9 Palmprint line extraction results by algorithm in Ref.[3]

4 结束语

提出了一种不同光谱融合的掌纹图像精细纹路提取方法,即NSCT 与数学形态学细化结合的掌纹线特征提取方法。针对手掌上浅而细小的精细纹路,提出将黄绿光谱下的掌纹图像与自然光下的掌纹图像的NSCT 分解系数特征相融合,考虑到系数对应着不同层次的掌纹纹线,设计了增强的融合规则。实验中,将本文方法与文献[3]方向滤波的掌纹线检测法进行了比较。实验表明,本文方法能够有效地提取手掌上浅而细小的精细纹路,且提取的纹路更丰富清晰。

[1]邬向前,李乃民,张大鹏,等.掌纹纹线提取及病理纹的识别[C]∥计算机在诊法中的应用与研究论文汇编,哈尔滨:哈尔滨工业大学计算机科学技术学院计算机生物信息中心,中国人民解放军211 医院,2005:227-230.

[2]Zhang Da-peng,Shu Wei.Two novel characteristics in palmprint verification:datum point invariance and line feature matching[J].Pattern Recognition,1999,32(4):691-702.

[3]Wu Xiang-qian,Wang Kuan-quan,Zhang David.A novel approach of palm-line extraction[C]∥Proceedings of the Third International Conference on Image and Graphics,USA,2004:230-233.

[4]Li Wen-xin,Zhang David,Xu Zhuo-qun.Palmprint recognition based on fourier transform[J].Journal of Software,2002,13(5):879-886.

[5]陈丽燕,陈建华.基于非下采样轮廓波的图像检索[J].福州大学学报:自然科学版,2012,40(2):172-175.Chen Li-yan,Chen Jian-hua.Image retrieval based on nonsubsampled contourlet[J].Journal of Fuzhou University(Natural Science Edition),2012,40(2):172-175.

[6]Do M N,Vetterli M.Contourlets:a directional multisolution image representation[C]∥Proc of IEEE Int Conf on Image Processing,Rochester,USA,2002:357-360.

[7]崔玲玲,卢朝阳,李静,等.基于非下采样Contourlet域高斯混合模型的布匹瑕疵识别算法[J].吉林大学学报:工学版,2013,43(3):734-739.Cui Ling-ling,Lu Chao-yang,Li Jing,et al.Fabric defect recognition algorithm based on Gaussian mixture model in nonsubsampled Contourlet domain[J].Journal of Jilin University(Engineering and Technology Edition),2013,43(3):734-739.

[8]李杰,彭月英,元昌安,等.基于数学形态学细化算法的图像边缘细化[J].计算机应用,2012,32(2):514-516,520.Li Jie,Peng Yue-ying,Yuan Chang-an,et al.Edge thinning based on mathematical morphology thinning algorithm[J].Journal of Computer Applications,2012,32(2):514-516,520.

[9]徐兴鹏.基于四元数模型的多光谱掌纹识别[D].哈尔滨:哈尔滨工业大学,计算机科学与技术学院,2010.Xu Xing-peng.Multispectral palmprint recognition using the quaternion mode[D].Harbin:Harbin Institute of Technology,College of Computer Science and Technology,2010.

[10]Abdallah Meraoumia,Salim Chitroub,Ahmed Bouridane.Fusion of multispectral palmprint images for automatic person identification[C]∥Spain Electronics Communications and Photonics Conference(SIECPC),Barcelona,2011:1-6.

[11]Zhang D,Guo Zhen-hua,Lu Guang-ming,et al.An online system of multispectral palmprint verification[J].IEEE Transactions on Instrumentation and Measurement,2010,59(2):480-490.

[12]Maurício Ramalho,Sanchit Singh,Paulo Lobato Correia,et al.Secure multi-spectral hand recognition system[C]∥The 19th European Signal Processing Conference(EUSIPCO),Barcelona,Spain,2011:2269-2273.

[13]Guo Zhen-hua,Zhang D,Zhang Lei,et al.Feature band selection for online multispectral palmprint recognition[J].IEEE Transactionson on Information Forensics and Security,2012,7(3):1094-1099.