视频拼接中最优自适应单应性矩阵求解算法

张春雨,王 文,邱亚特,郭克友

(1.交通运输部公路科学研究所 北京诚达交通科技有限公司,北京 100088;2.北京工商大学 机械工程学院 北京 100037)

视频拼接是近几年来图像处理领域的研究热点之一[1-5],但受处理算法复杂度及硬件条件所限,目前大多数的研究方向主要集中在对实时性要求不高的静态图像拼接处理上[6-11]。而相比于静态图像而言,视频拼接的难度较大,要实现真正的实时性拼接,需要在几十毫秒的时间之内完成对单帧图像的拼接处理,这就对拼接的算法提出了很高的要求。针对交通场景中对视频拼接速度要求较高的需求特点,本文从静态图像拼接处理入手,结合视频帧间的相关性特点,提出了利用视频帧的最优单应性矩阵进行实时拼接的快速算法,并在交通监控视频序列中进行了实现和应用,达到了实时的处理效果。

1 整体框架

本文的主要工作是将两段已经拍摄好的交通场景视频进行拼接,针对实时性要求,提出了利用视频帧的最优单应性矩阵进行实时拼接的快速算法,搭建了实时视频拼接系统。算法的主要步骤如下:

(1)获取两组同质视频图像。

(2)对同一时刻对应的帧图像进行预处理。

(3)采用SURF算法提取对应帧特征点。

(4)采用最近邻匹配法(Nearest neighbour,NN)匹配显著特征点对。

(5)随机抽样一致性匹配算法(Random sample consensus,RANSAC)剔除误匹配特征点对。

(6)求解视频初始k帧的最优单应性矩阵。

(7)根据最优单应性矩阵进行后继视频帧场景的拼接。

(8)同时对第k帧图像的特征点进行跟踪,把其在后继帧中的位置作为相应特征点位置。

(9)若匹配点对的数目超过了给定的阈值,则认为图像前景发生了较大的变化,最优单应性矩阵应该更新。

(10)程序跳转到步骤(2),重新计算特征点、匹配点对以及最优的单应性矩阵。

2 关键算法与实现

2.1 图像预处理算法

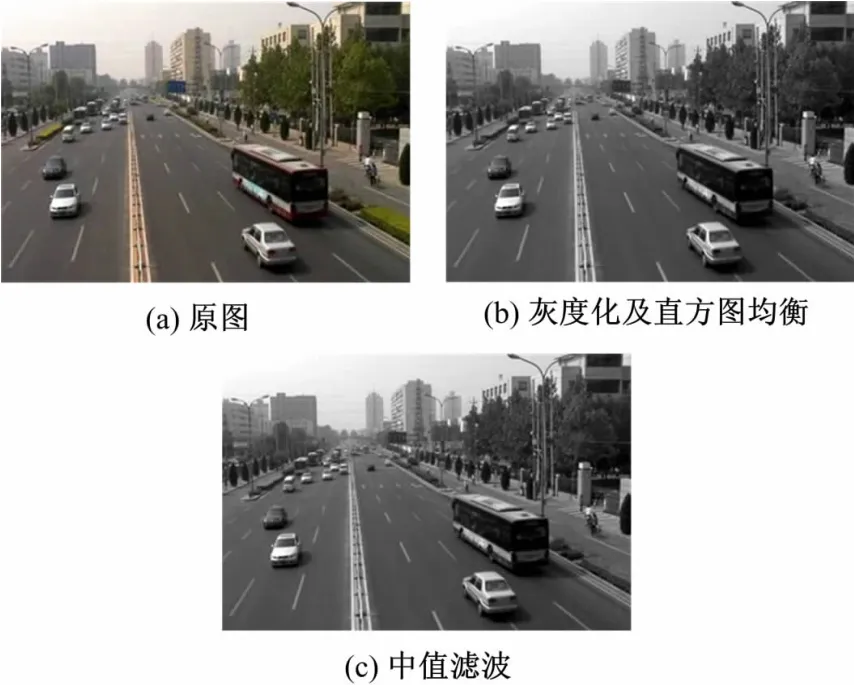

由于同一对象在不同摄像机视角下会产生几何变形,而且图像在采集过程中不可避免地会受到光线等外界因素的影响,因此在预处理阶段需要对两个视频对应帧图像进行预处理,本文采用的是图像灰度化、直方图均衡以及中值滤波处理,以扩大图像的灰度范围,增强对比度,便于后续特征点的提取。图1是经过预处理后的图像。

图1 视频帧图像预处理效果图Fig.1 Proceesing of video images

2.2 SURF特征点提取算法

SURF算子由Bay等[12]在2006年提出,它本质上是对SIFT算子的改进。该方法在SIFT算法基础上,利用方框滤波近似代替二阶高斯滤波,使用图像积分替代图像卷积操作以提高计算速度,利用Hessian矩阵的数学性质检测特征值。尽管特征点的提取质量受到一定的影响,但计算效率高。SURF算子的实现主要包括以下步骤:尺度空间特征点检测,特征点的稳定性判定,以及描述符的形成。图2是用SURF算法处理的图像,白色圆圈标注的是提取的特征点位置。

图2 SURF算法处理后特征点提取效果图Fig.2 Feature points abstracted by SURF algorithm

2.3 特征点匹配算法

利用SURF方法对两幅图像分别提取特征点后,用NN[8]方法对图像间的特征点进行初始匹配,从而找出两幅图像中匹配的显著特征点对。由于初始匹配中包含有大量的出格点,直接采用线性算法得不到正确的投影变换参数,为此,本文采用了鲁棒的随机采样算法,有效地剔除了初始匹配中的出格点,获得精确匹配的点集,然后利用这些精确匹配的点集来计算投影变换参数。

(1)初始匹配算法

NN方法是在SURF提取出的特征点描述符具有很高独特性的前提下使用的,用特征点的最近邻距离与次近邻距离的比值作为特征点间是否匹配的依据。在搜索最近邻与次近邻时使用一种在k-d树快速搜索方法基础上改进的BBF(Best bin first)方法来提高运算速度。

(2)随机采样一致性

RANSAC是一种鲁棒的参数估计方法。对初始匹配点集中包含有较高比率出格点的情况,该算法仍能有效地获得精确的参数估计值,去除出格点,保证后继图像拼接的正确性。

其具体步骤如下:①在输入数据中随机重复采样n次,利用每次采样所得到的最小点集(4组)估计出所要确定的单应性矩阵,计算每组假设对应的距离;②通过与门限值比较,将低于门限值的点对作为“内点”,其他的点作为“出格点”;③如此迭代一定的次数之后,将对应输入数据中“内点”比例最高的点集作为优化的点集;④将对应输入数据中“内点”比例最高的点集所估计出的参数值以及选出来的内点一起进行优化,用所选取点集中的匹配对重新计算单应性矩阵,从而得到最终的参数估计值。图3为RANSAC处理后的效果图。

图3 RANSAC处理后效果图Fig.3 RANSAC post-processing

2.4 最优单应性矩阵的求取

从摄影几何中可知,如果空间点位于同一平面上且该平面不通过两摄像机的任一光心,两幅图像对应点之间存在一一对应关系,且这种对应关系可以用单应矩阵的变换矩阵来表示[13],即单应性矩阵把源图像平面上的点集与目标图像平面上的点集位置联系起来。

从单应性矩阵的性质可以得出:一个性能好的单应性矩阵可以使两幅待拼接图像很好地拼接在一起。但由于在特征点匹配过程中可能存在特征点误匹配的情况,实际在单帧图像中通过特征点对匹配求解所得单应性矩阵不一定是最优单应性矩阵。而且,对视频图像采用单帧图像拼接的方式进行处理,没有利用视频图像帧间的相关性,也没有考虑到帧间单应性矩阵的关联,这都会降低视频拼接的效率。

由于两幅待拼接图像重叠区域内图像的相关性非常高,因此可利用相关性作为重叠区域拼接效果评价的依据。具体步骤如下:

(1)确定拼接图像的重叠区域

根据单应性矩阵,按照图像的映射关系,得到保留特征点在另一对应帧图像的匹配点;如果计算出的匹配点没有落在图像内,说明这一点并不在两幅图像的重叠区内,反之,如果特征点映射前后都落在图像内,说明它处在重叠区内;用这种方法遍历一遍,即对一幅图像中所有保留特征点进行透视变换,以另一幅图像的边缘为边界,取重叠区的最小内接矩形作为重叠区域。

(2)求前k帧对应拼接图像重叠区域相似度

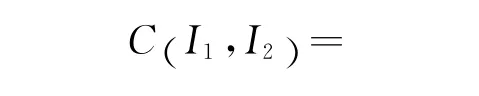

将匹配点对按照最小距离由小到大进行排序,并按照加权距离的归一化设定权值,再按照归一化协方差相关函数来计算相似度。如下式所述:

式中:w、h分别为重叠区的宽和高。

显然,相似度C取值范围是(-1,1),取值越大说明重叠区相关程度越高。

(3)确定前k帧的最优单应性矩阵

对连续前k帧相似度值求极大值,相关性最高的图像帧对应的单应性矩阵即为最优的单应性矩阵,可作为后继帧的单应性矩阵。

2.5 最优单应性矩阵的优化和变换

由于多幅图像进行拼接会产生全局的累计误差,因此需要对初始的最优单应性矩阵进行优化和变换。

本文采用对图像中的动态特征点进行动态跟踪的KLT方法来确定是否要对最优的单应性矩阵进行优化和变换。通过跟踪一帧图像的匹配点对,得到这些匹配点对在当前图像帧中的新位置,作为当前图像帧的特征点。若匹配点对的数量变化超过了给定的阈值,则认为视频帧的前景有显著变化,当前的最优单应性矩阵需要进行优化和变换。同时需要重新提取图像帧中特征点对进行匹配,寻求k帧图像的单应性矩阵。

3 实验结果分析

本实验采用固定摄像机的方式进行交通场景的视频拼接,其中两个摄像头完全相同,设置相同的亮度、焦距、色度等参数。视频帧大小为320×240像素,帧频为28帧/s。

在台式机上进行模拟实验,采用Core22.8G CPU,3G内存的硬件平台,VC2008软件编程。实验结果表明:单帧拼接所需时间约400ms左右,在得到最优单应性矩阵之后,视频的平均拼接时间远小于100ms。如果采用DSP、FPGA等硬件进行算法加速,单帧的处理速度会更快。

图4是重叠区域为50%的视频中两对应帧图像。图5是经过拼接处理后得到的宽视野范围的拼接图像。

图4 视频中两对应帧图像Fig.4 Two corresponding images of video

图5 拼接后图像Fig.5 Mosaic image of video frames

从视频拼接帧上看,拼接效果较好,拼接后的视频录像画面流畅清晰,能够满足交通场景中视频监控对宽视野的需求。由于本拼接系统的算法本身也有一定的局限性,不可避免地存在一定的误差,例如拼接处的部分图像存在微弱的接痕和变形等,同时两视频帧的亮度还需要用算法进行调整。

4 结束语

提出了基于最优单应性矩阵的实时视频拼接求解算法,并将其应用于交通场景的视频拼接中,可以实现交通监控过程中对全景交通状态的监控以及回放,减少了数据存储的空间。本算法在SURF算法提取特征点的基础上,分别利用最近邻匹配法、随机抽样一致性匹配算法求出视频初始几帧的单应性矩阵作为最优单应性矩阵,然后利用最优单应性矩阵进行视频后继k帧的拼接;同时利用K-L算法对特征点对进行跟踪,若当前帧中匹配的特征点对的数量变化超过了给定的阈值,则认为需要对最优单应性矩阵进行优化和变换,重新计算视频帧特征点对以及单应性矩阵。该快速算法具有参数估算准确,计算量小、速度快的优点,实现了实时的视频拼接,对视野背景相对固定的视频拼接效果尤其理想。下一步工作有两个主要内容,一是研究基于形态学的图像融合算法,避免由于过度拼接或由于物体运动造成的高频信息丢失引起的鬼影现象;二是在提高视频拼接质量的前提下,采用DSP高速处理器,进一步提高视频帧拼接速度。

[1]Smith S,Susan Brady M.A new approach to low level image processing[J].International Journal of Computer Vision,1997,23(1):45-78.

[2]Lemeshewsky G P.Multispectral multi-sensor image fusion using wavelet transforms[J].Pro SPIE,1999,3716:214-222.

[3]Luo Zhong-xuan,Liu Cheng-ming.Fast algorithm of image matching[J].Journal of Computer-Aided Design & Computer Graphics,2005,17(5):966-969.

[4]Lowe D G.Object recognition from local scale-invariant features[C]∥International Conference on Computer Vision,Corfu,Greece,1999:1150-1157.

[5]Brown M,Lowe D G.Automatic panoramic image stitching using invariant features[J].International Journal of Computer Vision,2007,74(1):59-73.

[6]Lowe D G.Distinctive image features from scale-invariant key points[J].International Journal of Computer Vision,2004,60(2):91-110.

[7]陈昱,庄天戈 .基于灰度值相应概率的非刚性图像配准[J].上海交通大学学报,1999:33(9):1128-1130.Chen Yu,Zhuang Tian-ge.Non-rigid registration for multi-modal medical images based on gray value correspondence probability[J].Journal of Shanghai Jiaotong University,1999,33(9):1128-1130.

[8]董瑞,梁栋.基于颜色梯度的图像特征点匹配算法[J].计算机工程,2007,33(16):178-180.Dong Rui,Liang Dong.Image feature points match algorithm based on color gradient,computer engineering[J].Computer Engeering,2007,33(16):178-180.

[9]李广儒,张闯.基于Harris特征点检测法的雷达图像与电子海图的数据融合[J].大连海事大学学报,2009,35(2):55-58.Li Guang-ru,Zhang Chuang.Data mining of radar image and electronic chart based on Harris feature point detection[J].Journal of Dalian Maritime University,2009,35(2):55-58.

[10]许俊泽,胡波.对数极坐标变换域下互信息图像配准方法[J].信息与电子工程,2009,7(4):289-293.Xu Jun-ze,Hu Bo.Mutual information image registration based on log-polar transform[J].Information and Electronic Engineering,2009,7(4):289-293.

[11]李根,李文辉.基于尺度不变特征变换的平面旋转人脸检测[J].吉林大学学报:工学版,2013,43(1):186-191.Li Gen,Li Wen-hui.Face detection under rotation in image plane based on scale invariant feature transform[J].Journal of Jilin University(Engineering and Technology Edition),2013,43(1):186-191.

[12]Bay H,Tuvtellars T,Van Gool L.SURF:speeded up robust features[C]∥Proceedings of the European Conference on Computer Vision,2006:404-417.

[13]Jain P K,Jawahar C V.Homography estimation from planar contours[J].Third International Symposium,2006,77(15):877-884.