一种改进的频率调谐显著性检测方法

于乃昭,姚志均,杨 波

(船舶重工集团公司723所,扬州 225001)

0 引 言

人类在观测一副图像时,通过视觉注意机制能够很容易地注意到感兴趣的目标或图像中的重要部分。若能将这种机制引入到计算机视觉领域中,首先找出显著性区域,然后将计算资源优先分配给这些区域,就能显著提高现有图像处理和模式识别等的工作效率和性能。提取出来的显著性图像可以广泛应用于计算机视觉领域,如图像分割[1]、图像压缩[2]、目标识别[3]、内容感知、图像编辑[4]、图像检索[5]等。

显著性检测方法大致可分为3类:基于生物学的方法、纯计算的方法和结合这2种思想的方法。第1类方法的典型代表是Itti等人[6]于1998年提出的一种基于生物学的视觉注意模型,它提取图像的梯度、颜色、方向等特征,用高斯差(DOG)计算中心-周围差值得到各特征所对应的显著图,最后线性组合得到最终的显著图。受Itti模型的启发,Frintrop等人[7]提出了一种新的方法,他们用均方滤波器计算中心-周围差值,并用积分图像加快计算速度。纯计算的显著性检测方法有:Ma和Zhang[8]用中心-周围特征距离估计显著性;Gao和Vasconcelos[9]通过最大化中心和周围的特征分布之间的互信息来求得图像的显著性;Hou和Zhang[10]提出了一种基于频域的显著性检测方法——频域残余谱(SR)方法。第3类方法是结合生物学模型和计算模型实现的。Harel等人[11]用Itti的方法生成特征图,然后用基于图论的方法执行归一化操作。

上述方法中有些方法得到显著图的分辨率比较低,如Itti的方法[6]得到的显著图是原始尺度的1/256,Hou和Zhang[10]方法得到的显著图为64×64像素。有些方法突出显著目标的边缘,而不是均匀地显示整个显著区域,如Ma和Zhang的方法[8]和Hou和 Zhang的方法[10]。

针对上述这些问题,Achanta等人[12]提出了频率调谐(FT)方法,该方法采用Lab颜色空间作为图像特征,对于每个颜色通道,计算某个像素与整幅图像的平均色差并取平方,然后将这3个值相加作为该像素的显著性值。由于该方法不需要下采样,故可以输出跟原始图像一样大小的显著图;同时该方法保留了全部空间频率信息,从而能够提取整个显著区域。

然而,由于Lab颜色空间的3个分量L、a、b的取值范围不一样,L的取值范围为[0 100],而a、b的取值范围为[-128 127],且这3个分量的变化不一致,一副图像中的亮度变化往往比较大,而色度的变化不大,这样很有可能导致基于这3个分量得到的显著性值不在同一个数量级,从而不能很好地体现出各个分量的作用。为此,本文提出一种改进的频率调谐(IFT)方法,与文献[12]一样采用Lab颜色空间作为图像特征,然后得到3个颜色通道的显著图,最后加权得到最终的显著图。

1 本文提出的方法

在讨论本文提出的方法之前,先介绍一下频率调谐方法。设给定图像I的尺寸为H×W,其中H为高度,W为宽度。

第1步,先对图像做高斯平滑处理,以消除噪声、因编码引入的误差及精细的纹理,得到一个新的图像Ig,其计算公式如下:

式中:(i,j)为像素坐标;符号“*”表示卷积;G为高斯平滑滤波器,其尺度大小一般选3×3或5×5。

第2步,将图像Ig从三原色(RGB)颜色空间转换到Lab颜色空间,得到图像的亮度特征L和颜色特征a、b。

第3步,计算每个特征所对应的整幅图像的均值:

第4步,对于每个像素,计算各特征下与整幅图像均值之间的距离:

第5步,特征融合得到每个像素的最终显著性值:

由公式(8)得到的值往往远大于255,故不能直接用于图像显示,一般会将它归一化为[0 1]之间的实数或[0 255]之间的整数。

由于L、a、b3个分量的取值范围和变化快慢不一样,很有可能导致由公式(5)~(7)得到的各特征所对应的显著性值不在一个数量级上,从而抑制了值小的分量的作用。为此,本文提出了一种改进的频率调谐方法,改进之处在于特征融合这一环节。文献[12]是直接将不同特征的显著性值线性相加得到最终的显著性值,而本文提出的方法是先对各特征的显著性值做归一化处理,即:

在得到新的显著性值之后,经如下公式融合得到最终的显著性值:

式中:ωL、ωa、ωb分别为3个特征所对应的权重(本文的实验中取ωL=ωa=ωb=1/3)。

2 实验结果与分析

为了验证本文提出的显著性检测方法的有效性和性能,进行了实验仿真。

第1个实验是以一个小尺寸的图像块作为目标,通过查看L、a、b3个分量的值及所对应的显著性值来证明本文提出改进方法的思路是正确的,同时也与文献[12]比较最终得到的显著图性能。图1中箭头所指方框(大小为16×11)是感兴趣的目标图像,经颜色空间转换之后L、a、b3个分量的值分别如图2(a)、(c)、(e)所示,由公式(5)~(7)计算得到的3个分量所对应的显著性值分别如图2(b)、(d)、(f)所示。

从图2可以看出,亮度的变化比颜色特征变化大;3个特征所对应的显著性值不在一个数量级,其中亮度特征L的显著性值的最大值为3 948,而颜色特征a、b的显著性值的最大值分别为163、758。

图1 箭头所指方框为感兴趣目标

图2 目标图像L、a、b 3个分量的值及对应的显著性值

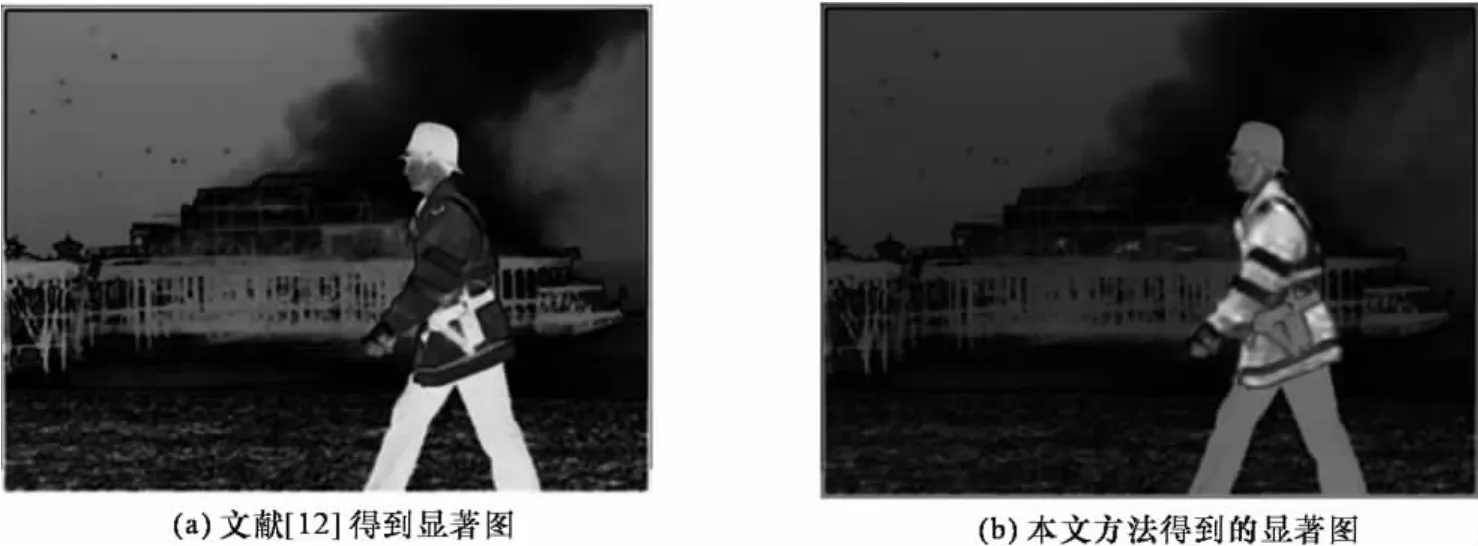

这样,在特征融合时,颜色特征很容易被亮度特征抑制,从而不能发挥颜色特征所特有的功能。图3(a)和(b)分别是文献[12]和本文方法得到的显著图,像素的亮度越亮,显著性值越大,表明该像素越显著。文献[12]的结果表明人的黑色帽子和裤子是显著性目标,本文方法的结果表明人的绿色上衣是显著目标。而事实上,当人们观测这幅图像时,图中的人物肯定是人们关注的对象,但相比于黑色帽子和裤子,更多的注意力会放在绿色上衣上面,这也就说明本文提出的方法要好于文献[12]。

图3 文献[12]和本文方法得到的显著图

第2个实验是从文献[12]的数据库(共有1 000幅图像)中选择了5幅不同类型的图像,然后比较Hou和Zhang的频域残余谱方法、文献[12]的频率调谐法及本文提出的方法这3种显著性检测方法的性能。实验结果如图4所示。对于频域残余谱方法,由于它是在64×64像素这样的尺度上实现的,为了方便比较,本文通过插值法将它拉伸到跟原始图像一样大小。由图4(b)可以看出,频域残余谱方法突出目标边缘部分,能够检测小目标物体;频率调谐法能够检测大尺度的目标,且目标整体比较均匀,但由于它可能抑制了某些颜色分量的作用,从而不能充分检测出显著性区域;而本文方法既继承了频率调谐法的优点,同时又充分利用了各颜色分量的作用,以至于取得很好的检测结果。

3 结束语

本文分析了频率调谐显著性检测方法的不足,并对它做了相应的改进:先将每个特征所得到的显著图进行归一化处理,然后再用加权平均融合得到最终的显著图。由于改进的方法充分利用了各颜色分量的作用,因而取得了好于原始频率调谐法的显著性检测结果。

[1] Han Junwei,Ngan King Ngi,Li Mingjing,et al.Unsupervised extraction of visual attention objects in color images[J].IEEE Transactions on Circuit and System on Video Technology,2006,16(1):141-145.

[2] Christopoulos Charilaos,Skodras Athanassios,Ebrahimi Touradj.The JPEG2000still image coding system:an overview [J].IEEE Transaction on Consumer Electronics,2000,46(4):1103-1127.

[3] Rutishauser Ueli,Walther Dirk,Koch Christof,et al.Is bottom-up attention useful for object recognition?[A].Proceedings of The IEEE Conference on Computer Vision and Pattern Recognition[C].Pasadena,USA,2004:37-44.

[4] Wu Huisi,Wang Yushuen,Feng Kunchuan,et al.Resizing by symmetry-summarization[J].ACM Transaction on Graphics,2010,29(6):1-9.

[5] Chen Tao,Cheng Mingming,Tan Ping,et al.Sketch2photo:Internet image montage [J].ACM Transaction on Graphics,2009,28(5):1-10.

[6] Itti Laurent,Koch Christof,Niebur Ernst.A model of saliency-based visual attention for rapid scene analysis[J].IEEE Transactions on Pattern Analysis and Machine Intelligence,1998,20(11):1254-1259.

[7] Frintrop Simone,Klodt Maria,Rome Erich.A real-time visual attention system using integral images[A].Proceedings of The 5th International Conference on Computer Vision Systems[C].Bielefeld,Germany,2007.

[8] Ma Yufei,Zhang Hongjiang.Contrast-based image attention analysis by using fuzzy growing[A].Proceedings of ACM International Conference on Multimedia[C].New York,USA,2003:374-381.

[9] Gao Dashan,Vasconcelos Nuno.Bottom-up saliency is a discriminant process[A].Proceedings of The IEEE International Conference on Computer Vision[C].San Diego,USA,2007:1-6.

[10]Hou Xiaodi,Zhang Liqing.Saliency detection:a spectral residual approach[A].Proceedings of The IEEE Conference on Computer Vision and Pattern Recognition[C].Shanghai,China,2007:1-8.

[11]Harel Jonathan,Koch Christof,Perona Pietro.Graphbased visual saliency[A].Proceedings of The Advances in Neural Information Processing Systems 19[C].Vancouver,Canada,2007:545-552.

[12]Achanta Radhakrishna,Estrada Sheila,Wils Francisco,et al.Frequency-tuned salient region detection[A].Proceedings of The IEEE International Conference on Computer Vision and Pattern Recognition[C].Lausanne,Switzerland,2009:1597-1604.