一种应用于视频眼震分析的瞳孔中心定位方法

陈学军 杨永明 何 为 毛玉星

1(重庆大学输配电装备及系统安全与新技术国家重点实验室,重庆 400044)2(莆田学院电子信息工程系,莆田 351100)

CHEN Xue-Jun1,2 YANG Yong-Ming1* HE Wei1 MAO Yu-Xing11

(State Key Laboratory of Power Transmission Equipment& System Security and New Technology,Chongqing University,Chongqing 400044,China)

2(Department of Electronic Engineering,Putian University,Putian 351100,China)

引言

眼睛是视觉的窗口,对眼睛的研究,不仅有助于了解许多心理活动规律,而且有助于眼睛临床诊断。研究眼动的历史非常漫长,而对于运用仪器设备对眼动进行观察和实验是从中世纪才开始的,但直到1901年 Dodge和 Cline通过摄像机使用角膜反光法,记录拍摄下反射光点运动的轨迹,即眼动轨迹[1-2]。上世纪至今,眼动技术先后经历了影像记录法[1],生物电极法[3]、电磁线圈法[4]、红外眼电图法[5]、视频眼震法[6]等多种方法的演变。

这些方法在临床都得到了实验和应用,传统应用较为广泛的生物电极法,需要在患者角膜贴上生物电极,易使患者眼球感觉不适,并会受到电极安放位置的生理电位影响,导致检测误差[7];电磁线圈法需要一个线圈作为电极来连接透镜,但是线圈在放入眼睛时,会改变眼内压力,引起测量误差[8-10];红外眼电图法主要基于虹膜与巩膜不同的反射特性,在水平方向上具有较高的检测精度,而在垂直方向上精度偏低[11]。这些眼动分析仪器和技术方法均存在一定的缺陷。

随着高性能摄像机和人机交互接口技术的发展,国外在应用视频图像对眼震进行研究[12-15],并研制出了一些可应用于临床的视频眼震仪,但是这些设备均存在大型、昂贵等不足,不利于在医院推广应用。国内视频眼震研究起步较晚,在视频眼震及其图像分析做了相关研究[16-17],但仍有一系列问题待以解决和完善。为了实现基于红外视频图像进行眼震分析,介绍一种基于形态学和区域连通标记算法,提出了基于左上邻域方法进行连通图像标记,对图像进行区域分割,再进行区域合理校验和区域合并,最终得到瞳孔区域,通过计算获取瞳孔中心位置坐标,画出瞳孔运动轨迹,并进行了实验分析验证。

1 方法

1.1 眼震视频分析系统的硬件结构

图1为眼震视频分析系统的硬件结构原理框图。系统包含光学系统部分、采集和控制部分以及眼震分析软件系统等3部分。光学系统部分主要由摄像头和光源组成,并把两者经过工艺模型制成合适的一体化眼罩。摄像采用CMOS摄像头来捕捉眼睛区域图。考虑到照明以及视网膜对红外线不敏感等因素,选择850 nm的红外LED光源作为光源照射人的眼睛,来达到检测瞳孔获取灰度图像的目的。

系统前端捕捉到的图像,通过采集卡输入到计算机眼震分析软件,进行眼震轨迹及相关的参数计算。而要进行的医学或其它领域的试验项目对象,通过采集控制部分传输到眼罩上的显示屏,被实验者双眼跟随项目对象进行相应的眼震实验。

图1 系统硬件结构Fig.1 Hardware Structure of the system

1.2 瞳孔中心定位算法

经临床观察,在眼球震颤过程中,瞳孔大部分区域不会被上下眼睑遮掩,所以视频眼震分析系统的目的是获取瞳孔的运行轨迹,从而通过计算获得在记录时间内的眼震的频率、振幅、眼震快慢相速度和眼震方向等诊断信息。

通过系统前端硬件部分采集到的眼震视频信号是一序列帧的眼睛图像。为了去除眼睛图像不必要的背景信息,从而获得有用的瞳孔目标,本研究提供的一种基于形态学和区域连通标记算法,并提出了左上邻域方法进行标记连通像素,再进行区域合并,计算到得到瞳孔中心位置坐标,实时把每帧图像得到瞳孔中心坐标通过曲线拟合出来,得到瞳孔的运动轨迹,从而获得所期望的诊断信息。

本研究的视频眼震图像分析算法流程如图2所示。系统获取瞳孔原灰度图像后,首先经过二值化和扫描去噪,取得初步消噪后的瞳孔突显图像;因还存在LED影像残余,需再经膨胀和腐蚀除去,获得更完整的瞳孔图像;接着采用本文提出的左上邻域法提取最大连通区域即为瞳孔,并计算其中心坐标;最后,拟合出每一帧的瞳孔中心坐标即为眼动轨迹。

图2 瞳孔中心定位算法流程Fig.2 Algorithm flow chart of Pupil center location

1.2.1 灰度图像二值化及扫描去噪

为便于红外眼睛视频图像的进一步处理,使图像变得简单,而且数据量减小,并能突显出眼睛区域包括瞳孔的轮廓,首先对图3所示的红外灰度图像进行二值化处理。经过多次实验比较,眼睛戴上眼罩后,得到眼睛大致处于的区域阈值A;并对灰度图像直方图处理,从直方图灰度统计特征上可以得到瞳孔区域的灰度阈值h。即可通过式(1)进行阈值判定,把灰度图像中符合阈值T的像素点(i,j)灰度值f设置成白色,否则设置为黑色。图4(a)所示是二值化后的效果图。T=f < h||(i,j)∈ A(1)

图3 原灰度图Fig.3 Original gray image

因为采集到的红外视频图在不同区域会存在不同的噪声干扰,而且红外光源LED在眼睛里存在影像,为此,需对整张图像分区域进行扫描消噪。对于图像边界的4个角区域采用2×2窗口进行滤波,取角顶点为当前点,对2×2区域值进行两两比较,若当前点的值最大,认为是噪声,则用邻域较大值替换当前点的值;同样,若当前点的值最小,亦认为是噪声,则用邻域较小值替换当前点的值。这样达到对图像4个角区域进行滤波。而除去图像边界的4个角区域后的边界,采用2×3窗口进行滤波,同样办法,若当前点的值为最大或最小值,认为是噪声,采用邻域较大值或较小值进行替换。中间区域采用3×3窗口进行中值滤波。图4(b)所示是消噪后的效果图。图中虽消除了一些噪声,但还存在LED影像残余,还需要做进一步图像处理。

图4 二值化和消噪图。(a)二值化;(b)消噪Fig.4 The binarization and filtered image.(a)Binarization image;(b)Filtered image

1.2.2 膨胀和腐蚀[18-21]

膨胀和腐蚀是图像处理中数学形态学的两个基本运算。膨胀是将与物体接触的所有背景点合并到该物体中,使边界向外部扩张的过程,可以填补物体中的空洞,其一般意义的概念定义为式(2),即由B对X膨胀所产生的二值图像D是满足:如果B的原点平移到点(i,j),那么它与X的非空交集点(i,j)的集合即为图像D。

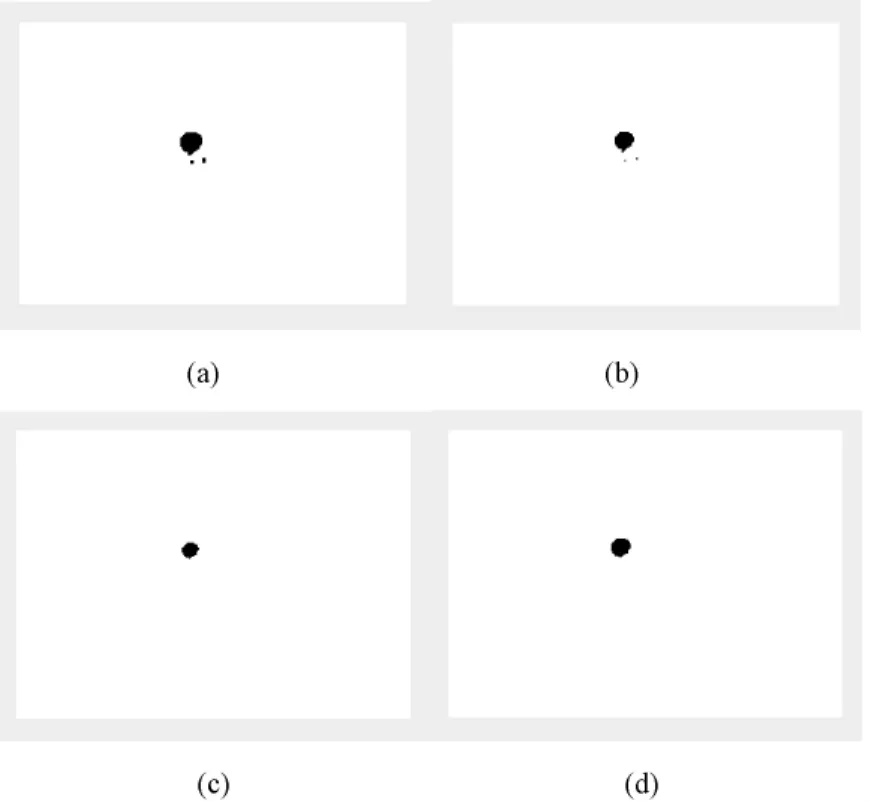

针对本研究消噪后的图像,构建8-邻域判断算法,即当前点的8-邻域有一个点的颜色是黑色时,就把当前点的颜色填充成黑色。这样目标区域增加了很多,方便进行后继的边界提取,其效果图如图5(a)所示。但是,从图中可以看出,同样把不需要的区域亦增大,因而还需进行腐蚀。

图5 膨胀和腐蚀图。(a)第1次膨胀;(b)第1次腐蚀;(c)第2次腐蚀;(d)第2次膨胀Fig.5 Erosions and dilations.(a)Result of the first erosion;(b)Result of the first dilation;(c)Result of the second dilation;(d)Result of the second erosion

腐蚀是一种消除边界点,使边界向内部收缩的过程,可以消除小且无意义的物体,其一般意义的概念定义为公式(3),即由B对X腐蚀所产生的二值图像E是满足:如果B的原点平移到点(i,j),那么它将完全包含于X中的点(i,j)的集合。

同样构建8-邻域判断算法,与膨胀相反,即当前点的8-邻域有一个点的颜色是白色时,就把当前点的颜色填充成白色。这样目标区域变小了很多,同时亦把不需要的区域变小,达到消噪目的,其效果图如图5(b)所示。

这样先膨胀后腐蚀就是执行了一次形态学闭合运算,为了使图5(b)中在瞳孔旁边的红外LED点过滤掉,再执行一次腐蚀,其结果如图5(c)所示,LED点完全消去。但因其瞳孔区域执行第二腐蚀后,区域变小了,不便于边界提取,且比实际瞳孔区域小。为此,进行第二膨胀,其效果如图5(d)所示。同样这样先腐蚀后膨胀实现了图像开启运算。图中得到的瞳孔跟真实的瞳孔大小接近,且不存LED影像,不会影响瞳孔中心定位。

1.2.3 瞳孔中心定位

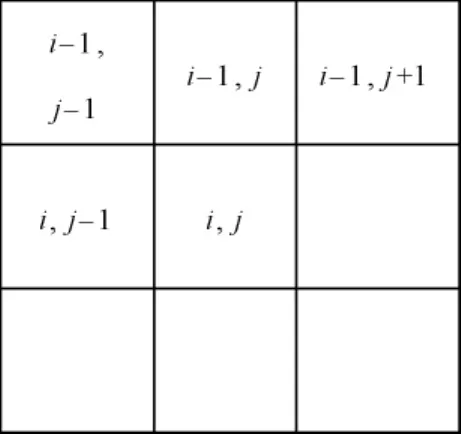

对于图像目标的定位方法有很多,成熟的瞳孔搜索算法研究主要应用于人脸检测。为了获取瞳孔中心坐标,本研究提出采用左上邻域法进行区域连通性标记检测,获得各个连通区域,再通过区域校验及合并,最终获得目标瞳孔连通区域。左上邻域如图6所示,是指像素(i,j)左,左上,上,右上4个像素{(i,j– 1),(i– 1,j– 1),(i– 1,j),(i–1,j+1)}构成的集合,它只需判断相邻的左上像素即可,而不像4-邻域和8-邻域还要判断下一行相邻像素,这样进行扫描连通标记时,不会重复扫描,减少了算法时耗。

图6 左上邻域Fig.6 Left-up neighborhood

基于左上邻域连通像素标记二值化图像获取各个连通区域的思想是:若当前像素的值是0,则转向下一个像素;若当前象素的值是1,检查它左边和上边的4个近邻象素,如果它们都是0,就给当前象素一个新的标记,并更改连通区域,并开始新的连通区域的像素个数计数;如果上述4个近邻元素只有一个值为1,就把该象素的标记赋给当前象素,并赋予同一标记,对该连通区域的像素个数加1;如果它们的值都为1且具有相同的标记,就将该标记赋给当前象素,并对其连通区域的像素个数加1;如果它们的值都为1,但具有不同的标记,就应进行合并到一个区域,同时连通区域的像素个数相加。

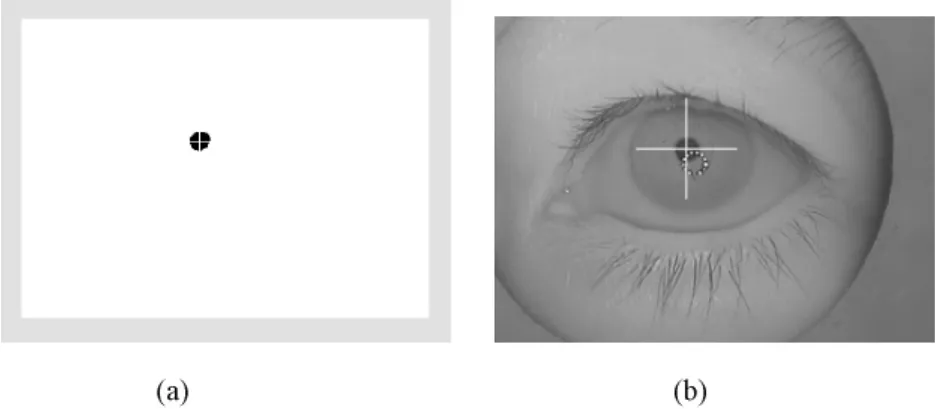

最终可以得到若干个连通区域,因为目标瞳孔区域显然有一定的连通数范围,为此,以一个最大值和一个最小值为阈值,把连通区域限定到这两个阈值之间,若不在这范围之内的连通区域进行强制置0。消除不合理的连通区域后,对剩余的连通区域进行边界坐标求解,并再次进行连通区域限制,对若干通连区域进行合并和去除,最终获得一个连通区域。若得到一个连通区域,则表明定位成功,进行瞳孔中心坐标计算;若没有得到连通区域,代表定位失败,保持上次瞳孔中心坐标。运用其算法获取瞳孔中心定位,如图7(a)所示,定位点在视频中回放的位置,如图7(b)所示。

图7 瞳孔中心定位图。(a)二值化图瞳孔中心定位;(b)视频图瞳孔中心定位Fig.7 Pupil center location.(a)The binarization image of pupil center location;(b)The video image of pupil center location

2 结果与讨论

实验之前,把红外眼动视频瞳孔位置进行平面坐标转换,在视频平面上的瞳孔转动分为水平方向运动和垂直方向运动。实验对象为一位被认为眼睛正常的志愿者进行眼动实验。实验时,这位志愿者眼睛做无规律转动,系统对其进行采样250帧眼动视频图像。通过VC++进行实现前述算法完成瞳孔中心定位,并对提取的中心位置进行拟合,得到眼动轨迹如图8(a)所示。图8(a)中上图为水平方向的瞳孔运动曲线,下图为垂直方向的运动曲线,二者明显不同,与事实相符,瞳孔在运动过程中是无规律,表明在水平和垂直的幅度存在不一样。同时,把眼动视频中的瞳孔运动转换到视平面投影分析,可以得到瞳孔运动在各帧图像间的位移分布,如8(b)所示。即图8(b)中的小圆圈代表瞳孔中心在各帧图像间的位移分布,大圆圈代表以眼睛几何中心为圆心且半径为20像素的圆。经计算,可以得到医学上所需要的眼震分析参数,即水平方向和垂直方向的震幅分别为51像素和35像素。

通过多次实验分析,系统运行良好,均能够把每次实验的眼动轨迹拟合出来;而且耗时短,应用程序定位拟合250帧的眼动轨迹仅需3 s左右,平均每帧定位为10 ms左右,比经典Hough变换快一个数量级,甚至比优化改进的 Hough变换快一倍[22-23]。此外,对于同一次眼震视频帧运用文献[24]的瞳孔定位拟合方法,得到眼震曲线与文中提到的方法获取的曲线进行相关计算,平均结果显示为0.975。因此,文中所提到的方法能够达到同样的瞳孔定位精度,而且时间更快。

图8 眼动轨迹图。(a)瞳孔水平方向(上)和垂直方向(下)的轨迹;(b)红外视频中瞳孔各帧之间位移分布Fig.8 Eyemovementtrajectory.(a)Horizontal(upper)and vertical(bottom)trajectory ofeye movement;(b)Displacement distribution of pupil among frames of infrared video

3 结论

本研究提出一种应用于眼罩式视频眼震分析系统的瞳孔中心定位方法。此方法基于形态学进行分割消噪,采用区域连通标记检测各连通区域进行区域分割。其主要是基于本研究提出的左上邻域法进行一次全图像扫描即可完成区域连通标记和分割,并进行区域合理校验和合并,最后得到与真正瞳孔近似的圆形几何区域,通过计算获得瞳孔中心坐标。应用此方法进行多次实验验证,对每次实验的眼震视频的每一帧图像所获得瞳孔中心坐标进行拟合瞳孔运动轨迹。

实验结果表明,基于所提出的瞳孔中心定位方法能够很好得到瞳孔运动轨迹。该瞳孔中心定位算法简单,只需一次扫描图像标记,因而速度快。通过分析获取的瞳孔中心坐标数组、帧数、采集率及运行轨迹,可得到眼震分析的诊断参数,包括眼震潜伏期、持续时间、总次数、频率、振幅、快慢相速度和眼震方向等。与传统眼震电图仪相比,具有无接触,不损伤眼睛,不受生理电位影响等优点。为现有国内研究的视频眼震瞳孔中心定位提供了一种可借鉴的实用方法。本研究下一步工作是应用于眼科和心理学临床实验,丰富实验眼震数据库,为临床诊断做准备;并进一步提高视频采样率,对高频眼震信息进行检测,优化瞳孔中心定位算法,进一步提高运算速度,以便于获得眼震的各种频率成份信号,为眼震的临床诊断、疗效评估、药理实验等提供更丰富的信息依据。

[1]Dodge R,CLINE TS.The angle velocity of eye movements[J].Psychological Review,1901,8(2):145-157.

[2]Morimoto CH,Mimica MRM.Eye gaze tracking techniques for interactive applications[J].Computer Vision and Image Understanding,2005,98(1):4-24.

[3]Marg E.Development of electro-oculography[J].The A M A Archives of Ophthalmology,1951,45:169-185.

[4]Robinson DA.A method of measuring eye movement using a scleral search coil in a magnetic field[J].IEEE Transactions on Biomedical Engineering,1963,10:137-145.

[5]Anders S,Weiskopf N,Lule,et al.Infrared oculography validation of a new method to monitor startle eyeblink amplitudes during fMRI[J].Neuroimage,2004,22(2):767-770.

[6]Hermann DS,Jan Y,Tony P,et al.Assessment of ocular counterroll during head tilt using binocular video oculography[J].Investigative Ophthalmology& Visual Science,2002,43(3):662-667.

[7]Christian WH,Rene M,Otmar M.Recording of Horizontal Saccadic Eye Movements:Methodological comparison between electro-oculography and infrared reflection oculography[J].Neuro-Ophthalmology,1986,6(3):189-197.

[8]Träisk F, Bolzani R, Ygge J.A comparison between the magnetic scleral search coil and infrared reflection methods for saccadic eye movement analysis[J].Graefe's Archive for Clinical and Experimental Ophthalmology,2005,243(8):791-797.

[9]Collewijn H,Van der Mark F,Jansen TC.Precise recording of human eye movements[J].Vision Research,1975,15(3):447-450.

[10]Kenyon RV.A soft contact lens search coil for measuring eye movements[J].Vision Research,1985,25(11):1623-1633.

[11]Eadie AS.Improved method of measuring eye movements using limbusreflection technique[J].Medical and Biological Engineering and Computing,1995,33(1):107-112.

[12]Van der Geest JN,Frens MA.Recording eye movements with video-oculography and scleral search coils:a direct comparison of two methods[J].Journal of Neuroscience Methods,2002,114:185-195.

[13]Luima A,Minamitani H,Ishikawa N.Image analysis of quick phase eye movements in nystagmus with high-speed video system[J].Medical& Biological Engineering& Computing,2001,39(1):2-7.

[14]Zuñiga A,García N,Rodríguez D,et al.Dynamic visual acuity using video-oculography[C]//Leder RS,eds.Proceedings of Annual International Conference of the IEEE Engineering in Medicine and Biology.Mexico City:IEEE Press,2003:3229-3232.

[15]Darren RG,Todd BP,Kevin SL,et al.Real-time monitoring of eye movements using in frared video-oculography during functional magnetic resonance imaging of the frontal eye fields[J].Neuroimage,2000,11(1):58-65.

[16]王萑,史仪凯,吴磊,等.瞳孔快速定位方法在眼震实时检测系统中的应用研究[J].光电子·激光,2009,20(4):540-544.

[17]邓梁,史仪凯,袁小庆.一种基于图像分割的视频眼震图记录新方法[J].中国生物医学工程学报,2006,25(5):523-526.

[18]申志强,陈韬,钱基业,等.基于形态学的冷轧薄板板形识别[J].重庆大学学报,2007,30(12):25-29.

[19]John M,Mike R,Paul D.An approach using mathematical morphology and support vector machines to detect features in pipe images[C] //Caelli T.2008 Digital Image Computing:Techniques and Applications,Canberra:IEEE Press,2008:84-89.

[20]Isabelle B.Defining belief functions using mathematical morphology-Application to image fusion under imprecision[J].International Journal of Approximate Reasoning,2008,48:437-465.

[21]QiDawei, LiYuanxiang, LeiYu.The application of mathematicalmorphologicaloptimization algorithm in edge detection of defected wood image[C] //Proceedings of the IEEE International Conference on Automation and Logistics.Qingdao:IEEE Press,2008:2271-2276.

[22]秦开怀,王海颍,郑辑涛.一种基于Hough变换的圆和矩形的快速检测方法[J].中国图象图形学报,2010,15(1):109-115.

[23]Dobeš M,Martinek J,Skoupil D,et al.Human eye localization using the modified Hough transform[J].Optik,2006,117(10):468-473.

[24]Takegami T,Gotoh T,Kagei S,et al.A hough based eye direction detection algorithm without on-site calibration[C] //Sun C,Talbot H,Ourselin S,eds.Proceedings of 12nd Digital Image Computing:Techniques and Applications.Sydney:Csiro Publishing,2003:459-468.