基于兴趣点特征的多类物体识别

刘海华,廖秋萍

(中南民族大学生物医学工程学院,武汉430074)

物体识别是计算机视觉领域中最重要的,也是最具挑战性的课题.近来各国研究者提出各种多类物体识别的方法,如FeiFei等人提出的基于“bag of words”贝叶斯模型的多类物体识别方法[1,2],Graumand[3]、Lazebnik[4]等人提出的尺度空间金字塔匹的识别模型.然而,这些方法存在计算量过大、模型优化困难等缺点.2005年 Thomas和 Poggio[5]根据人的视觉系统信息加工机理的研究成果,提出第一个能模拟人脑视觉系统的物体识别模型,即HMAX模型.随着人类对自身视觉系统研究的逐步深入,以及认知心理学和计算机视觉的不断发展,基于该模型的各种改进算法不断出现,并应用于物体识别领域.2006年 Mutch[6]在 HMAX 模型基础上,加入稀疏性、侧面抑制等生物特性来实现多类物体的识别,取得了良好的识别效果.国内学者朱庆生[7]等人通过AdBoosts算法结合HMAX的特征对柑桔溃疡病进行识别;李芹[8]等人通过对模型训练特征的提取方法及匹配算法进行改进,并限定C2层的不变性范围来对人脸进行识别,达到了非常好的效果;2009年汤毓婧[9]通过提取显著点处小块作为特征小块,在一定程度上提高特征模板有效性.但这些方法都存在共同性的问题,即计算量大,且识别率与计算量很难平衡等问题.为此,本文结合多类物体特点来简化HMAX模型,减少计算量;同时,给出适合于多类物体稳定兴趣点的提取算法,提高多类物体的识别率.

1 HMAX标准模型

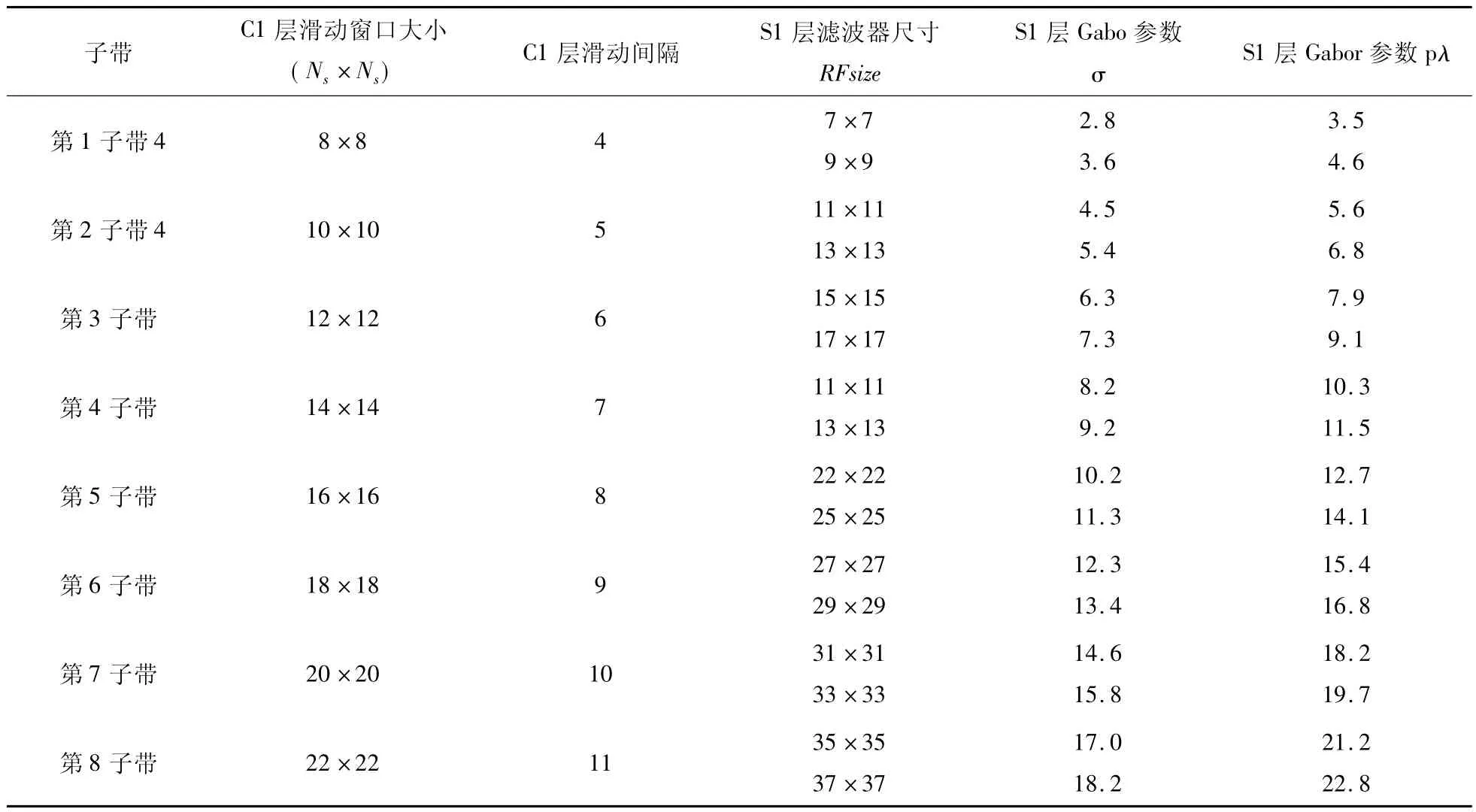

其 中,λ = σ/0.8,X=xcosθ+ysinθ,σ =0.0036RFsize2+0.35RFsize+0.18,Y=xsinθ+ycosθ.RFsize为滤波器尺寸,分别设置为 7,9,11,…,37.

C1层模拟V2区复杂细胞,对S1层8个子带采用最大化联合操作方法模拟V1区复杂细胞生理特性.具体操作方法是:对各子带进行Ni×Ni(Ni=9,10,…,22;i=1,2,3,…,8 区域的最大值滤波处理(滤波器的滑动间隔了半个区域),从而实现小范围的局部位置不变性;然后,抽取同一子带同一方向上两尺度的最大值,以实现小范围的局部尺度的不变性.

对于训练样本,要在C1层生成的不变响应中学习出特征模板,该学习过程通过随机选择任意子带,在该子带对应的4个方向特征上随机抽取不同大小的小块,将抽取的小块保存为特征模板.本模型的具体做法是,从第2个子带上随机的抽取4种不同的小块,通过最小距离计算获取训练的特征,共K个特征.4种小块的大小分别为4×4,8×8,12×12和14×16.

S2层主要模拟视觉皮层的V4层,通过图像所有子带、所有位置的C1层输出特征与训练特征进行遍历相似度匹配,来获得具有全局尺度不变性和全局位置不变性的特征.对于图像某子带中某位置的局部C1特征,采用式(2)的径向基函数(RBF)来与个训练特征进行匹配计算:

r=exp( - γ‖X-Pi‖2),i=1,2,3,…,K,(2)其中Pi为第i个训练特征,r代表与训练特征遍历匹配结果.那么每个训练特征都与所有尺度上的所

Thomas Serre[5]提出了模拟大脑视觉皮层腹部通路的4层次结构模型,分为S1层、C1层、S2层和C2层,分别对应视觉皮层的V1、V2、V4和IT区.其中,该模型S1层中使用(1)式给出的Gabor滤波器模拟V1区的简单细胞的生理特性,反应了简单细胞在不同尺度和不同方向上的响应,在原模型中使用了4个方向、16个尺度的Gabor滤波器组成了1个滤波器组对图像进行操作,从而获得64个响应子图,并将相邻两个尺度的响应图作为1个子带,从而形成了8个子带图.有位置特征进行匹配计算,最终结果即是具有全局尺度和位置不变性的S2特征.

C2层模拟视觉皮层中的IT层,即取S2层输出中所有尺度和位置上的最大值.也就是说,S2特征代表输入图像的所有位置和尺度与一系列特征小块Pi的匹配值,而C2特征代表其中最匹配的值.如特征模板有K个训练特征,那么最终得到列向量,作为该图像的C2层特征向量.最后将C2特征向量送入SVM分类器进行分类.

2 改进的HMAX模型

2.1 S2层尺度不变性范围限定

标准模型最初主要用于复杂背景中单类物体的识别,所以在S2层计算中用到8个子带的C1特征与特征小块,并采用遍历形式进行相似匹配,从而实现全局尺度和位置的不变性.这种方法的主要问题是计算量较大.为此,采用选择合适的局部尺度不变性范围的方法对原标准模型进行改进.

由于图像数据库中各种类型物体具有在视野中的大小变化不大,物体位置也基本上都在视野中央的特点.而rolls指出V4和IT区中的神经元并非具有完全意义上的不变性[10],其感受野范围仅在部分视域和一定尺度范围内.为此,在模型中没有必要对所有尺度的信息进行考虑,而是需要有选择性的使用.也就是说对S2层匹配的尺度不变性范围限定,从而在不影响识别率的基础上,提高模型的识别速度.

在模型中,每个子带的C1特征是原图像经过不同尺度Gabor滤波器滤波后得出的不同的特征,其相邻子带所包含的信息相似,因此有限地选择子带,减少计算量.如模板来自第2子带,那么由于第2子带与邻近子带(如3子带)的C1特征包含信息较为相似,与特征模板匹配时,能产生更良好的匹配结果;而来自第8子带的C1特征由于经过尺度相差较大Gabor滤波后,得出的特征信息与第2子带的C1特征差异较大,所以得到最好匹配的概率较少.因此,为了减少模型的计算量,在子带选择时不需要全部子带,而是通过实验选择部分子带,从而获取合适的局部尺度不变性范围.

2.2 特征模板提取位置限定

由于HMAX模型随机选取小块作为特征模板,其结果导致特征模板有效性不高.为此,采用能有效表达多类物体信息的兴趣小块作为特征模板,从而提高特征模板的有效性.采用的方法是获取图像中的兴趣点,并以兴趣点为中心选取相应大小的兴趣小块,作为特征模板.

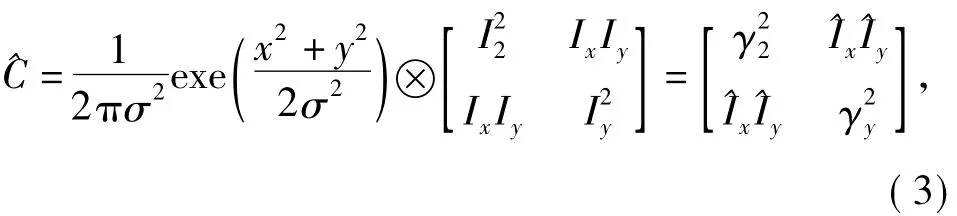

为了节约运行时间,所以在改进模型中采用计算简单、抗噪性良好的harris兴趣点提取算法来提取兴趣点.Haris算子[11]是受信号处理中自相关函数的启发而构建的,其基本思路是计算由图像灰度梯度构成的自相关函数关联一阶曲率,如果两个曲率值都高,那么就认为该点是兴趣点特征.矩阵^C的定义由式(3)确定.其中,Ix为图像I在方向的偏导;Iy为y方向的偏导.兴趣点响应函数CRF的判断标准为:

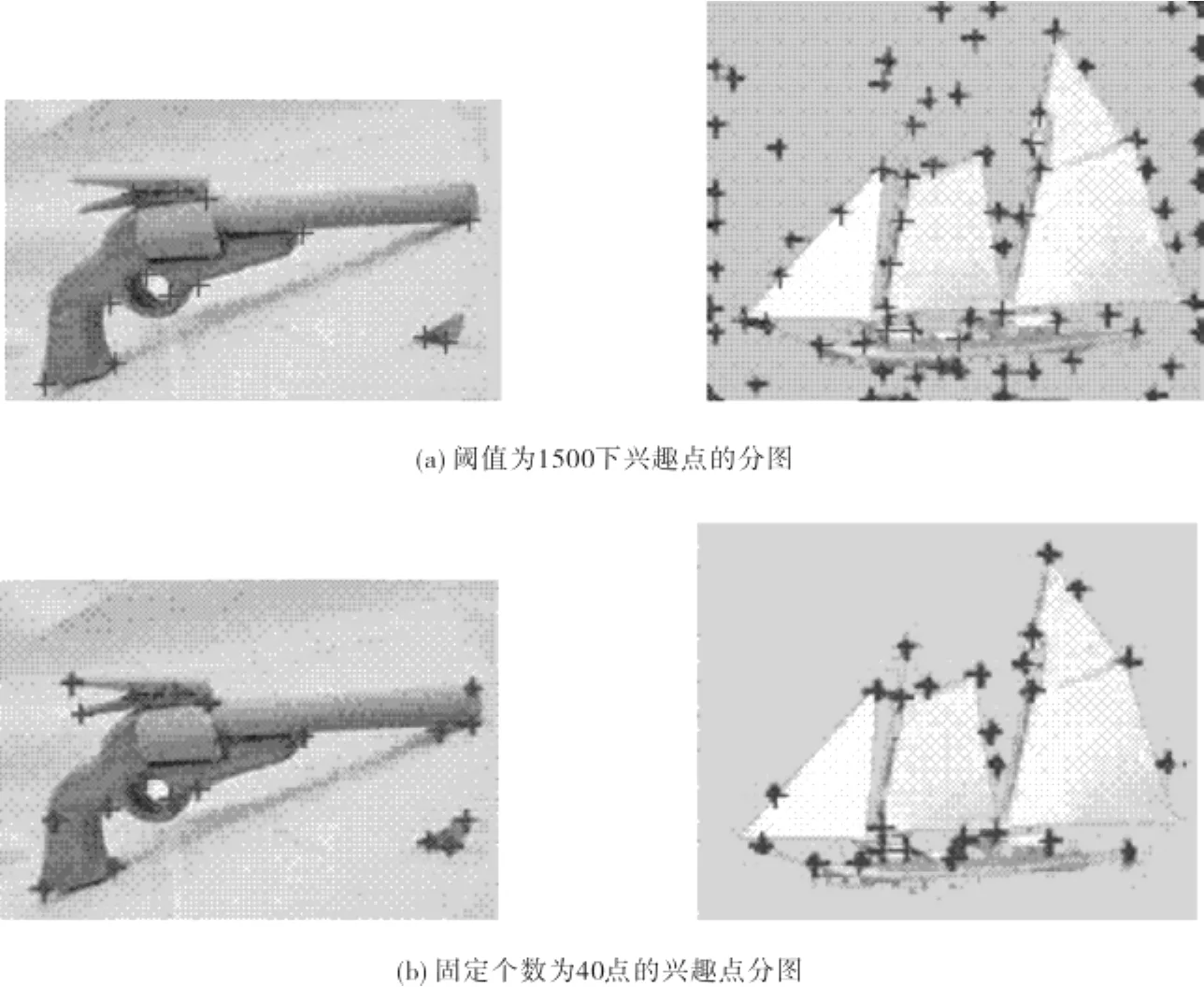

图1分别给出了一副图像随机选取点和提取兴趣点后的复合图像.从图1可以看出,随机选取点的方法所选取的点在图像中的分布较均匀,既有在关注对象上的点,也有在背景上的点,因此有效点的数量相对较少.而采用选择兴趣点的方法所获得的点几乎全在关注对象上,提高了所选择点的有效性.由于Harris兴趣点提取算法是根据CRF值的大小来确定取兴趣点,因此需要为CRF设置阈值.然而不同类别的目标表现出的图像信息不同,计算出的CRF值的分布不同,很难给出统一的标准.为此采用设置固定的兴趣点数量来解决这类问题.

对于不同图像,计算的CRF值越大,该点是该图像的兴趣点概率就越大.通过对计算获得的CRF值进行降序排列,选取前n个点作为兴趣点.使用该方法对所有的图像都选取相同的n个兴趣点,以选择的兴趣点为中心选取n个小块.虽然可能存在所选取的小块在背景上的情况,但却能够降低漏选能表达目标特征的兴趣小块,且保证了所有图像在计算兴趣小块所消耗的时间的一致性.图2给出了以设置CRF阈值的方法和设置兴趣点总数的方法所获得兴趣点图,其中图2(a)为设置CRF阈值为1500的兴趣点图,图2(b)为选取固定数量为40的兴趣点图.从图2可以发现,(a)图中右图所选取的兴趣点有较大一部分落在背景上,而左边的图漏选了一些我们感兴趣的点;而(b)图中的两幅图所选取的兴趣点都比较均匀分布在目标上,即选出了能表达目标特征的兴趣点,而有没有过多兴趣点分布在图像的背景上.

3 实验结果与分析

为了对上述方法进行合理的验证,采用标准图像数据库Caltech-101作为测试图像数据来源.该数据库包含101类不同的目标和背景类共102类,每类大约包含40到800张彩色图片.本文选取了其中的8类物体进行分类.这8类物体分别是手风琴、飞机、汽车、钢琴、摩托车、手枪、帆船、手表.在实验过程中,选取每类图像20幅作为训练样本,剩下的作为测试样本.为了实验的方便快捷,对所有图像进行高度为140,宽度等比例缩小的方式进行预处理,使用OSU-SVM工具箱的线性核函数进行分类,其中惩罚因子设置1.实验中,S1层Gabor滤波器组的参数和C1层滑动窗口的参数按照表1给出的值进行设置;其中训练样本学习获得的特征模板为800个小块,小块的分别为4×4、8×8、12×12和16×16等4种尺寸,每种取200个小块.

图2 兴趣点提取分布图Fig.2 Interest points extacting distribution map

表1 HMAX模型中S1层和C1层参数的设置Tab.1 HMAX model S1 layer and C1 layer parameters settings

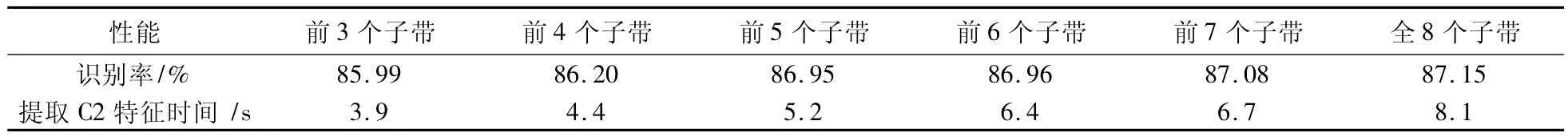

为了验证限定S2层的尺度不变性范围的有效性,将HMAX模型全部8子带的C1特征全部与特征模板进行匹配,逐步递减到只用前3子带的C1特征与特征模板进行匹配,从而获取识别的准确率.表2是给出了实验所获得的识别准确率和提出C2特征所需要的时间,其中每次实验结果取6组实验数据的平均值.

从表2给出的结果可以看出,选取与特征模板进行匹配的C1层子带的数量从8个逐渐减少到5个,其提取C2特征的时间大大缩短,但识别率下降的幅度却较小.该结果说明小部分高子带即第6、7、8特征所损失的轮廓特征在可接受范围内,所以限定局部尺度不变性范围为前5子带.

表2 不同局部尺度不变性范围的识别率和速率对比结果Tab.2 Comparison of different local scale invariance range of recognition rate and rate

根据上述结果,在选取C1层5个子带进行特征匹配来简化模型的基础上,再提取训练图像的兴趣点,把兴趣点映射到该图像的C1特征,以映射后的兴趣点为中心的小块特征作为特征模板,其基本步骤为:

第1步:随机从训练样本中抽取1副图像,并提取该图像第2子带的C1特征;

第2步:提取该图像Harris兴趣点,在把兴趣点映射到C1特征上;

第3步:随机选取映射到C1特征上的兴趣点,以该点为中心提取大小的小块;

第4步:判断该小块是否有超出C1层的边缘,如超出则把小块向图像中间移动,直到所取小块全部在C1层上为止;

第5步:保存小块为特征模板.

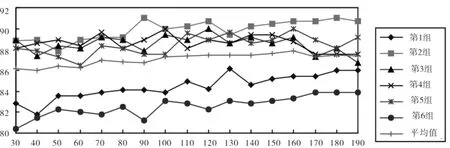

图3给出了提取兴趣点的数量与识别率的关系图.每组对训练图像提取兴趣点的个数从30点到190点,每次间隔10个兴趣点.从图3给出的6组数据的平均识别率曲线可看出,识别率随着兴趣点个数的增加逐渐提高,当识别率达到最大后,识别率随兴趣点的增加有所回落并趋于平稳.这表明当兴趣点少时,虽然取得的特征小块都是兴趣小块,但另一部分代表目标兴趣区域的小块没有选出来,所以识别率较低;随着兴趣点的增加,漏选的兴趣区域小块减少,识别率随之提高.而当兴趣点达到一定个数时,对部分类别图像所选取点兴趣点落在非目标区域上的数量会增加,从而影响识别效果.随着兴趣点的进一步增加,提取兴趣小块的完整性与非兴趣小块之间达到平衡,从而使得识别趋于平稳.从平均识别率曲线上看,当取兴趣点个数为170时,能够达到最高识别率87.89%.

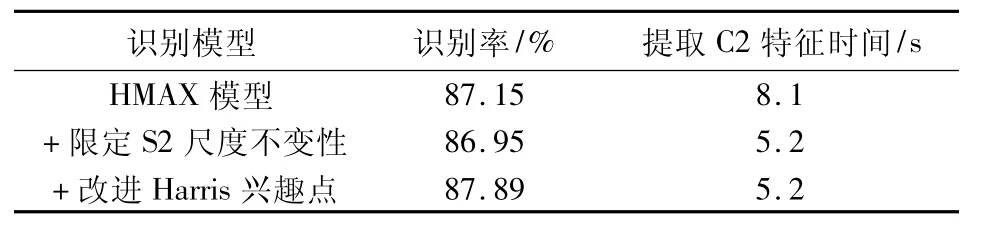

表3给出了改进模型与HMAX模型识别率和识别速度的对比结果.其中限定S2尺度不变性范围为5个子带,兴趣点个数为170个.从表3可以看出建议对HMAX模型进行限定S2层特征的尺度不变性范围,识别率没有大幅度降低但却大大提高识别的速度;当根据建议的方法提取兴趣小块为特征模板后,提高了模型的识别率.从整体上看,本文改进的模型比HMAX模型具有更快的识别速度和更高的识别率.

图3 兴趣点数量与识别率的关系Fig.3 Relationship between number of interest points with recognition rate

表3 改进模型与HMAX模型识别率和识别速度的对比结果Tab.3 Comparison of rate and speed of recognition between improved model and HMAX model

4 结语

本文在HMAX模型的基础上对该模型进行改进,其重点在于在特征模板的训练过程中,选取以本文改进的兴趣点为中心兴趣小块作为特征模板,力求解决无法在所有目标中协调阈值选取问题,以提高模型的识别率.通过对Caltech-101图像数据库中多类目标进行分类实验表明,本文改进模型不仅比原HMAX模型具有更快的识别速度和更高的识别率,而且具有应用的普适性,即能对所有类别目标取统一的兴趣点数量进行特征提取,从而解决了不同类别目标图像阈值选择问题.

[1]Fei-Fei L,Fergus R,Perona P.Learning generative visual models from few training examples:an incremental Bayesian approach tested on 101 object categories[C]//IEEE.Proc of the Workshop on Generative-Model Based Vision in Computer Vision and Paueru Recognition.Washington:IEEE,2004:59-70.

[2]Wang G,Zhang Y,Fei-Fei L.Using dependent regions for object categorization in a generative framework[C]//IEEE.IEEE Computer Society Conference on Computer Vision and Patten Recognition.New York:IEEE,2006:1597-1604.

[3]Grauman K,Darrell T.Pyramid match kernels:Discriminative classification with sets of image features[C]//IEEE.Proceedings of International Conference on Computer Vision.Washington:IEEE,2005:1458-1465.

[4]Lazebnik S,Schmid C,Ponce J.Beyond bags of features:Spatial pyramid matching for recognizing natural scene categories[C]//IEEE.Proceedings of the IEEE Computer Society Conference on Computer Vision and Pattern Recognition.NewYork:IEEE,2006:2169-2178.

[5]Serre T,Wolf L,Poggio T.Object recognition with features inspired by visual cortex[C]//IEEE.Proc IEEE CVPR.Washington:IEEE Press,2005:994-1000.

[6]Mutch J,.Lowe D.Multiclass object recognition using sparse,localized hmax features[C]//IEEE.Proc CVPR 2006.New York:IEEE Press,2006:11-18.

[7]朱庆生,张 敏,柳 锋.基于HMAX特征的层次式柑桔溃疡病识别方法[J].计算机科学,2008,35(4):231-232.

[8]李 芹,练秋生.基于生物视觉模型的人脸识别设计[J].电视技术,2008,2(2):80-84.

[9]汤毓婧.基于人脑视觉感知机理的分类与识别研究[D].南京:南京理工大学,2009.

[10]Roll E,Deco G.The computational neuroscience of vision[M].Oxford:Oxford University Press,2001.

[11]Harris C,Stephens M.A combined corner and edge detector[J].Image Vision Computting,1998,6:121-128.