基于YOLOv8n的交通标志检测研究

摘 要:针对传统交通标志检测算法识别精度较低、受环境因素影响较大等问题,提出一种基于YOLOv8n的交通标志检测算法。为解决卷积运算带来的参数共享问题,利用感受野注意力(RFA)机制为每个卷积核滑窗生成不同的特征权重,并通过坐标注意力(CA)获取长距离信息,以加强网络对全局与局部信息的关注度;同时引入聚焦边界框自身形状与尺度的Shape-IoU损失函数计算预测框回归损失。在GTSDB数据集上进行验证实验。实验结果表明,相较于基础模型,改进后的模型平均精确度达到了94.8%,参数量仅为3.210 MB,能够满足实时检测标准,适用于复杂交通场景下的交通标志检测任务。

关键词:YOLOv8n;交通标志;实时检测算法;Shape-IoU损失函数;RFA机制;GTSDB数据集

中图分类号:TP391.4 文献标识码:A 文章编号:2095-1302(2025)04-00-04

0 引 言

交通标志检测算法作为智能驾驶系统的重要组成部分,可以为行驶车辆提供前方道路的交通标志信息,以保障道路交通安全。因此,精确且高效的交通标志检测算法可以极大地减少交通事故的发生,对于实现智能驾驶与交通调控具有重要意义[1]。

交通标志检测可以分为基于传统方法与基于深度学习的方法。基于传统方法的交通标志检测算法根据目标的颜色、形状等人工提取图像特征,再通过分类器将目标分类。手工提取的特征无法表达目标的深层语义,使得传统方法的精确度较低。卷积神经网络(Convolutional Neural Network, CNN)的发展,让目标检测的性能得到极大提高,使得基于深度学习的交通标志检测算法逐步取代了传统检测算法。基于深度学习的目标检测算法可以分为单阶段与双阶段算法。双阶段算法通过区域候选网络(Region Proposal Network, RPN)提取可能存在物体的候选区域,再对每个候选区域的目标进行定位与识别,通常具有更高的检测精度,如R-CNN与Faster R-CNN算法[3-4]等。单阶段算法能够直接由输入图像得到目标物体的类别与位置信息,通常具有更快的检测速度,如SSD和YOLO系列算法[4-5]等。YOLO算法为经典的单阶段算法之一,采用端到端的卷积神经网络模型,相较于双阶段算法,更适用于实时性较高的应用场景。2023年,Ultralytics发布YOLOv8版本,进一步提高了模型的检测准确性。YOLOv8可以完成分类、分割与姿态估计等任务。通过调整网络宽度与深度,YOLOv8可以分为YOLOv8n、YOLOv8s、YOLOv8m、YOLOv8l和YOLOv8x。这些不同大小的模型,能够更好地权衡精度与速度,从而高效完成检测。

与其他目标检测任务相比,交通标志检测通常需要算法具有更强的小目标检测性能,且由于交通标志的应用场景复杂多样,光照与气候条件也会对算法的检测效果造成不同程度的影响,导致交通标志检测时存在较多的漏检与误检情况。

针对上述问题,本文提出了一种改进YOLOv8n的交通标志检测算法。该算法主要工作如下:

(1)使用CA注意力使网络关注显著特征,并通过RFA模块弥补CA注意力的不足,使注意力图无需在卷积核滑窗间共享参数;

(2)采用Shape-IoU计算边界框回归损失,综合考虑边界框自身的尺寸与形状。

1 改进YOLOv8n算法

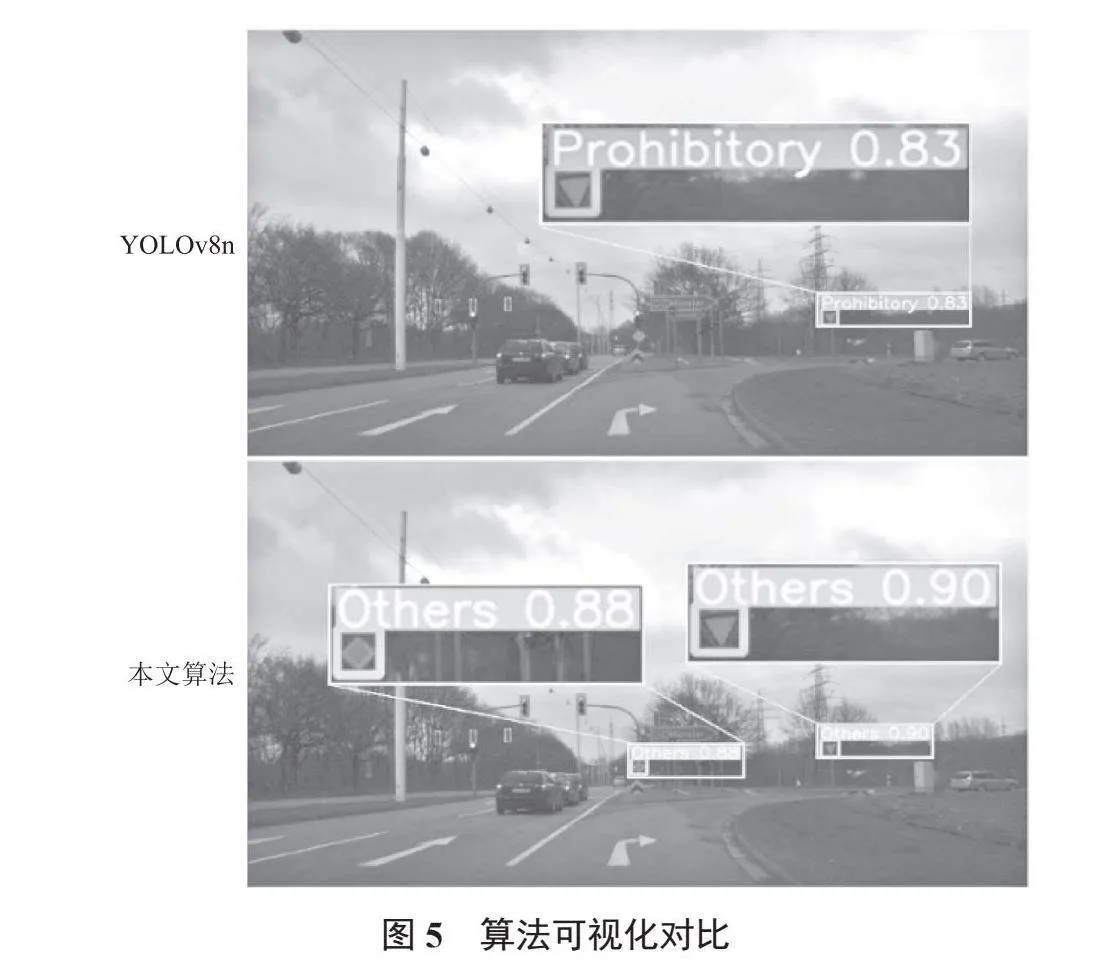

YOLOv8网络主要由3个部分组成:特征提取网络(Backbone)、特征融合网络(Neck)与检测头(Head)。相比于YOLOv5,YOLOv8将C3模块替换为C2f模块,使模型获得更丰富的梯度流信息;其次,YOLOv8使用解耦头(Decoupled Head)与Anchor-Free策略,且不再有之前的Objectness分支;再次,YOLOv8使用二进制交叉熵损失作为分类损失,使用DFL(Distribution Focal Loss)与CIoU作为边界框回归损失;最后,YOLOv8采用Task-Aligned Assigner动态分配策略,能够动态地调整正负样本的分配比例,以适应不同的任务和数据分布。考虑到YOLOv8不同模型的训练时间与检测效果,本文对YOLOv8n网络进行改进。改进后的YOLOv8n网络结构如图1所示。

1.1 RFCAConv模块

卷积运算作为卷积神经网络的基本运算,虽然能够极大地提升深度学习模型在计算机视觉方面的性能,但也存在着许多局限性。如一味地增加网络深度,并不会提升模型性能,反而会出现退化现象。在降低模型计算开销和复杂性的同时,卷积计算中的参数共享策略也限制了网络的性能。

针对CNN的内在局限性,注意力机制是很好的解决方法。注意力机制的属性使网络能够集中于显著特征,进一步提升模型捕获深层语义特征的能力。虽然现有的空间注意力机制已经可以很好地解决卷积运算中参数共享的问题,如卷积块注意力模块(Convolutional Block Attention Module, CBAM)和CA(Coordinate Attention)等。但面对较大卷积核运算时,它们无法强调感受野中每个特征的重要性,仍会存在参数共享问题。为全面解决参数共享问题,提升模型关注度,本文引入了感受野注意力(Receptive-Field Attention, RFA)[9],并将其与CA [10]结合为RFCAConv模块。RFCAConv结构如图2所示。

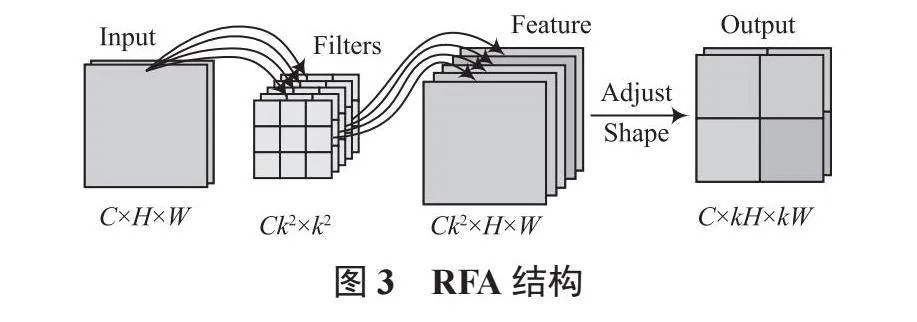

RFCAConv模块首先通过RFA获取感受野空间特征,再使用CA获取全局信息与长距离信息,最后聚合注意力图与空间特征图,使网络学习到感受野滑块内不同特征的重要性。RFA结构如图3所示。RFA主要由分组卷积与形状调整部分组成。分组卷积的输入通道数为C,卷积核大小为k,输出通道数为Ck2。RFA将输入特征图分为C组,以最小化计算开销和参数数量。形状调整部分通过拼接特征图,使通道数减小k2倍,特征图尺寸增加k倍,从而使每个卷积核滑窗都有与之对应的注意力权重。将普通卷积替换为RFCA模块能够消除卷积运算中的参数共享问题,使网络关注到每个感受野内的空间特征。

1.2 Shape-IoU损失函数

计算边界框回归损失是目标检测中的重要步骤。一个良好的回归损失函数能够更准确地定位目标位置。YOLOv8网络使用CIoU[11]作为回归损失。CIoU的表达式如下:

(1)

(2)

式中:ρ(b, bgt)表示两框中心点之间的欧氏距离;c表示最小外接矩形的对角线长度;v表示长宽比的一致性;α表示权重参数。

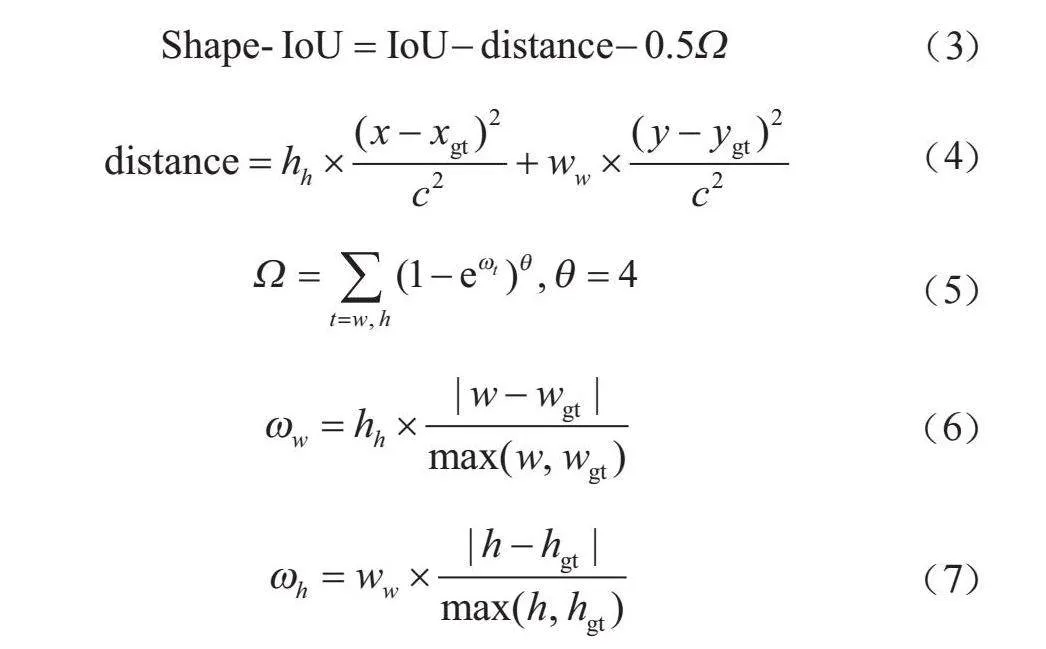

CIoU虽然考虑了边界框回归的重叠面积、中心点距离与纵横比,使训练过程更加稳定,但是式(1)的v反映的为相对值,而非绝对值,且CIoU忽略了边界框自身的形状与尺度等固有属性对回归的影响。因此本文引入Shape-IoU[12]替代CIoU,如图4所示。其表达式为:

(3)

(4)

(5)

(6)

(7)

式中:ww与hh分别表示水平和竖直方向的权重系数。与CIoU相比,Shape-IoU聚焦了边界框自身的形状与尺度,可以适应重叠或非重叠的边界框回归,有效提高了边界框的回归性能。

2 实验结果与分析

2.1 实验环境与配置

本文实验基于Windows 11操作系统,计算机配置为CPU13th Gen Intel® CoreTM i7-13700H、GPUNVIDIA RTX 4060,显存8 GB。实验采用PyTorch框架搭建深度学习环境,在Pycharm平台上完成模型的训练与测试,采用Mosaic进行数据增强,其中epoch为300,batch size为8,同时在训练过程中不使用预训练权重。

2.2 实验数据集与评价指标

本文选用GTSDB作为实验数据集。GTSDB为德国交通标志数据集,样本选自德国不同自然条件下的街道场景图像,共包含图片900张,含有指示(Mandatory)、禁令(Prohibitory)、危险(Danger)及其他(Others)3大类交通标志,图片分辨率为1 360×800。将数据集按8∶1∶1的比例划分为训练

集(约599张)、验证集(约67张)与测试集(75张)。

本文采用不同的性能指标对各模型进行对比分析,如平均精确度(mAP50)、每秒检测帧数(FPS)与参数量等。其中mAP50表示IoU的阈值为0.5时,所有类别的平均精确度。AP为单个类别的平均精确度,通过精确度(Precision)与召回率(Recall)曲线计算而来。其表达式为:

(8)

(9)

(10)

式中:TP为正样本被正确分类的数量;FP为负样本被错误分类的数量;FN为正样本被错误分类的数量。

2.3 实验设计及结果分析

2.3.1 对比实验

为验证改进算法的检测性能,本文将YOLOv5n、YOLOv6n、YOLOv7-tiny、YOLOv8n模型与本文算法置于相同的实验环境下[5-8],在数据集GTSDB上进行对比分析。不同算法性能指标对比见表1。

根据表1可知,相比于其他模型,本文算法在GTSDB数据集上的Precision、Recall与mAP50均有提升;虽然参数量略微增加,但识别精度比参数量最低的YOLOv5n提升了2.9个百分点,比基线模型提升了4.3个百分点,达到了94.8%;改进算法的FPS已满足实时监测需求。这表明本文算法检测性良好,具有较好的特征提取与目标定位能力,能够强调网络中的目标特征,提升交通标志检测精度。

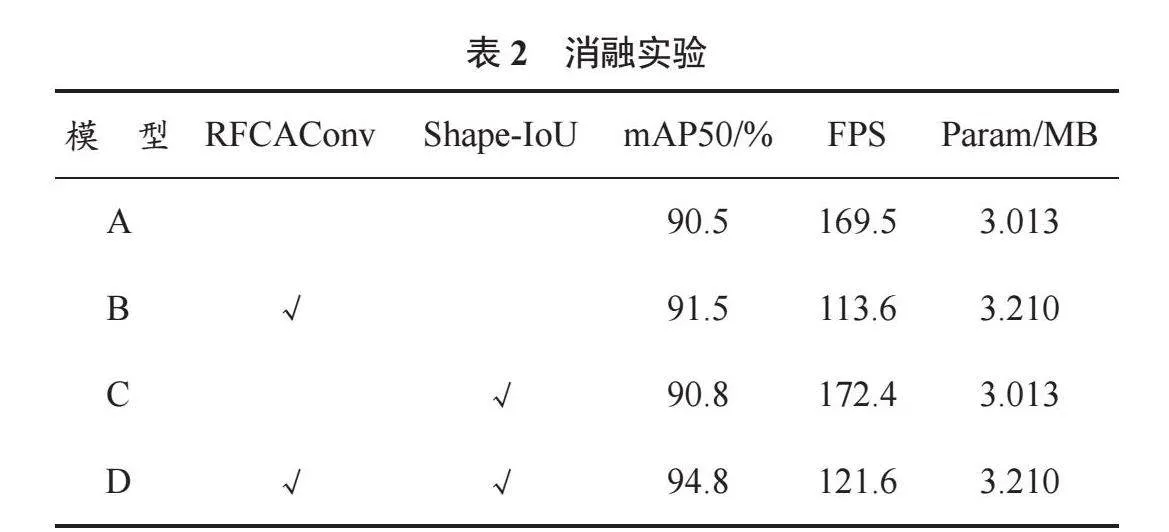

2.3.2 消融实验

为验证本文模型中改进方法的有效性,本文设计了一组消融实验。在YOLOv8n网络中添加不同的改进方法,以相同策略在数据集GTSDB上进行训练与测试,见表2。

表2中,模型A为YOLOv8n原模型,“√”表示在原模型基础上添加对应的改进方法。根据表2可知,在分别添加两种改进方法后,模型检测精度均有提升。其中,使用RFCAConv模块替换普通卷积有效解决了参数共享问题,使mAP提升了1个百分点;引入损失函数Shape-IoU进一步优化边界框回归损失,使mAP提升了0.3个百分点;同时添加两种改进方法时提升效果最明显,mAP达到了94.8%。上述测试验证了本文改进方法的有效性,表明本文改进方法能够有效增强模型对目标特征的感知能力。

2.3.3 算法可视化分析

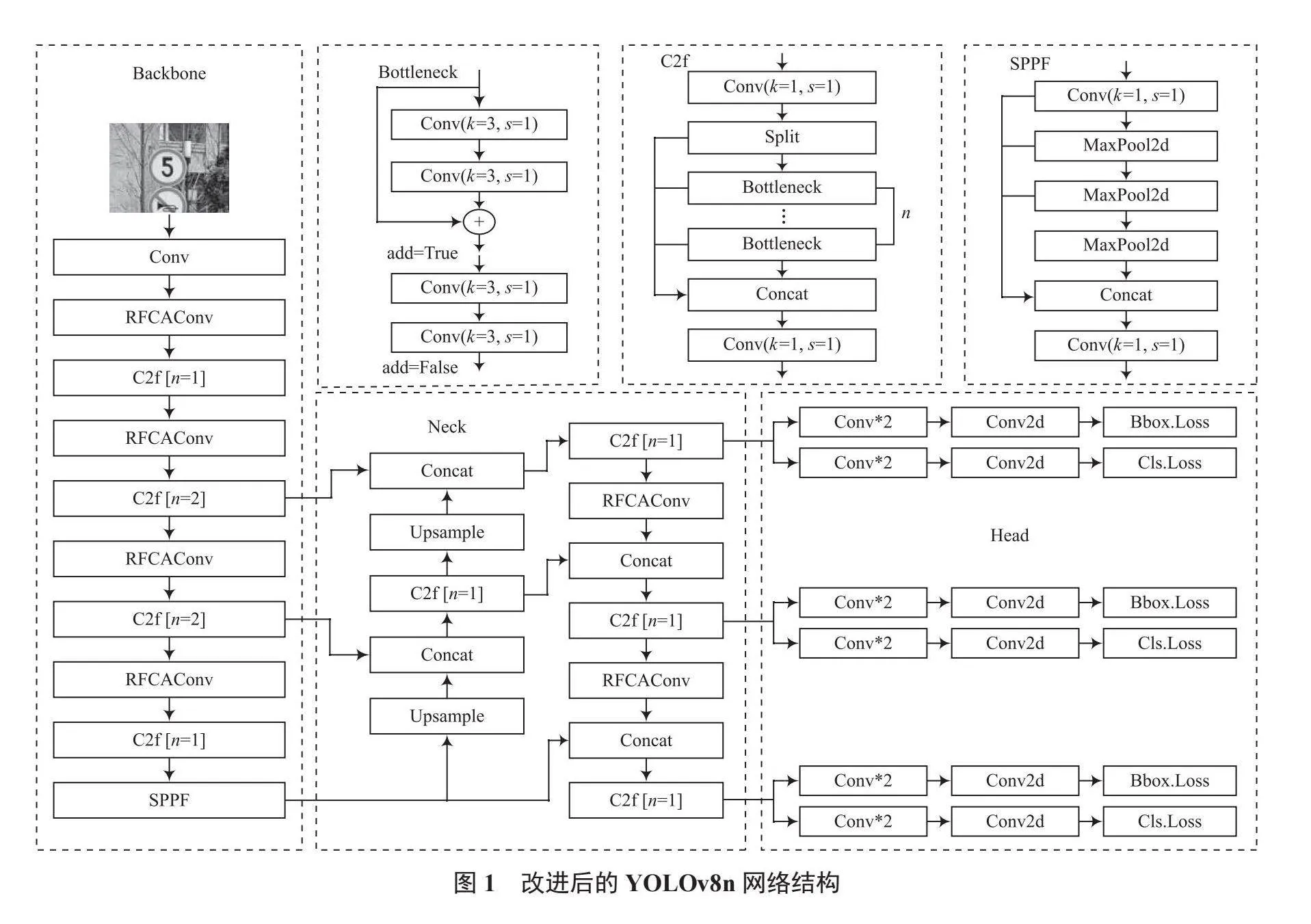

为了更加直观地分析算法改进后的检测效果,使用YOLOv8n与本文算法的权重模型对GTSDB测试集进行推理,并选取其中1组具有代表性的图片进行分析,如图5所示。

在图5中,不难发现图片中的标志均为远距离小目标,且光线较暗也加大了检测难度,导致YOLOv8n对图中的两个标志均未识别成功,其中一个被漏检,另一个则被误检为禁令标志;而在本文算法的检测结果中,两个交通标志均被正确定位与分类,表明本文算法检测性能良好。可视化分析验证了本文算法出色的小目标信息拾取能力。

3 结 语

为进一步提高交通标志检测算法的准确性,尽可能保障道路行驶安全,本文提出了一种改进YOLOv8n的交通标志检测算法。该算法以YOLOv8n为基础网络,使用RFCAConv模块,提高了网络对远距离小目标的关注能力,在复杂环境下有效提取了目标特征信息,同时采用Shape-IoU损失函数,聚焦边界框自身固有属性,提升了模型泛化能力。本文在GTSDB数据集上进行实验,使改进模型的检测精度提高了4.3个百分点,检测速度达到了121.6 FPS。与原算法相比,本文算法更适用于复杂交通场景下的交通标志检测任务。

参考文献

[1] JIA X, TONG Y, QIAO H, et al. Fast and accurate object detector for autonomous driving based on improved YOLOv5 [J]. Scientific reports, 2023, 13(1): 1-13.

[2] GIRSHICK R, DONAHUE J, et al. Rich feature hierarchies for accurate object detection and semantic segmentation [J]. IEEE conference on computer vision and pattern recognition, 2014, 81(1): 582-587.

[3] REN S, HE K, GIRSHICK R, et al. Faster R-CNN: towards real-time object detection with region proposal networks [J]. Advances in neural information processing systems, 2016: 1137-1149.

[4] LI Z, ZHOU F. FSSD: feature fusion single shot multibox detector [EB/OL]. (2024-02-23). https://doi.org/10.48550/arXiv.1712.00960.

[5]方强,涂振宇,相敏月,等.一种基于轻量化YOLOv5的PCB缺陷检测研究[J].物联网技术,2023,13(8):15-19.

[6] LI C, LI L, JIANG H, et al. YOLOv6: a single-stage object detection framework for industrial applications [EB/OL]. (2022-09-07). https://doi.org/10.48550/arXiv.2209.02976.

[7] WANG C Y, BOCHKOVSKIY A, MARK LIAO H Y. YOLOv7: trainable bag-of-freebies sets new state-of-the-art for real-time object detectors [C]// Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition. Vancouver, BC, Canada: IEEE, 2023: 7464-7475.

[8] ZHANG L J, FANG J J, LIU Y X, et al. CR-YOLOv8: multiscale object detection in traffic sign images [J]. IEEE access, 2023, 12: 219-228.

[9] ZHANG X, LIU C, YANG D, et al. RFAConv: innovating spatial attention and standard convolutional operation [EB/OL]. (2024-03-28). https://doi.org/10.48550/arXiv.2304.03198.

[10] HOU Q, ZHOU D, FENG J. Coordinate attention for efficient mobile network design [C]// 2021 IEEE/CVF Conference on Computer Vision and Pattern Recognition (CVPR). Nashville, TN, USA: IEEE, 2021: 13713-13722.

[11] ZHENG Z, WANG P, REN D, et al. Enhancing geometric factors in model learning and inference for object detection and instance segmentation [J]. IEEE transactions on cybernetics, 2021, 52(8): 8574-8586.

[12] ZHANG H, ZHANG S. Shape-IoU: more accurate metric considering bounding box shape and scale [EB/OL]. (2024-01-12). https://doi.org/10.48550/arXiv.2312.17663.