基于改进YOLOv5s模型的田间食用玫瑰花检测方法

收稿日期:2023-10-09

基金项目:国家自然科学基金项目(62173160)

作者简介:化春键(1975-),男,北京人,博士,副教授,主要从事机器视觉、图像处理、深度学习等研究。(E-mail)277795559@qq.com

摘要: 为了在田间环境下准确检测食用玫瑰花及其成熟度,实现花期玫瑰花的自动化采摘,针对田间光照、遮挡等因素造成识别精度较差的问题,提出了一种基于YOLOv5s的改进模型,对花蕾期、采摘期、败花期食用玫瑰花的生长状态进行检测。首先,为了增强多尺度特征融合能力,对特征融合结构进行改进。其次,采用多分支结构训练提高精度,在颈部网络C3模块进行改进。最后,为了提升特征信息的提取能力,在颈部网络中添加融合注意力模块,使模型关注检测目标,减少玫瑰花的误检及漏检现象。改进后的模型检测总体类别平均精度较原始模型提升了3.6个百分点,达到90.4%,对3个花期玫瑰花的检测精度均有提升。本研究结果为非结构环境下的不同花期食用玫瑰花检测提供了更加准确的方法。

关键词: 目标检测;YOLOv5s;特征融合;注意力机制;食用玫瑰花

中图分类号: TP391.4 文献标识码: A 文章编号: 1000-4440(2024)08-1464-09

Detection method of edible roses in field based on improved YOLOv5s model

HUA Chunjian1,2, HUANG Yufeng1,2, JIANG Yi1,2, YU Jianfeng1,2, CHEN Ying3

(1.School of Mechanical Engineering, Jiangnan University, Wuxi 214122, China;2.Jiangsu Key Laboratory of Advanced Food Manufacturing Equipment & Technology, Wuxi 214122, China;3.School of Internet of Things Engineering, Jiangnan University, Wuxi 214122, China)

Abstract: In order to accurately detect edible roses and their maturity in the field and realize the automatic picking of flowering roses, an improved model based on YOLOv5s was proposed to solve the problem of poor recognition accuracy caused by factors such as light and occlusion in the field. The growth state of edible roses at bud, picking and abortive flowering stages was detected. Firstly, in order to enhance the ability of multi-scale feature fusion, the feature fusion structure was improved. Secondly, multi-branch structure training was used to improve the accuracy, and the neck network C3 module was improved. Finally, in order to improve the ability of feature information extraction, a fusion attention module was added to the neck network to make the model focus on the detection target and reduce the false detection and missed detection of roses. The mean average precision of the improved model was 3.6 percentage points higher than that of the original model, reaching 90.4%, and the detection accuracy of roses in three flowering periods was improved. The results of this study provide a more accurate method for detecting edible roses at different flowering stages in unstructured environment.

Key words: object detection;YOLOv5s;feature fusion;attention mechanism;edible roses

玫瑰是一种备受人们青睐的观赏花植物,近年来玫瑰花的食用及药用价值受到人们的关注。玫瑰花产业发展迅速,玫瑰鲜花饼、花茶、精油等玫瑰花产品深受消费者欢迎[1]。墨红玫瑰是常见的可食用玫瑰品种,墨红玫瑰株高约56 cm,植株较矮,花期短,采摘时效性强,需要短时间投入大量劳动力进行采摘。目前玫瑰花采摘仍然采用人工方式,相较于机械采摘费时费力[2],且采摘效率易受天气影响。随着中国食用玫瑰花产业的发展壮大,建立高准确率的食用玫瑰花检测方法对于确定不同花期玫瑰的分布区域、检测玫瑰的花期具有重要意义。

针对非结构环境下作物识别问题,国内外开展了广泛的研究。传统的图像处理算法普遍采用颜色、纹理和边缘等特征识别作物。陈礼鹏[3]以果萼作为识别特征点,采用基于R-G的猕猴桃多目标果实识别方法对果实进行检测;吴超[4]对玫瑰鲜切花的俯拍及侧拍图像进行边缘提取,并结合支持向量机对玫瑰鲜切花品质进行分级预测;Shao等[5]利用高光谱成像技术对3个不同生长阶段的草莓进行图像采集,通过支持向量机结合自适应加权采样方法评估草莓成熟度。近年来,研究学者将深度学习应用于作物的识别和定位中。Chao等[6]利用改进的YOLOv4模型检测非结构化环境中茶菊的生长时期,在颈部网络中融合CSPResNeXt等模块改进YOLOv4模型,对茶菊萌芽期、开花早期和盛开期检测的平均精度达到89.53%。王小荣等[7]为识别复杂环境下的红花,在YOLOv7检测模型中引入Transformer注意力机制以提高模型的检测精度,检测精确度(mAP)达到88.5%。王彦钧[8]为更好地识别玫瑰花,将人工神经网络结合纹理特征识别方方法对食用玫瑰进行识别检测,准确率达到85%,但该方法对光线不敏感。张振国等[9]为解决复杂环境下红花丝的检测精度较差问题,引入GhostNet结构,并将CBAM注意力模块融入特征金字塔结构,关注重要特征的同时弱化背景、枝叶等干扰特征,提高模型的检测性能。龚惟新等[10]为提高猕猴桃花朵的检测精度,在YOLOv5检测模型中引入C3HB和注意力模块,使模型轻量化。顾满局[11]在实验室黑色背景下拍摄获得图像数据集,对图像进行预处理后采用Resnet50模型对俯视角度的玫瑰鲜切花分级,准确率达到91%。

针对食用玫瑰花采摘的检测方法较少,目前相关研究主要在实验室中进行,这些检测方法在田间的检测效果较差。墨红玫瑰同一枝干上存在多朵玫瑰,彼此之间往往会互相遮挡。田间环境下,玫瑰花成熟度与图像采集效果受光照等因素的影响较大,每朵玫瑰成熟度不一致,使得尺度变化较大。这些问题都会导致YOLOv5模型对被遮挡玫瑰的检测能力较差,造成误检、漏检等。基于以上问题,本研究建立非结构环境下的食用玫瑰花数据集,以YOLOv5s为基础网络模型,根据食用玫瑰实际种植中存在的问题对模型进行改进,为快速、精确识别可食用玫瑰花提供理论依据。

1 材料与方法

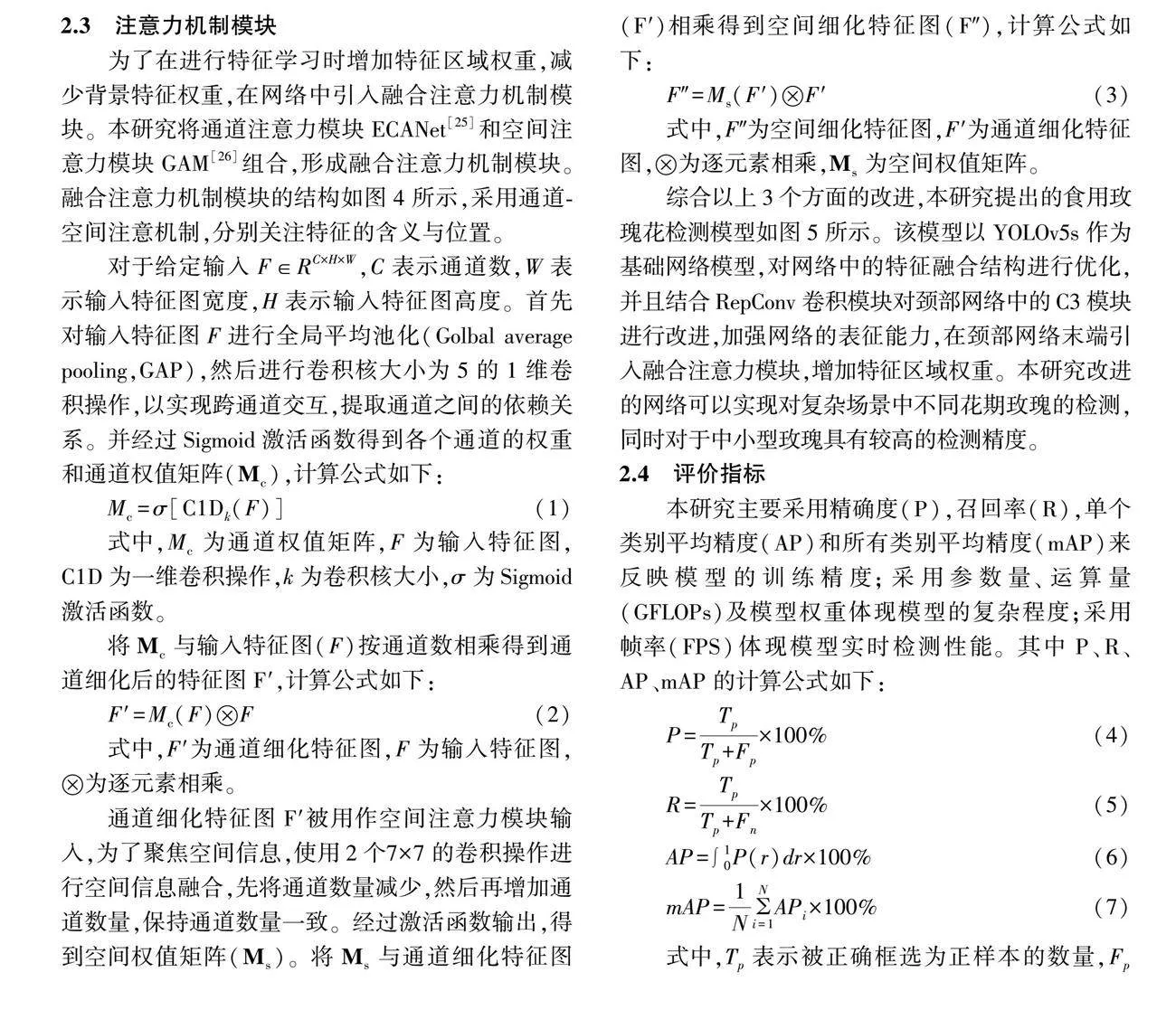

1.1 数据采集与数据集制作

本试验以墨红玫瑰花为研究对象,数据集拍摄于江苏省宜兴市美栖花田(北纬31°23′57″,东经119°39′40″),花田面积约40 hm2。数据采集时间为2022年9月下旬至10月上旬每天的9:00-16:00,图像采集设备为SONYDSC-W830。为识别田间非结构环境下不同花期的食用玫瑰花,在不同时间和角度拍摄玫瑰花照片1 600张,部分食用玫瑰花照片如图1所示。

通过图片标注工具LabelImg对数据集中的食用玫瑰花图像进行标注,用矩形选取框将图像中的玫瑰花框出。根据采收决策,按照花蕾期(CF)、采摘期(PF)、败花期(WF)对样本进行分类及标注,保存标注信息为txt格式,并将3个花期的玫瑰花图像划分为训练集、测试集和验证集,三者按8∶1∶1比例分配。

1.2 YOLOv5网络模型

随着目标检测模型的不断发展,目前基于深度学习的目标检测方法已经有RCNN[12]、SSD[13]、RetinaNet[14]和YOLO系列等。与YOLOv4相比,YOLOv5的检测精度和推理速度较好,目前已大量应用在农业领域[15-16]。近年来,YOLO系列更新较快,现在已有YOLOv7[17]、YOLOv8等版本[18]。YOLOv5模型主要包括主干网络、颈部网络和预测层3个部分。主干网络选用基于CSPDarkNet53结构的骨干网络对图像特征进行特征提取。颈部网络通过特征金字塔网络(Feature pyramid networks,FPN)[19]和路径聚合网络(Path aggregation network,PAN)[20]连接主干网络与预测层,对特征信息进行多层级的特征融合,提高网络对不同特征层的识别能力。预测层对不同维度的特征进行预测,得到预测结果。

2 改进的食用玫瑰花检测模型

2.1 特征融合结构改进

在卷积神经网络中,高层特征也指语义特征,经过多次卷积后从而具有更强的语义信息,包含丰富的组合信息,但其分辨率较低[21]。低层特征主要指纹理、颜色和形状等特征,往往具有更高的分辨率,因此目标位置信息较为准确,可以较好反映图像的内容。对食用玫瑰花数据集进行分析,发现图像中需要识别的玫瑰花尺寸不一,不少玫瑰花尺寸较小。为了提高食用玫瑰花检测模型的性能,将部分低层特征与高层特征进行融合,使其具有更强的语义信息和对细节的感知能力。

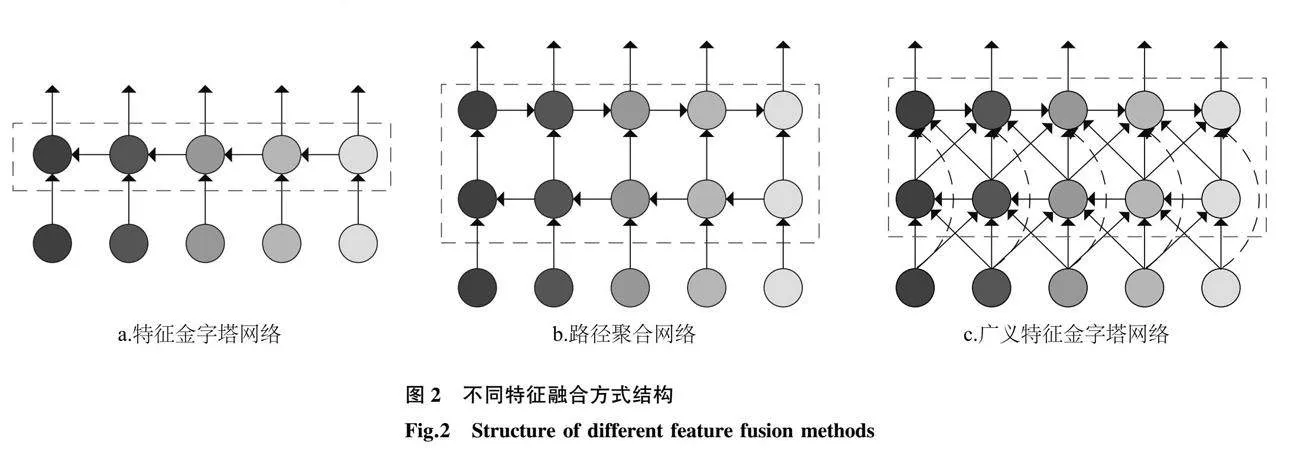

传统的特征金字塔网络采用自上而下的路径实现多尺度特征的融合,如图2所示,路径聚合网络在FPN的基础上额外增加了一个自下而上的路径,而广义特征金字塔网络(Generalized feature pyramid network, GFPN)设计了一种新的路径融合,利用Queen-Fusion[22]接收来自斜上方和斜下方节点的信息,通过跨层和跨尺度连接操作,充分发挥高层语义信息与低层空间信息之间的交换作用,虽然采用这种方式可以增强特征交互,但也增加了许多额外的上采样和下采样操作。使用Concat方法合并特征通道,可以有效避免特征信息的丢失,使模型在检测不同尺寸的物体时具有更好的性能。

考虑到实时检测模型的要求,移除Queen-Fusion中部分上采样操作,将颈部和骨干网络不同尺度的特征信息相融合,实现多尺度特征融合,以提高检测精度。

2.2 颈部网络改进

使用CSPStage结构[23]进行特征融合,代替基于3×3卷积的特征融合方式,提高模型的表征能力,融合更加丰富的梯度信息。

CSPStage模块主要由卷积模块(Conv)和基础模块(BasicBolck)组成。BasicBolck模块由重参数化卷积(RepConv 3×3)和3×3卷积(Conv3×3)组成,其中RepConv[24]在3×3卷积基础上额外添加了并行的1个1×1卷积(Conv1×1)和一个BN(Batch normalization)层,在训练时采用多路径拓扑,在推理时将多分支融合在一起,从而减少了推理时间,并且具备了多分支的优点,增加模型的表征能力,融合更加丰富的梯度信息。

如图3所示,将前置层的信息作为输入初始特征信息,首先将输入特征分配到2条分支中,利用包含卷积和BasicBlock模块的下分支和独立卷积模块的上分支进行特征提取,最后使用特征融合方式Concat将两个分支的特征信息合并,得到最终的输出结果。

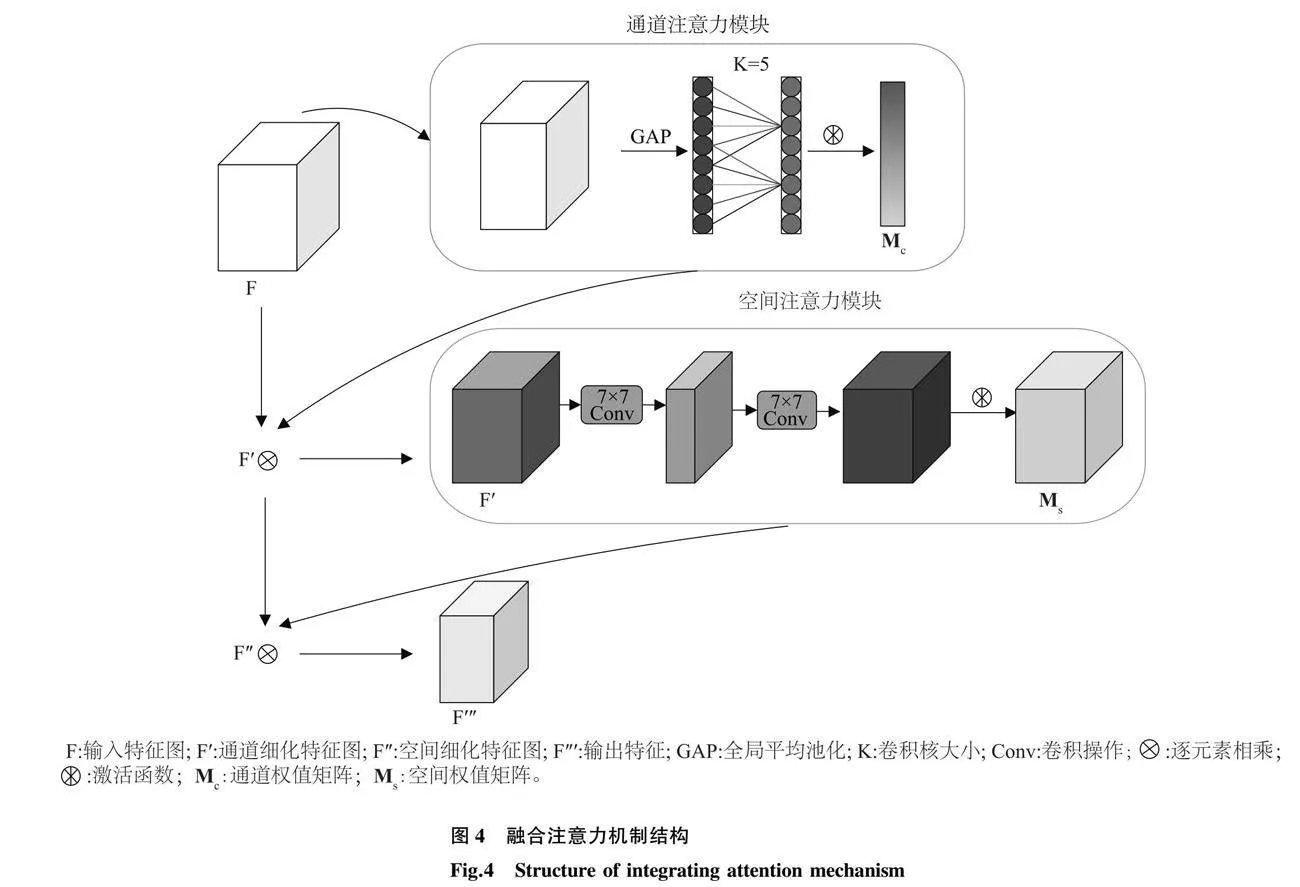

2.3 注意力机制模块

为了在进行特征学习时增加特征区域权重,减少背景特征权重,在网络中引入融合注意力机制模块。本研究将通道注意力模块ECANet[25]和空间注意力模块GAM[26]组合,形成融合注意力机制模块。融合注意力机制模块的结构如图4所示,采用通道-空间注意机制,分别关注特征的含义与位置。

对于给定输入F∈RC×H×W,C表示通道数,W表示输入特征图宽度,H表示输入特征图高度。首先对输入特征图F进行全局平均池化(Golbal average pooling,GAP),然后进行卷积核大小为5的1维卷积操作,以实现跨通道交互,提取通道之间的依赖关系。并经过Sigmoid激活函数得到各个通道的权重和通道权值矩阵(Mc),计算公式如下:

Mc=σ[C1Dk(F)](1)

式中,Mc为通道权值矩阵,F为输入特征图,C1D为一维卷积操作,k为卷积核大小,σ为Sigmoid激活函数。

将Mc与输入特征图(F)按通道数相乘得到通道细化后的特征图F′,计算公式如下:

F′=Mc(F)F(2)

式中,F′为通道细化特征图,F为输入特征图,为逐元素相乘。

通道细化特征图F′被用作空间注意力模块输入,为了聚焦空间信息,使用2个7×7的卷积操作进行空间信息融合,先将通道数量减少,然后再增加通道数量,保持通道数量一致。经过激活函数输出,得到空间权值矩阵(Ms)。将Ms与通道细化特征图(F′)相乘得到空间细化特征图(F″),计算公式如下:

F″=Ms(F′)F′(3)

式中,F″为空间细化特征图,F′为通道细化特征图,为逐元素相乘,Ms为空间权值矩阵。

综合以上3个方面的改进,本研究提出的食用玫瑰花检测模型如图5所示。该模型以YOLOv5s作为基础网络模型,对网络中的特征融合结构进行优化,并且结合RepConv卷积模块对颈部网络中的C3模块进行改进,加强网络的表征能力,在颈部网络末端引入融合注意力模块,增加特征区域权重。本研究改进的网络可以实现对复杂场景中不同花期玫瑰的检测,同时对于中小型玫瑰具有较高的检测精度。

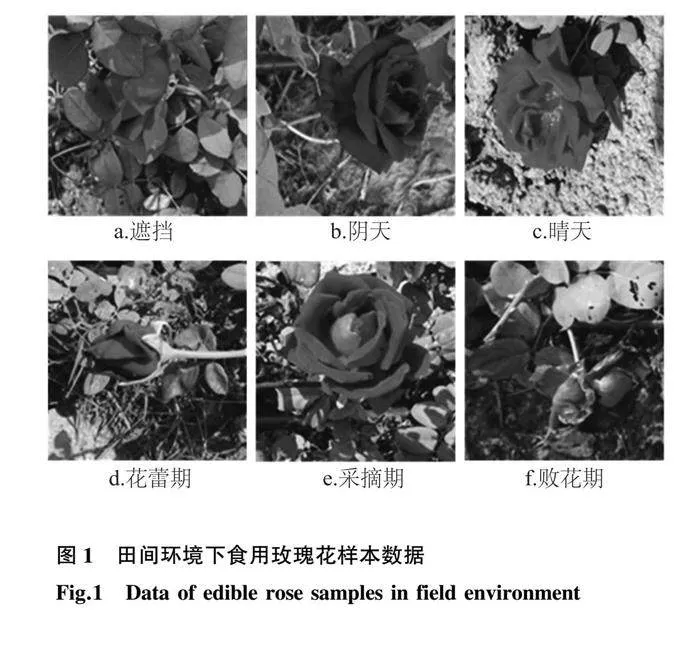

2.4 评价指标

本研究主要采用精确度(P),召回率(R),单个类别平均精度(AP)和所有类别平均精度(mAP)来反映模型的训练精度;采用参数量、运算量(GFLOPs)及模型权重体现模型的复杂程度;采用帧率(FPS)体现模型实时检测性能。其中P、R、AP、mAP的计算公式如下:

P=TpTp+Fp×100%(4)

R=TpTp+Fn×100%(5)

AP=∫10P(r)dr×100%(6)

mAP=1NNi=1APi×100%(7)

式中,Tp表示被正确框选为正样本的数量,Fp表示被错误框选为正样本的数量,Fn表示正样本被错误框选为负样本的数量,N表示玫瑰样本类别数。

Backbone:主干网络;Neck:颈部网络;Head:预测网络;Input:输入;Conv:卷积;SPPF:空间金字塔池化结构;Upsample:上采样操作;Concat:特征融合方式;Attention Model:融合注意力机制模块。CBS:激活函数为SiLU的卷积模块;C3:CSP架构的3卷积模块;CSPStage:改进后的C3模块。

2.5 试验环境与参数设置

试验的运行环境是64位Ubuntu 20.04 LTS操作系统,CPU为AMD EPYC 7232P 8-Core Processor,GPU为NVIDIA GeForce RTX 3090,数量为2。采用基于Pytorch的深度学习框架进行训练,网络模型以Python3.8.10编程语言实现,软件平台为Visual Studio Code,搭配环境CUDA11.0、Cudnn8005。

初始化学习率设置为0.01,动量参数设置为0.937,批量大小设置为32,总迭代次数设置为300次,权重衰退系数设置为0.1,设置图片标准尺寸为640×640像素。

3 结果与分析

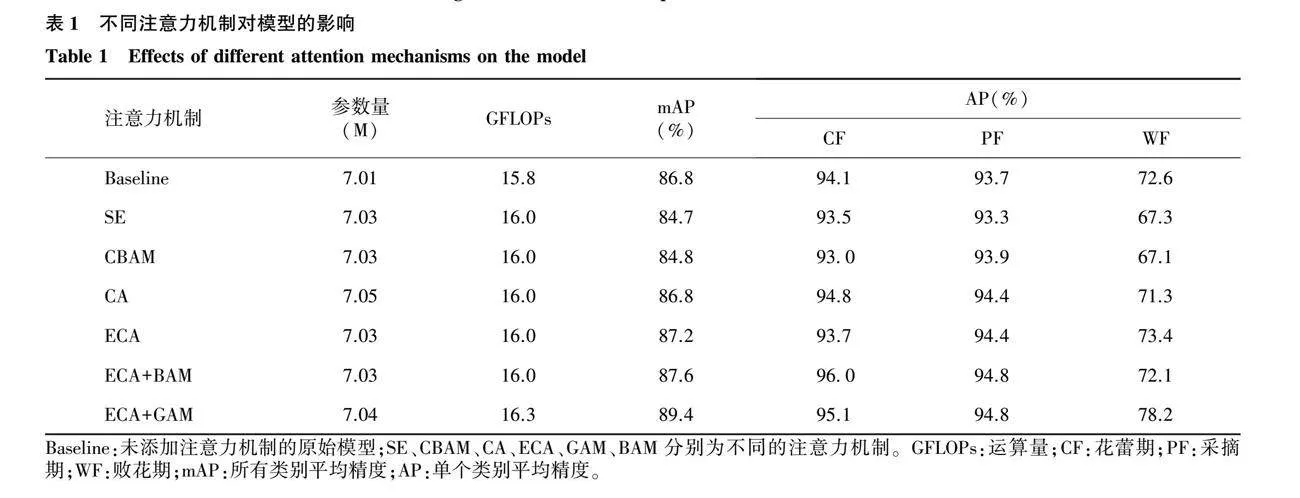

3.1 不同注意力机制对模型的影响

为验证引入的注意力机制对模型的影响,将SE(Squeeze-and-excitation)、CBAM(Convolutional block attention module)、ECA(Efficient channel attention)和CA(Channel attention),GAM(Global attention mechanism)等不同注意力机制添加到模型中展开试验,试验结果如表1所示。

由表1可知,添加不同注意力机制使模型运算量增加;添加SE[27]和CBAM[28]注意力机制都会使模型的总体检测精度下降,因此不考虑使用;添加CA[29]和ECA注意力机制提高了模型对采摘期玫瑰花的检测精度,检测精度提升了0.7个百分点,但是添加CA注意力机制的模型对败花期玫瑰花和添加ECA注意力机制的模型对花蕾期玫瑰花的检测精度降低;由于ECA注意力机制带来的总体性能提升更显著,将其作为融合注意力机制模块的通道注意力组成部分,经对比发现,添加ECA+BAM注意力机制的模型对采摘期玫瑰花的识别精度与添加ECA+GAM注意力机制的模型一致,达到94.8%,相较于原模型提升了1.1个百分点,对于花蕾期的花朵识别精度比添加ECA+GAM的模型提升了0.9个百分点,但是对败花期的花朵识别精度降低了6.1个百分点。

仅考虑注意力机制的影响,添加融合注意力机制比添加CA等单一注意力机制在所有类别平均精度上更具优势,添加至模型后并没有带来更多的运行负担。并且相较于部分单一注意力机制只关注通道或空间注意力,本研究的ECA+GAM融合注意力机制采用顺序结构,兼顾通道和空间注意力。综合衡量各项精度和参数量,添加ECA+GAM融合注意力机制提升效果更加明显,可有效提高模型特征提取能力。

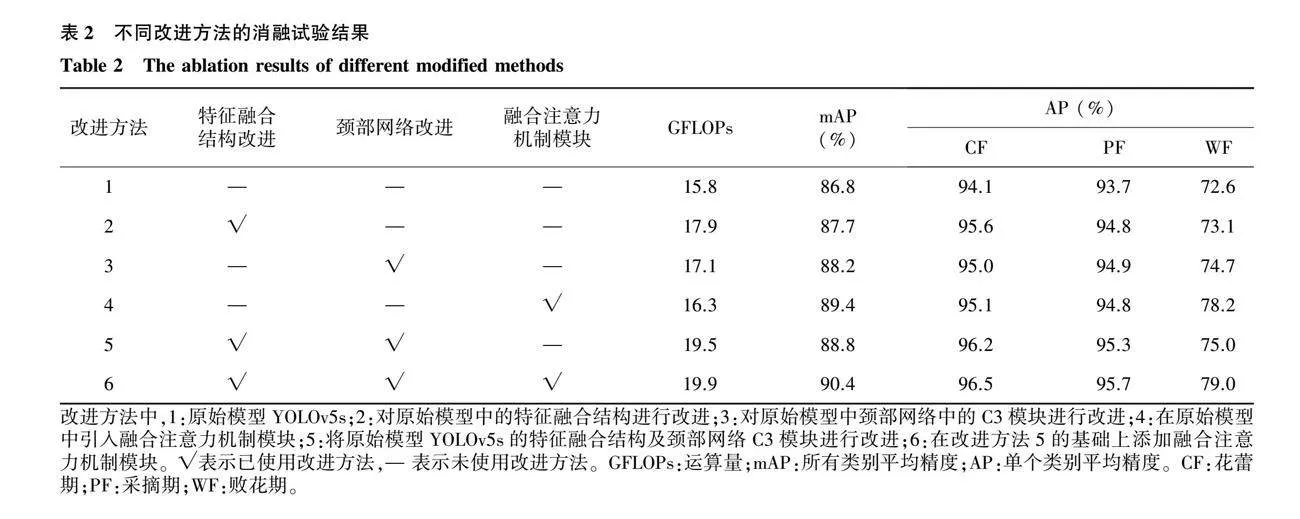

3.2 不同改进方法对模型性能的影响

为验证上述改进后的模型在复杂背景下对食用玫瑰花采摘识别的优化效果,使用原始模型与改进后的模型在数据集上进行训练,进行了一系列消融试验,使用改进方法用“√”表示,未使用改进方法用“—”表示,试验结果见表2。

根据表2可知,改进方法2针对制作的玫瑰花数据中存在中小型目标较多的特点,采用多尺度特征融合,将更多低层特征与高层特征进行融合,从而提高模型的特征提取能力,使得改进后的模型相较于原模型mAP提升了0.9个百分点,对3个花期玫瑰的识别都有提升效果,其中对花蕾期花朵单个类别平均精度提高了1.5个百分点;改进方法3使用CSPStage结构替代原有C3模块后,在训练时候采用多路径拓扑,具有多分支的优点,使模型能够更加关注玫瑰花的特征,mAP达到88.2%;改进方法4为在原始模型中引入融合注意力机制模块,具有空间注意力和通道注意力的优势,增加特征区域权重,减少背景特征权重,提高了对败花期玫瑰花的检测精度,相较于原模型提升了5.6个百分点,并且总体类别平均精度达到89.4%。改进方法5为将YOLOv5s的特征融合结构及颈部网络C3模块进行改进,总体类别平均精度达到88.8%,改进方法6为在改进方法5的基础上添加融合注意力机制模块,在满足实时检测需求的情况下增加一定的参数量,使检测精度较大提升,改进后总体类别平均精度达到90.4%,较原始模型提升了3.6个百分点,其中,对于花蕾期、采摘期、败花期的玫瑰花单个类别平均精度分别提高了2.4个百分点、2.0个百分点、6.4个百分点,有效提高了模型对食用玫瑰识别的精度。

3.3 不同检测模型的检测效果

为了对改进后的网络模型与现有不同模型进行对比,分析不同模型的性能,探究本研究改进模型的优越性,采用mAP和帧率以及模型体积为指标,选择目前主流的目标检测模型Faster R-CNN、YOLO系列等进行对比分析。由表3可知,两阶段检测模型的检测速度较慢,不适用于实时检测。而在与一阶段检测模型的对比中,本研究改进后的模型在检测目标物体时相比于YOLOv4、YOLOv5s、YOLOv7所有类别平均精度分别提升了7.3个百分点、3.6个百分点、2.3个百分点,具有更好的检测性能。本研究改进后的模型使得检测精度得到较大提升,模型体积和检测速率仍能够满足实时检测需要,与其他模型相比,在检测速度方面具有一定优势,具有较好的综合性能。

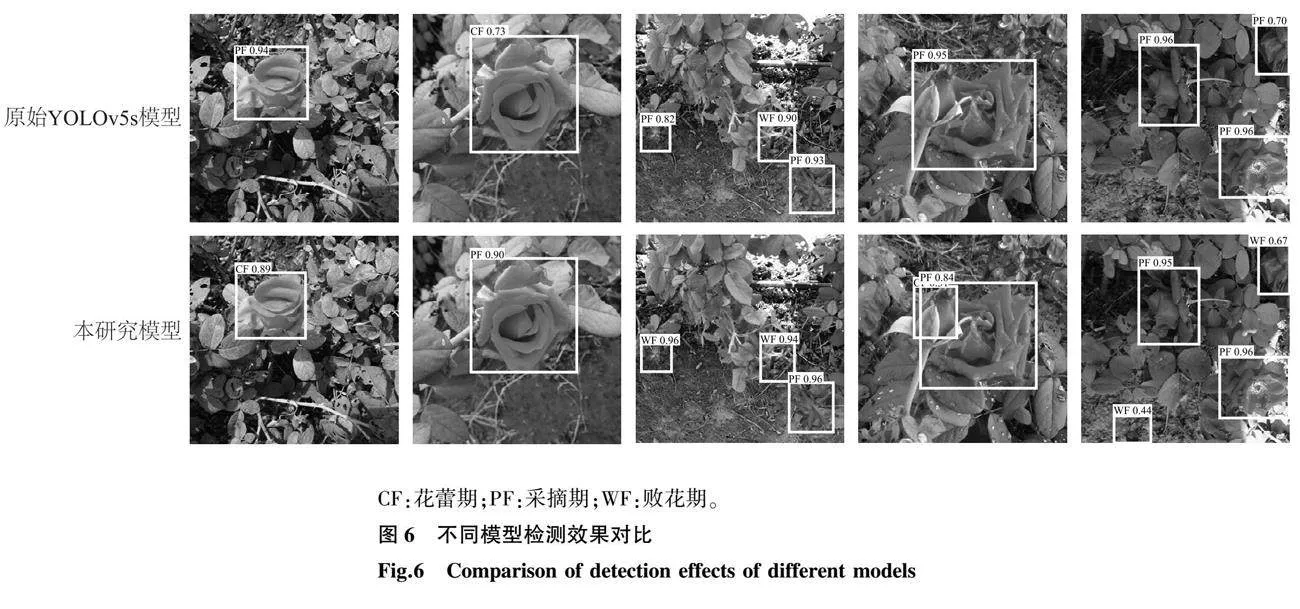

为了进一步比较改进后的模型与其他模型的检测效果差异,分别对测试集进行检测,检测效果如图6所示。改进后的模型识别效果更佳,能够减少相似背景的影响,能够更加有效地识别出不同花期玫瑰花的位置,并且对重叠目标的识别能力更强。改进后的模型漏检、误检现象减少,对不同尺度的玫瑰花检测效果更好,提升模型检测置信度。

4 结论

针对非结构化环境下现有检测模型对不同花期玫瑰花识别准确率低、鲁棒性差等问题,本研究以YOLOv5s为基础模型,将主干网络与颈部网络的特征图进行跨层连接,同时进行多尺度特征融合,使特征提取能力提升,使用改进的CSPStage模块对颈部网络进行优化,可以在提高精度的同时加快检测速率,并将融合卷积注意力模块添加到Neck网络中,采用通道空间顺序结构,提取更全面的有效特征,加强关键信息的提取,提高检测精度。根据实际种植环境,本研究制作了不同自然场景下的不同花期食用玫瑰花数据集用于模型的训练、验证和测试,并分别与Faster R-CNN、YOLOv4、YOLOv5s和YOLOv7等模型进行对比,结果表明,本研究提出的改进后的模型较原模型对于花蕾期、采摘期、败花期的玫瑰花单个类别平均精度分别提高了2.4个百分点、2.0个百分点、6.4个百分点。改进后的模型复杂度提高,但检测速率仍能达到每秒95.2帧,仍满足实时识别的要求。

本研究所提出的检测模型能够在复杂环境下识别出不同生长状态下的玫瑰花,减少光照以及叶片或其他花朵遮挡等问题对检测效果的影响,使采摘机器人能够更好地完成精准识别任务,为智能化采摘和科学管理提供技术支撑。

参考文献:

[1] 谢丽美,晏慧君,唐开学,等. 云南4个主栽食用玫瑰品种产量评价及营养成分分析[J]. 西南农业学报,2022,35(11):2627-2632.

[2] 董万鹏,吴 楠,吴洪娥,等. 不同食用玫瑰生长特性、花品质及生理变化特征[J]. 热带农业科学,2020,40(8):6-11.

[3] 陈礼鹏. 基于机器视觉的簇生猕猴桃果实多目标识别方法研究[D]. 杨凌:西北农林科技大学,2018.

[4] 吴 超. 基于计算机视觉的玫瑰鲜切花质量分级评价[D]. 昆明:昆明理工大学,2020.

[5] SHAO Y, WANG Y, XUAN G, et al. Assessment of strawberry ripeness using hyperspectral imaging[J]. Analytical Letters,2020,54(10):1547-1560.

[6] CHAO Q, NYALALA I, CHEN K J. Detecting the early flowering stage of tea chrysanthemum using the F-YOLO model[J]. Agronomy,2021,11(5):834.

[7] 王小荣,许 燕,周建平,等. 基于改进YOLOv7的复杂环境下红花采摘识别[J]. 农业工程学报,2023,39(6):169-176.

[8] 王彦钧. 食用玫瑰花采摘机器人研究[D]. 昆明:昆明理工大学,2015.

[9] 张振国,邢振宇,赵敏义,等. 改进YOLOv3的复杂环境下红花丝检测方法[J]. 农业工程学报,2023,39(3):162-170.

[10]龚惟新,杨 珍,李 凯,等. 基于改进YOLOv5s的自然环境下猕猴桃花朵检测方法[J]. 农业工程学报,2023,39(6):177-185.

[11]顾满局. 基于机器视觉的玫瑰鲜切花花形分类研究[D]. 昆明:昆明理工大学,2023.

[12]REN S, HE K, GIRSHICK R, et al. Faster R-CNN:towards realtime object detection with region proposal networks[J]. Advances in Neural Information Processing Systems,2015,28:91-99.

[13]LIU W, ANGUELOV D, ERHAN D, et al. SSD:single shot multibox detector[C]//EUROPEAN CONFERENCE ON COMPUTER VISION. Computer vision-ECCV 2016:14th european conference. Amsterdam,Netherlands:Springer International Publishing,2016.

[14]LIN T Y, GOYAL P, GIRSHICK R, et al. Focal loss for dense object detection[C]// IEEE. 2017 IEEE international conference on computer vision. Venice,Italy:IEEE,2017.

[15]魏天宇,柳天虹,张善文,等. 基于改进YOLOv5s的辣椒采摘机器人识别定位方法[J]. 扬州大学学报(自然科学版),2023,26(1):61-69.

[16]邢洁洁,谢定进,杨然兵,等. 基于YOLOv5s的农田垃圾轻量化检测方法[J]. 农业工程学报,2022,38(19):153-161.

[17]王金鹏,周佳良,张跃跃,等. 基于优选 YOLOv7模型的采摘机器人多姿态火龙果检测系统[J]. 农业工程学报,2023,39(8):276-283.

[18]JIANG T, CHEN S. A lightweight forest pest image recognition model based on improved YOLOv8[J]. Applied Sciences,2024,14(5):1941.

[19]LIN T, DOLLAR P, GIRSHICK R, et al. Feature pyramid networks for object detection[C]//IEEE. 2017 IEEE conference on computer vision and pattern recognition. Honolulu,HI,USA:IEEE,2017.

[20]LIU S, QI L, QIN H, et al. Path aggregation network for instance segmentation[C]//IEEE/CVF. 2018 IEEE/CVF conference on computer vision and pattern recognition. Salt Lake City,UT,USA:IEEE,2018.

[21]杨其晟,李文宽,杨晓峰,等. 改进YOLOv5的苹果花生长状态检测方法[J]. 计算机工程与应用,2022,58(4):237-246.

[22]JIANG Y Q, TAN Z Y, WANG J Y, et al. A heavy-neck paradigm for object detection[C]//INTERNATIONAL CONFERENCE ON LEARNING REPRESENTATIONS. The tenth international conference on learning representations. Vienna,Austria:ICLR,2021.

[23]陈范凯,李士心. 改进Yolov5的无人机目标检测算法[J]. 计算机工程与应用,2023,59(18):218-225.

[24]DING X, ZHANG X, MA N, et al. RepVGG:making vgg-style convnets great again[C]//IEEE/CVF. 2021 IEEE/CVF conference on computer vision and pattern recognition. Nashville,TN,USA:IEEE,2021.

[25]WANG Q, WU B, ZHU P, et al. ECA-Net:efficient channel attention for deep convolutional neural networks[C]//IEEE/CVF. 2020 IEEE/CVF conference on computer vision and pattern recognition. Seattle,WA,USA:IEEE,2020.

[26]肖粲俊,潘睿志,李 超,等. 基于改进YOLOv5s绝缘子缺陷检测技术研究[J]. 电子测量技术,2022,45(24):137-144.

[27]陈 超,齐 峰. 卷积神经网络的发展及其在计算机视觉领域中的应用综述[J]. 计算机科学,2019,46(3):63-73.

[28]LU S, CHEN W, ZHANG X, et al. Canopy-attention-YOLOv4-based immature/mature apple fruit detection on dense-foliage tree architectures for early crop load estimation[J]. Computers and Electronics in Agriculture,2022,193:106696.

[29]HOU Q, ZHOU D, FENG J. Coordinate attention for efficient mobile network design[C]// IEEE/CVF. 2021 IEEE/CVF conference on computer vision and pattern recognition. Nashville,TN,USA:IEEE,2020.

(责任编辑:成纾寒)