基于类簇合并的无参数密度峰值聚类算法

摘 要: 密度峰值聚类算法(DPC)通过决策图直观地找到类簇中心进而完成聚类,是一种简单高效的聚类算法。然而,DPC算法的截断距离和类簇中心都是人为确定的,受主观影响较大,具有不确定性。针对上述问题,提出一种基于类簇合并的无参数密度峰值聚类算法(NDPCCM)。首先根据样本点两两之间的相似度的分布特征将其分为类内相似度和类间相似度两种类型,并利用类内相似度自动确定截断相似度,避免了人为设置参数;接着根据簇中心权值的下降趋势自动选择初始类簇中心,得到初始类簇;最后通过合并初始类簇对初步聚类结果进行优化,提高了聚类的准确性。在人工数据集和UCI真实数据集上,将所提算法与DPC、DBSCAN、K⁃means算法进行对比实验。结果表明所提算法无需输入参数就能够自动得到类簇,且聚类性能优于其他算法。

关键词: 聚类分析; 密度峰值聚类算法; 初始类簇; 类簇合并; 相似度; 聚类性能

中图分类号: TN929.5⁃34; TP181" " " " " " " " "文献标识码: A" " " " " " " " " " "文章编号: 1004⁃373X(2024)08⁃0001⁃08

Nonparametric density peak clustering algorithm based on clusters merging

LIU Tianjiao, WANG Shengjing, YUAN Yongsheng

(College of Mathematics, Hohai University, Nanjing 211100, China)

Abstract: The density peak clustering algorithm (DPC) is a simple and efficient clustering algorithm that can intuitively find the cluster centers by a decision graph and complete clustering. However, the cutoff distance and cluster centers of the DPC algorithm are both determined artificially and subject to significant subjective influence, resulting in uncertainty. To address the above issues, a nonparametric density peak clustering algorithm based on clusters merging (NDPCCM) is proposed. Based on the distribution characteristics of pairwise similarities among sample points, they are divided into intra⁃class similarity and inter⁃class similarity, and the cutoff similarity is determined automatically by means of intra⁃class similarity to avoid manually setting parameters. Based on the decreasing trend of the cluster center weights, the initial cluster centers are selected automatically to obtain the initial clusters. The initial clustering results are optimized by merging the initial clusters, which can improve the accuracy of clustering. The comparative experiments were conducted between the proposed algorithm and" DPC, DBSCAN, and K⁃means algorithms on both artificial and UCI real datasets. The results show that the proposed algorithm does not require input parameters and can automatically obtain clusters, with better clustering performance than other algorithms.

Keywords: cluster analysis; density peak clustering algorithm; initial cluster; cluster merging; similarity; clustering performance

0" 引" 言

聚类分析是一种重要的无监督学习方法,在生物信息学、模式识别、图像处理等领域有着广泛的应用[1⁃4]。密度峰值聚类(Density Peak Clustering, DPC)算法是2014年由A. Rodriguez等人提出的一种密度聚类算法[5]。该算法能够实现任意形状数据集的聚类,根据决策图直观产生类簇中心,从而确定簇的数量,并具有高效的样本点分配策略。相较于传统的聚类算法,该算法使用简单、参数少且在许多数据集上表现良好,因而受到了广泛关注。然而,DPC算法的截断距离依靠主观经验选取,类簇中心根据决策图人工选择,这些主观性因素给最终的聚类结果带来了不确定性。

针对DPC算法自身存在的一些局限性,一部分学者从局部密度的衡量方面展开了相关研究。Du M J等人将K近邻的思想引入到局部密度的计算中,优化了样本局部密度的度量,取得了较好的性能[6]。但是该算法需要输入参数,并且仍然需要人工选择类簇中心。R. Mehmood等人通过热扩散方法使用核密度估计来计算样本点的密度,同时考虑了截断距离的选择和核密度估计的边界修正,获得了更精确的类簇,具有鲁棒性和有效性,但是仍需要人工参与来选择簇的数目[7]。Liu R等人使用共享近邻信息定义样本之间的相似度,基于该相似度重新定义局部密度,并提出两步分配策略来分配非聚类中心,避免了一步分配策略带来的连带错误,但是类簇中心的选取仍然具有人为主观性[8]。丁世飞等人利用基于块的不相似性度量计算样本之间的相似度,再根据样本的K近邻重新定义局部密度,可以更高效地处理复杂数据[9],但是引入了新的参数K。章曼等人使用非参数核密度估计方法估计样本局部密度,并计算自适应可达距离来对非中心点进行分配,提高了DPC算法的聚类效果,但是引入了参数半径调节系数[10]。位雅等人利用样本自然最近邻域内的样本信息来计算样本局部密度以及相对密度,对选出的聚类中心计算其聚类距离,根据聚类距离分配剩余点,能有效地处理密度不均匀数据集的聚类问题。但是该算法聚类效果依赖于距离调节系数,并且仍需要人工选取类簇中心[11]。

另有部分学者从类簇中心的自适应选取方面进行了相关研究。R. F. Bie等人利用模糊规则自适应地进行聚类中心的选择,接着基于截断距离将部分类簇合并得到最终类簇。该算法对于静态数据具有有效性和稳健性,但是存在截断距离的合理选取问题[12]。Liang Z等人基于分治策略和密度可达概念,递归地找到正确的类簇数量,但是仍然需要输入参数截断距离[13]。马春来等人将簇中心权值按降序排列,选择下降趋势由急变缓的“拐点”之前的点作为类簇中心,自适应地完成聚类过程,但是仍需要根据主观经验确定截断距离[14]。王万良等人分别通过切比雪夫不等式和标准差确定归一化后的密度和距离的阈值,以及簇中心权值的阈值,自动选取相关指标大于阈值的点作为簇中心,但是切比雪夫不等式中[ε]的选取会影响聚类效果[15]。徐童童等人使用共享近邻定义样本之间的相似度以及局部密度,对簇中心权值进行函数变换,然后根据决策函数自适应地选取潜在聚类中心,最后经过筛选自动得到最终聚类中心,但是引入了样本近邻数[16]。Ding S F等人使用分层加权自然邻域集来计算局部密度,并提出一个子簇合并策略自适应地获取最优类簇数,有效地消除了截断距离对聚类结果的影响,但是层数参数是人工直接选取的[17]。

综上所述,现有的改进方法中,存在参数或者类簇中心需要人工选择的问题,算法无法完全自适应完成。为此,本文提出一种基于类簇合并的无参数密度峰值聚类算法(Nonparametric Density Peak Clustering Algorithm Based on Clusters Merging, NDPCCM)。NDPCCM算法首先根据样本点两两之间相似度的分布特征自动确定截断相似度,避免了人为设置参数影响聚类结果;其次,为了避免人工漏选类簇中心,根据簇中心权值的下降趋势自动选取初始类簇中心,并完成分配得到初始类簇;最后,为防止一个类簇中的样本点因选出多个类簇中心而被分为多个类簇,对初始聚类结果进行优化,将初始类簇合并得到最终类簇。

1" DPC算法及其缺陷分析

DPC算法基于两个基本假设确定类簇中心:

1) 类簇中心被局部密度更低的近邻样本点包围;

2) 类簇中心与局部密度更高的样本点的距离相对较大。

设有数据集[X=x1,x2,…,xN],其中[xi=xi1,xi2,…,xid,i=1,2,…,N],表示一个样本点,[N]为数据集样本点总数,[d]为样本点维数。对数据集中任意一个样本点[xi],DPC算法分别计算其局部密度[ρi],以及与更高密度的最近点之间的距离[δi]。样本点[xi]的局部密度[ρi]有两种计算方法,一种使用截断核计算,结果为离散值,公式如下:

[ρi=i≠jχdij-dc] (1)

式中:[χx]是指示函数,当[xlt;0]时,[χx=1];否则[χx=0]。另一种使用高斯核计算,结果为连续值,公式为:

[ρi=i≠jexp-dijdc2] (2)

式中:[dij]为样本点[xi]和[xj]之间的欧氏距离;[dc]为截断距离参数,一般取所有样本点两两之间的距离值升序排列的1%~2%处的值[8]。

通过计算样本点[xi]与其他局部密度更高的点之间的最小距离得到[δi]:

[δi=minj:ρjgt;ρidij] (3)

对于密度最高的点,一般取[δi=maxjdij]。

接着,DPC算法以[ρi]为横坐标,[δi]为纵坐标绘制决策图,根据决策图直观地选取[ρi]和[δi]值较大的样本点作为类簇中心;或者定义簇中心权值为[γi=ρi×δi],选取[γ]值较大的样本点作为类簇中心。最后,将非类簇中心样本点分配到距离其最近的密度更高点所属类簇。

DPC算法不需要预先确定类簇个数,在许多数据集上聚类效果良好,但是截断距离的确定带有主观经验, 影响类簇中心的准确选择。若截断距离较大, 则可能选取到少于真实个数的类簇中心;若截断距离较小,则可能选取到多于真实个数的类簇中心。并且类簇中心的选取不是自适应的,而是根据决策图人工选取的,可能会造成聚类中心的误选。

图1所示为DPC算法在Aggregation数据集上的决策图和簇中心权值降序排列图。Aggregation数据集共有7个类别,可以看出,在没有任何先验信息的情况下,仅通过决策图难以准确地选出7个类簇中心,可能会漏选或者多选,从而影响聚类效果。

2" 基于类簇合并的无参数密度峰值聚类算法(NDPCCM)

DPC算法的截断距离值直接影响样本局部密度的度量,类簇中心的选择直接影响最终的聚类结果,而截断距离和类簇中心的选择均受主观影响较大,导致算法的鲁棒性较差。

针对上述问题,NDPCCM算法首先根据样本点的类内相似度自动确定截断相似度,并计算每个样本点的簇中心权值;其次根据簇中心权值的斜率变化自动选择初始类簇中心,得到初步聚类结果;最后,合并初始类簇得到更准确的聚类结果。

2.1" 截断相似度的自动选取

样本点之间的相似度可以根据两个样本是否属于同一类别分为类内相似度和类间相似度两种类型。类内相似度值较大,而类间相似度值较小。因此可以根据相似度的分布特征将其分为两类,并利用类内相似度来定义截断相似度,以实现截断相似度的自动选取。

NDPCCM算法首先对样本点之间的欧氏距离进行函数变换,得到样本点之间的相似度;其次使用K⁃means算法将所有样本点两两之间的相似度分为类内相似度和类间相似度两种类型,定义截断相似度为类内相似度的均值;最后使用截断相似度计算样本点的局部密度、相对相似度以及簇中心权值,具体如下:

1) 对于数据集[X],定义样本点[xi]和[xj]之间的相似度[18]为:

[sij=11+d2ij] (4)

式中[dij=k=1dxik-xjk2]为样本点[xi]和[xj]之间的欧氏距离。样本点[xi]和[xj]之间的距离越小,相似度则越大。公式(4)运用函数变换将距离值[dij]映射到区间[(0,1]]上。

2) 使用K⁃means聚类算法将所有相似度值分为两类,其中均值较大的为类内相似度集合,记为[Sintra]。

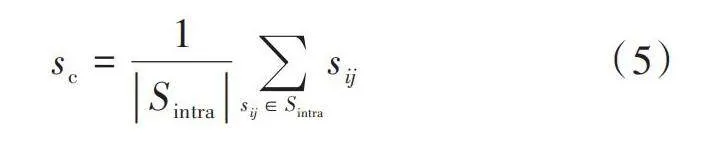

定义1:截断相似度。将类内相似度的均值作为截断相似度[sc],即:

[sc=1Sintrasij∈Sintrasij] (5)

式中[Sintra]表示集合[Sintra]中元素的个数。

3) 利用截断相似度计算样本点[xi]的局部密度[ρi],公式如下:

[ρi=j≠iexpsijsc] (6)

该式表明,当样本点[xi]周围与其相似度大于截断相似度[sc]的点越多,局部密度则越大。

通过样本点的局部密度和相似度计算样本点的相对相似度,公式如下:

[δi=minsij," i=argmaxmρmmaxρjgt;ρisij," i≠argmaxmρm] " "(7)

式(7)即样本点与局部密度更高的样本点之间的最大相似度。当样本点局部密度最大时,其相对相似度为该样本点与其他样本点之间的最小相似度。

4) 计算样本点的簇中心权值。根据DPC算法关于类簇中心的假设,在NDPCCM算法中,具有较高的局部密度[ρ]和较小的相对相似度[δ]的样本点更有可能被选为类簇中心。

首先,为了和局部密度保持一致,利用对数函数对相对相似度进行函数变换,公式如下:

[δ'i=-lg δi] (8)

由[δi]的定义可知,[δi∈0,1],从而[δ'i∈0,+∞],并且当[δi]越小时,[δ'i]越大。因此,[ρi]和[δ'i]都较大的样本点是类簇中心的可能性更大。

其次,为了避免[ρ]和[δ']因量纲不同而对聚类结果产生影响,对[ρ]和[δ']进行归一化处理,分别得到[ρ∗i]和[δ∗i]。最后定义样本点的簇中心权值。

定义2:簇中心权值。计算样本的簇中心权值的公式如下:

[γi=ρ∗i·δ∗i] (9)

根据前文的分析,类簇中心的[γ]值应该相对较大。

2.2" 自动选择初始类簇中心

图2是NDPCCM在Aggregation数据集上的样本[γ]值分割示意图,利用[γ]值的分段线性回归,将样本点分为初始类簇中心和非类簇中心两类。其中空心圆点表示初始类簇中心的[γ]值;空心三角形表示非类簇中心的[γ]值;虚线是对初始类簇中心[γ]值的拟合直线;实线是对非类簇中心[γ]值的拟合直线。根据[γ]值的下降趋势可以将其分为两部分:左边[γ]值较大,下降速度较快;右边[γ]值较小,下降速度较慢。前后两侧[γ]值下降趋势具有明显差异的分界点称为变点,记为[γt]。因此,NDPCCM算法使用分段线性回归分析寻找变点,自动选择初始类簇中心,避免人工选择类簇中心带来的不确定性。

NDPCCM算法首先将[γ]值降序排列得到序列[γ1gt;γ2gt;…gt;γk-1gt;γkgt;γk+1gt;…gt;γN]。依次将每一点[γk(2≤k≤N-1)]作为分界点,得到两个[γ]值序列,即[γ1,γ2,…,γk]和[γk+1,γk+2,…,γN]。

其次,取这两个序列为因变量,对应的自变量分别取[0,1,2,…,k-1]和[k,k+1,…,N-1],分别进行一元线性回归分析,得到两个[γ]值预测序列,即[γ1,γ2,…,γk]和[γ'k+1,γ'k+2,…,γ'N]。

最后计算误差平方和[Ek=i=1kγi-γi2+i=k+1Nγ'i-γi2],于是变点[γt]可以由下式得到:

[t=argmin2≤k≤N-1Ek] (10)

将变点及其之前的点选出作为初始类簇中心。得到初始类簇中心后,根据DPC算法的分配策略,将非类簇中心点分配给与其相似度最大的密度更高点所属类簇,得到初始类簇[P=P1,P2,…,Pt]。

2.3" 初始类簇合并

样本密度不均匀可能会导致同一类簇中出现多个密度峰,进而影响聚类结果。图3是NDPCCM算法在Aggregation数据集上获取的初始类簇,相同数字代表一类。部分原本属于同一类簇的样本点被划分成了几类。因此需要对初始类簇进行合并,优化初始聚类结果,以提高聚类的准确性。

NDPCCM算法将所有的样本点分为边界点和核心点两类,若两个初始类簇之间相似度较大且相似度最大的两个样本点都是核心点,则将这两个初始类簇合并。

首先,NDPCCM算法根据样本点邻居数的多少将其分为核心点和边界点两类。固定一个相似度半径[r],对于每一个样本点,周围与其相似度大于等于[r]的样本点则被称为该样本点的邻居。显然,边界点的邻居数较少,而核心点的邻居数较多。因此可以使用K⁃means算法将样本邻居数降序排列截成两段,截断处即为临界邻居数。邻居数小于该临界值的样本点是边界点,集合记为[Xboundary],反之则为核心点,集合记为[Xcore]。NDPCCM算法在Aggregation上聚类分析图如图4所示。

图4a)所示为Aggregation数据集中边界点示意图,图中一个数字代表一个初始类簇,加粗的为边界点。其中,相似度半径[r]取所有样本点到其他样本点的最大相似度的最小值。并且,为了避免离群点的影响,在计算[r]之前先去除样本中的离群点。定义满足如下条件的点[xi]为离群点[19]:

[ρ∗ilt;μρ∗-σρ∗]

[δ∗igt;μδ∗+σδ∗]

式中:[μ·]和[σ·]分别表示数据的均值和标准差。将离群点的集合记为[Xoutlier],则[r=minxi∈X\Xoutliermaxj≠isij]。

其次,对于初始类簇[Pi]和[Pj],计算两个类簇之间的最大相似度,判断是否需要合并。记两个类簇之间相似度最大的样本分别为[xmi]和[xmj],即[smi,mj=maxsuvxu∈Pi,xv∈Pj]。若最大相似度大于相似度半径[r]且[xmi]和[xmj]均为核心点,则将[Pi]和[Pj]合并,即若满足式(11), 则将这两个初始类簇合并。

[smi,mjgt;r," xmi∈Xcore," xmj∈Xcore] (11)

重复进行上述步骤,直至任意两个类簇都不满足上述条件,得到最终类簇[C=C1,C2,…,Cnc],其中[nc]表示最终类簇个数。图4b)是Aggregation数据集初始类簇合并后的最终聚类结果,一个数字代表一类。可见,初始类簇正确地合并为一个类簇,初始聚类结果得到了优化。

2.4" NDPCCM算法的具体步骤

基于上述分析,NDPCCM算法的具体步骤如下:

输入:数据集[X=x1,x2,…,xN];

输出:聚类结果[C=C1,C2,…,Cnc]。

1) 根据式(4)计算样本点之间的相似度[sij],构造相似度矩阵[S=sij];

2) 将所有的相似度值降序排列,使用K⁃means聚类算法将所有的相似度值分为两类,得到类内相似度集合[Sintra];

3) 根据式(5)~式(7)、式(9)计算截断相似度[sc]、局部密度[ρi]、相对相似度[δ]和簇中心权值[γi];

4) 将簇中心权值[γi]降序排列,从左向右对每个点的左侧和右侧的[γi]值分别进行线性回归分析,根据式(10)得到变点[γt];

5) 将变点及其之前的点选出得到初始类簇中心,并分配非类簇中心点,得到初始类簇[P=P1,P2,…,Pcp];

6) 对任意两个初始类簇[Pi]和[Pj],若满足式(11),则将这两个类簇合并,更新聚类结果;

7) 重复步骤6),直至任意两个类簇都不满足式(11),得到最终类簇[C=C1,C2,…,Cnc]。

3" 实验与结果分析

3.1" 数据集及实验参数设置

为了验证本文提出的NDPCCM算法的性能,在人工数据集和UCI真实数据集上将本文算法与DPC算法、DBSCAN算法以及K⁃means算法进行对比实验。数据集详细信息如表1和表2所示。实验环境为Windows 11 64位操作系统,Intel[Ⓡ] CoreTM i7⁃1360P CPU @ 2.20 GHz处理器,16.0 GB内存,使用Jupyter Notebook编程。

本文采用常用的调整兰德指数(Adjusted Rand Index, ARI)[20]、调整互信息(Adjusted Mutual Information, AMI)[20]以及FM指数(Fowlkes and Mallows Index, FMI)[21]这3个外部评价指标来衡量实验中所使用的聚类算法的聚类性能。ARI的取值范围为[[-1,1]],AMI的取值范围为[[-1,1]],FMI的取值范围为[[0,1]]。3个指标的值越大,表示聚类效果越好。

本文的实验参数设置为:NDPCCM算法无需设置参数;DPC算法的参数[p=2];DBSCAN算法参数为邻域半径[(Eps)∈[0.1,1]],以及最少样本数[(MinPts)∈[2,20]],采用网格搜索方法选取最优值作为最终的实验结果;K⁃means算法的参数[k∈2,35],通过轮廓系数选择参数。

3.2" 实验结果分析

表3给出了NDPCCM算法、DPC算法、DBSCAN算法以及K⁃means算法在6个人工数据集上的3个评价指标(ARI、AMI、FMI)的值以及参数设置,其中加粗字体表示性能最好的实验结果。表4给出了NDPCCM算法、DPC算法、DBSCAN算法以及K⁃means算法在4个真实数据集上的3个评价指标(ARI、AMI、FMI)的值以及参数设置,其中加粗字体表示性能最好的实验结果。

从表中的实验结果可以看出,与其他算法相比,NDPCCM算法在除了Spiral和Breast之外的其他数据集上3个聚类指标都达到了最优。在Spiral数据集上,NDPCCM算法性能仅次于DPC算法;在Breast数据集上,NDPCCM算法AMI和FMI值都达到了最大,ARI值仅次于DBSCAN算法。

通过在人工数据集和UCI真实数据集上的对比实验可以体现本文提出算法的优越性。DPC算法需要人为选择参数和聚类中心;DBSCAN算法对参数敏感;K⁃means算法对于非凸数据的聚类效果较差,并且需要预先确定参数的范围;而NDPCCM算法无需输入参数,自动完成聚类,并且聚类性能更好。

4" 结" 语

本文针对DPC算法中截断距离和聚类中心的人为选择问题, 对DPC算法进行改进, 提出一种基于类簇合并的无参数密度峰值聚类算法(NDPCCM)。该算法首先根据类内相似度自动确定截断相似度,并计算局部密度、相对相似度和簇中心权值;其次根据簇中心权值的下降趋势自动选取初始类簇中心;最后对初始类簇进行优化,得到最终的聚类结果。NDPCCM算法无需输入任何参数, 并且整个聚类过程都是自动完成的。在人工数据集和UCI真实数据集上的实验结果表明,NDPCCM算法取得了优于其他算法的聚类效果,性能稳定,适用于不同类型的数据集。但是在NDPCCM算法中,仍然利用欧氏距离度量相似度,在处理大量数据时,计算复杂度高;面对真实的高维数据集时,性能较差。因此,改进相似度度量和提升NDPCCM对真实复杂的数据集的聚类性能是下一步的研究重点。

注:本文通讯作者为袁永生。

参考文献

[1] BHATTACHARJEE P, MITRA P. A survey of density based clustering algorithms [J]. Frontiers of computer science, 2021, 15(1): 151308.

[2] SI Y Q, LIU P, LI P H, et al. Model⁃based clustering for RNA⁃seq data [J]. Bioinformatics, 2014, 30(2): 197⁃205.

[3] DUCOURNAU A, BRETTO A, RITAL S, et al. A reductive approach to hypergraph clustering: an application to image segmentation [J]. Pattern recognition, 2012, 45(7): 2788⁃2803.

[4] CHAUDHARY C, GOYAL P, TULI S, et al. A novel multi⁃modal clustering framework for images with diverse associ⁃ated text [J]. Multimedia tools and applications, 2019, 78(13): 17623⁃17652.

[5] RODRIGYEZ A, LAIO A. Clustering by fast search and find of density peaks [J]. Science, 2014, 344(6191): 1492⁃1496.

[6] DU M J, DING S F, JIA H J. Study on density peaks clus⁃tering based on K⁃nearest neighbors and principal component analysis [J]. Knowledge⁃based systems, 2016, 99: 135⁃145.

[7] MEHMOOD R, ZHANG G Z, BIE R, et al. Clustering by fast search and find of density peaks via heat diffusion [J]. Neurocomputing, 2016, 208:210⁃217.

[8] LIU R, WANG H, YU X M. Shared⁃nearest⁃neighbor⁃based clustering by fast search and find of density peaks [J]. Information sciences, 2018, 450: 200⁃226.

[9] 丁世飞,徐晓,王艳茹.基于不相似性度量优化的密度峰值聚类算法[J].软件学报,2020,31(11):3321⁃3333.

[10] 章曼,张正军,冯俊淇,等.基于自适应可达距离的密度峰值聚类算法[J].计算机应用,2022,42(6):1914⁃1921.

[11] 位雅,张正军,何凯琳,等.基于相对密度的密度峰值聚类算法[J].计算机工程,2023,49(6):53⁃61.

[12] BIE R F, MEHMOOD R, RUAN S S, et al. Adaptive fuzzy clustering by fast search and find of density peaks [J]. Personal and ubiquitous computing, 2016, 20(5): 785⁃793.

[13] LIANG Z, CHEN P. Delta⁃density based clustering with a divide⁃and⁃conquer strategy: 3DC clustering [J]. Pattern recognition letters, 2016, 73: 52⁃59.

[14] 马春来,单洪,马涛.一种基于簇中心点自动选择策略的密度峰值聚类算法[J].计算机科学,2016,43(7):255⁃258.

[15] 王万良,吴菲,吕闯.自动确定聚类中心的快速搜索和发现密度峰值的聚类算法[J].模式识别与人工智能,2019,32(11):1032⁃1041.

[16] 徐童童,解滨,张喜梅,等.自适应聚类中心策略优化的密度峰值聚类算法[J].计算机工程与应用,2023,59(21):91⁃101.

[17] DING S F, DU W, XU X, et al. An improved density peaks clustering algorithm based on natural neighbor with a merging strategy [J]. Information sciences, 2023, 624: 252⁃276.

[18] 吴润秀,尹士豪,赵嘉,等.基于相对密度估计和多簇合并的密度峰值聚类算法[J].控制与决策,2023,38(4):1047⁃1055.

[19] TONG W N, WANG Y P, LIU D L. An adaptive clustering algorithm based on local⁃density peaks for imbalanced data without parameters [J]. IEEE transactions on knowledge and data engineering, 2023, 35(4): 3419⁃3432.

[20] VINH N X, EPPS J, BAILEY J. Information theoretic measures for clusterings comparison: variants, properties, normalization and correction for chance [J]. The journal of machine learning research, 2010, 11: 2837⁃2854.

[21] FOWLKES E B, MALLOWS C L. A method for comparing two hierarchical clusterings [J]. Journal of the American statistical association, 1983, 78(383): 553⁃569.

作者简介:刘天娇(1998—),女,江苏南通人,硕士研究生,研究方向为统计学习、应用统计。

王胜景(1999—),女,河南驻马店人,硕士研究生,研究方向为统计学习、应用统计。

袁永生(1964—),男,江苏南通人,博士,教授,主要研究方向为数理统计、应用统计。