智能革命与人的素养重构

摘 要:人工智能技术的加速发展引起了有识之士对于人类自身存在价值的怀疑和对于发展前景的忧虑。人工智能时代人类应该拥有什么素养,才能与另一类智能体互补、互促、共生、共荣?对这一教育原点问题,有必要基于技术哲学去分析人工智能技术的实质、局限、发展趋势,并据此建构与之协同创新、共生共荣的素养模型。其中,人机协同素养的核心是能够与当下的机器智能互补且驾驭它完成创新任务的高级智能;人机共生素养的核心则是能够应对近未来机器智能带来的各种人文问题、善于追求并实现共同美好生活的实践智慧。

关键词:人工智能;AI;人机协同;人机共生;技术哲学

一、问题提出

人类社会正在经历一场深刻而持久的智能革命。人工智能(artificial intelligence, AI)技术的每一次跃迁都引发了人类对自身存在价值的怀疑和对发展前景的忧虑,AlphaGo的出现如此,大语言模型(Large Language Model, LLM)的火爆也如此。如慨叹人类受到生物学的限制,其智能发展存在极限;而AI却能突破人类的智能常数,“造成劳动、手艺、经验、博学的贬值,最终导致人的废物化”(赵汀阳, 2023);AI技术正在以“全然自动的智能系统替代人类的很大一部分‘脑力劳动’,……最终,人工智能的机械系统将在广泛的领域竭尽所能地取代一切人类劳动,包括‘脑力劳动’和‘体力劳动’”(余明, 2022, p. 20)。当然,也有学者对AI时代人类的发展持乐观态度,“人以自己的常识和本能知识等来弥补人工智能这方面的知识不足,而机器则以自己海量的知识储存来弥补人脑的不足”;甚至,通过脑机接口技术,让“人脑接上具有强大知识记忆和发现功能的人工智能系统”,由此形成前所未有的“最强大脑”,使得知识的发现、生产和创造进入一个全新时代(肖峰, 2020)。其实,未来AI技术是使作为万物之灵的人类彻底“废物化”,还是助其突破自然的限制、进化出“最强大脑”,取决于人类的价值选择、制度设计和教育应对。理想的状况是基于“以人为本”“和谐共生”的价值选择及制度设计,理性、透明、公平地研发AI技术及其应用,同时辅以积极有效的教育应对,使得人们普遍拥有更加高级的素养,得以与另一类智能体互补、互促、共生、共荣。本文以人类将做出合理的价值选择及制度设计的假设为前提,探讨智能时代“应当拥有什么素养”的教育原点问题,以启示教育应对的方向。

我们认为,智能革命对人的素养要求,并非在原先素养的基础上简单地增加关于AI的认识、技能等,而是彻底的素养重构——原先的素养要求是基于人—人共事与共生提出的,智能革命的核心却是人—机协同与共生,因而需要基于新的实践结构建立新的素养模型。国务院参事、清华大学经济管理学院院长钱颖一(2023)认为,“未来的人工智能会让我们的教育制度培养学生的优势荡然无存”,教育必须超越知识,着重培养学生的好奇心和想象力,以及超越短期功利主义的价值取向。杨宗凯教授等认为以ChatGPT为代表的生成式人工智能要求变革教育理念,将人才培养重心从知识传授转移到高阶能力培养和综合素养培育,构建一体化、高质量的学生数字素养培育体系,培育独立、质疑、多元、科学的批判性思维,提升面向“人际+人机”的创新与协作能力(杨宗凯 等, 2023)。这些观点都有素养重构的倾向,富有启发性。本文将基于技术哲学的视角,反思当下机器智能的实质及局限,预测近未来机器智能的发展趋势,进而推断与之竞争合作的人所必备的素养。选择这条致思路径,是由技术与人之间互相依存、互相作用的辩证关系决定的。斯蒂格勒(Stiegler, B.)的人性结构理论认为技术的“代具弥补”重构了人的存在方式(Stiegler et al., 2012)。技术首先外在于人本身,随后在发展中又内化于人(Camp, 2009)。技术内化于人,不单单是技术操控能力的获得与提升,更可能是素养结构的重组。尤其是AI技术,它使得机器在体力、感知力、智力等方面与人类全面对撞,这就需要对人的素养进行全面重构,以形成与机器智能的耦合关系。

二、当下机器智能反思与人机协同素养建构

当代技术哲学由以前的先验批判转向经验研究,旨在“回到技术本身,打开技术黑箱”。通过聚焦于具体的“小写技术”,分析它们的设计、生产、发展、应用等环节,反思其本质及与各种社会因素的关系。以下将采用经验研究的方法,对当下最有代表性和发展前景的AI技术进行描述、解释和批判,进而据此建构人机协同素养模型。

(一)LLM的智能实质与局限

1. 由语言获得智能

LLM的开发采取了由语言而认知的逻辑。即“喂给”机器自然语言,训练它像人一样聊天和思考。LLM之所以能够超越此前的经典机器学习算法,一举突破语言理解与表达的难题,源于通过庞大的神经网络自动提取海量语料的语言特征,而不是通过人工提取语言特征。人工提取语言特征不仅成本高昂,而且只能提取有限的一般化显性特征,从而导致机器缺乏泛化的语言能力。LLM却不是这样,它通过足够庞大的神经网络的深度学习机制自动提取足够丰富、抽象、复杂的语言特征,以表征海量语料中绝大多数的规律性联系,包括语言知识、上下文语境关系、世界知识等。这相当于把整个语言世界都压缩①于自身,从而获得应对任何语用场景的能力。

更引人注目的是,LLM在语言能力的基础上涌现出一定的认知智能。这似乎印证了语言哲学关于语言与思维紧密联系的观点①。经由文本理解,LLM获得了对世界的认识;通过文本生成,LLM表现出相当强的推理能力。比如GPT-3通过对海量文本的充分挖掘,可以自主发现“心智理论”②这种有关他人思维状态的隐性知识,进而加以正确运用。简言之,LLM能够超越词句的表面联结,自动学习主观世界和客观世界的规律或模式,并准确运用这些规律或模式进行推理,表现出很强的发现学习能力和迁移学习能力。

2. 困于语言的智能

LLM虽然由语言而获得智能,但因其只在语言文本上训练,且主要采用联结主义范式,这就在根本上限制了其智能的进一步发展。根据维特根斯坦(Wittgenstein, L.)的语言游戏理论,语言实践(语言游戏)植根于生活形式;生活形式的多样性决定了语言游戏的多样性。理解一种语言就是理解一种生活形式,需要对话双方生活形式的重叠或共通。LLM沉浸于人类丰富的语言材料中,虽然可以由语言而透析人类的一部分生活形式,却由于缺乏自身的生活形式,而无法在语言理解和表达中实现真正意义上的生活形式重叠或共通,从而表现出根本性的智能缺陷。

首先,缺少求真能力。这是由LLM对世界的认识完全源自语言、缺少经验基础导致的。比如它们可以学习概念与用语言表述的定义、正例、反例之间的关系,也可以用语言解释理论,将理论运用于用语言描述的问题中。但是,它们不会把概念与现实世界联系起来,不会脱离语言构想理论在现实世界中的运用情形。这就好像一个人,从一出生就切断他自身内部世界与身外世界感知和互动的通道,而只通过语言向他灌输书本知识,再进行反复刷题的应试训练。其结果很可能是博学、能言而又无知、低能。ChatGPT等使用中经常出现的“幻觉”,除数据质量不高、相关数据缺乏、提示不明确等原因以外,根本原因便是ChatGPT缺乏经验基础导致的真实与虚构、现实世界与想象世界的混淆。由于没有现实世界这个原型作为参照,语言模型在回答有关事实的问题时,可能错误地提取了语料中虚构的事实,也可能在语言规律的支配下“大胆”推理,从而“一本正经地胡说八道”。而且,作为语言模型,LLM受制于语言的模糊性、多义性及其表征世界的局限性,认识世界的能力非常有限。值得注意的是,新一代的LLM已经突破语言的藩篱,向多模态方向发展。目前,我们观察到的主要是语言模型对图像、视频、音频等理解的促进作用。未来,随着非文本数据训练结果与语言模型的融合,应该也会出现语言模型改进的效果。因为源于视听觉的数据虽然不能真正解决缺乏经验基础的问题,但毕竟向经验世界迈进了一步。

其次,缺少审美能力。LLM的言语活动缺少感性基础。理性遵循规则或律令,因而是普遍的,统一的;感性受需求或欲望支配,因而是特殊的,个别的。人类的语言活动兼具理性与感性。即在遵循语法、逻辑、文法等规则的同时,又会抛开甚至违反这些规则而融入或表现自我独特的感受或感情。在文学作品的阅读与创作中,这种情况尤其普遍。但是LLM的训练方式决定了它倾向于认识和运用更具普遍性和一般性的语言表达方式,从而表现出对真正个性化、审美化语言的欣赏无能和表达无能。比如ChatGPT评价《再别康桥》的语言为:流畅性9分,“……有一些地方的表达稍显生硬,稍微改进一下可以使整体流畅度更好”;艺术性8分,“……有些表达略显直白,不够富有想象力和隐喻性”。然后,它修改了原诗。其中第二诗节由“那河畔的金柳,是夕阳中的新娘;波光里的艳影,在我的心头荡漾”改为“那河畔的垂柳,宛如夕阳下的新娘佳人;波光之中,倒映出我心中荡漾的情思”。原诗中最能表现主人公炽热情感的意象被更日常的词语替换。这正是由LLM的言语活动缺少一个感性“自我”而导致的。所以,从根本上说,LLM审美欣赏和审美创造的缺陷是难以避免的。

(二)AI4S①的智能实质与局限

1. 数据驱动的建模智能

AI4S代表了当前专业领域机器智能的最高发展水平。在科学探索事业中,它们已经展现出令人震惊的科学发现能力,取得了令人瞩目的成就。比如AlphaFold,以深度神经网络作为工具,几乎完成了全部已知人类蛋白的结构预测,并且接近或达到实验得出的预测的精度。而在此之前,只有约三分之一的蛋白质的三维结构通过实验方法得到了解析,且很多时候只确定了这些蛋白质的部分结构。

AI4S实质上拥有的是数据驱动的建模智能。历史上,“科学始于观察”“科学始于问题”,即科学发现非常依赖人类的感知觉、直觉、理论假设。物理学家或应用数学家的工作往往是从第一原理出发,得出一个现象的函数描述,然后从测量结果中估计出未知参数,得到一个准确的世界模型。而现在“科学始于数据”——科学发现可以不从明确的函数假设开始,而纯粹由数据驱动,逼近“真理”。在这种情况下,神经网络的优势凸显——它相当于函数家族,有能力逼近广泛的输入/输出关系。霍尼克(Hornik, K.)等曾以严格的数学形式证明了前馈神经网络只要隐层数量足够,就能以任意精度逼近任意函数(即万能近似定理)(Hornik et al., 1989)。实际上,求解微分方程、多体量子系统基态能量和波函数的任务全部可以转化为深度神经网络的优化问题。现代科学发现与科学应用的瓶颈——“维数灾难”问题,可以由神经网络的深度学习而得到较好解决。

成功的AI4S并不单纯依靠深度神经网络来拟合数据。为适应特定问题、任务或者数据,以及更加高效可靠地发现知识,神经网络中往往由科学家植入了归纳偏置(Inductive Biases)。归纳偏置是对拟建构模型的某些预先假设。对于特定分布的数据而言,合理的归纳偏置能够缩小参数的搜索范围,从而能够利用更少的数据更高效地得到最优解;对于不同分布的数据,合理的归纳偏置还能够反映不同任务之间的共性,从而帮助模型快速适应不同的任务,实现分布外泛化。实验证明,使用图网络等归纳偏置技术训练深度神经网络,再对训练出的初步模型使用符号回归算法,不但重新发现了力学定律、哈密尔顿量,还新发现了宇宙学中暗物质晕(DM halo)的一个解析公式(Cranmer & Spergel, 2020)。

2. 止于数据拟合的智能

对AI4S进行结构功能分析可见,它的科学发现能力在很大程度上依赖于科学家预先的精妙设计和事后对其输出的筛选、检验、解释;作为纯粹机器的那部分功能,主要还是数据拟合。与独立的科学研究人员相比,AI4S的缺陷主要体现在以下两个方面。

首先,缺少面向研究对象的科研设计能力。迄今为止,AI4S还不能借助先验知识进行初步的数据分析,由此开展面向研究对象的科研设计。科研设计,这一科学发现中最为关键和基础的环节依然要靠人类科学家完成。对于AI4S而言,科学发现中非常重要的特征提取、神经网络结构设计和模型优化机制设计等,依靠的都是人类智慧。还以AlphaFold为例,它不像LLM一样自动化提取文本特征,而是由科学家设定提取氨基酸序列的序列特征和序列平方特征。此外,科学家创造性地使用Evoformer以及self-attention层建构它的神经网络结构;通过“先预测氨基酸两两之间的距离分布和氨基酸链的夹角分布,再计算以上概率分布与夹角采样及推导出的距离之间的差距”构造损失函数,都是导向AlphaFold成功的关键因素。可见,AI4S高度依赖人类的设计智慧,机器研究的自主性和创造性有待提升。

其次,缺乏针对研究对象的因果解释能力。AI4S缺少关于世界的经验,因而不像人类那样拥有关于研究对象因果关系的直觉。它们建构的只是相关性模型,且模型的可解释性往往不足。抛弃因果性、只求相关性,实际上是现代科学研究的弱点。贝叶斯网络之父、图灵奖得主珀尔(Pearl, J.)认为,这不仅导致了谬误,而且违背了科学寻求“为什么”的终极目的。对于AI,他认为强人工智能必须配备因果推理引擎,而现下的深度学习虽然取得了令人瞩目的成就,但缺失关于世界的因果模型,本质上只是适应“曲线拟合”,导致研究者困在“关联级别”窘境里(朱迪亚·珀尔 & 达纳·麦肯齐, 2019)。缺少因果推理能力更导致AI4S很难获得原创性的科学发现。汤超院士分析认为,AI4S“从1到10、10到100、甚至10到1000的例子不少,而从0到1的可能不多”;从现在的情况来看,“很难想象它能再进一步,发现牛顿定律”(北京大学定量生物学中心,2022)。上文指出的重新发现物理定律的实验之所以成功,其关键在于归纳偏置的植入,换句话说,是科学家告诉机器要去找什么,而不是机器自己发现新的科学规律,引发科学革命。

(三)人机协同素养:智能升级

由以上分析可见,当下的机器智能虽然强大,但在类型上依然属于基础智能。它们尚不具备真正意义上的判断真伪、区分美丑、探索真理的高级智能。因此,人需要把机器擅长的交给机器,同时升级自身的智能水平——由基础智能升级到高级智能,形成与机器的互补—驾驭关系,处理人机协同创新中全局性、关键性、方向性事务。

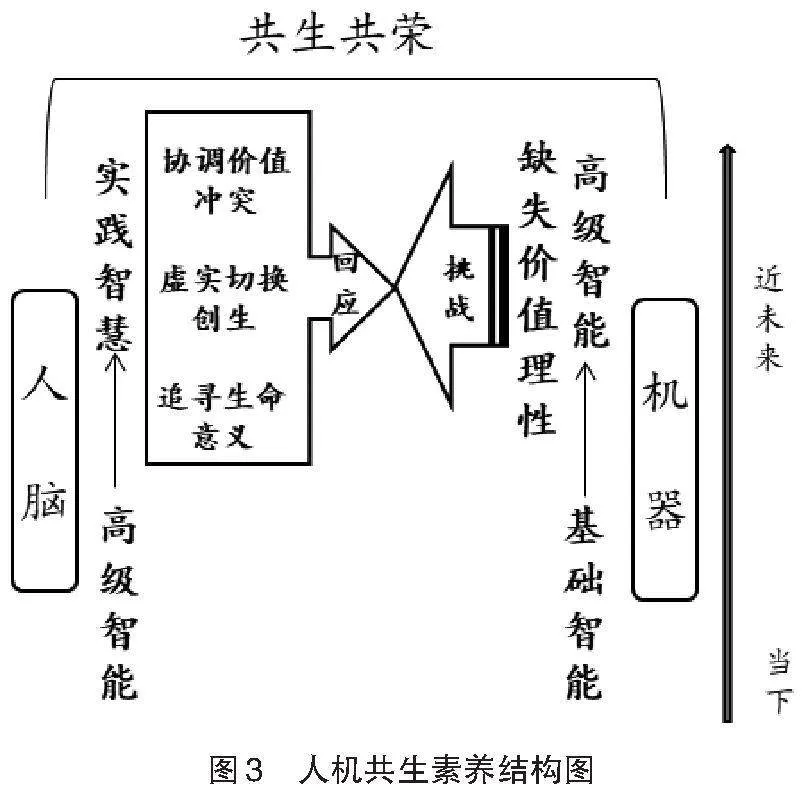

具体地说,人机协同素养由外显行为与内隐心理两个层面构成。在外显行为层面,它表现为对人机协同任务的界定、分工,给予机器所要完成任务的提示(prompts)、示例(即给机器布置任务),对机器完成特定任务的功能结构设计,对机器生成内容的评估、选择、修正、再造、运用等(如图1所示)。

在整个流程中,人发挥对全局的掌控作用:首先,基于问题情境,提出明确的任务,根据自身和智能机器各自的优势和局限进行任务分工;其次,通过提示、示例等向机器布置任务,以引导机器做出期望中的操作(在人类介入更深的情况下,人可以直接根据任务完成的需要,对机器的功能结构进行设计);再次,人对机器的输出进行评估,选择其中可靠合用的部分,或者根据需要进行加工改造,再使用选择或加工后的内容完成任务;最后,人还需要对照先前界定的任务或发现的问题,反思任务完成的过程和结果。

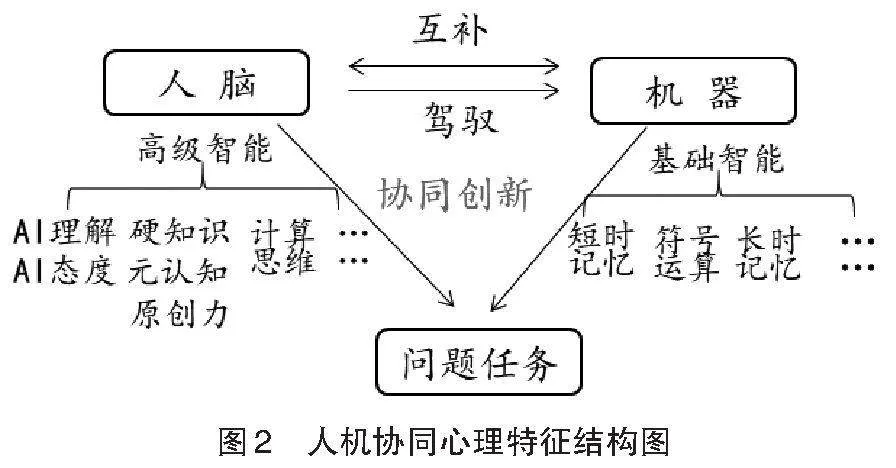

相应地,在内隐心理层面,人需要具备三方面特征,以与机器智能互补,且驾驭机器完成创新任务(如图2所示)。它们的具体内涵如下。

第一,对AI技术及其应用持有客观理性的认识与态度,理解机器的智能优势和局限,特别是与待完成任务相关的智能的实质。一方面,客观理性的态度是人机协同的前提。麻省理工学院物理学家泰格马克(Tegmark, M.)在2018年出版的著作中,一针见血地指出人们应当对人工智能保持冷静客观的态度,盲目的崇拜与盲目的抗拒都会造成恶果;在各行各业,人类都将与人工智能有机融合(Tegmark, 2018, p.36)。另一方面,对AI正确深刻的认识是人机协同的基础。因为只有正确深刻的认识才会产生客观理性的态度;而且是否对AI具有正确深刻的认识,直接决定了人们能否做出合理的人机分工。但是,在AI技术及其产品越来越不透明的当下,这样的认识来之不易。因为神经网络是认知的“黑箱”,其中很大一部分学习过程和结果都难以解释,这给人们认识AI带来了困难。加之开发AI应用时往往基于迎合用户的原则,比如ChatGPT的训练采用了针对预训练语言模型的基于人工反馈的强化学习(RLHF)方法,使得语言模型做出符合人类偏好的回应,这就进一步增加了人们准确评估其生成内容的客观性、准确性的难度。而人们在倍感智能机器便利合用的同时,会在不知不觉中增强对它的依赖,形成对它的盲目信任。对此,有学者认为ChatGPT会逐渐损害人的批判思维能力(Rahman & Watanobe, 2023)。要改变这种状况,既需要AI开发者和研究者加强算法的透明性,以及对深度学习过程和结果的解释性研究,更需要每个期待与智能机器协同创新的人深入理解未来智能伙伴的实质、优势和局限。

第二,深刻理解领域内的硬知识,同时具有领域内的原创能力和元认知能力。人机协同与人人合作一样,伙伴的能力越强,对自身知识能力提出的要求越高。机器具有生成知识、创作文化产品的能力;人类要想准确地鉴别、评价、筛选、加工,自身就必须拥有更高级的知识和更高阶的能力。首先,AI时代,人类不是不需要掌握知识,而是需要在真正意义上掌握更高级的知识。互联网时代造成传统的知识过滤机制失效,导致知识超载或知识危机(戴维·温伯格, 2014, pp.17-22)。这种状况在智能时代更加严重,因为智能机器的知识创造和文化产品创作效率远超人类。面对个人的、网络上的、机器生成的海量知识,人们难免感到焦虑。但实际上,在人机协同中,人根本无须在意自身掌握知识的“量”,而应关注掌握知识的“质”。人只有深刻理解了特定领域内的“硬知识”——即他不仅掌握了被确证的、置信度最高的那部分知识,还掌握了那部分知识被发现、被验证的过程,以及其与所解释对象的关系,他才可能对海量的“软知识”加以检验、甄别、评价和筛选,并对筛选出的知识加以解释,赋予它们意义,等等。其次,AI时代,人类更须拥有与智能机器互补的高阶能力。如前所述,LLM的认知缺乏经验基础,AI4S缺乏因果推理能力,而这些是科学发现中提出原创性理论假设所需要的。在人机协同中,人类应该补上机器的上述不足,强化自身从现实世界中发现问题、抽象关系、提出假设的能力。在文化产品创作中,LLM缺少经验基础及感性基础,而人类却可以拥有来自经验和感性的创作冲动和艺术原创力。因而,回归生活、回归感性自我应是每个艺术创作者修炼自身素养的核心所在。除此以外,由于人类需要掌控人机协同完成任务的全局,因而就需要理解和反思任务完成中人机双方的认知过程和结果,包括认知交互的过程和结果,即具有领域内的元认知能力。比如,作家小白在尝试使用GPT-4进行人机融合创作时,认识到它“似乎具备了对人类写作而言极其重要的心智理论能力,能推测特定情境中不同人的想法、观点、情感变化,甚至能推测多层意向性、可能性”,“懂得如何反讽,能够通过语言表达来模拟人类情感”(澎湃新闻·澎湃号·湃客,2023)。这段文字反映的正是人机协同中人对写作过程及机器写作特点的深刻反思能力。

第三,具有强大的计算思维(Computational Thinking)能力。2006年,卡内基梅隆大学周以真(Wing, J. M.)教授首次系统性地定义了计算思维,即“计算思维是运用计算机科学的基本理念,进行问题求解、系统设计以及理解人类行为”(Wing, 2016)。运用计算思维进行问题求解主要有三步:把实际问题抽象为数学问题,并建模;进行映射,把数学模型中的变量等用特定的符号代替;把解决问题的逻辑分析过程写成算法。这三步后,计算机执行算法,进行求解。实质上,人类运用计算思维的过程,就是研究哪些问题可计算以及如何计算的过程,或者说,是把实际问题转化为可计算问题,并设定算法让计算机去执行的过程。对照人机协同的行为表现,计算思维实际上是在进行任务界定、任务分工、任务布置、结构设计等。只是不同于使用自然语言与机器交互,计算思维是使用数学和程序语言与机器进行更直接、更基础层面的交互。因而,人在协同中的自由度更大,掌控力更强。浙江大学人工智能研究所所长吴飞曾指出,科学家在使用人工智能这个工具的过程中,需要形成以设计构造、计算为核心的计算思维(赵广立, 2021)。AlphaFold就是不同学科的科学家汇聚在一起运用计算思维解决问题的范例。实际上,人机协同时代不仅科学家需要计算思维,每个人都须具备这项基本技能(Wing, 2016)。

三、近未来①机器智能预测与人机

共生素养建构

如果说当下机器智能的发展水平决定了人类需要发展高级智能与之形成互补—驾驭关系,那么以AI技术的发展速度,不久的将来机器就很可能拥有强大的高级智能,那时人类更须拥有与之共生的智慧。鉴于此,我们将基于当下机器智能的发展状况对近未来机器智能进行科学预测,由之推断适应近未来机器智能的人类素养结构。“‘近未来’的图景预见既是对前景的积极预测,又是当下现实的合理延续”(祝智庭 等, 2023)。前文对机器智能的分析揭示了其智能局限的根源在于没有选择人类天生具备的认知方式,如因果认知、具身学习等。AI科学家和工程师们正在着力解决这些问题。我们推测近未来机器智能很可能在因果认知、具身学习方面取得突破,进而出现真正意义上的机器超人。不过,机器超人的本质依然是机器,其局限及带来的挑战不可避免。而智能机器近未来的发展、局限及挑战是我们建构人机共生素养模型的基础。

(一)近未来AI技术的突破方向

1. 配置因果推理引擎

大脑天生倾向于寻求因果解释,并天生擅长因果推理。前科学时代就是如此。近现代以来,借助实验和数学工具,这种天性和才能更是帮助人类创造了庞大而严谨的科学知识体系。要发展强人工智能,不应当单纯走大数据+深度学习的道路,而应当在现代计算机上模拟大脑的因果推理机制,创造“人工科学家”。这个智能机器人将会为我们发现未知的现象,解开悬而未决的科学之谜,设计新的实验,并不断从环境中提取更多的因果知识。珀尔(Pearl, J.)和麦肯齐(Mackenzie, D.)将因果关系之梯分为三个层级:第一层级是通过观察发现关联,从而进行预测。观察到的事物关联可能是因果性的,也可能不是。第二层级是通过行动进行干预。“操纵”原因获得预期结果,因果关系便得到一定程度的证实。第三层级是反事实的创构(即对诸如“假如我采取了相反的行动会怎么样”一类问题的回答),是基于因果关系的合理想象(推理)。他们认为,目前的深度学习处于第一层级——由观察数据建构关系模型,再进行预测。而通过Do算子,AI可以在不实施干预的情况下预测干预的效果,跃升至第二层级。通过反事实算法,AI则可以进一步跃升至因果关系之梯的最高层级。(朱迪亚·珀尔 & 达纳·麦肯齐, 2019, p.10)我们可以乐观地估计,配置了这样的因果推理引擎,再加上大数据、大算力的加持,AI自主提出高质量科学假设、获得原创性科学发现的可能性将大大提高。

2. 开发具身智能机器人

当前的LLM和AI4S都属于非具身智能,它们没有物理身体,只能被动接受人类采集、制作好的数据,无法执行任何物理行动,无法真正理解世界的真实意义。因此,它们虽然能够迅速获得特定智能,却也有极大的局限性。目前,具身智能机器人通过与环境的真实互动进行强化学习,虽然学习进度慢,(理论上)却不存在智能发展的上限,通常被认为是AI的终极形态。目前,具身智能已经成为国际学术前沿研究方向。谷歌公司Everyday Robot的SayCan已经将机器人和对话模型结合到一起,能够让机器人在大型语言模型的帮助下,完成一个包含16个步骤的长任务。加州大学伯克利分校的LM-Nav用三个大模型(视觉导航模型ViNG、大型语言模型GPT-3和视觉语言模型CLIP)教会了机器人在不看地图的情况下按照语言指令到达目的地。近未来,随着机器人感知和行动能力的进一步发展,在强大的知识储备、运算能力和语言能力的加持下,它的理论思维能力与实践能力、推理能力与创新能力将相互强化,产生Lollapalooza效应(可译作“好上加好”效应)。

(二)近未来AI技术的发展限制

我们推测,近未来的智能机器大概率将缺失价值理性。虽然具备了因果认知、具身学习能力,机器可以获得自主探索真理、判断真伪、区分美丑等高级智能,但是从人本主义立场出发,人类很可能不会赋予它们自主为各种价值排序、做出价值选择的价值理性。可以设想,人类开发AI时会预先给它植入科学知识、道德规范、价值准则等。在它自主的科学探索中,程序会允许它根据新的科学发现修正原先植入的科学知识,因为科学本就是容错和可证伪的。在它与环境互动的过程中,程序也会允许它修正原先植入的道德规范,因为道德规范过于机械,往往需要根据复杂的道德情境加以调整。但是程序却不会允许它修改价值准则,因为一旦机器能够修改价值准则,就意味着它有了自己的好恶,驱动它的也就不再是人类的目标指令或目的设定,而是它自己的好恶,那将是人类的巨大灾难。环顾世界各国,人本人工智能(Human-centered AI,HAI)已被确立为人工智能发展的方向,而人本人工智能的核心便是将人类的需求和价值观纳入人工智能技术的开发、应用和治理之中(祝智庭 等,2023)。从技术开发的角度看,这意味着机器的智能再发达,也得听命于人类的价值排序和价值选择。

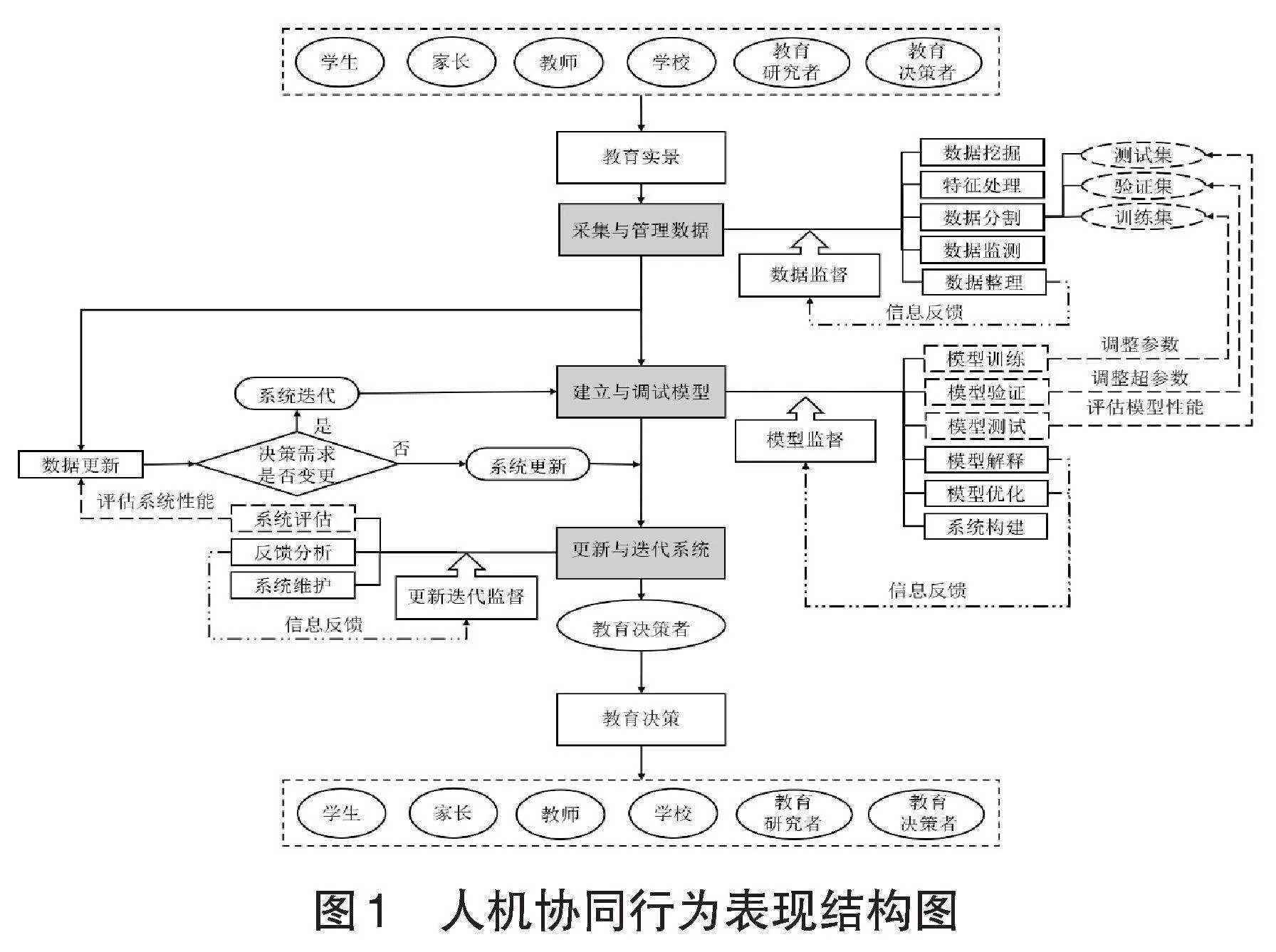

(三)人机共生素养:智慧跃迁

近未来机器智能高度发达而价值理性缺失,对人类不仅意味着手和脑的解放,更意味着前所未有的人文挑战。一方面,智能机器的设计与应用需要人们做出价值排序和价值选择,这很可能使价值冲突显性化、扩大化;另一方面,数字智能技术高度发达,也会导致现实世界祛魅和人类智能贬值,最终让生活失色和生命沉沦。要应对这些挑战,需要人们实现智慧跃迁——拥有善于考虑“对整个生活有益的”实践智慧(亚里士多德, 2003, p.172),以创造新的和谐生活和美好生命,而不是沉沦到“高科技,低生活”的赛博朋克世界中。实践智慧具体表现在三个方面(如图3所示)。

1. 协调价值冲突的智慧

智能机器缺失价值理性,需要人们替它们做出价值排序和价值选择。而价值问题的本质在于不存在一个真理解或普遍必然解。即不存在关于“好”的普遍必然定义。同时,价值排序永远存在两难困境,因而难以合理地解决优先级问题。不仅如此,机器高度发达的智能及其广泛应用于公共生活的公共性,会导致原先有限范围的价值冲突扩大化,原先隐藏的价值冲突公开化、尖锐化,这些价值冲突将给人们带来极大的困扰。如在无人驾驶技术开发中,如何给等概率致伤自己与致伤行人进行价值排序?在智能教育技术应用中,是选择智能学伴,还是人类学伴?是将学习完全置于技术监控与数据分析之下,还是让孩子自由地想学什么就学什么、想怎么学就怎么学?智能机器将这些前所未有的尖锐的价值冲突摆在人们面前。对于价值冲突,前人通过共同体规范或者民主磋商加以解决,而在智能时代这些办法可能还不够。也许只有每个人都拥有筹划共同美好生活的实践智慧,才可能有效协调各种复杂的价值冲突。

2. 虚实切换创生的智慧

AI技术高度发达会进一步加深现实世界数字化、虚拟化的程度,加深人类生存的数字化程度,直至迎来元宇宙的繁盛期。元宇宙作为一个与传统物理世界平行的全息数字世界,是用计算机技术复制现实世界得出的镜像与愿景。到元宇宙全面繁荣时,人类将在元宇宙中建立与现实物理世界相平行的“数字孪生组织”,企业之间、人与人之间相互作用的过程都将全部数字化。有人认为这将实现人的数字化永生。然而,换个角度看,这是否意味着人类另一种形式的异化呢?机器因为具身学习而向现实世界扩张,人类却堕入“数字沉迷”的深渊而失去了自身的现实性。要避免这种结果,人们必须不忘创造美好现实生活的初衷,善于在虚拟世界与现实世界之间自由切换,善于汲取虚拟世界的养料来创生现实的美好。举一个极端的例子,在元宇宙中,高度发达的AI、VR、脑机接口等技术可以轻易让人分泌多巴胺,产生近似恋爱的感觉,但是人不能沉溺于此,而应懂得什么才是真正“对自己好的、有益的事情”(亚里士多德, 2003, p.172),从而让自己从虚幻的满足中脱离出来,到现实生活中建立真实的亲密关系以及人与人之间的真挚感情。

3. 追寻生命意义的智慧

每一波AI技术突破都会导致大量工作自动化。如2023年高盛发布研究报告称,随着生成式人工智能的广泛应用,预计全球将有3亿个工作岗位被AI取代,超过900种职业(占全美近三分之二的职业)将部分被AI替代(Sachs, 2023)。近未来,在大部分工作上智能机器都可以有类人或超人的表现。单纯从生产效率和经济效益的角度出发,人类劳作的机会及其必要性都会大大降低。然而,这并非全然是幸事。生活富足安逸很可能导致人们精神的空虚。以挪威为例,虽然位居世界上最富有的国家之列,但自杀率居高不下。其原因一方面与气候有关,另一方面与人心空茫、缺乏生活目标有很大关系。(车凤, 2018)近未来,人们的空闲时间大幅增多,但心灵空虚的风险也随之增大,因为劳作不一定是辛苦或负担。如果从事与自身价值观匹配、发挥身心潜能的工作,“劳作”实质上就成为“创造”,或者说是“自我实现”的过程。马斯洛(Maslow, A.)需要层次理论认为,自我实现的需求处于需求层次的顶端。较低层次的生理需求、安全需求、爱与归属感、自尊得到满足后,会产生厌倦、无趣的情绪;自我实现需求却不会如此。自我实现会给人带来巅峰体验,使人获得极大的幸福感、敬畏感、和谐感。考夫曼(Kaufman, B. S.)的研究也表明,自我实现会带来最佳的心理健康与个人成长(Kaufman, 2018)。然而,强大的机器智能、逐利的资本本质,以及人类自身的惰性,会极大挤压自我实现的空间。在这样的境遇下,寻找生命的意义将变得更加艰难。或许,只有人们深刻反思,意识到“意义”应替代“效率”成为根本目标,AI时代的生命荣光才会绽放。

四、结语

综上,基于技术与人相互构成、技术与社会共同进化的技术哲学假设,我们推演出人机协同—人机共生的素养模型,以期人类社会做出及时的、必要的教育应对。实际上,新技术发展中普遍存在“科林里奇两难现象”,即在早期阶段、新技术尚具有可塑性时,人们因缺少它将产生何种社会影响的知识,而没有做出必要调整,直到获得那些知识后,新技术已经完全嵌入社会而难以做出任何改变(Poel, 2020)。所幸的是,通过技术哲学研究和小规模社会实验,我们可以提前获得AI技术—人、AI技术—社会的知识,提前调整技术开发以及人才培养的方向,让智能革命与人的发展、社会进化同步同向而行。

参考文献

北京大学定量生物学中心. (2022-8-15). 2022科学智能峰会回顾|汤超院士:关于AI for Science的几层意思. 北京大学定量生物学中心网站. http://cqb.pku.edu.cn/info/1065/1851.htm

车凤. (2018-5-25). 时代呼唤人文素养. 中国共产党新闻网. http://theory/people.com.cn/n1/2018/0525/c40531-30013242.htlm

澎湃新闻·澎湃号·湃客. (2023-6-10). 当“我”和“它”的界限不再明晰,ChatGPT会为文艺创作带来什么?澎湃新闻网. https://www.thepaper.cn/newsDetail_forward_23424789

钱颖一. (2023-2-12). 人工智能将使中国教育优势荡然无存. 《当代教育家》杂志官方网易号. https://www.163.com/dy/article/HTBE2IS60516DKF5.html

戴维·温伯格. (2014). 知识的边界(胡泳,& 高美 译). 山西人民出版社.

肖峰. (2020). 人工智能的知识哲学审思. 求索(1),87-94.

亚里士多德. (2003). 尼各马可伦理学(廖申白 译). 商务印书馆.

杨宗凯,王俊,吴砥,& 陈旭. (2023). ChatGPT/生成式人工智能对教育的影响探析及应对策略. 华东师范大学学报(教育科学版)(7),26-35.

余明. (2022). 还原与无限:技术时代的哲学问题. 上海三联书店.

赵广立. (2021-12-29). 我们正处于新科学革命的起点|学界热议AI for Science. 科学网. https://news.sciencenet.cn/htlmnews/2021/12/471722/shtm

赵汀阳. (2023). GPT推进哲学问题了吗. 探索与争鸣(3),66-74.

朱迪亚·珀尔,& 达纳·麦肯齐. (2019). 为什么:关于因果关系的新科学(江生,& 于华 译). 中信出版集团.

祝智庭,戴岭,& 赵晓伟. (2023). “近未来”人机协同教育发展新思路. 开放教育研究(5),4-13.

Camp, V. (2009). Stiegler, habermas and the technological condition of man. Journal for Cultural Research (2),125-141.

Cranmer, M., & Spergel, D. (2020-6-19). Discovering symbolic mo-

dels from deep learning with inductive biases. Cornell University Website. https://arxiv.org/abs/2006.11287

Hornik, K., Stinchcombe, M., & White, H. (1989). Multilayer feedforward networks are universal approximators. Neural Networks (2),359-366.

Kaufman, B. S. (2018-9-7). What does it mean to be self-actualized in the 21st century. Scientific American. https://blogs.scientificamerican.com

Poel, I. V. D. (2020). Three philosophical perspectives on the relation between technology and society, and how they affect the current debate about artificial intelligence. Human Affairs (10),499-511.

Rahman, M. M., & Watanobe, Y. (2023). ChatGPT for education and research: Opportunities, threats, and strategies. Applied Sciences,13(9), 5783.

Sachs, G. (2023-4-5). Generative AI could raise global GDP by 7%. Navigating the AI Era. https://www.goldmansachs.com/intelligence/pages /generative-ai-could-raise-global-gdp-by-7-percent.html

Stiegler, B., Roberts, B., Gilbert, J., & Hayward, M. (2012). Bernard Stiegler: ‘A rational theory of miracles on pharmacology and transindividuation’. New Formations (10),164-184.

Tegmark, M. (2018). Life 3.0: Being human in the age of artificial intelligence. Vintage.

Wing, J. M. (2016). Computational thinking. Communication of the ACM (3), 33-35.

Intelligent Revolution and Reconstruction of Human Literacy: An Educational Reflection Based on Technology Philosophy

Abstract: The accelerated development of AI technology has caused visionary men to doubt the value of human existence and worry about the prospect of human development. What qualities should human beings own in the era of AI in order to complement, promote, co-exist and co-prosper with another type of agent? For this educational origin problem, it’s necessary to analyze the essence, limitations and development trends of AI technology based on technology philosophy, and build a literacy model to collaboratively innovate and co-prosperity with it. Among them, the core of human-machine synergistic literacy is the advanced intelligence that can complement the current machine intelligence and control it to complete innovative tasks. The core of human-machine symbiosis literacy is the practical wisdom to deal with various humanistic problems brought about by machine intelligence in the near future and to be good at pursuing and achieving a better life together.

Keywords: AI; human-machine synergistic; human-machine symbiosis; technology philosophy