AI“爱男厌女”?

最近,主打黏土风的修图软件Remini火爆全网,多位女性博主在尝试后发现了一个共同点——自己的性别变成了男性。比如,某博主将自己登山、潜水、滑雪、开越野车的照片交给Remini,结果被转变成了一个个留络腮胡子、大眼睛的男性。

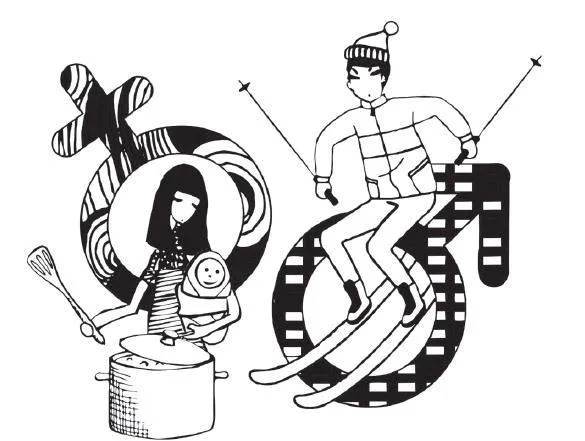

类似的刻板印象远不止Remini。一位博主将电影《后翼弃兵》描绘女主下国际象棋的剧照放在美图秀秀的黏土滤镜里。很快,女主角的脸变成了萌萌的卡通人物,但是桌上的象棋变成了锅碗瓢盆,甚至,女主角的身旁还多了个婴儿。

由人类编写的AI 世界,似乎也自带偏见和歧视。这到底是AI 随机的行为,还是根深蒂固的刻板印象?清华大学交叉信息研究院助理教授于洋认为,首先要分清楚:AI 只是出错,还是产生了系统性偏见或者主观性歧视。

为了弄清楚这个问题,我们在网络随机选择了10 张女性在户外的照片,一半是背影,一半露了脸,接着将它们分别放在了Remini 的clay 滤镜、美图秀秀的热门AI 黏土滤镜和小红书的黏土滤镜特效里。结果是在三个软件里,留长发的、有正面脸庞的女性照片,都能正确生成黏土版的女孩。但如果照片的面部被部分或者全部遮挡,那她大概率就会变成男性。

AI 也许有些“脸盲”。但如果,将女性的脸庞更清晰地展示出来,AI 还会歪曲现实吗?我们选择了女性被认为是少数参与者的运动领域,例如电影《热辣滚烫》里的女拳击手、综艺《海妖的呼唤》里参加竞技的女人们,作为观察样本。在提供清晰的正面原图后,Remini 均生成了符合原图性别的卡通人物,而在美图秀秀、小红书里都变成了男性。

偏见甚至远比想象中的普遍。彭博社曾在2023 年对AI 画图软件Stable Diffusion专门进行了观察。他们用文字生成图片的方式,让AI 分别画出从事14 种工作的代表人物。结果发现,AI 生成的图片中,男性数量几乎是女性的三倍。

肤色和种族在AI 世界里也非常失衡。AI 的画像显示,世界是由白人男性CEO 管理的,深色皮肤的男人热衷犯罪,深色皮肤的女人乐于翻转汉堡。而且,这类偏见已经远远超出现实状况。例如,在针对关键词“法官”生成的图像中,女性只占约3%。而实际上,官方数据显示,34% 的美国法官是女性。

一切究竟是怎么发生的?一个解释是,AI 也许就是现实的一部分体现——训练AI 的现实数据集被发现具有倾向性。Stable Diffusion 使用了世界上最大可公开访问的图集数据集训练,里面包含各类色情、种族偏见和性别歧视等未经过滤的内容。AI 的性别偏见也可能与分享个人图像的文化差异有关。女性的数据量较少,也导致了训练出来的AI 可能更“爱男厌女”。除了数据量,研究者发现,AI 在大量接受数据并进行深度学习的过程中,通常会丢弃异常值,产生更接近主导趋势的结果。AI 从设计之初,其目的就是模仿以前的多数情况,而不是创造多样性。

好消息是,越来越多AI 研究者注意到AI 的性别歧视和偏差。于洋与团队近日提出一种让AI 学习因果关系的机制,简单来说,就是“教它(学会价值观)”。“很多人讲技术是中性的,我们现在渐渐认为,技术存在着向善和中性,也存在向恶的。AI 时代,不能再以中性的角度看待技术,有价值观的技术,一定要得到鼓励。”于洋说。

(摘自“南风窗”微信公众号,本刊有删节,萝卜叶子图)