基于改进Swin-Unet的遥感图像分割方法

摘 要:针对遥感图像数据本身存在分辨率高、背景复杂和光照不均等特性导致边界分割不连续、目标错分漏分以及存在孔洞等问题,提出了一种基于改进Swin-Unet 的遥感图像分割方法。在编码器末端引入空洞空间金字塔池化(AtrousSpatial Pyramid Pooling,ASPP) 模块,用于捕获多尺度特征,增强网络获取不同尺度的能力,充分提取上下文信息;将解码器端的Swin Transformer Block 替换为残差Swin Transformer Block,不仅保留了原始信息,又能够缓解模型出现梯度弥散现象;在跳跃连接中引入残差注意力机制,可以让模型更加关注特征图中的重要特征信息,抑制无效信息,从而提高模型分割的准确率。在自建数据集上进行实验,结果表明,改进后的网络平均交并比(mean Intersection over Union,mIoU) 达到了80. 55% ,提高了4. 13 个百分点,证明改进后的网络可以有效提高遥感图像分割的精度。

关键词:遥感图像;语义分割;SwinUnet;空洞空间金字塔池化;残差注意力机制

中图分类号:TP751 文献标志码:A 开放科学(资源服务)标识码(OSID):

文章编号:1003-3106(2024)05-1217-09

0 引言

遥感图像包含丰富的地物特征信息[1],通过遥感图像分割技术,可以帮助人们自动提取出关键信息,为合理分析和利用土地资源提供应用指导,已广泛应用于军事、农业、城市规划、自然灾害监测、道路分析和森林植被等各个领域。然而,由于遥感图像的分辨率高、纹理信息丰富、同物异谱和异物同谱现象明显[2],给遥感图像分割带来了很大挑战。

近年来,越来越多的学者针对如何提高遥感图像分割精度的问题展开了研究[3]。阈值分割算法通过选取合适的阈值来实现目标和背景的分离,算法难度小、实现简单,能够实现图像的快速分割[4],但对噪声比较敏感[5],不适用于复杂场景下的遥感图像分割。聚类分割算法具有分割速度快、拓展性强、无监督、高效等特性[6],但初始聚类中心和聚类数量难以确定,对噪声也较为敏感[7]。支持向量机(Support Vector Machine,SVM)方法可以排除大量冗余样本,具有较好的鲁棒性[8],但耗时较长,并且只能用于小型数据集,对空间的信息利用率不高[9]。阈值、聚类和SVM 分割方法属于传统图像分割方法,对于复杂的遥感图像来说,传统分割方法时间效率低、分割的精度并不能满足实际需要。Unet是由Ronneberger 等[10]提出的一种对称的编码-解码结构,它可以融合浅层和深层次的语义信息[11],并且简单灵活,可以在较小的数据集上获得良好的分割效果[12],但仍会由于空间和细节信息的丢失而导致边缘分割模糊[13]。深度学习方法可以更深层次地提取遥感图像的特征,但不能充分利用遥感图像丰富的上下文信息,仍然会存在细节丢失、边界模糊等问题。

将U 型网络与Transformer 结合已经成为近2 年来的研究热点之一[14]。Swin-Unet[15]是一种以Transformer 为骨干网络的U 型网络,它可以利用Transformer 来弥补Unet 本身在捕获长距离依赖上的缺陷。Gao 等[16]改进了Swin-Unet 以解决糖尿病视网膜病变黄斑水肿区域分割不准确的问题,结果表明,改进后的网络不仅提高了视网膜黄斑水肿的整体语义分割精度,还进一步提高了多尺度、多区域水肿区域的语义分割效果。张文康[17]针对云区域识别精度低的问题,采用了Swin-Unet 模型对云图进行识别,结果表明,该模型可以从遥感图像中提取更多的语义信息,获得更好的识别效果,虽然云的边缘和细节仍存在一定的误差,但整体上提高了对云图的识别精度。Yao 等[18]针对遥感图像同物异谱和同谱异物问题,提出将改进后的Swin-Unet 模型作为一个纯Transformer 模型和新的预处理方式。实验结果证明,该模型能够更有效地提升遥感图像分割的精度,相比于传统模型更有优势。然而,Swin-Unet 提取的遥感图像仍然存在边缘模糊、目标漏分等问题。

针对遥感图像背景复杂、分辨率高导致遥感图像的分割结果不理想的问题,本文设计了一种基于改进Swin-Unet 图像分割算法。本文的主要贡献如下:① 标注新的遥感数据集,并进行数据增强等一系列预处理操作;② 在编码器末端引入空洞空间金字塔池化,充分提取多尺度遥感图像特征,增大感受野;③ 将残差思想引入解码器端的Swin TransformerBlock,防止模型出现过拟合现象;④ 在跳跃连接中引入残差注意力机制,增强重要特征,抑制不重要特征。

1 基于改进Swin-Unet 的遥感图像分割网络

1. 1 网络结构

本文在Swin-Unet 的基础上加以改进来实现遥感图像分割,改进Swin-Unet 网络结构如图1 所示。改进后的Swin-Unet 网络包括编码器、解码器和跳跃连接3 个部分。在编码器部分,输入图像先通过图像分块处理(Patch Partition)操作,将输入图像划分为一个个大小相等的分块,再通过线性嵌入(Linear Embedding)改变每个分块的通道数目。将这些分块输入多个Swin Transformer Block 和图像块合并层(Patch Merging)中,在编码器的末端引入空洞空间金字塔池化(Atrous Spatial Pyramid Pooling,ASPP)模块,用于提取不同尺度信息,增大感受野,提取更多细节信息。其中,Swin Transformer Block可以提取图像特征,Patch Merging 操作的主要作用是下采样,可以将特征图的长宽变为原来的一半,同时通道数增加为原来的2 倍。解码器部分包括了多个残差Swin Transformer 模块(Res-Swin TransformerBlock)和图像块扩展层(Patch Expanding)。Res-Swin Transformer Block 中引入了残差思想,可以有效防止模型出现过拟合现象,提升模型的泛化能力。Patch Expanding 的主要作用是上采样,可以将特征图的长宽变为原来的2 倍,通道数减半。最后一个Patch Expanding 将特征图的长宽变为原来的4 倍,通道数不变,最后经过一个线性映射得到最终的遥感图像分割结果。在跳跃连接部分,将编码器端的Swin Transformer Block 与解码器端的Res-Swin Trans-former Block 进行跨层连接,弥补了信息的丢失,同时在跳跃连接中加入了残差通道注意力模块(Res-SE Block),可以关注特征图中重要的信息,抑制不重要的信息,以提升图像的分割精度。

1. 2 ASPP

图像分割网络大多是基于编码器-解码器的结构,在通过下采样扩大感受野、上采样恢复至原图的过程中,很容易丢失一些重要的语义特征信息,并且未能充分考虑上下文信息,往往会造成很大的精度损失。ASPP 模块是由Chen 等[19]在DeepLab V2 中首次提出的,它可以利用不同膨胀率的空洞卷积并行捕获图像的不同尺度特征,获得不同的感受野特征,并将其进行融合,充分考虑了上下文信息,同时提高了网络对细节特征的提取能力。

ASPP 模块主要包括5 条分支,第1 条分支为1 个1×1 的卷积,第2、3、4 条分支为空洞率分别为3、6、12 的3×3 空洞卷积,第5 条分支为全局平均池化(Global Average Pooling,GAP)。其中,空洞卷积可以在不增加模型参数量的同时,增大特征图的感受野[20]。最后通过双线性差值将图像还原至原始图像大小。ASPP 模块如图2 所示。本文在SwinUnet 编码器的末端加入ASPP 模块,可以充分提取多尺度信息,增大感受野,同时也有助于解码器恢复细节信息。

1. 3 Res-Swin Transformer Block

随着深度学习网络模型层数的不断增加,网络模型很容易出现过拟合和网络退化的问题,进一步限制了网络模型精度的提升。为了解决这一问题,He 等[21]提出了ResNet 模型,它通过一条有向快捷连接,将输入直接越层连接到输出,在不增加参数量的前提下,有效缓解了网络出现梯度弥散的现象,同时捕获了更加丰富的语义特征,提高了图像识别的精度。

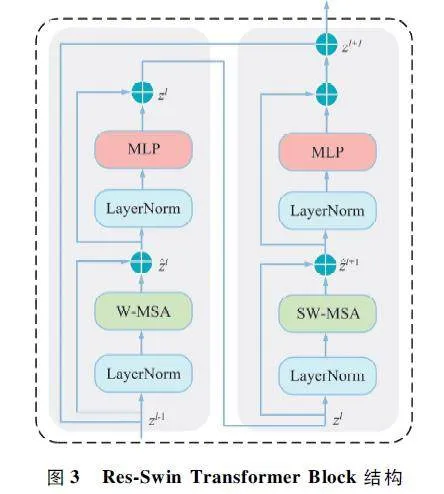

受到ResNet 的启发,本文将残差思想引入SwinTransformer Block,用一条快捷连接,连接SwinTransformer Block 的头尾,通过恒等映射来防止网络模型出现梯度消失的现象。本文将成对带有Window Multi-Head Self Attention (W-MSA)和ShiftWindows Multi-Head Self-Attention(SW-MSA)的模块作为一个Swin Transformer Block,Res-Swin TransformerBlock 结构如图3 所示。实验中发现,将解码器端的Swin Transformer Block 替换为Res-Swin TransformerBlock 后,可以有效提高模型对遥感图像分割的准确率。

1. 4 残差注意力机制

跳跃连接能够通过将编码器端的低层次特征与解码器端的高层次特征进行拼接,进一步弥补信息的丢失。然而,低层次特征中包含大量冗余的信息,同时缺少特定的语义信息,可能会影响遥感图像分割的精度。为此,本文将残差注意力机制引入跳跃连接中,可以强化重要的特征区域,减弱冗余的特征区域,从而提高遥感图像分割的准确率。

注意力机制[22]是在2017 年提出的,它的基本思路是从特征通道角度入手,增强重要的特征通道信息,弱化不重要的特征通道信息。压缩与激励(Squeeze & Excitation,SE)模块主要包括压缩和激励两部分。压缩(Squeeze)部分将特征图进行GAP操作,生成1×1×C 的向量;激励(Excitation)部分使用2 个全连接层来得到每个特征通道的通道权重,最后进行Scale 操作,将得到的权重与原有的特征图进行相乘,得到最后的输出结果。

残差注意力机制首先对Swin Transformer Block输出特征图进行Reshape 操作,将其从L×C 形状改变为H×W×C 形状。接着,对特征图进行GAP、全连接等一系列操作,并将得到的特征图通过Scale 操作与原特征图相乘;然后,通过一条快捷连接将改变形状后的Swin Transformer Block 直接与Scale 操作后得到的特征图相加,得到新的特征图;最后,再通过Reshape 操作,将其从H×W ×C 形状重新恢复为L×C 形状大小。残差注意力机制既没有增加模型的参数量,又保留了原始信息,同时也防止模型出现过拟合问题。残差注意力机制结构如图4 所示。

2 实验

2. 1 数据集制作及预处理

WHU-RS19 数据集[23]是从Google Earth 中提取的遥感影像图像,包含机场、沙滩、桥梁、沙漠、农田和足球场等19 个场景类别,每一类大约有50 张图像,共计1 005 张图像,每张图像尺寸为600 pixel×600 pixel。由于受尺度、方向和照明等因素影响,该数据集更为复杂。

RSC11 数据集[24]是中科院于2016 年发布的开源高分辨率遥感影像,涵盖了美国多个城市的影像图片,包含了港口、居民区、铁路、立交桥、储罐、密林和疏林等11 个类别,图像尺寸为512 pixel ×512 pixel,每一类大约有100 张图像,整个数据集总共有1 232 张图像。

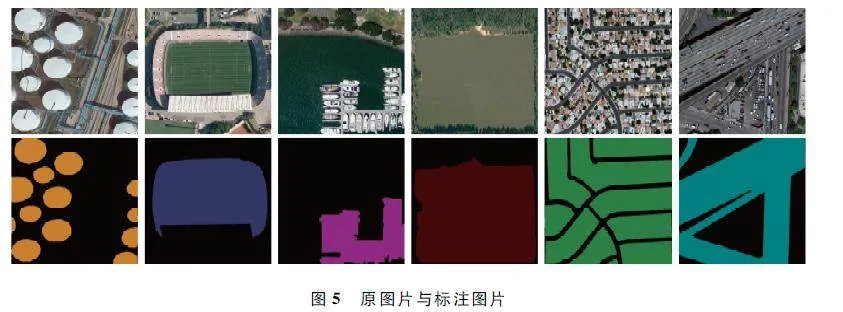

本文从WHU-RS19 和RSC11 数据集内筛选出了一些具有明显特征的类别,去除了相似、重复和单一背景的类别,形成遥感图像分类数据集。通过使用Python 脚本,将数据集内所有图像的后缀名修改为png 并调整图像大小为512 pixel × 512 pixel。然而,由于遥感图像分类数据集属于图像分类数据集,缺乏语义分割标签,因此需要Labelme 手动标注图像,生成遥感图像分割数据集。标注完成后,通过“labelme2voc”脚本将标注完成后所生成的json 文件批量转换为语义分割数据集,并将语义分割数据集内的RGB 彩色标签转换为对应的单通道数字标签。最后采用水平翻转、垂直翻转、对比度增强、旋转和添加噪声等一系列数据增强方法,最终得到的遥感图像分割数据集总共有3 528 张图像,其中选取3 000 张作为训练集,528 张作为测试集。原图片与标注图片(部分数据集)展示如图5 所示。

2. 2 实验环境

本文的实验环境基于Ubuntu 18. 04 系统,采用的深度学习框架为Pytorch。实验所用的GPU 为单卡的NVIDIA RTX_3090,CUDA 的版本为11. 7。预训练权重使用在ImageNet 数据集上预先训练好的swin_tiny_patch4_window7_224. pth 权重,初始学习率为0. 01,动量为0. 9,优化算法为随机梯度下降(Stochastic Gradient Descent,SGD)方法。训练模型的epoch 设置为300 个,batch size 大小为12,窗口大小为8。

2. 3 损失函数

本文使用的损失函数为经典的交叉熵损失(Cross Entropy Loss,CE Loss)和骰子损失(DiceLoss)相结合的损失函数。二者结合的损失函数公式为:

Loss(y,ypred ) = 0. 4Lossce(y,ypred )+ 0. 6LossDice(y,ypred ),(1)

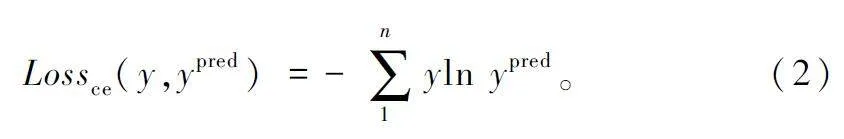

CE Loss 是经典的语义分割中常用的损失函数,可以很好地优化类间距离,同时还可以缓解DiceLoss 训练造成的震荡问题,其公式为:

由于遥感图像的前景与背景之间存在不平衡的问题,Dice Loss 可以减轻复杂背景对分割结果的影响,衡量前景与背景之间的重叠部分,很好地解决部分图像中前景所占比例较小的问题,用来计算真实值和预测值之间的相似度,其公式为:

式中:n 为遥感图像分割的类别数。

2. 4 评价指标

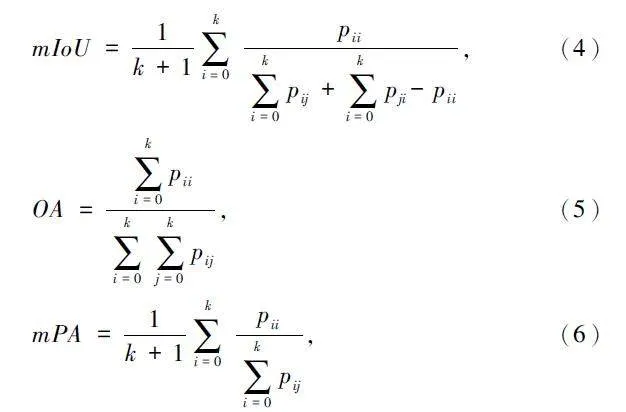

为了验证改进网络的有效性,本文采用平均交并比(mean Intersection over Union,mIoU)、总体准确率(Overall Accuracy,OA)和平均像素精度(meanPixel Accuracy,mPA)作为评价指标来评估模型对遥感图像的分割效果,具体计算公式如下:

式中:k 表示遥感图像分割的类别数(不包含背景),pii 表示真正例,即实际为类别i 且被正确地预测为类别i 的像素数量;pij 表示假正例,即实际为类别i却被错误地预测为类别j 的像素数量;pji 表示假负例,即实际为类别j 却被错误地预测为i 的像素数量。

3 实验结果与分析

3. 1 消融实验结果与分析

为了验证所引入模块的有效性,本文依次将Res-Swin Transformer Block、残差注意力机制以及ASPP 叠加到基线模型中进行消融实验,并通过评价指标结果评估每个模块对模型性能的影响效果。消融实验评估结果对比如表1 所示。其中,Res_SE表示残差注意力机制,Res _ Swin 表示Res-SwinTransformer Block,ASPP 表示空洞空间金字塔池化。

从表1 可以看出,引入Res-Swin TransformerBlock 后,相较于基线模型,模型的mIoU 提升了1. 12 个百分点。在此基础上,进一步添加残差注意力机制,mIoU 提高了1. 93 个百分点,最后引入ASPP 模块,模型的mIoU、OA 和mPA 分别提高了4. 13、1. 76、5. 5 个百分点,进一步验证了本文所提的3 个模块均可以有效提升遥感图像分割的精度。

为了更直观地比较各个模块对分割结果的影响,本文对消融实验结果进行了可视化,消融实验分割结果对比如图6 所示。从图6 可以看出,原始的Swin-Unet 模型存在着明显的漏分和错分问题,但随着Res_Swin、Res_SE 和ASPP 等模块的逐步引入,目标轮廓变得更加准确和清晰,模型的分割效果与真实标签更加接近,目标误分、漏分的现象也有所减少,这充分证明了本文所提模型能够有效地改善遥感图像分割的结果。

3. 2 模型对比实验结果与分析

为了验证本文所提模型的优越性,本文分别将测试图片输入到训练好的Unet、SegNet、DeeplabV3 +、Swin-Unet 以及本文所提模型中进行对比实验,并随机选择了几张预测图像进行了可视化,模型对比实验分割结果如图7 所示。模型对比实验除了改变网络模型外,其余实验条件均保持一致,包括数据集、数据增强方式等。

从图7 可以看出,Unet 能够基本还原物体轮廓,但存在较多噪声和多分类识别错误现象;相比之下,SegNet 表现有所提升,噪声和误分类现象得到一定改善;DeeplabV3 +能够识别更大的区域,噪声也有所减少,但在边缘轮廓识别方面仍有待提高;Swin-Unet 能够准确识别目标物体,但仍存在未被识别和错误识别的像素;而本文所提模型更接近真实标签,能够准确分割出更为精细的遥感目标,显著改善了目标错分和漏分现象,分割效果最佳。

为了客观评估不同方法对遥感图像分割效果的影响,本文通过3 个评价指标来对不同方法进行定量评估。各个方法的模型对比实验结果如表2 所示。

由表2 可知,本文所提的模型在各项评价指标中均取得了较大的提升。本文模型的mIoU 为80. 55% ,相比于其他模型分别提高了10. 54% 、6. 23% 、6. 73%和4. 13% ;OA 为91. 89% ,比其他模型分别提升了6. 6% 、4. 91% 、4. 42% 和1. 76% ;mPA 为90. 36% ,分别提升了10. 96% 、8. 62% 、7. 92% 和5. 5% ,提升效果显著。由此可以证明,本文提出的模型分割效果最好,验证了融合多尺度提取更细节的特征、引入残差减少过拟合、引入残差注意力机制关注重要特征的有效性,优化了遥感图像分割的效果。

4 结束语

本文提出了一种基于改进Swin-Unet 的遥感图像分割方法,并用于自建的遥感图像分割数据集,以解决遥感图像分割边界模糊、目标漏分等问题。在原有Swin-Unet 的基础上,引入ASPP 模块,融合不同尺度遥感图像特征,增大感受野;使用Res-SwinTransformer Block,不仅保留了原始特征信息,还有效防止了模型出现过拟合问题;在跳跃连接中引入残差注意力机制,增强重要特征信息,弱化冗余背景特征信息。实验结果表明,改进后的Swin-Unet 网络分割结果与真实标签更为接近,相比于其他模型,分割效果均有所提升,证明了本文所提模型的优越性和有效性。虽然本文所提方法取得了较好的提升效果,但Swin-Unet 模型复杂度较高。未来将进一步优化Swin-Unet 网络,降低其复杂度,并设计更加轻量化的网络模型。

参考文献

[1] WU Z H,GAO Y M,LI L,et al. Semantic Segmentation ofHighresolution Remote Sensing Images Using Fully Convolutional Network with Adaptive Threshold[J]. ConnectionScience,2018,31(2):169-184.

[2] WANG C,XU W,PEI X F,et al. An Unsupervised Multiscale Segmentation Method Based on Automated Parameterization [J]. Arabian Journal of Geosciences,2016,9(15):1-10.

[3] JIANG B D,AN X Y,XU S F,et al. Intelligent Image Semantic Segmentation:A Review Through Deep LearningTechniques for Remote Sensing Image Analysis [J ].Journal of the Indian Society of Remote Sensing,2023,51:1865-1878.

[4] 黄旭,张世义,李军. 图像分割技术研究综述[J]. 装备机械,2021(2):6-9.

[5] 闵蕾,高昆,李维,等. 光学遥感图像分割技术综述[J]. 航天返回与遥感,2020,41(6):1-13.

[6] 何瀚志,朱红,王竞. 基于聚类分析的医学图像分割综述[J]. 中国科技信息,2017(15):43.

[7] 王怡,涂宇,罗斐,等. 彩色图像分割方法综述[J]. 电脑知识与技术,2020,16(23):183-184.

[8] LU W Z,LIANG L X,WU X S,et al. An Adaptive Multiscale Fusion Network Based on Regional Attention for Remote Sensing Images [J ]. IEEE Access,2020,8:107802-107813.

[9] ZHANG L B,LI A X,LI X W,et al. Remote SensingImage Segmentation Based on an Improved 2D GradientHistogram and MMAD Model[J]. IEEE Geoscience andRemote Sensing Letters,2015,12(1):58-62.

[10] RONNEBERGER O,FISCHER P,BROX T. UNet:Convolutional Networks for Biomedical Image Segmentation[C]∥Medical Image Computing and Computerassisted InterventionMIGGI 2015. Munich:Springer,2015:234-241.

[11] ZHANG Z X,LIU Q J,WANG Y H. Road Extraction byDeep Residual UNet[J]. IEEE Geoscience and RemoteSensing Letters,2018,15(5):749-753.

[12] SU Z B,LI W,MA Z,et al. An Improved UNet Methodfor the Semantic Segmentation of Remote Sensing Images[J]. Applied Intelligence,2022,52(3):3276-3288.

[13] 黄杰,蒋丰. 遥感影像中建筑物的Unet 分割改进[J].计算机系统应用,2021,30(10):319-324.

[14] 傅励瑶,尹梦晓,杨锋. 基于Transformer 的U 型医学图像分割网络综述[J]. 计算机应用,2023,43 (5 ):1584-1595.

[15] CAO H,WANG Y Y,CHEN J,et al. SwinUnet:UnetlikePure Transformer for Medical Image Segmentation[C]∥Computer VisionECCV 2022 Workshops. Tel Aviv:Springer,2022:205-218.

[16] GAO Z J,CHEN L. Research on Semantic SegmentationMethod of Macular Edema in Retinal OCT Images Based onImproved SwinUnet[J]. Electronics,2022,11(15):2294.

[17] 张文康. 基于SwinUnet 的云分割算法的研究[J]. 仪器仪表用户,2022,29(4):5-9.

[18] YAO J Y,JIN S G. Multicategory Segmentation ofSentinel2 Images Based on the Swin UNet Method[J].Remote Sensing,2022,14(14):3382.

[19] CHEN L C,PAPANDREOU G,SCHROFF F,et al. Rethinking Atrous Convolution for Semantic Image Segmentation[EB/ OL]. (2017 -12 -05)[2023 -06 -06]. https:∥arxiv. org / abs / 1706. 05587.

[20] 姚庆安,张鑫,刘力鸣,等. 融合注意力机制和多尺度特征的图像语义分割[J]. 吉林大学学报(理学版),2022,60(6):1383-1390.

[21] HE K M,ZHANG X Y,REN S Q,et al. Deep ResidualLearning for Image Recognition[C]∥2016 IEEE Conference on Computer Vision and Pattern Recognition(CVRR). Las Vegas:IEEE,2016:770-778.

[22] HU J,SHEN L,SUN G. SqueezeandExcitation Networks[C]∥2018 IEEE / CVF Conference on Computer Visionand Pattern Recognition. Salt Lake City:IEEE,2018:7132-7141.

[23] SHENG G F,YANG W,XU T,et al. Highresolution Satellite Scene Classification Using a Sparse Coding BasedMultiple Feature Combination[J]. International Journal ofRemote Sensing,2012,33(8):2395-2412.

[24] ZHAO L J,TANG P,HUO L Z. Feature Significancebased Multibagofvisualwords Model for Remote SensingImage Scene Classification[J]. Journal of Applied RemoteSensing,2016,10(3):035004.

作者简介

张 越 女,(1998—),硕士研究生。主要研究方向:图像处理、计算机视觉。

王 逊 女,(1973—),硕士,副教授。主要研究方向:数据挖掘、软件工程、机器学习。