基于改进YOLOv7的转炉火焰燃烧状态检测研究

段志伟 邵女 豆全辉 徐武

基金项目:国家自然科学基金(批准号:51474069)资助的课题。

作者简介:段志伟(1980-),副教授,从事测控技术与仪器的研究。

通讯作者:邵女(1998-),硕士研究生,从事测控技术与仪器、目标检测等的研究,sn1830108173@163.com。

引用本文:段志伟,邵女,豆全辉,等.基于改进YOLOv7的转炉火焰燃烧状态检测研究[J].化工自动化及仪表,2024,

51(3):388-395.

DOI:10.20030/j.cnki.1000?3932.202403003

摘 要 针对某炼钢厂A号转炉炉膛火焰燃烧状态分析判定问题,提出基于改进YOLOv7深度学习网络架构结合视频火焰状态的判断方法。首先引入无参平均注意力机制(PfAAM),在不添加参数或超参数的情况下捕获通道注意力和空间注意力,并使用轻量化上采样算子(CARAFE)、功能的内容感知重组进行上采样,使YOLOv7网络获得更好的鲁棒性和准确性。优化后的网络,MAP_0.5值提升了2.4%,精确率提升了5.5%,帧率达到了51.5帧/秒。结合视频图像Matlab火焰状态分析方法,充分利用图像和特征信息增加了对火焰状态判断的可解释性和鲁棒性,并提高了算法的安全性和可信度。实验结果也表明改进算法能够有效提升对火焰燃烧状态识别的准确率和实时性。

关键词 深度学习 燃烧状态 火焰区域 注意力机制 转炉火焰 特征信息 火焰燃烧视频 Matlab

中图分类号 TP311.13;TH?39 文献标志码 A 文章编号 1000?3932(2024)03?0388?08

钢铁工业冶炼生产过程中,炼钢转炉是一种常用设备,转炉内燃烧火焰情况是燃烧状态是否稳定最直接的判断方式[1,2],转炉炉膛火焰燃烧的稳定性会直接影响炉膛燃烧的安全。在燃烧不稳定的情况下,燃烧效率极易降低,并伴随污染物、噪声等,甚至导致严重事故,危及人员和设备安全。因此,研究火焰识别以及火焰燃烧情况判断方法具有应用价值和意义。

在火焰检测中,常用的卷积神经网络包括CNN[3]、Faster RCNN[4]和YOLO系列,其中YOLO系列在提取图像的全局信息方面优于其他卷积神经网络,并且可以端到端进行训练,因此在火焰检测方面更具优势。但YOLO模型只能判断图像中是否存在火焰和火焰位置,无法提供火焰燃烧的详细信息,如火焰强度、燃烧程度或其他相关属性。要判断火焰的燃烧状态,需要更多的信息和专门的算法。因此,笔者以鞍钢建设集团有限公司炼钢总厂西区2150生产线A号260 t转炉为研究背景,提出一种改进的YOLOv7目标检测算法,在火焰状态判断部分,结合视频火焰燃烧状态Matlab判断方法,根据火焰颜色特征、火焰圆形度、火焰面积增长率及尖角特性等形态特征实现火焰检测和燃烧状态的判定[5,6]。

1 算法原理与关键技术

1.1 改进的YOLOv7网络

1.1.1 YOLOv7网络架构

YOLOv7网络由3部分组成:input、backbone和head(YOLOv7将neck层与head层合称为head层)。backbone用于提取特征,head用于预测。首先将输入图片预处理成640×640的RGB图片,然后输入到backbone网络,在head层通过backbone网络继续输出3层不同size的特征图像,经过Rep和Conv,输出最后结果。

1.1.2 实验数据与扩增

数据集扩增可增加训练数据的多样性,提高模型的泛化能力和鲁棒性,从而让模型更好地适应实际场景。

在Make Sense平台将现场获取的鞍钢建设集团有限公司炼钢总厂西区2150生产线A号260 t转炉火焰图像以及相似火焰图像数据集中的1 800张图片进行标注,以保证目标检测实验中火焰数据的多样性,提高转炉火焰检測的准确度。为提升YOLOv7深度学习模型的性能,通过增加训练数据规模,用图像旋转、随机剪裁、旋转、正向剪裁等数据扩增方式对原始火焰图像进行数据扩增(图1),并用变换、组合等方式生成新的数据样本,扩大原数据集,提高数据量,对处理前后的图像进行融合,共同构成扩增数据集5 400张。从图1可以看出,扩增后的每张图像基本都保持了原图像的关键信息。

1.1.3 无参平均注意力机制PfAAM和轻量化上采样算子CARAFE

一般来说,注意力机制可以分为通道注意力和空间注意力两种[7~9],或是两者的结合[10]。而这些注意力模块中的大多数都是在训练过程中添加可学习的模型参数实现的。作为现有模块的扩展,从图2所示的PfAAM原理可以看出,给定一个形状为H×W×C的输入特征图,PfAAM注意力机制将原输入特征图分两次进行平均池化[11],一种是通道注意力,另一种是空间注意力;然后将它们拉伸成原特征图尺寸,再将两特征图相乘并作用于原特征图。PfAAM注意力机制在不添加参数或超参数的情况下捕获通道和空间注意力,通过平均激活来促进自我强化效果。

CARAFE特征上采样是许多卷积网络架构中的关键操作,这种设计对于密集的预测任务至关重要。

CARAFE特征具有以下3个特点[12]:

a. 感受野大。CARAFE可以在一个大的接收域中聚合上下文信息。

b. 内容感知。CARAFE没有对所有样本使用固定的内核(如反卷积),而是支持特定于实例的内容感知处理,可以动态生成自适应内核。

c. 轻量级、计算速度快。CARAFE引入的计算开销很小,并且可以很容易地集成到现有的网络体系结构中。

CARAFE的整体框架如图3所示。CARAFE由两个关键组件组成,即内核预测模块和内容感知重组模块。在图3中,大小为H×W×C的特征图被上采样了σ(取值2)倍。

CARAFE作为一个内容感知的内核重组算子,由两个步骤组成:

a. 根据每个目标位置的内容預测重组核。

b. 与预测的检查特征进行重组,给定大小为H×W×C的特征图X和上采样率σ(假设σ是整数),CARAFE将生成大小为σH×σW×C的新特征图X′。对于输出X′的任意目标位置l′=(i′,j′)在输入X处都有对应的源位置l=(i,j),其中i=i′/σ,j=j′/σ。将

N(X,k)表示为以位置l为中心的X的k×k子区域,即X的邻居。

在步骤a中,核预测模块Ψ根据X的邻居预测每个位置l′的位置核W。假设上采样核尺寸k×

k(越大的上采样核代表着更大的感受野),如果要想在输出特征图不同位置使用不同的上采样核,那么期望的上采样核的形状就是σH×σW×

k×k,对于通道压缩器输出的特征图,使用一个

k×k的卷积层来预测上采样核。输入通道数为C,输出通道数为σ2k2,在空间维度展开为σH×σW×k,重组步骤公式化为以下方程式:

W=Ψ(N(X,k))(1)

X=?(N(X,k),W)(2)

其中,?是内容感知重组模块,将X的邻居与位置核W进行重组。

1.1.4 优化后的网络结构

优化后的网络结构如图4所示,使用SiLU激活函数,并加入PfAAM无参注意力机制,同时在head网络结构中采用新的CARAFE上采样,在保持特征丰富性和准确性的同时可以提高分辨率。

1.2 视频图像火焰状态分析原理

YOLOv7进行高效率火焰检测后,获取每个帧中火焰的边界框。将视频输入到本研究的Matlab检测系统中,通过火焰颜色特征、火焰尖角、面积增长率、圆形度等形态特征[13],可以进一步诊断转炉炉膛燃烧的状态。

1.2.1 火焰颜色特征

火焰燃烧时,颜色特征比较明显,火焰燃烧区域和背景图像有明显的视觉差异,因此可以用火焰的颜色特征判断火焰的燃烧状态。HSV色彩模型可以更好地反映人眼对颜色的认知,将颜色分为色调(Hue)、饱和度(Saturation)和亮度(Value)3个参数,HSV色彩模型还能更好地数字化处理颜色,因此本研究采用HSV色彩模型进行转炉火焰图像的色彩分析。

1.2.2 火焰圆形度特征

火焰圆形度是用来描述火焰形状的一个指标,它反映了火焰在平面投影上的圆形程度,火焰圆形度越高,表示火焰形状越接近圆形;反之,火焰圆形度越低,表示火焰形状越不规则或拉长了。

火焰圆形度的计算可以基于火焰的外轮廓进行。一种常用的计算方法是使用火焰外轮廓的周长L和火焰外轮廓所包围的面积A来计算圆形度c:

c=(3)

计算得到的圆形度值在0~1,值接近1表示火焰形状近似于圆形,接近0表示火焰形状不规则或拉长。

1.2.3 火焰面积增长率

火焰燃烧时,火焰面积的增长会有变大的正面积增长或是变小的负面积增长。根据当前帧中火焰像素总数与这段时间后另一帧火焰图像像素数的差值,可以计算出火焰在一定时间内的面积增长率,其结果可以作为下一步识别火焰燃烧情况的依据。火焰面积增长率通过计算火焰面积的区域增长率来表示,火焰面积的增长率可以用图像区域的像素变化率表示,因为图像中最小的组成部分是像素。在视频帧中,每一帧的图像形态对目标物体占据不同的区域,不同的形态具有不同的像素值,它可以通过像素的变化来反映目标区域的变化,然后目标区域的变化可以直接反映火焰面积的变化。在连续视频火焰图像中,通过计算前、后帧数来划分时间,设第i帧也就是第t时刻目标区域像素总值为E,则第i+j帧也就是第

t时刻的像素总值为E,再令第i帧区域的面积为S,第i+j帧区域面积为S,则连续视频图像中火焰的面积变化率ΔA的计算式为:

ΔA====(4)

注意:火焰的面积变化率ΔA的时间范围为t~t。

1.2.4 火焰尖角特性

因为火焰在燃烧过程中具有不稳定性,有很多尖角,并且尖角数目呈现无规则的跳动;而稳定光源的尖角数目不大,而且基本固定在一定的范围内,二者的差异比较大。因而可以利用火焰在燃烧过程中的边缘抖动现象特征,将火焰尖角数作为火焰燃烧情况的判据。

2 实验设计和结果分析

YOLOv7可以高效检测目标物体(包括火焰),但对燃烧状态的判断相对欠缺。因此,本研究采用YOLOv7对图像进行目标检测,识别出火焰区域,获取其位置信息。然后,结合传统火焰燃烧状态判断方法,分析形状特征进一步判断火焰燃烧状态,这样既可充分发挥各自的优势又提高了火焰燃烧状态判断的准确性和鲁棒性。

2.1 实验设置

实验代码在YOLOv7深度学习网络结构上进行改进。训练迭代次数(epoch)为300次,批次大小(batchsize)为8,初始学习率为0.01,采用随机梯度下降方法。

实验配置为Windows11,64位操作系统,Intel(R)Xeon (R)Gold6330 CPU@2.00 GHz, NVIDI

ADeForceRTX3090(24 GB)显卡,Pytorch 1.11.0 Cuda11.3深度学习框架,Python版本为3.8。

2.2 评价指标

将平均精度均值MAP_0.5(Mean Average Precision)、精确率P(Precision)、召回率R(Recall)和帧率FPS作为火焰识别检测模型性能的评价指标。

2.3 实验结果与分析

2.3.1 改进YOLOv7算法的实验结果

本次实验采用改进YOLOv7火焰检测算法,分别与Faster RCNN、SSD、YOLOv3、YOLOv5、YOLOv7网络模型算法在同一测试集上进行实验,结果见表1。分析表1可知,使用笔者模型相比于Faster RCNN、SSD、YOLOv3、YOLOv5、YOLOv7,平均精度均值MAP_0.5分别提升了21.1%、2.2%、8.0%、0.6%、2.4%。改进后YOLOv7算法的FPS高于其他火焰检测算法,达到51.5 帧/秒,满足火焰检测的实时性要求。

在300个训练迭代时,SiLU激活函数加上不同注意力机制的对比实验(表2)可以看出,相比于其他注意力机制,加入了PfAAM注意力机制的P值和MAP_0.5值最高,分别为87.3%和86.6%,P值和MAP_0.5值比原YOLOv7网络分别提升3.3%和0.7%。在进一步改进了上采样方法CARAFE后,P值和MAP_0.5值比原YOLOv7提升了5.5%和2.4%,总体提升了原YOLOv7网络提取图像特征的能力和检测精度。

如图5所示,优化后的网络MAP_0.5值和P值均好于原YOLOv7网络。

2.3.2 视频火焰燃烧状态判断GUI界面结果展示

图形用户界面(Graphical User Interface,GUI)能可视化计算机操作用户界面。笔者通过获取每帧图像火焰部分的颜色、圆形度、火焰面积增长率及火焰角点等特征,将火焰燃烧状态显示在GUI界面上,可进一步判断锅炉火焰燃烧的情况。

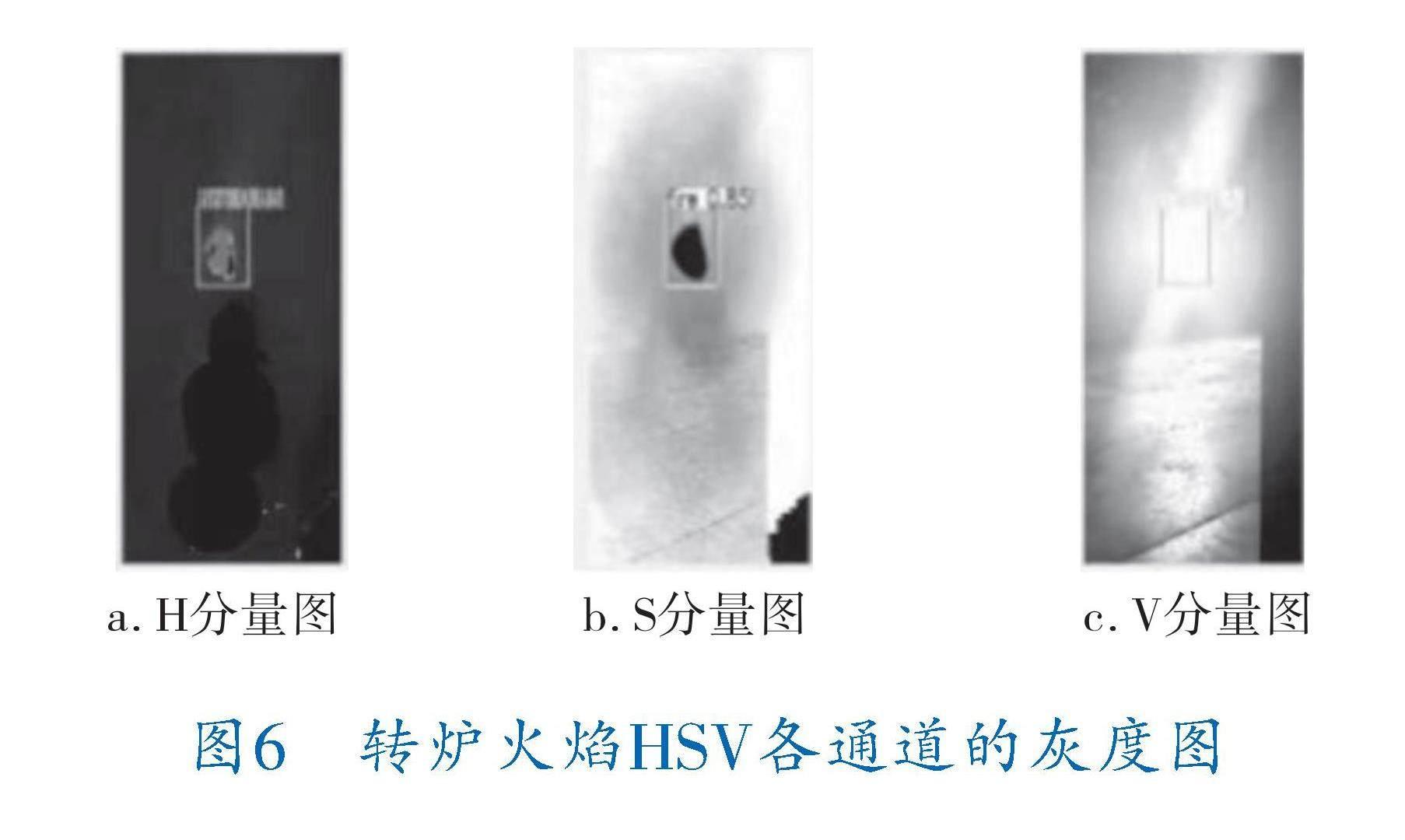

如图6所示,图片在HSV颜色空间比在RGB颜色空间中更便于理解和处理。

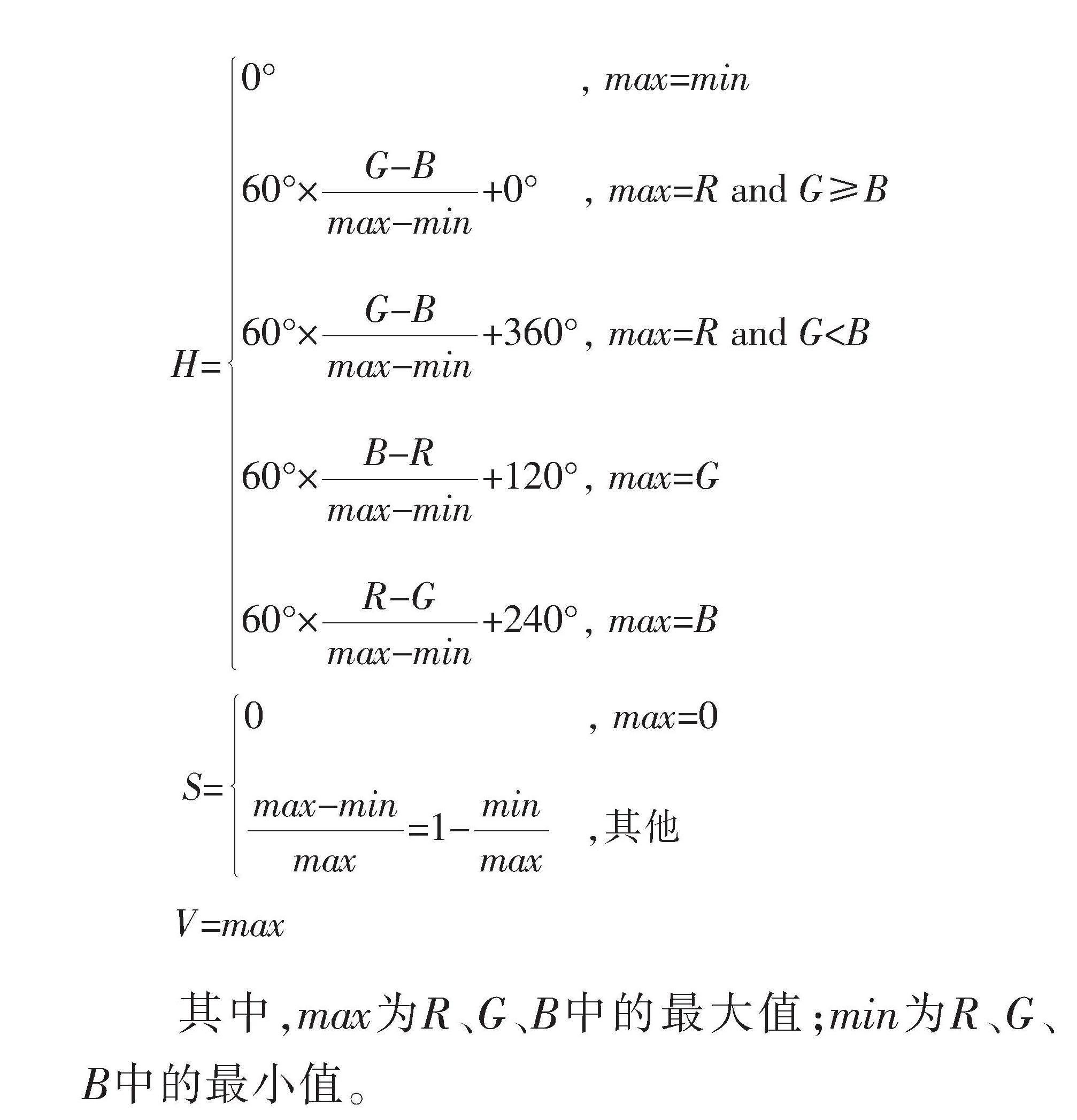

取视频里每一帧,根据转换公式将RGB图像转换到HSV色彩模型中,再将HSV各通道的图像转化为灰度图,简化图像处理和分析过程,同时保留有用信息。设(R,G,B)分别是一个颜色的红、绿和蓝坐标,其值是0~1之间的实数。RGB颜色空间转HSV颜色空间的转换公式为:

H=0° , max=min

60°×

+0° , max=R and G≥B

60°×

+360°, max=R and G 60°× +120°, max=G 60°× +240°, max=B S=0 , max=0 =1- ,其他 V=max 其中,max為R、G、B中的最大值;min为R、G、B中的最小值。 获取HSV颜色分量后,再对HSV图像设置红色阈值,提取红色分量进行上下帧的对比,如果上下帧均有红色分量就计算火焰的动态特征。 火焰是实时动态跳跃的,本研究Matlab程序设计当圆形度小于1并且面积增长率大于0时,表示有火焰在燃烧。火焰的圆形度和其他干扰物的圆形度明显不同,火焰燃烧的形态尖角多,而一般的灯光等干扰物的圆形度普遍大于火焰燃烧圆形度。而火焰的尖角数量要比其他干扰物大很多。因此,从火焰的圆形度和尖角数目可以很好地区分火焰和其他干扰物。火焰面积变化率则通过对火焰上下帧图像进行处理,计算出相邻两帧图像中火焰面积的变化率,当火焰面积变化率较大时,说明火焰处于燃烧状态;当火焰面积变化率较小或趋近于0时,说明火焰处于不燃烧状态或熄灭状态。 为了减小视频中的火焰图像受到噪声干扰,以及更好地捕捉火焰的动态特性,笔者将帧间隔设置为3。如图7所示,相邻两帧的火焰圆形度均小于1,并且火焰面积增长率大于0,角点数目较大,变化较小,火焰处于稳定燃烧状态。 3 结束语 通过改进的YOLOv7深度学习网络算法识别火焰区域,识别图像中的火焰位置、火焰数目及置信度等,准确检测并识别出火焰。再结合Matlab进行火焰的颜色特征、圆形度特征、面积增长率特征和角点特征分析,更准确地判断出无火焰、有火焰及稳定燃烧等火焰状态。实验结果也证实笔者方法不仅准确率高、鲁棒性强,同时增加了对火焰状态判断的可解释性和准确性。 参 考 文 献 [1] 周怀春,胡志方,郭建军,等.面向智能发电的电站燃煤锅炉在线运行优化[J].分布式能源,2019(3):7-15. [2] 戚凯旋,朱凌云.基于图像处理的燃气锅炉燃烧状态检测研究[J].自动化仪表,2021,42(11):34-38. [3] CHUNG Y L,CHUNG H Y,CHOU C W.Efficient flame recognition method based on a deep convolutional neural network and image processing[C]//2019 IEEE 8th Global Conference on Consumer Electronics(GCCE).2019:573-574. [4] CHAOXIA C Y,SHANG W W,ZHANG F.Information guided flame detection based on faster R?CNN[J].IEEE Access,2020,8:58923-58932. [5] 赵媛媛,朱军,谢亚坤,等.改进Yolo?v3的视频图像火焰实时检测算法[J].武汉大学学报(信息科学版),2021,46(3):326-334. [6] 沐小会,陈嘉卿,宋英磊.火焰特征提取研究在火灾探测中的运用[J].电子设计工程,2016(21):188-190. [7] JIE H,LI S, ALBANIE S,et al.Squeeze?andexcitation networks[C]//Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition.2018:7132-7141. [8] SANGHYUN W,JONGCHAN P,JOONYOUNG L,et al.Cbam:Convolutional block attention module[C]//Computer Vision?ECCV European Conference.LNCS,2018:112-118. [9] WANG Q L,WU B G,ZHU P F,et al.Eca?net:Efficient channel attention for deep convolutional neural networks[C]//IEEE Conference on Computer Vision and Pattern Recognition(CVPR).2020:11534-11542. [10] OKTAY O,SCHLEMPER J,FOLGOC L L,et al.Attention u?net:Learning where to look for the pancreas[J].arXiv Preprint arXiv:1804.03999,2018. doi.org/10.48550/arXiv.1804.03999. [11] KORBER N.Parameter?Free Average Attention Improves Convolutional Neural Network Performance(Almost)Free of Charge[J]. arXiv:Computer Science,arXiv:2210.07828,2022.https: //arxiv.org/pdf/ 2210.07828.pdf. [12] WANG J Q,CHEN K,XU R,et al.CARAFE:Content?Aware ReAssembly of FEatures[C]//ICCV 2019 Oral Presentation.2019.https://arxiv.org/pdf/1905.02188v2. [13] 缪存可,杨炼,姜玥颖.基于神经网络的视频图像火焰检测方法[J].自动化应用,2021(4):71-74. (收稿日期:2023-09-18,修回日期:2024-04-16) Research on Flame Combustion Detection of the Converter Based on Improved YOLOv7 DUAN Zhi?wei1, SHAO Nv1, DOU Quan?hui1, XU Wu2 (1. School of Physics and Electronic Engineering, Northeast Petroleum University; 2. Angang Construction Group Co., Ltd.) Abstract Aiming at analyzing and judging flame combustion of No. A converter furnace in a steel mill, a judgment method based on improved YOLOv7 deep learning network architecture and video flame state was proposed. Firstly, having a parameter?free average attention mechanism(PfAAM) introduced to capture channel attention and spatial attention without adding parameters or hyperparameters, including having a lightweight up?sampling operator (CARAFE) and functional content?aware recombination adopted to upsample the YOLOv7 network so as to achieve better robustness and accuracy. In the optimized network, the MAP_0.5 value can be increased by 2.4%, the precision value increased by 5.5%, and the frame rate reached 51.5 frames per second. Through combined with video image Matlab flame state analysis method, both interpretability and robustness of the flame state judgment can be increased by making full use of image and feature information, and both security and reliability of the algorithm were improved. The experimental results also show that the improved algorithm can effectively improve both accuracy rating and real time recognition of flame combustion state. Key words deep learning, combustion state, flame region, attention mechanism, converter flame, characteristic information, video of flame combustion, Matlab