改进 Faster RCNN with FPN 的素布瑕疵检测的算法研究

马政 生鸿飞

摘要:纺织行业中的布匹检测仍存在采用人工检测的情况,人工检测效果受工人主观影响较大,易发生检测效率的降低和瑕疵的漏检误检。针对这种现状,探究素布瑕疵检测的算法,改进Faster RCNN with FPN目标检测算法。首先,为了提升Faster RCNN with FPN对于多尺度特征的融合能力,丰富各个特征层的上下文信息,引入跨尺度特征融合模块来改进特征金字塔网络结构。其次,为了更好的利用深层特征,加入尺度内特征交互模块来处理ResNet50输出的深层特征层,丰富高级特征层的语义信息。然后,为了增强对于极端尺寸瑕疵目标的检测能力,使用K-means++聚类和遗传算法,改进预设锚框。最后,由于素布瑕疵的尺寸较小,为了平衡正负样本,采用Focal Loss,增加对于素布瑕疵的检测效果。经过实验,使用CO- CO指標进行评价,该改进后的网络模型与Faster RCNN with FPN相比,在mAP50、mAP75和mAP50:95指标上分别提升6.5%、4.4%和4.0%,平均准确率有了明显提升,可以更好地完成素布瑕疵的检测任务。

关键词:素布瑕疵检测;更快的区域卷积神经网络;改进特征金字塔网络结构;重新设计锚框;焦点损失

中图分类号:TS107.3 文献标志码:A 文章编号:2097-2911-(2024)02-0084-13

Research on algorithm for improving Faster RCNN with FPNfor plain cloth defect detection

MA Zheng,SHENG Hongfei

( School of Mechanical Engineering and Automation, Wuhan Textile University, Wuhan 430073, China)

Abstract:In the textile industry, manual detection is still used for cloth inspection. The effect of manual detec- tion is greatly affected by workers' subjectivity, leading to reduced efficiency and missed or erroneous detection of defects. To address this situation, the algorithm of plain cloth defect detection is explored to improve Faster RCNN with FPN target detection algorithm. Firstly, in order to improve the fusion capability of Faster RCNN with FPN for multi-scale features and enrich the context information of each feature layer, the cross-scale fea- ture fusion module is introduced to improve the feature pyramid network structure. Secondly, in order to make better use of deep features, the intra-scale feature interaction module is added to process the deep feature layer output by ResNet50, and enrich the semantic information of the high-level feature layer. Then, in order to en- hance the detection capability for defects of extreme sizes, preset anchor boxes are improved by using K- means++ clustering and genetic algorithms. Finally, considering the small size of plain fabric defects, FocalLoss is used to balance the positive and negative samples to increase the detection effect of plain cloth defects. Through experiments, the COCO index is used for evaluation. Compared with Faster RCNN with FPN, the im- proved network model increases by 6.5%, 4.4% and 4.0% on the mAP50, mAP75 and mAP50:95 indexes, respective- ly. The average accuracy has been significantly improved, which can better complete the detection task of plain cloth defects.

Keywords: flaw detection of plain fabric;Faster RCNN;improved feature pyramid structure;redesigning an- chor box;Focal Loss

我国已经成为纺织品的生产强国,截至到去年,我国规模以上纺织企业营业收入47009亿元,利润总额1802亿元,同比增长7.2%[1]。随着纺织行业的蓬勃发展,行业在解决产量问题的基础上,对生产布匹质量的要求越来越高。产品检测是保证产品质量的重要环节,产品质量关系产品在市场上的销售份额,面料产生瑕疵会使其价格降低45%~65%,因此需要好的检测工艺来有效评估产品质量[2]。现行业中仍存在采用人工进行布匹瑕疵检测的情况,一般来说人工验布的速度为10~20 m/min[3], 这种人工检测长时间会使工人出现疲劳,导致检测效率降低和漏检误检,同时增大企业人工成本,无法满足工厂大批量生产的实际需求[4]。因此,采用自动化检测代替工人人眼检测,对布匹的工业生产有着重要的意义。

传统的布匹瑕疵检测算法主要有两种:频域算法和空间域算法[5]。频域算法将图像转换到频域进行处理,适用于背景简单的纯色布匹上的边缘缺陷和破洞等瑕疵的检测,但是其计算复杂度较高。空间域算法直接计算和分析图像的灰度值,提取图像的特征信息,进行相应的瑕疵检测。该算法可以检测由于断线和针头断裂等原因造成的复杂纹理布匹上的表面瑕疵,但空间域算法易受图像中存在的噪声影响。

在进行布匹瑕疵检测过程中,传统的计算机视觉算法易受布匹的纹理和厂区车间光线条件等各种因素干扰,导致检验准确率低。近年来,受益于计算机硬件性能的显著提升和大量有用工业信息的收集,深度学习发展迅速,工业生产方向的人工智能得以快速发展,广泛应用到各行业的实际生产中来。在布匹瑕疵检测方面,深度学习算法和工人人眼检测相比,具备了优秀的自动化特性,同时相比于传统的瑕疵检测算法,具有更好的通用性和鲁棒性,应对多种瑕疵的检测时,检测的精准度更高。

以Faster RCNN[6]系列为代表的二阶段目标检测算法和以 SSD[7]、YOLO系列[8]和RetinaNet[9]等为代表的单阶段目标检测算法的出现,布匹表面瑕疵检测项目迎来了更加可靠的方案。 CHEN等人[10]为了解决织物纹理干扰问题,改进了 Faster RCNN 模型,将 Gabor 核嵌入到 Faster RCNN模型中,设计了一种基于遗传算法和反向传播的两阶段训练方法来训练新模型,并对模型进行了广泛的实验验证,实验结果表明提出的新模型在精度方面优于Faster RCNN模型。XIE等人[11]在 SSD网络的基础上,在网络中加入FCSE block提升检测精度,调整默认锚框以适用更多条状瑕疵的检测,并在 TILDA 和雪浪数据集上实验,证实该算法的有效性。SHI 等人[12]改进 YOLO5,提出了YOLO-GFD织物瑕疵检测模型来提升检测速度和准确性,满足工业环境中实时织物瑕疵检测的要求。QIN 等人[13]针对 Reti- naNet在小规模织物数据集上检测效果较差的问题,基于 RetinaNet 构建网络结构,得到新模型 FSR,通过实验与baseline RetinaNet相比,说明新算法有更好的检测性能。

两类目标检测算法相比,通常二阶段检测算法具有更高的检测精度和更复杂的计算量,单阶段检测算法具有更快的检测速度和相对更低的检测精度。因此,在进行瑕疵检测时要合理地选择目标检测算法来完成工业检测任务。本文针对具有较小尺寸和极端长宽比瑕疵的素布,需要更高的检测精度来完成对于素布表面瑕疵的检测,因此选用Faster RCNN系列目标检测算法来实现检测任务。

本文针对具有较小尺寸和极端长宽比瑕疵的素布,需要检测精度更高的模型来完成对于素布表面瑕疵的检测,因此选用Faster RCNN系列目标检测算法来实现检测任务。

1算法原理与改进

1.1 Faster RCNN with FPN 网络结构

1.1.1特征提取主干网络

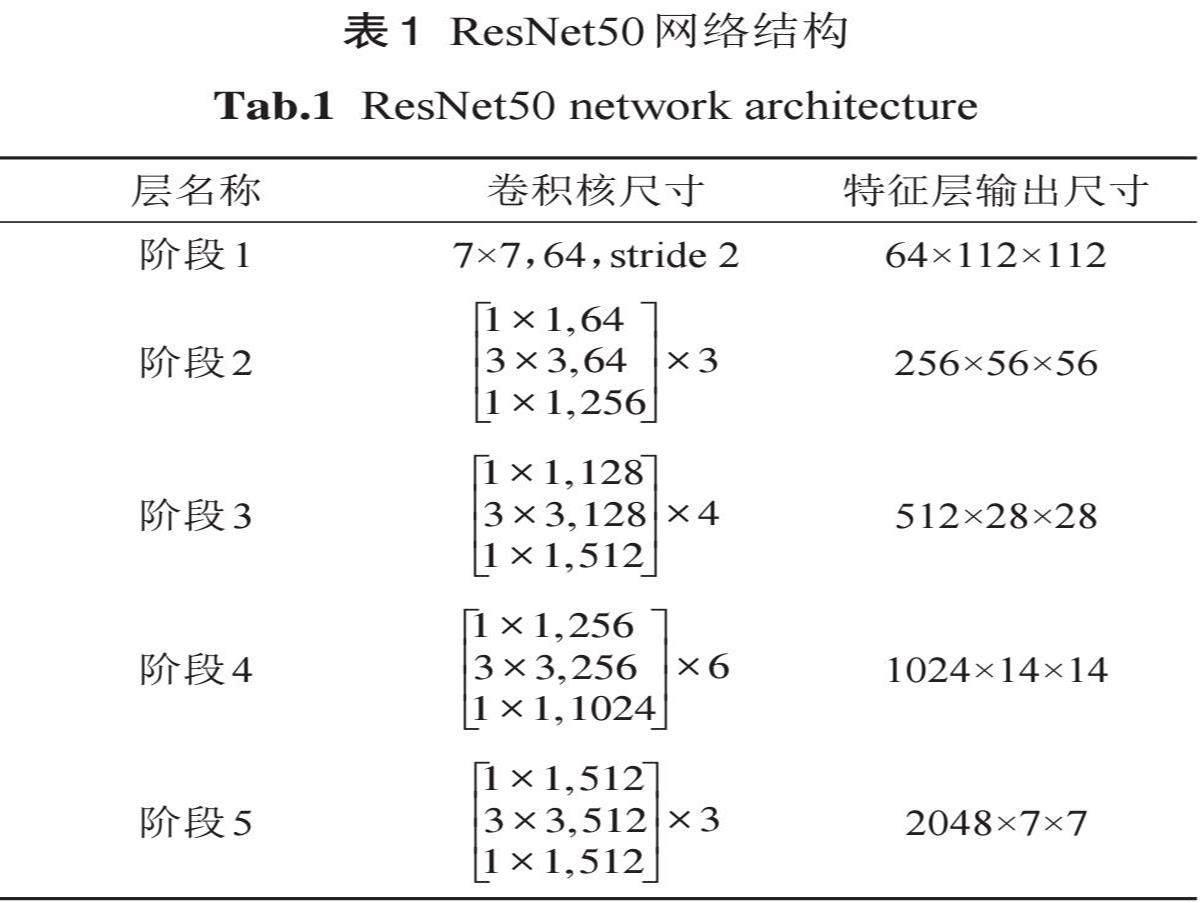

区别于原始 Faster RCNN 的特征提取主干网络选用VGG16[14],Faster RCNN with FPN的特征提取主干网络选用ResNet50[15],ResNet50的网络结构如表1所示,这种主干网络的阶段2到阶段5是由残差模块构成的,每个残差模块中由若干残差块组成,这种结构有效地缓解了梯度消失和模型退化,能够更好地提取图像特征,增强了主干特征提取网络的鲁棒性。

1.1.2特征金字塔网络结构

Faster RCNN with FPN基于Faster RCNN引入特征金字塔网络(Feature Pyramid Network, FPN)[16],FPN 结构如图1所示,这种网络结构具备多层特征,能够根据检测目标尺寸大小选择相应的特征层级。当检测大尺寸瑕疵目标时,网络利用较大的感受野进行检测;而对于小尺寸瑕疵目标,则采用较小的感受野,从而提高小目标瑕疵的检测准确度。

Faster RCNN with FPN 使用 ResNet50主干网络来构建 FPN 。Faster RCNN with FPN 通过 FPN结构提取并融合不同深度和尺度的特征层,从而得到语义更加丰富的特征图,其FPN结构如图2所示。

1.1.3区域建议网络

RPN通过对比真实值和预测值,通过二值交叉熵损失计算目标预测概率损失,通过 smooth L1损失计算预选框边框回归损失。

RPN是一个全卷积网络,主要用于在待检测图像中提取候选区域。它以原始图像的特征图作为输入,在每个特征点上生成多个原始锚框。这些原始锚框用于判断框内是否包含目标,并对包含目标的原始锚框进行边界回归操作,RPN初步产生大约2000个的proposal 。区域建议网络通过对比真实值和预测值,通过二值交叉熵损失计算目標预测概率损失,通过 smooth L1损失计算预选框边框回归损失。

1.1.4 RoI Align

在原始的Faster RCNN中,RoI Pooling的主要作用是将前面步骤提取出来的不同尺寸的素布瑕疵特征层转化为尺寸一致的特征图,并输送到后面网络,用于素布表面瑕疵的分类和预测框的回归。在RoI Pooling过程中有两次量化取整操作,对于小尺寸的瑕疵目标会产生较严重的定位精度偏差。

针对ROI Pooling过程中由两次量化取整得到的最终特征图与原始图像中检测目标位置之间的不匹配问题,结合Mask RCNN的设计思想[18], Faster RCNN with FPN 使用 RoI Align 来代替传统的 ROI Pooling,以得到更精准的特征图。 RoI Align以消除量化取整操作带来的定位精度误差为出发点,采用双线性差值算法获取候选框的位置坐标,将原来的量化操作由线性操作的方法代替。

1.1.5 目标分类和边框回归

Faster RCNN with FPN 网络对 RoI Align 层得到的统一尺寸的特征图进行目标分类和边框回归。在训练中通过梯度下降算法,调整网络权重,以降低损失函数的值,来提升对于素布瑕疵的检测精度。其中瑕疵目标分类采用交叉熵损失来计算,输入真实标签和预测标签,交叉熵损失函数的表达式如式(1)。

式中:M为类别数量;yic 为样本 i关于类别c的标签,当样本i真实类别和c相等,yic 取1,否则取0; pic 为样本i属于类别c的概率。

边框回归损失采用 smooth L1损失来计算, smooth L1损失的表达式如式(2)—(3)。

式中:f(xi)为样本 i的预测值;yi 为样本 i的真实值。

1.2改进特征金字塔网络结构

1.2.1 RT-DETR检测模型

DETR(Detection Transformer)[19]是由 Face- book AI研究团队提出的一种端到端的目标检测模型,它利用了 Transformer 架构的强大能力来解决目标检测问题。

区别于传统的目标检测方法,DETR使用了更简洁、更直观的方式来解决检测问题,它引入对象查询(object queries)的概念,将目标检测问题转化为一个对象查询问题。

RT-DETR(Real-TimeDetectionTransformer)[20]是由百度飞桨的Paddle Detection团队提出的一种实时目标检测模型,旨在对DETR进行改进,提高 DETR 的推理速度。它设计了一个高效的混合编码器,编码器由跨尺度特征融合模块和尺度内特征交互构成,以高效地处理多尺度特征,减少不必要的计算。

1.2.2跨尺度特征融合模块

跨尺度特征融合模块(Cross-Scale Feature Fusion Module,CCFM)是一种轻量级的跨尺度特征融合模块,它在RT-DETR中的结构图如图3所示。它可以将不同尺度的特征通过融合操作整合起来,增强输出特征层的语义丰富度,提升对于中小尺寸目标的检测能力,减少了漏检和误检的情况。

在 CCFM 中使用融合模块(fusion block)来实现两个相同尺寸维度的不同特征层之间的特征融合。融合模块的结构如图4所示,融合模块结构为残差结构,其中RepVggBlock由卷积核为3×3和卷积核为1×1两个卷积层构成,在RT-DE- TR中使用3层RepVggBlock。

1.2.3尺度内特征交互模块

尺度内特征交互(Intra-scale Feature Interac- tion,AIFI)模块是由一层 Transformer 的 Encoder 结构构成的,利用自注意力机制来处理图像中的高级特征,它的结构示意图如图5所示。

使用AIFI模块来获取图像中的高级特征并对其进行处理操作,得到这些概念实体之间的联系,这些被处理的特征通常含有丰富的语义信息,包括目标的位置、大小、形状以及与其它目标间的关系。

1.2.4新的特征金字塔网络结构

本文使用CCFM构建新的FPN结构,并基于 AIFI 模块的思想,使用一层 Transformer 的 En- coder 结构处理特征提取主干网络中的深层信息,本文改进的网络结构图如图6所示, 其中 CCFM内的融合模块使用2层RepVggBlock。

如图6所示,特征提取主干网络ResNet50阶段2到阶段5输出的特征层先经过通道数统一操作,再输入CCFM,其中阶段5输出的特征层在进入CCFM前,先输入AIFI模块,提取高级特征语义信息。随后CCFM输出P2到P5等4个预测特征,其中P5预测特征层通过卷积核为1×1,步长为2的最大池化操作得到P6特征层。

1.3锚框设计

1.3.1 K-means++聚类算法改进

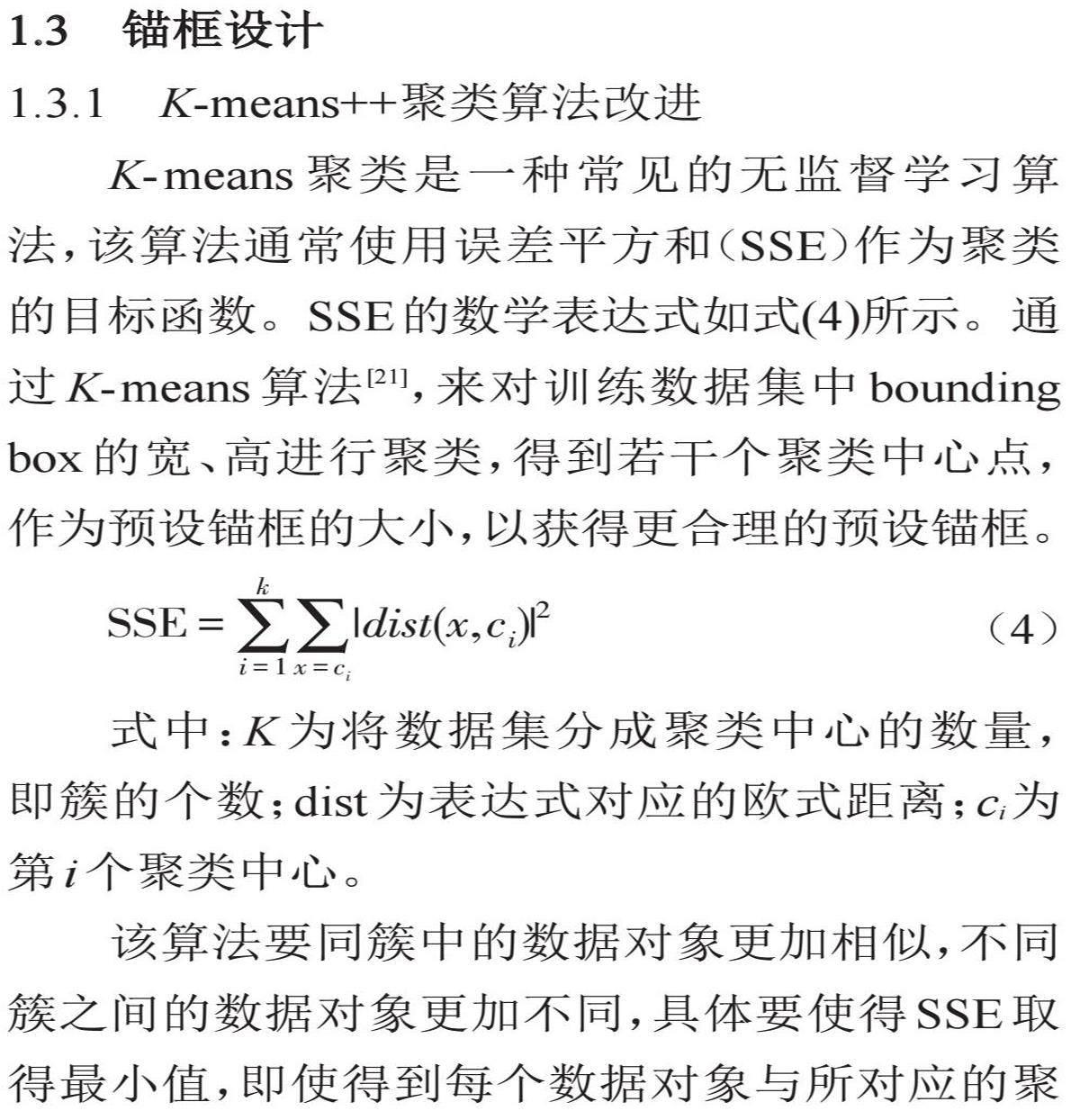

K-means 聚类是一种常见的无监督学习算法,该算法通常使用误差平方和(SSE)作为聚类的目标函数。SSE的数学表达式如式(4)所示。通过K-means 算法[21],来对训练数据集中bounding box的宽、高进行聚类,得到若干个聚类中心点,作为预设锚框的大小,以获得更合理的预设锚框。

式中:K 为将数据集分成聚类中心的数量,即簇的个数;dist为表达式对应的欧式距离;ci 为第i个聚类中心。

该算法要同簇中的数据对象更加相似,不同簇之间的数据对象更加不同,具体要使得 SSE取得最小值,即使得到每个数据对象与所对应的聚类中心之间的平方欧氏距离之和的最小值。

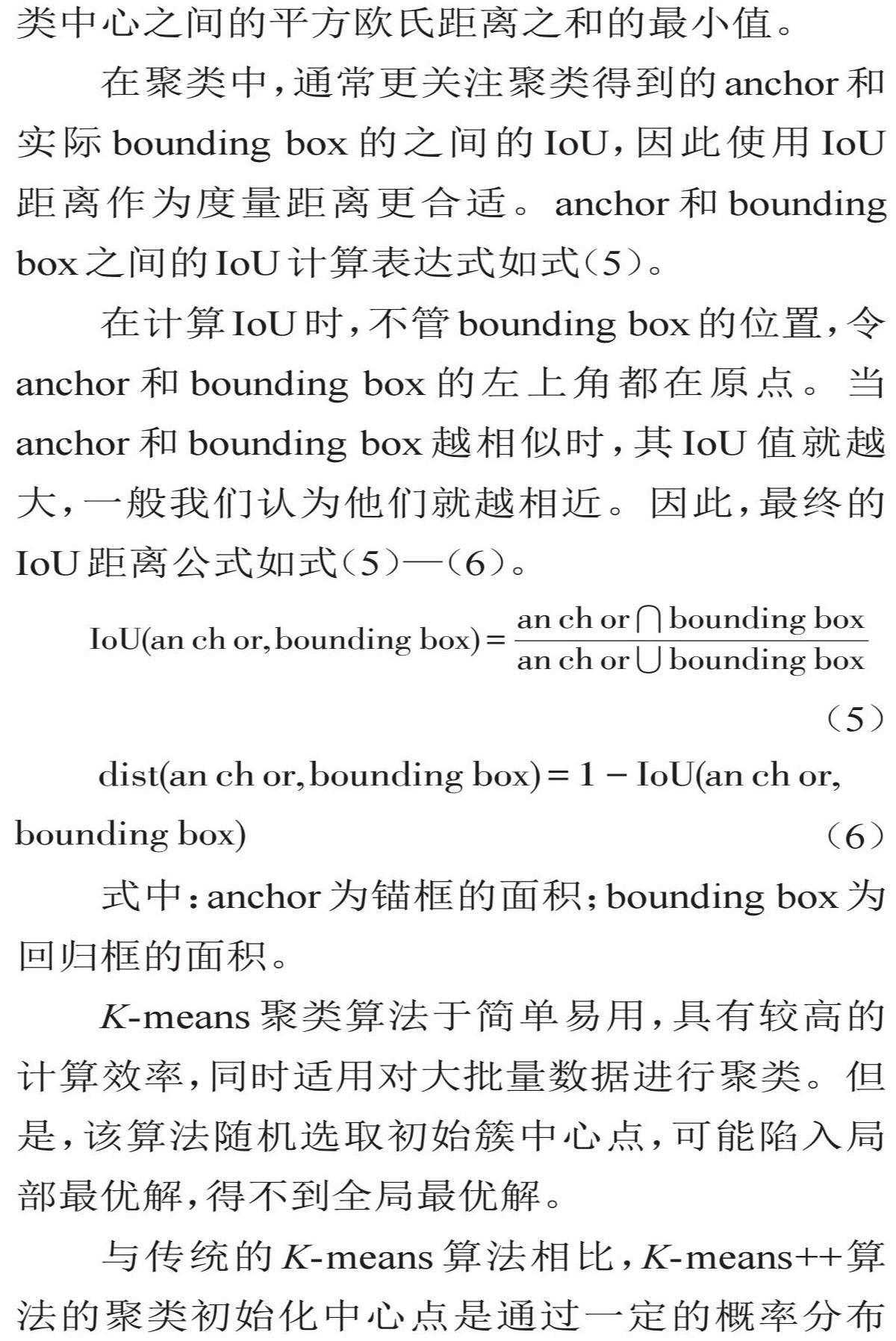

在聚类中,通常更关注聚类得到的anchor和实际 bounding box 的之间的 IoU,因此使用 IoU 距離作为度量距离更合适。anchor 和 bounding box之间的IoU计算表达式如式(5)。

在计算IoU时,不管bounding box的位置,令 anchor 和 bounding box 的左上角都在原点。当 anchor 和bounding box 越相似时,其 IoU 值就越大,一般我们认为他们就越相近。因此,最终的 IoU距离公式如式(5)—(6)。

式中:anchor为锚框的面积;bounding box为回归框的面积。

K-means 聚类算法于简单易用,具有较高的计算效率,同时适用对大批量数据进行聚类。但是,该算法随机选取初始簇中心点,可能陷入局部最优解,得不到全局最优解。

与传统的K-means 算法相比,K-means++算法的聚类初始化中心点是通过一定的概率分布方式选取的,能够避免随机选取的不良影响,从而得到更好的聚类结果[22]。

本文为了更好地检测具有极端长宽比的素布瑕疵,使用 IoU 距离代替欧式距离,采用 K- means++代替传统的K-means 聚类算法进行聚类,通过遗传算法对聚类的 anchor 结果进行处理,随机对一些 anchor的宽和高进行改变,即进行变异,以适应度(Fitness)和召回率(best possi- ble recall)作为评价标准,得到比之前好的变异结果就赋值给 anchor,差的变异结果就忽略,共变异1000次。

1.3.2重新设计预设锚框

本文的K-means++算法使用 IoU 距离来计算聚类中心,在训练集上分别使用K值为2到13的聚类中心数量进行聚类,计算其平均 IoU 值,如图7所示。如图所示,横轴代表从2到13不同的K值,纵轴代表了各个K值对应的平均 IoU值。

手肘法是判定选取最佳K值的常用方法[23],通过观察平均IoU折线图,选取使得平均IOU的斜率产生明显变化的K值。当K=8时其上升幅度较大,且随着K值的增加,折线上升幅度逐渐平稳,因此,最佳聚類数K选取为8。

使用遗传算法对聚类结果操作,以适应度和召回率作为评价,结果如表2所示。由表可知,使用遗传算法,聚类效果略有增加。

在Faster RCNN中,预设锚框比例共有3种,分别是0.5、1.0和2.0,预设锚框尺寸有5种,分别是32、64、128、256、512,分别对应5个预测特征层。设定K=8,根据多次计算聚类结果,选取8种预设锚框比例,分别是0.11、0.2、0.41、1.0、2.18、3.76、6.7和25.0,预设锚框尺寸仍使用最初的5种来对应5个预测特征层。

1.4 Focal Loss

在 Faster RCNN with FPN 目标检测模型的 RPN网络中,使用二分类交叉熵损失函数来计算目标损失值。该损失函数表达式如式(7)。

式中:y ′为模型预测为正样本的概率;y 为样本的真实值。

对于正样本来说,模型预测的概率值越大,则交叉熵损失值越小,而对于负样本来说,模型预测的概率值越小,则交叉熵损失值越小。对于当训练集中,产生预测框中负样本数量远多于正样本时,模型可能会倾向于将所有样本都预测为负样本减小总体损失,这对于正样本的预测非常不利,也是交叉熵损失导致模型性能不佳的原因之一。

焦点损失(Focal Loss)是为了解决单阶段目标检测算法中正负样本不平衡以及难易样本不平衡的问题而提出的[9],而在素布的瑕疵检测中,因为瑕疵目标尺寸较小,也会存在候选框正样本和负样本之间比例极不平衡的问题。

Focal Loss是在交叉熵损失函数上经过修改得到的,具体公式如式(8)。

式中:α为平衡因子;γ为可调节因子,γ>0。

当γ>0时,通过减少容易分类样本的损失,来使得检测网络模型更关注困难样本,平衡因子α用来平衡正负样本的比例失衡。

本文采用 Focal Loss 函数来代替 RPN 网络中的二分类交叉熵损失函数,其中参数平衡因子α为0.25,可调节因子γ为2。

2实验

2.1数据集构建

本文所使用的数据集是佛山南海某纺织车间采集而来的素布数据集[24]。该数据集共5913张素布瑕疵图片,包含尺寸不一的34种瑕疵,其中一个图片可能包含一种或者多种类别的素布瑕疵。本文采用类似VOC格式的数据集,将这些瑕疵按照瑕疵形态和形成原因进行合并分类,得到20种瑕疵类别,将其的类别名改为1到20,得到表3。

由表3可知,三丝、结头和粗维等瑕疵数量在总体瑕疵数量中占比较大,各个瑕疵的分布较不平衡,为了训练达到理想效果,通过数据增强扩充数据规模。

本文为避免数据失真,保证数据集的尺寸比例不变,对数据集进行水平翻转和旋转180°等操作,将数据集扩展为原数据集规模的3倍,其中,对训练集、验证集和测试集按照6:2:2进行划分。2.2图像预处理

对输入模型的数据集图像进行预处理。训练数据集的图像原始尺寸的通道数、高和宽分别为3、1000、2446,经过图像缩放,得到新图像的尺寸为3、544、1333。

对缩放后的图像进行图像标准化处理,图像标准化的公式如式(9)—(11)。

式中:yi 为输出图像的像素值;xi 为输入图像的像素值;xmean 为输入图像像素的均值;s 为输入图像像素的标准差;

为了在训练时充分利用预训练模型,对缩减后的图像进行图像标准化时,选用在ImageNet数据集上得到的均值和标准差,其中均值为[0.485, 0.456, 0.406],标准差为[0.229, 0.224, 0.225]。图8为原图和其经过图像标准化处理后,使用 cv2显示的图像。

2.3模型训练

2.3.1训练环境

本文的 Faster RCNN with FPN 及其改进目标检测模型采用云服务器训练,其操作系统为 ubuntu 18.04,编程语言选用python3.8,深度学习框架采用pytorch1.7.0,所用的具体硬件参数如表4所示。

2.3.2训练方式

为了避免训练模型从头开始,减少训练时间和硬件资源成本,增加网络的训练的收敛速度,提升网络的训练效果,本实验使用迁移学习的方式进行训练[25],使用在 ImageNet 训练得到的 ResNet50预训练权重进行训练。

本文对于 Faster RCNN 的训练通过近似联合训练(approximate Joint Training)来完成,这种训练方法在一次前向和反向传播过程中同时计算RPN和Fast RCNN的损失,实现了高效的端到端训练,提高了训练效率,有助于模型在目标检测任务中取得更好的性能。

2.3.3训练超参数

设置训练和验证的参数,优化器选用 SGD 优化器,学习率调整策略选用余弦退火[26],学习率设置为0.0055,衰减权重为0.0005,训练和验证的batch size均设置为16,共训练55个 epoch,为了减缓模型训练时的震荡,加快模型收敛速度,第一个epoch使用Warmup预热学习率。

2.4评价指标

为了充分验证对模型改进的有效性,需要一套有效的评价指标来对模型进行评估,本实验选用Microsoft COCO数据集中的 COCO指标来评估模型,该指标广泛应用于图像分割和目标检测任务。

本文为了更直观地评估目标检测模型性能,对个别类别进行评估时使用 AP(Average Preci- sion)表示平均精度,对全部类别进行评估时使用 mAP(Mean Average Precision)表示各类别AP的平均值。其中,对于单个类别来说,AP是Preci- sion-Recall曲线(即PR曲线)与坐标轴围成的面积,用于衡量检测算法在该类别上的准确率。其中精确率(Precision)和召回率(Recall)的计算公式如式(12)—(13)。

式中:TP为模型正确预测正例目标的个数;FP为模型错误预测为正例目标的个数;FN为模型错误预测为负例目标的个数。

本文使用mAP50、mAP75、mAP50:95和AP50等指标,对不同模型进行对比和评估。其中,mAP50指在 IoU=0.50阈值下的平均精确率,mAP50和 mAP75分别指在 IoU=0.50和 IoU=0.75阈值下的各类别AP的平均值,mAP50:95指从0.50到0.95不同IoU阈值下的各类别AP的平均值。

2.5实验结果分析

本文使用 Focal Loss 损失函数来计算 RPN 网络的目标损失,在改进的Faster RCNN的训练过程中,其网络总的训练平均损失和 Faster RCNN中各个损失函数的训练平均损失变化如图9所示。

观察图8,总的平均损失在[2,3]之间损失值上升,分析可知,在此区间内,因为Fast RCNN网络的分类损失(classifier loss)和边界框回归损失(box regression loss)都在上升,同时RPN网络的 Focal Loss的损失值相对于原来的二值交叉熵损失值较低,导致总的平均损失上升,在迭代次数大于3后,网络训练的总体损失值快速下降。

分析总的平均损失变化,在前40次迭代中,网络总的平均损失值迅速减小,当迭代次数达到45次时,总的平均损失曲线逐渐趋于平稳。

为了验证本算法的有效性,选择4种目标检测模型,均使用预训练模型,输入网络的图像尺寸统一缩放为3、544、1333,各模型分别使用验证集上效果最好的模型参数在测试集上进行测试,其实验结果如表5。

本章实验的Baseline选用Faster RCNN with FPN目标检测模型,除了更改指定网络结构或参数以外,本文不做其他任何操作,共训练55轮,得到各个改进模型在验证集上得到的mAP50变化曲线如图10。

由上圖可知,改进的模型相比Faster RCNN with FPN的检测性能提升较多。每个模型分别使用其在验证集上取得最好效果的模型参数,在测试数据集上进行测试,结果如表6所示。

由表6可知,本文的4种改进方法都提升了网络的检测精度。引进 CCFM 结构改进 Faster RCNN with FPN的FPN结构对于精度提升最多,其 mAP50、mAP75和 mAP50:95都分别提升了4.7%、3.0%和3.3%,说明构建新的 FPN 结构对提高检测模型的精度十分关键。引进AIFI模块继续改进 FPN 结构,mAP75和 mAP50:95分别提升了0.6%和0.3%,证明AIFI结构对于Faster RCNN这类二阶段检测模型提升精度有一些帮助。重新设计锚框,mAP50、mAP75和mAP50:95分别提升了0.4%、0.7%和0.4%,说明重新设计锚框有助于网络模型检测尺寸不一的素布瑕疵。在使用Focal Loss 替换RPN网络中的二值交叉熵损失后,mAP50提升了1.2%,表明平衡正负样本有利于提升对于素布瑕疵的检测精度。

本文针对10类具有不同形态特征的常见瑕疵进行检测,改进算法和Faster RCNN with FPN 对于选定的10类素布瑕疵检测精度AP50的对比如图11。

观察上图可知,本文改进算法相对于原始的Faster RCNN with FPN来说,对于具有较大长宽比的瑕疵类别,如6、10、11、20等瑕疵类别,精度均有较大提升,说明重新设计锚框有利于检测宽高比较大的目标。而改进算法对于 Faster RCNN with FPN检测较困难的瑕疵类别提升较大,尤其是10、13、18等瑕疵类别,其精度AP50值分别提升了20.10%、8.03%和8.99%,说明改进算法对于检测困难类别有较大帮助。

本文改進前后的检测检测效果如图12所示,通过对改进的算法模型和Faster RCNN with FPN进行对比可知,改进的算法模型在受到检测环境和布面噪声的干扰下,对于中小尺寸和长宽比极端的瑕疵,具有更准确的检测效果。

3结论

(1)针对素布瑕疵长宽比例极端和中小目标较多的问题,本文对Faster RCNN with FPN检测模型进行了一系列的改进,包括:引入 CCFM改进 FPN 结构,在改进的 FPN 结构中使用AIFI 模块,利用一层Transformer的Encoder结构处理深层特征层,改进聚类算法并重新设计锚框,使用 Focal Loss代替RPN网络的二值交叉熵损失。最后,使用预训练模型进行模型的训练,加快模型收敛,提高训练效果。

(2)在对照实验中,改进检测算法模型相对于原始的 Faster RCNN with FPN,在 mAP50、 mAP75和 mAP50:95指标上分别提升6.5%、4.4%和4.0%,证明本改进算法对于提升素布瑕疵检测模型的检测性能有明显效果,可以实现对于20种素布瑕疵的检测。

(3)检测模型在改进过程中,由于多种模块的引入,导致模型结构更加复杂和参数量的增加,从而减缓了检测速度,下一步的工作是分析模型网络结构,进一步优化检测模型,以提高模型检测效率,加快模型检测速度,更好地完成在纺织车间实时检测素布瑕疵的要求。

参考文献:

[1]谢博韬.工信部:2023年纺织行业利润总额同比增长7.2%[EB/OL].(2024-01-29)[2024-03-05]. https://news.cctv.com/2024/01/29/ARTIha3lWeH YUPfsoqvRx9og240129.shtml.

XIE Botao. Ministry of industry and information technology of the people's republic of China:The total profit of the textile industry in 2023 in- creased by 7.2% year-on-year [EB/OL].(2024-01-29).https://news.cctv.com/2024/01/29/ARTIha3lW eHYUPfsoqvRx9og240129.shtml.

[2]OUYANG W, XU B, HOU J, et al. Fabric defect detection using activation layer embedded convo- lutional neural network [J]. IEEE Access, 2019, 7:70130-70140.

[3]MEIER R, UHLMANN J, LEUENBERGER R. More than meets the eye - a quality revolution [J]. Textile Month, 1999(2): p.34-36.

[4]KUMAR A. Computer-vision-based fabric defect detection: A survey [J]. IEEE Transactions on In- dustrial Electronics, 2008, 55(1):348-363.

[5]邓中民, 胡灏东, 于东洋, 等.结合图像频域和空间域的纬编针织物密度检测方法[J].纺织学报, 2022, 43(8):67-73.

DENG Zhongmin, HU Haodong, YU Dongyang, et al. A density detection method for weft knitted fabrics combining image frequency domain and spatial domain [J]. Journal of Textile Research, 2022, 43(8):67-73.

[6]REN S, HE K, GIRSHICK R, et al. Faster R- CNN: Towards real-time object detection with re- gion proposal networks [J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2017, 39(6):1137-1149.

[7]WEI L, DRAGOMIR A, DUMITRU E, et al. SSD: Single shot multibox detector [J]. arXiv, 2016, 1512.02325.

[8]REDMON J, DIVVALA S, GIRSHICK R, et al. You only look once: Unified, real-time object de- tection [C]//IEEE.2016 IEEE Conference on Computer Vision and Pattern Recognition(CVPR). Las Vegas:IEEE, 2016:779-788.

[9]LIN T Y, GOYAL P, GIRSHICK R, et al. Focal Loss for dense object detection [C]// IEEE.2017 IEEE International Conference on Computer Vi-sion (ICCV). Venice:IEEE, 2017:2999-3007.

[10]CHEN M, YU L, ZHI C, et al. Improved faster R- CNN for fabric defect detection based on gabor filter with genetic algorithm optimization [J].Computers in Industry, 2022, 134:103551.

[11]XIE H, ZHANG Y, WU Z. An improved fabricdefect detection method based on SSD [J]. AATCC Journal of Research, 2021, 8(suppl 1):181-190.

[12]SHI L, SONG J, GAO Y, et al. YOLO-GFD: A fast and accurate fabric defect detection model [C]//IEEE.20234th International Conference on Big Data, Artificial Intelligence and Internet of Things Engineering (ICBAIE). Hangzhou:IEEE, 2023:229-233.

[13]QIN Y, CHEN M, QI L, et al. Focus generator with score classification on fabric defect detec- tion [C]//Focus.2019 IEEE 31st International Conference on Tools with Artificial Intelligence (ICTAI). Portland:IEEE, 2019:1708-1714.

[14]SIMONYAN K, ZISSERMAN A. Very deep con- volutional networks for large-scale image recog- nition [J]. CoRR, 2014, arXiv:1409.1556.

[15]HE K, ZHANG X, REN S, et al. Deep residual learning for image recognition [C]//IEEE.2016 IEEE Conference on Computer Vision and Pat- tern Recognition (CVPR). Las Vegas:IEEE, 2016:770-778.

[16]LIN T Y, DOLLáR P, GIRSHICK R, et al. Fea- ture pyramid networks for object detection [C]// IEEE.2017 IEEE Conference on Computer Vi- sion and Pattern Recognition (CVPR). Honolulu: IEEE, 2017:936-944.

[17]GIRSHICK R. Fast R-CNN [C]//IEEE. Proceed- ings of the IEEE international conference on computer vision. Santiago:IEEE, 2015:1440-1448.

[18]HE K, GKIOXARI G, DOLLáR P, et al. Mask R- CNN [C]//IEEE.2017 IEEE International Confer- ence on Computer Vision (ICCV). Venice:IEEE, 2017:2980-2988.

[19]CARION N, MASSA F, SYNNAEVE G, et al. End- to- end object detection with Transformers [J]. ArXiv, 2020, ArXiv:2005.12872.

[20]LV W, XU S, ZHAO Y, et al. DETRs beat YO- LOs on real- time object detection [J]. ArXiv, 2023, ArXiv:2304.08069.

[21]PELLEG D, MOORE A. Accelerating exact K-means algorithms with geometric reasoning [C]// FAYYAD U. Proceedings of the fifth ACM SIG- KDD international conference on Knowledge dis- covery and data mining. San Diego:Associationfor Computing Machinery, 1999:277-281.

[22]ARTHUR D, VASSILVITSKII S. K- means ++:The advantages of careful seeding [C]//GABOW H. SODA. New Orleans Louisiana:Society for In- dustrial and Applied Mathematics3600 Universi- ty City Science Center Philadelphia, 2007, 7:1027-1035.

[23]NAINGGOLAN R, PERANGIN-ANGIN R, SI- MARMATA R, et al. Improved the performance of the K-Means cluster using the sum of squared error (sse) optimized by using the elbow method [J]. Journal of Physics: Conference Series, 2019, 1361(1):012015.

[24]TIANCHI. Smart diagnosis of cloth flaw dataset /布匹瑕疵檢测数据集[EB/OL].(2020-10-21)[2024-03-5]. https://tianchi.aliyun.com/dataset/79336.

[25]PAN S J, YANG Q. A survey on transfer learning [J]. IEEE Transactions on Knowledge and Data Engineering, 2010, 22(10):1345-1359.

[26]LOSHCHILOV I, HUTTER F. SGDR: Stochas- tic gradient descent with warm restarts [J]. arX- iv: Learning, 2016, arXiv:1608.03983.

(责任编辑:周莉)