512层螺旋CT薄层扫描结合计算机人工神经网络对小肠病变的诊断价值研究*

廖忠剑 文兴林 刘艳平 邓星星 范存庚 雷 剑

江西省赣州市人民医院CT室 341000

近年,小肠癌发病率明显上升,早期检测并采取有效的治疗措施,可有效提高存活率,避免病情继续恶化。但小肠结构迂曲复杂、活动度大、长度大,难以通过常规检查手段有效检测病灶,同时小肠病变多具有隐匿性特点,临床症状无明显的特异性,因此小肠病变的诊断一直是一大难题[1]。目前,在小肠病变辅助检测中,常用的有气钡双重造影、CT影像、MRI、灌肠造影、胶囊内镜、双气囊内镜造影几种检查方法,但这些检查方式诊断价值有限或因有创性而存在一定的局限性[2]。相较而言,小肠CT造影技术具有成像速度快、分辨率高的优势,在小肠血管性病变、炎性病变、小肠肿瘤、不明原因消化道出血等病变诊断方面都有较高的价值[3-4]。但小肠CT造影技术主要获取扫描影像,依赖于医师对影像的解读能力,主观性较强,易造成误诊、漏诊现象[5]。大量人工智能技术在图像识别方面的研究应用显示,利用人工智能技术能准确地提取图像特征,找出图像的特异性[6-8]。为此,本研究以512层螺旋薄层扫描小肠CT图像和病理报告为基础,基于卷积神经网络ResNet 101[9]、目标检测算法模型(Faster R-CNN)[10]结合长短期记忆网络(LSTM)[11]构建小肠图像特征,提取描述循环迭代模型(以下简称RF-LSTM),通过模型输出小肠病变图像特征信息和病变类型,为医师诊断提供更为客观的特征数据,以提高小肠疾病诊断的准确性。

1 材料与方法

1.1 材料及设备 筛选我院2020年1月—2022年1月行512层螺旋CT薄层扫描重建图像及相应的病理诊断报告共计1 572套,每套材料包括CT平扫、动脉期、静脉期、延迟期轴位和冠位图像及病理报告,主要包含了出血、糜烂、溃疡、炎性息肉、腺瘤性息肉、脂肪瘤、腺癌、间质瘤、淋巴瘤等病变类型,部分病例存在多种病变。按7∶3比例随机分为训练组和测试组,具体见表1。纳入标准:(1)图像显示清晰,结构显示清晰;(2)图像上无标线、标注等非原始扫描图像记号;(3)病例均经过病理诊断,图像有相应的病理报告;(4)每套图像中,CT平扫、动脉期、静脉期、延迟期轴位、冠位图像均完整。

表1 样本材料病变类型及数量

本研究中,所收集的病例图像均在我院由GE公司Revolution 256排512层螺旋CT行小肠薄层CT扫描。图像经MPR、MIP进行后处理重建图像,重建层厚1~1.5mm,重建间隔0.6~1mm。采用Python编程语言编程构建模型,采用Pytorch深度学习框架。

1.2 数据预处理及增强 本研究中所收集的图像资料为CT重建图像,其尺寸较大,而ResNet 101模型的输入尺寸为224×224,因此需要对原始图像资料进行压缩处理,统一压缩至224×224。对病理报告进行处理,并由4位医师盲读图像补充描述性标签,通过分词建立规整且符合模型输入要求的语料,主要包括病变类型、肠壁状态、平扫CT值、增强CT值、肠管壁密度特征、肠管周围脂肪间隙CT值、肠壁黏膜完整性、病灶形态、边缘特征、积液、系膜特征。测试样本图像诊断后,收集影像特征医师判断错误结果汇总数据,用以检验模型图像识别能力。

对训练组的样本数据进行增广处理,采用几何变换的方法来增加样本的多样性。具体方法为对训练组图像进行小比例缩小和放大、对图像进行一定裁剪,对图像进行旋转,使训练组样本量增加6倍,训练样本数据增广至8 648例,共计87 942张CT图像。

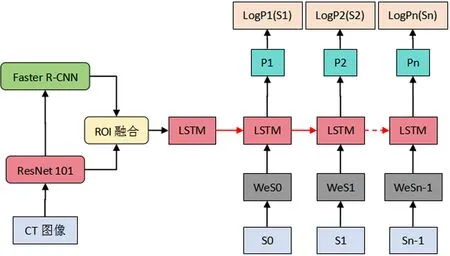

1.3 模型构建 本研究中构建的RF-LSTM模型,包括编码器和解码器两个模块,编码器负责图像特征的提取,解码器负责将提取出的图像特征翻译为病变信息,搭建一个encoder-decoder的端对端图像描述神经网络模型。编码器采用卷积神经网络ResNet 101和目标检测算法Faster R-CNN构建,图像输入后首先通过ResNet 101提取图像特征(ROI),采用Faster R-CNN来结合ResNet 101提取的图像特征探索疑似病变区域,提取疑似病变区特征,再将ResNet 101提取的图像特征与Faster R-CNN提取的疑似病变区图像特征进行特征融合,将融合后的新特征转换为特征向量输入解码器;解码器采用长短期记忆网络模型LSTM作为语言模型,根据编码器提取的图像特征生成文字解释词汇,经过反复迭代后直至产生完整的描述,输出病变特征的语言描述,模型结构见图1。

图1 模型结构图

1.4 图像特征提取方法 图像特征的提取采用ResNet 101模型结合Faster R-CNN提取图像特征的方法。首先,使用ResNet 101模型对输入的CT图像进行卷积和池化,根据病变类型和病变复合状态组建17分类网络,epochs=200,batch_size=16,drop_out=0.1,学习率0.000 1,默认优化方法采用SGD,提取图像特征数据构建14×14×2 048的图像特征向量。再根据RestNet 101模型提取出的图像特征,利用Faster R-CNN以图像特征为中心铺设锚框,判断锚框内是否含有疑似病变部位,并修正锚框边界,挑选出疑似病变部位概率>0.8的目标区域,提取出疑似病变区域的图像特征数据构建图像特征向量。最后,将ResNet 101提取出的图像特征与Faster R-CNN提取出的疑似病变区域图像特征进行融合,提高图像特征的准确度和丰富性,降低信息冗余干扰,最终形成新的疑似病变部位图像特征向量。

1.5 图像诊断文本生成 图像特征的文字解码采用LSTM模型来完成,采用表现效果的单向循环神经网络来构建模型进行解码,信息的传递采用从前往后的单向传递方式。根据抽取的图像特征参数,捕捉图像特征语义,自上而下的循环迭代遍历语料库,找到最合理的描述词语组成诊断文本。

1.6 评价指标 采用诊断文本质量评价指标、诊断准确率(正确判断病变类型数量占总数量的比例)、病变部位提取正确率指标三个指标对模型性能进行评价[12]。各病变类型随机抽取50张图像10个病变类型共计500张,由4名医师采用五级量化方法,结合病理报告对模型生成诊断文本质量进行评分。1分=质量极低,11个特征描述错误项≥3项;2分=质量较低,描述错误项2项以内;3分=一般,无错误项,仅词句结构不完全合理,可用于辅助诊断;4分=极匹配,无错误项,词句结构基本合理,并能少量发现人工阅片遗漏错误的地方;5分=完美,无错误项,仅少量词句结构不合理,并能发现较多人工阅片遗漏错误的地方,有极大的辅助诊断价值。重点筛选1分、2分样本进行分析。

2 结果

2.1 文本质量评价结果 模型训练完成后,输入测试样本数据,输出图像的文本诊断结果,统计4名医师对文本质量的人工评价结果,分别为(4.08±0.692)分、(3.97±0.687)分、(4.05±0.635)分、(4.04±0.651)分。4名医师人工评价,模型输出诊断结果文本质量在4分左右,4名医师对文本质量评价较统计,评价差异无统计学意义(F=1.498,P=0.213>0.05)。

4名医师对质量极低、质量较低的模型输出样本评价完全一致,在3分、4分、5分评价上存在显著差异,具有统计学意义(P<0.05)。见表2。

表2 医师人工评价各分段分布情况(例)

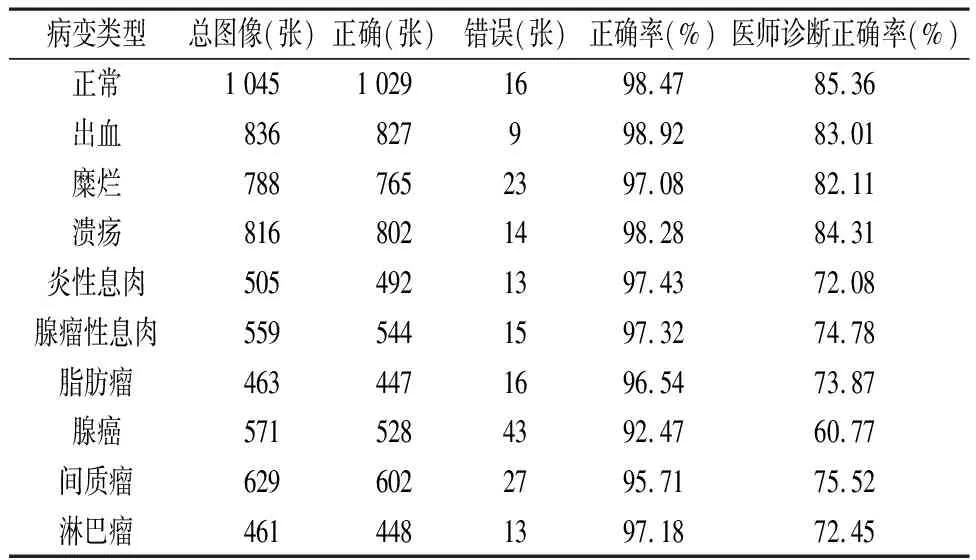

2.2 诊断准确率 统计病变类型模型判断正确与错误的图像样本数量,计算诊断正确率,并与医师仅凭图像的诊断正确率对比,见表3。各病变类型图像的病变判断中,正确率均高于90%,其中对腺癌的判断正确率稍低,为92.47%。

表3 模型诊断准确率统计结果

2.3 病变部位提取正确率 在病变部位的提取上,提取病变组织部位图像的正确率均超过99%。见表4。

表4 模型病变部位提取正确率统计结果

3 讨论

图像描述技术是一种通过计算机视觉、机器学习、自然语言处理等技术,对图像进行分析识别并生成文本描述的技术。在早期图像描述研究领域,主要采用基于模板匹配的方法利用事先制定的规则生成图像描述,但检测精度和准确率不高。随着人工智能技术的发展尤其是深度学习技术的进步,循环神经网络(RNN)和卷积神经网络(CNN)被应用于图像描述技术中,以结合性地解决图像描述精度和准确率不高的问题,并形成了多种模型,如Show and Tell模型、g-LSTM模型、Adaptive-att模型、自适应Attention模型等,使得图像描述技术得到极大提高。大量研究显示,图像描述技术应用中,生成的描述文本往往对语义信息考虑不足。刘茂福等[13]针对视觉关联和上下文信息差异问题,采用双注意力机制建立了VRCDA模型,结果显示采用双注意力机制能有效提高文本描述的语义表达能力。傅煦熙等[14]针对这一问题,则采用了融合MOGRIFIER网络的方法,对内容信息分配不同的权重以获得更准确的描述,语义表达能力有较明显的提升。刘青茹等[15]针对复杂场景图像的细节描述深层语义不足现象,采用多尺度特征环路融合、多分支空间分步注意的方法建立了多重注意力结构模型提取图像特征,基于LSTM解码进行图像描述,结果显示多重注意力结构能有效提升图像描述的深层语义表达能力。

目前,相关研究和应用虽然已经在社会生产生活的多个领域展开,且成为人工智能领域研究的一大热点,但在医疗影像辅助诊断领域的研究和应用还较少。张俊三等[16]采用共同力机制进行视觉特征和语义特征的综合处理,结合对抗网络GAN和强化学习RL方法建立模型,结果显示该模型能较好地输出高质量报告。林玉萍等[17]以青光眼影像数据为材料,采用深度水平集算法结合自然语言处理,生成影像的文本标注,结果显示模型有较好的信息表征能力。沈秀轩等[18]基于医学图像全局特征,采用卷积神经网络和Transformer模型进行融合建模,基于深度学习生成医学影像报告,实验表明在医学影像报告的生成上有极大的有效性 。但医学报告的语言结构和语义表达需要极高的准确性,目前研究多采用Bleu、Moteor、Rouge、CIDEr等指标来评价文本质量,对语义特征的评价能力不足。同时,现在研究还未见关于小肠病变CT图像的智能化图像描述研究。本研究中,采用医师人工评价模型输出的影像报告文本质量的方式,构建基于RestNet 101、Faster R-CNN、LSTM的图像描述模型,对512层螺旋CT薄层扫描重建图像进行文本描述,医师评价文本质量平均分在4分左右,在11项特征描述中,仅0.8%的样本产生错误描述项,其余样本均能进行正确描述,但有约35%左右的样本存在词句结构较明显的不合理现象,表明模型能进行正确的病变影像特征判断,但在词句结构组合上还有所不足,不过模型能发现较多医生肉眼未能识别出的病变影像特征并进行文本描述,可为医生临床诊断提供更为丰富的信息。

本研究中,对模型的9病变类型及正常样本诊断准确率进行了分析,结果显示模型能很好地通过CT影像辨识小肠病变类型,正确率均高于90%,在出血、糜烂、息肉、肿瘤等病变类型上均有极强的识别能力,仅对腺癌的识别能力稍弱,正确率为92.47%,分析发现对腺癌识别能力稍弱,主要是由于其CT图像特征与腺瘤性息肉极为近似,因此易出现误诊为腺瘤性息肉的现象。医师在各病变类型的误诊漏诊上都明显高于模型识别结果,正确率基本处于85%以下,对腺癌的正确诊断率更仅60.77%,实验显示模型能更为准确地借助CT影像识别病变类型,可为医师提供有效的辅助诊断信息。分析其原因,在仅依靠CT图像进行病变类型诊断时,医师更多地依靠主观经验和图像认识水平进行诊断,在对图像的精细特征信息把握上不足,而模型能更多地识别出CT图像中的精细特征信息,从而作出更准确的判断。与其他部分利用人工智能技术进行小肠病变类型定性诊断的研究结果相比,本研究对小肠病变类型的诊断准确率普遍更优,分析其原因与本研究中所建立的模型采用RestNet 101和Faster R-CNN两个模型提取图像特征进行融合有关,两个模型提取图像征特信息进行ROI融合后,能获得更为丰富的图像特征信息,有利于病变类型的诊断识别。而在病变部位的提取准确率上,本研究所建立的模型能极为准确地定位病变部位,提取正确率均达到99%,但在正常图像上略有所不足,出现在0.53%的正常图像样本中识别出病变部位的现象。分析其原因,主要因为错误提取的正常图像中,存在一定的与病变部位近似的图像特征,被错误地认为存在糜烂、炎性息肉等病变。

当前,图像描述技术在各领域均有较多的应用和研究,并展现出极高的应用价值。本研究中,基于RestNet 101和Faster R-CNN构建编码器,提取512层螺旋CT薄层扫描小肠重建图像的图像特征参数进行ROI融合,采用LSTM进行解码,对病变类型和影像特征进行描述,共包含了正常图像和9种小肠病变类型,设计了11个病变部位影像特征标签。研究结果显示,模型对病变类型有较好的识别能力,并能较为准确地描述病变部位影像特征,同时还能正确辨识部分医师人工阅片未能准确判断的影像特征,能为医师临床诊断提供更为丰富、准确的辅助诊断信息,具有一定的研究及推广应用价值。采用RestNet 101和Faster R-CNN构建编码器,可有效提取512层螺旋CT薄层扫描小肠重建图像的病变特征参数,运用LSTM对病变特征进行解码,可以准确根据图像病变特征识别病变类型,并以中文输出病变部位影像特征和病变类型,同时还可识别部分医师人工阅片无法判断的影像特征,可为医师临床诊断提供更为丰富的辅助诊断信息,具有研究及推广应用价值。