基于多可穿戴传感器的用户人体复杂行为主动识别

叶彩仙,胥立军

1.广州新华学院 信息与智能工程学院,广东东莞 523133 2.广州新华学院 人工智能与数据科学系,广东东莞 523133

0 引言

一般来说,人体行为识别技术主要利用所设计的采集程序,在不断变化的背景环境下进行周期的人体行为数据获取并及时作出分类处理,利用多维算法来完成最终的复杂行为主动识别。针对于特定用户人体复杂行为的识别是一项十分繁琐的工作,过程中不仅要对采集获取的数据进行分类化处理,还需要筛选、剔除不合理信息,以确保后续识别结果的可靠性与真实性。此外,对于复杂行为的主动识别,要根据用户的特征及习惯来解析,这也是一个十分复杂的过程,较难把控。

当前的用户人体复杂行为主动识别算法多为目标采集与智能算法结合,参考文献[1]和文献[2]的设定传统改进MobileNet V1 用户人体复杂行为主动识别方法、传统Conv-Involution 用户人体复杂行为主动识别方法,这一类主动识别算法虽然能够实现预期的识别任务与目标,但是缺乏针对性与具体性,面对不同的识别对象时,难以进行精准特征定位与解析,导致最终的识别结果出现不可控的误差。文献[3]提出了一种基于梅尔频率倒谱系数(Mel-frequency Cepstral Coefficients,MFCC)特征的Wi-Fi 信道状态信息人体行为识别方法,这种方法过于依赖外部硬件设备,一旦硬件受限,识别的F1-score 数值较低,导致最终识别结果不理想。

为解决以上方法存在的问题,提出对基于多可穿戴式传感器数据融合的用户人体复杂行为主动识别方法的设计与验证研究。多可穿戴式传感器数据融合主要指的是通过智能手环、陀螺仪、加速度计等传感装置进行范围之内用户行为数据的采集,例如:心率、多巴胺、眼球追踪停留时间、位置等,将融合后的数据与主动识别工作相结合,一定程度上能够强化识别的精准度及可靠性,为后续相关技术的发展与完善奠定基础[4]。

1 基于多可穿戴式传感器的用户指标数据采集

在主动识别用户人体复杂行为前,需要通过传感器[5-7]采集用户人体的指标数据。该步骤采用多个可穿戴式传感器采集数据,包括心率传感器、运动传感器、全球定位系统(Global Positioning System,GPS)传感器、智能手环、陀螺仪等[8-9],将其佩戴在用户身上,在传感器上设置节点,通过部署的节点进行多可穿戴式传感器的关联搭接,采集用户可识别数据。采集的数据包括用户生理、生化和行为指标数据,后续研究中融合多个传感器采集的数据,为主动识别用户人体复杂行为奠定基础。用户的生理指标数据是人体本能做出的反应数据;用户生化指标数据是生理行为的一种延伸,是基于生理反应所形成的指标数据;用户行为指标数据是用户最终的外在动机表现。通过多个可穿戴式传感器采集这些数据,是因为生理-生化-行为实际上是一个循环性的过程,包含了用户人体在执行行为时的大多数信息,通过多个可穿戴式传感器采集信息范围较广,可以在一定程度上提高行为识别准确性。具体采集过程如下:

首先,在接入系统中布设一定数量的监测传感节点,这些监测节点均为可穿戴式传感器,传感器之间互相关联,形成全覆盖性的数据识别结构。基于多个可穿戴式传感器,设计用户生理-生化-行为指标数据采集流程,如图1 所示。

根据图1,通过多个可穿戴式传感器完成用户生理-生化-行为指标数据采集。设定多个可穿戴式传感器的数量为n,第i个可穿戴式传感器采集的原始数据为(t),则归一化处理采集的数据,获得采集后的用户生理-生化-行为指标数据,公式为:

式中,(t)max表示可穿戴式传感器采集的原始数据最大值;(t)min表示原始数据最小值。通过多个可穿戴式传感器采集了用户生理-生化-行为指标数据,为后续数据融合的对象。

2 多可穿戴式传感器数据融合的复杂行为主动识别方法

2.2 多传感器数据融合的虚拟场景构建

虚拟现实(Virtual Reality,VR)是常见的辅助性技术,该技术应用于用户复杂行为主动识别工作处理。本文引入该技术,为用户人体复杂行为主动识别奠定基础。首先,基于上述章节,通过多个可穿戴式传感器采集的用户生理-生化-行为指标数据,设计多维复杂行为主动识别的虚拟现实场景,结合实际的主动识别范围进行基础场景控制指标与参数的设置,如表1 所示。

表1 用户行为主动识别虚拟现实场景指标表

根据表1 完成对用户行为主动识别虚拟现实场景指标的设定,明确可穿戴式传感器的实际覆盖范围,具体如公式(2)所示:

式中,W表示多可穿戴式传感器的实际覆盖范围;B表示定向传感次数;N为常数,表示求和上限;o表示转换比;U表示可控传感距离;χ表示重复传感区域;F表示描述范围。

在明确覆盖范围后,需要计算可穿戴式传感器允许出现的最大传感差值,具体如公式(3)所示:

式中,E表示最大传感差值;Ψ表示可识别范围;ς(表示主动识别次数;l表示可控识别均值。

在可穿戴式传感器覆盖范围之内,并且在传感误差允许下,结合三维图形技术和多媒体技术,划分基础场景,并进行关联设定,将区块性的用户关联,进行全覆盖虚拟转换控制。结合VR 中的仿真技术和伺服技术,设计虚拟场景的功能执行单元,具体如图2所示。

根据图2 完成对虚拟场景功能执行单元的设计与验证应用。基于VR 虚拟显示基础,在各个执行单元中增设监测程序,并与初始部署的节点进行搭接关联,融合多个可穿戴式传感器数据采集的用户生理-生化-行为指标数据,公式为:

式中,wi表示多个可穿戴式传感器的融合权值;ε表示覆盖范围阈值;ε'表示传感误差阈值。

通过对各个可穿戴式传感器采集数据进行加权平均,根据不同传感器的重要性给予不同权重,得到一个综合的融合结果。

通过多媒体技术,结合融合处理后的可穿戴式传感器采集的用户生理-生化-行为指标数据,输入CNN 网络,得到基于虚拟现实的用户运动行为场景,公式为:

通过公式(5)完成基于虚拟现实的场景构建,为后续的主动识别处理奠定基础环境。

2.3 复杂行为主动识别方法设计

通过上述章节构建了虚拟现实场景,当用户的行为在该场景中发生变化后,虚拟识别点会自动将数据传输到可穿戴式传感器,通过融合该传感器获取的数据后,获取用户行为与预定数据相似度,通过相似度获取有效数据,剔除部分冗余数据,具体如公式(6)所示:

式中,δ表示单元融合基准值;L表示融合次数;c表示关联融合均值;d表示主动识别差;e表示错误识别次数。

依据得出的用户复杂行为数据相似度,筛选当前可穿戴式传感器识别的数据信息,便于使用者随时查看所属的数据,这样的方式会形成一个用户复杂行为主动识别序列,具体如图3 所示。

根据图3 完成主动识别序列参数的设定,计算公式为:

式中,φ表示融合相似度阈值。

依据上述获取的主动识别序列参数,对用户复杂行为变化进行追踪性的识别处理[10-11]:

首先,主动提取用户复杂行为的可识别特征点,在提取过程中,为了提高识别的准确性,引入自相关系数,公式为:

基于上述自相关系数,主动提取可识别特征点,公式为:

式中,σ表示标准差。

在确定可识别特征点后,引入循环神经网络,通过该网络实现用户人体复杂行为主动识别,隐藏状态的计算公式为:

式中,W(·)表示权重矩阵;θ表示偏置向量。

在确定循环神经网络隐藏状态后,获取全连接层的计算公式:

式中,W'表示连接全连接层与隐藏状态的权重矩阵。

使用Softmax 函数主动分类用户复杂行为,主动识别用户人体复杂行为,公式为:

至此,通过多个可穿戴式传感器采集用户的生理-生化-行为指标数据,融合采集的数据,根据融合后的数据构建了虚拟现实场景,基于构建的场景,结合融合相似度、自相关系数和循环神经网络算法,主动识别用户人体复杂行为。

3 实验分析

分析与验证基于多可穿戴式传感器数据融合的用户人体复杂行为主动识别方法应用效果。考虑到最终测试结果的真实性与可靠性,采用对比的方式展开分析。对比文献设定为改进MobileNet V1 用户人体复杂行为主动识别测试组、Conv-Involution 用户人体复杂行为主动识别测试组,以及此次所设计的多可穿戴式传感器数据融合用户人体复杂行为主动识别测试组。根据当前识别需求及标准的变化,对最终得出的识别结果进行比照研究。

3.1 实验准备

针对用户人体复杂行为主动识别的测试需求,进行基础环境的搭建。当前可以先采用Sgdm 优化器进行初始网络的接入处理,设置最小批的识别处理大小为18,最大迭代次数控制在60,初始学习识别率为3.2,识别丢弃率为12.35%。针对当前测试的系统,随机选定3 000 名青少年用户进行测试,并将其划分为5 个小组,人数分别为200 人、400 人、600 人、800 人和1 000 人。

在当前的程序中设计一个多维动态的数据集,选定可穿戴式的智能手环作为测试的主要辅助工具,在数据集中导入101 个动作类别作为主动识别的参数对象,接下来,基于实际的识别要求,进行测试控制参数的设置,如表2 所示。

表2 人体行为主动识别测试控制参数设定表

结合表2,实现对人体行为主动识别测试控制项目的设定。以此为基础,利用可穿戴式传感器采集的数据进行用户行为特征值的计算。结合当前的测试,将该数值作为实际的限制测试标准,识别测定用户人体复杂行为。

3.2 实验过程及结果分析

在上述搭建的测试环境中,结合多可穿戴式传感器数据融合原理,对选定的30 名用户的人体复杂行为主动识别方法进行测试与分析。首先,设置6 个基础的测试周期,每一个周期针对选定的用户进行一次主动识别,并记录下获取的信息,利用智能手环对用户的身体状态进行实时监测,获取对应的数据、信息,汇总整合之后,待后续的应用解析;接下来,在各个周期之内,通过系统下达指令,选择指定的动作组为参照标准,并进行可控主动识别,智能手环在进行动作主动识别的过程中还会对识别的耗时进行记录,计算出主动识别的平均耗时,如公式(13)所示:

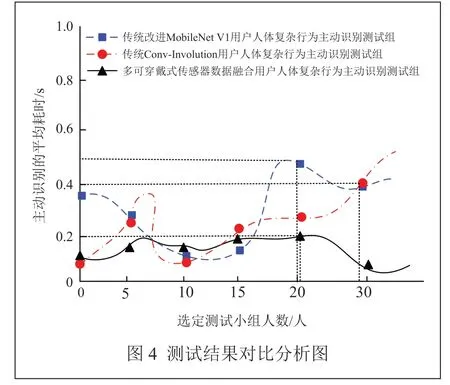

式中,B表示定向范围;J表示识别均值差;Q表示识别精度。结合当前的测试,完成对结果的分析,具体如图4 所示。

根据图4 完成对测试结果的分析。对比于传统的改进MobileNet V1 方法、Conv-Involution 方法测试组,本文设计的人体复杂行为主动识别测试组最终得出的主动识别的平均耗时被较好地控制在0.2 s 以下,说明在可穿戴式传感器数据融合原理的辅助下,所设计的针对复杂人体行为的主动识别方法更为高效、精准,误差可控,具有实际的应用价值。

在上述实验分析的基础上,为了进一步分析该方法的识别性能,以F1-score 作为评估指标,其计算公式为:

式中,P0、P1分别表示识别准确率和召回率。

通过公式计算出F1-score 数值,该数值越大越好。实验结果如表3 所示。

表3 不同方法的F1-score 结果

根据表3 数据可知,3 种方法的F1-score 数据均在0.900 以上。通过对比可知,在测试人数达到30 人时,传统改进MobileNet V1 识别测试组的F1-score 数值为0.915,传统Conv-Involution 主动识别测试组的F1-score 数值为0.939,基于多可穿戴式传感器数据融合的识别组的F1-score 数值为0.986,本文方法的F1-score 数值最高,比对比方法提高了0.040 以上。因此,该方法具备更高的识别准确性。

4 结束语

综合上述分析,本文设计的基于多可穿戴式传感器数据融合的用户人体复杂行为主动识别方法在初始的行为主动识别覆盖范围较小,且在各个领域受到一定限制的情况下,面对不同的传感器数据,利用多可穿戴式传感器进行数据的采集与融合可进一步扩大主动识别的范围。与此同时,结合多模态数据融合、概率推理和深度学习等原理,不断完善、优化当前的主动识别方法。针对人体复杂行为识别的双向特征,形成与之匹配的识别机制,可进一步提升整体的识别效率和准确性,其识别平均耗时低于0.2 s,并且F1-score 数值达到0.986,验证了其具备一定的可行性和有效性,为后期关联技术的发展提供参考依据和理论借鉴。