基于改进YOLOv5卷积神经网络的SAR图像目标识别

曾祥书,黄一飞,蒋忠进

(东南大学毫米波国家重点实验室, 江苏 南京 210096)

0 引 言

合成孔径雷达(SAR)是一种主动式微波遥感系统,可以全天候全天时地进行SAR成像,已广泛用于农林监测、地质调查、灾害监测、海洋监测以及国防建设等诸多方面。不论是民用还是军用,对SAR图像中陆地和海洋目标的检测与识别都具有重要意义[1-5]。

传统的SAR图像目标识别主要包含预处理、目标检测、特征提取和特征分类等4个步骤,其识别效果很大程度上取决于人工设计的特征提取,步骤复杂,泛化能力差[6]。随着以卷积神经网络(CNN)为代表的深度学习的不断发展,深度学习在SAR图像目标识别中也得到广泛应用[7-8]。通过CNN可以完成SAR图像的高维特征提取,减少人为干预,实现“端到端”的处理流程[9-11]。

目前基于CNN的SAR图像目标检测与识别算法,按照模型结构可以大致分为双阶段算法和单阶段算法。双阶段算法通常具有较高的识别精度,但相当耗时且具有较大的计算开销,常用的模型结构主要包括R-CNN[12]、Fast-RCNN[13]、Faster-RCNN[14]等。单阶段算法大幅提高了识别速度,常用的模型结构主要包括SSD[15]、YOLO[16]等。早期单阶段算法的精度不如双阶段算法,但YOLOv3[17]的出现改变了这一局面,其在保证计算速度的前提下,进一步提高了识别精度,使单阶段算法在速度和精度上均超过双阶段算法。2020年6月,Ultralytics公司发布了YOLOv5模型,这是在YOLOv3的基础上进行了大幅改进的新一代单阶段模型,它不仅提高了模型的性能,还实现了模型的轻量化设计。

基于CNN的SAR图像目标识别经过国内外大量科研人员的实验验证,已经取得了大量的成果[18-20]。文献[21]针对SAR图像中相干斑噪声的影响,提出了一种像素级去噪和语义增强的检测模型,并在SSDD数据集上验证了该模型的有效性和泛化性能。文献[22]提出一种基于监督对比学习正则化的SAR图像建筑物提取方法,通过增强特征空间中相同类像素的相似性和不同类像素的差异性,提高了建筑物的识别精度。文献[23]提出了一种基于改进Faster-RCNN的SAR图像运动目标检测方法,提高了检测准确率,降低了虚警率,并在自制的Mini-SAR系统中验证了该方法的有效性。

针对SAR图像中目标分布密集、背景复杂等问题,本文提出一种改进YOLOv5网络模型,并将其用于SAR图像目标识别。该方法根据训练数据中的标注框尺寸信息,使用宽度比和高度比作为距离度量,利用k-means聚类方法生成先验锚点框,作为预测框优化时的框尺寸初始值。引入SIoU[24]来代替竞争性交并比 (CIoU),以得到更加合理的框回归损失函数,提高在密集分布情况下的目标定位精度。使用Focal Loss[25]来替代二元交叉熵,以得到更加合理的置信度损失函数,提高在复杂背景下的目标识别精度。本文基于大规模多类SAR目标数据集MSAR进行了大量的实验验证,结果表明,相比于所选用的几种对比网络,本文的改进YOLOv5网络模型具有更好的目标识别性能。

1 改进YOLOv5网络模型

1.1 网络模型结构

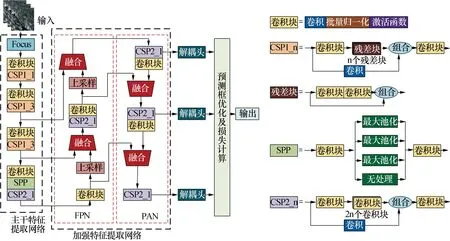

本文使用的改进YOLOv5网络模型如图1所示,由输入、主干特征提取网络、加强特征提取网络、解耦头、预测框优化及损失计算、输出等六个部分组成。

图1 YOLOv5网络结构

主干特征提取网络选用CSP-Darknet网络,用于基础特征提取,该网络包含1个Focus结构、4个卷积块、4个CSP结构、1个SPP 结构。其中Focus结构对原始SAR图像在横坐标和纵坐标方向各做二倍间隔采样,减少层数和参数量,以提升推理速度和梯度反传速度。卷积块包含卷积(Convolution)、批量归一化(BN)和SiLU激活函数三部分。SiLU激活函数表示为

f(x)=x·sigmoid(x)

(1)

SiLU激活函数可以视为平滑的ReLU函数,具有平滑、无上界有下界、非单调的特性。CSP结构具有两种不同的设计,如图1中CSP1_n和CSP2_n,CSP结构可以在保证准确性的情况下减少网络参数,提高计算速度和对设备的要求。SPP结构能通过池化核大小不同的最大池化处理进行特征提取,以提高网络的感受野。

通过主干特征提取网络,可以得到输入SAR图像的三种层次的特征图,其中浅层特征图具有较强的位置信息和较弱的语义特征,而深层特征图具有较强的语义特征和较弱的位置信息。这些特征图被输送给后续的加强特征提取网络,做进一步的特征提取和融合。

加强特征提取网络由特征金字塔网络(FPN)和路径聚合网络(PAN)组成,用于多尺度特征提取与融合,FPN和PAN的结构如图1所示。FPN把深层的语义特征通过上采样与浅层融合,从而增强多个尺度上的语义表达。PAN则相反,把浅层的定位信息通过卷积块实现下采样与深层融合,增强多个尺度上的定位能力。经过加强特征提取网络后,特征图将同时具有丰富的语义信息和位置信息。

网络训练阶段,YOLOv5首先将输入SAR图像的大小调整为256×256;然后输入图像经过主干特征提取网络和加强特征提取网络,得到大小分别为32×32、16×16、8×8的三个不同层次的特征图;这些特征图分别经过三个不同的解耦头,获得针对小、中、大目标的三组边框回归与目标分类参数;最后将这些参数与训练数据的标签信息进行比较,计算损失函数,并反向传播更新网络参数。

网络测试阶段,在测试集上利用训练好的网络模型生成大量预测框,通过非极大值抑制(NMS)算法,删除冗余预测框,得到和不同目标一对一匹配的多个检测框。将测试集标签信息与检测框参数进行对比,统计准确率和召回率等各项技术指标。

1.2 先验锚点框生成

在常规YOLOv5网络中,通常会引入锚点框(anchor),作为后续参数优化中预测框的初始尺寸值。默认的锚点框是基于COCO和VOC数据集进行训练得出的,总共包含9组,分别覆盖大、中、小三种尺寸,每种尺寸都包含三组不同的宽高比。

本文针对大规模多类SAR目标数据集MSAR,使用k-means聚类算法对训练数据集标签信息中的边界框尺寸进行聚类,进而重新生成了9组最适用于MSAR数据集的锚点框。

此处构建任意两个边界框之间的距离度量d为

(2)

式中:w1和w2分别表示边界框1和边界框2的宽度;h1和h2分别表示边界框1和边界框2的高度。

通过计算两个边界框之间的宽度比和高度比,以描述它们之间的相似程度。此时需要同时计算w1/w2、h1/h2、w2/w1和h2/h1,并在这四个比值中选择最大值作为距离度量d。当两个边界框之间的相似程度越高时,它们之间的距离度量就会越小,匹配效果就会越好。

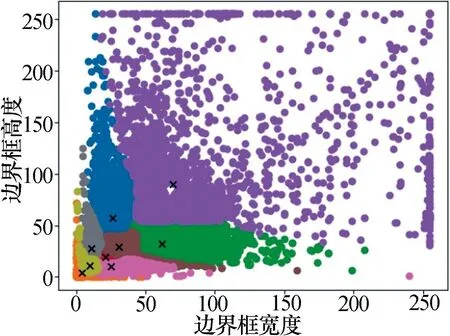

锚点框的聚类结果如图2所示,图中横轴表示边界框的宽度,纵轴表示边界框的高度。本实验从数据库标签信息中一共摘取49 386个边界框,根据每个边界框的宽度和高度来确定其坐标,成为图中的一个圆点。

图2 k-means聚类所得锚点框

通过k-means聚类,将距离度量d接近的边界框聚为一类,并表示成同一种颜色,每种颜色的圆点群的质心用×点表示。每个×点就是一个锚点框,本实验一共构建了9个锚点框,其坐标分别为[4, 4]、[10, 11]、[25, 10]、[11, 28]、[21, 19]、[31, 29]、[26, 57]、[62, 32]、[70, 90]。

1.3 损失函数

YOLOv5目标识别可以归结为目标边框参数和目标类别参数的回归问题,其所使用的损失函数包括框回归损失lreg、置信度损失lobj、分类损失lcls三部分。损失函数表示为

l=lreg+lobj+lcls

(3)

常规的框回归损失lreg由预测框和真实框之间的CIoU损失构成[23]。本文使用SIoU指标替代CIoU指标,以衡量预测框和真实框之间的相似度。SIoU值越大,说明它们的匹配度越高,相应的损失函数值就越小。

为了更好的说明SIOU值的计算,给出预测框A和真实框B的示意图如图3所示。

图3 预测框和真实框示意图

式中:σ表示A和B中心点之间的距离;cw和ch分别表示以σ为对角线的矩形框的宽和高;dw和dh分别表示能包围A和B的最小方框的宽和高。

SIoU值计算如下:

(4)

式中:rIoU(A,B)表示预测框A和真实框B之间的交并比,计算如下。

(5)

Δ代表距离成本函数,计算为

Δ=(1-e-γρx)+(1-e-γρy)

(6)

Ω代表尺寸成本函数,计算为

Ω=(1-e-ωw)θ+(1-e-ωh)θ

(7)

可以看出,相较于CIoU,SIoU除了考虑预测框和真实框之间的重叠区域、距离和长宽,还考虑了两个框之间的角度关系。SIoU指标可以使预测框更快、更准确地朝着与真实框重叠度更高、对齐程度更好的方向优化。

由此改进的框回归损失lreg计算为

(8)

在置信度损失lobj中,本文采用Focal loss代替二元交叉熵,以优化置信度损失函数。相对于二元交叉熵,Focal loss具有更好的类别平衡性和针对性,能够提高网络训练效率和目标识别精度。改进的置信度损失lobj计算为

(9)

关于分类损失lcls,本文的计算方法与常规YOLOv5网络一致,计算如下

(10)

2 实验验证

实验选用了YOLOv3、常规YOLOv5以及改进YOLOv5三种网络,进行训练和测试,以进行SAR图像目标识别性能的比较。

实验所使用的数据集来自文献[25]中所提出的大规模多类SAR目标数据集MSAR,该数据集包括HH、HV、VH和VV四种极化方式,由28 449张尺寸为256×256像素的SAR图像切片构成,涵盖机场、港口、近岸、岛屿、远海、城区等复杂场景,类型有舰船、油罐、桥梁和飞机四类目标,共计39 858艘舰船,12 319个油罐,1 851架桥梁和6 368架飞机。本实验将数据集按9:1的比例,划分为训练集和测试集。

2.1 目标识别结果与分析

本文在MSAR数据集上,使用三种网络进行了SAR图像目标识别实验,部分实验结果如图4~图7所示。其中紫色方框标示检出舰船目标,蓝色方框标示检出桥梁目标,绿色方框标示检出油罐目标,红色方框标示检出飞机目标,红色椭圆框标示漏检目标,红色三角形标示虚检目标。

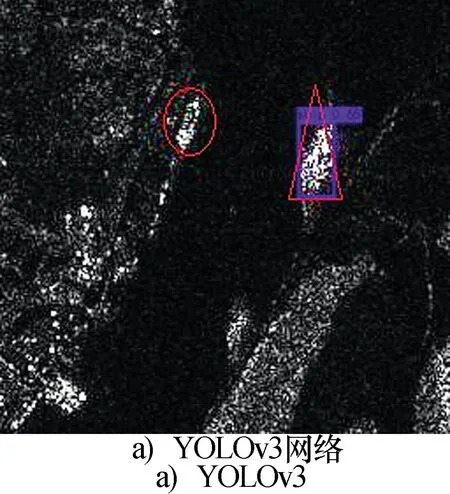

图4 舰船目标识别效果

试验中,YOLOv3、常规YOLOv5以及改进YOLOv5三种网络模型给出的SAR图像舰船目标识别结果如图4所示,图中有一个靠岸停泊的舰船目标。

从图4中可以看出, YOLOv3网络的识别结果中存在一处虚检和一处漏检,常规YOLOv5网络的识别结果中存在二处虚检,而改进YOLOv5网络不存在虚检和漏检。

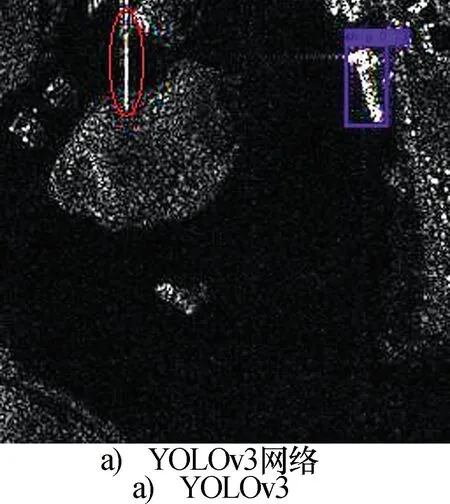

三种网络模型给出的SAR图像桥梁目标识别结果如图5所示,图中有一个小岛,通过一座桥梁与陆地相连,小岛对面有一个舰船目标停靠。

图5 桥梁目标识别效果

从图5中可以看出,三种网络均正确识别出停靠的舰船目标。YOLOv3网络未能识别出桥梁目标,常规YOLOv5网络和改进YOLOv5网络均正确识别出桥梁目标,但常规YOLOv5网络的结果中存在一处舰船目标的虚检。

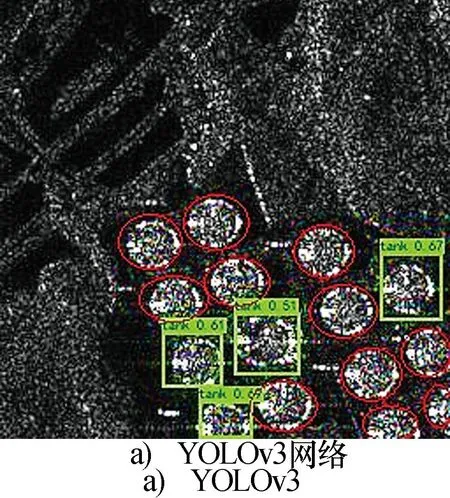

三种网络模型给出的SAR图像油罐目标识别结果如图6所示,图中存在密集分布的油罐目标群。

图6 油罐目标识别效果

从图6中可以看出,YOLOv3网络的识别结果中存在11处漏检,常规YOLOv5网络和改进YOLOv5网络不存在虚检和漏检。

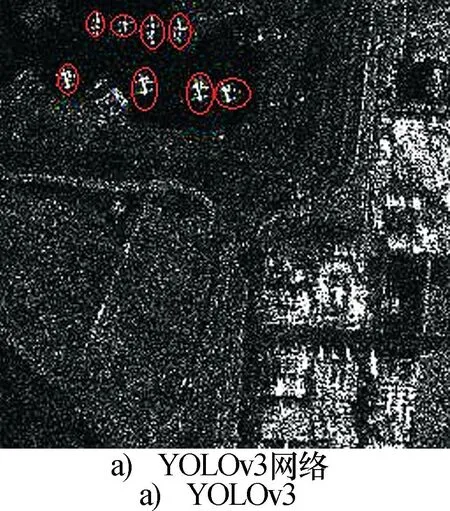

三种网络模型给出的SAR图像飞机目标识别结果如图7所示,图中存在8个飞机目标,其背景为一个机场。

图7 飞行目标识别效果

从图7中可以看出,YOLOv3网络未能识别出所有8个飞机目标,常规YOLOv5网络的识别结果中存在3处漏检,而改进YOLOv5网络不存在虚检和漏检。

此外,本文还针对密集型小目标进行了目标识别实验,实验结果如图8所示,图中存在机场背景下密集分布的多个飞机小目标。

图8 密集型小目标识别效果

从图8中可以看出,YOLOv3网络和常规YOLOv5网络的识别结果中存在较多的漏检和虚检,而改进YOLOv5网络基本不存在虚检和漏检。由于SAR图像分辨率较低,目标众多,识别结果中没有标示虚检和漏检,仅仅标示了检出的飞机目标。

2.2 识别性能指标对比

本文采用的SAR图像目标识别性能指标包括:准确率rP=NTP/(NTP+NFP),指正确检出目标占检出目标总数的比例;召回率rR=NTP/(NTP+NFN),指正确检出目标占真实目标总数的比例;以及二者的调和平均数F1=2×rP×rR/(rP+rR)。其中,参数NTP为正确检出目标个数,NFP为虚检目标个数,NFN为漏检目标个数。

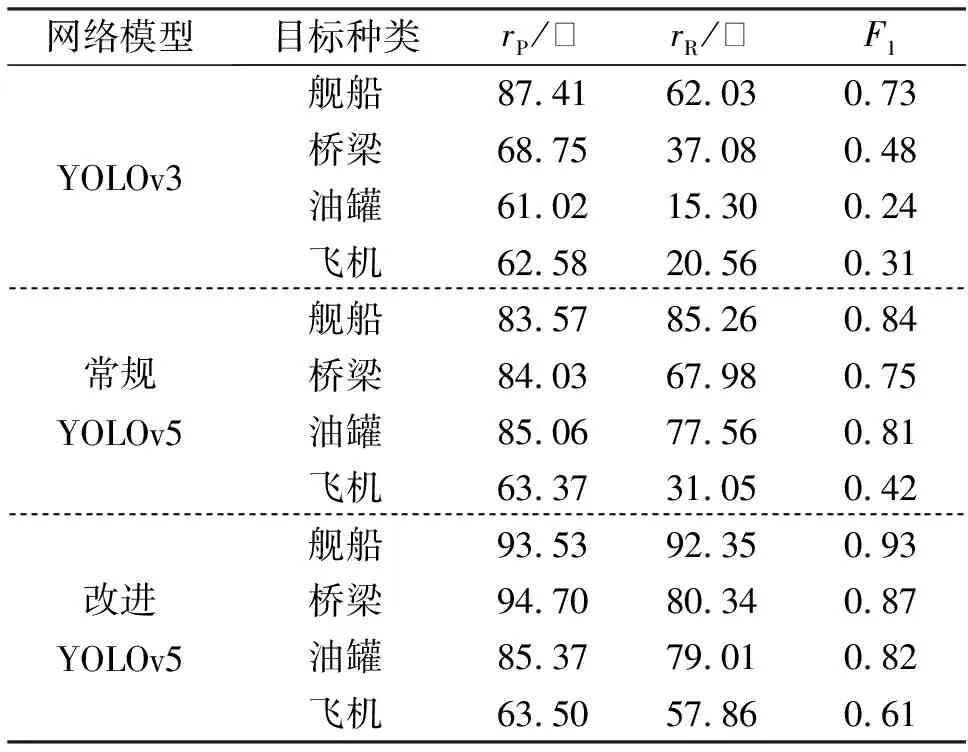

本文基于MSAR数据集进行了大量实验,统计了YOLOv3网络、常规YOLOv5网络以及改进YOLOv5网络在目标识别方面的性能指标,具体数据如表1所示。

表1 三种网络的性能指标比较

由表1可以看出,在舰船目标识别中,相较于YOLOv3网络,常规YOLOv5网络的识别准确率rP略有降低,但召回率rR和调和平均数F1值明显提高,漏检更少。并且,对于桥梁、飞机、油罐三类目标,常规YOLOv5网络的准确率rP、召回率rR和调和平均数F1值均明显高于YOLOv3网络。

相比于前两种网络,改进YOLOv5网络对全部四类目标,在召回率rR、准确率rP、调和平均数F1值三方面均有明显提升。

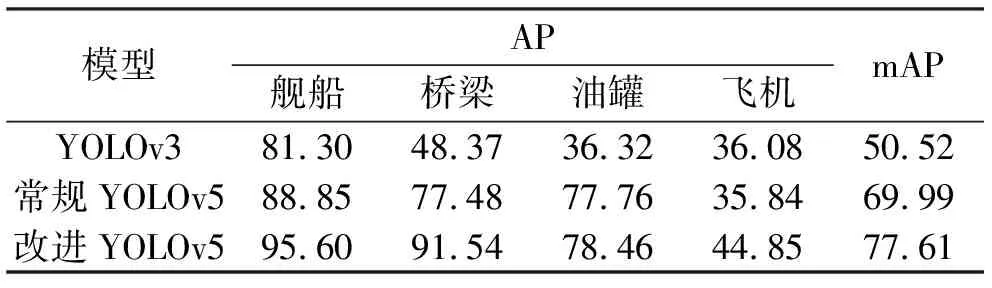

除此之外,本文还统计了三种网络对四类目标的识别平均精度(AP),并计算其平均精度均值(mAP),统计结果如表2所示。

表2 三种网络的AP值和mAP值对比

由表2可知,相比于YOLOv3网络,常规YOLOv5网络对飞机目标的识别AP值略有降低,但对舰船、桥梁、油罐三类目标的识别AP值均有明显提升,由此其识别mAP值提高了19.47%。相比于常规YOLOv5网络,改进YOLOv5网络对全部四类目标的识别AP值均有明显提升,导致其识别mAP值提高了7.62%。

此外,本文还利用YOLOv3网络、常规YOLOv5网络和改进YOLOv5网络对同一组尺寸为256×256的SAR图像进行目标识别,并测量计算时间和处理速度。结果显示,YOLOv3网络的计算时间为0.010 s,处理速度为99FPS;常规YOLOv5网络的计算时间为0.011 s,处理速度为93FPS;改进YOLOv5网络的计算时间为0.011 s,处理速度为90FPS。可以看出,相对于YOLOv3网络,常规YOLOv5网络和改进YOLOv5网络的计算时间略有增加。这是因为YOLOv5网络所采用的结构比YOLOv3网络更加复杂,且本文的改进YOLOv5网络中,采用SIoU来衡量预测框和真实框之间的相似度,以计算框回归损失,这都会导致计算量增加。

3 结束语

本文提出一种改进YOLOv5卷积神经网络,并将其用于SAR图像目标识别。在该网络中,改进了先验锚点框的生成方法、框回归损失函数和置信度损失函数,以提高在复杂背景下对密集分布目标的识别精度。

本文基于MSAR数据集,选择了YOLOv3、常规YOLOv5作为对比网络,分别对舰船目标、桥梁目标、油罐目标、飞机目标以及密集分布小目标进行了大量的SAR图像目标识别实验,以验证改进YOLOv5网络的有效性。

实验结果表明,相比两种对比网络,改进YOLOv5网络对四类目标均具有更高的识别准确率、召回率和F1值。在AP值和mAP值综合指标方面,改进YOLOv5网络亦优于另外两个对比网络。在计算时间方面,改进YOLOv5网络与常规YOLOv5网络相当,且二者的计算时间均略长于YOLOv3网络。