基于多智能体强化学习的空地网络抗干扰传输方法研究*

廖程建,刘思懿,赵晨羽,张果,侯宏伟,朱瀚然,夏晓晨,许魁

(陆军工程大学通信工程学院,江苏 南京 210007)

0 引言

5G/6G 等新一代移动通信技术通过超密集组网、跨频段使用、波束空间复用等方式大幅提升了频率复用度,实现了高速率、低时延、大容量传输。当地形环境较为复杂时,通信系统的节点分布较为稀疏,无法进行超密集组网,导致区域覆盖能力和“山中通”能力等面临较大挑战。无人机、无人升空平台等空基平台具有部署灵活、覆盖范围广等特点,为有效提升通信覆盖能力提供了一条新的思路。

无人机(UAV,Unmanned Aerial Vehicle)由于其灵活性和易控制性,可以在某些特殊场景提供高效可靠的无线通信[1]。特别是当地面基站无法提供服务时,UAV 可以作为空中基站,为地面用户提供紧急通信[2]。无人机还广泛应用于物联网中,为设备应用收集数据[3]。无人机亦可作为中继节点,与远程节点建立可靠连接,抵御恶意干扰和窃听,保证无人机中继网络中的安全传输问题[4-5]。此外,研究UAV 网络中的抗干扰问题也是一大研究热点,博弈论和凸优化理论广泛应用于UAV 通信抗干扰方案设计。文献[6]将UAV 视做中继节点,从博弈论视角出发构建斯坦伯格博弈模型,研究了空天地一体化网络在非理想信道状态信息条件下如何抵御恶意干扰问题。文献[7]应用交替优化和逐次凸逼近理论,将非凸问题进行转换,通过优化无人机的轨迹以及功率分配,最大化特定时间段内系统的平均保密速率。文献[8]研究了无人机网络的物理层安全问题,使得无人机基站在存在多个窃听者的情况下,通过协作干扰向多个信息接收器传输机密信息,提升了性能增益。然而,以上研究仅考虑了单个或少量的无人机场景,大规模无人机场景下的抗干扰传输问题仍需进一步研究。当环境发生变化时,所提出的优化算法可能会变得无效,难以满足实时决策的需求。

近年来,强化学习(RL,Reinforcement Learning)方法引起了广泛关注,用于解决传统数学方法无法处理的高复杂度优化问题。将强化学习、深度学习等智能算法应用于抗干扰传输是当前一大研究热点[9-13]。文献[9]针对无人机网络易受智能干扰机干扰,提出一种基于知识的强化学习方法,该方法利用领域知识来压缩智能体需要探索的状态空间,从而提高算法的收敛速度。文献[10]研究了窃听节点存在的条件下的无人机网络安全传输问题,提出了一种多智能体深度强化学习(MADRL,Multi-Agent Deep Reinforcement Learning)算法,通过联合优化无人机的轨迹、无人机发射机的发射功率和无人机干扰机的干扰功率来最大化安全容量。文献[11]考虑了一个合法无人机与智能窃听无人机的组合通信系统,通过构建零和博弈模型,并提出一种基于MADRL 的算法,获得合法通信链路节点的策略,优化合法无人机的功率、轨迹。该算法的不足是仅考虑两个无人机智能体,没有考虑多智能体协同抗干扰。文献[12]研究了无人机网络中联合信道和功率分配的抗干扰问题。首先将问题建模为一个局部相互作用的马尔可夫博弈以同时刻画无人机之间的竞争和协作关系。其次,提出了一种基于协作多智能体分层Q 学习的抗干扰通信算法来降低动作空间的高维特性,并分析了该算法的渐近收敛特性。文献[13]研究了无线传感器网络的智能抗干扰通信方法。引入随机博弈框架对多用户干扰问题进行建模和分析,提出了一种联合多智能体干扰算法,以获得最优的干扰策略。上述研究仅考虑数量较少的UAV 网络,将强化学习、深度学习等算法应用于多智能体空地一体化网络抗干扰传输的研究还有待完善。

针对以上问题,本文面向空地一体化网络场景,提出了基于多智能体强化学习(MARL,Multi-Agent Reinforcement Learning)算法的抗干扰传输算法,旨在抵御智能干扰机的恶意干扰,有效增强通信系统区域覆盖能力。具体来说,采用集中训练和分散执行的总体框架,采用近端策略优化(PPO,Proximal Policy Optimization)算法更新神经网络参数。每个UAV 均看做是智能体,每个智能体基于自己的观察和来自评论员的价值函数执行自己的动作。由于无人机的能量容量和计算能力非常有限,可以将离线集中训练上传到高空平台(HAP,High Altitude Platforms)[10],节省能量开销。本文的贡献可以概括为以下几点:

(1)首先,本文设计了一种针对三维空间的多UAV轨迹优化算法,所有UAV 动态调整自身发射功率使得系统内所有用户可达速率之和最大,从而最大化奖励函数,增加了优化问题的难度与复杂度。

(2)其次,将联合轨迹与功率的优化问题转化为一个稳健的马尔可夫决策过程(POMDP,Partially Observable Markov Decision Process)问题,每个UAV观测与其自身相关联的用户,而不需要从时变的多UAV环境中获得完整的信息。提出了一种基于MARL 的抗干扰传输算法,用于多UAV 场景下的轨迹设计和功率优化。

(3)最后,制定了一个集中训练和分步执行的框架。在集中式训练阶段,每个智能体通过与环境交互获取的经验存储在经验回放池中,然后使用经验池来训练演员-评论员网络。在分布式执行阶段,每个无人机都使用训练好的演员神经网络来生成相应的动作序列,以调整下一时刻的飞行位置和发射功率。仿真结果表明所提方法相较于对比算法具有优越性。

1 系统模型及问题建模

1.1 系统模型

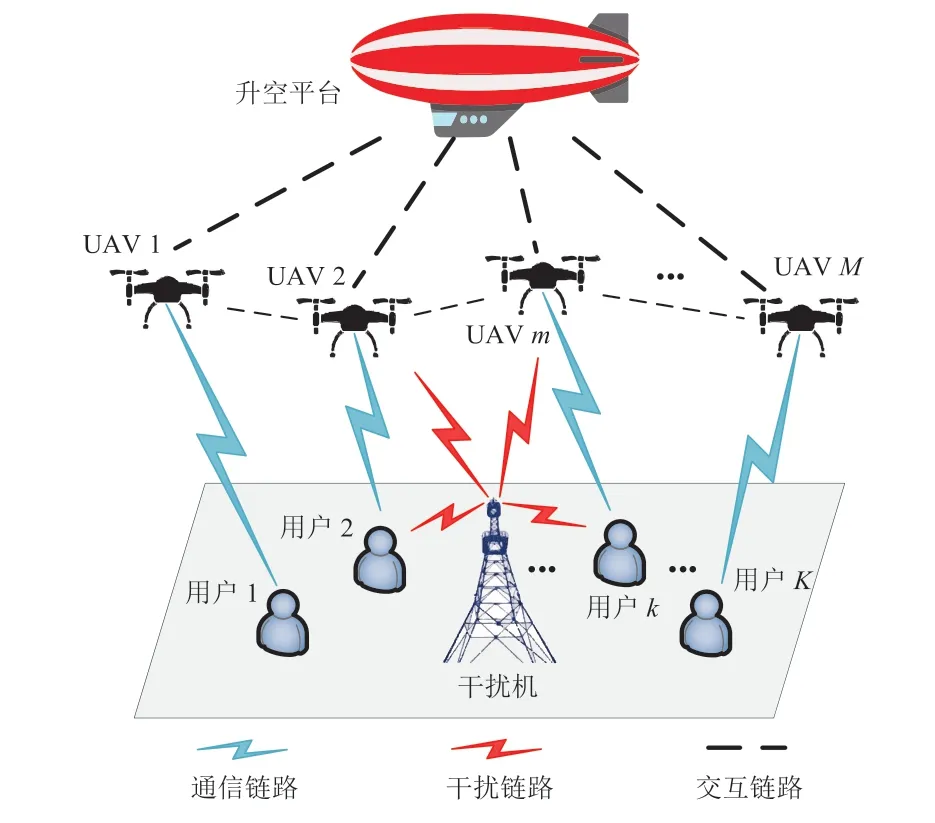

系统模型如图1 所示。考虑一个具有无人升空平台,M个无人机,K个用户和一个智能干扰机的多UAV 多用户大规模多输入多输出(MIMO,Multi-Input Multi-Output)通信系统,其中无人机均配备N根天线,用户均配备单天线,干扰机配备L根天线。在给定的系统模型中,干扰机对用户释放干扰信号,其目的是降低用户下行接收信噪比,影响通信质量。无人升空平台用于训练无人机网络,减轻无人机内部负担。本文研究目标是优化无人机飞行轨迹以规避干扰,并动态调整发射功率,使得系统所有用户的可达速率之和最大。

图1 系统模型

(1)信道模型

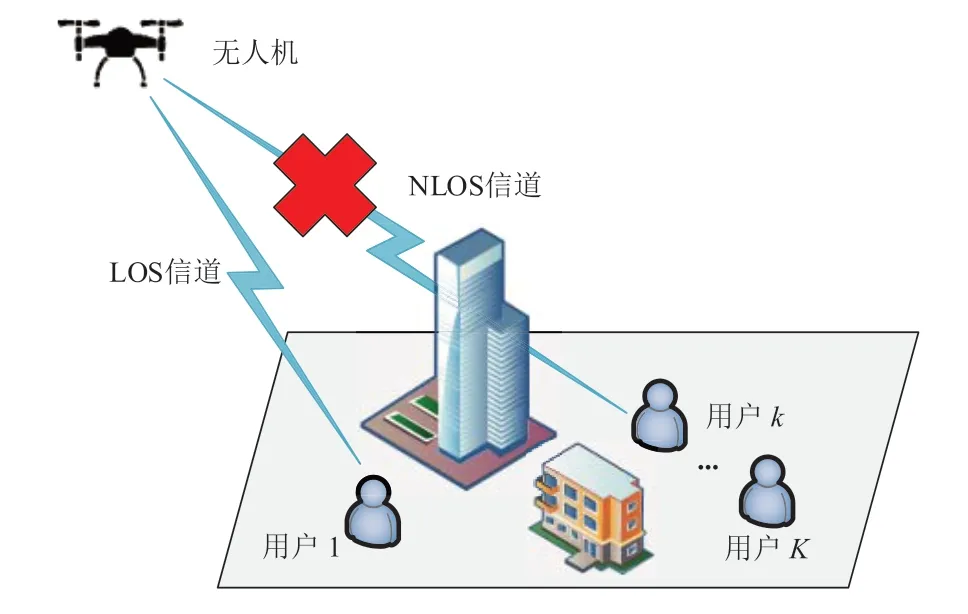

在地面环境较为复杂、障碍物较多时,无人机与用户之间的视距路径(LoS,Line of Sight)路径可能会被阻挡。因此,本文采用一种基于无人机飞行高度和仰角的概率视距(PLoS,Probabilistic Line of Sight)信道模型[14],来建模空地信道的路径损耗。基于概率的信道模型示意图如图2 所示,随着无人机的运动,无人机与用户之间的信道有可能被障碍物遮挡,由LoS 信道变成NLoS 信道。

图2 基于概率的信道模型示意图

(2)信号传输模型

干扰机的预编码矩阵可表示为:

则在t时刻用户k接收来自UAVm的SINR 为:

在t时刻用户k接收来自所有UAVm的可达速率为:

其中B是信道带宽。

1.2 UAV优化问题建模

假设所有UAV 的飞行高度固定不变,研究目标是优化无人机轨迹以规避干扰机的干扰,并动态调整发射功率,使得系统内所有用户的可达速率之和最大。基于以上假设,构建如下优化问题:

2 基于部分马尔科夫观测的MARL算法

对于优化问题,由于目标函数的非凸性以及用户可达速率与UAV 位置之间的耦合关系,式(15) 是个非凸优化问题,难以通过传统的凸优化理论来解决。强化学习使智能体能够通过不断与环境进行交互来获得最优策略,通常被认为是一种有效的技术,以次优的方式解决此类问题。然而,大多数基于强化学习的方法只考虑单个智能体系统,当网络节点数量增加时,多个智能体之间需要交换大量的网络信息,导致这些方法失效[19]。

在多智能体强化学习中,每个智能体在没有完整环境信息的情况下独立地选择自己的动作,有可能导致算法难以收敛、系统性能下降等问题。部分可观测马尔可夫决策过程(POMDP,Partially Observable Markov Decision Process)可用于建模具有不完全观测的随机决策问题[20]。在POMDP 中,系统状态并不是直接可见的,而是通过观测到的部分信息来间接推断,适用于具有不完全观测或感知能力受限的情况下进行决策的问题。

在本文考虑的多智能体环境中,每个UAV 均作为智能体,从环境中学习和更新经验。由于每个UAV 仅能观测到与自身相关联的信息,因此可以将优化问题转化为一个POMDP 问题,具体表示为:

(1)智能体:每一个UAV 都可以被视为一个智能体,每个智能体观察自己的状态并根据其策略采取动作,然后从环境中获得奖励并进入下一个状态。

(2)状态空间:在每个时间间隙,每个智能体观察环境的状态信息,从而制定相应的策略。时隙t的状态可表示为:

(3)动作:每个智能体的动作是其演员网络的输出,对于时隙t时的无人机m,其动作可以定义为:

(4)转移概率:智能体在执行动作at后,将以概率从当前状态st转移到下一个状态st+1。

(5)奖励函数:奖励函数是一种用来评估智能体行为的指标,它对智能体在特定环境中采取不同动作的结果进行评估,引导智能体朝着期望的目标行为进行学习。在优化问题中,其目标是最大限度地提高系统内所有用户的可达速率。因此,奖励函数应该设置为一个周期T内所有用户的可达速率之和。基于上述分析,本文设计的奖励函数如下所示:

在所提模型中,智能体通过观察环境,做出相应动作并从环境中获取奖励。每个智能体均有状态价值函数和状态-动作价值函数,其中π表示当前策略。强化学习算法通常通过最大化状态价值函数或状态-动作价值函数来改进演员网络的策略和增强评论员网络的评估能力。

状态价值函数表示在给定状态下,一个智能体可以获得的长期累积奖励的期望值,它衡量了当前状态的好坏程度。状态价值函数可表示为:

状态-动作价值函数表示在给定状态和采取某个动作后,一个智能体可以获得的长期累积奖励的期望值,它衡量了在某个状态下采取某个动作的好坏程度。状态-动作价值函数可表示为:

每个智能体的目的是使给定策略π的预期折扣奖励的价值最大化。在强化学习中,优势价值函数用于评估特定动作相对于一般动作的优势或价值,它可以通过状态价值函数和状态-动作价值函数的差异来计算,表达式为:

基于上述分析,POMDP 的目标函数可以表示为:

3 集中训练-分布执行框架与参数更新

3.1 集中训练与分布执行框架

由于多UAV 环境的状态空间庞大,简单的基于强化学习的方法难以寻找最优策略。MARL 模型是一种针对多UAV 环境的强化学习模型,旨在解决状态空间庞大的问题[21],并实现智能体之间的协作。该模型分为集中式训练和分布式执行两个阶段。

(1)集中式训练阶段

集中式训练阶段在HAP 实现,每个无人机需要学习下一个飞行位置和发射功率。训练过程中,通过从经验回放池中随机采样小批观测值来更新神经网络,从而避免总观测值之间的相关性,提高学习效率[22]。在演员网络中使用神经网络来参数化策略函数,并以高斯分布生成策略:

其中,θk表示演员神经网络的参数,是生成动作的标准差和平均值,其表达式为:

其中,v表示偏移向量。是演员网络的神经网络的隐藏层和输出层的激活函数。评论员网络负责计算优势函数,用于引导演员网络以低成本朝着梯度方向更新。同时,优势函数随着训练的进行而不断更新。与网络中的UAV 相比,HAP 具有显著的计算优势。因此,MARL 模型的训练可以在HAP 以离线的方式集中完成。经过充分的训练,模型可以用于分布式执行阶段。

(2)分布式执行阶段

在分布式执行阶段,每个无人机都使用训练好的演员神经网络来生成相应的动作序列,以调整下一时刻的飞行位置和发射功率。这样,无人机可以以分布式的方式提供联合服务。同时,使用评论员神经网络来评估每个无人机的动作,并根据时分误差算法来更新演员神经网络和评论员神经网络的参数。

基于以上分析,本文将基于MARL 的功率分配和轨迹优化算法总结如下。首先,对神经网络、经验回放池和参数设置进行初始化。将每个训练片段设置为T个时隙。在每个时隙t,智能体通过重要抽样来观察状态以获得传输速率、UAV 位置、飞行速度以及干扰功率,这是一种代替抽样的近似方法。在这一步中,只有演员网络起作用。然后将状态序列送入神经网络以计算接收奖励的动作。最后,每个智能体将转换元组存储在经验回放池中。

3.2 基于PPO算法的参数更新

本节对演员-评论员网络参数进行更新。近端策略优化(PPO,Proximal Policy Optimization)算法在实现方面更加简单且易于使用[23],同时也能提供接近信赖域策略优化(TRPO,Trust Region Policy Optimization)的性能。PPO 的核心思想是通过限制更新步长,使策略在每次更新中只发生适度的变化,改善了传统策略梯度算法的采样效率和稳定性。因此,本文采用基于剪裁和计数的PPO 算法来训练演员-评论员网络,该算法使用剪裁的比率函数来简化公式。为此,首先表示新策略与旧策略之间的概率比,即:

则演员网络的损失函数可以表示为:

最后,将PPO 应用于策略和价值函数的网络体系结构,在目标函数中增加了关于价值估计的均方误差项,以鼓励充分的探索。评论员网络更新的目标是最小化损失函数,其损失函数表达式为:

4 仿真结果

为验证所提的MARL 抗干扰算法性能,本节进行仿真验证。仿真环境设置为1 个HAP、4 个UAV、1 个干扰机和20 个用户的空地一体化网络,所有用户随机分布在半径为500 m 的覆盖区域内。每个智能体的演员和评论员网络都有两个完全连接的隐藏层,都包含50 个神经元。演员和评论网络的学习率均为0.000 1。此外,折扣因子为0.999,剪辑参数分布设置为,其余具体参数设置见表1。训练过程是离线的,在HAP 上运行。使用离线集中训练和在线分布执行方法的优点是,可以将所有的通信和计算开销都放在训练阶段,所提算法在测试阶段的执行速度相较于传统算法将会大幅提升。

表1 仿真参数设置

为了验证本文所提出的基于裁剪和计数的PPO 算法在MARL 方法训练中的性能,本文将该算法与其他两种策略梯度算法进行了比较。比较的算法如下:

(1)Vanilla PG[25]:一种基于梯度的最大化目标函数的学习策略的方法。它是一种无模型的、直接从经验中学习的强化学习算法,智能体根据当前的策略直接采样动作,然后使用采样得到的轨迹来估计梯度。

(2)信任域策略优化(TRPO,Trust Region Policy Optimization)[26]:TRPO 旨在提高策略梯度算法的稳定性和收敛速度,具有较高的实用性和性能。在TRPO 中,通过约束当前策略与上一次策略之间的差异,以限制每次更新的步长大小,从而控制更新对性能的影响。

(3)本文采用的PPO 算法:一种基于裁剪和计数的PPO 算法,通过限制更新步长,使策略在每次更新中只发生适度的变化,改善传统策略梯度算法的采样效率和稳定性。

图3 比较了上述三种算法所获取的系统奖励。从仿真结果可以看出,使用所提算法来训练神经网络可以获得单调递增的奖励。与其他两种算法相比,本文提出的算法在3 000 次迭代后具有更快的收敛速度和更高的奖励。这表明,本文所提改进算法可以有效地训练网络。由于PPO 算法使用了一个剪切比例变量,它可以限制策略更新的幅度,防止过大的策略变动。这样可以确保训练过程稳定而不会过度调整策略,从而相比其余两种算法可以获得更高的奖励和更快的收敛速度。

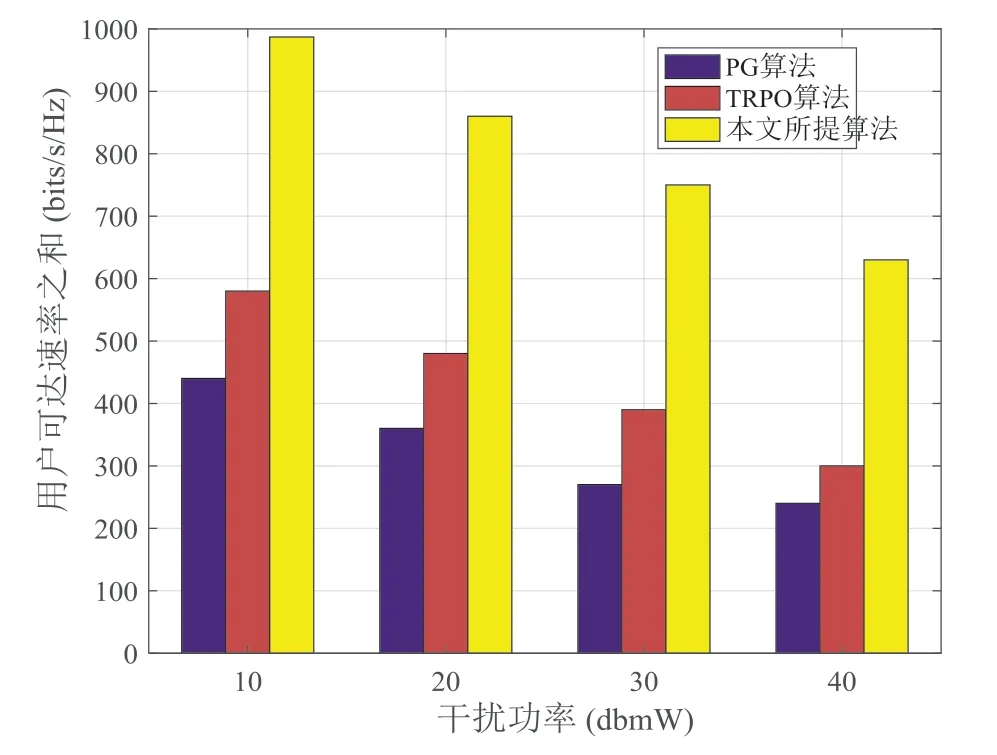

图4 比较了三种策略算法的所有用户的可达速率之和与干扰功率的关系,通过设置不同的干扰功率,对所提算法性能进行评估。可以看出,随着干扰功率的增加,用户的可达速率有所下降,但是本文所提算法所获取的可达速率高于其余两种算法。当干扰功率为10 dBmW时,本文所提算法比TRPO 算法获取的可达速率提升约为68.9%,说明在相同干扰功率条件下,本文所提算法具有一定的抗干扰性能,验证了所提MARL 算法的有效性。由于奖励函数是以用户可达之和为指标设计的,获取奖励越高,意味着用户可达速率之和越大。而本文所提算法可以获取最高的奖励,因此用户可达速率之和也最大。

图4 不同干扰功率下的可达速率之和

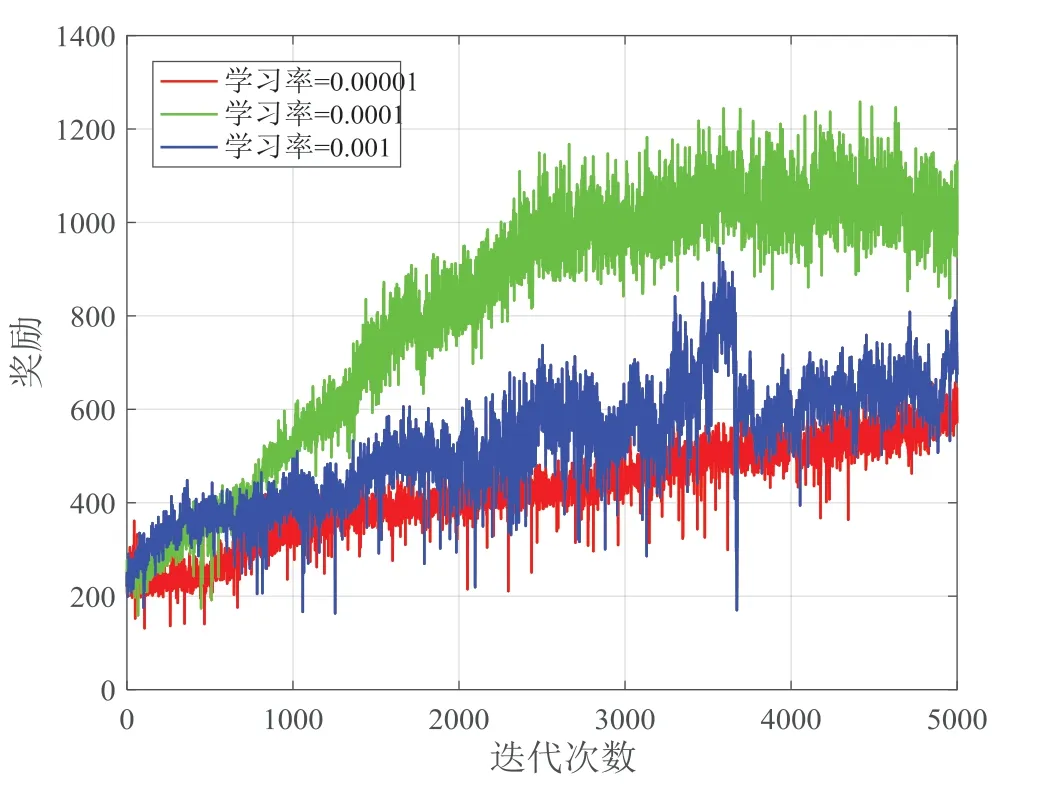

图5 仿真了所提MARL 算法在不同学习率下的性能。通过设置不同的学习率δ,对所提算法性能进行评估。将学习率δ分别设置为三个值:0.001、0.000 1 和0.000 01。仿真结果说明,当迭代次数较少时,δ=0.000 1 的奖励比δ=0.001 的奖励低,但随着迭代次数的增加,奖励也随之增加,并在大约3 500 次迭代后最终收敛。这是由于较大的学习率,例如δ=0.001,可能会导致训练模型的较大波动,从而难以找到最优策略,而较小的学习率,例如δ=0.000 01,会导致极长的训练时间。因此,考虑到算法的实际执行情况,将δ设置为0.000 1。

图5 不同学习率条件下的算法性能

5 结束语

本文提出了一种基于多智能体强化学习的抗干扰传输算法,旨在抵御空地一体化网络中的功率干扰,使所有用户的可达速率之和最大化。将无人机轨迹和功率联合优化问题转化为POMDP 问题,采用了集中式训练和分布式执行框架。在集中式训练过程中,每个智能体与环境交互获得的经验存储在经验回放池中,用于训练演员-评论员网络。在分布式执行过程中,每架无人机使用经过训练的演员网络根据观测结果输出动作,并调整其飞行位置和传输功率以提供联合服务。采用PPO 算法来更新演员-评论员网络参数,使其在复杂的多智能体环境中更加有效。仿真结果表明所提算法相较于传统算法具有优越性。