基于内外混合图像先验与图像融合的DIP改进降噪模型

徐少平 陈晓军 罗 洁 程晓慧 肖 楠

①(南昌大学数学与计算机学院 南昌 330031)

②(南昌大学附属感染病医院 南昌 330006)

1 引言

图像在获取和传输过程中,不可避免地会因各种原因而引入噪声。噪声图像中的噪声未经妥善处理将给后续的高层视觉任务带来严重影响,因此图像降噪问题在过去几十年来一直都受到研究者的持续关注,各类性能优异的降噪算法不断地被提出来[1,2]。近十年来得益于深度学习技术的迅速发展,基于深度神经网络(Deep Neural Network, DNN)构建的降噪模型在降噪效果和执行效率方面获得了前所未有的成功,且新的降噪模型不断被提出来[3,4]。根据在训练过程中是否需要无失真图像,这些DNN降噪模型可以划分为有监督和无监督两种类型。其中,FFDNet[5](Fast and Flexible Denoising convolutional neural network), RIDNet[6](Real Image Denoising), GCDN[7](Graph-Convolutional image Denoising)和Restormer等有监督[8]降噪模型分别应用了残差学习[9]、注意力机制[6]、图卷积[7]和Transformer[8]等主流网络结构。一般来讲,现有的有监督降噪模型虽然在通用数据集上能达到很好的降噪效果,但泛化能力不强。在处理有别于训练集的图像时,降噪效果就会不同程度地下降。故有监督降噪模型的性能受训练数据的影响很大,存在数据依赖(data dependency)的缺陷。

近几年,研究者进行的一系列研究试图让深度网络降噪模型训练摆脱对无失真训练图像的依赖,仅使用噪声图像进行训练的无监督网络模型受到普遍关注。例如,Lehtinen等人[10]提出N2N(Noise2-Noise)算法,该算法将统计学中点估计(point estimation procedure)的方式进行推广,其中网络的输入和目标图像均为噪声图像,初步放松了网络模型训练中目标图像必须为无失真图像的约束。尽管如此,N2N降噪模型想要得到性能比较高的降噪模型,仍然需要在大量的噪声图像集上进行训练,且这些噪声图像集中的图像必须是采集于同一场景,然而收集相同场景的噪声图像在实际应用中仍然受到很大限制。为解决此问题,Krull等人[11]提出了一种被称为N2V(Noise2Void)的降噪模型。该降噪模型假设无失真图像中的相邻像素点之间的亮度值是相互关联的,而噪声像素的亮度值是相互独立的。基于此,提出用盲点网络(blind-point network)作为降噪模型的骨干网络。通过将输入图块的中心像素进行掩模处理,而其值作为网络的预测输出。这样就可以建立中心像素周围的像素点与中心像素点之间的网络映射关系,这样用于训练模型的噪声图像不再需要来自同一场景,从而在N2N模型的基础上进一步放松了对训练图像的约束。然而N2V降噪模型对噪声分布的假设导致无法很好地处理空间位置相关的噪声(噪声像素点之间具有相关性)。最近,Huang等人[12]提出的Ne2Ne(Neighbor2-Neighbor)降噪模型,使用一种随机邻域子采样器(random neighbor sub-sampler)巧妙地生成训练图像对,为解决无监督降噪模型准备训练图像问题提供了一种新的思路。然而,随机邻域子采样器将图像的分辨率降低了一半,导致降噪性能存在一定程度的下降,且不适于处理与空间位置相关噪声(spatially-correlated noise)和极暗图像(extremely dark images)。简而言之,上述无监督降噪模型在训练过程虽然解除了对无失真图像的需求,但仍然要求有大量的噪声图像才能工作,这在实际应用中仍然存在很大的局限性。

Ulyanov等人[13,14]近年提出的DIP(Deep Image Prior)模型仅需要噪声图像本身和合适的网络结构(即U-Net[15]),就可以利用网络结构本身所获得的内部先验(internal prior)信息完成降噪,而不需要大量的噪声图像数据集进行训练,对训练图像的要求进一步降低。然而,DIP降噪模型虽然解决了有监督、无监督降噪模型需要大量训练数据的问题,但与大多数现有的降噪模型相比,DIP模型的降噪性能还存在明显的差距,特别是在合成噪声图像方面。为了解决上述问题并基于对DIP降噪模型降噪过程在图像细节恢复上具有不确定性(uncertainty)的特点,本文提出一种基于内外混合先验和图像融合的改进DIP降噪模型(Improved Deep Image Prior, IDIP)。在合成噪声图像和真实图像上大量的实验表明:与DIP原模型相比,IDIP降噪模型的降噪性能得到显著的提升。其降噪性能已显著优于其他主流的无监督降噪模型,即便在合成噪声图像上也能达到甚至超过当前新近提出的有监督降噪模型。

2 深度图像先验(DIP)

一般地,基于给定的噪声图像y获得关于无失真图像x的最佳估计图像的问题可以采用式(1)所定义的最小化问题进行求解[14]:

其中,E(·,·)是保真项,R(·)是正则项。保真项E(·,·)主要的作用是确保降噪后图像xˆ与噪声图像y接近,以限定图像在图像空间(image space)上的搜索范围。而正则项R(·)则是利用关于图像的各种先验知识建立约束条件,使得图像xˆ具有较少的噪声的同时具有最佳的自然性(naturalness)。在DIP降噪模型中,其核心关键技术就是利用深度卷积神经网络fθ(·)参数化图像I[14],即I=fθ(z)。这里,z是随机生成的噪声(满足某种先验分布,作为神经网络的输入),I是待参数化图像(即降噪后图像),θ是网络参数值集合。具体地,DIP降噪模型用式(2)实现对式(1)的近似求解(取消了R(x)正则项):

即让深度网络模型f通过不断调整网络参数值θ,使得网络输出图像fθ(z)不断逼近噪声图像(目标图像)y。在某个迭代步数所对应网络参数θ*的作用下,网络输出图像xˆ*=fθ*(z)能与噪声图像y在图像空间中比较接近,同时图像xˆ*中的噪声比较少。此时,以随机噪声z在f(网络参数值θ*)的作用下所得到网络输出图像xˆ*作为无失真图像的最佳估计。DIP降噪模型在网络具体实现上主要利用了所谓的U型编码-解码(encoder-decoder)网络架构来构建网络模型,编码器和解码器同层结构之间由Skip连接建立联系,保证原始特征信息不损失。

无监督DIP模型针对给定噪声图像,通过在线训练方式获得降噪后图像(训练过程即为降噪过程),其所使用的网络模型参数是与给定噪声图像相关的,即所谓的特定图像网络(image-specific network)。所以它的网络参数值是与图像相关的(是可变的),在图像局部区域细节复原上较有监督模型更具灵活性,能获得更好的复原效果。尽管如此,DIP降噪模型在整幅图像上的降噪效果实际上仍远低于DnCNN(Denoising Convolutional Neural Network)[9], FFDNet, Restormer等降噪方法,甚至对于同样是仅利用图像内部先验信息的BM3D[16]经典算法而言,DIP模型很多时候也达不到它的降噪性能。其主要的原因在于噪声图像(目标图像)质量过低和仅利用给定噪声图像内部的信息。

3 IDIP降噪模型

3.1 改进思路

为实现在保持无监督DIP方法灵活性的基础上极大提升其降噪性能,采用以下两项降噪性能提升措施来实现上述目标:

(1) 使用具有更高图像质量的图像作为目标图像。为了获得更高图像质量的目标图像,本文从内部和外部先验的两类主流降噪方法中各选1个有代表性的降噪方法处理给定的噪声图像获得2张预降噪图像并使用空间随机混合器将它们合成为1张混合图像后作为第2目标图像(原噪声图像仍作为第1目标图像)。新增第2目标图像具有较高的图像质量,相当于在DIP模型中增加了正则项,可以约束DIP网络输出图像的范围,有效防止DIP对噪声图像的过拟合,从而提高降噪性能。从宏观角度来说,与DIP模型使用单目标图像仅能利用内部图像先验信息不同,IDIP降噪模型在内部图像先验的基础上引入了外部图像先验知识约束降噪过程,有望获得更高的降噪效果。

(2) 利用DIP模型的不确定性。DIP模型具有不确定性,即便在相同的约束条件下(相同的网络输入、相同的目标图像和相同的迭代步数)所输出的降噪后图像也不完全相同,这些图像在图像局部区域的重构误差存在有高有低、互为补充的特性。为此,本文提出利用图像融合技术对这些具有互补性的DIP输出图像进行融合并将融合后图像作为最终的降噪图像。最为简单而常用的图像融合框架就是加权融合,即通过为不同的样本图像设置不同的加权系数值实现。目前这种设置权值的方法主要根据各个像素点在视觉上的重要性设置,其值在很多时候靠人工经验设置[17]。为了获得一种通用性好且易用的权值生成方法,本文提出利用深度卷积网络(Deep Convolutional Neural Network, DCNN)作为非线性映射函数,直接接受需要参与融合的样本图像,通过设置合理的Loss函数,在最小化Loss值的训练过程中,通过网络参数的调整使得DCNN网络将输入的多张样本图像映射为单张融合图像(具有最高的图像质量,作为最终的降噪后图像)。整个过程实质上是一种无监督、无人工干预的权重设置方法,各个像素点具体权重值设置大小均隐式蕴藏在DCNN网络海量的网络参数中。

3.2 执行流程

根据上述改进策略,在具体实现中IDIP降噪模型由两个串行执行的模块组成,分别对应两次图像质量提升过程,执行流程的框架如图1所示。(1)第1阶段为样本生成阶段,其目标是在原DIP框架下基于双目标图像生成足够多的输出(样本)图像。具体地,首先选用两种分别来自内部和外部先验的主流降噪方法处理给定的噪声图像获得两张预降噪图像,记为Iint和Iext。为了能够生成图像质量更高且更具多样性的样本图像,所提出的IDIP降噪模型使用空间随机混合器(spatially random mixer)将它们混合成1张图像后作为第2目标图像。然后再使用不同的随机输入和目标图像(其中第1目标图像(即噪声图像)保持不变,而第2目标图像由于是随机混合生成的,均不同)的约束条件下多次执行标准DIP在线训练降噪流程,以生成足够多的m张样本图像xˆi。(2)第2阶段为样本融合阶段。其目标是将上一阶段生成的具有互补性的m张样本图像进行有效融合,将融合后具有更高图像质量的融合图像作为最终的降噪图像。具体地,为了让所获得的样本图像更具随机性和稳定性,首先按照50%的比例,随机丢弃生成的样本图像,最终获得n=m/2张样本图像{si|i=1, 2, ···,n}参与融合。然后,对参与融合的样本图像进行拼接(concatenation)操作,送入UNet骨干网络[18]中完成多尺度融合,网络的输出图像即为融合后图像(作为最终的降噪图像)。UNet网络为一种流行的Encoder-Decoder结构,它可以有效地捕获多尺度特征并产生具有丰富细节的结果。为了获得与给定噪声图像内容自适应的降噪结果,UNet骨干网络的训练模式被设置成无监督模式,以Loss函数(通过设计让融合图像最大限度保留样本图像共性的细节内容)值最小化为导向,通过网络训练调整UNet网络参数,使得最终融合图像能最大限度地利用样本图像互补性,从而确保融合后的图像(作为最终的降噪后图像)的图像质量能比融合前的各样本图像进一步得到提高。

图1 IDIP降噪模型的执行流程

3.3 样本生成阶段

首先利用分属内外图像先验的降噪方法(即BM3D和FFDNet)生成2张预处理图像。然后,利用空间随机混合器将2张预处理图像混合,混合后的图像作为目标图像ti。该空间随机混合器从两个初始降噪图像Iint和Iext中分别提取一部分像素,并将它们组合成一个整体图像作为第2目标图像。理论上来讲,可任意选择混合比例,但4.2节的消融实验表明在两个初始降噪图像中分别提取50%的像素点构成第2目标图像时的降噪效果最佳。故每次生成第2目标图像时,随机生成一个掩码来确定混合图像从Iint图像中提取像素点的空间位置(占比50%)。同时,通过反转掩码来确定混合图像从Iext图像提取像素点的空间位置(占比50%)。需要说明的是:本文选用BM3D和FFDNet两个降噪算法生成预处理图像,这是因为之前的工作已经通过大量实验发现两者所生成的预处理图像之间具有很好的互补性[18],能保证目标图像ti中更有更高的图像质量。本文提出多次从BM3D和FFDNet图像中各自随机抽取50%像素点构建目标图像,在保证获得内外先验信息的同时,获得多个不同的目标图像,从而可以利用DIP生成多个不同且互补的样本图像,从而为融合阶段打下基础,更详细的实验分析可以参见4.2节消融实验。

如图2所示,为了更为充分地利用DIP模型的不确定性,本文按照原DIP降噪的流程,但使用不同的随机输入zi、不同目标图像生成足够多的样本图像。由于含有2个目标图像(ti和y),所以IDIP降噪模型使用的Loss函数定义为

图2 双目标图像的样本图像生成框架

其中,Loss函数Lmix用于度量DIP网络输出图像与第2目标图像(混合图像ti)之间的MSE距离

Loss函数Lnoisy定义为度量DIP网络输出图像和第1目标图像(噪声图像y)之间的MSE距离

其中,Lnoisy其实就是原DIP降噪模型所采用的Loss函数,新增的Lmix项具有正则项的作用,能确保DIP的迭代过程在图像空间中收敛到更为合理的位置。这样,通过多次运行标准的DIP降噪方法即可以获得m张样本图像。

所提出的样本图像生成方法的优点是:不仅利用了内部和外部图像先验信息,还利用了给定噪声图像中未被破坏的信息,并且不需要对DIP骨干网络进行任何修改。其中,内部图像先验知识涵盖了BM3D算法所利用的图像自相似性和稀疏性以及DIP 模型自身所利用的图像低级统计特性,而外部图像先验知识则由在大量训练图像集合上所获得的FFDNet模型提供。经过双目标图像改进后,IDIP模型所输出的图像(样本图像)的图像质量已经显著超过原DIP降噪模型(采用单目标图像)。需要说明的是:本文并未在使用3个或更多初步降噪图像构成的混合图像上观察到更高的降噪效果,因此仅选用内外两种图像先验算法生成混合图像作为第2目标图像。更多的实验结果列在4.2节的消融实验中。

3.4 样本融合阶段

如图3所示,给定一组图像样本{sk|k=1, 2,·, n,n=m/2}(关于n值的设置,可参见4.2节消融实验),使用拼接(concatenation)操作联结这些样本图像后直接作为UNet网络的多通道输入,整个UNet骨干网络主要由收缩路径和扩展路径组成,其中编码器通过连续下采样操作提取图像潜在(latent)特征,而解码器从提取的特征中重建图像(1个通道,相当于完成图像融合操作)作为降噪后图像。网络采用无监督方式训练,融合后的图像xF分别与n个样本图像的MSE值累积和构成Loss函数

图3 无监督样本图像融合框架

在式(6)中,若要使得Loss函数值最小,图像xF中某一处像素点位置的亮度值必须与多张样本图像同一位置差别最小。这些类似于NLM算法[18]的工作原理,从而确保了融合图像的图像质量。由于所提出深度图像融合网络工作在无监督模式,所以它具有以下优点:(1)无需人工干预。整个过程无需人工设置任何参数,克服了人工设置权重值所带来的不确定性。(2)扩展性好。深度融合网络采用的是多通道输入模式,可以接受任意多个的样本图像,能完美配合样本生成阶段的工作,并通过融合策略再次提升降噪性能。

4 实验结果及其分析

4.1 测试环境配置

为了全面评价IDIP降噪模型的降噪性能,将其与BM3D[16], NCSR[19], WNNM[20], DnCNN[9],FFDNet[5], VDNet[21], CsNet[22], DIP[13], N2V[11],Ne2Ne[12]和Restormer[8]共11个降噪方法在Set12[5],BSD68[22]和SIDD摄像头图像[23]数据集合上进行了测试。其中Set12与BSD68分别由12, 68张灰度图像构成,SIDD数据集是通过相机拍摄得到的高分辨率彩色图像集。所有对比方法都在相同硬件平台(Intel(R) Xeon(R) CPU E5-1 603 v4 @ 2.80GHz RAM 16GB, GPU为NAVIDA RTX 3 090 )和软件环境(Window10操作系统)上运行。

4.2 消融实验

为了对比不同图像作为目标图像对生成样本图像的图像质量影响,本文在Set12基准数据集上进行了消融实验。表1给出了分别以噪声图像(N)、BM3D预处理图像(B)、FFDNet预处理图像(F)、混合图像ti作为单目标图像、噪声图像联合单一与处理图像(N+B与N+F),以及以噪声图像联合混合图像(N+ti)作为双目标图像,在各自情况下所生成样本图像的PSNR均值。表1中数值为数据集中各图像在不同目标图像条件下所获得降噪后图像的PSNR均值。由表1可以发现:以BM3D或者FFDNet为目标图像,相比于以噪声图像为目标图像的原DIP模型,PSNR值都有提升,表明使用具有较高图像质量的初始降噪图像作为目标图像能提升降噪效果。而选择从FFDNet和BM3D两个初始降噪图像中分别提取50%的像素组合的混合图像ti(0.5,0.5)作为目标图像,相比于单独以BM3D或者FFDNet为目标图像,PSNR值又有较大幅度的提升(达到了0.6 dB),这表明BM3D和FFDNet预处理图像之间具有一定的互补性。此外,以噪声图像和单一预处理图像一起作为目标,生成的样本图像同样比单独BM3D或者FFDNet为目标图像的PSNR值有明显增加,从而使得生成的样本图像质量得到进一步提升,这说明引入噪声图像作为目标图像是有益处的。这是因为混合图像是由预处理图像混合后生成的,预处理图像某些像素点难免在降噪过程中被过度光滑而失真。与此相补充的是噪声图像中这些像素点则可能未受噪声干扰,相对而言与无失真图像更为接近,噪声图像中仍然含有大量对图像降噪有用的信息。最后,为了分析BM3D和FFDNet初始降噪图像参与混合的比例对降噪性能影响,选择了(0.25,0.75), (0.75,0.25)和(0.5,0.5)3种组合情况进行比较,结果表明在样本生成阶段,IDIP模型选择将混合图像和噪声图像共同构成双目标图像生成样本图像,且在混合图像中BM3D和FFDNet初始降噪图像各占比50%时具有最佳降噪效果。

在IDIP模型中,使用多少张样本图像是样本融合阶段的一个重要的超参数。为此本文在Set12基准数据集合上完成了对2~8张样本图像(实际生成4~16张样本图像)进行融合的消融实验,实验结果如表2所示。由表2可知:选择5张样本图像时的PSNR均值最高,而选择4张和6张时,PSNR值仅比前者低0.02 dB。考虑到选择4张样本图像与选择5张样本图像进行融合的PSNR值相差较小,而效率却提升了许多。需要说明是,随着参与融合的样本图像逐渐增多,融合效果存在过拟合的趋势。因此,在样本融合阶段,IDIP模型最终选择4张样本图像参与融合。

表2 使用不同样本数量参与融合所获得降噪后图像的PSNR均值比较(dB)

4.3 合成噪声图像降噪

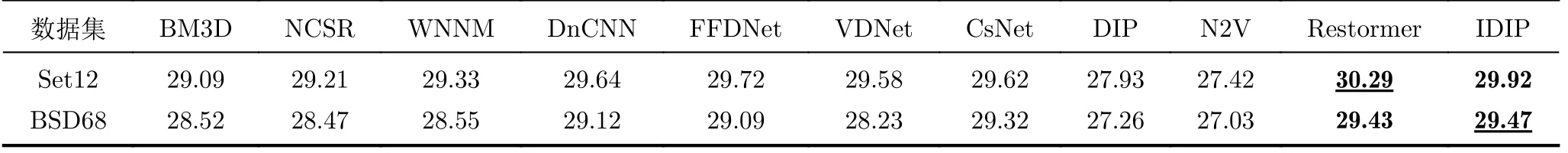

为了全面地验证IDIP降噪模型的降噪效果,在Set12和BSD68图像中分别人工添加了噪声水平值从10到60、间隔为10的高斯噪声。表3列出了各个对比方法在两个数据集和各个噪声水平值上所获得的PSNR平均值,其中排名第一的数据加粗且加下划线表示,排名第二的数据仅加粗表示。由表3可知:IDIP方法在两个数据集的所有噪声级别上综合排名均为前二。其性能显著超过了基于内部图像先验构建的降噪算法(包括BM3D, WNNM,DIP和N2V)和基于外部先验构建的降噪模型(包括DnCNN, FFDNet和VDNet降噪模型),这充分说明本文所提出性能提升策略是有效的。即使与新近提出的有监督Restormer降噪模型相比,IDIP方法也有很强的竞争力。两者在Set12数据集上差距并不大,而在纹理细节更为复杂的BSD68数据集上IDIP方法有少许优势,这表明IDIP模型处理复杂图像更具优势,它能利用外部图像先验方法先对图像中占比例较大的常见图像内容进行处理,然后再利用DIP善于处理图像中特定复杂的纹理细节优势处理占比例较少的图像特有内容,这样总体上获得更高而鲁棒的处理效果。

表3 各对比方法在Set12和BSD68数据集上的平均降噪性能比较(dB)

4.4 真实噪声图像降噪

在现实生活中,噪声图像中的噪声分布往往并不符合常规的高斯噪声分布假设。因此,现有降噪方法在应用于实际真实图像的降噪时,往往并不能获得理想的降噪效果。为了验证IDIP方法对真实降噪图像的处理效果,在SIDD摄像头数据集上随机挑选出10张不同场景(正常光照条件下)的图像用于对比实验。统计各降噪方法在这些图像上所获PSNR的平均值后发现:IDIP模型相较用于生成先验图像的FFDNet和CBM3D方法平均分别高出6.09 dB和5.51 dB,较DIP降噪模型也提升了1.04 dB,但低于Restormer 4.5 dB。在降噪效果视觉方面,从图4所示的一张场景上可以观察到:IDIP的降噪结果相比FFDNet和DIP具有显著优势,并与Restormer在视觉上获得相当的效果。需要说明的是:虽然Restormer在客观评价指标上最优,但它所用降噪模型是在SIDD正常光照图像上专门训练的,存在着有监督降噪模型典型的数据依赖缺陷,在低照度图像和医学图像数据集上表现不佳(限于篇幅,这里未提供具体实验数据)。而IDIP方法则具有更好的鲁棒性,更适用于各种真实场景图像的降噪。

图4 各对比方法在SIDD数据集上的降噪视觉效果对比

5 结束语

在原DIP无监督降噪模型的基础上,本文通过双目标图像样本生成和无监督样本融合两个连续执行的性能提升模块获得了一种新的被称为IDIP的降噪方法。从宏观的角度来看,IDIP降噪模型相当于先用经典的内外先验降噪算法(模型)将噪声图像中通用性的内容进行大体的处理,然后利用DIP善于处理特定图像局部细节内容的优势,对降噪后图像若干局部细节再进行精细微调处理。对于人工合成噪声图像而言,改进后的IDIP降噪模型的降噪效果总体逼近当前新近基于Transformer提出的有监督降噪模型,充分展示出内外图像先验信息的合理利用以及图像融合这两项性能提升策略是有效的。而对于实际的真实噪声图像,则在降噪效果的鲁棒性上拥有显著优势。总之,IDIP降噪模型不但显著地提升了降噪性能,还保留了原DIP降噪方法处理降噪图像的灵活性,使得它在缺乏训练数据集合的应用场景中具有广泛的应用前景。