与AI“共舞”:系统化视角下的AI−员工协作*

尹 萌 牛雄鹰

与AI“共舞”:系统化视角下的AI−员工协作*

尹 萌 牛雄鹰

(对外经济贸易大学国际商学院, 北京 100029)

AI−员工协作是一个以高效完成任务为目标, 由“AI−人−组织”构成的交互系统。促进AI−员工协作对于推动AI与实体经济的深度融合, 以及员工在数字化时代的心理健康与职业发展至关重要。AI与员工的交互关系错综复杂, 现有研究呈现碎片化特点, 缺乏对AI−员工协作的整体认识。因此, 有必要在厘清相关概念的基础上, 对AI−员工协作的相关研究进行系统地梳理。通过对相关研究的系统性回顾, 本文厘清了AI和AI−员工协作的内涵, 梳理了AI−员工协作系统的构成要素, 分析了构成要素的作用和影响, 并进一步基于系统化的视角构建了一个研究框架。最后, 基于AI−员工协作的研究框架提出未来研究展望。

人工智能, AI−员工协作, 系统化视角, 研究框架, I-P-O

1 引言

AI作为推动科技跨越发展、产业优化升级、生产力整体跃升的重要驱动力量, 基础性、关键性作用日益凸显。但如何推动各类AI技术的落地应用, 促进AI和实体经济融合, 成为AI产业发展亟需解决的难题。微观层面, 大量组织在积极拥抱AI时, 也在眼花缭乱的技术浪潮中遭遇了数智化转型的失败(Canhoto & Clear, 2020)。许多企业在AI上投入大量的资源, 但却未能获得预期收益, 甚至还造成了一系列负面的后果(Fountaine et al., 2019)。德勤在针对152项AI项目的调查中发现, 47%的项目存在AI与员工协作困难的问题; 《中国数字经济发展观察报告》的调查结果也显示, 尽管64%的高管推动AI项目, 但仅有12%的AI与员工有效合作。究其原因, 主要在于AI带来的结构性改变与员工认知、情感和行为反应之间张力, 反映在AI与员工之间未能形成持久、稳定的协作关系(谢小云等, 2021)。因此, 揭示AI−员工协作的内在机制, 帮助组织在优化AI−员工协作时有的放矢, 对于促进AI产业的发展以及提升AI的组织有效性有重要意义。

在此背景下, 组织中的AI研究也如火如荼地展开。AI作为底层技术在组织中的应用方式较为丰富, 不同应用情境下的研究关注焦点也不尽相同。AI可以完全独立地完成工作(如, AI驱动的自动化系统), 也可以扮演管理者的角色(如, AI算法管理), 履行计划、执行、控制、绩效反馈等管理职能(Tong et al., 2021); 也可以扮演同事或助手的角色, 与员工协作完成任务(Jia et al., 2023)。不足的是, 尚未有文献在对AI不同应用方式做出区分的基础上, 对AI和AI−员工协作的概念内涵进行系统阐述, 这导致了组织中AI含义的模糊以及不同AI应用方式的概念间的混淆。此外, AI−员工协作的研究具有跨学科的碎片化和复杂性, 整体呈现研究范式不统一、理论不清晰和机制未厘清的特点。尽管已有综述类文献关注AI−员工协作的相关议题(如: Seeber et al., 2020; Tsai et al., 2023), 但尚未有文献对已有研究进行系统梳理并构建AI−员工协作的研究框架, 厘清AI−员工协作的构成要素、内在机制, 这也导致缺乏对AI−员工协作研究现状和未来发展走向的整体把握。

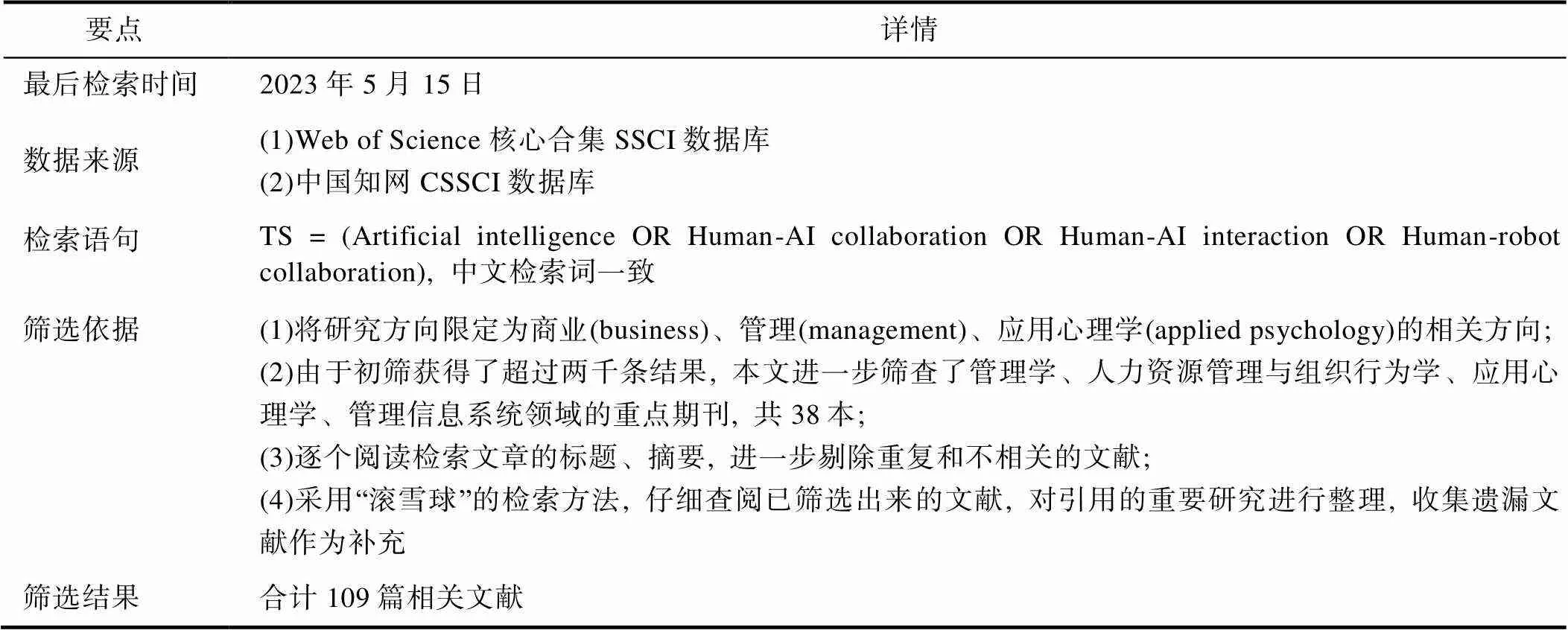

鉴于此, 本文对AI−员工协作的相关文献进行了全面检索(检索流程和规则如表1所示)。根据Webster和Watso (2002)的建议, 对文献的发表信息、理论基础、核心研究结论等内容进行了编码, 深入阅读文献后, 基于系统性综述的方法组织文章内容并构建研究框架。本文首先阐述了工作场所AI和AI−员工协作的概念、内涵、维度; 其次, 基于AI−员工协作的系统化分析视角, 梳理了AI−员工协作系统的输入项、过程项和输出项, 并在此基础上构建了一个研究框架。基于本文提出的研究框架和现有研究的不足, 提出未来研究展望。通过上述研究, 有助于我们更深刻、系统地理解AI−员工协作, 推动组织中AI研究的深化, 进而更好地帮助组织在实践中优化AI−员工协作, 提升AI的组织有效性。

表1 检索流程和规则

2 工作场所AI的概念、内涵和维度

随着AI在工作场所的广泛应用, “人工智能”、“机器人”、“算法”等与AI相关的概念层出不穷, AI在工作中担任的职能或扮演的角色也多种多样。为此, 本文首先厘清工作场所AI的概念、内涵和维度, 并对本研究关注的AI−员工协作进行详细地阐述。

2.1 工作场所AI的概念

AI是指能够执行通常与人类思维相关的认知功能的机器, 如学习、互动和解决问题(Nilsson, 1971)。在心理学和组织管理领域, AI的功能主要包括从外部(包括自然语言)或其它计算机系统收集信息, 解释信息、预测模式、推导规则或预测事件, 生成结果、回答问题或向其它系统提供指示, 评估其行动的结果并改善其决策系统以实现特定目标(Ferràas-Hernáandez, 2018)。在对未来技术的设想中, AI是能够和人类一样, 甚至能够比人类更好地执行所有任务的通用智能。但受限于技术发展水平, 具有通用智能的超级AI或强AI目前尚未成熟。本研究主要关注的是目前在组织中被广泛使用的弱AI或狭义AI, 即能够实现对人类智能的片段进行模拟的各种AI驱动的智能技术, 比如人脸识别、声音识别和理解、智能推荐算法、聊天机器人等(Charlwood & Guenole, 2022)。

AI在现实中的表现形式包括机器人AI、虚拟AI和嵌入型AI (Glikson & Woolley, 2020)。机器人AI是指由AI技术驱动的具备实体形态的机器人。其中, 最受组织管理研究者关注的是AI驱动的社交机器人(Yam et al., 2022), 例如Pepper机器人。除了AI驱动的社交机器人外, 常见的机器人还包括工业机器人。根据国际机器人联合会的定义, 社交机器人是为人类或设备执行有用任务的实体, 而工业机器人是自动控制的、可再编程的多用途操作臂(IFR, 2022)。前者由AI驱动, 而后者是预先编程设计的(Yam et al., 2022)。虚拟AI是指由AI驱动的虚拟主体, 这种AI不具备实体形态, 例如ChatGPT、AlphaGo、Siri等。其中, 由于机器人AI和虚拟AI都是应用AI理论与技术制造的AI机器, 能自主活动的软件或者硬件主体, 因而又被统称为智能体AI或智能体(龚群, 2023)。最后, 嵌入型AI没有视觉表现或特别的身份, 它嵌入到不同类型的应用程序中, 比如搜索引擎和GPS地图, 嵌入型AI对于使用者而言是“隐形”的, 而用户可能并不知道它的存在(Glikson & Woolley, 2020)。

2.2 AI−员工协作的内涵

在探究技术与工作关系的研究中, 传统的分析视角倾向于将技术视为工具或媒介:工具视角关注员工如何利用技术工具提升绩效表现(Nelson & Irwin, 2014); 媒介视角关注员工如何利用技术促进团队沟通(Bechky, 2003)。但这两种视角局限于人主体性的领导地位, 而忽视了AI的主体性。为克服这一不足, Anthony等(2023)通过整合分布式认知理论和行动者网络理论, 提出了AI−员工协作的系统化分析视角(以下简称“系统化视角”)。该视角将AI视作与用户、组织等利益相关者具有等同性的行动主体, 认为AI、用户、组织共同推动了AI的设计、实施和使用。系统化视角下, AI−员工协作是一个以高效完成任务为目标, 由“AI−人−组织”构成的交互系统(Anthony et al., 2023)。据此, 本文采用系统研究常用的I-P-O范式(Ilgen et al., 2005), 从系统的输入(Input)、过程(Process)和输出(Output)三个方面构建AI−员工协作系统的研究框架:输入层面, 由AI、员工、组织三方行动主体构成; 过程层面, 包含AI−员工协作的任务构型; 输出层面, 包含AI、员工、组织受到的影响。

在AI−员工协作的系统中, AI是指人工智能技术驱动的, 能够协助或与人类合作执行任务的软件和硬件的统称(Moussawi et al., 2020)。此类AI区别于AI驱动的自动化系统和AI驱动的算法管理, 它们通常在工作中扮演助手、同事的角色, 与员工协作完成任务, 因而也有研究将其称之为AI助手(Jia et al., 2023)、AI同事(Savela et al., 2021)、AI团队成员(Seeber et al., 2019)等, 下文均以AI代称。本研究除了涉及常见的智能体AI外, 还涉及嵌入型AI驱动的软件系统, 这类AI虽然不具备智能体的实体或虚拟形态, 但同样可以与员工进行协作。例如, 为在线客服配备的AI助理(Jia et al., 2023), 具备简单问答, 收集客户信息、生成客户画像, 对消费意向做出初步判断等功能。

3 AI−员工协作的系统性研究框架

系统化视角下, “AI−人−组织”共同构成了交互系统, 它们围绕目标任务推动AI的设计、实施和使用(Anthony et al., 2023)。这意味着, AI、员工和组织构成了AI−员工协作系统的输入端, 它们之间相互独立, 共同决定最终的输出结果; 而任务特征是过程项, 体现了输入如何转化成结果。据此, 本文基于现有文献, 从AI的技术特征因素、员工个体因素、组织情境因素和任务构型四个方面进行回顾。

3.1 AI的技术特征

随着机器智能的日益强大, AI与人之间出现相互渗透的趋势。在系统化视角下, AI的主体性得到重视, AI的技术特征成为协作系统的主要驱动因素之一(Anthony et al., 2023)。例如, Seeber等(2020)在对65名科学家的采访中发现, 建构AI与员工的团队应首先关注机器的外观、可视性、可靠性等技术特征; Yoon和Lee (2019)指出, 要实现成功的人机交互, 设计AI时应把握好用户友好、准确性、可靠性等十个技术特征。本文在对现有文献归纳总结的基础上, 借鉴Glikson和Woolley (2020)中对AI特征的维度划分, 从物理属性、心智属性和伦理属性三个维度刻画AI的技术特征。

3.1.1 AI的物理属性

AI的物理属性主要从有形性和拟人性两个角度进行刻画。

有形性是指AI的虚拟或实体形态(Glikson & Woolley, 2020), 拟人性是指AI的外观、声音、表情、性别等物理特质的拟人化程度(Alabed et al., 2022)。关于AI有形性和拟人性的研究已较为丰富, 并得出了较为成熟的结论。研究发现, 相比于虚拟形态的AI, 具有实体形态的AI (如机器人AI)更能获取人的信任和好感 (Alabed et al., 2022; Glikson & Woolley, 2020); 相比于不具备类人型外观的工业型智能体, 个体更容易对拟人化程度更高的智能体产生情感认同, 更能容忍AI出现执行任务失败或技术故障, 对于其社会价值和功能价值的评估水平也更高(Belanche et al., 2021; Yam et al., 2021; 张仪, 王永贵, 2022)。而AI的女性性别、交互语音自然程度、类似于人的年龄、昵称等, 都会被认为具有温暖、含蓄、微妙的人性尺度, 减少AI作为“人造物”的不自然痕迹, 更容易被使用者接受(Borau et al., 2021; Guha et al., 2023)。

尽管智能体适度的类人型可以激发人的移情作用, 增加人机交互时的好感, 但外型的过度人格化则会造成“恐怖谷”效应, 造成使用者的心理不适(Glikson & Woolley, 2020; Stein et al., 2020)。所谓“恐怖谷”效应, 是指智能体的外观和行为跟人类越是接近, 人们越容易产生积极情绪; 但当正面情绪到达一个峰值之后, 随着相似度的提高, 人们会对智能体产生恐怖的感觉(Mori, 2012)。综上所述, 优化AI−员工的协作系统, 要在工业设计上赋予AI适度的人格特征, 如外观、表情、声音、性别等, 有助于增强员工对AI的信任和好感, 提升员工的接受度和使用意愿。

3.1.2 AI的心智属性

个体通常从情感和机能两个角度形成对其他实体心智水平的感知(Gray et al., 2007)。因此, AI的心智属性主要从情感性和机能性两个角度进行刻画。情感性是指AI进行沟通交流、情感感知、提供情感支持的能力。随着技术的进步, 具备共情智能和多感官交互的AI开始能够准确识别、理解、应对甚至影响人类的情绪(Huang & Rust, 2018; Lv et al., 2022)。研究发现, AI与用户之间存在情绪传染效应(Chuah & Yu, 2021; Han et al., 2022), 高情感性的AI能将积极情绪传递给用户, 拉近AI与用户间的心理距离, 帮助AI与用户建立亲密、稳定的关系(Lee et al., 2022; Song et al., 2022), 增强用户对AI的满意度(Gelbrich et al., 2021; Lee et al., 2022)。Dutta等(2022)研究发现, AI与员工之间的沟通交流营造了信任的氛围, 增强了员工的工作投入。有趣的是, 对于情感性低的AI, 虽然它们无法为员工提供情感支持, 但正是由于其非人性化的特征, 因而也会提升员工的适应性。例如, 随着情感性低的AI引入工作团队, 员工增强了对人类身份的认同感, 缓解了对外部群体(如不同种族、宗教信仰、移民、性取向)的排斥, 有助于减少群体间的偏见和紧张关系(Jackson et al., 2020); 在人机互动过程中, 由于低情感性的AI不具备同理心、道德感和社会评判能力(Giroux et al., 2022; Lanz et al., 2023), 人面对AI时不会感觉到尴尬、羞耻等负面情绪(Holthöwer & van Doorn, 2023; Pitardi et al., 2022); 由于对AI缺乏人性化的感知, 当员工面对AI扮演的咨询师时, 会减少对评估者天然的抵触和厌恶情绪(Desideri et al., 2019)。

机能性是指AI理性地思考、计划和行动的能力(Yam et al., 2021)。高机能的AI有较强的问题诊断和解决能力、响应速度快、易用性高(Yoon & Lee, 2019), 能增强用户对AI的认同感和使用倾向(Belanche et al., 2021; Pantano & Scarpi, 2022)。例如, Guha等(2023)研究发现, AI能够执行任务的数量和敏捷性的提高能增加用户对AI机能性的感知, 进而导致用户的积极评价。Glikson和Woolley (2020) 指出, 员工对AI的信任会随着交互的深入不断增强, 但AI的机能性会调节信任的发展过程, 高机能性的AI通常会更快地发展高水平的信任。但高机能的AI对员工也存在负面影响。当与AI合作时, 员工会与AI进行社会比较, 高机能的AI会打击员工的自尊心, 导致员工的自卑和工作不安全感, 引发挫折、愤怒等消极情绪, 甚至会导致工作场所不文明行为、反生产行为的发生(Seeber et al., 2020; Spatola & Normand, 2020; 王才等, 2019; Yam et al., 2023)。对于低机能的AI, 由于容易出现技术故障或未按照程序设定的规则运行, 会直接和间接导致用户的不满(Filieri et al., 2022)。例如, 随着智能自主服务系统在服务行业的广泛应用, 随之而来的是频发的技术故障, 以及由此导致的服务失败和顾客投诉(吕兴洋等, 2021)。当服务员工与智能系统协作时, 不得不面对更多生气与失望的顾客, 这加剧了员工的情绪劳动和心理资源耗竭, 进而滋生对系统的抵触情绪(Groth et al., 2019; Johnson et al., 2020)。

通过上述分析可见, AI的情感性和机能性的影响并非单一或线性的, 具备较强的情境性特征。在AI−员工协作的系统化分析视角下, AI的设计和实施过程中要充分考虑用户和组织的特点。

3.1.3 AI的伦理属性

AI伦理属性主要从透明度和可靠性两个角度进行刻画。

科技部在《新一代人工智能伦理规范》中明确指出, 在AI的研发过程中, 要在“设计、实现、应用等环节, 提升透明性、可靠性等”; 马斯克等AI领域的企业家和科学家呼吁在明确AI的伦理风险和治理机制前暂停大模型的开发和训练; 意大利也宣布禁用ChatGPT, 原因是它侵犯了用户的隐私。可见, AI的透明度和可靠性至关重要。透明度是技术的底层操作规则和内部逻辑对用户的可见程度(Glikson & Woolley, 2020)。AI的设计不是“完美”的, 实际应用中难免出现故障和问题, 高透明度的AI有助于政府和企业澄清和追溯是机器、设计师还是其他利益相关者的权利、责任和义务, 建立可定义的监管标准, 也有助于员工理解AI所做出的决策和建议, 使人类能够对AI进行“反哺”, 通过监督学习提升AI的智能水平(Seeber et al., 2020)。AI的透明度还涉及安全和隐私问题, 许多AI的运行首先需要数据的输入, 包括姓名、家庭关系、工作和家庭位置等私人信息, 进而制定个性化的响应模式(Moussawi et al., 2020)。当封闭的AI系统威胁到员工的安全和隐私时, 员工使用AI可能会面临法律、道德等伦理问题, 员工会感到紧张、降低信任, 由此会削弱对AI的使用意愿(Pillai & Sivathanu, 2020)。AI的透明度还关系到对算法中偏见的控制。AI的算法中可能存在设计师、工程师、公司的偏见, 这种偏见不仅会影响用户的信任和决策质量, 还有可能在更高层面和更高风险的情境中导致不良后果(Anthony et al., 2023)。尽管有持反对意见的人认为AI是“黑箱”, 实现AI对员工完全透明是不切实际的, 但仍有一些较为复杂的方法可以帮助员工理解“黑箱”的内在机理(Charlwood & Guenole, 2022)。例如, 目前已发展出一些评估指标(如: sharp values; Sundararajan & Najmi, 2020) 增强了模型的可解释性。综上所述, 优化AI−员工的协作, 要从技术和制度设计两个角度增强AI的透明度, 帮助员工不需要掌握专门知识或了解其内部结构, 就能理解AI的功能和输出结果。

可靠性是指AI功能和行为表现的准确性、一致性和稳定性, 以及能够真正落地使用(Glikson & Woolley, 2020)。根据《智能软件可靠性的研究进展与趋势》, AI的可靠性包含了数据可靠性、模型可靠性和平台可靠性三个维度。随着商业用途的AI系统复杂性提升, 需要大量获取数据资源、商业机密、员工隐私等信息, 因而工作场所AI的可靠性至关重要。员工是否会在工作中接受、使用和信任一个经常犯错和“反复无常”的AI呢?答案显然是否定的。甚至, 尽管AI和人类同事一样都会犯错, 但我们对AI犯错的容忍度远远小于人类自己犯错。Esterwood和Robert (2023)研究发现, 在AI−员工协作中, 当AI 出错达到三次, 员工对AI的信任通过任何策略都无法弥补。Robinette等(2017)研究发现, 在高风险的情境中参与者会对可靠性低的AI失去信任。在一些研究中还发现, AI行为表现的一致性和稳定性的下降比准确性的下降更能影响员工的信任(Desai et al., 2013)。Wang等(2022)研究发现, 员工对AI能力的评估还取决于AI的可靠性, 当AI可靠性低时员工倾向于认为AI也是能力低下的。因此, 优化AI与员工的协作, 应重视AI的可靠性测试、评估及提升工作, 为员工提供稳定安全可靠的AI系统。

3.2 员工的个体因素

系统化视角下, AI尽管被视为理性的行动者, 但仍无法抹去人类行动者的角色, 系统根植于人机互动, 归根结底需要人的参与, 在多数“弱AI”应用中人仍占据主导地位(Anthony et al., 2023)。因此, AI−员工协作会受到员工个体特征的影响。根据对现有文献的梳理, 本文从员工的态度、知识、技巧和能力(knowledge, skills, abilities, 简称KSAs)、性格和人口统计学特征四个方面进行讨论。

3.2.1 态度

当员工以变革创新的意愿和积极的态度去接纳和使用AI时, 能与AI形成良好的协作关系, 强化自身的认同感和幸福感, 提升AI的组织有效性(Savela et al., 2021; 赵宜萱等, 2020)。有学者提出了STARA (smart technology, artificial intelligence, robotics, algorithms)意识的概念, 即员工对智能技术、人工智能、机器人、算法如何影响职业前景的看法(Brougham & Haar, 2018), 也有研究称之为AI意识(AI awareness) (Kong et al., 2021)。高STARA意识意味着对技术较低的包容度和对职业前景更悲观的估计, 会降低员工对AI的接受度, 对员工与AI的协作关系以及员工自身造成负面影响(Li et al., 2019)。例如, Brougham和Haar (2018)研究发现, STARA意识会削弱员工的组织承诺和职业满意度, 导致员工的离职倾向以及愤世嫉俗和抑郁情绪; Lingmont和Alexiou (2020)研究发现, STARA意识会导致员工的不安全感; Kong等(2021)研究发现, AI意识会导致员工的工作倦怠。随着对STARA意识和AI意识研究的深入, 最新的研究揭示了它们的“光明面”。以酒店业员工为样本的研究发现, 对STARA意识和AI意识的挑战性评估可以激发员工的内部动机和工作投入, 对于员工生产力和创造力的提升有促进作用(Ding, 2021; Liang et al., 2022)。

3.2.2 KSAs

工作场所AI的引入对员工应具备的KSAs提出了新的要求, 员工只有不断学习和完善顺应时代的KSAs, 才能促进员工对AI技术的适应和掌握。现有研究一方面关注与AI相关的KSAs, 如AI使用经历、对AI的熟悉程度、对AI的敏感性、AI专业素养等(Kim et al., 2022; Parker & Grote, 2022)。Jaiswal等(2021) 通过案例研究发现, 数智化时代员工必备的五项技能, 分别是数据分析、数字工具使用、复杂认知、决策制定和持续学习技能。Wilson和Daugherty (2018)指出, 在与AI的合作中, 员工需要掌握如何训练AI完成特定任务、如何对AI的工作进行解释说明、如何保证AI的安全与可靠等能力。另一方面, 关注一般意义上的个体能力和素质, 如工作能力、职业生涯建构能力、沟通交流能力等(Basu et al., 2023; Guha et al., 2023; 王才等, 2019)。Jia等(2023)研究发现, 只有具备高工作技能的员工才能在和AI的协作中收益, 提升创造力。Huang和Rust (2018)还认为, 随着AI技术的发展和对人类工作领域的渗透, 情感作为智能技术尚难以有效模仿和替代的人类能力, 是人类与AI形成优势互补的关键。因此, 管理者应将招聘重点从分析能力转移到人际交往能力, 员工和教育工作者也应该注重培养情绪智力与人际交往能力, 学习如何与AI进行协作(Huang et al., 2019)。

3.2.3 性格

员工天生多样化的个性特征被证明会影响AI与员工的交互(Kim et al., 2022; Parker & Grote, 2022; 王振源, 姚明辉, 2022)。例如, Oksanen等(2020)研究发现, 员工的大五人格中开放性强的个体显然更容易接受AI的应用。Tang, Koopman, McClean等(2022)也关注了大五人格的作用, 发现由于AI与员工之间的互补性, AI能帮助责任心低的员工增强角色宽度自我效能、降低角色模糊, 进而促进工作绩效, 但责任心、有序性高的员工却难以从与AI的协作中获益; Tang, Koopman, Yam等(2022)揭示了核心自我评价的作用, 研究发现对AI的过度依赖会损伤员工的自尊心, 进而威胁其工作绩效, 但核心自我评价高的员工能保持对工作的动力, 减少对AI过度依赖的负面影响。

3.2.4 人口统计学特征

年龄、性别、社会阶层、学历等人口统计学特征也会影响AI与员工的交互。年龄方面, Dutta等(2022)研究发现, 年长的员工必然伴随着认知能力的下降, 他们对新技术的熟悉和掌握程度较低, 难以从与AI的协作中获益。但年轻员工精通技术知识, 对新兴技术工具的使用意愿更强, 更容易从与AI的协作中获益(Guha et al., 2023)。类似的, 社会阶层和学历水平较低的个体对于新技术的熟悉和掌握程度低、学习速度慢(Oksanen et al., 2020; 王林辉等, 2022; 张仪, 王永贵, 2022), 这类员工同样难以适应与AI的协作。

3.3 组织情境因素

系统化视角下, AI与员工的互动嵌入在社会技术系统中, AI−员工协作的演化和发展受到组织中广泛的利益相关者的影响(Anthony et al., 2023)。Wilson和Daugherty (2018)指出, 实现AI与员工的协作, 需要组织在AI应用的全生命周期的深度参与。据此, 组织情境因素在AI−员工协作中扮演了重要角色, 根据对现有文献的梳理, 本文从组织准备、组织支持、组织氛围和文化三个方面进行讨论。

3.3.1 组织准备

组织准备(organizational readiness)是指组织采用某项技术所需组织资源的准备程度和可用性(Hossain et al., 2017)。结合不同的技术类型, 组织准备可以用来反映组织在特定技术上的准备程度。例如, van de Weerd等(2016)在探究影响SaaS采用的组织因素时, 将组织准备定义为组织采用SaaS所需组织资源的准备程度和可用性。因此, 在AI使用的组织情境中, 组织准备反映了组织采用AI所需资源的准备程度和可用性(Prikshat et al., 2021)。组织准备包括技术成熟度、资金准备程度、技术专家准备程度以及高层管理者的支持等内容(Hossain et al., 2017)。对于组织准备高的组织, 对AI相关技术的应用较为成熟, 有充足的资金引进和维护AI技术, 有足够的专业技术人员对AI进行植入和维护, 高层管理者也调配了充足的资金和人力资源(Prikshat et al., 2021)。在组织准备高的组织中, 员工能更快速地评估、准备和集成AI系统, 对于AI有更强的心理适应性, 更有动力利用AI提供的信息采取行动, 组织也有更强的意愿和能力利用AI开发新的产品和服务(Makarius et al., 2020)。

3.3.2 组织支持

组织支持首先要求管理者对AI有一定的熟悉和了解程度, 对AI技术持包容和接纳的态度, 倾向于推动组织实现智能化转型(Basu et al., 2023)。反之, 若管理者不信任AI技术对组织的帮助, 对AI技术充满焦虑时, 提供组织支持也无从谈起(Suseno et al., 2021)。具体的, 管理者要表达对于引入AI技术的承诺和支持, 给予员工信心(李燕萍, 陶娜娜, 2022; Prikshat et al., 2021; 王振源, 姚明辉, 2022), 主动为员工提供数字技能、知识的教育与培训(Li et al., 2019; Vrontis et al., 2022)。此外, 由于雇主在社会和经济体系中的相对权力, 技术往往更有利于雇主而非雇员, 因而组织还应该考虑通过内部的政策和规定来帮助确保安全、健康和有意义的工作设计, 例如围绕技术、不稳定工作、监视等的政策(Parker & Grote, 2022)。组织还应着手建立和完善技术应用相关的安全保障和伦理规范(Kim, 2022), 并通过相关的法规对技术应用过程中利益相关者的责任和义务进行澄清(Seeber et al., 2020)。

3.3.3 组织氛围和文化

根据技术接受和使用统一理论, 个人对是否采取某项特定行为感受到的社会压力是影响个体采纳新技术的关键因素(Venkatesh et al., 2003)。员工在组织中常常会关注同伴的想法, 通过与群体保持一致增强归属感, 特别当员工没有足够的信息做出理性的决策时, 所在群体对其行为的影响更大。因此, 用户对于AI的接纳和使用会受到社会规范和榜样模范的社会影响(Basu et al., 2023; Gursoy et al., 2019; 李燕萍, 陶娜娜, 2022)。此外, 组织对于员工使用AI的包容、支持、鼓励的氛围也有助于AI与员工的协作。研究发现, 包容型组织氛围(裴嘉良等, 2021)、鼓励创新的组织文化(Malik et al., 2020)、包容失败和支持进步的组织文化(Webber et al., 2019)、竞争性的心理氛围(Li et al., 2019)会促进员工对AI的接受和使用, 因而有助于改善AI−员工协作。

3.4 任务构型

系统的组件及其功能服务于执行特定的任务, AI、员工和组织围绕工作任务进行运转, 它们通过执行任务影响输出结果(Anthony et al., 2023)。过程环节描述了系统的输入如何转换成结果(Ilgen et al., 2005), 具体内容就包括明确目标和相互协调(Marks et al., 2001), 因而任务构型是AI−员工协作系统中的过程项。任务构型包含“干什么” (任务目标)和“怎么干” (交互方式)两个维度, 任务目标刻画了协作从事任务的性质, 交互方式则刻画了AI与员工在任务中的角色定位、任务量和资源的分配情况(Kim, 2022; Seeber et al., 2020)。优化AI−员工协作, 需要考虑双方的交互方式与任务目标, 只有技术与任务的高度匹配才能最大化协作效能(Lee, 2018; Wang et al., 2020; 赵宜萱等, 2020)。

3.4.1 交互方式

Makarius等(2020)根据AI在工作中应用的范围以及AI的新颖性、智能性水平, 发展出了8种交互方式, 分别是仿真(如: 超级人工智能)、自治(如: 自动驾驶汽车)、增强(如: 手术机器人)、共生(如: 深度学习)、自动化(如: 流水线机器人)、放大(如: 预测AI)。此外, 还有研究根据交互双方的身份(人或AI)的不同构建了交互方式矩阵, 例如:Robinson等(2020)根据员工与顾客是人或AI构建了四种交互方式, 分别为人内关系、AI员工与人类顾客的种间关系、AI顾客与人类员工的种间关系、AI内关系。现有研究讨论较多的是自动化与增强两种交互方式(Raisch & Krakowski, 2021)。

自动化意味着机器接管人工任务, 优点在于员工只需很少甚至不需要任何参与就可以将任务交付给AI来完成, 通过将人类从系统中抽离以实现更全面、合理和高效的任务处理(Davenport & Kirby, 2016)。但这同时也带来诸多负面影响, 对自动化的依赖会造成员工的去技能化、管理者去中介化, 威胁员工和管理者长远的成长发展与价值实现, 并可能造成严重的失业和社会不平等问题(Raisch & Krakowski, 2021)。而增强的应用方式则意味着人与AI之间持续的紧密交互, 用人类的独特能力(如情感、直觉)来作为AI的补充(Wilson & Daugherty, 2018)。增强的应用方式旨在增强员工的工作能力、改善组织结构、加强沟通和表达, 意味着员工通过使用AI来深化工作的深度和广度(Hunter, 2019)。但增强模式需要人的持续参与和试验, 受到人的情绪和其他主观因素的影响, 技术成果无法复制, 单一的增强模式则意味着人类的偏见持续存在, 技术成果难以实现稳定、可靠和持久(Amershi et al., 2014)。

3.4.2 任务目标

尽管AI可以显著提升员工的劳动生产率, 但组织在引入AI的同时需要考虑适配的任务目标, 否则会适得其反。现有研究根据任务中情感−社会成分和认知−分析成分的差异将任务区分为认知−分析型任务和情感−社会型任务(Glikson & Woolley, 2020; Lee, 2018; Wirtz et al., 2018)。情感社会型任务对于情绪智力、情感沟通能力、人际交往能力、组织协调能力有较高的要求, 需要消耗大量的情绪资源; 认知分析型任务对于处理复杂信息的能力、数据分析计算能力有较高的要求, 需要消耗大量的认知资源(Huang et al., 2018; Huang & Rust, 2018; Wirtz et al., 2018)。根据Glikson和Woolley (2020)总结, 相比于情感−社会型任务, 员工对于从事认知−分析型任务的AI更为信任, 类似的Lee (2018)也在研究中发现, 相比于人工任务, 员工对于从事分析计算任务的AI更为信任。

对于情感−社会型任务, 如具有复杂情感和社会属性的服务工作, AI只能以较高的水平模拟情绪的表面扮演, 员工的深层扮演、创新思维和具有社会复杂性的真实情感却难以被AI轻易模仿和替代(Wirtz et al., 2018)。王林辉等(2022)应用机器学习模型测算了AI的职业可替代率, 发现非程式化且对思维能力和社交能力要求高的任务, 难以被AI所取代。例如, 在服务失败情境下或是情绪激烈的服务工作中(医学测试、丧葬服务、婚礼策划), 需要一线服务员工对遭遇失望、侮辱、冒犯的客户表示尊重、同情或其它特定情绪, AI难以满足客户的同理心需求(Delcourt et al., 2017; Rafaeli et al., 2017)。而AI通常被认为情感表达虚假、做作, 实际服务效果并不理想(Robinson et al., 2020)。一些具有关系动机的客户更看重服务中的社交元素, 更希望体验员工的情感表达, 通过非语言线索来消除服务中的模糊性、提高舒适性、建立信任(Lim et al., 2017)。但由于AI缺乏丰富的情感性线索, 尚难以满足此类客户的需求(Robinson et al., 2020)。因此, 在情感−社会型任务中, 不宜让AI完全取代员工执行任务, 应充分发挥员工在情感沟通能力、人际交往能力上的优势。

然而, 在认知−分析任务中采用机器主导的协作模式, 意味着耗费大量体力资源和认知资源的机械式任务和分析式任务更多地由AI完成(Huang & Rust, 2018), 员工被要求以辅助或监督者的身份去维护AI系统的正常和安全运行(Wilson & Daugherty, 2018)。这种人与AI的分工协作不仅能实现更理性和高效的任务处理(Davenport & Kirby, 2016), 还能将人类从重复性、规则性、机械性和需要耗费大量认知资源的工作中解放, 员工拥有更多的工作自主性去从事与判断、创造力、价值创造等相关的新工作角色。例如, 智能制造技术的广泛应用引导工人由传统的重复性生产装配工作, 向工业现场的异常性诊断与分析工作转型, 极大程度地提升了工人的工作意义感。反之, 在认知−分析任务中若存在人的过度参与, 在人类主观因素的干预下, 生产结果不具备完全理性, 难以实现生产力的跃升(Huang et al., 2012; Raisch & Krakowski, 2021)。同时, 员工受困于重复性、机械性的任务中, 自身的创造力和新的价值难以被激发。

3.4.3 交互方式与任务目标的匹配

根据上述分析, AI与员工的交互方式呈现出“双刃剑”效应, 而不同的任务目标也应该适配不同的交互方式。因此, 在情感−社会型任务中, 适宜采用以员工为主导的增强交互方式, 重视和发挥员工的情感沟通能力、直觉判断能力; 在认知−分析型任务中, 适宜采用AI为主导的自动化模式, 提升效率的同时实现员工个性和价值的解放。例如, Jia等(2023)进行了一项工作设计, 由AI承担程序性和重复性的销售工作(如, 拨打电话、收集顾客基本信息), 在确定顾客具备一定的购买意向后, 由人工客服去承担更为深入的沟通交流工作, 落实顾客的购买行为。实地实验发现, 这样的工作设计能显著提升人工客服的创造力。类似的, Jarrahi (2018)分析了决策过程中的任务构型, 鉴于人在感性、直觉上的优势以及AI在分析能力上的优势, 当面对高度复杂的问题时, 人类决定数据收集和处理的方向, AI进行高速、大量的数据处理; 面对具有不确定性的问题时, 缺乏足够的信息辅助进行决策, 此时就需要发挥人的直觉优势; 处理模糊性较强的问题时, 人类负责协商、平衡多方利益, AI辅以多样化的信息解读处理(Jarrahi, 2018)。

此外, 随着AI代替人完成单一技能要求的任务, 社会对个体职业技能宽度和综合能力提出了更高的要求(王林辉等, 2022)。越来越多的员工被要求完成更为复杂的任务, 任务的性质既包括情感−社会型成分也包括认知−分析型成分。此时, 最佳的任务构型应是构建自动化模式与增强模式的良性循环, 形成人类智能与机器智能相互补充、相互推动的共生关系(Raisch & Krakowski, 2021)。例如, IBM研发的AI调香助手将香料配方与销售地区、顾客的大数据相匹配, 生成符合目标顾客喜好的香水, 调香师在AI生成香水配方的基础上, 创造能触发人类的情感和记忆的产品故事。AI与员工相互补充、相互推动的共生关系, 不仅可以最大化企业的竞争优势(Makarius et al., 2020), 也会让员工有更强的胜任感和工作旺盛感(朱晓妹等, 2021)。综上所述, 优化AI−员工的协作需要注意交互方式与任务目标的匹配, 但随着工作的丰富与深化, 应构建任务目标与交互方式动态匹配的协作构型, AI与员工之间形成相互补充、相互推动的共生关系。

3.5 AI−员工协作的系统性研究框架

系统化视角下, AI−员工协作的系统会对各方行动主体造成广泛的影响(Anthony et al., 2023), 而系统中各行动主体间的相互影响和塑造关系也是AI与员工协作研究关注的焦点(谢小云等, 2021)。据此, 在AI−员工协作系统的输出项, 本文基于上文的分析, 归纳了员工、AI和组织三个行动主体受到的影响和做出的变化, 并进一步将AI−员工协作系统的输入项、过程项和输出项整合, 构建了AI−员工协作的系统性研究框架, 如图1所示。

4 研究总结与未来研究展望

通过对现有文献的回顾, 本文清晰界定了工作场所AI和AI−员工协作的概念内涵, 这有助于推动学术对话的统一, 为开展AI−员工协作的后续研究奠定基础。随后, 本文基于Anthony等(2023)提出了AI−员工协作的系统化视角, 采用I-P-O范式构建了AI−员工协作的研究框架。Anthony等(2023)聚焦于对抽象理论的辨析和讨论, 本文的研究框架则实现了对系统化视角的具象化, 对系统的构成要素和内在机制进行了显性描述。还通过对实证研究的整理和归纳, 为系统化视角提供了更多经验支持。总体而言, 本文丰富了AI−员工协作系统化视角的文献, 是对系统化视角的一次重要应用。同时, 本文也有助于深化对AI−员工协作的认识, 为后续开展更为深入的研究提供基本的理论框架指导。尽管如此, 无论是工作场所的AI研究, 还是AI−员工协作的系统化视角都处于萌芽阶段。基于本文提出的研究框架和现有研究的不足, 总结了以下未来研究方向。

4.1 强化协作系统中AI伦理问题的研究

尽管诸多研究强调了澄清和解决伦理问题在AI−员工协作中的重要意义, 但现有研究更多进行了理论探讨, 相关命题缺乏足够的经验证据, 未来研究应注重实验研究设计, 以克服AI研究中样本获取渠道受限、AI应用方式差异化较大等难题。此外生成式AI (例如: ChatGPT、NovelAI)的发展激发了更多关于AI伦理问题的讨论, AI算法中存在的偏见、歧视, 以及虚假和误导性信息, 生成内容的合法性、版权等问题尚未得到组织管理研究的足够重视(Paul et al., 2023)。未来研究应探索不断涌现的伦理问题对员工和组织的潜在消极影响, 例如:由于AIGC的内容来源于对已有知识的深度模仿和伪造, 当员工长期依赖于AIGC的辅助时, 可能会削弱他们的道德判断, 进而导致工作场所非伦理行为的产生, 威胁组织的安全氛围, 造成内部的信任危机; 系统化视角下, AI算法中存在的歧视、偏见问题会逆向塑造员工的认知(Anthony et al., 2023), 导致员工的认知偏差和非理性行为, 可能会对员工和组织的工作绩效、社会责任、组织合法性造成消极影响。

4.2 探索协作系统中的组织后果

关于AI−员工协作中组织后果的实证研究较为匮乏, 未来研究应加强对组织后果的研究。例如, 战略核心理论认为担任核心角色的成员占据工作流程的中心位置, 对群体社会交换过程有最强的影响力, 个体的态度、行为会对整个组织造成影响(Grijalva et al., 2020)。因此, 个体的AI使用行为可能会自下而上塑造组织AI文化和氛围, 未来研究可以揭示组织的AI文化和氛围是如何被领导、员工影响和塑造的。此外, 组织引入AI的根本目的是提升绩效并获得竞争性优势, 如何将AI驱动的绩效与广义的绩效指标区分, 客观地衡量AI−员工协作带来的绩效表现提升, 是未来开展组织后果研究的重点。例如, 社会技术资本(sociotechnical capital)是指将社会资本与数字技术结合所带来的生产力, 它可以通过各种方式不断积累, 是有价值的、难以模仿的、组织所特有的, 可以用来构建可持续的竞争优势(Makarius et al., 2020), 因而社会技术资本可能是探索AI−员工协作效能在组织层面具体表现的指标之一。

4.3 拓展协作系统中的个体特征因素

对于员工而言, 协作系统中的个体特征是自身相对容易改变或控制的因素, 拓展个体特征因素有助于员工主动适应协作系统。首先, AI的机器学习过程需要人工对数据进行标注, 对训练过程进行引导, 不仅能更顺利地产出结果, 还有助于AI的功能实现、性能改进(Raisch & Krakowski, 2021)。因此, 实际应用中, 员工在AI−员工协作系统中的地位或许更重。例如, 包括AIGC只能基于人类已知的知识库和明确的问题描述生成答案, 能否提出有想象力和有价值的问题已经成为AI时代的一项重要技能, 对于释放AI的潜能至关重要。高度职业化的提示词工程师(prompt engineer), 更是成为近年来招聘圈的热门。因此, 未来研究可以进一步发掘与AI−员工交互相关个体特征因素, 例如与AI对话能力, 开发相关变量的量表并进行实证检验其对AI−员工协作的影响。其次, 技术全球化面临着高度的地域差异, 相同的AI系统在不同文化背景下的设计模式和应用效果却截然不同(Chi et al., 2023)。然而, 现有研究却忽视了文化价值观在AI−员工协作中的作用, 不利于研究结论的应用和普及。因此, 未来研究应关注跨文化情境下的AI−员工协作研究。

图1 AI−员工协作的系统性研究框架

4.4 强化协作系统中任务构型的研究

系统化视角下AI−员工协作强调了情境化特征, 只有结合任务环境的协作设计才能最大化AI的效能(Anthony et al., 2023)。然而, 关于任务构型的研究多局限于理论层面的讨论, 仅有少数研究提供了经验证据(Jia et al., 2013; Lee et al., 2018), 本文呼吁未来研究采用情境实验或现场实验的方法检验任务构型的影响。此外, 本文重点分析了认知−分析型任务、情感−社会型任务, 以及自动化、增强两种交互方式, 未来研究应对AI−员工协作的任务构型进行更为细致的刻画。例如, 任务目标方面, 可以将任务目标进一步细分为机械任务、分析任务、直觉任务和共情任务(Huang & Rust, 2018); 交互方式方面, 还可以基于空间和流程的视角, 发展出独立、顺序、同步、支持等四种人机交互方式(El Zaatari et al., 2019), 该视角的研究设计也具有更强的可操作性(Jia et al., 2023)。

4.5 AI−员工协作研究框架的补充与完善

本文采用I-P-O范式构建了AI−员工协作的研究框架, 实现对系统化理论视角的具象化。推动AI−员工协作系统化理论的发展, 还需要对研究框架进行补充与完善。Marks等(2001)将过程项的维度进一步拓展, 除了包括本研究关注的明确目标和相互协调外, 还包括任务分析、制定策略、监控、冲突管理等内容; Ilgen等(2005)则将I-P-O范式进一步拓展成I-M-O-I, 提出了输出结果逆向影响输入和过程的反馈回路。未来研究可以在研究框架的基础上进一步拓展过程项、增加反馈回路, 深入揭示AI−员工协作系统的内在机制。例如, 对于过程项, 未来研究可以关注AI相关的监管手段、监管政策, AI−员工协作失败的容错机制, AI−员工“排异”的协调机制在协作系统中的作用; 对于反馈回路, 尽管高度拟人化的AI可以提高个体对AI的情感认同, 但当它们表现出消极敌意的行为时, 高度的情感认同反而会放大用户的负面体验(Sullivan & Wamba, 2022; Yam et al., 2022), 最终影响员工对于AI的态度, 即可能存在AI (输入)−员工感知(输出)−员工态度(输入)的反馈回路。最后, Anthony等(2023)指出AI−员工协作系统的行动主体还包括更广泛的利益相关者, 如政府、监管机构、生产与开发商、设计师、工程师等, 他们制定的政策以及行为偏好会对系统造成深刻的影响(Parker & Grote, 2022)。遗憾的是, 关于这部分的实证研究还较为匮乏, 我们呼吁未来研究能弥补这一领域的不足。

龚群. (2023). 论弱人工智能体的道德性考察.(3), 37−45.

李燕萍, 陶娜娜. (2022). 员工人工智能技术采纳多层动态影响模型: 一个文献综述.(1), 35−56.

吕兴洋, 杨玉帆, 许双玉, 刘小燕. (2021). 以情补智: 人工智能共情回复的补救效果研究.(8), 86−100.

裴嘉良, 刘善仕, 钟楚燕, 谌一璠. (2021). AI算法决策能提高员工的程序公平感知吗?(11), 41−55.

王才, 周文斌, 赵素芳. (2019). 机器人规模应用与工作不安全感——基于员工职业能力调节的研究.(4), 111−126.

王林辉, 胡晟明, 董直庆. (2022). 人工智能技术、任务属性与职业可替代风险: 来自微观层面的经验证据., (7), 60−78.

王振源, 姚明辉. (2022). 工作场所人机协作对员工影响的研究述评.(9), 86−102.

谢小云, 左玉涵, 胡琼晶. (2021). 数字化时代的人力资源管理: 基于人与技术交互的视角., (1), 200−216.

张仪, 王永贵. (2022). 服务机器人拟人化对消费者使用意愿的影响机理研究——社会阶层的调节作用.(3), 3−18.

赵宜萱, 赵曙明, 栾佳锐. (2020). 基于人工智能的人力资源管理: 理论模型与研究展望., 36− 43.

朱晓妹, 王森, 何勤. (2021). 人工智能嵌入视域下岗位技能要求对员工工作旺盛感的影响研究.(11), 15−25.

Alabed, A., Javornik, A., & Gregory-Smith, D. (2022). AI anthropomorphism and its effect on users’ self-congruence and self-AI integration: A theoretical framework and research agenda., 121786.

Amershi, S., Cakmak, M., Knox, W. B., & Kulesza, T. (2014). Power to the people: The role of humans in interactive machine learning.(4), 105−120.

Anthony, C., Bechky, B. A., & Fayard, A. L. (2023). “Collaborating” with AI: Taking a system view to explore the future of work., Advance online publication. https://doi.org/10.1287/orsc.2022.1651

Basu, S., Majumdar, B., Mukherjee, K., Munjal, S., & Palaksha, C. (2023). Artificial intelligence-HRM interactions and outcomes: A systematic review and causal configurational explanation.,(1), Article 100893.

Bechky, B. A. (2003). Sharing meaning across occupational communities: The transformation of understanding on a production floor.(3), 312−330.

Belanche, D., Casaló, L. V., Flavián, C., & Schepers, J. (2021). Examining the effects of robots’ physical appearance, warmth, and competence in frontline services: The humanness-value-loyalty model.(12), 1024−1052.

Borau, S., Otterbring, T., Laporte, S., & Wamba, S. F. (2021). The most human bot: Female gendering increases humanness perceptions of bots and acceptance of AI.(7), 1052−1068.

Brougham, D., & Haar, J. (2018). Smart technology, artificialintelligence, robotics, and algorithms (STARA): Employees’ perceptions of our future workplace.(2), 239−257.

Canhoto, A. I., & Clear, F. (2020). Artificial intelligence and machine learning as business tools: A framework for diagnosing value destruction potential.(2), 183−193.

Charlwood, A., & Guenole, N. (2022). Can HR adapt to the paradoxes of artificial intelligence?(4), 729−742.

Chi, O. H., Chi, C. G., Gursoy, D., & Nunkoo, R. (2023). Customers’ acceptance of artificially intelligent service robots: The influence of trust and culture., Article 102623.

Chuah, H. W., & Yu, J. (2021). The future of service: The power of emotion in human-robot interaction.(3), Article 102551.

Davenport, T. H., & Kirby, J. (2016).. New York: Harper Business.

Delcourt, C., Gremler, D. D., de Zanet, F., & van Riel, A. C. (2017). An analysis of the interaction effect between employee technical and emotional competencies in emotionally charged service encounters.(1), 85−106.

Desai, M., Kaniarasu, P., Medvedev, M., Steinfeld, A., & Yanco, H. (2013, March).. 8th ACM/IEEE International Conference on Human-Robot Interaction, Tokyo, Japan.

Desideri, L., Ottaviani, C., Malavasi, M., di Marzio, R., & Bonifacci, P. (2019). Emotional processes in human-robot interaction during brief cognitive testing., 331−342.

Ding, L. (2021). Employees’ challenge-hindrance appraisals toward STARA awareness and competitive productivity: A micro-level case.(9), 2950−2969.

Dutta, D., Mishra, S. K., & Tyagi, D. (2022). Augmented employee voice and employee engagement using artificial intelligence-enabled chatbots: A field study.,(12), 2451− 2480.

El Zaatari, S., Marei, M., Li, W., & Usman, Z. (2019). Cobot programming for collaborative industrial tasks: An overview., 162−180.

Esterwood, C., & Robert, L. P. (2023). Three Strikes and you are out!: The impacts of multiple human-robot trust violations and repairs on robot trustworthiness., Article 107658.

Ferràs-Hernández, X. (2018). The future of management in a world of electronic brains.(2), 260−263.

Filieri, R., Lin, Z. B., Lu, X. Q., & Yang, X. W. (2022). Customer emotions in service robot encounters: A hybrid machine-human intelligence approach.,(4), 614−629.

Fountaine, T., McCarthy, B., & Saleh, T. (2019). Building the AI-powered organization., (7-8), 62−73.

Gelbrich, K., Hagel, J., & Orsingher, C. (2021). Emotional support from a digital assistant in technology-mediated services: Effects on customer satisfaction and behavioral persistence.(1), 176−193.

Giroux, M., Kim, J., Lee, J. C., & Park, J. (2022). Artificial intelligence and declined guilt: Retailing morality comparison between human and AI.(4), 1027−1041.

Glikson, E., & Woolley, A. W. (2020). Human trust in artificial intelligence: Review of empirical research.(2), 627−660.

Gray, H. M., Gray, K., & Wegner, D. M. (2007). Dimensions of mind perception.(5812), 619.

Groth, M., Wu, Y., Nguyen, H., & Johnson, A. (2019). The moment of truth: A review, synthesis, and research agenda for the customer service experience., 89−113.

Grijalva, E., Maynes, T. D., Badura, K. L., & Whiting, S. W. (2020). Examining the “I” in team: A longitudinal investigation of the influence of team narcissism composition on team outcomes in the NBA.(1), 7−33.

Guha, A., Bressgott, T., Grewal, D., Mahr, D., Wetzels, M., & Schweiger, E. (2023). How artificiality and intelligence affect voice assistant evaluations., 843−886.

Gursoy, D., Chi, O. H., Lu, L., & Nunkoo, R. (2019). Consumers acceptance of artificially intelligent (AI) device use in service delivery., 157−169.

Han, E., Yin, D., & Zhang, H. (2022). Bots with feelings: Should AI agents express positive emotion in customer service?., Advance online publication. https://doi.org/10.1287/isre.2022.1179

Holthöwer, J., & van Doorn, J. (2023). Robots do not judge: Service robots can alleviate embarrassment in service encounters.,, 767−784.

Hossain, M. A., Standing, C., & Chan, C. (2017). The development and validation of a two-staged adoption model of RFID technology in livestock businesses.(4), 785−808.

Huang, H. H., Hsu, J. S. C., & Ku, C. Y. (2012). Understanding the role of computer-mediated counter-argument in countering confirmation bias.(3), 438−447.

Huang, M., & Rust, R. T. (2018). Artificial intelligence in service.(2), 155−172.

Huang, M. H., Rust, R., & Maksimovic, V. (2019). The feeling economy: Managing in the next generation of artificial intelligence (AI).(4), 43−65.

Hunter, G. K. (2019). On conceptualizing, measuring, and managing augmented technology use in business-to- business sales contexts., 201−213.

IFR. (2022).. https://ifr.org/

Ilgen, D. R., Hollenbeck, J. R., Johnson, M., & Jundt, D. (2005). Teams in organizations: From input-process-output models to IMOI models., 517−543.

Jackson, J. C., Castelo, N., & Gray, K. (2020). Could a rising robot workforce make humans less prejudiced?(7), 969−982.

Jaiswal, A., Arun, C. J., & Varm, A. (2021). Rebooting employees: Upskilling for artificial intelligence in multinational corporations.,(6), 1179−1208.

Jarrahi, M. H. (2018). Artificial intelligence and the future of work: Human-AI symbiosis in organizational decision making.(4), 577−586.

Jia, N., Luo, X. M., Fang, Z., & Liao, C. C. (2023). When and how artificial intelligence augments employee creativity., Advance online publication. https://doi.org/10.5465/amj.2022.0426

Johnson, A., Dey, S., Nguyen, H., Groth, M., Joyce, S., Tan, L., … Harvey, S. B. (2020). A review and agenda for examining how technology-driven changes at work will impact workplace mental health and employee well-being.(3), 402−424.

Kim, H., So, K. K. F., & Wirtz, J. (2022). Service robots: Applying social exchange theory to better understand human-robot interactions., 104537.

Kim, S. (2022). Working with robots: Human resource development considerations in human-robot interaction.(1), 48−74.

Kong, H. Y., Yuan, Y., Baruch, Y., Bu, N., Jiang, X., & Wang, K. (2021). Influences of artificial intelligence (AI) awareness on career competency and job burnout.(2), 717−734.

Lanz, L., Briker, R., & Gerpott, F. H. (2023). Employees adhere more to unethical instructions from human than ai supervisors: Complementing experimental evidence with machine learning., Advance online publication. https://doi.org/10.1007/s10551-023- 05393-1

Lee, C. T., Pan, L.Y., & Hsieh, S. H. (2022). Artificial intelligent chatbots as brand promoters: A two-stage structural equation modeling artificial neural network approach.(4), 1329−1356.

Lee, M. K. (2018). Understanding perception of algorithmic decisions: Fairness, trust, and emotion in response to algorithmic management.(1), 1−16.

Li, J., Bonn, M. A., & Ye, B. H. (2019). Hotel employee’s artificial intelligence and robotics awareness and its impact on turnover intention: The moderating roles of perceived organizational support and competitive psychological climate., 172−181.

Liang, X., Guo, G., Shu, L., Gong, Q., & Luo, P. (2022). Investigating the double-edged sword effect of AI awareness on employee’s service innovative behavior., Article 104564.

Lim, E. A. C., Lee, Y. H., & Foo, M. D. (2017). Frontline employees’ nonverbal cues in service encounters: A double-edged sword.(5), 657−676.

Lingmont, D. N. J., & Alexiou, A. (2020). The contingent effect of job automating technology awareness on perceived job insecurity: Exploring the moderating role of organizational culture., Article 120302.

Lv, X. Y., Yang, Y. F., Qin, D. Z., Cao, X. P., & Xu, H. (2022). Artificial intelligence service recovery: The role of empathic response in hospitality customers’ continuous usage intention., Article 106993.

Makarius, E. E., Mukherjee, D., Fox, J. D., & Fox, A. K. (2020). Rising with the machines: A sociotechnical framework for bringing artificial intelligence into the organization., 262−273.

Malik, A., Budhwar, P., Patel, C., & Srikanth, N. R. (2020). May the bots be with you! Delivering HR cost-effectiveness and individualised employee experiences in an MNE.(6), 1148−1178.

Marks, M. A., Mathieu, J. E., & Zaccaro, S. J. (2001). A temporally based framework and taxonomy of team processes.(3), 356−376.

Mori, M. (2012). The uncanny valley (Translated by Karl MacDorman and Norri Kageki).(2), 98−100.

Moussawi, S., Koufaris, M., & Benbunan-Fich, R. (2020). How perceptions of intelligence and anthropomorphism affect adoption of personal intelligent agents.(2), 343−364.

Nelson, A. J., & Irwin, J. (2014). “Defining what we do-all over again”: Occupational identity, technological change, and the librarian/Internet-search relationship.(3), 892−928.

Nilsson, N. J. (1971).. New York: McGraw-Hill.

Oksanen, A., Savela, N., Latikka, R., & Koivula, A. (2020). Trust toward robots and artificial intelligence: An experimental approach to human-technology interactions Online., Article 568256.

Pantano, E., & Scarpi, D. (2022). I, robot, you, consumer: Measuring artificial intelligence types and their effect on consumers emotions in service.(4), 583−600.

Parker, S. K., & Grote, G. (2022). Automation, algorithms, and beyond: Why work design matters more than ever in a digital world.(4), 1171−1204.

Paul, J., Ueno, A., & Dennis, C. (2023). ChatGPT and consumers: Benefits, pitfalls and future research agenda.,(4), 1213−1225.

Pillai, R., & Sivathanu, B. (2020). Adoption of artificial intelligence (AI) for talent acquisition in IT/ITeS organizations.(9), 2599−2629.

Pitardi, V., Wirtz, J., Paluch, S., & Kunz, W. H. (2022). Service robots, agency and embarrassing service encounters.(2), 389−414.

Prikshat, V., Malik, A., & Budhwar, P. (2021). AI-augmented HRM: Antecedents, assimilation and multilevel consequences.,(1), Article 100860.

Rafaeli, A., Altman, D., Gremler, D. D., Huang, M. H., Grewal, D., Iyer, B., … de Ruyter, K. (2017). The future of frontline research: Invited commentaries.(1), 91−99.

Raisch, S., & Krakowski, S. (2021). Artificial intelligence and management: The automation-augmentation paradox.(1), 192−210.

Robinette, P., Howard, A. M., & Wagner, A. R. (2017). Effect of robot performance on human-robot trust in time- critical situations.(4), 425−436.

Robinson, S., Orsingher, C., Alkire, L., de Keyser, A., Giebelhausen, M., Papamichail, K. N., … Temerak, M. S. (2020). Frontline encounters of the AI kind: An evolved service encounter framework., 366−376.

Savela, N., Kaakinen, M., Ellonen, N., & Oksanen, A. (2021). Sharing a work team with robots: The negative effect of robot co-workers on in-group identification with the work team., Article 106585.

Seeber, I., Bittner, E., Briggs, R. O., de Vreede, T., de Vreede, G., Elkins, A., … Söllner, M. (2020). Machines as teammates: A research agenda on AI in team collaboration.(2), Article 103174.

Song, X., Xu, B., & Zhao, Z. Z. (2022). Can people experience romantic love for artificial intelligence? An empirical study of intelligent assistants., Article 103595.

Suseno, Y., Chang, C. C., Hudik, M., & Fang, E. S. (2021). Beliefs, anxiety and change readiness for artificial intelligenceadoption among human resource managers: The moderating role of high-performance work systems.,(6), 1209−1236.

Spatola, N., & Normand, A. (2020). Human vs. machine: The psychological and behavioral consequences of being compared to an outperforming artificial agent.(3), 915−925.

Stein, J. P., Appel, M., Jost, A., & Ohler, P. (2020). Matter over mind? How the acceptance of digital entities depends on their appearance, mental prowess, and the interaction between both., Article 102463.

Sullivan, Y. W., & Wamba, S. F. (2022). Moral judgments in the age of artificial intelligence.(4), 917−943.

Sundararajan, M., & Najmi, A. (2020, July).. ICML’20: Proceedings of the 37th International Conference on Machine Learning, Vienna, Austria.

Tang, P. M., Koopman, J., McClean, S. T., Zhang, J. H., Li, C. H., de Cremer, D., … Ng, C. T. S. (2022). When conscientious employees meet intelligent machines: An integrative approach inspired by complementarity theory and role theory.(3), 1019−1054.

Tang, P. M., Koopman, J., Yam, K. C., de Cremer, D., Zhang, J. H., & Reynders, P. (2022). The self-regulatory consequences of dependence on intelligent machines at work: Evidence from field and experimental studies., Advance online publication. https://doi.org/10.1002/hrm.22154

Tong, S., Jia, N., Luo, X., & Fang, Z. (2021). The Janus face of artificial intelligence feedback: Deployment versus disclosure effects on employee performance.(9), 1600−1631.

Tsai, C. Y., Marshall, J. D., Choudhury, A., Serban, A., Hou, Y. T. Y., Jung, M. F., … Yammarino, F. J. (2022). Human-robot collaboration: A multilevel and integrated leadership framework.(1), Article 101594.

van de Weerd, I., Mangula, I. S., & Brinkkemper, S. (2016). Adoption of software as a service in Indonesia: Examining the influence of organizational factors.(7), 915−928.

Venkatesh, V., Morris, M. G., Davis, G. B., & Davis, F. D. (2003). User acceptance of information technology: Toward a unified view.(3), 425−478.

Vrontis, D., Christofi, M., Pereira, V., Tarba, S., Makrides, A., & Trichina, E. (2022). Artificial intelligence, robotics, advanced technologies and human resource management: A systematic review.(6), 1237−1266.

Wang, B., Liu, Y., & Parker, S. K. (2020). How does the use of information communication technology affect individuals? A work design perspective.(2), 695−725.

Wang, J. W., Omar, A. H., Alotaibi, F. M., Daradkeh, Y. I., & Althubiti, S. A. (2022). Business intelligence ability to enhance organizational performance and performance evaluation capabilities by improving data mining systems for competitive advantage.,(6), Article 103075.

Webber, S. S., Detjen, J., MacLean, T. L., & Thomas, D. (2019). Team challenges: Is artificial intelligence the solution?(6), 741−750.

Webster, J., & Watson, R. T. (2002). Analyzing the past to prepare for the future: Writing a literature review.(2), 9−20.

Wilson, J., & Daugherty, P. (2018). Collaborative intelligence: Humans and AI are joining forces.(4), 114−124.

Wirtz, J., Patterson G. P., Kunz H. W., Gruber, T., Lu, V. N., Paluch, S., & Martins, A. (2018). Brave new world: Service robots in the frontline.(5), 907−931.

Yam, K. C., Bigman, Y. E., Tang, P. M., Ilies, R., Cremer, D. D., Soh, H., & Gray, K. (2021). Robots at work: People prefer-and forgive-service robots with perceived feelings.(10), 1557−1572.

Yam, K. C., Goh, E. Y., Fehr, R., Lee, R., Soh, H., & Gray, K. (2022). When your boss is a robot: Workers are more spiteful to robot supervisors that seem more human., Article 104360.

Yam, K. C., Tang, P. M., Jackson, J. C., Su, R., & Gray, K. (2023). The rise of robots increases job insecurity and maladaptive workplace behaviors: Multimethod evidence.(5), 850−870.

Yoon, S. N., & Lee, D. (2019). Artificial intelligence and robots in healthcare: What are the success factors for technology-based service encounters?(3), 218−225.

Dancing with AI: AI-employee collaboration in the systemic view

YIN Meng, NIU Xiongying

(Business School, University of International Business and Economics, Beijing 100029, China)

AI-employee collaboration is an interactive system composed of “AI-human-organization” with the goal of completing tasks efficiently. Promoting AI-employee collaboration is crucial for driving the deep integration of AI and the real economy, as well as the mental health and career development of employees in the digital era. AI-employee interactions are intricate and complex. Existing studies are fragmented and lack of a comprehensive understanding of AI-employee collaboration. Therefore, it is necessary to systematically sort out the relevant studies on AI-employee collaboration on the basis of clarifying relevant concepts. Through a systematic review of relevant studies, this paper clarifies the connotation of AI and AI-employee collaboration, sorts out the components of AI-employee collaboration system, analyses the influences of the components, and further constructs an integrated research framework from the perspective of systemic view. Finally, based on the research framework of AI-employee collaboration, future research directions are proposed.

artificial intelligence, AI-employee collaboration, systemic view, research framework, I-P-O

B849: C93

2023-03-28

* 对外经济贸易大学研究生科研创新项目(202221)。

尹萌, E-mail: yinmeng1231@qq.com