基于PIE和CGAN的无人农机红外与可见光图像融合

王红君,杨一鸣,赵 辉,岳有军

基于PIE和CGAN的无人农机红外与可见光图像融合

王红君,杨一鸣,赵 辉,岳有军

(天津理工大学 电气工程与自动化学院 天津市复杂系统控制理论与应用重点实验室,天津 300384)

为了使无人农机在复杂环境的生产过程中及时感知环境信息,避免安全事故发生,本文提出了一种PIE(Poisson Image Editing)和CGAN(Conditional Generative Adversarial Networks)相结合的红外与可见光图像融合算法。首先,利用红外图像及其对应的红外图像显著区域对CGAN网络进行训练;然后,将红外图像输入训练好的网络,即可得到显著区域掩膜;在对其进行形态学优化后进行基于PIE的图像融合;最后,对融合结果进行增强对比度处理。该算法可以实现快速图像融合,满足无人农机实时感知环境的需求,并且该算法保留了可见光图像的细节信息,又能突出红外图像中行人和动物等重要信息,在标准差、信息熵等客观指标上表现良好。

红外图像;图像融合;生成对抗网络

0 引言

近年来,为了进一步提高农业生产效率,解决农村劳动力资源短缺的问题,农机装备被列为“中国制造2025”十大重点研究领域之一[1]。作为智能农机的重要组成部分,无人农机的环境感知能力对于提升作业效率、保证作业安全十分重要。为了提高复杂农业环境下(大雾、沙尘天气以及夜晚作业等)无人农机环境感知能力,研究适合无人农机的红外与可见光图像融合方法具有重要意义。

传统的红外与可见光图像融合方法大多基于多尺度分解,即将源图像进行多尺度变换后得到一系列的子图像或系数,然后针对融合需求制定不同的统合框架和融合规则,融合分解得到的子图像或系数,最后经过相对应的逆变换得到融合图像[2]。文献[3]提出了一种基于目标增强的多尺度变换分解的红外和可见光图像融合。文献[4]提出了一种基于多尺度变换和范数优化的红外和可见光图像融合方法。文献[5]提出了一种基于显著性检测和双尺度变换分解的红外和可见光图像融合。上述方法融合规则比较复杂,处理速度偏慢,难以满足无人农机对环境的实时监控需求。

基于深度学习的红外与可见光融合方法,一般基于改进网络结构进行图像融合,文献[6]提出了一种生成对抗网络框架下基于深度可分离卷积的红外与可见光图像融合方法。文献[7]提出了一种基于离散小波变换和生成对抗网络来融合高光谱图像和多光谱图像的方法。文献[8]提出了红外与可见光图像注意力生成对抗融合方法。此类方法融合质量一般取决于训练集的质量好坏。

Pérez等人提出的泊松图像编辑(Poisson Image Editing,PIE)[9],可以将两幅图像自然融合,但是在融合过程中需要手动制作红外图像显著区域掩膜,无法满足无人农机实时处理环境信息的要求,本文通过引入深度学习技术实现红外图像显著区域掩膜的自动生成。在农机实际生产过程中,复杂的环境会影响红外图像显著区域掩膜生成的准确性,农机环境感知能力不仅要具备实时性,而且要能够在复杂环境中精确处理大量的图像。本文通过自制适合本文背景的数据集来训练条件生成对抗网络CGAN自动生成红外图像显著区域掩膜并对生成的掩膜进行形态学优化,简化红外图像显著区域掩膜的生成过程并加快了生成速度。使用Adam算法和随机梯度下降算法优化网络权重,并采用学习率衰减来减小成本函数收敛到最优解时的振荡。对融合结果采用直方图均衡化进行增强对比度处理。

1 原理和方法

1.1 泊松图像编辑

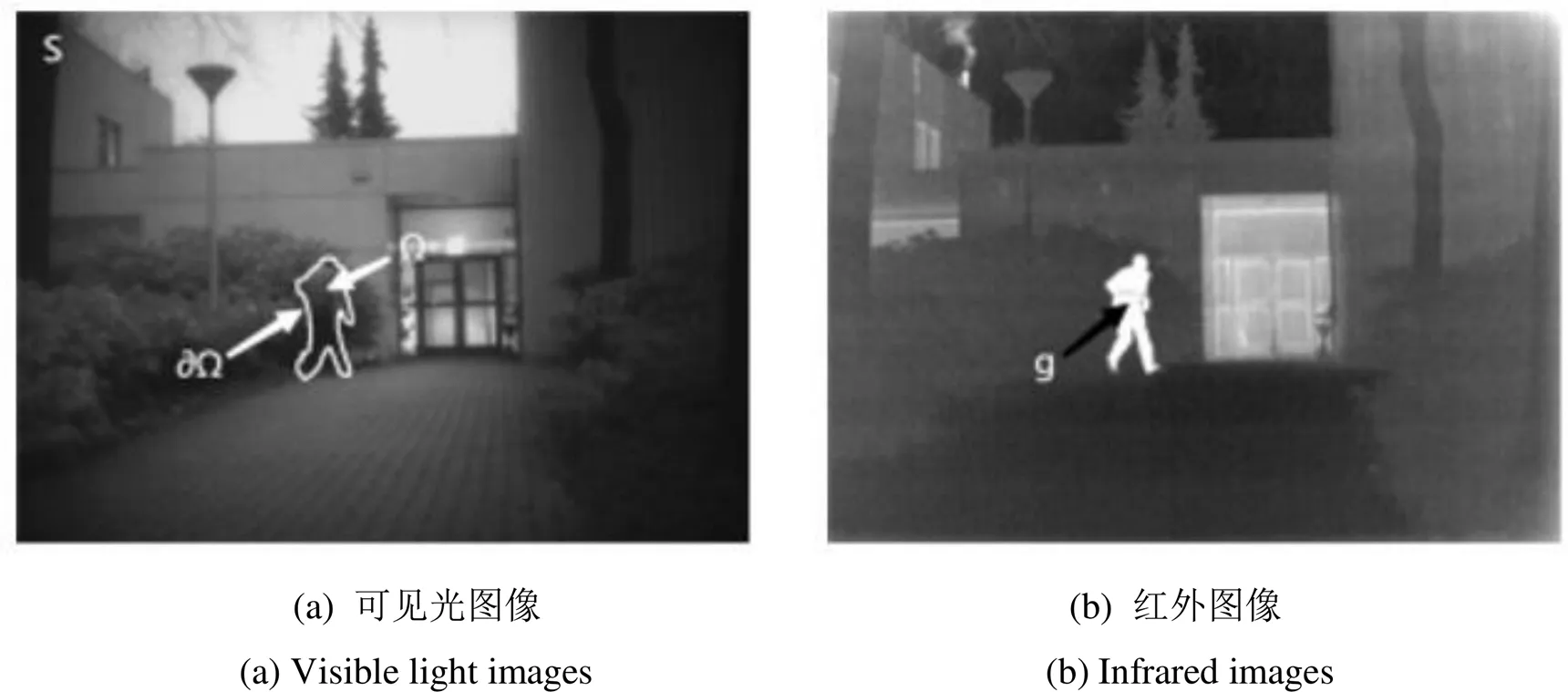

泊松图像编辑是利用基于泊松方程的通用插值机制来实现不同图像之间的无缝融合,如图1所示。将可见光图像背景中与周围环境对比度低的区域替换为红外图像中高亮的区域,∂表示合成边界。

图1 泊松图像编辑插值图示

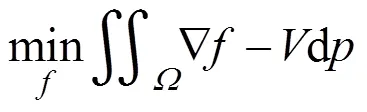

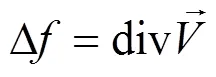

要使在插入的同时内容平滑,边界无缝过渡,中的像素值应该满足以下条件:

在融合的过程中,需要对背景图像和目标图像进行Mask操作,得到和区域,其表示如下:

Ñ(,)=Mask(,)×ÑIR(,)+

(1-Mask(,))×ÑVIS(,) (4)

式中:Ñ(,)、ÑIR(,)和ÑVIS(,)分别为融合后图像、红外图像和可见光图像在(,)处的梯度,Mask(,)为红外图像经过Mask操作后得到的显著区域。

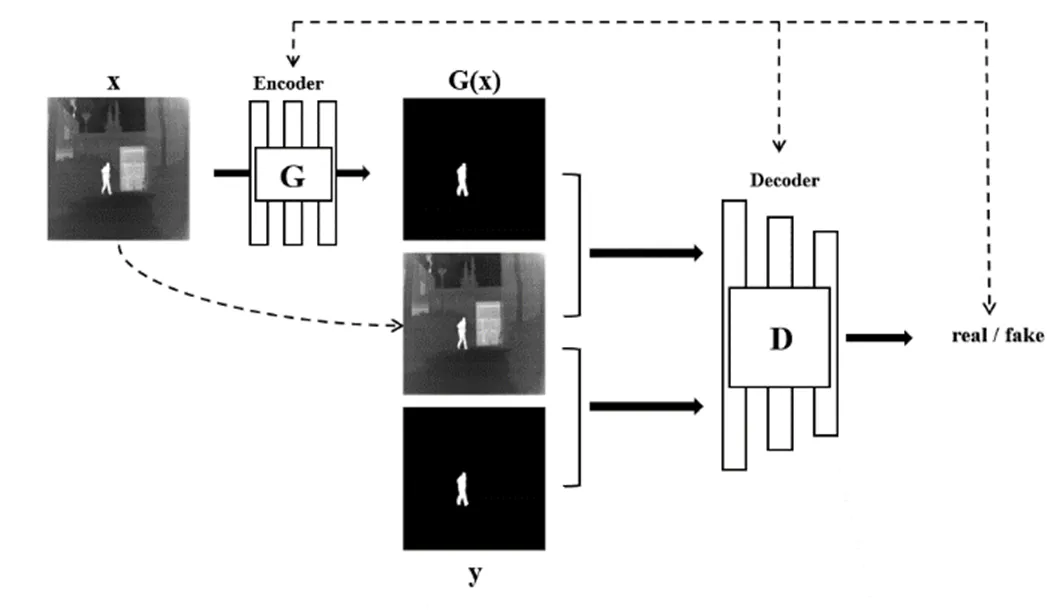

1.2 条件生成对抗网络

CGAN原理如图2所示,由生成器以及判别器构成[10]。采用U-net网络作为生成器,结构如图3(a)所示。它是一个5层卷积神经网络,每层网络都包含卷积层、ReLu激活层[11]和归一化层[12],解码器包含反卷积层、激活层和归一化层。编码器的作用是特征提取,而解码器的作用是恢复图像。判别器采用马尔可夫判别器[13],结构如图3(b)所示。马尔可夫判别器采用全卷积形式,图像输入作为一个×矩阵,原图中的每一小块都对应着×矩阵中的一个元素。

图2 CGAN基本原理图

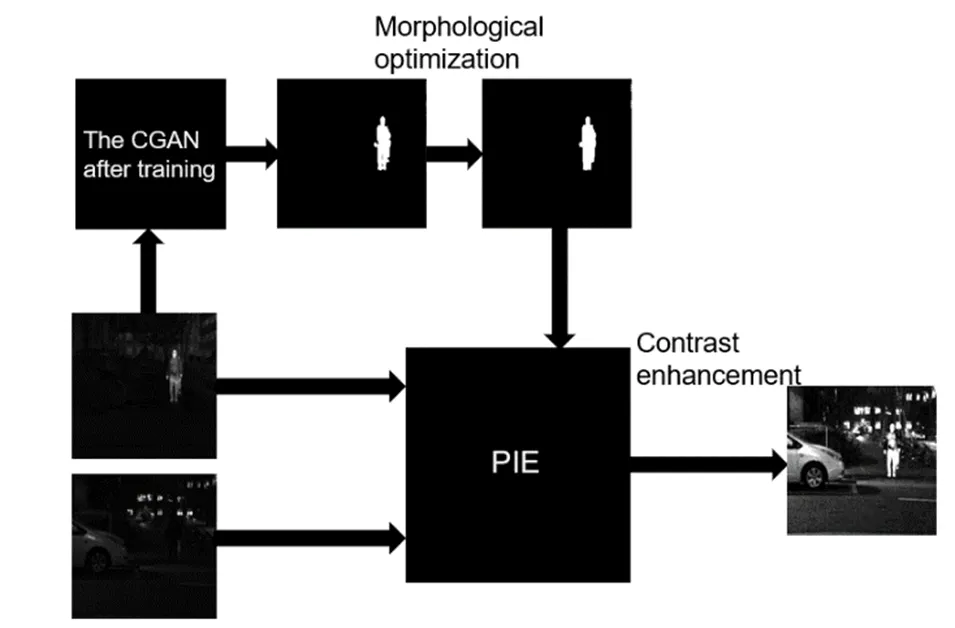

CGAN经过训练可以实现从观察到的图像和随机噪声向量到输出图像,即::{,}®。目标函数如式(5)所示:

在CGAN网络训练过程中,生成器与判别器之间互相对抗。经过训练后生成器生成的结果无法与“真实”的图像相区分。而经过训练的判别器则尽可能地区分生成器生成结果图像的真伪,与此同时,CGAN网络生成一幅和参考值很相似的图像。为了更好地恢复图像的低频信息,引入下式1距离:

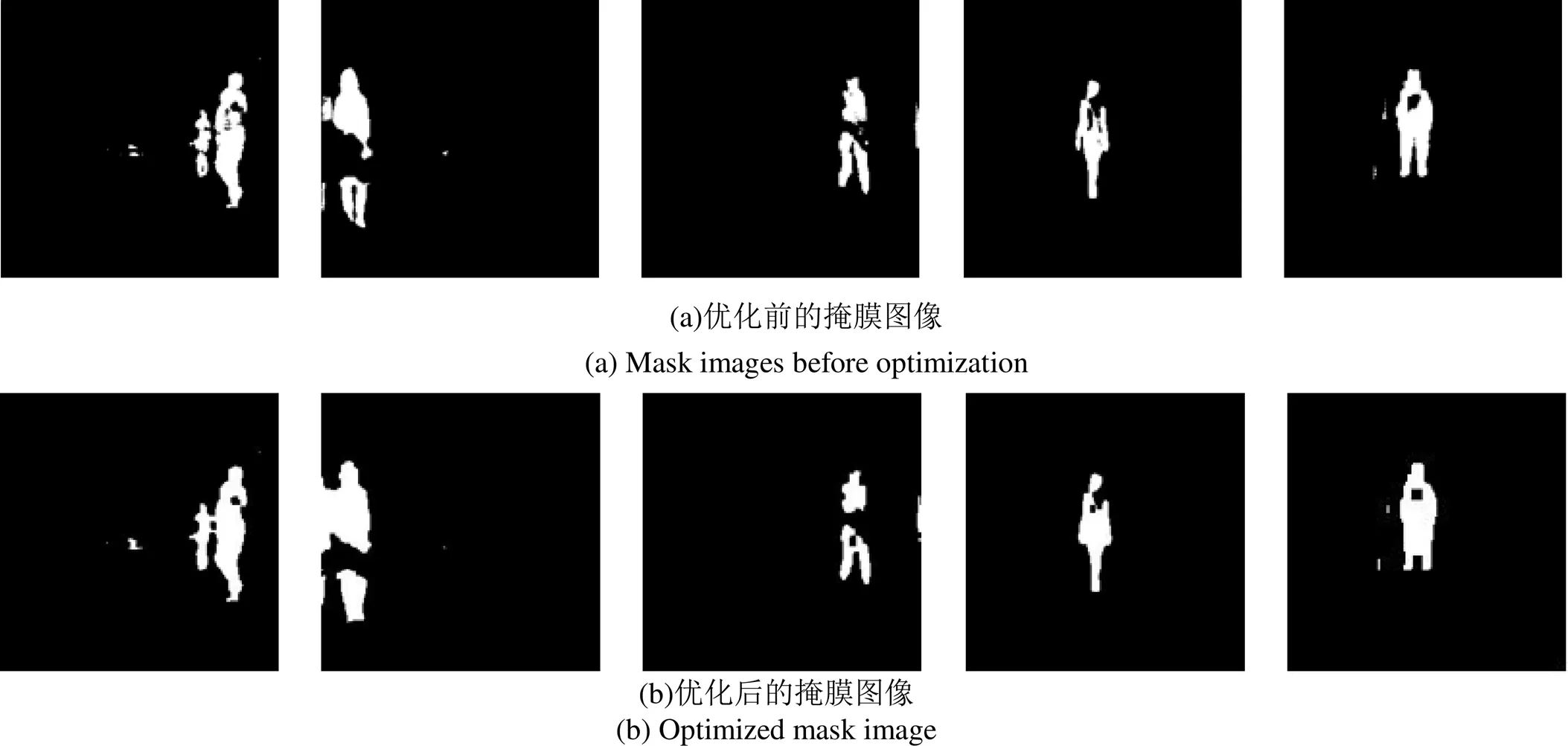

本文所使用的损失函数如下式所示:

式中:为循环一致性损失系数,其数值为10。

2 训练与评价

2.1 CGAN的训练

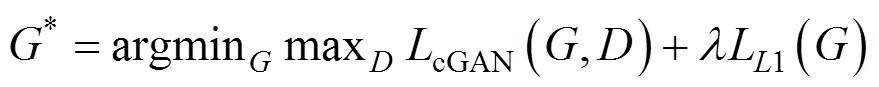

首先,在公开TNO数据集中提取85幅红外图像和可见光图像,将图像的尺寸批量压缩到300×300并使用Photoshop软件绘制红外图像对应的掩膜图像,通过MATLAB进行裁剪,最终得到765幅256×256红外图像及对应的图像显著性掩膜,舍弃其中165幅显著信息缺失的图像,将剩余的600对图像进行逐个配对。配对后的600幅图像为训练集。图4为训练数据集中部分红外图像以及对应的掩膜图像。

图4 训练集中部分图像。(a) 红外图像;(b)红外图像对应的掩膜图像

网络训练过程中为了优化网络权重,使用Adam算法和随机梯度下降算法,且每一轮迭代时都对学习率进行衰减。训练在一台个人计算机(AMD Ryzen 7 4800H、2.9GHz、16GB内存、NVIDIA GeForce 1650 Ti、4GB显存)上进行,用时4.5h完成训练。

采用TNO数据集中未经裁剪和MSRS数据集中共85幅红外图像作为测试数据集。经过测试,训练后的网络模型可以一次性快速得到测试数据集对应的掩膜图像,85幅图像用时仅需8s。图5为得到的部分图像掩膜测试结果。

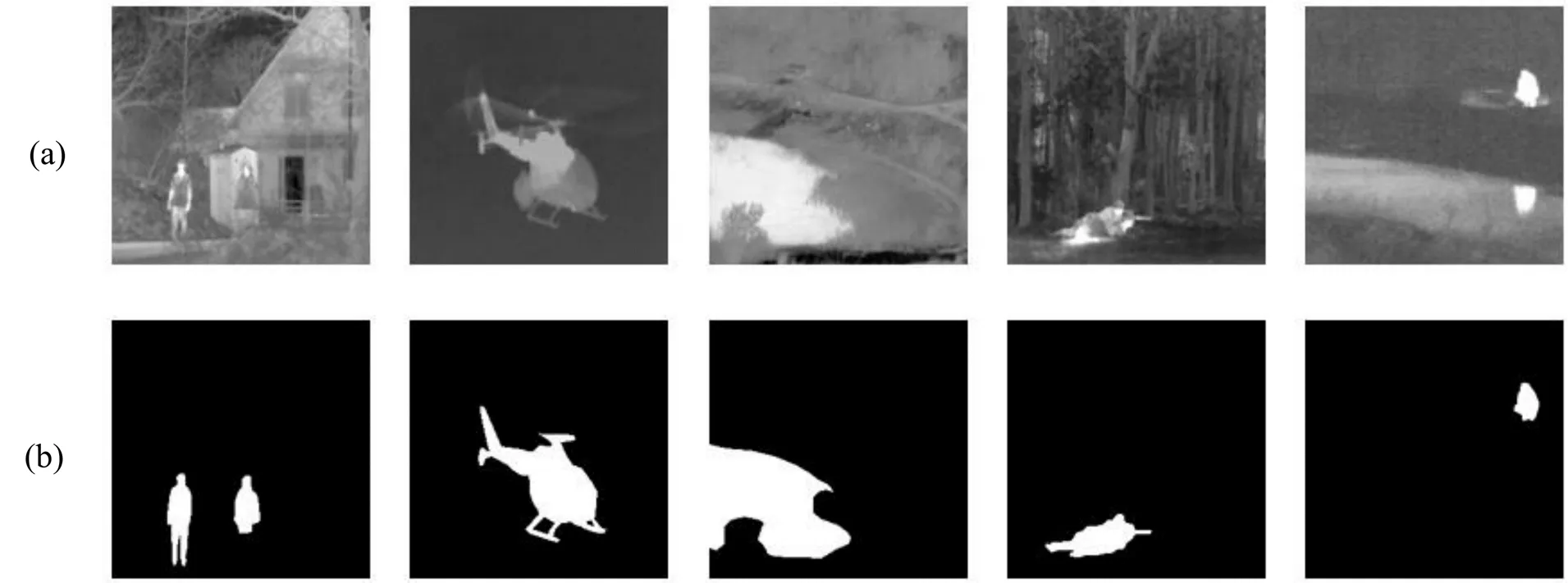

经过网络生成的掩膜图像中会有小的空洞,并且轮廓会存在不平滑的现象,所以,本文对生成的掩膜图像做形态学优化处理,即图像的闭运算,先膨胀,后腐蚀。闭运算可以在不改变目标大小的前提下平滑轮廓的一部分,可以消除细小的空洞,弥合高亮部分与高亮部分中较窄的间断,填补一部分轮廓的断裂。优化前后对比如图6所示。

图6 优化前后对比

2.2 融合结果评价

本文融合算法框架结构如图7所示。

使用泊松无缝融合可能会对融合结果有一定的影响,比如会对边缘产生不必要的平滑,显著目标与周围环境颜色趋于一致等问题,所以对融合结果采用直方图均衡化进行增强对比度处理。融合结果选用测试集中7组图片,使用本文融合结果与传统的红外与可见光图像融合算法结果,包括加权平均方法(Weighted average、WA)[14]、PCA变换法[15]和小波变换法(Wavelet transform、WT)[16]进行对比,对比结果如图8所示。

图7 融合算法流程图

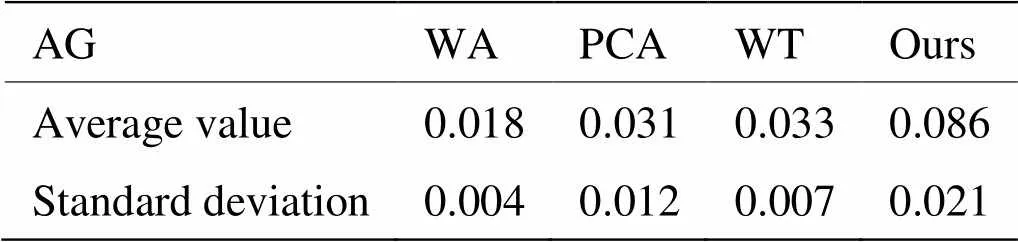

为了评价融合结果的质量,本文采用3个客观评价指标。评价指标分别是图像标准差[17]、信息熵[18]和平均梯度[19],分别对应为下式:

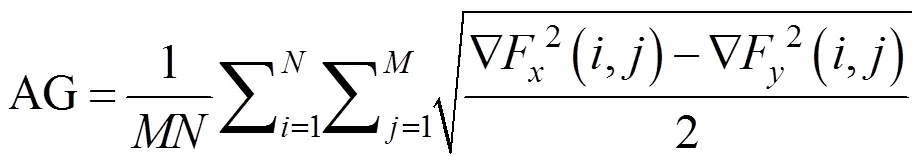

式中:为图像平均亮度值。SD值越大表明融合图像的对比度越高。

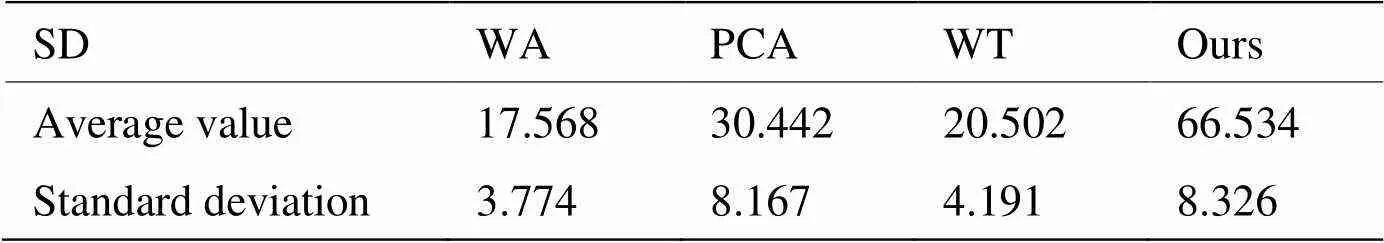

式中:为图像灰度等级;F()为融合图像中灰度级级出现的概率,EN值越大表明融合图像中信息越丰富。

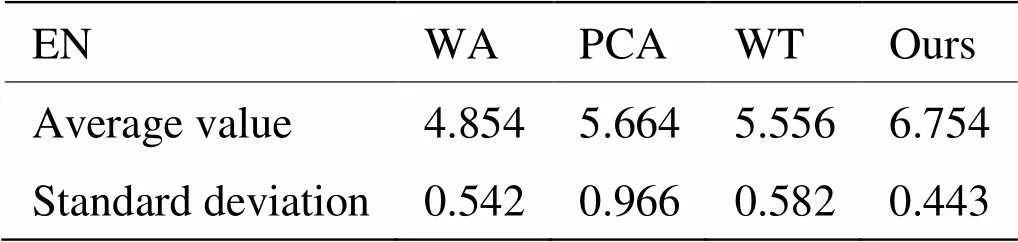

式中:ÑF(,)=(,)-(+1,),ÑF(,)=(,)-(,+1)。AG值越大表明融合后图像边缘保留程度越好[20]。

评价对象为主观对比图中的7组图像。客观对比数据如表1所示。

为进一步证明本文算法有效性,对测试集中85组图像进行客观对比试验,客观数据SD平均值与标准差如表2所示。

客观数据EN平均值与标准差如表3所示。

客观数据AG平均值与标准差如表4所示。

根据图表综合对比分析,本文所提方法能在保留红外图像中显著目标高对比度的同时,保留更多的可见光图像细节。同时,融合后的图像在各项指标上表现优异,能保留更多的有效信息,更加符合人眼感知情况。

表2 客观数据SD对比

表3 客观数据EN对比

表4 客观数据AG对比

3 结论

本文提出了一种基于CGAN和PIE的红外与可见光图像融合方法,该方法通过引入深度学习技术解决了传统PIE方法掩膜生成的问题,而且相比于传统融合方法,本文方法得到的融合图像质量更高,可读性更强。本文算法即保留了红外图像中与周围环境有温差的目标的对比度,又保留了可见光图像中的环境细节。对比结果证明了本文算法的有效性。可以为无人农机在能见度低的环境下提供较好的环境感知能力,是一种可行有效的融合方法。不过该方法在融合过程中可能会受到其他非行人高温目标的干扰,更精确的融合方法是今后努力的目标。

[1] 郑国伟. 《中国制造2025》简介与相关情况[J]. 中国仪器仪表, 2018(10): 25-28.

ZHENG Guowei. Introduction and related situation of "Made in China 2025" [J]., 2018(10): 25-28.

[2] 安影. 基于多尺度分解的红外与可见光图像融合算法研究[D]. 西安: 西北大学, 2020. Doi: 10.27405/d.cnki.gxbdu.2020.000953.

Anying. Study on infrared and visible light image fusion algorithms based on multi -scale decomposition[D]. Xi'an: Northwest University, 2020. Doi: 10.27405/d.cnki.gxbdu.2020.000953.

[3] CHEN Jun, LI Xuejiao, LUO Linbo, et al. Infrared and visible image fusion based on target-enhanced multiscale transform decomposition[J]., 2020, 508: 64-78.

[4] LI G, LIN Y, QU X. An infrared and visible image fusion method based on multi-scale transformation and norm optimization[J]., 2021, 71(2): 109-129.

[5] ZHANG S, LI X, ZHANG X, et al. Infrared and visible image fusion based on saliency detection and two-scale transform decomposition[J]., 2021, 114(3): 103626.

[6] 王海宁, 廖育荣, 林存宝, 等. 基于改进生成对抗网络模型的红外与可见光图像融合[J/OL]. 电讯技术, [2022-06-08]. http://kns.cnki. net/kcms/detail/51.1267.tn.20220509.1228.004.html.

WANG Haining, LIAO Yurong, LIN Cunbao, et al. Based on the integration of infrared and visible light images that are improved to generate network models [J/OL]., [2022-06-08]. http://kns.cnki.net/kcms/detail/51.1267.tn.20220509.1228.004.html.

[7] 孙佳敏, 宋慧慧. 基于DWT和生成对抗网络的高光谱多光谱图像融合[J]. 无线电工程, 2021, 51(12): 1434-1441.

SUN Jiamin, SONG Huihui. Hyperspectral multispectral image fusion based on DWT and generative adversarial network[J]., 2021, 51(12): 1434-1441.

[8] 武圆圆, 王志社, 王君尧, 等. 红外与可见光图像注意力生成对抗融合方法研究[J]. 红外技术, 2022, 44(2): 170-178.

WU Yuanyuan, WANG Zhishe, WANG Junyao, et al. Infrared and visible light image attention generating confrontation fusion methods [J]., 2022, 44(2): 170-178.

[9] Hussain K F, Mahmoud R. Efficient poisson image editing[J]., 2015, 14(2): 45-57.

[10] Chandani P, Nayak S. Generative adversarial networks: an overview[J]., 2020, 7(3): 753-758.

[11] MOON S. ReLU network with bounded width is a universal approximator in view of an approximate identity[J]., 2021, 11(1): 427-427.

[12] WU S, LI G, DENG L, et al. L1-norm batch normalization for efficient training of deep neural networks[J]., 2019, 30(7): 2043-2051.

[13] Abdeimotaal H, Abdou A, Omar A, et al. Pix2pix conditional generative adversarial networks for scheimpflug camera color-coded corneal tomography image generation[J]., 2021, 10(7): 21-21.

[14] 甄媚, 王书朋. 可见光与红外图像自适应加权平均融合方法[J]. 红外技术, 2019, 41(4): 341-346.

ZHEN Mei, WANG Shupeng. Visible light and infrared images adaptive weighted average fusion method[J]., 2019, 41(4): 341-346.

[15] 张影. 卫星高光谱遥感农作物精细分类研究[D]. 北京: 中国农业科学院, 2021. DOI:10.27630/d.cnki.gznky.2021.000383.

ZHANG Ying. Satellite High Spectrum Remote Sensing Crop Fine Classification Study[D]. Beijing: Chinese Academy of Agricultural Sciences, 2021. Doi: 10.27630/d.cnki.gznky.2021.000383.

[16] 倪钏. 红外与可见光图像融合方法研究[D]. 温州: 温州大学, 2020.Doi:10.27781/d.cnki.gwzdx.2020.000124.

NI Yan. Research on the Fusion Method of Infrared and Visible Light Image[D]. Wenzhou: Wenzhou University, 2020. Doi: 10.27781/d.cnki. gwzdx.2020.000124.

[17] CHEN J, LI X, LUO L, et al. Infrared and visible image fusion based on target-enhanced multiscale transform decomposition[J]., 2020, 508: 64-78.

[18] 刘娜, 曾小晖. 基于信息熵引导耦合复杂度调节模型的红外图像增强算法[J]. 国外电子测量技术, 2021, 40(12): 37-43. Doi: 10.19652/j.cnki. femt.2102956.

LIU Na, ZENG Xiaohui. Based on information entropy guidance coupling complexity adjustment model of infrared image enhancement algorithm [J]., 2021, 40(12): 37-43. Doi: 10.19652/J.CNKI.FEMT.2102956.

[19] KONG X, LIU L, QIAN Y, et al. Infrared and visible image fusion using structure-transferring fusion method[J]., 2019, 98: 161-173.

[20] 王瑜婧. 显著性检测的红外与可见光图像融合算法研究[D]. 西安: 西安科技大学, 2021. Doi:10.27397/d.cnki.gxaku.2021.000608.

WANG Yujing. Research on Infrared and Visible Light Image Fusion Algorithms of Significant Detection[D]. Xi'an: Xi'an University of Science and Technology, 2021. Doi: 10.27397/d.cnki.gxaku.2021.000608.

Infrared and Visible Image Fusion of Unmanned Agricultural Machinery Based on PIE and CGAN

WANG Hongjun,YANG Yiming,ZHAO Hui,YUE Youjun

(School of Electrical Engineering and Automation, Tianjin University of Technology/Tianjin Key Laboratory of Complex System Control Theory and Application, Tianjin 300384, China)

In this study, we proposed an infrared and visible image fusion algorithm that combines PIE and CGAN to make unmanned agricultural machinery perceive environmental information promptly and avoid accidents during production in complex environments. First, we trained the CGAN using an infrared image and corresponding saliency regions. The infrared image is input into the trained network to obtain the saliency region mask. After morphological optimization, we performed image fusion based on the PIE. Finally, we enhanced the fusion results by contrast processing. This algorithm can realize fast image fusion and satisfy the requirements for real-time environmental perception of unmanned agricultural machines. In addition, the algorithm retains the details of visible images and highlights important information concerning humans and animals in infrared images. It performs well in standard deviation and information entropy.

infrared image, image fusion, generative adversarial network

TP391

A

1001-8891(2023)11-1223-07

2022-06-14;

2022-08-10.

王红君(1963-),女,硕士,教授,研究方向为复杂系统智能控制理论及应用,流程工业综合自动化理论与技术、电力系统及其自动化,农业信息化与精准农业智能监控理论与技术、微机控制技术、农业机器人技术。E-mail: hongewang@126.com。

杨一鸣(1997-),硕士研究生,主要研究方向为图像处理。E-mail:1046147950@qq.com。

天津市科技支撑计划项目(19YFZCSN00360, 18YFZCNC01120)。