基于无监督学习和注意力机制的水下偏振图像融合

巩文哲, 褚金奎, 成昊远, 张 然

(大连理工大学 辽宁省微纳米系统重点实验室,辽宁 大连 116024)

1 引 言

海洋面积占地球总面积的70%以上,海洋生态系统是地球上生产力最高、最具活力的生态系统之一,人们在海洋资源勘探、生物考察和水下航行器导航等领域展开了研究[1-5]。水下光学图像是目前探索海洋的重要媒介之一,但是由于光线在水中受到大量漂浮微粒的影响,实际水下获得的图像严重退化,存在背景噪声大、对比度低和细节丢失等问题[1]。因此,水下图像增强技术的研究对于海洋探测和获取水下的有效信息具有重要的意义和价值。

在众多水下成像技术中,水下偏振光学成像技术作为新型光学成像技术备受关注[6-9]。偏振是光的波动性的表现,不同物体反射光的偏振态不同,在一定程度上能表征目标物体的特征信息。研究表明,水下偏振成像技术利用散射光的偏振特性可以在一定程度上减小后向散射光对水下成像的影响[8]。偏振探测中,通常用斯托克斯矢量表征光波的强度和偏振态。其中,总光强包含反射光和透射光并倾向于描述物体的反射率和透射率;线性偏振度(Degree of Linear Polarization, DoLP)图像用于表征偏振特性并提供详细的特征。为了获得同一场景的互补信息,需要融合强度和DoLP 图像。近年来,图像处理领域出现了许多图像融合方法。图像融合方法根据融合过程可以分为像素级、特征级和决策级3 种不同层级的融合。其中,像素级图像融合的研究和应用最多,分为基于变换域的融合方法(图像金字塔[10]、小波变换[11]、Ridgelets 变换[12]、Curvelet 变换[13])和基于空间域的融合方法(HIS 变换融合方法[14]、主成分分析逆变换融合方法[15]、像素值加权法、统计模型融合方法)两类,可从像素层面实现多源图像的融合,融合后的图像信息更加全面、精确、可靠。

近年来,深度学习技术发展飞快,计算机视觉和图像处理领域的许多问题取得了突破性进展。目前,基于深度学习的图像融合技术研究日益增多,在数字成像(多焦点图像融合[16]、多曝光图像融合[17]等)、多模态成像(可见光与红外光图像融合[18-21]、医学多模态图像融合[22]、偏振图像融合[23]等),以及遥感成像[24](多光谱与全色图像融合、多光谱与高光谱图像融合等)等多个方向。与传统方法表征输入图像和目标图像复杂映射关系的能力有限相比,深度学习模型在表征不同信号之间复杂关系方面具有强大的能力,并且可从数据中自动提取有效的特征,解决人工设计的困难。本文将深度学习应用于水下偏振图像融合,提出了一种基于无监督学习和注意力机制引导的网络模型,主要分为特征提取、特征融合和图像重构3 个模块。其中,特征提取模块融合了注意力机制,其次构建了相关损失函数及权重参数。该方法能够有效融合水下光强和偏振度图像信息,提高视觉成像质量,具有较强的稳定性和自适应性。

2 成像原理

2.1 水下成像模型

Jaffe-McGlamery 模型[25-26]是常用的水下成像模型之一,诸多水下图像复原算法都是基于此模型提出的。如图1 所示,Jaffe-McGlamery 模型中探测器最终接收到的图像是3 个分量的线性组合,这3 个分量分别是探测器接收到的目标反射光S(x,y)、光源在到达目标物前经水体散射的后向散射光B(x,y)和部分目标反射光经水体散射到达探测器的前向散射光F(x,y),则该图像可表示为:

图1 Jaffe-McGlamery 模型Fig.1 Jaffe-McGlamery model

假定目标最初的辐照度为J(x,y),由于散射和吸收的作用,光从目标传播到探测器时损失部分能量,目标反射光S(x,y)可表示为:

式中t(x,y)为介质透射率,其表达式为:

在单一均匀介质中,介质透射率由衰减系数β(x,y)和传播距离ρ(x,y)决定,衰减系数β(x,y)在空间上是恒定的,即β(x,y)=β0,传播距离ρ(x,y)是指物体与相机之间光路的水下部分。

后向散射光B(x,y)是背景光经水中颗粒反射到探测器处,可以表示为:

其中B∞表示无限远处的水下环境光光强。由于前向散射对成像质量的影响极小,通常可以忽略,则式(1)可简化为:

物体最初的辐照度J(x,y)可表示为:

2.2 偏振成像原理

在偏振探测领域最常用的偏振特性表示方法之一是斯托克斯矢量法,该方法能够全面地表征入射光波以及物质作用后光波的偏振特性。该矢量由4 个参量组成,如下:

式中:S0代表探测器接收到的总光强,S1代表0°和90°偏振分量I0°和I90°的光强度差值,S2代表45°和135°偏振分量I45°和I135°的光强度差值,S3代表光波中左旋和右旋圆偏振分量Ir和Il的光强差。不同方向的光强可以通过穆勒矩阵得出,即:

式中:θ是主光轴与参考线之间的夹角,S′表示角度为θ的出射光。根据式(8)可得角度为θ的出射光光强为:

偏振相机能够获得偏振方向为0°,45°,90°和135°的光强图,是因为CMOS 传感器的每个像元上都有4 个不同角度的偏振片(0°,45°,90°,135°)。如图2 所示,每4 个像元一组作为一个计算单元,进而获得θ为0°,45°,90°和135°的光强,联立后可以得到式(7)。利用斯托克斯矢量能够进一步计算入射光的线偏振度DoLP 以及偏振角φ:

图2 偏振传感器原理Fig.2 Schematic diagram of polarization sensor

其中:DoLP 代表光波中线偏振分量占总光强的比例,φ是入射光的优势偏振方向。

3 本文算法

3.1 网络结构

本文采用的网络结构如图3 所示,它主要包含:特征提取模块,特征融合模块和图像重构模块3 个模块。在特征提取模块,光强图像(S0image)和偏振度图像(DoLP image)采用双通道输入,第一层为包含3×3 卷积核的卷积层和激活函数ReLU,用来提取低级特征;之后是包含3 个卷积层的DenseBlock 模块,用来提取高级特征,每个卷积层也采用3×3 的卷积核,卷积核的运算步长为1。在卷积运算之前还有BN 层和ReLU 激活函数,这种排序方式能够加快网络的训练速度,DenseBlock 结构能够保留较多的深度特征,增强特征传播,确保之后的融合过程有足够的深度特征,也能缓解梯度消失的问题。光强图像和偏振度图像输入的两个通道共享相同的权重,减少了参数量,有助于降低网络的计算复杂度。之后是注意力单元(见3.2 节),注意力单元将前一层的特征图作为输入,能够捕获数据中的全局关系,引导网络学习特征图的分布。在特征融合模块,将特征提取模块输出的特征图叠加,两个特征图的通道大小均为128,叠加后融合特征图的通道大小为256。最后特征融合模块的输出作为图像重构模块的输入,图像重构模块包括5 个转置卷积层,每个转置卷积层的卷积核尺寸为3×3,通过重构模块从融合特征中重建出融合结果。详细的网络结构配置如表1 所示。

表1 水下偏振图像融合算法的网络结构配置Tab.1 Network structure configuration of under-water polarized image fusion algorithm

图3 水下偏振图像融合算法的网络结构Fig.3 Network architecture of under-water polarized image fusion algorithm

3.2 注意力单元

注意力机制是一种捕获全局依赖的机制。注意力单元结合了通道注意力和空间注意力,通道注意力能够使网络学习通道域的特征重要性,给与特征图不同的权重,从而在通道域上实现光强图像和偏振图像的选择性结合;而空间注意力聚焦于学习每一层特征图的有效信息分布,提高显著性特征的传递。注意力单元包括全局平均池化层、卷积层、激活层和拼接层等结构,如图4所示。

给定X∈RH×W×C和X′∈RH×W×C为注意力单元的输入和输出,则注意力单元的计算过程如下:

式中:σ为Sigmoid 激活函数,Fc为通道注意力分支,Fs为空间注意力分支,⊕为广播加法运算,⊗为逐元素乘法运算。

作为输入的特征图X∈RH×W×C经过通道注意力分支时,首先经过全局平均池化层得到通道特征Xc∈R1×1×C,然后用逐点卷积PWConv1,BN 层和ReLU 激活函数得到尺寸为1×1×r的通道特征,再经过逐点卷积PWConv2和BN 层得到尺寸为1×1×C的通道注意力特征图Xc。Fc表示为:

其中:δ为ReLU 激活函数,GAP 为全局平均池化。与通道注意力分支相似,在经过空间注意力分支时,先用3×3 卷积Conv1,BN 层和ReLU激活函数得到尺寸为H×W×r的特征图,再经过1×1 卷积PWConv2和BN 层得到尺寸为H×W×C的空间注意力特征图Xs。Fs表示为:

3.3 损失函数

本文中的损失函数包括全局加权结构相似性(Structural Similarity Index Measure, SSIM)损失函数(MSW-SSIM)[23],如下:

式中:LossSSIM(x,y;ω) 为基于SSIM 的损失函数,代表在窗口ω上图像x和y的结构相似性,其表达式为:

SSIM 是衡量两幅图像相似度的指标,包括亮度、对比度和结构3 个不同因素。SSIM 的取值为-1~1,SSIM 越接近1,两个图像越相似。

该损失函数基于多窗口的SSIM,解决了不同尺度的图像细节问题。使用的窗口尺寸包括3,5,7,9,11,不同窗口可以提取不同尺度的特征 。 此 外 , 在LossSSIM(IS0,If;ω) 和LossSSIM(IDoLP,If;ω)之间使用权重系数,权重系数基于和确定,定义如下:

其中:g(x)为防止异常情况设置的截断函数,g(x)=max(x,0.000 1)。当窗口内S0图像的方差大于对应DoLP 图像的方差时,说明S0图像的局部区域具有更多的图像细节,S0图像的权重系数γω应该更大。

此外,MSW-SSIM 可以保留高频信息,但对均匀的偏差不敏感容易导致亮度的改变,所以将它与L1范数损失函数整合,可以保证融合结果的亮度。L1范数损失函数表示为:

式中:M和N分别是图像的高度和宽度,Iavg为IS0和IDoLP的平均值。最终损失函数可以表示为:LMix=α⋅LossMSW-SSIM+(1-α)⋅Gσ⋅LossL1,(19)式中:α为控制MSW-SSIM 损失函数和高斯加权L1范数损失函数之间权重的超参数,设置为0.84。

4 实验与结果分析

4.1 实验配置

为了获取数据集,进行水下成像实验,实验装置及布局如图1 所示,主要包括偏振相机、玻璃水箱、偏振光源和目标物体。偏振相机型号为PHX050S-P,目标分辨率为2 448×2 048,采用焦平面偏光成像,镜头焦距为10.5 mm,可以一次拍摄4 张偏振角度分别为0°,45°,90°和135°的线偏振光强度图像。采用透明玻璃水箱作为容器,并在水箱内壁覆盖黑色绒布,以避免环境光和内壁反射的干扰。将目标放置在装满水的玻璃水缸中,获取光强图和线偏振度图像,最终构建了包含150 组图像的数据集。每组图像由对应的光强图和线偏振度图构成,图像尺寸为1 224 pixel×1 024 pixel,其中100 组作为训练集,剩余50 组为验证集和测试集。对数据集图像进行翻转,并裁剪为80×80 大小用作网络训练的输入,训练过程在显卡为NVIDA GeForce RTX 2080 Ti 的服务器上进行。在进行权值初始化后,使用mini-batch 大小为 128 的 Adam 优化器进行优化。学习率最初设置为0.000 1,并以0.99 的速率呈指数衰减,最大Epoch 设置为200。

4.2 结果分析

基于无监督学习和注意力机制对网络进行训练,并对水下图像融合性能进行测试。为了客观衡量融合图像的质量,采用信息熵(EN)、标准差(SD)、互信息(MI)和结构相似性(SSIM)4 种图像评价指标。信息熵表示图像的平均信息量,其计算公式如下:

信息量越大,信息熵越大。图像融合后会造成图像信息量的增加,而信息熵可以反映出变化的程度。

标准差指图像像素灰度值相对于均值的离散程度。标准差越大,表明图像中灰度级分布越分散,图像质量也就越好,其计算公式为:

互信息可度量两幅图像之间的相似程度,即融合图像获取了多少原图像信息量。互信息越大,表示融合图像保留更多源图像信息,质量越好。互信息由图像的信息熵H(A)和联合信息熵H(A,B)决定,即:

这里MI 的计算公式为:

SSIM 是一个广泛使用的图像质量评价指标,它是基于人眼观看图像时会提取其中的结构化信息的假设。SSIM 越接近1,相似度越高,融合质量越好。本文采用的计算公式为:

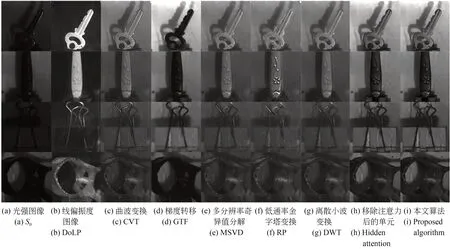

图像融合结果如图5 所示,可以发现,光强图像质量较差,场景细节退化严重,在加入偏振图像进行融合后,目标物变得更清晰,钥匙的纹理轮廓能够清楚地识别。根据采用的图像指标进行评价,融合后的信息熵提升24.48%,标准差提升139%,表明本方法可提升水下图像质量。

图5 融合结果Fig.5 Fusion result

此外,进行了消融实验,并将本方法得到的融合图像与其他几种图像融合方法进行了比较,包括曲波变换(Curvelet Transform, CVT)[13]、梯度转移(Gradient Transfer, GTF)[27]、多分辨率奇异值分解(Multi-resolution Singular Value Decomposition, MSVD)[28]、低通率金字塔变换(Ratio of low-pass Pyramid, RP)[10]、离散小波变换(Discrete Wavelet Transform, DWT)[11]以及移除注意力单元后的网络。如图6 所示,RP 的结果具有较差的视觉效果,钥匙边缘和阴影部分均产生了一定程度的伪影,且噪点较多;CVT,DWT和MSVD 的结果有一定程度的颗粒感,且对比度偏低,对于阴影的处理较差;GTF 的结果具有较高的对比度,但钥匙的纹理细节不够清晰;而本文方法具有较为真实的视觉效果,没有明显的伪影和失真且对阴影的处理效果较好,相对于移除注意力单元的网络在细节方面更为精细。

图6 部分测试集图像不同方法融合结果对比Fig.6 Comparison of fusion results of different methods for partial test set images

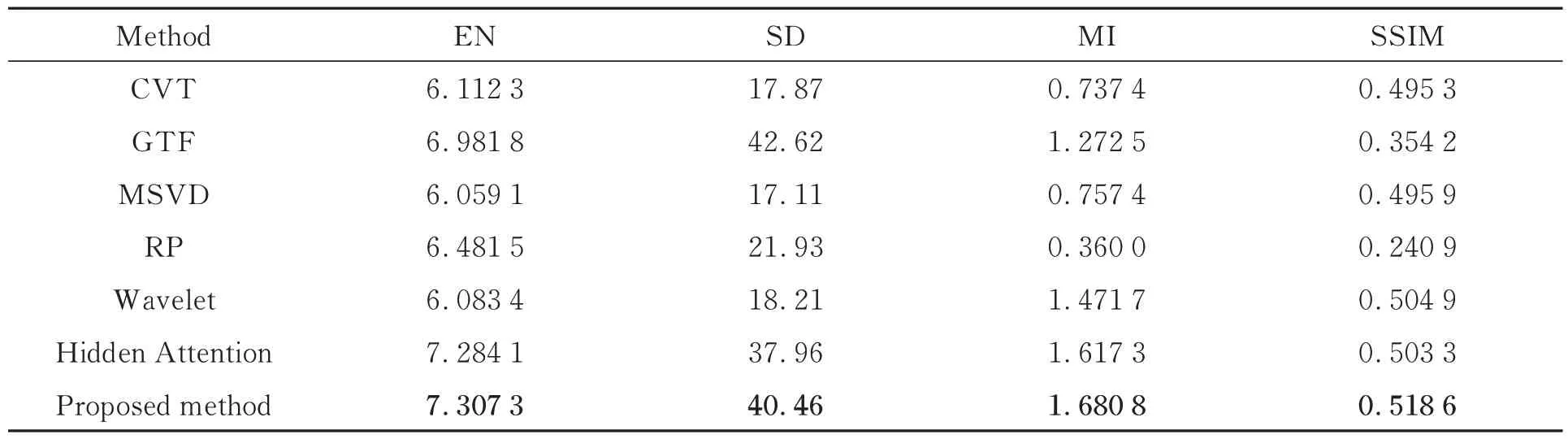

为了客观地评估方法的性能,使用之前介绍的4 种图像评价指标对测试集中的图像进行评估,最终结果取平均值,结果如表2 所示。本方法在信息熵、标准差、MI 和SSIM 3 种图形评价指标中均具有较好的表现,进一步说明了方法的有效性。

表2 不同方法对偏振图像融合的定量结果Tab.2 Quantitative results of polarization image fusion by different methods

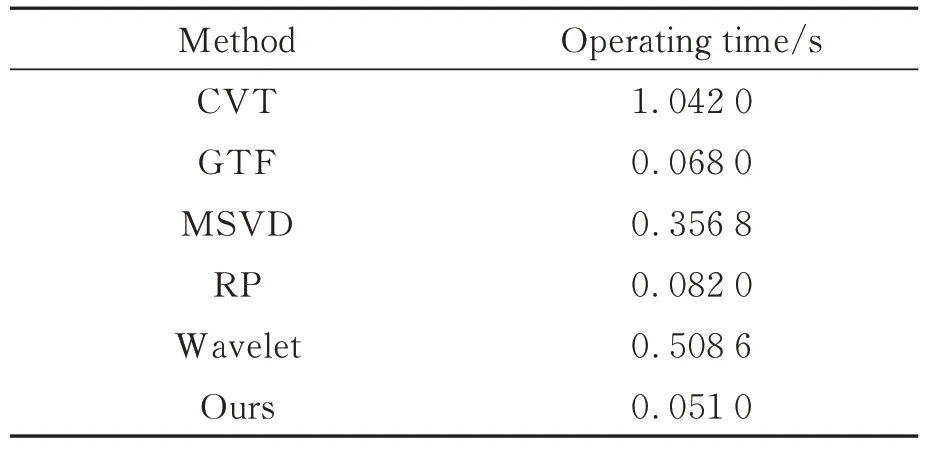

最后,在配置为NVIDIA GeForce RTX 2080 Ti,3.1GHz Intel Core i9-9600X,128G RAM 的服务器上进行运行时间评估,结果如表3所示。所有方法均在Python 语言下实现,采用多组取平均值,本文方法的处理速度为0.051 s,优于其他方法。

表3 不同方法的运算时间Tab.3 Operating time of different methods

5 结 论

本文针对水下光学成像质量差的问题,通过分析水下主动偏振成像模型,提出了将深度融合网络应用于水下偏振图像的方法,搭建实验装置获取水下偏振图像构建训练数据集,构造了基于无监督学习和注意力机制引导的端到端网络模型并设计损失函数。实验结果表明,本文方法提高了图像视觉质量,融合后的水下图像细节更为丰富,相比于光强图像信息熵提升了24.48%,标准差提升了139%。传统的图像融合方法通常需要设定权重参数来控制不同输入图像之间的融合程度,而权重参数的设定需要经过反复实验和调整才能得到最佳效果。相比之下,该方法不需要手动设定权重参数,可以从数据中学习到较优的融合策略。下一步研究包括构建更为全面的数据集、改进损失函数和网络模块以进一步提升融合图像质量,以满足实际应用的要求;同时还要提高算法的处理效率,减小运算时间,以满足实时处理水下视频的需求,实现对水下目标的实时检测。