基于卷积神经网络在卵巢肿瘤良恶性鉴别诊断中的研究

杨志新,赵丽珠,邓 玥,杨丽华

(昆明医科大学第二附属医院妇科,云南 昆明 650101)

卵巢癌在女性生殖系统恶性肿瘤中发病率居第3 位,病死率位列首位[1],GLOBOCAN 数据[2]显示2020 年全球约有31 万卵巢癌新发病例。由于卵巢癌早期缺乏典型临床特征,且无有效的筛查手段,超过70%的患者被诊断时已在Ⅲ期或Ⅳ期,预后较差,严重威胁妇女生命健康[3-4]。因此发现卵巢癌早期诊断的有效策略成为亟待解决的问题。

超声图像因其成本低廉、便捷迅速以及无创侵入等优点广泛运用于临床,2022 年国家卫生健康委员会发布的《卵巢癌诊疗指南》[5]指出现阶段超声检查是卵巢癌筛查的首选方法,可明确卵巢有无占位性病变,但高诊断准确率对超声医师的检查能力、临床经验及综合分析能力要求较高。近年来,深度学习作为前沿技术逐渐运用于医学影像学领域,其中卷积神经网络(convolutional neural network,CNN)的应用最为广泛。CNN 技术可通过计算机辅助诊断系统自动学习提取超声图像特征,检测医师难以发现的深层成像特征,更好地辅助医生诊断疾病,提高诊断效率[5]。其与肝脏超声、乳腺超声、甲状腺超声图像等结合,协助提高结节良恶性诊断水平[6-8]。本研究选取VGG16 与MobileNet-V2 2 个CNN 模型与卵巢肿瘤超声图像结合,以提高卵巢肿瘤超声图像鉴别诊断水平,提高卵巢癌早期诊断效率。

1 资料与方法

1.1 病例选择与图像收集

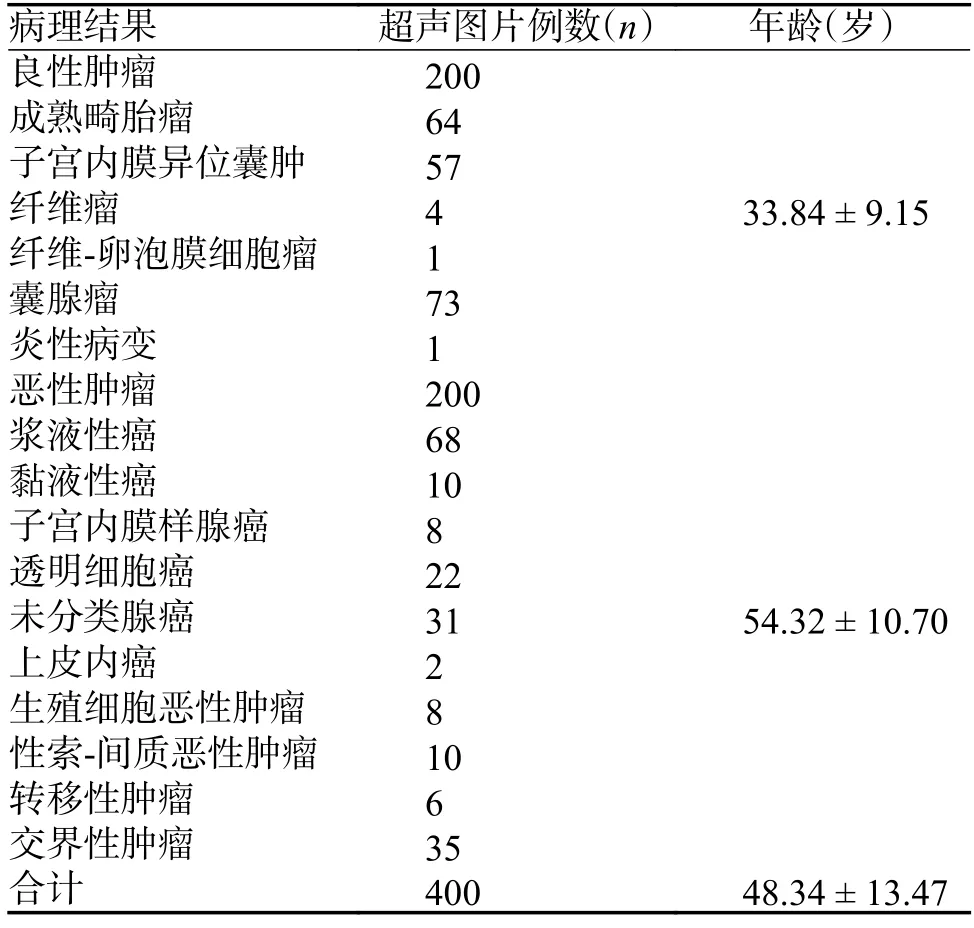

纳入标准[9]:细胞学或组织病理证实的卵巢恶性肿瘤、卵巢良性肿瘤患者;可获取疾病负荷状态的超声图像。排除标准[9]:虽病理证实为符合条件的卵巢病变但在昆明医科大学第二附属医院超声检查时已无疾病负荷;超声图像未存档或超声图像模糊无法辨认、包含无效信息过多。本次研究经昆明医科大学第二附属医院伦理委员会审查批准(伦理批件号审-PJ-2020-100),共收集2015 年6 月至2022 年9 月卵巢肿瘤患者365 例(良性患者200 例,恶性患者165 例),共400 张卵巢肿瘤超声图像,均取得患者本人或家属知情同意。具体病理类型,见表1。患者中位年龄为(48.34±13.47)岁。

表1 收集图片病理结果统计表()Tab.1 Statistical tables of pathological results from collected image()

表1 收集图片病理结果统计表()Tab.1 Statistical tables of pathological results from collected image()

超声图像集均来自Philips-Affiniti 50 彩色多普勒超声诊断仪,探头为 C9-4v 腔内超声探头,探头频率22~42 Hz。采集图像存储为JPG 格式。图像预处理流程,见图1。挑选肿瘤清晰的图像,由工作经验5 a 以上的超声科医生选取肿瘤感兴趣区域。另外,B 超图像上病灶标注等信息,利用Matlab 图像处理的方式去除。将图像统一调整为224×224 像素大小便于模型训练。随后超声图片数据集以1∶3 比例分为训练集及验证集,选取100 例超声图片(恶性50 例,良性50 例)作为训练集用于模型的训练与建立,余300 例超声图片(恶性150 例,良性150 例)作为验证集用于模型验证。

图1 B 超图像预处理流程图Fig.1 The preprocessing of ultrasound image

1.2 卷积神经网络模型搭建与训练

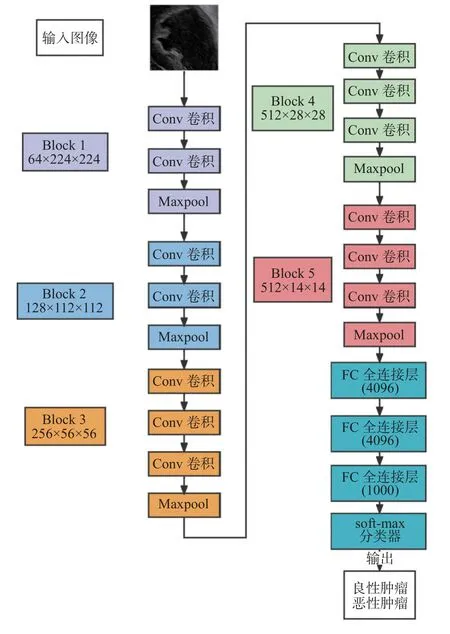

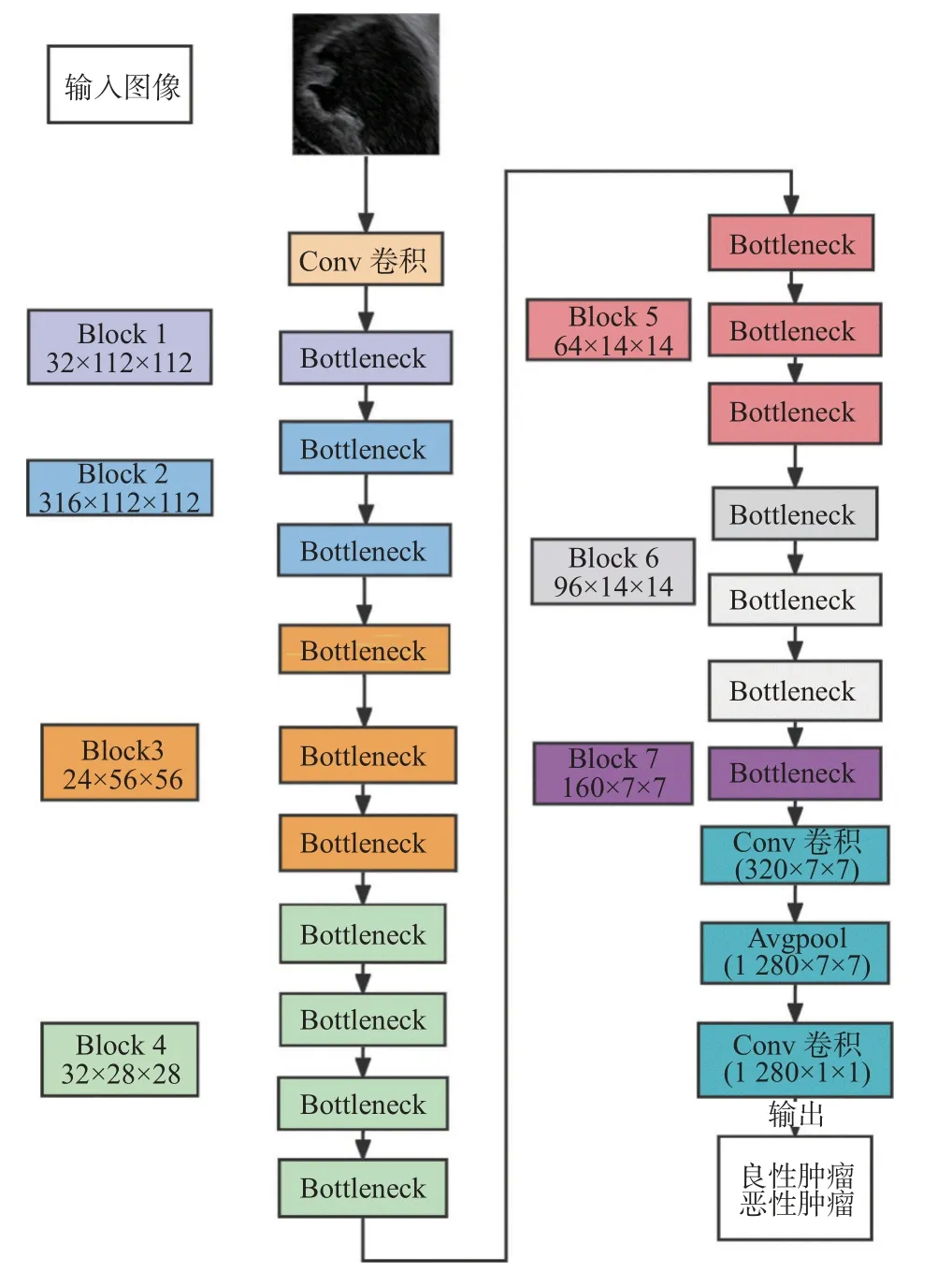

采用VGG16 和MobileNet-V2 构建CNN 模型,对卵巢超声图像进行分类。VGG 模型作为经典的CNN 网络,可以从B 超图像中提取肿瘤尺寸、位置、纹理等空间特征信息以实现分类任务。本研究选择VGG16 模型进行第1 轮搭建,它包含5 段卷积,每段卷积有1 到3 个卷积层,每段卷积后接1 个最大池化层来缩小特征值尺寸和增强特征,后接3 个全连接层,前2 层均有4 096 个通道,第3 层共1 000 个通道,对应1 000 个标签类别,最后1 层为Softmax 层,见图2。MobileNet-V2 模型不仅借鉴VGG 结构,堆叠卷积层以提高准确度,另外引入线性瓶颈结构和反向残差结构,实现模型参数少、计算速度快的优点,且适用于轻量级设备的应用部署。本研究应用的MobileNet-V2 包含初始的32 个卷积核的全卷积层,后接17 个反向残差瓶颈模块,然后是2 个全卷积层,2 个全卷积层之间插入1 个平均池化层以实现分类任务,见图3。

图2 VGG16 模型Fig.2 The structure of VGG16

图3 MobileNet-V2 模型Fig.3 The structure of MobileNet-V2

本次实验使用个人计算机训练神经网络。使用python 3.7,CUDA 10.1 及包括Numpy、Pytorch、Torchversion 等在内的多个Python 组件,分别对VGG16 网络和MobileNet-V2 网络进行参数调整,学习率设置为0.001,Batchsize 为32,epoch 为200 次。损失值代表训练数据输入VGG16 及MobileNet-V2 网络后,预测值和真实值之间的误差;准确率反映模型预测值与真实值之间的一致性。损失值越小,准确率越高则模型诊断效能更强。在每次训练结束时,将每次训练后的训练集损失函数值与训练集准确率进行记录保存,然后根据数据创建折线图表来直观地反应结果。使用CUDA 加速,对数据集进行训练与前向推理。经过200 周期的训练后,模型保存为CSV 文件。最后用验证集来测试训练集得到的模型,以此作为评价诊断模型的性能指标。

1.3 比较 CNNs 卵巢癌诊断模型和超声医师诊断超声图像准确率

选择本院高年资和低年资2 名超声科医生,其中高年资医师的选择标准为取得中级资格证,妇科超声检查超过10 000 例,低年资医师标准为从事超声工作小于3 a,妇科超声检查不到3 000例。2 名医师分别独立地对电脑屏幕所展示的验证集图像进行识别判断,记录结果。与模型诊断结果进行比较。

1.4 统计学处理

采用SPSS 26.0 对数据进行统计描述和统计学分析,计数资料统计描述采用例数或百分比表示。分别计算Kappa 系数、灵敏度、特异度、准确度、阳性预测值、阴性预测值,4 种诊断方法各参数比较采用χ2检验,P<0.05 表明差异有统计学意义。

2 结果

2.1 VGG16 和MobileNet-V2 诊断模型建立过程中的损失值与准确率

随着训练次数的增加,两模型训练集的损失值不断下降,但损失值下降趋势逐渐减缓,VGG16 网络模型的损失函数值始终高于MobileNet-V2 模型,见图4A。使用VGG16 和MobileNet-V2 进行训练后得到的准确率结果,见图4B。总的看来,随着训练次数增加,2 模型训练集的准确率均呈上升的趋势,但实验次数100 次之后,准确率提升便不再明显,最终VGG16、MobileNet-V2 模型的准

图4 VGG16 和MobileNet-V2 在训练过程中的损失函数值和准确率Fig.4 The loss and accuracy of VGG16 and MobileNet-V2 during training process

2.2 VGG16 和MobileNet-V2 卵巢肿瘤诊断模型和超声医师诊断效能比较

统计4 种诊断方法结果,VGG16 模型有121例恶性肿瘤图片分类正确,119 例良性肿瘤图片分类正确;MobileNet-V2 模型有134 例恶性肿瘤图片分类正确,140 例良性肿瘤图片分类正确;高年资医生有113 例恶性肿瘤图片分类正确,121 例良性肿瘤图片分类正确;低年资医生有100 例恶性肿瘤图片分类正确,99 例良性肿瘤图片分类正确,计算统计各参数,见表2。分别比较MobileNet-V2、VGG16 模型、超声医生与病理诊断的一致性、准确率,灵敏度、特异度,结果发现VGG16、MobileNet-V2 模型诊断的准确率,灵敏度、Kappa 值均高于超声医生(P<0.05),而高年资超声医生的诊断效能又优于低年资超声医生(P<0.05),其中MobileNet-V2 模型各项指标均优于其他3 种诊断方法,整体性能最佳(P<0.05)。

表2 Mobilenet-V2、VGG16、与超声医生诊断能力比较Tab.2 Comparision of diagnosis performance among MobileNet-V2,VGG16 and ultrasound doctors in validation sets

3 讨论

恶性肿瘤的筛查与诊断一直以来都是肿瘤研究领域的热点,研究者们很早就将人工智能方法应用到肿瘤影像学中,从早期计算机辅助诊断系统,到现在普遍运用的深度学习。人工智能正逐步表露其巨大的潜力不断为恶性肿瘤的诊断筛查,甚至治疗、预后研究提供新的思路。伴随CNN 的迭代更新,拥有良好性能的CNN 模型不断涌现。VGG 的结构网络十分简洁,其利用小卷积核的堆叠,在减少网络参数的同时,能完成同大卷积核一样的感受野效果;另外每层卷积之后的非线性函数,提升网络对图片特征值的学习及表达。与之前的网络结构相比,VGG 的错误率大幅下降,拓展性很强,并且在图像分类和目标检测任务中都取得了很好的效果[10-11]。VGG 依据深度不同,划分为6 种结构,其中VGG16 具有良好的图片分类能力。Han 等[12]使用10 种机器学模型和 VGG算法对肺癌患者的PET/CT 图像进行学习分析,以构建用于肺腺鳞癌鉴别诊断的最佳分类模型,最后VGG16 算法曲线下面积0.903,优于结合放射组学的所有传统机器学习方法。Alshammari等[13]应用VGG16 对数据库中脑转移病人的核磁图像进行分类,使用函数计算辅助增强效能,最终对脑转移图像的分类准确率达93.74%,除此之外,VGG16 还用来辅助腰椎狭窄的影像学诊断,与其他深度学习方法相比VGG16 分类成功率最高,为 87.70%[14]。可见,VGG16 与影像学的结合应用比较灵活,且结果良好。本研究首先选用VGG16 网络模型来构建训练超声图像诊断模型,最后VGG16 模型的准确率为80.00%,灵敏度为80.67%,特异度为79.33%。鉴于VGG16 模型验证数据未达到笔者对CNN 鉴别附件包块超声图像良恶性的预期,因此本研究选用MobileNet-V2 模型进行新一轮搭建。MobileNet-V2 神经网络是轻量化卷积神经网络中表现较为优秀的网络,它不仅保留了VGG 网络堆叠小卷积层以提高准确度的结构,还创新性地运用线性函数及反向残差模块来减少运算量,随着巨型网络一步步演变为轻量化网络,模型准确率也越来越高[15-16]。近年来MobileNet-V2 广泛运用于医学影像辅助诊断,Palczynski 等[17]应用MobileNet-V2 协助白血病诊断,其分类平均准确率超过90%。Srinivasu 等[18]利用MobileNet-V2 模型对皮肤病进行分类,该模型比其他经典CNN 模型有更高的准确性。台北大学学者[19]选择MobileNet-V2 分析患者腹部超声图像对胆囊炎进行分类,最终曲线下面积分别达0.92 和0.94。本研究搭建MobileNet-V2 网络模型验证集最后准确率为91.33%,灵敏度为89.33%,特异度为93.33%。再选取本院1 名高年资超声医生、1 名低年资超声医生对验证集数据进行独立诊断,比较诊断结果显示MobileNet-V2 诊断性能最优,VGG16、MobileNet-V2 模型诊断的准确率,灵敏度、Kappa 值均高于高、低年资超声医生(P<0.05)。这与Martinez-Mas 等[20]基于机器学习技术建立的卵巢肿瘤超声图像诊断模型准确率相当。

本研究证明了利用卷积神经网络实现对卵巢癌肿瘤分类的可行性,有望应用于临床辅助卵巢癌的诊断、改善预后。但本研究模型训练的图像数据偏少,在下一步的工作中,将逐渐扩大样本量,改善优化算法模型,发展基于超声影像的卵巢癌自动检测方法,以期为卵巢癌早期诊断困难寻求新的解决办法。