基于文本摘要提取的双路情感分析模型

王郅翔,刘 渊

1.江南大学人工智能与计算机学院,江苏无锡214122

2.江南大学江苏省媒体设计与软件技术重点实验室,江苏无锡214122

随着互联网行业的快速发展,网络强国的建设取得了历史性成就,根据2021 年第48 次中国互联网络发展状况统计报告[1]指出,我国网络购物用户规模达8.12亿,占整体网民用户的80.3%。在此基础上,更加人性化、智能化的筛选和推送服务成为当下软件的主流,文本情感分类的研究因此变得火热。文本情感分析是指利用自然语言处理和文本挖掘技术,对带有情感色彩的主观性文本进行分析、处理和抽取的过程[2]。情感倾向分析是文本情感分析的核心工作,是指对包含主观信息的文本进行情感倾向判断[3]。在传统的情感文本分类任务中,主要采取基于机器学习方法,同时在文本预处理阶段,预处理方法如:One-hot、TF-IDF和N-gram等,主要存在着嵌入矩阵稀疏的问题,并且随着词汇量的增多而变得冗长,其特征表达的能力不够精确,不利于后续研究工作的开展。随着词嵌入(word embedding)概念的提出,文本的表达迎来了新的阶段,Mikolov等[4]在2013年提出的Word2vec词向量训练工具,Penmington等[5]在2014年提出了Glove词向量,两者都解决了词向量表达的稀疏性的问题,使得文本的表达能力上升了一个台阶。伴随着计算机视觉领域的发展,各种在图形图像领域中的经典模型被尝试应用到自然语言处理领域,以卷积神经网络(convolutional neural network,CNN)、循环神经网络(recurrent neural network,RNN)为代表的神经网络及其各种网络变体在文本领域的应用变得广泛起来。Kim[6]在2014 年首次将CNN 融入到文本分类任务中,通过不同大小的卷积核提取特征并进行融合,取得了较好的效果。2017年,谷歌的研究人员提出以自注意力机制为核心的Transformer[7],在此基础上,研究人员开始将注意力机制应用到CNN 和RNN 等神经网络框架中,并在各个研究层面中取得了较好的效果。例如:Wang 等[8]将长短期记忆网络(long short-term memory,LSTM)与注意力机制相结合,显著提升了模型在方面级情感分析领域的效果,赵宏等[9]将BERT 与层次化Attention 相结合,通过双向GRU 网络得到句子和文章的表示,并结合注意力机制探究模型在微博情感分析领域内的应用,赵亚南等[10]将CNN 与多头注意力机制相结合,探究了金融领域内的情感倾向。总的来看,以神经网络为核心的模型和框架不断推陈出新,为自然语言处理发展提供新的动力。

当下,主流的情感分析模型想要提升分类效果,往往把目光聚焦在提升神经网络模型性能上,却忽略了原始文本的重要性。因此,本文提出了一种基于文本摘要提取的双路情感分析模型BLAT(Bi-LSTM-Attention-TextCNN),该模型主要包括以下几个特点:

(1)对原始文本进行凝练,减少预处理过程中信息的流失,将其作为基本输入,可以起到数据增强的作用。

(2)采用加性注意力机制代替Transformer 的自注意力机制,提高模型的并行计算效率和泛化能力。

(3)采用双路网络并行的方式提取特征,最终提高分类准确率。

1 相关工作

1.1 文本摘要提取

文本摘要提取的目标是将整个长文本,通过归纳的方式,将原文凝练成可以概括主要内容的一段文字。文本摘要技术最早应用于金融数据分析和法律判决文书领域,起到辅助决策和提取关键信息的作用,例如,齐甜方等[11]将文本摘要技术和情感挖掘技术相融合对股票价格趋势进行预测。文本摘要生成方法主要分为抽取式摘要生成和生成式摘要两种,抽取式主要是对原文信息进行提炼,这种方法产生的摘要通常会保留源文章的显著信息,有着正确的语法[12],而生成式方法能够在建立完整语义时,避免信息的冗余,两种文本摘要方法各有千秋。但是BLAT 模型面对不同长度的文本时需要对原文进行较大程度的还原,并不需要提取额外的语义,故引入抽取式摘要生成方法,对长度过长和较为冗余的文本进行摘要提取的工作,并将其作为一路特征输入到模型中。

1.2 加性注意力机制

Transformer 已经在多个任务中证明了其在自然语言处理领域内的成功,由于Self-Attention 独特的机制,能够让文本信息之间建立直接的联系,因而相较于循环神经网络,学习特征能力较强。但是,Transformer 的主要问题是对于长文本的训练速度会发生指数级增长,为缓解这一问题,2019年,Yang等提出基于Transformer架构的Transformer-XL[13]和XLNet[14],其核心架构便是经典的注意力机制。其中,Transformer-XL主要采用了相对位置编码器的方式,解决了输入文本长度受限的问题,而XLNet 主要采取集成Transformer-XL 的方式,引入片循环机制,解决了长依赖的关系问题,大幅度提升了计算速度。2021 年Wu 等提出Fastformer[15],属于Transformer的一种变体,通过采用加性注意力(additiveattention)机制的方式,对全局特征进行提取,相较于主流的Transformer 结构达到了当下最好的性能,其每层使用的参数量也更少,计算的复杂度更是达到了线性量级,能够显著缩短训练时间。其中,注意力机制内部采用了权值共享的方式,能够有效地避免模型过拟合。因此,根据情感文本结构句式多变,文本长度不一的特点,引入Fastformer中的加性注意力机制代替Transformer中的自注意机制,以达到提升模型性能和泛化能力的目的。

1.3 双路特征提取

基于深度学习的单路特征提取分类模型已经有了很多研究进展,并且在广泛的数据实验中证明了其有效性。例如:Xiao等[16]利用双向长短期记忆网络(Bi-LSTM)与词嵌入相结合的方法,对中文文本情感进行研究。随着单路模型应用场景的不断丰富,模型提升的效果瓶颈也随之展露,需要性能更加优秀的模型才能满足对于指标的需求。然而在双路模型领域,田乔鑫等[17]使用Word2vec和Glove词向量作为文本输入的区别,提出了CNN+Attention 和BiGRU+Attention 双路并行的模型对情感分析领域进行研究。万俊杰等[18]采用BERT词嵌入作为文本特征输入,提出了双通道的BCBLA 模型。两者都取得了较好的效果,目前双路模型虽然都是采取不同词嵌入方式作为文本特征输入的区别,并没有重视对于原始文本信息的提取,但是也都印证了双路模型在情感分析领域内的有效性。

在此背景下,本文提出将Bi-LSTM与Fastformer的加性注意力机制融合作为其模型的单路特征提取网络,并选取TextCNN作为二路特征提取网络,利用三种不同的特征提取方法提取文本特征并做融合,从而达到进一步提升模型对文本情感识别的效果。

2 BLAT模型

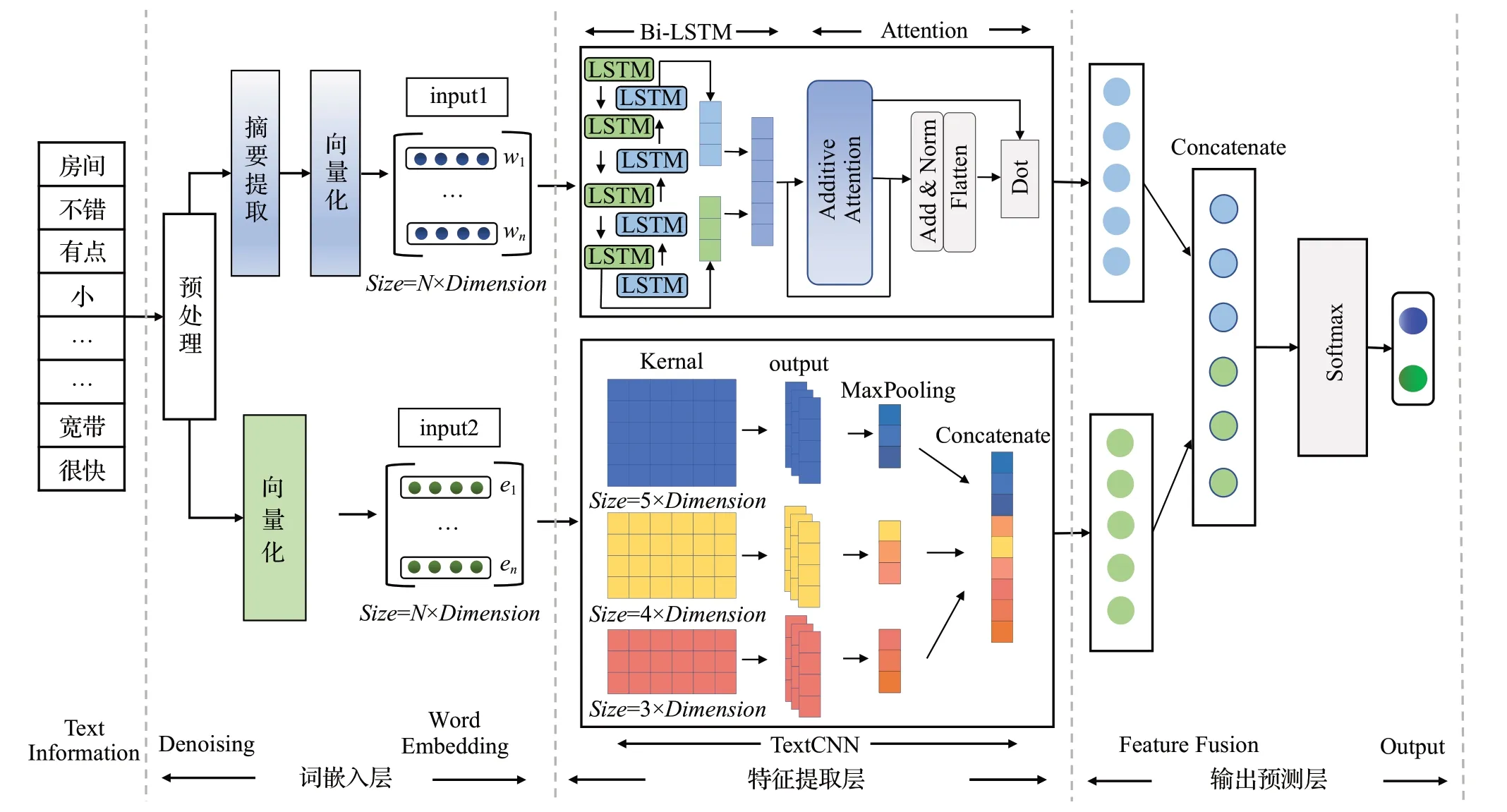

BLAT模型由以下几个部分组成:

(1)词嵌入层:将文本信息进行预处理的工作,对原文进行摘要提取,使用Word2vec 词向量工具得到双路文本向量。

(2)特征提取层:将词嵌入层得到的两个文本向量输入到双路模型中,同时利用不同的网络进行特征提取。

(3)输出预测层:将提取到的两个文本特征进行融合,使用Softmax分类器得到最终分类结果。

模型的具体结构如图1所示。

图1 BLAT结构图Fig.1 Structure diagram of BLAT

2.1 词嵌入层

当下主流的、可选择的预训练词向量有Word2vec、Glove 和BERT。Word2vec 和Glove 的主要差别在于训练过程中使用了不同的目标函数和权重函数,在文献[17]的实验结果中表现差别不大,同一模型使用这两者词向量在准确率上的误差保持在0.1%左右。而BERT 模型是按字划分的,输入到BERT中的词组依旧会转化成以字符为基本单位,由于模型在词嵌入层增加了分词的操作,为提取到更多文本序列内容,故选择Word2vec作为词嵌入工具。

在得到文本向量过程中,首要的就是预处理工作,由于文本噪声干扰较大,需剔除不符合逻辑的符号。对于抽取式摘要生成,本文引入Liu 等[19]在微博摘要生成中提到的方法,首先计算出单个词语在文章中的TF-IDF(词频-逆文档频率),通过对文本中单个词语的TF-IDF进行累加初步得到句子的权重,并对整体句子权重归一化,可以定义单个句子的权重。接着选取第一个句子作为主旨句,通过余弦相似度计算,得到单个句子的相似度权重,并且通过位置信息,得到位置权重。最后通过三个权重进行加权计算,并进行降序排序,最终按照自己划分的比例作为其摘要提取的内容。如果原文本长度过小,无法抽取,则采用原文本作为句向量的表达。

对于单路预处理完成的文本则可以表示为L={x1,x2,…,xn},通过分词操作后,超过定义长度的部分进行截断处理,长度不足的部分则进行补零操作,最终得到文本矩阵。本词嵌入层权重使用Word2vec知乎中文词向量包,词向量维度为d,那么最终单路词嵌入层矩阵可以表示为[w1,w2,…,wn],w∈R1×d。

通过上述操作,双路模型的输入分别定义为input1和input2,最终输入到双路特征提取层中。

2.2 双路特征提取层

2.2.1 Bi-LSTM+Attention层

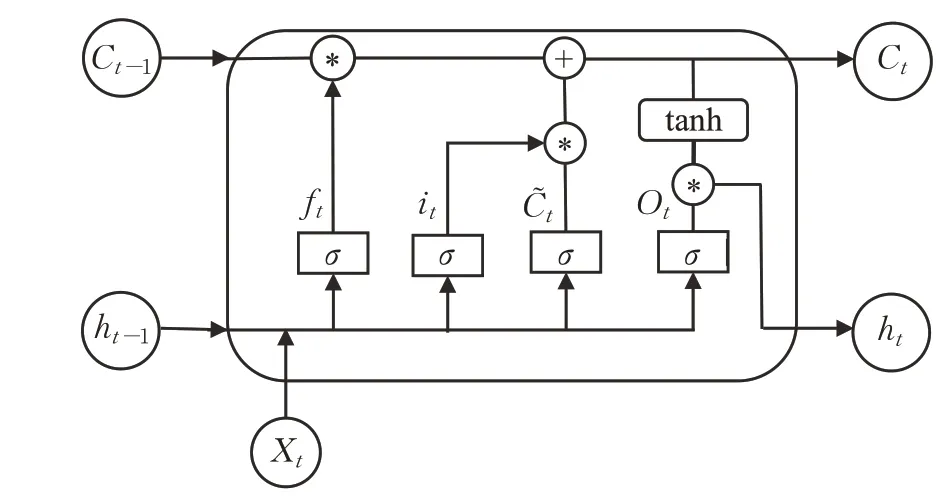

由于文本脉络承上启下,结构上具有顺序性的特点,循环神经网络非常适合作为其主要的特征提取模块。其中,LSTM 作为最经典的循环神经网络,极大地缓解了RNN 存在的梯度消失和梯度爆炸的问题。在LSTM模型中,主要有输入门it、遗忘门ft、记忆单元Ct和输出门Ot,对于上一时间步长t-1,其细胞状态表示为Ct-1,隐藏状态可以表示为ht-1,其各个参数之间的状态关系可以表示为:

其中,Wf、Wi、WO为权重矩阵,bf、bi、bO为偏置项,Sigmoid为激活函数,LSTM内部结构如图2所示。

图2 LSTM结构图Fig.2 Structureof LSTM

Bi-LSTM 网络由前向和后向的LSTM 神经网络构成,两者都同时连接输出层,通过不同顺序的文本交互,可以有效地捕捉文本语义信息的关联,其输出是蕴含着不同顺序的文本特征。

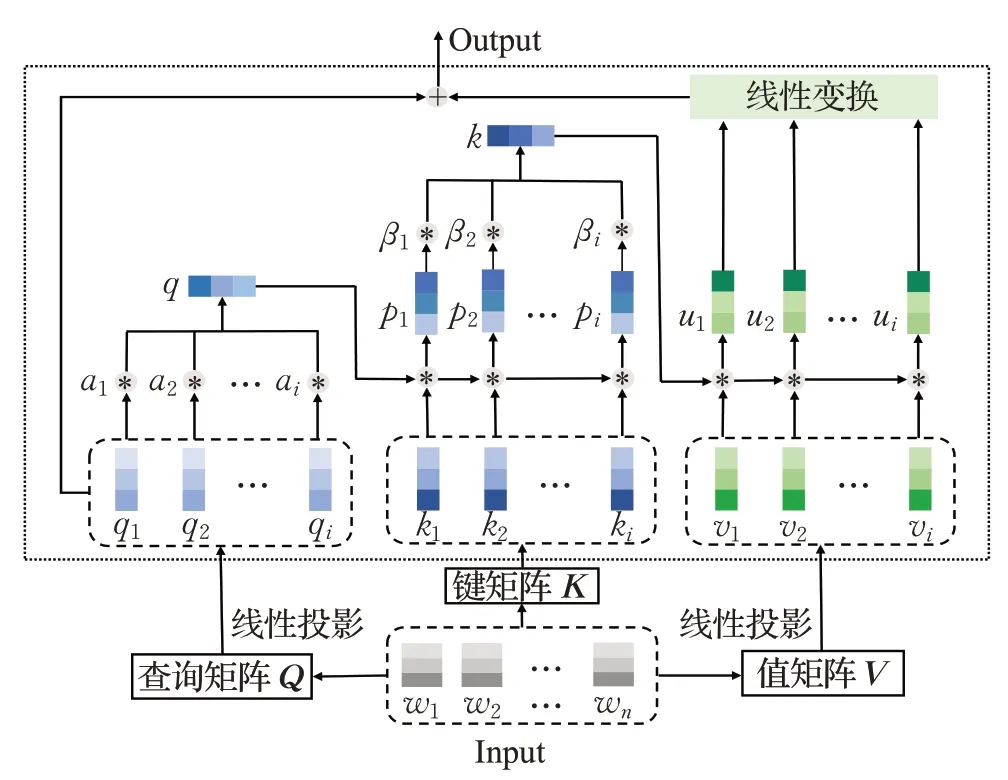

为了进一步得到关键文本的语义关联,将Bi-LSTM层输出后的内容输入到加性注意力机制中,加性注意力机制的内部结构图如图3所示。

图3 加性注意力结构图Fig.3 Structureof additive attention

加性注意力机制具体的操作是生成的Q,K,V∈RN×d矩阵,其分别包含了不同的qi,ki,vi,i∈N,对于全局查询向量q的生成,引入计算权重αi,并与qi相乘进行汇总,具体的权重和全局查询向量的生成方法如下:

使用element-wise相乘的方法可以有效反映出两个向量之间的线性关系[20],因此将全局查询向量q与ki进行交互,定义为pi,同时引入权重βi,通过与矩阵q相同的方法生成全局矩阵k,公式如下所示:

此时,已经得到蕴含上下文信息的k矩阵,同样使用element-wise相乘的方法得到最终的关系矩阵ui,并将ui输入到线性变换层进而与查询向量qi相加得到其最终输出特征Oi,将其得到的全局特征定义为Of=[o1,o2,…,oN]∈RN×d,公式如下:

本路特征提取工作已经结束,最终的输出是混合着文本信息的特征向量Of。

2.2.2 TextCNN特征提取层

卷积神经网络主要通过卷积核实现对局部关键信息的提取,由于使用的卷积核大小不同,其提取到的特征也具有多样化的特点。TextCNN作为CNN网络的一种,主要应用在文本领域,与CNN的主要区别是使用了与词嵌入维度相同大小的卷积核。完整的TextCNN 内部结构主要分为卷积层、池化层、全连接层和输出层,由于需要进行特征融合的操作,此路特征提取模型需要舍弃输出层,其主要的结构描述如下:

(1)卷积层有三个不同的过滤器,用来提取不同的文本特征,其计算公式如下:

其中,f为激活函数,wi(x,y)为对应的第i个节点过滤器输入的权重,cx,y为输入节点()x,y的取值,bi为偏置项,最终的hi是卷积层的输出。

(2)池化层主要起到降维的效果,减少计算量,防止过拟合,采用的是最大池化操作。

(3)全连接层主要是对三个不同的过滤器提取到的特征进行拼接得到特征向量,本文将输出文本特征向量定义为Tf。

2.3 输出预测层

输出层主要是对Bi-LSTM-Attention层中的特征向量Of和TextCNN 层中的特征向量Tf进行融合并使用Softmax函数得到最终的情感结果,其公式如下:

其中,Wf和bf为权重和偏置项,结果P为情感倾向。

3 仿真实验及结果分析

3.1 实验环境及数据集

本实验在Windows10环境下运行,采用的编程语言是Python3.8,IDE 为Pycharm2020,CPU 为Intel®CoreTMi7-8750H 2.20 GHz,内存24 GB,采用的深度学习框架为Tensorflow 2.7.0。

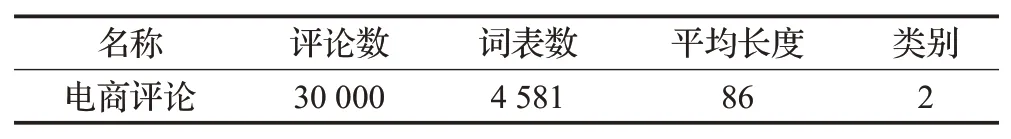

实验使用的数据集是中文电商评论数据集,其中包含了6 000条中科院谭松波博士所提供的中文酒店评论数据集(Tan Songbo Hotel Review),以及由在电商平台搜集的各类商品评价。正负样本各15 000条,数据集详细信息如表1所示。

表1 数据集信息统计Table 1 Information of dataset

3.2 摘要提取和预处理

(1)摘要提取能够提炼出原文关键信息,对于文本较长的评论,可以避免由于截断操作从而影响语义的丢失。值得注意的是,文本的摘要提取是以句号为分界的,因此面对数据数据集中不一定正确的标点格式,如果一个句子只有一个句号结尾,摘要的提取并不会成功。因此采取的方式是将所有的逗号替换成句号,确保方法最大限度地融入到模型中。

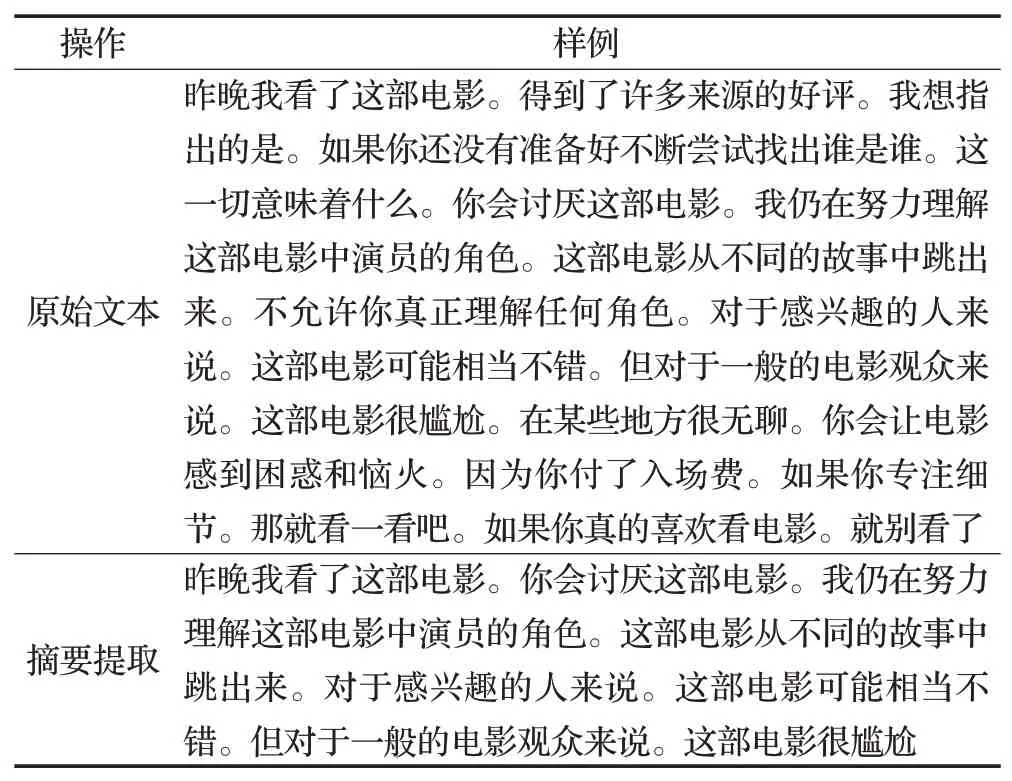

摘要提取样例如表2所示。

表2 摘要提取样例表Table 2 Abstract extraction example table

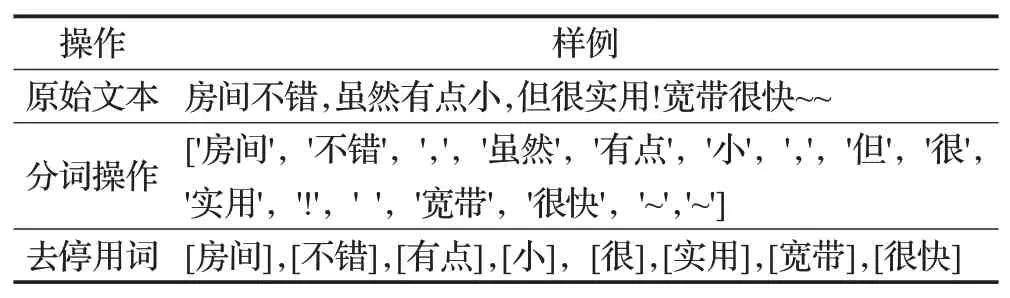

(2)正负样本中包含了大量的无用信息,为了避免影响模型效果,需要进行对文本进行数据清洗。本实验采用jieba 中文分词工具包进行操作,在分词完成之后则进行去除停用词的操作,以减少无用信息对于文本的影响。本实验采用哈工大中文停用词,对数据进行操作,处理样例表如表3所示。

表3 文本处理样例表Tbale 3 Text processing sample table

3.3 评估指标及实验参数

根据文本分类的常用指标,本文决定采取准确率(accuracy)、精确率(precision)、召回率(recall)和F1(F1-score)。

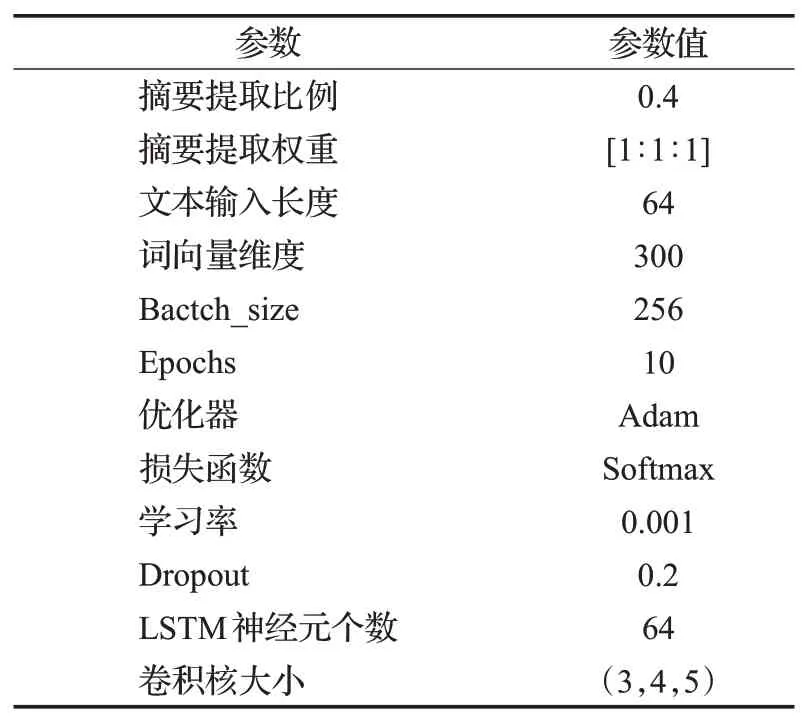

本文的实验结果除了受到网络模型结构的影响之外,实验参数的设置也会对模型结果产生影响,因此参数设置也需要规范化处理,整体设置如表4所示。

表4 实验参数表Table 4 Experimental parameter table

3.4 对比模型及实验分析

为了证明其模型的有效性,并且考虑到文本结构的特点,以及情感分析任务的一些特点,选取以下几个模型作为BLAT模型的对比实验,主要对比的方向为:(1)验证BLAT 模型相较于当下主流模型的分类效果;(2)与目前的双路情感分析模型进行对比,选取BCBLA 模型和GCDA模型中的主要结构进行验证分析。

对比的模型分别为:

(1)Bi-LSTM[16]:采用双向的LSTM 网络提取前后文之间的信息特征。

(2)单层Fastformer[15]:采用单层加性注意力机制做分类,观察其分类效果。

(3)单层Transformer[7]:采用单层注意力机制做分类,用来与加性注意力做对比效果。

(4)LSTM+Attention[8]:将LSTM网络获取的文本特征输入到注意力机制中捕捉关键信息。

(5)TextCNN[6]:采用三个不同大小的特征提取器,提取文本局部特征并作融合。

(6)DPCNN:采用深层次的,不同的固定位置卷积核提取文本中邻接词信息。

(7)CNN+Attention[10]:采用卷积神经网络和自注意力机制的方法提取网络特征。

(8)BCBLA[18]:双通道的模型,为保证模型效率的一致性,使用原有结构,但用Word2vec词向量代替BERT词向量做对比。

(9)GCDA[17]:双路特征提取模型,该模型主要使用Glove 词向量和Word2vec 词向量作为文本双路输入的区别,在对比实验中延续其模型思想。

对比模型和本文所提出的BLAT 模型的实验结果如表5所示。

表5 实验结果Table 5 Experimental results单位:%

从表5 的实验结果可以看到,BLAT 模型在准确率和F1 上分别达到了92.26%和92.37%,相较于单路模型,能够有较为出色的效果,相较于双路特征提取模型也有了一些提升。对比经典的循环神经网络Bi-LSTM,在准确率上提升了3.66 个百分点,相较于TextCNN 和DPCNN在准确率上分别提升2.36和3.9个百分点,相较于融入了注意力机制的CNN 网络在准确率和F1 指标上分别提升1.43 和1.61 个百分点。由于BLAT 模型由三种不同的特征提取方式组成,能够提取到较为丰富的文本信息,因而导致准确率的大幅提升。

在双路网络模型的表现方面,由于BCBLA 模型与GCDA模型都是双路特征提取模型,相较于单路模型也有着较好的效果,同时从侧面也印证了双路特征提取模型的有效性。由于两者对原始文本主要采用不同的词嵌入作为文本输入的区别,没用重视对于原始文本的凝练,从而忽视了长文本在输入时,由于截断操作而导致潜在的关键语义流失,因而在准确率上BLAT模型相较于BCBLA 模型在和GCDA 模型在准确率上分别提升了1.06和0.93个百分点。其中F1指标相较于双路模型均达到较为出色的效果,分别提升了0.81和1.01个百分点,能够说明BLAT模型在双路模型方面具有一定的优越性。

3.5 消融实验

3.5.1 双路并行方式对模型的影响

由于双路网络模型都是由单路网络模型组网形成,故主要选取提取特征效果更好的单路模型进行验证对比,主要是以注意力机制为核心的模型,一些模型的实验结果已在表5中体现,故选择的模型如下:

(1)Bi-GRU+Attention:GCDA 的单路特征提取模型,采用双向GRU 网络提取特征并利用注意力机制提取上下文关联。

(2)Bi-Attention:使用双层注意力机制进行特征提取。

(3)TextCNN+Attention:采用卷积核宽度同词向量维度一致的卷积网络和注意力机制提取特征。

(4)Bi-LSTM+Fastformer:BLAT模型中的单路提取网络。

(5)BLAT(无摘要):使用双路网络并行的方式,不使用摘要提取的方法。

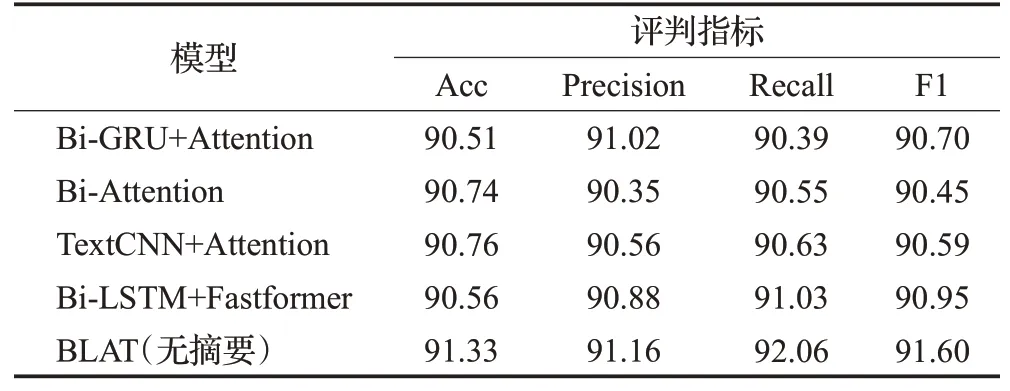

对比模型的实验结果如表6所示。

表6 对比实验结果Table 6 Comparison of experimental results单位:%

从表6 中可以看出,单路模型通过增加注意力机制的方式,能够使得原模型在准确率上有一些提升,例如:Bi-LSTM+Fastformer相较于表5中的Bi-LSTM和Fastformer在准确率上分别提升了1.96和1.20个百分点,融合了注意力机制的TextCNN 相较于单一的TextCNN模型在准确率和F1指标上分别提升0.86和0.51个百分点。

尽管增加注意力机制和更换网络的方法能够使得模型识别能力有所上升,但是依然出现了瓶颈,如Bi-GRU和Bi-LSTM同属于循环神经网络,并且Trasnformer和Fastformer 都为注意力机制,其分别组网的模型Bi-GRU+Attention 和BiLSTM+Fastformer 在表6 中准确率上的表现相差0.05 个百分点,F1 指标相差0.25 个百分点,相对能够说明其在提升效果上受到一定限制。而BLAT 模型通过双路并行的方式,其结果能够相较于BiLSTM+Fastformer和表5中的TextCNN在准确率上分别提升0.77和1.43个百分点,相较于表6中的Bi-GRU+Attention、Bi-Attention 模型能够在准确率上分别提升0.82、0.59个百分点。由于BLAT模型二路特征提取中,使用的是面向文本领域的卷积网络,提取到的特征能够有效地区别于循环神经网络和注意力机制所提取的内容,模型融合后的特征也更加得精确和丰富,其结果也能够相对说明双路并行的方法能够有效提升模型识别效果。

3.5.2 文本摘要对模型识别效果的影响

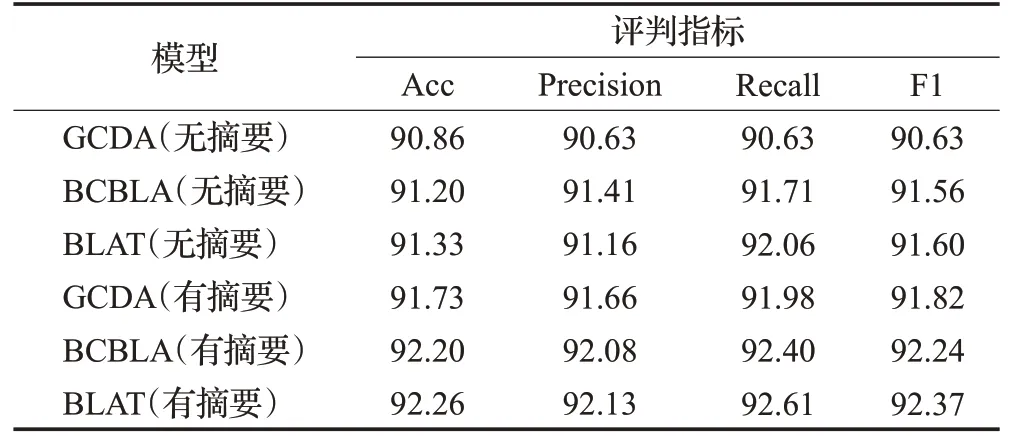

关于双路模型的效果,BCBLA 和GCDA 模型中在其各自的文章中已经验证说明,故本文着重对比关于摘要提取方法的有效性,本实验采取使用相同的词向量嵌入方法并选取BCBLA 模型和GCDA 模型进行验证,并使用本文提出的摘要提取方法做双路特征输入进行对比实验。实验结果如表7所示。

表7 摘要提取对比结果Table 7 Abstract extract comparison results单位:%

从表7 中可以看出,在双路模型整体表现方面,BLAT模型达到了比较好的效果,BCBLA和BLAT模型在准确率上的表现类似,是否使用摘要提取方法在准确率上分别相差0.06和0.13个百分点,而GCDA模型是否使用摘要提取方法在准确率上和BCBLA模型相差0.47和0.34个百分点,相较于BLAT模型在准确率方面分别相差0.53和0.47个百分点,但从总体上来说,相较于表5、表6中的单路模型依旧达到了较好效果。

得益于摘要提取方法的融入,不同的双路模型在其各项评判指标在中的表现均有所提升,其中:使用了摘要提取的GCDA 模型相较于无摘要的方法在准确率和F1指标上分别提升了0.87和1.19个百分点,相较于表5中GCDA 模型中所使用Glove 和Word2vec 的词向量做区别双路特征的方法在准确率上提升了0.4 个百分点。而有摘要提取的BCBLA模型相较于无摘要的方法在准确率和F1指标上分别提升了1和0.68个百分点,使用了摘要提取方法的BLAT 在准确率和F1 指标上分别提升0.93 和0.77 个百分点。三个模型效果的提升能够反映出文本摘要方法的融入使得模型在单句情感倾向的判别上更为准确,同时也证明了通过凝练文本原始特征的方式可以有效提升模型分类效果。

3.5.3 加性注意力机制对模型训练时间的影响

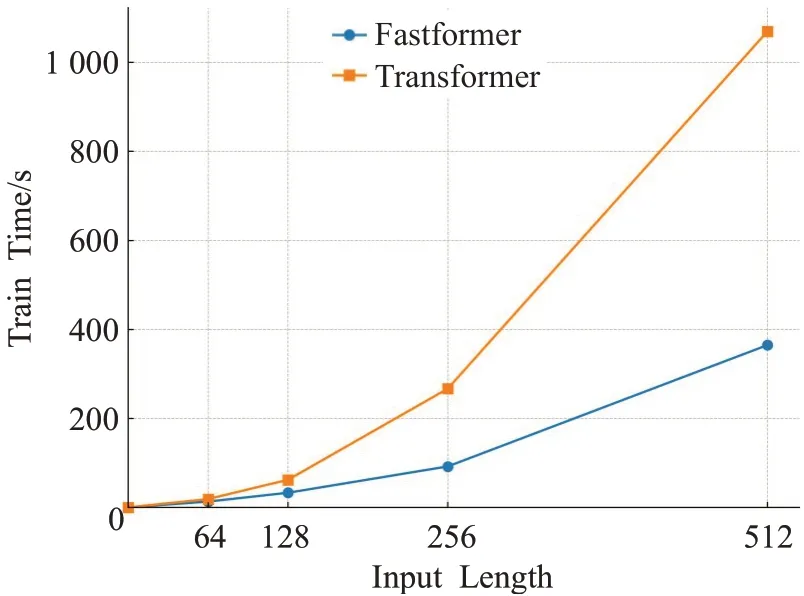

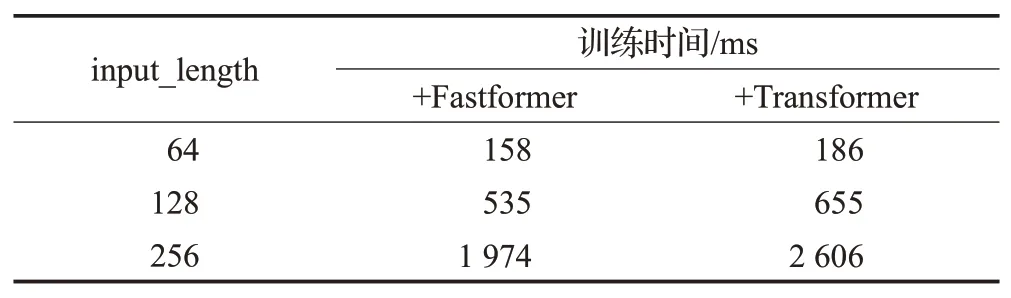

为了验证Fastformer中的加性注意力机制对训练效果的影响,选取当下情感分类模型中主流的自注意力机制Transformer与Fastformer进行对比,实验设计采用两者的注意力机制对数据集进行单独做分类,实验数据共计30 000 条,在设定Batch_size为256,注意力头参数设置为8 的情况下,实验选取Word2vec 中的key_to_index组成一维向量做句子的输入。观察每批次下,不同输入长度时,Transformer 与Fastformer 对训练时间的影响,其实验记录如表8所示。

表8 每批次训练时间Table 8 Training time of each batch

从表8 中可以看出,Fastformer 相较于Transformer有一定的优越性,两者虽然都是随着输入长的增长而变化,在运算时间方面,加性注意力机制始终比自注意力机制能够达到较好的效果。其中,当输入长度为512时,Fastformer 的计算速度仅为Transformer 的1/3,能够大幅度减少训练时间,两者整体的运行时间实验结果如图4所示。

图4 总训练时间Fig.4 Total training time

从图4 中可以看出,在输入长度为64 的情况下,两者训练时间不会有太大差距。然而随着文本输入长度的增长,Transformer 训练时间的曲线斜率开始逐渐增加,并增长到一个较大的范围。相反,Fastformer的曲线斜率处于相对平缓的状态,缓解了由于文本长度增长而出现的训练时间倍增的问题,将此模块融入到BLAT模型中,对于训练效果的提升也是有帮助的,由于模型对于不同的输入长度在实际训练中为提取到更丰富的特征,需要更改网络参数,故本实验将LSTM 网络单元数跟随文本输入长度进行同步变换,并设置为相同个数。观察BLAT模型使用不同的注意力机制在每Batch下的训练时间变化,如表9所示。

表9 BLAT模型每批次训练时间Table 9 Training time of eachbatch of BLAT model

从表9 中可以看出,当输入长度为64、128 时,由于文本长度较短的缘故,整体的计算效率差距不大且较为迅速,但使用加性注意力机制在运算时间上的运算效率相较于Transformer为基础的自注意力机制模型能够分别减少15.1、18.3 个百分点,而当文本长度增长到256时,使用加性注意力机制的模型能够在每一批次计算上减少632 ms,相较于Transformer为基础的BLAT模型能够在运算时间上减少24.2 个百分点。将此模块替换到模型之中,结合本文提出的所提出的摘要提取方法,BLAT 模型能够在面对中长度文本数据时,能够留意到一些关键信息并且提取到较为丰富的文本内容,其训练时间相较于Transformer 为基础的模型能够在大epoch上的训练时间有一定程度上的缩减,因而本文提出的BLAT模型具有较强的泛化能力和一定的优越性。

3.6 实验参数设置对模型训练的影响

由于模型使用了不同的注意力机制和方法,除模型参数设置和注意力机制外,模型的训练效果主要受到摘要提取比例、分词和词向量维度这三点的影响。三者都对模型的训练产生了至关重要的影响,对于模型的最终准确率的影响也较大,下文将进行详细说明。

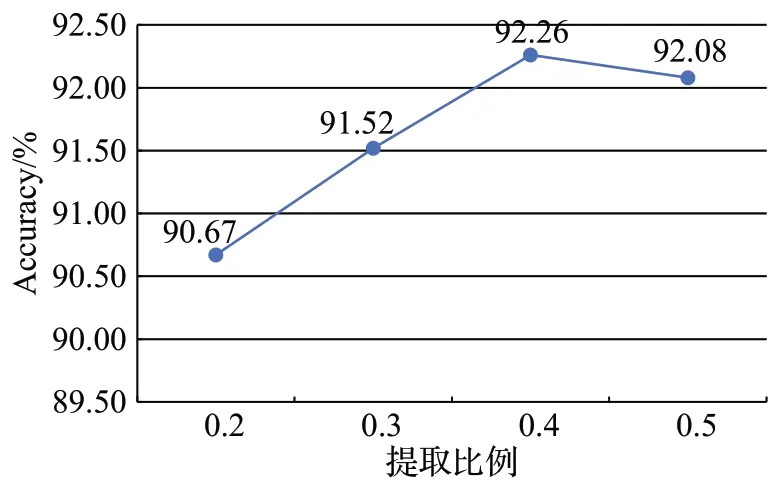

3.6.1 摘要提取比例的影响

摘要提取工作主要分为两部分,一是选择摘要提取权重,二是确定摘要提取比例。由于文本具有顺序性的特点并且词语中生僻词TF-IDF 值会比较高,这些因素对于文本的提取效果都会产生影响,故本模型给予相同的权重。摘要提取的比例不宜过少或过多,过少会只提取到一两句信息,导致后续真正主旨句的缺失,过多则会引入额外的语义特征,导致歧义,给模型验证增加干扰。故本实验设置在相同的摘要提取权重下,验证不同的摘要提取比例对于实验结果的影响,考虑到文本提取比例不宜过低,因此选择的提取比例分别为0.2、0.3、0.4、0.5,这样可以避免提取到的句子过于冗长,并为真正主旨句的提取留有空间。其实验结果如图5所示。

图5 摘要提取比例的影响Fig.5 Effect of abstract extraction ratio

从图5中可以看出,摘要提取的比例对模型训练产生了不可忽视的影响,当提取比例在0.2时,模型的准确率相较于无摘要的方法下降了,这是由于过少的摘要提取比例会丧失真正的主旨句,提取到一些无关紧要的句子,并给模型增加了干扰特征。而随着提取比例的增加到0.4,模型的准确率都是上升的趋势,并达到极大值,伴随着句子提取比例的增加,其提取凝炼出来的文本也变得全面从而引发准确率的上升。而当摘要提取比例为0.5 时,模型的准确率略有下降,过多地提取会使得额外语义信息的引入,因此摘要提取的比例设置0.4 为最佳。

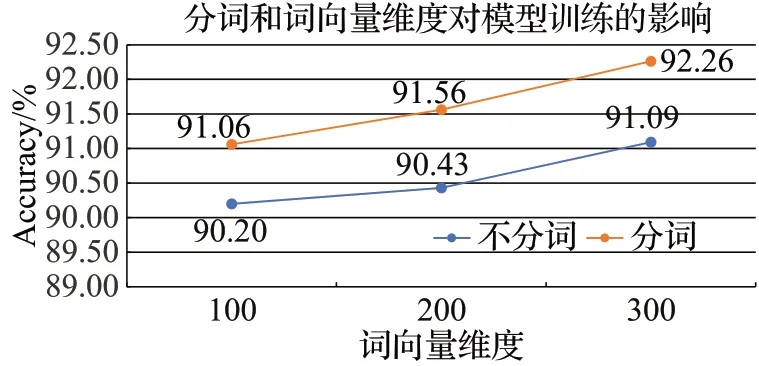

3.6.2 分词和词向量维度的影响

文本的处理方式,可以选择单个字符成句也可以选择词组成句。如果选择词组,则需要对文本进行分词处理,最常用的工具是jieba分词中的精确模式,将文本切分为由名词,动词、形容词等组成的单个词语。此方法相较于单个字符能够提取更加丰富的语义,缺点是比较依赖给定好的的语义,不能解决一词多义的问题。但由于单个字符成句过程中,在实际理解可以通过不同方式的断句,产生不一样的语义,对于动名词的判断常常也难以识别,因而选择分词的方法相较于单个字符成句能够在一定程度上缓解语义缺失的问题。

对于分词完成的句子,则要转化成整体的文本向量,词向量的维度选择也会对模型训练效果产生至关重要的影响,维度过大的词向量在现实应用中对于模型的时间和空间复杂度影响都过高。故本实验选取的维度分别为100、200、300,且为了避免由于自身样本不够全面从而训练产生的误差,选择腾讯AI Lab 中文词嵌入语料库中所训练完备的词向量做对比实验分析,提供的词向量维度分别为100和200。通过验证分词和不同维度的词向量对于模型最终训练效果的影响,实验的结果如图6所示。

图6 BLAT模型的准确率变化Fig.6 Accuracy change of BLAT model

从图6可以看出,预处理方式和词向量维度的选择都会对模型效果产生不可忽略的影响。在分词选择的角度,选择分词的方法在100维、200维、300维的词向量最终的准确率上相较于不分词的方式分别提升了0.86、1.13、1.17 个百分点,通过此方法,能够将句中的大部分动词、名词等关键信息截取出来,形成一个单独的词向量进而组成文本矩阵,相较字符成句既能提取到一些语义的关键信息,又可以通过将字符变为词组的方式缩短整体的输入的长度,从而侧面减少由于截断操作的带来的影响。

在词向量维度方面,模型的训练结果都是随着维度的增加而呈现出递增的趋势,其中在300 维的时候,模型的整体效果达到最好,选择分词和不分词的方法相较于100 维的词嵌入在准确率上分别提升了1.20 和0.89个百分点,相较于200 维的词嵌入分别提升0.7 和0.66个百分点。由此可以推断出,更长的词向量维度,其训练时形成的特征也更加精确,能够帮助提升文本向量在计算机中的表达效果,进而改进模型最终的训练精度。

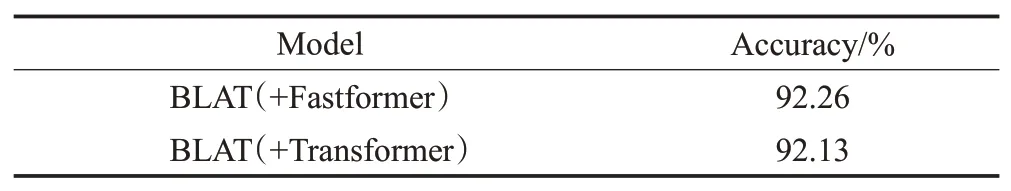

3.6.3 不同注意力机制对模型训练结果的影响

Fastformer 和Transformer 对文本单独做分类的效果已经在表5中有所显示,加性注意力机制显示的效果较好,在准确率上相较于Transformer 能够提升0.54 个百分点,为了验证两者对BLAT 模型训练效果的影响,实验设置BLAT模型使用不同的注意力机制,其实验结果如表10所示。

表10 不同注意力的训练效果Table 10 Training effect of different attention

从表10中可以看出,BLAT模型使用不同注意力的表现相差不大,在准确率上相差0.13个百分点。由此可以推断出,在准确率的提升方面,Fastformer具有一定程度上的优势,但经过神经网络后的特征注入注意力机制后,对于训练结果的影响会被缩小,在网络模型中的作用会回归注意力机制本身,但从整体上来说,使用Fastformer的效果更佳。

4 结束语

本文提出了一种基于文本摘要提取的双路情感分析模型,通过对文本信息进行抽取,与原始的文本形成两路特征作为输入,同时融合了卷积神经网络、循环神经网络与Fastformer三种不同的特征提取方法对情感倾向进行预测。实验结果表明,BLAT 模型具有一定的优越性。

文本的摘要提取有助于提高文本分类的准确率,接下来的主要工作思路是加强对于方面级情感分析领域的研究,通过对文本信息的进一步凝练,总结出更加切合方面级领域的特征摘要,并更换较为前沿的网络模型和词向量模型,验证本文提出思路的有效性。