基于注意力和宽激活密集残差网络的图像超分辨率重建

寇旗旗, 李超, 程德强, 陈亮亮, 马浩辉, 张剑英

(1.中国矿业大学 计算机科学与技术学院,江苏 徐州 221116;2.中国矿业大学 信息与控制工程学院,江苏 徐州 221116)

1 引 言

超分辨率重建(Super-Resolution,SR)旨在对输入的一幅或多幅低分辨率图像(Low-Resolution,LR)进行重建,以得出细节更加丰富的高分辨率图像(High-Resolution,HR)。目前,随着计算机视觉的飞速发展,图像超分辨率重建技术已经广泛应用于夜间高噪图像重建、遥感卫星成像、医学影像分析和雾霾图像重建等领域[1-3]。对于任意的一张低分辨图像,其重建后对应无数个不同的高分辨图像,因此,图像的超分辨率重建是一个典型的病态问题。为解决这个问题,国内外学者提出了基于插值的方法[4-5]、基于重建的方法[6]和基于学习的方法。其中,基于学习的方法是通过学习低分辨率图像和高分辨图像之间的对应关系来获得图像的先验知识,进而预测目标的高分辨率图像。在基于学习的重建任务中,将高分辨率图像使用双三次差值下采样得到相应低分辨率图像,组成用于模型训练的高低分辨率图像对。与传统重建方法相比,基于学习的方法可以得到更好的重建效果,因此受到了众多学者的关注。

近些年来,随着深度学习技术的发展,涌现出大量用于解决超分辨重建问题的网络模型。2015年,Dong[7]等首次将卷积神经网络应用于图像的超分辨率重建,并提出了一种超分辨率重建卷积神经网络(Super-Resolution Convolutional N-eural Network,SRCNN),该网络直接学习从低分辨率图像到高分辨率图像之间的映射关系,是一项开创性的工作。随后,Shi[8]等在SRCNN的基础上对反卷积层上采样操作进行了改进并提出了高效的亚像素卷积层,该层通过重新对特征图进行排列,在减少网络参数的同时,获得了更好的重建效果。然而,上述方法均采用浅层的网络来获取图像的低频特征信息,忽略了深层特征信息对图像纹理细节重建的影响。Kim[9]等通过采用更深的网络结构以及更大的感受野,同时引入了残差网络(ResNet)[10]思想,提出了一种超分辨率重建极深卷积神经网络(Super-Resolution Using Very Deep Convolutional Net-works,VDSR),该网络模型不仅实现了深层特征信息的提取,且残差信息的引入也有效缓解了网络层加深导致的梯度弥散问题,提高了网络的重建性能。但随着网络深度的增加,网络参数量也在剧增,这导致网络难以训练,收敛缓慢。因而Kim[11]等又在深度递归网络(Deeply Recursive Convolutional Network,DRCN)中结合VDSR模型的优点,提出了递归监督的学习策略以减少模型的参数。紧接着,Tai[12]等在深度递归卷积网络(Image Super-Resolution Via Deep Recursive Residual Network,DRRN)中提出了递归残差块来实现权重共享,以此进一步降低网络参数量。Lim[13]等通过去除批量归一化(Batch Normalization,BN)来改进残差块,提出了一种增强型深度超分辨率网络(Enhanced Deep Residual Networks for Single Image Super-Resolution,EDSR),重建效果得到了显著的提升。Hui[14]等研究发现网络深度也是影响超分辨率重建速度的重要因素,因此提出了轻量化的多蒸馏网络(Lightweight Image Super-Resolution with Infor-ma-tion Multi-Distillation network,IMDN)用来提升网络的重建速度,为超分辨率重建的轻量化开启一个新思路。与Hui等思路不同,Luo[15]等通过提出双支路特征提取模块和反向级联融合策略来降低计算复杂度和内存需求,然而此方法的性能提升却并不明显。Tong[16]等设计了一种密集连接的网络以促进图像特征的信息流通,从而提出了密集跳跃连接超分辨率网络(Image Super-Resolution Using Dense Skip Connections,SRDe-nseNet)。此后,Zhang[17]等通过将残差连接和密集连接进行融合,进一步提升了LR图像的超分重建效果。2018年,Zhang[18]等通过设计一种通道注意力模块(Channel Attention,CA)来对不同通道的特征重新进行加权分配以增强网络的辨别学习能力,提出了基于残差注意力的超分辨率重建网络(Image Super-Resolution Using Very Deep Residual Channel Attention Networks,RCAN),注意力机制的引入使得其重建效果相比其他SR方法得到了显著的提升。随后,Dai[19]等对RCAN中的通道注意力进行改进,提出了基于二阶统计的注意力机制,并第一次将非局部注意力[20]引入超分辨率重建任务中。2021年,Chen[21]等从底层研究注意力机制对超分辨率重建的作用,并提出了一种注意力嵌套图像超分辨率重建网络(Attention in Attention for Image S-uper-Resolution,A2N)。鉴于注意力机制优异的特征表达能力,研究人员开始在SR任务中引入各种注意力机制来提高网络的重建性能。此外,Ledig[22]等利用感知损失和对抗损失来实现低分辨图像的超分辨重建,并提出了一种超分辨率生成对抗网络模型(Super-Resolution Generative Adversial Network,SRGAN),也取得了良好的图像重建效果。

虽然上述图像超分辨率重建网络取得了较好的重建效果,但大部分网络模型没有充分利用低分辨率图像的全局和局部信息,存在特征图太少可能导致重要信息丢失的问题。目前,虽然也有少量网络模型综合考虑了该问题,如Yu[23]等提出了一种宽激活深度残差网络(Wide Act-ivation for Efficient and Accurate Image Super-resolution,WDSR)用于图像超分辨率重建,该网络在尽量不增加参数量的前提下,通过扩大残差块内激活函数前的特征通道数实现了深层次高频信息的提取。然而,该方法虽然提取到不同的深层特征信息,但是仍然存在特征复用和利用率较低的问题。

为了解决以上问题,本文提出了一种基于注意力和宽激活密集残差网络的图像超分辨率重建模型(Image Super Resolution Reconstruction Based on Attention and Wide-Activated Dense Residual Network,WDRN)。针对低分辨率图像浅层特征信息利用不足的问题,在浅层特征提取模块,采用4个不同尺度且平行的卷积核提取低分辨率图像的局部和全局信息,作为空间转换的先验信息,通过获取多层次的感受野来丰富底层关键特征的多样性,提高重建性能。为保留低分辨率图像的空间信息,通过引入空间特征转换层,将多尺度浅层特征作为该层的先验信息来引导高频特征的提取,从而为图像的重建增添更加深层次的纹理信息。为了获取丰富多样的高频特征信息,对激活函数前的特征通道数进行了扩大以获取多通道高频信息。构造全局和局部残差连接以加强残差块和网络特征前向传播,使网络在不增加参数的情况下提取多样性更加丰富的特征。在深层特征映射模块,在宽激活残差块中融入轻量级注意力机制,对高频区域信息分配更多权重,使模型的重建结果更清晰的同时仍维持较低的参数量水平。

2 原 理

2.1 网络结构

本文提出融合注意力的宽激活密集残差网络模型的整体结构如图1所示。该网络模型有3个子模块:(1)多尺度浅层特征提取模块,不同尺度的卷积可以充分提取低分辨率图像全局和局部的信息,该模块提取的信息一方面作为深层特征映射模块的输入,另一方面作为空间特征转换层的先验信息来引导图像的重建;(2)深层特征映射模块,用于提取图像高频特征以及对特征重复利用,该模块由融合注意力机制的宽激活残差块(Wide Activation Residual Block,WARB)密集连接形成的密集残差组(Wide Activation Residual Block Group,WARBG)构成,空间特征转换层在密集残差组的前面,用于转换特征图的中间特征;(3)上采样重建模块,该模块主要由亚像素卷积层和一个3×3卷积层组成,用于重建出最终的高分辨率图像。

图1 融合注意力的宽激活密集残差网络结构Fig.1 Structure of attention and wide-activated dense residual network

2.2 多尺度浅层特征提取模块

受到Szegedy[24]等提出的拓展网络宽度思想的启发,WDRN中多尺度浅层特征提取模块使用4个不同尺寸且平行的卷积核对LR图像进行卷积操作,4个卷积核的大小分别为1×1,3×3,5×5,7×7。小尺寸的1×1和3×3卷积核可以学习得到LR图像的局部特征,5×5和7×7的较大卷积核在对LR图像进行特征提取时能获得大感受野的特征图。为获得更佳的特征映射效果,将每个卷积核输出64个特征图后进行多尺度特征级联的融合操作,进而为空间特征提取模块提供丰富的先验信息。然后,再将该先验信息融入深层特征映射模块,使低分辨率图像的信息得以充分利用,从而提高重建效果。多尺度浅层特征提取过程表示如下:

其中:FSFE,n×n(·)表示分别用n为1,3,5,7的卷积核对低分辨率图像进行浅层特征卷积处理,f0表示将获得的多尺度特征图经过concat后把通道数降为64的操作。

2.3 深层特征映射模块

2.3.1 注意力机制

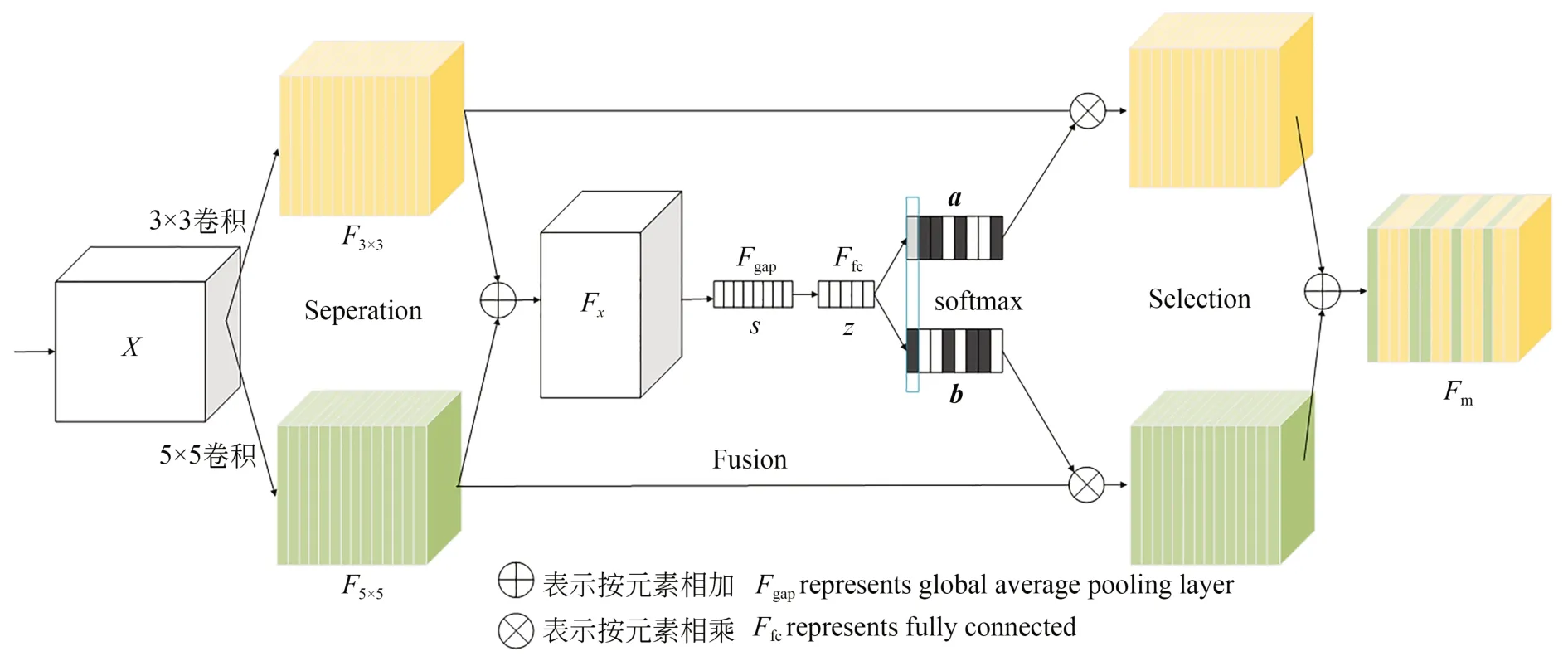

人类视觉感知系统会有选择地聚焦于全局信息中较为显著的部分,同时忽略其他不重要的信息。而计算机视觉中的注意力机制与人类视觉感知相似,会从不同角度或在不同程度上重新为网络所提取的信息加以区分。文献[19]提出的二阶通道注意力机制是对RCAN中通道注意力机制的改进,但两者仅通过调整通道特征来获得对于信息的区别性表示,忽略了空间特征注意力信息的表示。文献[20]中的非局部注意力模块由于只涉及特征图位置信息而缺乏对于特征图通道的注意力,且其矩阵乘操作计算量较大,因此在网络模型中并不适合多次使用该注意力机制模块。综上,本文在深层特征映射部分采用轻量级注意力模块[25],选择性内核网络(Selective Kernel Networks,SKNet),该模块可以根据不同尺度的输入信息自适应地选择合适的卷积核来关注某些特征信息,并且经过分离、融合以及选择操作后拥有对于通道和空间信息加以区分的能力,因而更适用于在超分辨率重建任务中捕捉图像的高频信息,该模块的具体结构如图2所示。

图2 SKNet注意力机制Fig.2 SKNet attention mechanism

在分离操作阶段,对输入的初始特征图X分别使用3×3和5×5的两种卷积核进行卷积操作,得到两个输出F3×3和F5×5。其次,通过融合操作将此两部分的特征图按元素相加的方式融合,得到新的特征图Fx:

为获得特征图的注意力信息,特征图Fx依次经过全局平均池层、先升维再降维的全连接层,得到一个紧凑的特征向量:

其中:Fgap表示全局平均池化层(global average po-oling,gap),Ffc表示全连接层(fully connected,fc)。

最后,在选择操作阶段首先将特征向量Z重新分为a和b两个特征向量,两者为互补关系,然后再分别与F3×3和F5×5进行相应通道的加权操作,进而求和得到最终的输出向量Fm,即:

其中:A,B分别表示由不同的全连接矩阵进行特征维度转化后的结果,ac和bc表示输出特征向量a和b的第c个元素。最终的特征映射Fm是通过各种卷积核的注意力权重获得的。

2.3.2 融合注意力的宽激活残差块

在本文中每个融合注意力的WARB包括2个卷积核为1的卷积层,1个卷积核为3的卷积层与1个SK注意力模块。WARB[23]首先在ReLU激活层前通过1×1卷积的方式扩展通道数来获得更多特征图,利用多个通道数增大信息提取的能力,从而避免单一通道数造成高频有效信息丢失的问题。然后,在ReLU激活层后分别又用卷积核大小为1和卷积核大小为3的低秩卷积核替换一个大的卷积核,以此降低其计算开销。因此,WARB不仅有着强大的特征表达能力,且将参数量也维持在较低水平。鉴于该宽激活残差块的优异特性,为了给网络提取的高频信息自适应地分配更多的注意力,以得到更加丰富的高频特征,本文提出在WARB中融入轻量级的SK注意力模块,并将该融合结果作为提取深层特征信息的基本单元模块,具体流程如图1所示。由于简单地堆叠残差块不利于特征信息的传递,因此将每一个残差块提取的特征都输送给后面的残差块中来构建一个WARBG,从而促进特征信息的有效传递。

2.3.3 空间特征转换层

为获取更加丰富的深层次图像空间信息,本文采用空间特征转换层(Spatial Feature Transform Layer,SFT)[26]来对同一个特征图的不同位置进行差异化处理。该空间特征转换层通过生成仿射变换参数来实现空间特征的调制,并且可以与超分辨率重建主干网络结合在一起,使用相同的损失函数进行端到端的训练,其结构如图1所示。空间特征变换层包含两个输入,分别是前一个密集残差组的输出特征和浅层特征提取模块中条件共享的先验信息L0。通过对进行变换得到新的输出并将它作为下一个密集残差组的输入。浅层先验信息L0分别送入到由两个1×1的卷积层组成的卷积块,通过学习得到参数对γi和βi,然后再据此对深层特征映射模块网络中的每个中间特征图进行仿射变换,从而实现自适应输出。相比没有空间特征变换的网络,此模块有助于网络重建出纹理更加清晰、边缘轮廓更为明显的图像。

2.4 上采样重建模块

上采样重建模块包括亚像素卷积和一个3×3的卷积层,亚像素卷积旨在对特征图进行上采样放大,再通过最后的卷积层得到通道数为3的高分辨率重建结果,其输出如下:

其中:fup表示由上采样重建模块组成的函数,P0表示深层特征模块和浅层特征融合后的输出,ISR表示最终的重建结果。

3 实验结果及分析

3.1 数据集和实验设置

在实验训练阶段,采用DIV2K公共标准数据集作为本文的训练数据集,该数据集共包含1 000张样本图像,其中每幅图像都包含非常清晰的细节纹理信息,非常适合作为自然图像超分辨率重建的训练数据。在测试和分析阶段,为测试和验证本文所提WDRN网络性能的优越性,选取Set5,Set14[27],BSD100[28],Urban100[29]4个公共标准数据集作为基准测试集来进行测验和分析。

本实验训练测试的实验硬件环境为: Intel(R) Core(TM) i9-10980XE CPU@ 3.00GHz,18核36线程;系统内存为64 GB;GPU为NVIDIA RTX 3090,24 GB显存容量;软件环境为Ubuntu20.04操作系统。

将L1函数作为损失函数来优化重建后的高分辨率图像与真实高分辨率图像之间的差值,从而进一步优化网络,可以表示为:

其中:θ表示网络需要学习的参数集表示原始的高分辨率图像表示利用本文所提WDRN网络重建后的高分辨率图像。模型在训练阶段使用Adam算法优化网络参数,共训练300个训练周期(Epoch),初始学习率为1×10-4,训练200个Epoch后的学习率衰减为0.5×10-4。

3.2 消融实验结果与分析

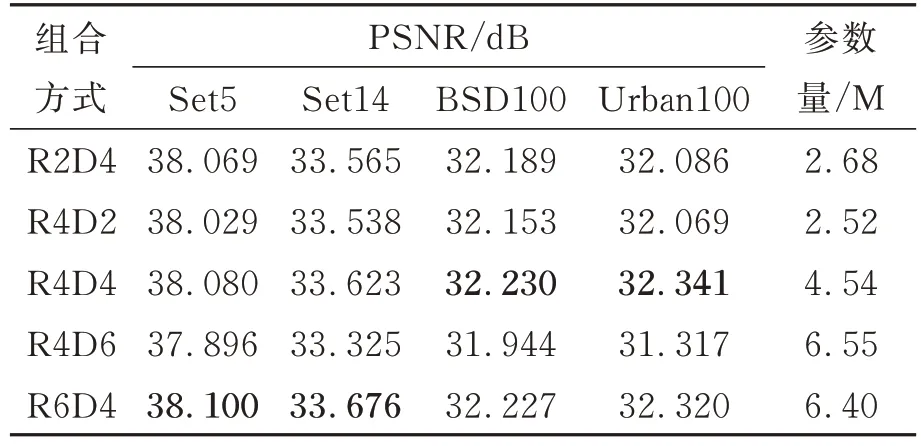

3.2.1 密集残差组数和残差块的消融实验

为了测试和验证不同数目的残差组(D)和残差块(R)组合方式对所提出的WDRN网络重建性能的影响,并选取最有效的组合方式,具体测试结果如表1所示。从表1可以看出,随着残差组数目以及残差组中残差块数目的增加,各个测试集的PSNR指标都有所提升。当模型规模大于R4D4时,参数量增加、训练时间延长,性能提高不明显。由实验结果可知,R6D4的模型在Set5和Set14的测试集上分别提高了0.02 dB和0.053 dB,一方面是由于DIV2K训练集与Set5和Set14测试集中的图片类型比较一致,另一方面是由于Set5,Set14是基于非负领域嵌入的低复杂度单图像的测试集,而在包含高复杂度图像的BSD100和Urban100测试集上性能提升不明显,然而R6D4的模型参数量却比R4D4的模型参数量高40.97%。因此,在综合考虑算法性能、网络参数量因素后,本文最终采用R4D4的组合方式。

表1 残差组数量(D)和残差块数量(R)对2倍超分辨率重建性能的影响PSNRTab.1 Effect of number of residual groups (D) and number of residual blocks(R) on performance of 2×super-resolution reconstruction

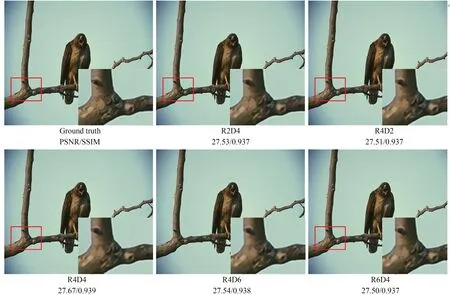

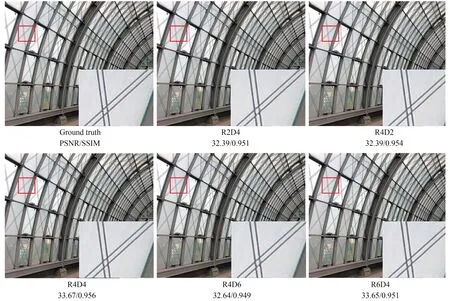

为进一步证明R4D4组合方式的优越性,选取BSD100数据集的42 049图像和Urban100数据集的img002图像在不同组合方式下进行重建图像的可视化对比,如图3和图4所示。各组合方式的PSNR和SSIM值如图下方数字所示。在主观视觉上,采用R4D4组合方式重建后的图像相比其他组合方式,在图3中树杈阴影部分的处理更为明亮清晰,在图4中建筑物线条交汇处的像素分辨能力最强。

图3 不同组合方式在BSD100_42049上的重建效果对比Fig.3 Comparison of reconstruction effect of different combination methods on BSD100_42049

图4 不同组合方式在Urban100_img002上的重建效果对比Fig.4 Comparison of reconstruction effects of different combinations on Urban100_img002

3.2.2 不同通道倍数的消融实验

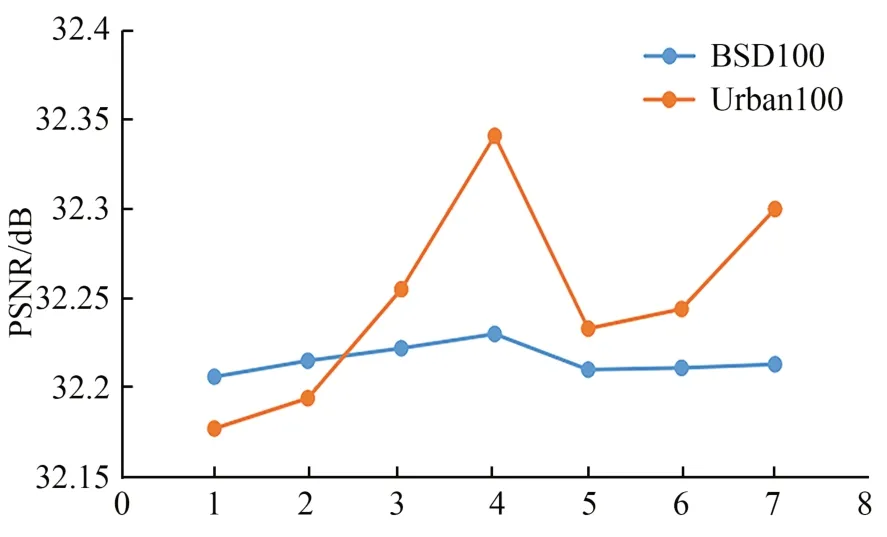

本文针对WARB内激活函数前放大不同倍数(用k表示)的特征通道数也进行了有效性研究。在R4D4模型的基础上,分别采用不同扩大倍数对网络进行训练,实验结果如图5所示。由折线图的趋势不难看出,在BSD100和Urban100测试集上扩大倍数小于4时的网络性能随着k值的增大而提高,当扩大倍数为4时两个测试集的性能均达到最佳;k值继续增大后,在BSD100测试集上性能表现趋于平缓,但是在图像纹理细节更加丰富的Urban100测试集的性能则呈现先下降后升高的现象,表明此时的网络已经出现了过拟合现象,且对应的计算量和参数量也随之增大。因此,将通道数扩大为原来的4倍可以达到最佳状态。

图5 不同通道倍数下4倍超分辨率的PSNRFig.5 PSNR with 4× super-resolution at different channel multiples

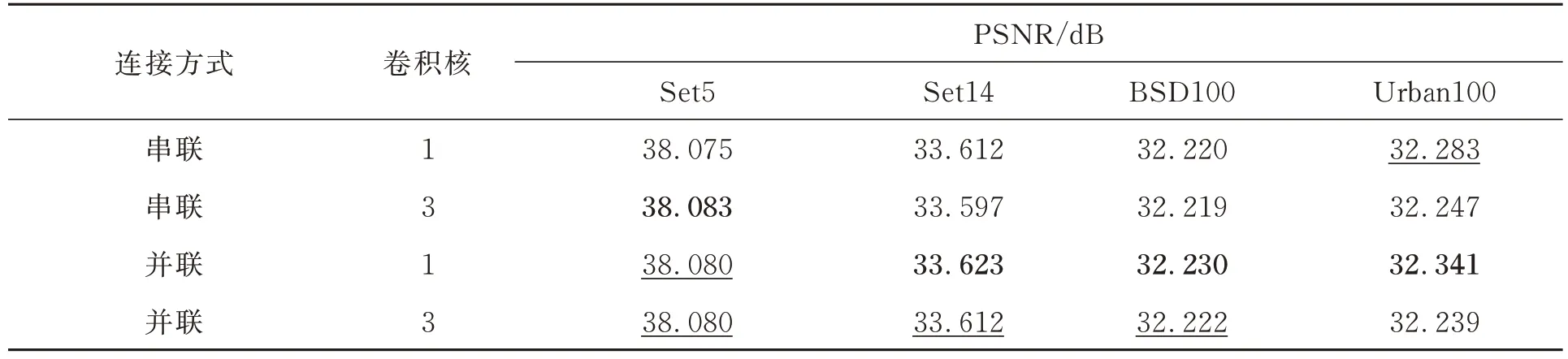

3.2.3 空间特征转换层的消融实验

网络结构的微小改动往往会导致结果有较大的提升,这里针对SFT采用不同连接方式及不同大小卷积核进行了有效性验证。图1中,将共享的低分辨率特征信息送入两个1×1并联的卷积层学习以得到一对调制参数。通过将卷积层的并联替换成串联的方式,并探讨不同尺度卷积核对性能的影响,其测试结果如表2所示。由表2可以看出,在空间特征转换层的连接方式上,同一卷积核大小的情况下,除了在Set5测试集上卷积层并联的效果稍逊于串联形式,在Set14,BSD100和Urban100测试集上的效果均明显优于串联的连接方式。在卷积核尺寸选择上,串联情况下,卷积核的增大除了在Set5测试集上提高了0.008 dB之外,在其他测试集上均有所下降;并联情况下的性能对比则更为明显,卷积核为1×1比3×3的PSNR平均高出0.03 dB。从实验结果不难看出,SFT中两个卷积层的并联组合效果要优于串联的效果,并且卷积核的增大对性能的提升作用并不明显。因此,选用1×1的卷积核效果更好。

表2 空间特征转换层卷积核尺寸及连接方式对2倍超分辨率重建性能的影响Tab.2 Effect of convolution kernel size and connection mode of spatial feature transformation layer on performance of 2×super resolution reconstruction

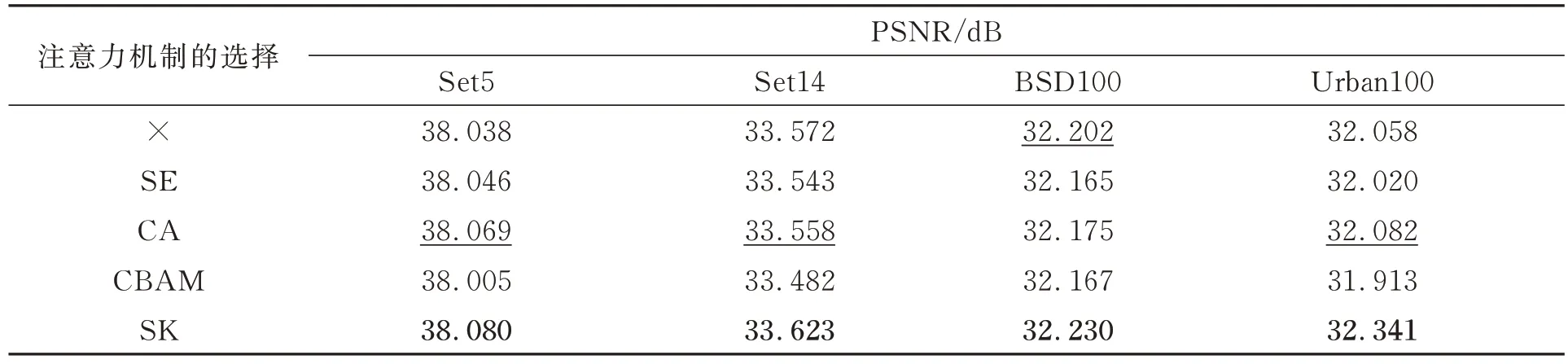

3.2.4 注意力机制的消融实验

为了进一步说明采用选择性注意力机制的有效性和优越性,将它与现有的经典注意力机制进行比较。实验结果如表3所示,相较于没有加入注意力机制的情况,网络在4个测试集上的PSNR指标分别提升了0.042,0.051,0.028,0.283 dB,充分证明了网络融合注意力机制的有效性。加入SK注意力相比于加入SE,CA,CBAM等经典注意力机制,网络性能提升更为明显,证明了网络中融合SK注意力机制的优越性。

表3 注意力机制对2倍超分辨率重建性能的影响Tab.3 Effects of attention mechanisms on 2× super-resolution reconstruction performance

3.3 算法先进性验证

本文算法训练300个迭代周期(Epoch),网络在不同放大倍数下的收敛曲线如图6所示。

图6 不同倍数下的损失函数曲线Fig.6 Loss function curves at different magnifications

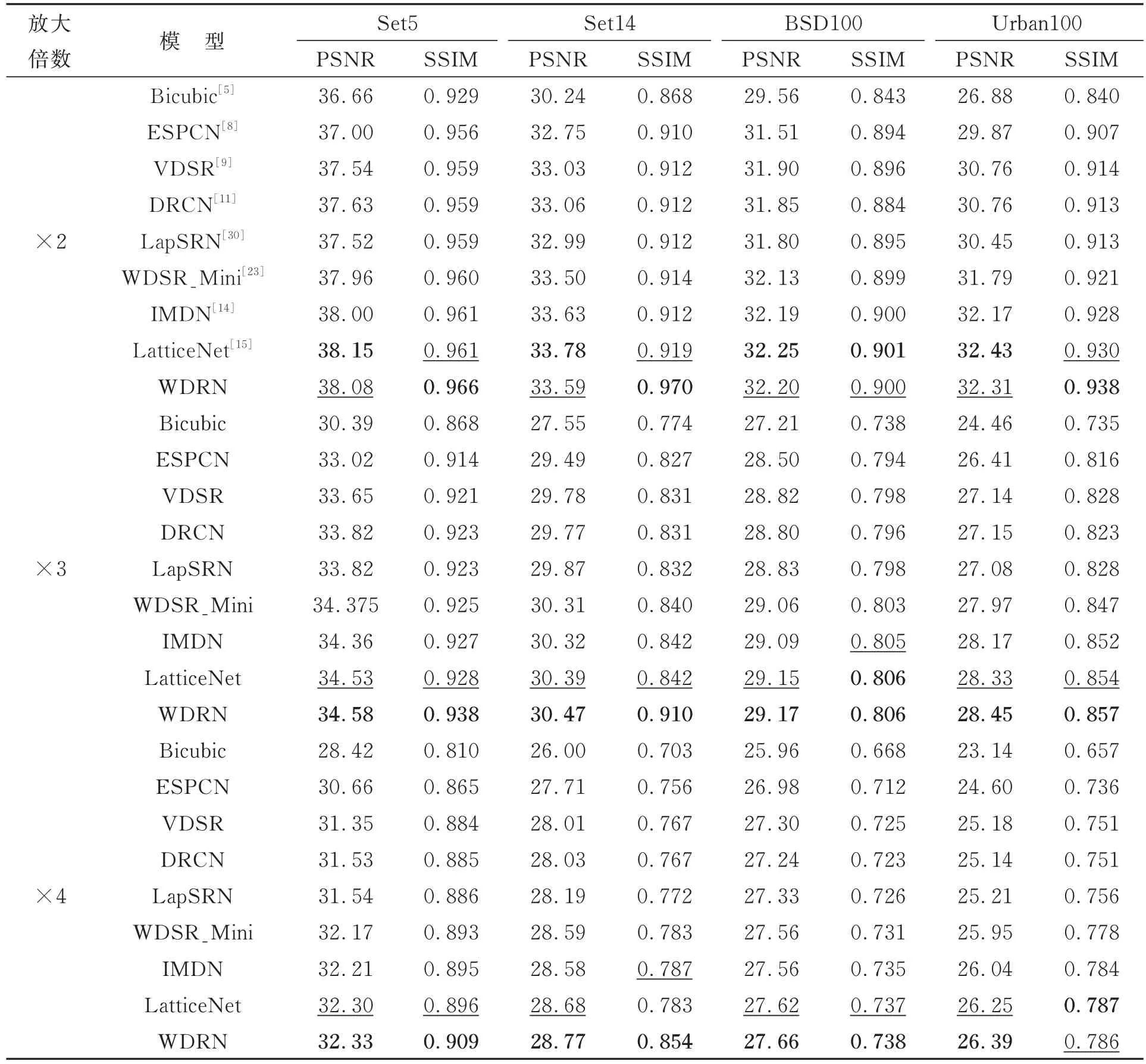

为了进一步验证WDRN模型的有效性,将它与Bicubic,ESPCN[8],VDSR[9],DRCN[11],LapSRN[30],WDSR_Mini[23],IMDN[14]和LatticeNet[15]8种主流算法,在Set5,Set14,BSD100以及Urban100测试集及不同放大倍数下(×2,×3,×4)的超分辨率重建结果分别进行客观评价和主观评价,对比结果如表4所示。

表4 放大倍数为2,3,4时在基准数据集上的重建结果比较Tab.4 Reconstruction comparison on baseline dataset at magnifications of 2, 3 and 4(dB)

从表4可以看出,WDRN网络在3种放大倍数下的超分辨率重建结果均明显优于Bicubic,ESPCN,VDSR,DRCN,LapSRN,WDSR_Mini,IMDN及LatticeNet网络。此外,WDRN采用的是由16个残差块构成的密集残差网络模型,通过在各个测试集上对不同放大倍数的重建结果进行测试和对比分析,实验结果表明,本文模型在PSNR和SSIM指标上均优于同为16个残差块构成的WDSR_Mini模型。与LatticeNet网络相比,虽然在放大倍数为2时本文模型的重建性能在客观指标PSNR上略低于该网络,在SSIM指标上却优于LatticeNet,表明本文算法重建出的2倍图像在结构细节方面保持得较好,这主要得益于本文模型采用空间特征转换层来获取低分辨率图像空间结构信息的原因。此外,WDRN网络在3倍和4倍时的超分辨率重建性能的提升则更加显著。尤其是在放大倍数为4时,本文的WDRN网络在Set5,Set14,BSD100数据集上的PSNR和SSIM与IMDN和LatticeNet相比,分别平均提高了0.137 dB,0.0215和0.075 dB,0.021。值得注意的是,在主要由城市建筑物规则图案组成的纹理特征复杂的Urban100数据集上,WDRN网络在PSNR指标上也相较LatticeNet提升了0.14 dB。结果表明,本文所提算法在图像超分辨率重建效果方面均优于其他对比算法。

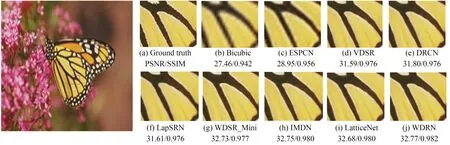

由于放大倍数越大,重建出的图像边缘就会越模糊,因此为了进一步表明本文算法重建结果的相对优越性,本文着重展示了不同重建方法在放大4倍时的视觉效果图,如图7~图10所示。首先,从较小数据集方面分析重建结果,图7是不同方法对Set5数据集中的baby图像重建后的结果。从该结果可以观察到,当图像中有细小的条纹时,Bicubic,ESPCN,VDSR,WDSR_Mini等模型重建后的眼睫毛线条仍有少许的伪影,与IMDN,LatticeNet模型相比,本文的WDRN模型有效缓解了伪影问题。图8是不同方法对Set14数据集中monarch图像重建后的结果,从图中可以看出,Bicubic,ESPCN重建后的图像较为模糊,而WDSR_Mini重建后的图像缺失原图像边缘轮廓微小的变化,IMDN和LatticeNet得到了相对清晰的重建结果,但与原图和WDRN方法重建后的图像相比,上述方法表现得过于平滑,致使在纹理细节方面存在丢失的现象。

图7 不同方法在Set5_baby上的重建效果对比Fig. 7 Comparison of reconstruction effects by different methods on Set5_baby

图8 不同方法在Set14_ monarch上的重建效果对比Fig.8 Comparison of reconstruction effects by different methods on Set14_ monarch

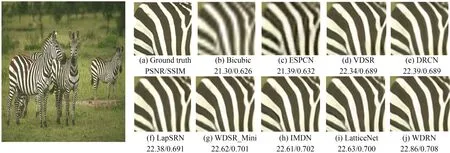

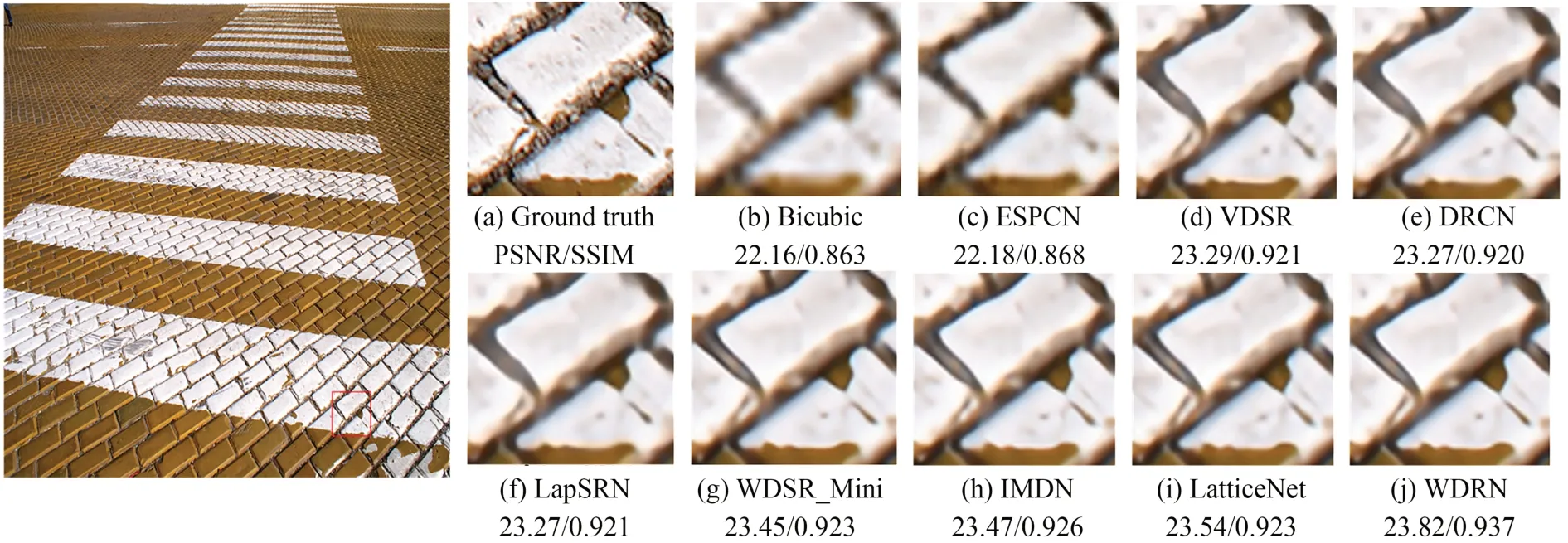

图9和图10是在较大数据集上各种方法的重建结果对比,其中图9是对BSD100数据集中编号为253027的斑马图像的重建结果。从图中可以看出,Bicubic,ESPCN重建后的纹理信息非常模糊,主观视觉上表现也最差,WDSR_Mini模型重建后的图像整体相较原图像过于明亮并且边缘稍显模糊,IMDN重建后的图像在整体上有轻微的颜色失真,LatticeNet模型的重建结果则存在过曝光问题,而本文重建出的斑马图像身上的线条轮廓更为明显,整体也最为真实。图10中的原始图像选自图像细节丰富且重建难度较大的Urban100数据集,从编号为img091红框内地面砖块部分可以看出,本文算法明显改善了Bicubic,ESPCN两种方法在重建时出现锯齿状效应严重的问题。相比于VDSR,DRCN,LapSRN,WDSR_Mini算法重建后均出现边缘细节模糊的现象,本文算法的重建效果也得到了明显的提升。此外,相比于IMDN,LatticeNet算法存在重建后图像过于平滑的现象,本文算法重建后的图像效果在主观上也更加接近原图。因此,WDRN网络模型无论是在主观评价上还是客观评价上均明显优于现有的主流图像超分辨率重建方法。

图9 不同方法在BSD100_253027上的重建效果对比Fig.9 Comparison of reconstruction effects by different methods on BSD100_253027

图10 不同方法在Urban100_img091上的重建效果对比Fig.10 Comparison of reconstruction effects by different methods on Urban100_img091

4 结 论

本文提出了一种基于注意力和宽激活密集残差网络的图像超分辨率重建模型,通过将图像的多尺度浅层局部特征和全局特征作为空间特征转换层的先验信息用以引导深层高频特征的提取,使得图像的空间信息一直作用于整个特征提取过程。然后,将轻量级注意力机制融入到宽激活残差块中,在不增加网络参数量的情况下尽量扩大特征图数目,对高频信息自适应地分配更多的注意力,从而获得了更加丰富的高频细节特征信息。实验结果表明,本文所提方法在Urban100数据集上4倍超分辨率时,相比于LatticeNet模型PSNR指标提升了0.14 dB,并且模型参数量维持在较低水平,重建后的图像在主观视觉感受上边缘轮廓也更为清晰,纹理细节信息更加丰富。