航天员混合现实训练与支持技术研究

晁建刚, 许振瑛, 何 宁, 孙庆伟, 魏源宏, 胡帅星

(1.中国航天员科研训练中心人因工程重点实验室, 北京 100094;2.航天工程大学宇航科学与技术系, 北京 101416)

1 引言

空间站任务中,航天员面临更加复杂的在轨维护维修、科学实验以及应急模式预案外的紧急排故等技能操作,不但对航天员的操作技能、协作技能提出了新的要求,更对复杂任务模式下的航天员支持保障手段提出了新的挑战。传统模式下航天员通过地面实物、半实物和数字仿真综合构建的模拟器进行技能训练,存在以下不足: ①空间失重模式下交互操作以及复杂典型故障等模拟程度有限或者难以在地面模拟; ②复杂任务的操作通常通过手动查看文字图片手册来进行,理解容易有歧义且无法高效工作; ③远程天地支持通常通过语音和有限实时视频图像进行,支持中的语义理解受到限制。

混合现实(Mixed Reality,MR)技术是通过在现实环境中引入虚拟对象/场景信息,在现实世界、虚拟世界和用户之间建起一个交互反馈的信息回路,以扩展增强用户体验信息范围,具有真实性、实时互动性以及构想性等特点[1]。其物理实体和虚拟数字对象满足真实的三维几何投影关系,用户视觉感知的混合场景空间结构、色彩纹理、亮度等虚实保持一致。根据真实场景视觉图像特征,借助IMU(Inertial Measurement Unit)等多传感器融合手段,能够实时高速地进行位姿估计与建 图(Simultaneous Localization and Mapping,SLAM);能够智能感知记忆物理场景,并输出运动估计位姿,用于真实场景中虚拟对象的实时融合渲染;能够根据扫描物理世界场景的Mesh 地图进行空间检测、多人协同共享定位或远程支持的虚拟场景匹配[2-3]。基于MR 技术的上述特点,在航天员训练和支持中,借助目前已有的实物、半实物模拟器环境,可以实现工程半实物难以模拟的典型设备操作和故障排除,实现地面难以模拟的失重运动操作,实现复杂设备智能虚拟辅助指导或智能定点定位引导操作,实现天地远程支持模式下三维沉浸式指导标注。

近年来,NASA 一直致力于MR 技术在太空探索中的应用。2015 年,NASA 实施了OnSight 项目,利用微软HoloLens MR 头盔将火星的地表在操作台附近地面虚拟渲染三维投射出来,佩戴MR 眼镜的多名工程师协同进行火星车任务的验证和规划讨论,多人协同定位基于头盔视觉生成Mesh 空间匹配[4]。针对国际空间站航天员复杂操作辅助诱导支持以及与地面支持人员远程协同,NASA 陆续在国际空间站测试Sidekick 项目,用于航天员执行复杂任务的辅助信息自主导引,同时通过Skyper 软件于地面指导航天员在轨工作。针对空间失重特因环境下的空间定位,NASA对HoloLens 头盔采用的VIO(Visual SLAM+IMU Odometry)6 自由度位姿估计模式进行了在轨适应性改造,并在失重飞机上进行了试验[5]。

中国空间技术研究院采用成熟的商业MR 设备在地面实现了嫦娥任务的月表场景投影,用于模拟沙盘的重建。中科院采用MR 实现了空间载荷设备操作的虚拟导引,其在轨位姿估计采用了三维对象目标匹配方法等。李畅等[6]、孙庆伟等[7]在MR 训练支持、场景理解、空间重建、位姿估计以及场景匹配上做了工程试验积累,但未形成应用实例。

为适应空间站航天员典型训练和支持任务动态变化需求,本文设计并实现了便于快速配置和扩展研发的航天员混合现实训练与支持系统的技术框架,针对训练和支持的特因环境,研究实现空间弱纹理以及失重模式下的纯视觉位姿估计算法;针对训练中的多人协同以及天地远程支持,解决对象操作同步、Mesh Anchor 虚实空间匹配、天地虚拟场景虚虚匹配等关键技术,为当前工程任务完成提供支持途径。

2 方法

2.1 设计目标

航天员混合现实训练聚焦地面训练和在轨支持2 种模式。地面训练模式主要在目前已有实物、半实物模拟器基础上,通过MR 头盔实时渲染生成的三维标注信息对复杂设备操作进行虚拟导引,提高航天员操作效率与准确性;模拟损伤性火灾场景等典型性故障,用于航天员应急处置;模拟失重模式下设备操作状态,用于航天员熟悉在轨作业状态;用虚拟模式补充模拟舱内工程实物、半实物实现难度大的设备,构建真实的在轨空间环境。在轨支持模式除复杂设备操作自主导引外,重点实现天地协同定点定位的三维协同支持。航天员佩戴MR 头盔,实时下传操作场景,地面根据下传图像建立Mesh 空间与预先虚拟场景进行虚虚匹配,在与空间一致的相对坐标位置进行虚拟信息的实时设置,上传虚实叠加导引,指导航天员定点定位操作。

2.2 设计约束

面向建立长期支持航天员地面训练与在轨支持的混合现实系统,要考虑混合现实使用物理场景的特殊性。设计约束有4 方面: ①建立的工程实施体系架构要同时满足地面和在轨支持需要,且根据任务快速开发与更动; ②无论地面训练用航天器模拟座舱还是真实的在轨航天器,视觉定位的场景纹理特征相对比较单一,属于弱纹理,选取健壮的特征点以及建立描述子满足精准位姿估计需要; ③在轨失重模式下,基于比力传感模式的MEMS(Micro-Electro-Mechanical System) IMU的加速度计无法正常工作,VIO 紧耦合模式定位紊乱,需要采用纯视觉模式进行位姿高速估计,同时兼顾头盔有限算力支持; ④多人协同及远程支持模式下,基准锚点(Ancho)如何精准匹配保证虚拟对象定位多人视觉感知位姿一致,远程支持模式下上传虚拟信息三维投射需要与在轨空间拟定叠加对象几何匹配一致[8]。其中,第一个约束属于体系架构设计问题,后3 个约束属于算法解决的关键技术。

2.3 体系框架

目前通用的混合现实开发体系架构通常面向单项任务,依据航天员地面和在轨训练需求,本文设计了面向多人协同以及远程支持的混合现实训练与支持技术框架,如图1 所示。

图1 体系框架设计Fig.1 Framework of the system

在基于MRTK(Mixed Reality Toolkit)开发体系架构基础上,采用MVC(Model-View-Controller)模式实现了航天员混合现实虚实融合交互操作中的数据、逻辑与显示界面分离,通过配置实现交互驱动、仿真及逻辑计算、对象空间显示等解析处理,在减少代码开发的同时,提高训练和支持科目的快速定制;系统基于OpenXR 接口机制,适应Windows、Android 等操作系统交互开发包的定制;基于NetCode for GameObject 对象状态网络分发机制实现多个训练终端之间的协同操作,剔除需要中间服务器中转信息的传统冗余模式;系统在统一Anchor 共享机制基础上,实现了航天员单人/多人协同操作、专家与航天员远程MR 三维标注支持。架构模式编译的应用软件可以按需进行笔记本的Windows 操作系统、平板电脑和手机的Android 操作系统、以及其他VR(Virtual Reality)头显等设备的部署生成,适应未来多终端模式便携使用以及与MR 终端协同使用。

MR 终端开发应用场景一般是在模拟器座舱内,首先,通过头盔鱼眼相机捕获周围视觉环境计算位姿,同步进行座舱环境的三维立体地图稀疏重建,用于虚实融合定位、虚拟碰撞检测、虚拟运动渲染和协同定位;其次,根据训练操作程序、预定脚本以及实体对象仿真,实时渲染生成三维虚拟对象或者引导标注信息,通过光波导系统三维立体投射叠加到实体场景中的操作实物对象上;最后,通过TOF 相机识别用户交互手势、通过头盔内嵌语音系统识别用户语音指令等,从而实现场景中的自然人机虚拟交互操作,形成人在MR回路中的按照虚拟引导的信息在实体环境中进行虚实融合操作,完成预定的模拟训练任务或者操作支持任务。协同或者远程支持在此基础上构建同一虚拟匹配空间场景,在MR 空间协同虚拟信息交互。

2.4 关键技术

2.4.1 位姿估计优化

位姿估计是航天员端单人/多人协同操作的基础,常规便携模式下,地面MR 采用Inside-out由里向外内置的视觉传感和IMU 融合模式进行位姿估计。其核心为视觉前端VO(Visual Odometry)视觉里程计,即提取每帧图像间接特征点,利用相邻帧图像进行特征点匹配(Frame to Frame),或者利用当前帧与当前地图保存地图进行位姿匹配(Frame to Map),计算得到位姿信息。由于视觉特征点位姿计算受头盔算力限制,输出位姿速率为30 Hz 难以满足实时渲染驱动90 Hz 的需要,因此采用高频IMU 预积分互补滤波激励低频视觉位姿估计,从而输出高频精准的位姿估计值,本文研制的头盔IMU 插值可以达到500 Hz,远远大于最低频率限制。

位姿估计多传感器融合根据使用环境、功耗和实时性要求,一般分为紧耦合和松耦合。紧耦合将视觉传感器和IMU 的状态通过一个优化滤波器合并在一起,需要把图像特征点信息加入到状态向量中,共同构建运动方程和观测方程,然后进行状态估计,最终得到需要位姿信息和优化的特征点信息,其融合过程本身会优化更新视觉和IMU 中的参数。松耦合将视觉传感器和IMU 分别计算得到的位姿直接进行融合,融合过程对二者本身不产生影响,一般通过EKF(Extended Kalman Filter)滤波进行融合作为后处理方式[9]。通过理论分析和试验证明,在紧耦合中,无论任何一个传感器失效,最终位姿均失效;松耦合模式,二者可失效互补[10]。本文地面模式下采用VIO 融合松耦合模式,在轨失重采用VSLAM 建立VO 里程计。考虑姿态陀螺仪姿态角速度只与初始坐标相关,在轨必要时可采用VSLAM 与MEMS 陀螺仪姿态角速度驱动的松耦合模式。

松耦合以IMU 测量的加速度和角速度为激励,进行本体预积分状态估计,以视觉里程计预估的位置和姿态为测量值,与IMU 状态的估计值建立残差状态矩阵如式(1)所示:

在轨空间环境下,IMU 感知的重力形成了围绕地球运动的向心加速度,基于比力模型的IMU加速度计无法正常工作,加速度计借助重力分解的俯仰角和滚动角无法对漂移较大的陀螺仪实施姿态互补滤波,同时IMU 和相机也无法借助重力矢量进行初始坐标系统一,因此常规的头盔位姿估计算法在轨无法正常使用。

基于上述分析,本文在轨采用纯视觉VSLAM模式。缺少了IMU 瞬时加速度、角速度激励和互补滤波,单纯的VSLAM 法相比常规对视觉感知的特征点选取要求更高。依据航天器舱内实际,针对设备结构复杂、角点以及轮廓几何等信息比较丰富,在算法的选择上可以采用Harris 角点、FAST(Features from Accelerated Segment Test)、BRIEF(Binary Robust Independent Elementary Features)、ORB(Oriented FAST and Rotated BRIEF)、BRISK ( Binary Robust Invariant Scalable Keypoints)等对几何信息比较敏感的特征点描述子,以有效避免舱内弱纹理信息特征提取的不足[11]。也有研究利用直线、面信息进行特征捕获,但计算比较复杂。通常情况下视觉位姿估计的频率大于60 Hz 才可满足人的虚实感知一致性需求。为解决高速姿态预估,VSLAM 前端采用计算负荷小、速度快的直接特征光流法(舱内几何角点信息丰富)进行特征点识别图像对齐,采用描述子进行关键特征点建立、位姿优化和适合MR 虚实融合三维Mesh 地图重建(原始为点云三维重建)。考虑到位姿预估的健壮性,本文研制的头盔纯SLAM 算法中采用特殊特征点描述子,经测量匹配速度为前最快的ORB 描述子1/3~1/4 倍。

纯VSLAM 模式位姿优化同样建立状态方程,通过式(3)建立滑动窗口进行姿态估计优化。

为保证姿态预估值更好地驱动渲染图像,提高纯视觉位姿估计不低于60 Hz 的速率,提高视觉图像处理VPU(Visual Process Unit)算力的同时,采用头盔CPU 芯片与VPU 混合模式双算力进行位姿估计解算。实际受舱内弱纹理图像位姿估计特征点需要,可对低频姿态预估值进行平滑高速插值计算,与VIO 优化恒速预估方法一致,采用前帧或者前几帧运动速度进行预估插值,从而提供更高速的位姿输出。考虑到头盔相机运动中光心一致性,建立如式(4)所示插值方程,基于李群李代数[12]扰动法进行解算。

2.4.2 多人协同操作

在航天员单人操作的基础上增加数据协同功能则可实现多人协同操作。为保证协同信息在物理空间中位置的一致性,在多名航天员可以各自进行位姿估计的基础上,采用空间锚点(Space Anchor)作为物理空间的共同参考。空间锚点提供了一种能够将协同信息保留在物理空间特定位置和旋转状态上的方法,并且保存了该点周围的空间信息,作为虚实融合信息交互的参考基准空间。锚点的建立是视觉扫描的物理空间,通过三维扫描建立场景点云空间,然后转换成可以表达空间场景的几何结构特征稀疏连接Mesh 地图。多人协同时,多个MR 终端通过实时扫描建立空间Mesh 地图,与已知共享的Mesh 地图匹配,当匹配置信度大于90%以上,可以认为此时空间为基准建立共享坐标系。多人在基于同一物理空间建立的虚拟空间场景进行虚拟协同交互,三维虚拟视觉感知场景位姿一致。

图2 为多人协同操作的流程控制图。MR 头盔之间建立连接,其中一台作为主机(服务端+客户端),采用应用程序中的NetCode 机制进行虚拟对象(GameObject)信息共享与分发,包含了冲突竞争处理,不再单独设置信息中转服务器;所有MR 头盔各自进行位姿估计与建图,并在稳定感知的物理空间位置创建空间锚点;主机将空间锚点通过网络发送到其他客户端,当各客户端接收到锚点信息时与自身创建的锚点信息进行比对,比对成功则将虚拟世界坐标进行校准,比对失败则继续空间感知捕获完善锚点信息,直到与主锚点相匹配;锚点与坐标校准后MR 头盔之间可以进行同步操作;不需要协同工作时客户端与主机断开连接,协同结束。由于协同操作时的物理基准空间匹配物是一致的,因此只要位姿估计准确和地图构建完备,即可实现空间锚点成功匹配和虚实融合信息的同一场景感知。

图2 协同流程控制Fig.2 Collaborative process control

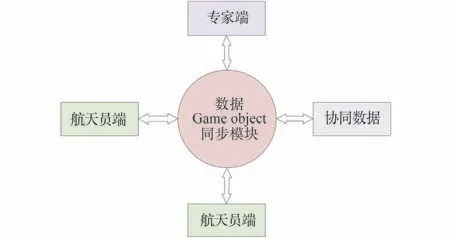

如图3 所示,多人协同操作数据通过数据同步模块实现同步,数据是以GameObject 对象通过网络同步机制进行分发与订阅,同步内容包含所有航天员端各自的位姿、操作数据等。终端航天员对虚拟对象的操作如移动、旋转、缩放、显隐、生成与销毁等实时同步到其他航天员端和专家端,保持MR 混合场景虚拟对象动态变化一致性。

图3 数据同步操作Fig.3 Data synchronization

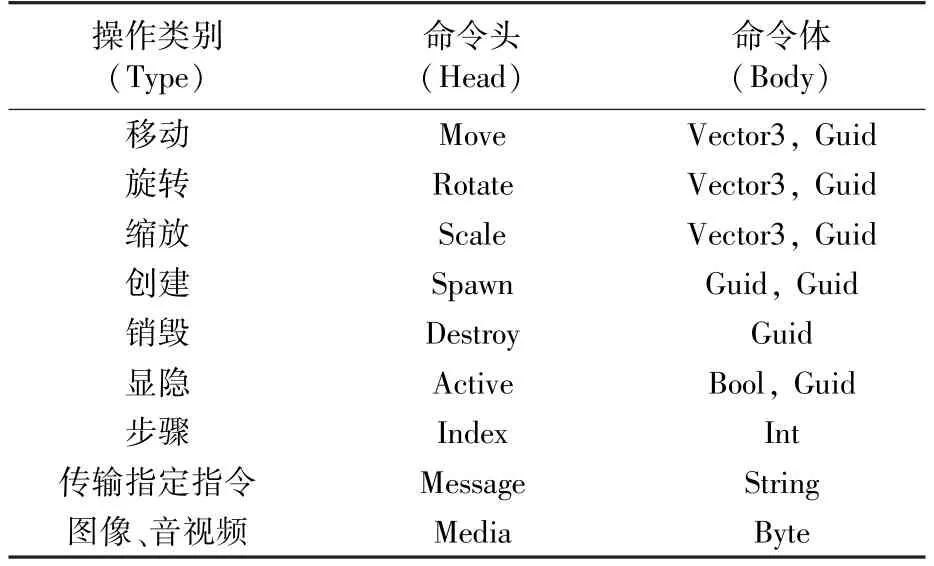

数据同步模块可以同步的数据类型包括Int、Bool、Vector3、String 以及Byte。同步命令列表如表1 所示,其中操作类别(Type)为触发的操作的类别名称;命令头(Head)具体区分每一条命令,不同的命令对应不同的协同操作。命令体(Body)根据Head 做对应操作:Vector3 为含有3个浮点数的结构体;Guid 为唯一识别码,每一个被操作的物体都有一个Guid,用来区分所要操作的物体;String 为特定的命令字符串;Int 为协同信息索引值;Bool 为协同信息的显隐值;Byte 则用来传输图像、音频、视频等。

表1 操作类别表示Table 1 Operation list representation

在数据同步时,根据操作内容构建不同的指令。例如,航天员端01 对协同信息进行移动操作,则根据类别表创建一条命令头为Move,命令体为协同信息当前的空间坐标,以及协同信息的Guid。然后发送命令到数据同步模块,数据同步模块接收到命令后将命令发送给其他客户端(航天员端或专家端),其他客户端对命令进行解析,解析依据接收到的命令头做相对应的响应。

2.4.3 远程支持

专家端对航天员端进行远程支持时,由于专家端运行于PC 端而没有空间位姿估计,因此专家端仅需与航天员端在空间匹配的基础上保持虚拟内容的同步即可。专家端与航天员端的协同控制流程如图4 所示,首先专家端与航天员端进行连接,进行天地2 个虚拟空间的虚虚匹配,然后进行支持操作的同步。与多人协同不同,首先需要将航天员操作的Mesh 空间与地面预知的支持场景的数字孪生三维模型粗匹配,通常采用全局或者局部轮廓匹配法;其次精准匹配到数字孪生虚拟空间场景中的对应局部空间位置,保证地面三维的标注对象及位姿能够准确映射到远程航天员MR 头盔视觉感知的真实场景中,且与拟标注实物对象精准虚实融合叠加。由于远程支持系统是多人系统操作的特例,因此其同步操作过程与多人协同操作相同。

图4 专家端与航天员端协同控制流程Fig.4 Collaborative process between expert and astronaut

专家端用于对航天员端进行远程支持,因此专家端通常设置为航天员端第一视角,保持与航天员视觉感知内容一致,便于实时支持;航天员端与专家端建立联系后,航天员端会将操作场景、设备状态、姿态等通过数据同步模块传输到专家端中;专家根据航天员所需可以在虚拟空间中编辑虚拟支持模型,包括模型选择、移动、旋转、缩放、添加指示箭头和特征符号等,专家操作通过数据同步模块同步到航天员端,形成航天员MR 视野中的三维虚拟标注支持信息。

3 试验结果

3.1 航天员体验训练主诉

基于设计的体系框架,针对典型任务训练,实现了出舱活动程序、应急火灾、环控生保ORU(Orbital Replacement Unit)、科学机柜ORU 以及CMG(Control Moment Gyro)维修等任务的混合现实训练支持单机诱导程序。13 名航天员地面体验和训练调查问卷统计表明:使用过程中均无不适感觉,相比全沉浸式VR,透射式MR 体验感好;移动定位精准、虚实融合一致、协同一致,渲染虚拟对象操作过程无漂移抖动,均认为可以有效用于实物半实物难以模拟的设备操作训练、典型复杂流程设备训练,可以弥补目前实物训练器难以工程实施的训练项目;77%航天员认为目前的电子手册可以混合现实模式在轨使用,直观视野显示,解放双手,提高操作效率;92%认为可用于自主预先训练以及过程训练。执行过在轨任务的航天员均表示作为一种新颖训练手段,MR 操作使用便捷方便,对手册操作解放双手和复杂程序引导有直观的辅助支持作用,提高了训练质量和效率,可以作为在轨自主训练和应急支持手段。

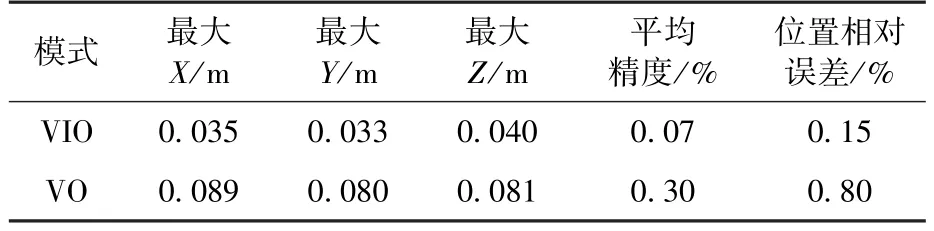

3.2 位姿试验

地面模式下采用渲染虚拟对象与实体融合方法,通过受试者位姿实时变化测量虚拟对象空间定位精准度和稳定性。在模拟器现场,锚点原点设置为桌角图标中心处,通过在空间锚点叠加渲染的15 cm×15 cm×15 cm 的半透明立方体(图5),经多次测试统计表明:地面VIO 模式下,受试者任意位置和姿态变换运动,渲染对象在实体空间中无大于1 cm 的位置偏差、姿态保持稳定、无抖动闪烁现象;多名受试终端同时协同任意位姿运动,渲染对象位姿保持稳定、视觉姿态变化与预想实际一致,虚拟对象抖动不明显。在纯视觉的VO 模式下,精度偏差保持在1 cm 内,虚拟渲染对象有轻微抖动现象,位姿输出平滑性有改善空间。

图5 位姿优化估计测试Fig.5 Pose optim ization test

通过专用位姿测试数据集(行程长度18.67 m)对自研MR 头盔2 种位姿预估算法进行了试验,位置和姿态估计误差结果如表2、表3 所示。可以看出,无论位置还是姿态估计,VIO 模式优于VSLAM 的VO 模式。经分析,VO 模式是视觉特征点基于前帧间的匀速运动预估后重投影位姿优化解算,而VIO 是视觉特征点基于IMU 本体瞬时中值积分的速度、角速度激励预估重投影位姿优化解算,因此VIO 重投影预估更精确和平滑一些。在轨VSLAM 的VO 定位方法还应该从算法和插值上再做优化。通过标准数据集V201 的VO 插值试验验证,如表4 所示,结果表明:运动预估采用前3 帧速度、角速度平滑预估后的均方根误差(RMSE)和平均误差(MEAN)更为精准一些,接近原始的GroundTruth 预估。

表2 位置估计误差Tab le 2 Position estim ation error

表3 姿态估计误差Table 3 Attitude estimation error (°)

表4 插值位姿误差Table 4 Interpolation pose error m

3.3 多人协同操作测试

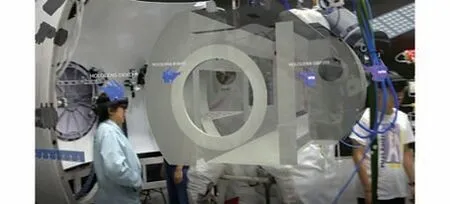

采用5 台MR 设备多人协同操作测试,其中4台作为被测对象,1 台用于拍摄测试过程,如图6所示,模拟航天员在模拟器现场头戴MR 设备,头顶出现代表航天员头部位姿的替身模型,且跟随模拟航天员头部位姿;混合现实场景中正确叠加了提示协同信息。结果表明:多人协同操作模块支持多人同时进入相同场景,支持其他用户随时加入;支持实时同步更新场景中的位置信息及操作控制信息。虚拟对象场景虚实融合位姿稳定,多用户操作体验感较好,满足航天员训练需求。

图6 多人协同信息测试Fig.6 M ulti-person collaborative information test

3.4 远程支持系统

在模拟器现场对远程支持系统进行测试,采用1 台PC 机作为专家端,1 台MR 设备作为航天员端。如图7 所示,专家端收到航天员端数据后,2 个场景Mesh 经过粗匹配和精匹配后基本吻合,还原了第一视角视频流的同时,恢复了航天员在混合现实场景中的位姿,并用替身模型加以标识,专家端可以在虚拟空间进行远程三维引导标注,航天员端可以实时根据虚拟对象空间标注指引进行操作。由于无需理解手册等辅助工具,直接按照虚实融合的标注引导进行操作,试验表明混合现实远程支持减少了脑力负荷,提高了操作的准确性和效率,适合应急模式下的操作支持。

图7 专家端还原航天员端第一视角Fig.7 Expert-end reconstruction of first view of astronaut

4 结论

本文从航天员在轨和地面训练实际需求出发,设计并实现了航天员混合现实训练系统,解决相关关键技术,并试验验证了其有效性,主诉训练体验和试验结果表明:

1) MR 作为一种虚实融合的便携训练手段,可以有效结合实物半实物训练器进行典型复杂设备操作引导、应急等实物难以模拟的训练。

2)在轨MR 可以通过预估速度的插值法实现VSLAM 位姿高速估计,解决了在轨失重模式下高速MEMS 加速度计无法支持难题。

3)航天员可以通过MR 协同模式进行多人训练与操作,地面专家可以通过MR 远程支持模式对在轨航天员进行三维标注沉浸支持,提高支持效率和精准性。

4)文中提出的VSLAM 姿态估计算法较好解决了在轨失重应用难题,但在算法速度、位姿误差度仍需优化,以提高位姿预估的平滑度。