遥感影像小目标检测研究进展

袁翔,程塨*,李戈,戴威,尹文昕,冯瑛超,姚西文,黄钟泠,孙显,韩军伟

1.西北工业大学自动化学院,西安 710021;2.中国科学院空天信息创新研究院,北京 100094

0 引言

遥感影像目标检测旨在设计相关算法获取遥感图像中有价值目标的类别和位置信息,是迈向遥感场景智能理解、构建遥感影像智能解译系统以及开展遥感影像分析业务化应用的重要途径(孙显 等,2022)。遥感图像具有幅面大、场景多样和成像高度多变等特点,因而包含大量尺寸极其有限的目标。例如在同一幅机场场景光学遥感图像中,飞机和车辆往往同时出现,而由于尺寸层面的天然差异,车辆目标往往仅占据几十个像素(Cheng 等,2022c)。合成孔径雷达(synthetic aperture radar,SAR)的目标成像与目标的散射特性有关,散射特性的强弱影响目标的成像质量,例如飞机目标的机翼散射特性弱、机身散射特征强,机翼区域的成像较为模糊,这使得目标在SAR 图像中相对偏小。此外,特殊的成像机理使目标容易受到杂波等噪声的干扰,导致目标边缘模糊,使得本身尺寸较小的车辆、船舶等观测目标成像区域更加受限(徐丰 等,2020)。红外探测系统中,目标与探测器之间距离较远,因而成像目标面积很小,往往呈现点特征(李俊宏 等,2020)。这些尺寸有限的目标给遥感影像智能感知系统带来了巨大挑战,也在一定程度上制约着遥感大数据在国防体系建设、灾害预警评估和农林资源监测等领域的实际应用。

与通用目标检测的蓬勃发展相比,小目标检测近年来发展缓慢,遥感图像领域亦是如此。作为通用目标检测的一个子任务,现有的小目标检测框架往往以通用目标检测任务中表现出色的模型为基础,添加针对性的设计(Cheng 等,2022c)。这些基础模型一般由特征提取网络和检测网络构成,前者通过深度卷积神经网络(deep convolution neural network)获得图像的高维表征,并利用下采样操作减少空间冗余;后者则在前者得到的深度特征上完成分类和回归(Liu 等,2020;Ren 等,2017;Lin 等,2020;Tian 等,2022)。遗憾的是,这些深度学习加持下的优秀检测范式在面对小目标时,性能往往捉襟见肘。究其原因,一方面是小目标的内在特性导致模型很难获得目标区域的良好特征表示。CNN 通过堆叠卷积层和池化层获得图像的高维表征,前者通过共享参数的卷积核获得区域表示,而遥感图像中的小目标往往背景复杂,经过卷积层后,目标区域的特征容易被背景或其他实例所干扰,丢失判别信息;后者旨在减少空间冗余并滤除噪声响应,然而这一操作却为小目标带来不可逆的信息损失(Noh 等,2015)。无论是缺乏判别性的特征表示,还是目标区域的信息损失,都会加剧后续分类和回归的任务难度。另一方面,深度学习是数据驱动的,获得性能优异的检测模型需要大量注释良好的数据用于训练。然而,小目标往往边缘模糊且视觉结构强依赖于图像质量,很难准确获得其轮廓信息,因而标注误差较大,在一定程度上误导网络训练。此外,现有数据集往往包含各种尺度的目标,小目标仅占其中一小部分,导致模型为兼顾整体精度而牺牲小目标的检测效果。

为了更好地促进领域发展,本文选取3 种代表性的遥感影像小目标检测任务,即光学遥感图像小目标检测、SAR 图像小目标检测和红外图像小目标检测,以算法和数据集为研究对象,全面回顾基于深度学习的遥感影像目标检测,并对应用现状和发展趋势进行总结。

1 小目标检测定义与挑战

1.1 问题定义

目标检测旨在识别并定位感兴趣的目标实例。遥感影像小目标检测,顾名思义,是专注于检测遥感影像中尺寸有限目标的一项基本视觉任务。迄今为止学术界对于小目标检测中的尺寸并无明确且统一的定义,并且对于不同任务,其定义也往往不一致。具体说来,现有的光学遥感图像小目标检测数据集(Cheng 等,2022c;Xu 等,2022b)中往往采用面积定义,例如SODA-A(small object detection datasets)中将面积≤ 1 024 像素的实例视为小目标(Cheng 等,2022c),SAR 图像与红外图像则常采用目标与图像的相对面积比来判断是否属于小目标。

1.2 遥感影像小目标检测主要挑战

小目标检测作为通用目标检测的一项子任务,除了面临通用检测任务的一些固有问题如类内差异类间相似和精度速度折衷以外,小目标的内在特质和遥感影像的数据特性使得面向遥感影像的小目标检测任务变得更具挑战性。本文将其归纳为3 个方面,即特征表示瓶颈、前背景混淆和回归分支敏感,如图1所示。

图1 遥感影像小目标检测主要挑战Fig.1 Three major challenges of small object detection for optical remote sensing images((a)the bottleneck of feature representation;(b)the confusion of foreground and background;(c)the sensitivity of regression branch)

1.2.1 特征表示瓶颈

基于深度学习的目标检测算法依赖于主干网络获得的高维特征,即通过降低空间分辨率减少冗余,提升通道维度获得在高维空间可分的良好特征表示。这一范式已被证明在计算机视觉和自然语言处理等多个领域卓有成效。然而,具体到小目标检测任务,这种机制有着不可忽视的天然缺陷。如前所述,小目标区域较小,包含信息有限,因而经过主干网络的下采样操作之后,空间维度上信息损失较大。如图1(a)所示,飞机和小车仅经过两个卷积层和池化层后,其特征响应就变得十分微弱。以ResNet(deep residual network)(He等,2016)为例,其主干网络的输出层相较原图的下采样倍数为32,即目标在主干网络的输出特征图上仅占据1 个像素点。凭借1 个像素点所含信息进行后续的分类和回归任务,难度可想而知。与此同时,浅层特征虽然可以缓解空间信息损失,但对光照、亮度、噪声和形变等因素较为敏感,同样会干扰检测(Cheng 等,2022c)。因而,如何在避免深度网络造成信息损失的同时,保证良好的特征表达能力,是小目标检测面临的一个瓶颈问题。

1.2.2 前背景混淆

遥感影像往往幅面较大且覆盖区域广,因而场景内背景复杂问题突出。与此同时,小目标信息有限,尤其对于SAR 图像和红外图像而言,由于缺乏色彩信息,目标成像仅具备结构和纹理特征,甚至只有点信息,很容易淹没在背景和噪声中。图1(b)中油罐类目标(黄色圆圈内)成像区域很小,极易淹没在复杂的背景中,由此带来的前背景混淆和漏检是小目标检测发展的一个关键挑战。

1.2.3 回归分支敏感

分类和回归是目标检测的两个基本任务,前者旨在识别目标类别,后者则使用边界框输出目标的位置信息,最终的性能指标使用真实标注和预测框的交并比(intersection over union,IoU)进行评估。然而,对于小目标而言,模型训练过程中预测框的轻微偏移都会带来IoU 的剧烈波动。如图1(c)所示,对于1 个像素的目标而言,预测框对角线方向的偏移会使其与真实框的IoU 急剧变化,6个像素的偏移使IoU 变为32.5%,偏移量为12 像素时,IoU 仅为8.7%。回归分支的敏感性不仅影响着正负样本分配,也给网络的整体优化带来困难。

2 小目标检测定义与挑战

2.1 光学遥感图像小目标检测算法

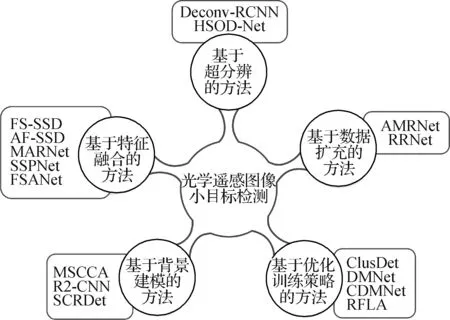

得益于通用目标检测任务的迅速发展,光学遥感图像小目标检测近年来涌现出一批优秀工作。这些方法往往以在通用目标检测领域大放异彩的检测算法,如Faster RCNN(regional-based convolutional neural network)(Ren 等,2017)、RetinaNet(Lin 等,2020)、FCOS(fully convolutional one-stage detector)(Tian 等,2022)、FPN(feature pyramid networks)(Lin等,2017)和YOLOv3(you only look once)(Redmon 和Farhadi,2018)等作为基础模型,对输入图像处理流程或结构设计进行针对性优化,从而完成对光学遥感图像中的小目标的检测。根据算法采用技术的主要特点,可概括为5 类,即基于数据扩充的方法、基于特征融合的方法、基于超分辨的方法、基于背景建模的方法和基于优化训练策略的方法。整体的分类图如图2所示。

图2 光学遥感图像小目标检测算法分类Fig.2 Algorithm taxonomy of small object detection for optical remote sensing images

2.1.1 基于数据扩充的方法

遥感图像中小目标难以检测的一个重要原因是缺乏足够数量的样本可供训练。当前,领域内大多数开源数据集小目标仅占很小一部分,导致模型很难在训练时对这些目标进行有效拟合。一个很自然的想法是在数据层面扩充小目标实例,从而提升训练时的正样本数量,增强模型对于小目标的优化能力,同时一定程度缓解尺度层面的不平衡。

针对遥感图像中目标尺度差异大、小目标密集分布的问题,AMRNet(Wei 等,2020b)提出了尺度自适应模块,通过动态调整图像块的尺寸来平衡目标尺度;同时将Mosaic 操作引入到遥感图像目标检测中,即通过拼接多幅原始图像形成新图,实际上增加了小目标的样本数量,利于网络优化。RRNet(Chen等,2019)采用“复制—粘贴”数据集中已标注实例的方式增加小目标数量,后者为了避免背景不匹配和尺度不匹配问题,引入了语义分割先验确定待粘贴区域,并在粘贴时转换目标尺度,从而保证了粘贴前后的一致性。

2.1.2 基于特征融合的方法

主流基于深度学习的目标检测范式中,检测分支依靠主干网络输出的深度特征完成分类和回归。研究表明,深层特征图关注高层级的语义信息,浅层特征图则关于低层级的细节信息(Liu 等,2020;Lin等,2017)。高维表征对后续任务至关重要,但是深度增加导致的空间维度上的信息损失对小目标检测的弊病同样不可忽视。因此,研究者致力于融合不同阶段的特征图,以获得兼顾语义信息和细节信息的高效特征表示,从而在提升小目标检测精度的同时,保证其他尺度目标的检测准确率。

FS-SSD(feature fusion and scaling-based single shot detector)(Liang 等,2020)以SSD(single shot detector)(Liu 等,2016)算法为基础,保留其多尺度检测优势的同时,将主干网络不同卷积层输出的特征图进行融合,获得分辨率和丰富语义信息兼备的特征表示,极大提升了SSD 的小目标检测能力。同样基于SSD,Lu 等人(2021)设计了AF-SSD(attention and feature fusion SSD),通过多层特征融合结构融合较浅层和较深层的特征信息。受FPN(Lin 等,2017)在自然图像目标检测任务上的良好表现的启发,部分研究者将其引入光学遥感图像目标检测领域,提升小目标检测精度。MARNet(multi-angle rotation network)(Cao 等,2021)为FPN 引入全局注意力机制,即首先利用深层特征图获得浅层特征在通道维度的注意力,然后与该注意力加权的浅层特征图进行融合,突出小目标区域的信息。Hong 等人(2022)设计了SSPNet(scale selection pyramid network),通过尺度增强模块和尺度选择模块增强小目标在FPN的表示。前者确保模型在不同层关注不同尺度的目标,避免小目标被大量背景淹没;后者则利用FPN中邻接层的关系实现特征共享,避免不同层之间的梯度不一致问题。FSANet(feature-and-spatial-aligned network)(Wu 等,2022)在邻接层特征图融合之前使用特征敏感的对齐模块对齐不同分辨率的特征,在光学遥感图像小目标检测任务上获得了可观的精度。此外,Zand 等人(2022)和Kim 等人(2021)均以YOLOv3(Redmon 和Farhadi,2018)模型为基础,融合深层浅层特征的结构以完成遥感图像小目标检测任务,同时保证了较高的推理速度。

2.1.3 基于超分辨的方法

在光学遥感图像中,相比于中大尺寸目标,小目标区域有限并且常伴随着结构模糊等挑战。围绕设计一种网络对小目标区域进行超分辨进而获得媲美大中尺寸目标的检测能力这一思路,一些研究者提出利用上采样技术增强小目标的结构信息,以期获得更好的特征表示。

Zhang 等人(2018c)提出了Deconv-RCNN(deconvolution rcnn),通过对主干网络输出的特征图进行反卷积操作,恢复在之前层(如池化层)带来的小目标信息损失,从而提升检测精度。受图像超分辨领域已有算法的启发,部分研究者借助生成对抗网络(generative adversarial network,GAN)(Goodfellow 等,2020)完成这一过程。Courtrai 等人(2020)通过在检测网络上添加基于GAN 的超分辨分支对输入图像进行分辨率提升,从而获得更清晰的图像进行检测。进一步地,Rabbi等人(2020)强调了目标的边缘特征,为超分辨图像带来更好的结构信息。Bashir 和Wang(2021)优化了生成器的结构,通过设计残差特征聚合帮助网络处理更复杂的特征,并且可以嵌入到多个检测器中实现端到端优化。考虑到对整幅图像或特征图进行超分辨非常耗时,HSODNet(hierarchical small object detection network)(Wu和Xu,2021)首先通过关键点预测获得可能存在目标的潜在位置,然后在这些位置对应的图像区域进行超分辨和检测,从而避免了无目标区域的无效运算。

2.1.4 基于背景建模的方法

人类的视觉系统在识别物体时可以利用周围环境或目标间的关系来辅助决策。同样,这种利用背景知识进行识别的模式也在视觉任务中大行其道(Zhang等,2018a)。在光学遥感图像中,目标所在场景往往对识别目标本身是有益的(Pang 等,2019),因此,相关工作也将这一机制引入光学遥感图像小目标检测任务,利用背景信息弥合小目标区域有限的缺陷,促进小目标识别。

Ren 等人(2018)在Faster R-CNN(Ren 等,2017)的基础上,添加了针对背景区域的区域特征提取,然后与原本的目标区域特征拼接,共同进行分类和回归任务。Ran 等人(2021)设计了一个轻量级的检测模型MSCCA(multiscale context and enhanced channel attention),通过融合多尺度的背景信息和增强的通道注意力来增强光学遥感图像中的小目标检测。R2-CNN(remote sensing region-based convolutional neural network)(Pang等,2019)设计了全局注意力模块,通过融合不同感受野的并行分支得到的特征图为目标区域引入背景信息,提升了光学遥感图像小目标的检测精度。Yang等人(2019b)设计了SCRDet(multi-category rotation detector for small,cluttered and rotated objects),通过有监督的注意力学习机制引导网络关注特定的背景信息,从而提升检测模型的鲁棒性。Zhang等人(2022a)设计了语义背景融合模块,将高层级的语义背景信息引入到浅层特征图中。

2.1.5 基于优化训练策略的方法

遥感图像往往尺寸较大,并且目标分布相比自然图像更为稀疏,采用一般的训练策略会带来不可忽视的时间与硬件资源开销。因此,部分工作着重于设计适合遥感图像目标检测的训练方式,提升模型对小目标的处理能力。

Yang 等人(2019a)设计了ClusDet(clustered detection),通过聚集提议网络生成目标聚集的候选区域(密集区域),随后的尺度估计网络会输出候选区域内目标的尺度估计,然后根据尺度大小对目标进行分隔与填充。这一过程中,小目标所在区域会被放大,但又避免了全图放大带来的计算开销,最终图像块会被送入检测网络得到检测结果。随后的DMNet(density-map guided object detection network)(Li 等,2020)和CDMNet(coarse-grained density map network)(Duan 等,2021)均采用像素级监督信息进行密度估计,从而获得能够精确反映目标分布的密度图。此外,还有一些工作在检测模型训练过程中的正负样本划分上做出了尝试。除了IoU 以外,Xu等人(2021a)将小目标中心点与锚框中心点之间的距离纳入纳入正负样本的考量,缓解了小目标回归过程中边框扰动带来的IoU 剧烈振荡。RFLA(Gaussian receptive field based label assignment)(Xu等,2022a)设计了基于高斯感受野的样本分类策略,缓解正样本过少,模型难以优化的问题。

2.2 SAR图像小目标检测算法

随着SAR 成像技术的不断发展,高分辨率SAR图像的数据积累与日俱增,数据驱动的深度学习领域涌现出一批代表性工作。这些方法往往以通用目标检测算法为基础,结合小目标的表征特性与SAR成像机理优化网络设计,从而完成对SAR 遥感图像中的小目标的检测。根据其优化的机理与设计技术的区别,可以概括为5 类,即基于数据扩充增强的方法、基于多尺度特征融合的方法、基于注意力特征感知的方法、基于半监督学习的方法和基于雷达散射机理的方法。整体的分类图如图3所示。

图3 SAR图像小目标检测算法分类Fig.3 Algorithm taxonomy of small object detection for SAR remote sensing images

2.2.1 基于数据扩充增强的方法

相比于光学遥感图像的小目标检测任务,SAR图像的小目标样本数据具有来源有限、标注成本高和小目标捕捉难度大的特点。样本稀缺形势比光学影像更加严峻,样本量的稀缺限制了检测算法的表现性能。因此可以考虑通过数据增强或样本生成的方法扩大样本数量,适当地缓解SAR 图像小目标样本稀缺问题。常见的数据扩充方式包括几何变换、颜色变换等。Wang 等人(2019c)通过子图像提取、噪声添加、滤波和翻转等几何变换方法扩充了SAR图像数据规模,增强小目标的拟合能力。随着生成对抗网络在计算机视觉领域的成功应用,同样得到SAR 图像解译领域众多学者的关注。Zou 等人(2020)设计了MW-ACGAN(multiscale wassersteire auxiliary classifier generative adversarial network),利用多尺度Wasserstein 距离辅助分类器生成对抗网络。Guo 等人(2022)提出了一种基于残差和注意力的生成对抗网络,Li等人(2022b)改进了残差条件生成网络,用以生成高质量模拟SAR图像样本。

2.2.2 基于多尺度特征融合的方法

经典卷积网络采用自上而下的单行结构,随着卷积层的逐渐加深,目标的底层特征的表现能力逐渐减弱。因此尺寸较小目标的语义信息往往出现在较浅特征图中,网络层数的加深可能导致目标特征信息的损失,甚至完全消失。因此,SAR影像小目标检测方法通常考虑将高低维度的尺度特征融合,以保留更多的目标特征,常用的多尺度特征融合方法采用特征融合、感受野增强和锚框匹配等思路。

在特征融合方面,Jin 等人(2020)结合了各尺度的特征上下文语义信息与扩张卷积方法;Han 等人(2019)利用反卷积技术增强了中小型船舶目标的特征表示;Wang等人(2021)设计SSS-YOLO,通过路径增强融合网络用以融合特征和语义信息;Yu 等(2021)提出TWC-Net(two-way convolution),利用双向卷积结构处理浅层和深层特征信息。在感受野增强方面,Zhao 等人(2019)从多个感受野生成候选区域并结合候选框的上下文信息;Dai等人(2020)融合自下而上和自上而下的特征图,增强小目标特征的感受野。在锚框匹配策略方面,为了避免锚框的影响,Fu 等人(2021a)采取无锚策略检测SAR 影像小型船舶;Xu等人(2021b)则利用改进的K-means++算法优化锚框的生成,减轻船舶多尺度特征的优化难度。

2.2.3 基于注意力特征感知的方法

SAR遥感影像场景覆盖范围大、背景情况复杂,因而图像中的小目标表征容易遭受背景噪音或其他显著目标的干扰。注意力机制的基本思想是使模型更关注于图像中的关键信息且忽略无关信息。因而基于注意力特征感知的方法能够辅助SAR 遥感影像中典型小目标的特征强化,抑制背景噪声干扰。Cui 等人(2021)将空间组注意增强模块引入检测网络;Wang等人(2020)设计了空间和通道注意的自注意力特征增强模块;Zhu 等人(2020)提出包括全局和局部注意模块的层次注意力机制;Sun 等人(2023)引入一种语义注意机制突出了船舶的区域特征;Du 等人(2022)将通道和空间注意机制应用到多尺度特征图中,提取较强的目标特征,并抑制噪声的影响;Xia 等人(2022)提出了CRTransfer,首次使用Transformer 实现SAR 图像船舶检测,结合了Transformer 的全局上下文信息感知信息和卷积神经网络的局部特征信息。

2.2.4 基于半监督学习的方法

监督学习方法通过训练带标注的数据来拟合期望输出,数据驱动的深度学习方法则需要海量的训练样本数据。然而,训练样本的制作意味着必要的时间与人力。由于SAR 图像的数据来源有限,并且样本标注成本高、小目标捕捉难度大,可以考虑采用半监督的思想,即利用大量未标注、多样性的数据提升模型在测试集上的性能。因此,基于半监督学习方法实现SAR 图像小目标检测是切实有效的研究思路。

Gu 等人(2020)提出“卷积神经网络—类激活映射—条件随机场”三部件模型,仅训练“目标”与“非目标”两个全局标签,生成位置热力图、目标预选框和像素级分割结果,从而减轻SAR 影像的样本标注压力。由于图像级样本的标注成本远低于切片级样本,Du 等人(2020)使用少量切片级标记样本和大量图像级标记样本,交替训练检测网络和更新候选区域集,获得与大量切片级样本全监督训练方法相似的检测性能。Liao 等人(2022)则设计解码模块和域自适应模块,利用未标注样本构建潜在特征空间辅助提升SAR目标特征的可分性。

2.2.5 基于雷达散射机理的方法

当前主流SAR 图像解译深度学习方法大多数从计算机视觉领域发展而来,通过神经网络对SAR幅度图像的视觉信息开展自动特征学习。尽管SAR图像的空间纹理信息能够有效解译SAR 影像的目标,但由于SAR 特殊的雷达成像机理,散射复杂的目标易受到散斑、十字耀斑等干扰噪声的影响,在视觉上难以区分。特别是对于密集排列的车辆、船舶和飞机等小目标,邻近目标的散射干扰较强,目标边缘模糊问题较为明显。因此,仅基于SAR 图像幅度信息无法全面理解SAR 图像,结合雷达散射成像机理的SAR图像特性研究具有重要意义。

Zhu 等人(2017)基于SAR 船舶结构特性生成投影形状模板,运用列相关运算来计算待测目标的匹配程度,实现船舶的精细化检测与识别。Guo 等人(2021)将SAR 飞机的电磁散射特性与深度学习网络融合,分析飞机内不同部件强散射点的特征,进行精细化检测。Huang 等人(2020)设计Deep SARNet,对于复数SAR 图像,综合考虑SAR 影像的空间纹理信息和后向散射模式,从而区分人造目标与自然背景。Kang 等人(2022)设计SFR-Net(scattering feature relation network),通过飞机散射点的数量和空间分布关系表征目标的拓扑信息,提升了复杂场景下的飞机检测性能,有效地增强了飞机的散射拓扑特征的泛化性。

2.3 红外图像小目标检测算法

随着红外成像技术的不断发展,结合深度学习的红外图像小目标检测方法屡见不鲜。这些方法往往以通用目标检测算法为基础,结合红外小目标的特点优化网络设计,从而完成对红外图像中小目标的检测。根据其优化手段与设计方法的区别,可以概括为4 类,即基于超分辨率的方法、基于背景噪声抑制的方法、基于注意力机制的方法和基于多尺度感知的方法。整体的分类图如图4所示。

图4 红外图像小目标检测算法分类Fig.4 Algorithm taxonomy of small object detection for infrared images

2.3.1 基于超分辨率的方法

红外图像小目标检测中一个重要的难点是可用特征少。当前,已开源的红外图像数据集中,目标红外成像呈现点目标特征,往往仅占图像的几十个或十几个甚至几个像素,缺乏精细的形状、纹理等结构信息,导致网络很难提取到有用的目标特征。针对此问题,部分研究者的想法是对图像进行超分辨率处理,使网络可以学习到更丰富的红外小目标特征,进而提高检测精度。Yang 等人(2020)提出一种新的卷积网络来提高红外图像的分辨率,该网络能将输入图像分为低频部分和高频部分来恢复细节。Sun 等人(2023)提出一种基于边缘梯度正则化的多帧图像超分辨率算法,设计了一个正则化项,并将其引入到贝叶斯问题的求解过程中,提高了红外图像的分辨率以及小目标的视觉显著性。在此基础上,还提出了一种基于梯度约束分解的图像增强方法,用来提高红外图像的对比度。Ren 等人(2022)提出一种区域超分辨率生成对抗网络,利用区域上下文网络,在消耗较少计算资源的条件下,有效地结合目标周围的上下文信息,从而获得更好的超分辨率图像。Ying等人(2022)提出一种用于红外小目标超分辨率的局部运动和对比度先验驱动的深度网络,将红外小目标的领域知识集成到深度网络中,以缓解红外小目标固有的特征不足问题,在目标增强方面优于目前最先进的超分辨率的方法。

2.3.2 基于背景噪声抑制的方法

红外图像小目标检测的另一个挑战是背景噪声大。红外图像是一种红外遥感器接收地物反射或自身发射的红外线而形成的图像,由于成像距离远,经过长距离传输后,图像不可避免地包含噪声和杂波。对此,部分研究者提出了抑制背景噪声的方法,提高了信噪比,使小目标更加清晰,对提高检测准确性有很大帮助。

Chen 和Xin(2016)提出一种检测率高、误报率低以及处理时间短的红外小目标检测方法,结合局部自相似性和局部对比度,得到一种有效的显著性映射,既能提高信杂比,又能抑制残余杂波。Bai 和Bi(2018)提出一种基于导数熵的对比度测量方法,用于各种复杂背景杂波下的红外小目标检测。首先,计算红外图像的不同方向导数;然后,通过分析小目标的导数性质,结合导数信息改进原始熵公式。随着熵的改进,构造了对比度测量来抑制每个导数子带中的背景杂波。最后,将从导数子带中得到的对比度测量图融合在一起,从融合结果中可以很容易地分割出小目标。Huang 等人(2019)提出一种自适应的杂波抑制方法,称为链生长滤波,用于红外小目标检测,该方法对不同类型的杂波具有良好的杂波抑制效果,对各种场景具有良好的检测性能。Zhang 等人(2021)提出一种基于密度—距离空间的检测方法,具有优越的抗噪声和抑制各种杂波的能力。

2.3.3 基于注意力机制的方法

红外小目标检测存在目标信号强度弱、易被网络忽视的问题。红外小目标本身亮度弱,与云层、海浪等杂波具有相似的特点,因此易被淹没,难以检测。针对这个问题,部分工作通过在网络中添加注意力模块,提高了图像的表征能力,丰富了小目标的特征信息,从而整体提高了红外小目标的检测性能。

Dai等人(2021a)提出基于非对称上下文调制网络结构的红外小目标检测法,为了更好地突出小目标,除了增加一个自上而下的全局上下文反馈外,还补充了一个基于点级通道注意力的自底而上的调制路径,用于交换高级语义信息和微妙的低级细节特征。同时,Dai 等人(2021b)提出了基于局部对比度注意力网络的红外小目标检测算法,与传统算法相比,检测效果明显提升。通过设计特征映射循环移位方案,将传统的局部对比测量方法模块化为端到端网络的无参数非线性特征细化层。该方法编码了相对较长的上下文交互,具有清晰的物理可解释性。此外,为了保留并突出小目标特征,还利用一种自下而上的注意力调制,将低级特征的细节信息集成到更深层次的高级特征中。Zhang 等人(2022b)提出了一种新的红外图像目标形状网络,设计了受泰勒有限差分启发的边缘块和双向注意力聚集模块,提高目标与背景的对比度。受TFD(Taylor-finite difference)启发的边缘块对不同层次边缘信息进行聚合和增强,以提高目标与背景的对比度,边缘块和双向注意力聚集模块计算具有行和列方向注意力的低级信息,并将其与高级信息融合,捕捉目标的形状特征,提高检测结果。Chen 等人(2022)提出了一种具有全局注意力的局部分块网络,综合了红外图像的全局和局部特性来检测小目标。从全局角度看,监督注意力模块能够抑制大部分与小目标特征无关的像素;从局部角度来看,网络能够利用从全局特征中分离出的局部特征来提高小目标的显著性。通过同时利用全局和局部属性,所提出的数据驱动框架具有检测小目标的能力。

2.3.4 基于多尺度感知的方法

红外小目标检测中还有一个可能出现的问题就是目标的尺度不一致。目标到拍摄装备的距离不一致时,在图像中出现的比例也不同。针对此问题,部分研究者提出了多尺度感知的方法,使网络能够更好地检测到不同尺度的目标,从而提升检测性能。

Han 等人(2018)提出一种利用相对局部对比度测量方法的多尺度检测算法,能够处理复杂背景下不同尺寸的小目标。首先对原始红外图像的每个像素计算多尺度RLCM(relative local contrast measurement),然后应用自适应阈值提取真实目标。Xia 等人(2020)提出一种基于多尺度局部对比度测量的小目标检测方法,创新性地用局部能量因子来描述小目标与周围背景之间的不同,采用自适应分割的方法从背景中提取小目标。Han 等人(2020)提出一种多尺度3 层局部对比度测量的方法,对不同类型和不同尺寸的红外小目标具有良好的检测性能。Li等人(2022d)提出一种基于多尺度双形态重建的新方法来检测红外图像中大小和极性未知(亮或暗)的低对比度目标。

3 遥感影像小目标检测数据集回顾

无论是自然图像目标检测还是遥感影像目标检测,数据都是基于深度学习的目标检测算法的基石,具有良好实例标注的大规模公开数据集不仅使得训练更深更大的模型成为可能,同时也为各种算法的评估与对比提供了一个公正的平台,进一步促进了领域的良性发展。本节将从3 种小目标检测任务出发,介绍与之对应的3 种类型的公开数据集,并选取领域内具有代表性的数据集对主流算法进行性能评估和分析,以期为后续的算法设计提供参考。

3.1 光学遥感图像

3.1.1 常用数据集

如果说深度学习为光学遥感图像目标检测的飞速发展插上了翅膀,那么领域内一批优秀的公开数据集则是支撑该任务的重要臂膀。本节全面回顾可用于训练及验证光学遥感图像小目标检测算法的多个数据集。为了突出小目标,本文以1 024为面积阈值,统计了相关数据集在该尺寸下的实例数目及一些数据特性(如表1 所示),并对其中最具代表性的部分数据集进行阐述。

表1 光学遥感图像小目标检测数据集Table 1 Public datasets for small object detection of optical remote sensing images

1)DOTA 数据集。DOTA(dataset of object detection in aerial images)是第一个可用于光学遥感图像目标检测的大型数据集,自从2018 年推出以来,已经更新了3 个版本,极大地推动了光学遥感图像目标检测任务的发展。最新的DOTA 2.0 数据集中共包含11 268 幅从谷歌地球、高分系列卫星等获得的不同分辨率图像,采用水平框和斜框标注了18 个类别1 793 658 个实例。由于拍摄方式以及目标本身面积的内在差异,DOTA 数据集有着丰富的尺度多样性,包括很多尺寸极其有限的目标。但是,DOTA 数据集中的小目标往往仅存在于少数几个类别,如小车(small-vehicle)和船(ship)中。

2)AI-TOD 数据集。AI-TOD(tiny object detection in aerial images)是专注于光学遥感图像微小目标检测的公开数据集。图像来源于诸多优秀的遥感领域目标检测数据集,并针对微小目标检测任务添加了标注。数据集包括28 036 幅分辨率为800×800 像素的图像,采用水平框标注了8 个类别共752 745 个实例。这些实例大多集中于车辆(vehicle)类别。AI-TOD 中的目标尺寸平均值仅为12.7 像素,对当前主流的目标检测算法是一个极大的挑战。

3)FAIR1M 数据集。FAIR1M(fine-grained object recognition in high-resolution remote sensing imagery)数据集包含了超过4万幅分辨率为0.3 m~0.8 m、尺寸为上千到上万像素不等的图像,其中来自我国自主产权高分系列卫星的数据占比超过80%。数据集中包含了100 多万条精细化标注、具有任意角度分布的实例,其中小目标占比约80%,场景覆盖全球上百个典型城市、乡镇及常用机场、港口等。根据遥感应用的实际需求,FAIR1M数据集将地物要素和典型目标进一步进行类型的细分,包含舰船、车辆、飞机、球场和道路5大类37种精细化类别。目前,该数据集已成为国际高分大赛、ISPRS Benchmark(International Society for Photogrammetry and Remote Sensing)等多项国内外赛事的标准数据集。

4)SODA-A 数据集。SODA-A 是第一个专为小目标检测设计的大规模数据集SODA 中面向倾斜目标检测任务的公开数据集,其公布标志着小目标检测迈向了大数据集时代。SODA-A 共包含从谷歌地球上截取的2 513幅高分辨率图像,采用斜框标注了9 个类别的872 069个实例。SODA-A数据集中图像的高分辨率特性使得数据集包含丰富多变的背景,逐实例的精确斜框标注允许更精确的定位评估和异常拥挤的场景,这些特点都保证了SODA-A更贴近于真实情况下的光学遥感图像小目标检测挑战,因而对于设计和评估专用的小目标检测算法具有重要意义。

DOTA、AI-TOD 和SODA-A 数据集的部分示例图像可视结果如图5所示。

图5 光学遥感图像小目标检测常用数据集标注可视化Fig.5 Annotation visualization of example images from several small object detection datasets for optical remote sensing images((a)DOTA;(b)AI-TOD;(c)SODA-A)

3.1.2 基于SODA-A数据集的主流算法性能评估

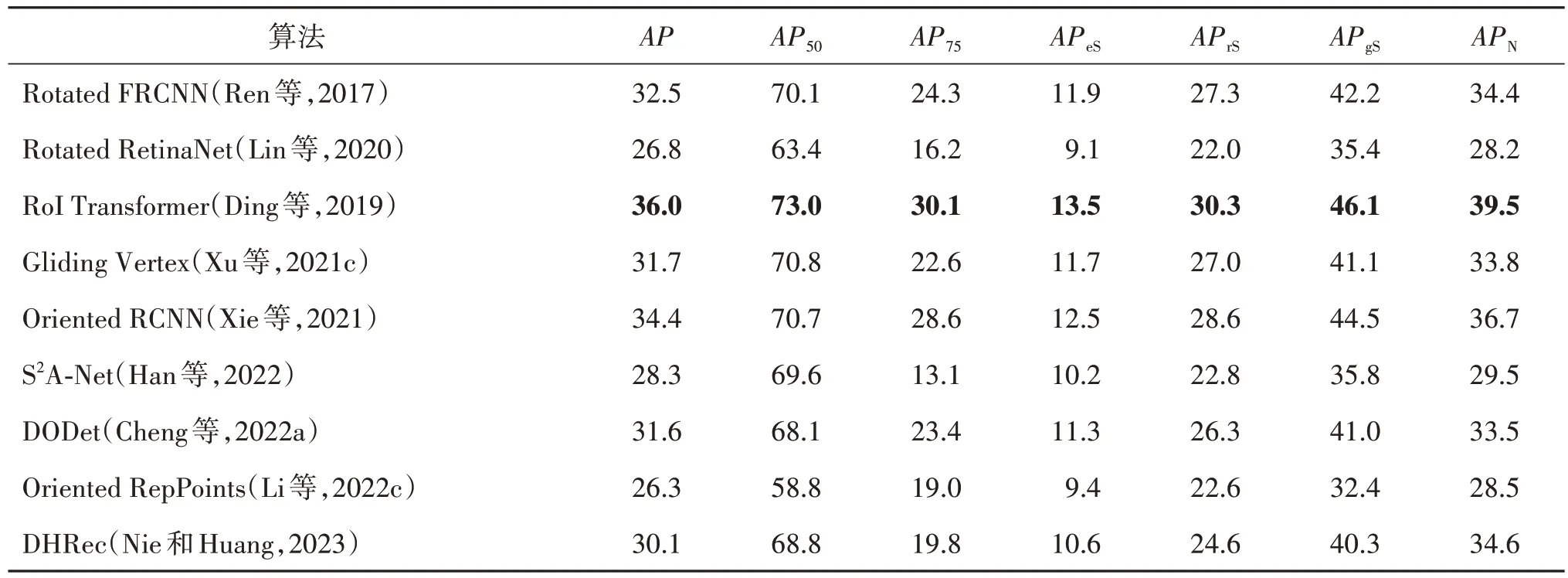

为了对光学遥感图像小目标检测算法进行更直观的比较评估,本小节分析领域内代表性方法在SODA-A 数据集上的表现,并对实验结果进行定性和定量分析,以期为之后的相关算法设计提供参考。

SODA-A 数据集分为训练集、验证集和测试集,分别包含344 228、231 439 和296 402 个实例。根据面积不同,这些实例分为S(small)和N(normal)两个面积集合,对应的面积区间分别为(0,1 024]和(1 024,2 000]。考虑到检测难度随着目标面积变小骤然上升,Small 进一步分为eS(extremely small)、rS(relatively small)和gS(generally small)3 个子集,对应的面积区间分别为(0,144]、(144,400]和(400,1 024](400,1 024]。SODA-A 数据集采用COCO(common objects in context)数据集(Lin等,2014)的评估方式,对small 面积类别内目标多个IoU(从0.5~0.95,以0.05 为间隔)阈值下的平均精度(average precision,AP)取平均。AP 指标用于评估检测算法的综合质量,计算该指标需要得到不同检测置信度下的准确率(precision)和召回率(recall),具体为

式中,FN(false negative)表示漏检目标数量,TP(true positive)表示正确目标数量,FP(false positive)表示虚警目标数量。

TP和FP的判断依赖于IoU阈值的选取。通过改变IoU阈值,即可获得P-R曲线。最终,AP计算为

受COCO 数据集启发,除提供总AP以及IoU 分别在0.5 和0.75 阈值下的AP以外,SODA-A 还提供了各个面积的AP。所有算法均在SODA-A训练集上完成训练,然后在SODA-A 测试集上进行评估,整体的性能表现如表2 所示,所有模型均采用ResNet-50(He等,2016)为主干网络。

表2 主流光学遥感图像小目标检测算法在SODA-A数据集上的性能对比Table 2 Performance comparison of several representative small object detection methods for optical remote sensing images on SODA-A dataset /%

可以看到,得益于多阶段的回归策略,RoI Transformer(Ding 等,2019)取得了最好的结果。以Faster RCNN 为基础模型,添加角度预测分支的Rotated FRCNN(rotated faster RCNN)(Ren 等,2017)表现不俗,再次印证了Faster RCNN强大的适应能力和鲁棒性。而改进倾斜目标表示方式的算法Gliding Vertex(Xu 等,2021c)、Oriented RCNN(Xie 等,2021)和 DODet(dual-aligned oriented detector)(Cheng 等,2022a)的性能参差不齐。具体说来,以水平框为基础,预测4 个顶点偏移量的Gliding Vertex 虽然可以提升低IoU 阈值下的检测效果,但由于目标尺寸很小,基于顶点的偏移量的轻微波动反而会降低模型在高IoU 下的性能。DODet 通过预测面积和尺度因子隐式地完成目标尺寸的预测,这种方式并不适合长宽较小且接近的小目标检测任务,因而整体性能逊色于Rotated FRCNN。对于单阶段检测器,Rotated RetinaNet(Lin 等,2020)的表现远远落后于两阶段算法。本文认为,这种性能差距根源于前、背景样本不平衡以及特征不对齐问题,由于目标区域很小,样本不平衡导致的模型优化困难会被进一步放大。S2A-Net(single-shot alignment network)(Han 等,2022)通过对齐锚框和目标区域的特征部分缓解了单阶段检测算法的问题,因而其性能优于Rotated RetinaNet,但仍然与双阶段算法存在较大差距。Oriented RepPoints(Li 等,2022c)利用点集来表示目标,结果表明这种表示方式对于光学遥感图像中的小目标并不友好。DHRec(double horizontal rectangles)(Nie 和Huang,2023)通过两个水平框的目标表示方式缓解了旋转目标检测中常见的角度周期性变换问题,在单阶段检测器中表现不俗。

3.2 SAR图像

3.2.1 常用数据集

本节回顾公开的合成孔径雷达(SAR)小目标检测数据集。SAR 图像由SAR 系统产生,是一种主动式的对地观测系统,有HH(horizontal horizontal)和HV(horizontal vertical)等不同极化方式,因为回波强度不同,分别包含了不同特征的信息。SAR 不受气候和云雾限制,相较光学传感器可以全天时全天候工作。本文总结了近年来公开的SAR 目标检测数据集的数据特性(如表3 所示),并对具有代表性的数据集进行阐述。

表3 SAR图像小目标检测数据集Table 3 Public datasets for small object detection of SAR images

1)SSDD 数据集。SSDD 数据集发布于2017 年,是面向舰船目标检测的第一个公开的SAR 数据集,数据来源为RadarSat-2,TerraSAR-X 和Sentinel-1 卫星,由1 160幅500 × 500像素的SAR 图像组成,图像分辨率大小在1~15 m 的范围之间。数据集采用水平框标注了2 456艘舰船目标,SSDD+在其基础上增加了旋转框标注。该数据集图像信息丰富,拥有不同海况、不同海域和不同舰船尺寸等多种条件下的成像结果。此外,该数据集包含非常典型的难检测目标,如特征不明显的小型舰船、港口停泊的密集船只等,也为难例挖掘任务提供了研究样本。

2)AIR-SARShip 数据集。AIR-SARShip 数 据集的1.0 版本发布于2019 年12 月,数据来源为高分3 号卫星单极化模式下的31 幅SAR 图像。选取的图像大小为3 000×3 000 像素,分辨率为1 m,包含不同气候条件下的港口、岛屿、悬崖和海平面等多种场景。数据集采用水平框标注512 个目标。根据Zhang 等人(2020)的统计,约94%的目标框大小占据全图像素比例 ≤3.29%,即小目标占比较大。

3)AIR-SARShip-2.0 数据集。在1.0 版本的基础上加入了更多数据,形成了一套包含300 幅SAR图像的基于高分3 号卫星数据的数据集。标注信息依然为舰船目标的位置,并通过了专业判读人员的查验。

4)HRSID 数据集。HRSID(high-resolution SAR images dataset)数据集发布于2020 年7 月,来源于Sentinel-1 和TerraSAR-X 卫星数据,包括0.5 m、1 m和 3 m 几种不同分辨率的SAR 图像,包含不同海况下的海域和沿海港口场景。数据集共5 604 幅800×800 像素的SAR 图像,极化方式为HH、HV 和VV(vertical vertical)。该数据集面向舰船实例分割和舰船目标检测任务,共16 951个舰船目标,其中超过99%的目标在图中像素占比≤3.29%,相比AIRSARShi-1.0小目标占比更大。

5)SAR-ACD 数据集。SAR-ACD(SAR aircraft classification dataset)数据集发布于2022 年,基于11 幅高分3 号下1 m 分辨率的SAR 图像进行构建,涵盖了上海虹桥机场和北京首都国际机场等区域不同时相的单极化SAR 信息。数据集中共标注了4 322 架飞机目标,并细分为20 个细粒度类别。该数据集包含复杂的时空场景,同时飞机类别多样,实例大小差异大,使得基于该数据集的分类检测任务有较大的挑战性。部分数据集的标注可视化如图6所示。

图6 SAR图像小目标检测常用数据集标注可视化Fig.6 Annotation visualization of small object detection SAR datasets((a)SSDD+;(b)HRSID;(c)AIR-SARShip-1.0;(d)SRSDD-v1.0;(e)RSDD-SAR;(f)SAR-ACD)

3.2.2 基于AIR-SARShip的主流算法性能评估

为了对SAR 图像小目标检测算法进行更直观的比较和评估,本文分析了领域内代表性方法在AIR-SARShip 数据集上的表现,以期为之后的相关算法设计提供参考。AIR-SARShip 采用准确率、召回率、F1以及AP来评估不同算法的性能水平。F1指标表示准确率和召回率的调和平均值,具体为

在AIR-SARShip 数据集中的21 幅影像上进行训练,余下的10 幅影像用于测试。不同算法在测试集上的性能表现如表4所示。从表4可以观察到,不同算法间的性能差异较大。Faster RCNN(Ren 等,2017)在该数据集上的平均精度指标为78.56%,准确率、召回率以及F1指标分别为76.61%、79.74%和78.14%。RetinaNet(Lin 等,2020)的各项指标与Faster RCNN 相近,平均精度指标甚至稍微优于Faster RCNN,但是单阶段检测方法YOLOv3(Redmon 和Farhadi,2018)和无锚框检测方法FCOS(Tian等,2022)呈现出较大的性能衰减,平均精度指标分别下降了13.13%和10.17%。

表4 主流SAR图像小目标检测算法在AIR-SARShip数据集上的性能对比Table 4 Performance comparison of several representative small object detection methods for SAR image on AIR-SARShip dataset /%

上述结果充分说明了SAR 图像相比光学图像在小目标检测上具有更大的挑战性。为了提升SAR小目标的检测精度,DCMSNN(densely connected multiscale neural network)(Jiao 等,2018)基于Faster RCNN 设计了密集连接网络处理多尺度和多场景的SAR 船舶目标,实现了准确率和召回率的提升。进一步考虑到SAR 成像机理,相似散射功率舰船目标的边界干扰容易导致特征错位从而影响定位精度,FBRNet(feature balancing and refinement network)(Fu 等,2021a)设计了注意力导向的平衡金字塔模块和特征细化模块,实现了复杂场景中更优的多尺度船舶检测性能,平均精度指标达到了83.62%。SSGENet(spatial shuffle-group enhance)(Cui 等,2021)则是考虑到SAR 图像中复杂的背景和杂波导致的大量虚警问题,基于关键点定位目标的思路,设计了注意力模块抑制噪声并提取更强的语义特征,准确率和召回率分别达到了86.35%和85.38%,平均精度指标进一步提升到85.28%。

综上所述,相比于通用的算法模型,有必要针对SAR复杂场景下小目标存在的挑战和难题进行有针对性的网络结构设计,实现算法的检测性能和应用效能的提升。

3.3 红外图像

3.3.1 常用数据集

数据集在深度学习中占据着非常重要的地位,一个高质量的数据集往往能够提高模型训练的质量和预测的准确率。本小节回顾领域内的一些公开数据集,总结其数据特性(如表5 所示)并对最具代表性的数据集进行详细说明。

表5 红外图像小目标检测数据集Table 5 Public datasets for small object detection of infrared images

1)NUAA-SIRST 数据集。NUAA-SIRST 数据集包含427幅图像,其中包括480个实例。为了避免训练集、验证集和测试集之间的重叠,只从每个红外序列中选择1幅具有代表性的图像。NUAA-SIRST除了具有短波长和中波长的红外图像外,还包括950 nm波长的红外图像。数据集中许多目标非常暗淡且隐藏在复杂的背景中。图7 展示了该数据集的部分标注示例进行可视化的结果。

图7 NUAA-SIRST数据集标注可视化Fig.7 Annotation visualization of NUAA-SIRST dataset

2)ITTDAT 数据集。ITTDAT 数据集是一个面向红外时敏目标检测跟踪,以车辆为探测目标,以地面场景为探测背景的图像序列数据集。共21 750帧图像,89 174 个目标,组成了87 段视频序列、393 段目标轨迹。

3)IDATDAT 数据集。IDATDAT 数据集是一个以地面、天空为背景的小飞机目标检测跟踪数据集。该数据集面向低空飞行的小飞机目标检测跟踪应用,获取场景涵盖了天空、地面等背景,共计22 段数据、30条航迹、16 177帧图像、16 944个目标。

4)IRSTD-1k数据集。IRSTD-1k数据集由1 001幅红外图像组成,图像大小为512×512 像素。包含了无人机、动物、船只和车辆等不同种类的小目标,背景涵盖了海洋、河流、田野、山区、城市和云等,并伴有大量复杂噪声。

5)NUDT-SIRST 数据集。NUDT-SIRST 数据集包含了城市、田野和海洋等背景场景。每幅图像均为不同目标与真实背景合成,数据集中约有37%的图像包含不少于2 个目标,27%的目标占据整个图像的面积不超过0.01%。

6)SIMTD 数据集。SIMTD 数据集是一个基于复杂背景的运动目标检测半仿真数据集。该数据集面向空中红外探测设备远距离探测空中飞行目标应用,共计350 段数据、150 185 帧图像,涵盖了天空、水面、植被和建筑物等多种场景。为了进一步模拟被探测目标的不同运动情况,SIMTD 数据集采用分段拟合的方式,通过设置不同复杂程度的目标运动轨迹,实现对不同灰度分布、不同信号强度的小运动目标进行仿真,并高质量地嵌入图像背景中。

3.3.2 基于NUAA-SIRST的主流算法性能评估

为了对红外图像小目标检测算法进行更直观的比较和评估,本文以NUAA-SIRST 数据集为训练数据集,然后以SIRST 测试集作为性能测试的数据集,选取领域内的代表性方法,以交并比、归一化交并比(normalized intersection over union,nIoU)、检测率(probability of detection,Pd)和虚警率(false-alarm rate,Fa)作为评价指标,全面评估在面对红外图像小目标时的性能表现,结果如表6 所示,以期为之后的相关算法设计提供参考。

表6 主流红外图像小目标检测算法在NUAA-SIRST数据集上的性能对比Table 6 Performance comparison of several representative small object detection methods for infrared image on NUAA-SIRST dataset /%

红外图像目标检测的评价指标不同于光学图像目标检测任务常采用的的AP指标。归一化交并比、检测率和虚警率的计算分别为

式中,N是样本总数,TP[·]表示正确预测的正样本数,T[·]和P[·]分别表示正确预测的样本数量和预测为正样本的数量。

式中,Pd表示正确预测目标数(Npred)与所有目标总数(Nall)的比值。

式中,Fa表示错误预测的目标数(Nfalse)与所有目标总数的比值。

由表6 可以看到,ISNet(infrared shape network)(Zhang 等,2022b)在所有评价指标方面都取得了最好的性能,在NUAA-SIRST 数据集上的IoU,nIoU,Pd,Fa指标分别为80.02%,78.12%,99.18%,4.924%。这是因为其引入了两个新的模块,即双向注意力聚集模块和受泰勒有限差分启发的边缘块。其中双向注意力聚集模块可以促进不同层级之间的特征融合,从而提升深层特征的细节信息,如形状的表达能力;受泰勒有限差分启发的边缘块能够提取精细的的边缘特征,可以帮助网络预测精确形状的目标掩码。ALCNet(attentional local contrast networks)(Dai 等,2021a)和ACM(asymmetric contextual modulation)(Dai等,2021b)也取得了不错的结果,这说明将低级的细节信息嵌入到高级特征中可以适当提高小目标的显著性,使之不会完全被背景淹没。MdvsFA(miss detection vs.false alarm)(Wang 等,2019a)将红外小目标的检测问题分解为抑制漏检和抑制虚警这两个子任务,并通过对抗性学习联合求解这两个子任务。结果表明,这种算法达到的性能有限。这是由于目标过小、特征太弱,网络无法提取到足够的特征信息,因而整体性能明显逊色于ISNet。MSLSTIPT(multiple subspace learning and spatial-temporal patch-tensor)(Sun 等,2021)、Top-Hat(Bai 和Zhou,2010)、RIPT(reweighted infrared patch tensor)(Dai 和Wu,2017)、PSTNN(partial sum of the tensor nuclear norm)(Zhang 和Peng,2019)、NRAM(nonconvex rank approximation minimization)(Zhang等,2018b)和TLLCM(Chen 等,2014)均是传统的方法,并未使用深度学习,因此检测结果明显低于基于深度学习的方法。

4 遥感影像小目标检测应用现状

在深度学习的驱动下,小目标检测已取得了重大突破,并广泛应用于国防安全、智能交通和工业自动化等多个领域。本文结合小目标检测在上述3 个领域数据的成像特点,选取智慧交通、港口目标监测、空中精确制导以及远海移动目标跟踪4 种典型的小目标检测应用场景进行介绍。

4.1 智慧交通

5G 和基于视觉的智能感知技术的飞速发展,使得遍布大街小巷的摄像头从以往单一的视频捕获设备摇身一变,成为具备一定信息处理能力的“智慧之眼”。同时,高度可变且部署便捷的无人机也从另一个视角为城市交通提供了辅助决策信息,为智慧交通构建提供支撑。但是,由于目标尺寸存在差异,实例之间的相互遮挡以及拍摄距离增加带来的尺度衰减,场景内大量小目标的精确感知成为构建智能交通监控系统不可或缺的一部分,这也催生了基于小目标检测的交通场景智能感知系统(He 等,2021;Sun 等,2022a),通过提供场景内的交通信息,辅助城市交通管理决策。此外,基于边缘设备开发可以实时运行的小目标检测模型,构建基于监控设备的交通状态实时分析系统也是一个热点应用方向(Mhalla等,2019)。

4.2 港口目标检测

SAR 采用的成像波长较长,可以绕过云层中的粒子进行传播,足以应对全球复杂多变的气候条件,特别是在海岛和海边等常年阴雨、云层笼罩的恶劣环境下具有突出作用。其中港口船舶目标检测是SAR的典型应用方向,近些年有很多的相关研究(Fu等,2021a;Cui 等,2021)。在实际应用中,港口船舶目标检测过程主要分为数据处理、发现目标和鉴别真伪(徐丰 等,2020)。通过模糊去除、不同的量化方式等,提高不同目标之间的特征区分度。不同船舶目标的尺寸变化较大、停靠角度任意以及密集排列,加之SAR 本身特性的问题,目标之间易发生重叠、遮掩和融合等,目前主要基于斜框的目标检测方法来发现目标(Sun 等,2022f,e)。港口周边具有很多与船舶散射强度相似并且几何形状特征相同的目标,例如船厂码头、近岸岛礁和厂房设施等,需要检测器具有较强的分辨能力,能精准地将目标与非相关目标进行区分。

4.3 空中精确制导

相比于可见光系统和雷达系统,红外系统具有全天时全天候工作、穿透性强、作用距离较远、隐蔽性高以及可识别伪装等许多突出优点。因此,红外图像小目标检测常应用于空中精确制导。采用先进的图像信息处理技术,能在复杂的战场环境和背景干扰下,对目标进行自动识别,并自动选择命中点,提高毁伤效果。红外制导技术的一个分支是成像制导技术,其利用红外探测目标及背景的红外辐射如实地显示出目标及其背景的“热”图像,并对目标图像进行捕获和跟踪,引导武器攻击目标。QN-202 是我国研制的一款便携式红外成像制导微型战术导弹,配有红外成像引导头,采用红外成像制导系统,能够自动搜索和跟踪目标,动力系统为两个固体火箭发动机,成本低廉。导弹还采用了图像识别技术,当目标锁定按钮启动后,导弹会记住目标图像,飞行中不断修正弹道,直至命中目标。

4.4 海上移动目标跟踪

地球海洋覆盖面积大,采用成像卫星是监测海洋状态的手段之一。其中,海上移动目标跟踪是重要的研究方向,在民用与军事领域中具有广泛的应用(孙显 等,2022;Yang 等,2018;Fu 等,2021b,2020)。由于海洋天气变化复杂、数据样本稀少等问题,单一模态对目标精准检测识别具有很大难度,利用多模态遥感图像解译手段具有很大的应用前景。海上目标相对海洋背景极度稀疏,目标捕获难度大,一般采用低分辨率宽幅成像手段,目标特征不显著,目标在不同模式影像上的特征具有互补性和差异性。因此,实际应用中可利用不同模态之间的数据对目标进行建模,其方法主要分为多模态对齐、多源融合以及多模态数据表示等,在分辨率、光谱性等多个方面得到增强,以构建目标的整体特征,提高目标的检测能力(Sun等,2022b)。

5 发展趋势与展望

深度学习的发展以及专用于小目标检测的开源数据集为遥感图像小目标检测带来了曙光,但相比通用目标检测任务中的大中尺寸目标的检测精度,小目标仍然难以望其项背,极大制约了检测算法的实际落地。基于已有研究和相关实验分析,展望遥感影像小目标检测任务,潜在的几个未来发展方向如下:1)适用于小目标相关下游任务的特征提取网络。众所周知,特征表示的良好与否直接影响着后续的任务精度。现有小目标检测算法均利用在通用目标检测任务上大放异彩的主干网络如ResNet 进行特征提取,这些网络通过池化等下采样操作减少空间维度冗余,却不可避免地造成小目标的信息丢失,而这种丢失很难通过后续操作复原。因此,设计有效的特征提取网络对于小目标相关任务至关重要。2)面向遥感影像小目标检测的大规模数据集。当前,无论是自然图像还是遥感图像小目标检测领域,性能优异的算法几乎都依赖于深度学习。如前所述,深度学习算法在训练时需要“喂入”大量的标注数据,而遥感影像小目标检测领域尚缺乏拥有良好标注的大规模数据集,尤其是对于SAR 图像和红外图像这两种常用于军事领域侦察的数据,这在很大程度上制约着该领域的进一步发展。3)多模态遥感数据协同的小目标检测算法。小目标算法性能羸弱的根本原因在于可用信息极少,如果能够丰富信息来源,就能在一定程度上缓解模型由于缺乏判别性信息无法准确决策的问题。具体到遥感影像,随着星座组网的进行和卫星多种载荷的搭配,不同模式的卫星影像在时间密度和空间密度上显著提升,通过不同模态数据之间的互补及协同应用,有效利用各模态之间的信息进行优势互补,克服不同模态之间在时间和空间上的差异和信息不足短板,开发基于多模态数据的遥感影像小目标检测算法是未来发展的一个重要趋势。4)更合理灵活的性能评估标准。目前的小目标检测评价体系大多沿用通用目标检测领域的评估指标,并不适用于小目标检测任务。因而设计更加灵活且合理的小目标检测评价标准,不仅能够进一步优化模型训练,也能够准确反映各算法的真实性能,引导领域的良性发展。

致 谢本文由中国图象图形学学会遥感图像专业委员会组织撰写,该专委会链接为http://www.csig.org.cn/detail/2446。