基于改进YOLOv5算法的农田杂草检测

王宇博 马廷淮 陈光明

摘要:随着智慧农业技术和大田种植技术的不断发展,自动除草具有广阔的市场前景。关于除草剂自动喷洒的有效性,农田杂草的精准、快速地识别和定位是关键技术之一。基于此提出一种改进的YOLOv5算法实现农田杂草检测,该方法通过改进数据增强方式,提高模型泛化性;通过添加注意力机制,增强主干网络的特征提取能力;通过改进框回归损失函数,提升预测框的准确率。试验表明,在芝麻作物和多种杂草的复杂环境下,本文方法的检测平均精度均值mAP为90.6%,杂草的检测平均精度AP为90.2%,比YOLOv5s模型分别提高4.7%和2%。在本文试验环境下,单张图像检测时间为2.8 ms,可实现实时检测。该研究内容可以为农田智能除草设备提供参考。

关键词:杂草检测;YOLOv5;数据增强;注意力机制;回归损失函数

中图分类号:S451: TP391.4

文献标识码:A

文章编号:2095-5553 (2023) 04-0167-07

Abstract: With the continuous development of intelligent agricultural technology and field planting technology, automatic weeding has a broad market prospect. Regarding the effectiveness of automatic herbicide spraying, the precise and rapid identification and positioning of farmland weeds is one of the key technologies. An improved YOLOv5 algorithm to realize weed detection can improve the model generalization of the backbone network, and improve the accuracy of the prediction box by improving the box regression loss function. The experiment shows that under the complex environment of sesame crops and multiple weeds, the mean average detection accuracy of this method is 90.6%, and the average detection accuracy of weed is 90.2%, which were higher than the YOLOv5s model by 4.7% and 2%, respectively. In the test environment of this paper, a single image detection time is 2.8 ms, enabling real-time detection. The research content can provide a reference for intelligent weeding equipment in farmland.

Keywords: weeds detection; YOLOv5; data augmentation; attention mechanism; regression loss function

0 引言

农田杂草是影响农作物产量和质量的重要因素之一。杂草与农作物争夺阳光、生长空间,土壤中营养和水分。此外,将杂草作为宿主的病虫害也会影响农作物的生长[1]。常见除草方式的缺点如下:人工除草法,耗费大量人力且效率较低;机械除草法,容易造成农作物的人为损害;铺设地膜法[2],经济成本较高,适用于大蒜等高收益农作物;全覆盖式喷洒除草剂法[3],雖然可以防控杂草,但残留药物会造成土壤肥力下降和环境污染,降低农作物品质。随着劳动力成本的不断增加,以及对食品安全和环境保护关注度的增强,靶向喷射除草剂法[4]成为农业除草技术研究的热点方向。

近年来,基于深度学习的目标检测不断发展。姜红花等[5]针对田间复杂环境中杂草分割精度低的问题,提出了基于Mask R-CNN[6]的杂草检测方法。该方法在玉米和杂草数据集上测试,mAP为85.3%,单样本检测时间为280 ms。樊湘鹏等[7]为解决棉花苗期杂草种类多、分布状态复杂的问题,选定VGG16[8]作为特征提取网络,提出了一种基于改进的Faster R-CNN[9]杂草识别与定位方法。该模型在棉花幼苗和杂草数据集上试验,mAP为94.2%,单幅图像检测时间为261 ms。权龙哲等[10]为了精准识别玉米秧苗与农田杂草,提出了一种基于YOLOv4[11]的杂草检测模型。该方法在玉米苗和杂草数据集上试验,F1值为0.828,检测时间为287 ms。相较于传统的机器学习方法,上述工作取得了一定进展,但与实际场景所需的精度高、速度快及成本低等需求仍有差距。

为推动杂草检测在智慧农业中的应用,本文提出一种改进YOLOv5的杂草检测方法。

1 目标检测的相关工作

1) 主流目标检测算法。目标检测可分为两阶段检测和一阶段检测方法。两阶段检测方法先推荐目标边界框,再对目标进行识别分类。其主流模型有Mask R-CNN、Faster R-CNN等,检测精度相对较高,但是检测速度较慢。一阶段检测方法为端到端地生成目标边界框和分类。其主流模型包括SSD[12]和YOLO[13]系列等,检测速度较快,但是检测精度较低。目前YOLOv5在业界应用广泛,它能实现检测速度和精度两者的平衡。

2) 目标检测改进的相关工作。数据增强可以扩大训练集规模,增加训练样本的多样性,从数据层面解决过拟合问题,提高模型的泛化性。常见的数据增强方式通过变化拍摄中光线、角度、时间,或者对训练图片进行裁剪、翻转、平移、色域调整等。mosaic数据增强有较好的效果,它先从训练集随机读取4张图片,再将4张图片和标注框拼接成1张图片。注意力机制对输入图片的各个部分,设置不同的权重,能从大量信息中筛选出重要的信息。

目标检测的主干网络可引入多种注意力机制方法:SE[14]、CBAM[15]、ECA[16]。框回归损失函数是目标检测精度计算的重要因素,检测模型大多使用IoU函数。此外,常见框回归损失函数有以下几种方法:GIoU[17]、DIoU[18]、CIoU[18]。

2 改进的YOLOv5算法

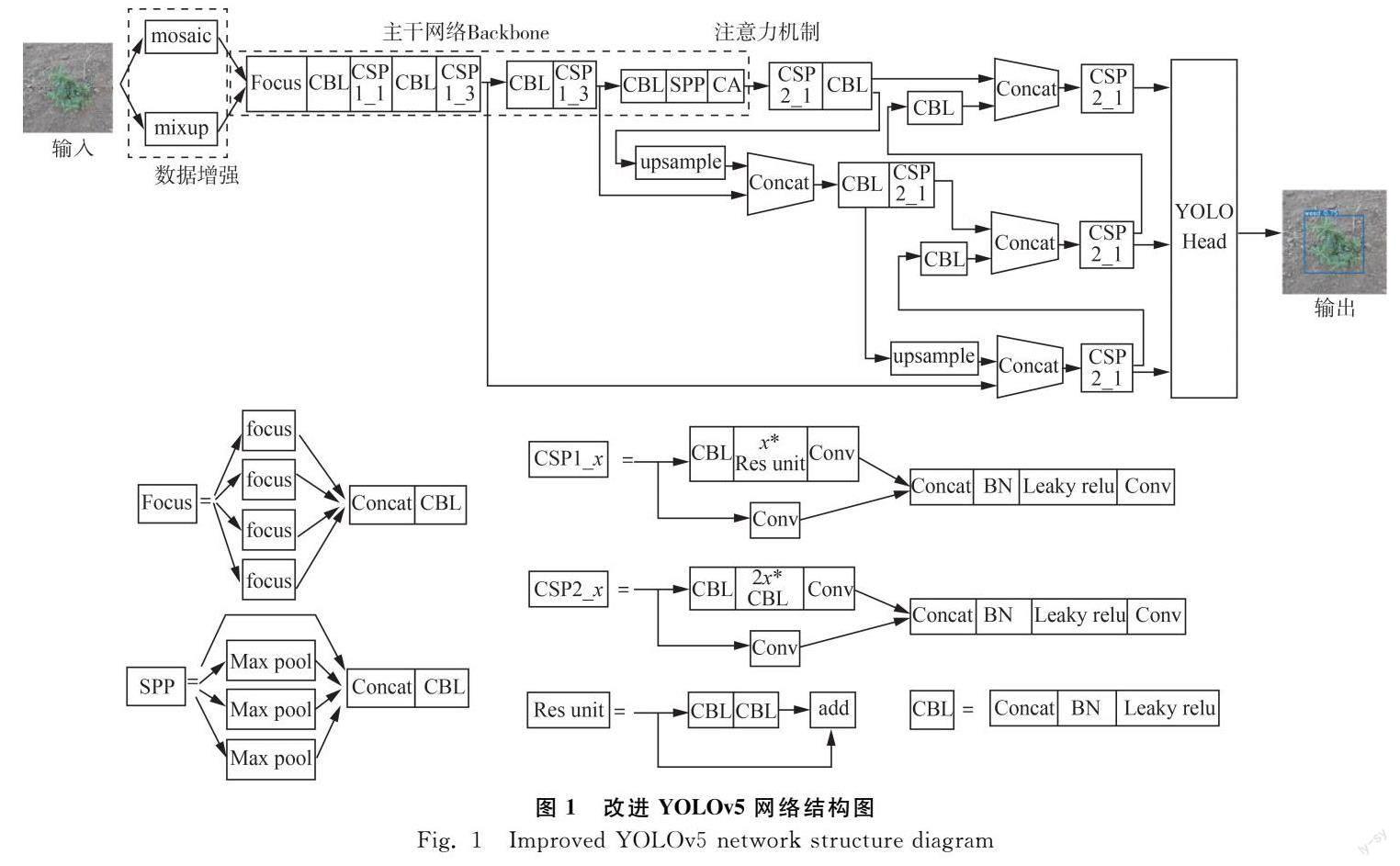

改进网络如图1所示。

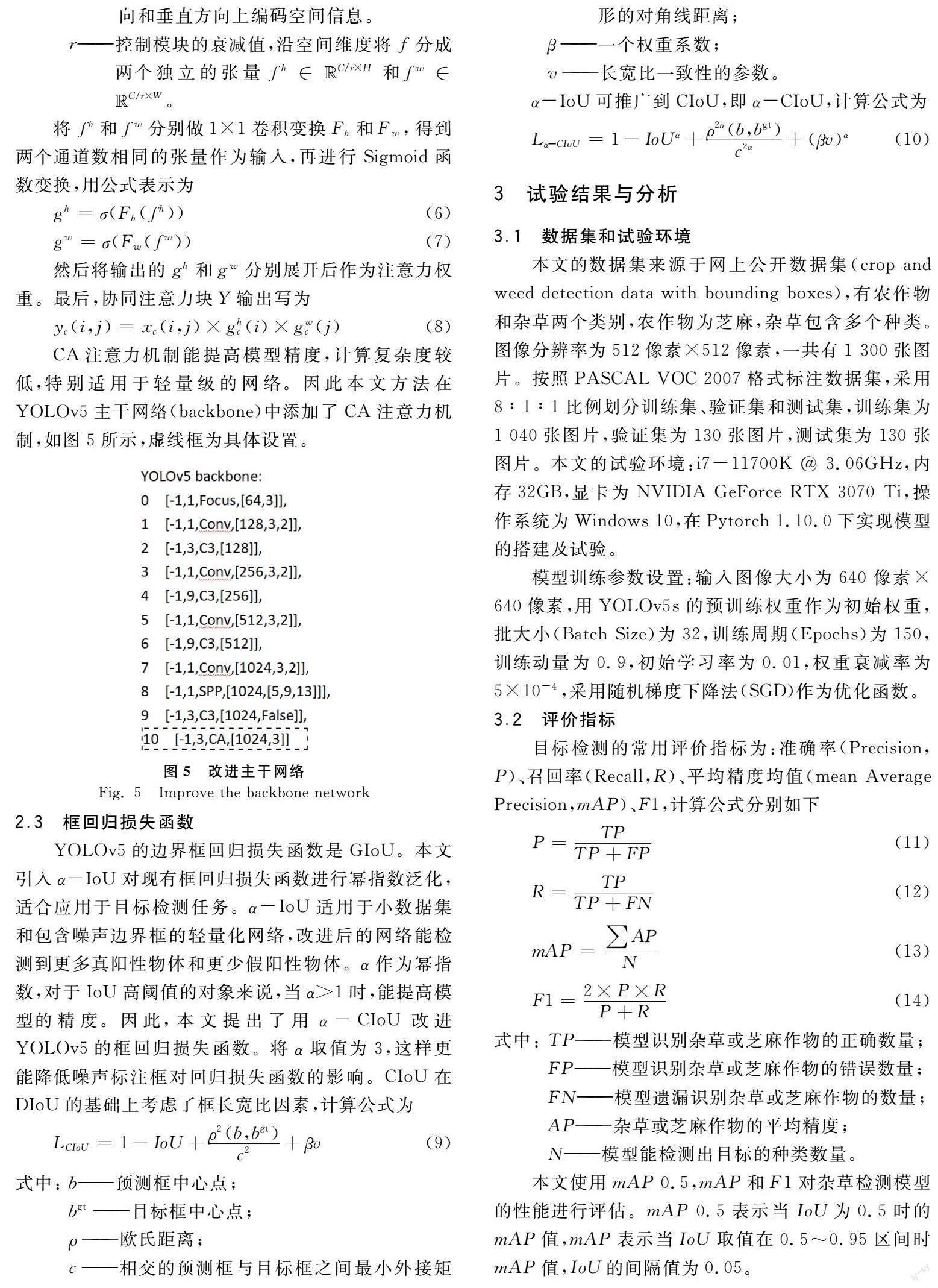

本文方法主要有三个模块:数据增强模块,将训练集按比例分别进行mosaic和mixup[19]数据增强,然后通过主干网络(Backbone)提取特征;注意力模块,在主干网络中添加协同注意力机制(Coordinate Attention[20],CA),关注位置信息对于特征图的影响;框回归损失函数模块,将α-IoU[21]和CIoU组合成α-CIoU,替换YOLOv5的GIoU。当α=3时,能更有效降低噪声标注框对回归损失函数的影响,提高定位精度和增强鲁棒性。

2.1 数据增强模块

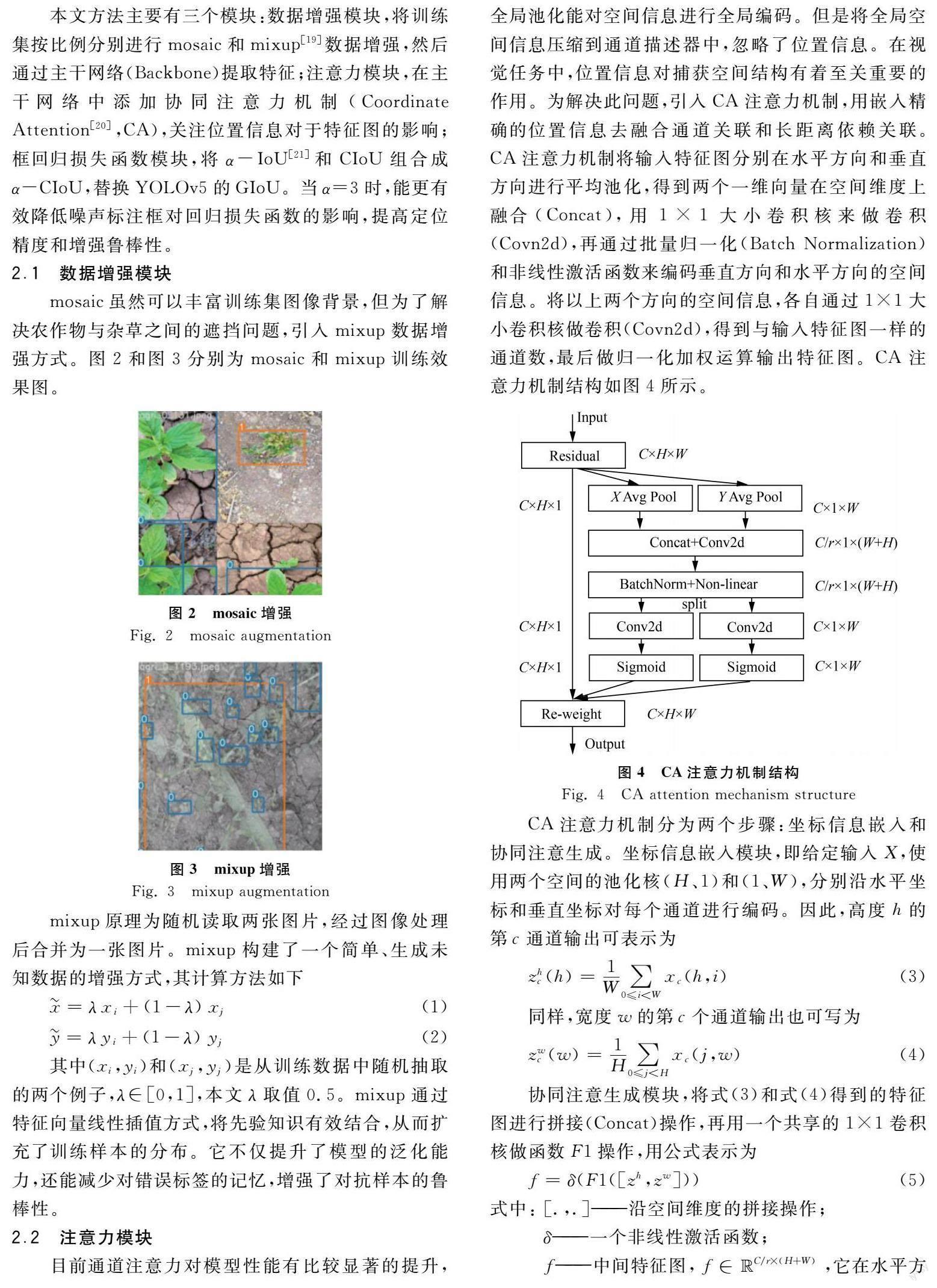

mosaic虽然可以丰富训练集图像背景,但为了解决农作物与杂草之间的遮挡问题,引入mixup数据增强方式。图2和图3分别为mosaic和mixup训练效果图。

3 试验结果与分析

3.1 数据集和试验环境

本文的数据集来源于网上公开数据集(crop and weed detection data with bounding boxes),有农作物和杂草两个类别,农作物为芝麻,杂草包含多个种类。图像分辨率为512像素×512像素,一共有1 300张图片。按照PASCAL VOC 2007格式标注数据集,采用8∶1∶1比例划分训练集、验证集和测试集,训练集为1 040张图片,验证集为130张图片,测试集为130张图片。本文的试验环境:i7-11700K @ 3.06GHz,内存32GB,显卡为NVIDIA GeForce RTX 3070 Ti,操作系统为Windows 10,在Pytorch 1.10.0下实现模型的搭建及试验。

模型训练参数设置:输入图像大小为640像素×640像素,用YOLOv5s的预训练权重作为初始权重,批大小(Batch Size)为32,训练周期(Epochs)为150,训练动量为0.9,初始学习率为0.01,权重衰减率为5×10-4,采用随机梯度下降法(SGD)作为优化函数。

3.2 评价指标

本文使用mAP 0.5,mAP和F1对杂草检测模型的性能进行评估。mAP 0.5表示当IoU为0.5时的mAP值,mAP表示当IoU取值在0.5~0.95区间时mAP值,IoU的间隔值为0.05。

3.3 不同數据增强的对比试验

从表1可看出,当训练集全用mosaic数据增强,mAP 0.5 值为85.9%,mAP值为51.1%,F1值为0.824。当YOLOv5全部使用mixup数据增强,mAP 0.5值为86.4%,mAP值为53.1%,F1值为0.823。由此可见,单独使用mosaic或mixup数据增强,模型精度值均不高。因此,将训练集划分一定比例进行mosaic和mixup数据增强,这样既可以提高模型的泛化性,又能解决杂草和农作物相互遮挡问题,提高模型的精度。设置mosaic的比例分别为0.9、0.7、0.5、0.3、0.1,同时设置mixup的比例分别为0.1、0.3、0.5、0.7、0.9,两者相对应的比例之和为1。经过对比试验得出,当设置mosaic和mixup比例为0.7和0.3时,mAP 0.5提升了3.8%,mAP提升了4.9%,F1提升了0.028。该配置下模型取得了最优值。

3.4 不同注意力机制的对比试验

考虑到模型检测精度和计算代价,本文引入了轻量级的CA注意力机制,与当前较先进的注意力机制作对比试验。由表2可知,在YOLOv5上添加SE注意力机制,mAP 0.5不变,mAP却下降了1.9%;在YOLOv5上添加CBAM注意力机制,mAP 0.5增加了0.6%,mAP和F1值都下降;在YOLOv5上添加ECA注意力机制,mAP 0.5和mAP均下降。

从以上四组试验结果分析,在YOLOv5网络上分别添加了不同注意力机制,模型的精度没有明显提高,反而下降。但是在YOLOv5上添加CA注意力机制,mAP 0.5增加了1.2%,mAP增加了1.3%,F1值增加了0.012。

3.5 不同回归损失函数的对比试验

YOLOv5模型的框回归损失函数为GIoU,为验证α-CIoU的性能,本文设计了4组对比试验,如表3所示。第一组试验,框回归损失函数分别设置为GIoU、DIoU和CIoU,试验结果表明CIoU的性能较优;同时本文引入了α-IoU,将它与常用的框回归损失函数相结合,分别为α-GIoU,α-DIoU和α-CIoU。α值作为幂指数,通常取值在1~9之间,将α分别取值为2、3和4后进行三组对比试验。经过以上四组对比试验得到最优设置,即框回归损失函数改进为α-CIoU(α=3),此时mAP 0.5比YOLOv5s提升了2.9%,mAP提升了3.9%。

3.6 消融试验

为了分析本文提出的改进方法对YOLOv5性能的影响,进行了消融试验。每组试验使用相同的训练参数,不同改进方法的检测结果如表4所示,“√”代表在模型中使用了相对应的改进策略,“×”代表在模型中未使用相对应的改进策略。

YOLOv5s-A使用α-CIoU 改进了框回归损失函数,mAP 0.5提升了2.2%;YOLOv5s-B在YOLOv5s-A的基础上,将70%的训练集进行mosaic数据增强,将剩余30%的训练集进行mixup数据增强,mAP 0.5提升了1.3%;YOLOv5s-C即本文方法,在YOLOv5s-B的基础上添加了CA注意力机制,mAP 0.5为90.6%,提升了1.2%。

3.7 不同模型的对比试验

为验证本文方法的性能,与YOLOv3、YOLOv5s+Mobilenet v3和YOLOv5s模型进行对比试验,试验结果如表5所示。YOLOv5s+Mobilenet v3模型是将主干网络替换为移动轻量化网络Mobilenet v3,这样可以缩减模型大小,单张图像推理时间是2.2 ms,但是mAP 0.5比本文方法降低了11.5%。本文方法与YOLOv5s模型相比,mAP 0.5提高了4.7%,杂草AP 0.5提高了2%,芝麻作物AP 0.5提高了7.2%,单张图像推理时间是2.8 ms。图6为本文方法和YOLOv5s检测结果的对比图。

4 结论

本文提出了一种基于改进YOLOv5的农田杂草检测算法,分别在数据增强、注意力机制和回归损失函数这三个方面做了改进工作。该方法在Nvidia GeForce RTX 3070Ti环境下,对于芝麻作物和多种杂草的数据集,mAP 0.5为90.6%,检测时间为2.8 ms。试验表明该方法检测精度高,推理速度快,有助于农田智能除草设备能准确、实时地检测目标。

1) 本文将YOLOv5s模型应用于农田杂草检测,并做了以下几个改进工作:引入mixup数据增强方式来提高模型泛化能力;添加轻量级CA注意力机制来增强主干网络的特征提取能力;使用α-CIoU来优化框回归损失函数。通过与目前较为先进的优化方法作对比试验,以及消融试验,验证了本文方法的性能。

2) 将本文方法与YOLOv3、YOLOv5s+Mobilenet v3和YOLOv5s模型进行对比试验。本文方法相较于YOLOv5s,mAP 0.5提高了4.7%,杂草AP 0.5提高了2%,芝麻作物AP 0.5提高了7.2%。

3) 今后将该方法应用到农田智能除草设备上,考虑在不降低模型检测精度的情况下,研究如何进一步减小模型规模和降低计算代价。

参 考 文 献

[1] Hasan A S M M, Sohel F, Diepeveen D, et al. A survey of deep learning techniques for weed detection from images [J]. Computers and Electronics in Agriculture, 2021, 184(3): 1680-1699.

[2] 姜延军, 岳德成, 李青梅, 等. 全膜双垄沟播玉米田选用除草地膜的适宜田间杂草密度研究[J]. 植物保护, 2018, 44(1): 110-115.

Jiang Yanjun, Yue Decheng, Li Qingmei, et al. Effects of covering weeding film on the suitable weed density in double-ridge maize fields with whole plastic-film mulching [J]. Plant Protection, 2018, 44(1): 110-115.

[3] 李香菊. 近年我國农田杂草防控中的突出问题与治理对策[J]. 植物保护, 2018, 44(5): 77-84.

Li Xiangju. Main problems and management strategies of weeds in agricultural fields in China in recent years [J]. Plant Protection, 2018, 44(5): 77-84.

[4] 王璨, 武新慧, 张燕青, 等. 基于双注意力语义分割网络的田间苗期玉米识别与分割[J]. 农业工程学报, 2021, 37(9): 211-221.

Wang Can, Wu Xinhui, Zhang Yanqing, et al. Recognition and segmentation of maize seedlings in field based on dual attention semantic segmentation network [J]. Transactions of the Chinese Society of Agricultural Engineering, 2021, 37(9): 211-221.

[5] 姜红花, 张传银, 张昭, 等. 基于Mask R-CNN的玉米田间杂草检测方法[J]. 农业机械学报, 2020, 51(6): 220-228, 247.

Jiang Honghua, Zhang Chuanyin, Zhang Zhao, et al. Detection method of corn weed based on Mask R-CNN [J]. Transactions of the Chinese Society for Agricultural Machinery, 2020, 51(6): 220-228, 247.

[6] He Kaiming, Gkioxari G, Dollar P, et al. Mask R-CNN [C]. Proceedings of the IEEE International Conference on Computer Vision (ICCV), 2017: 2961-2969.

[7] 樊湘鵬, 周建平, 许燕, 等. 基于优化Faster R-CNN的棉花苗期杂草识别与定位[J]. 农业机械学报, 2021, 52(5): 26-34.

Fan Xiangpeng, Zhou Jianping, Xu Yan, et al.Identification and localization of weeds based on optimized Faster R-CNN in cotton seedling stage [J]. Transactions of the Chinese Society for Agricultural Machinery, 2021, 52(5): 26-34.

[8] Simonyan K, Zisserman A. Very deep convolutional networks for large-scale image recognition [C]. In ICLR, 2015.

[9] Ren Shaoqing, He Kaiming, Girshick R, et al. Faster R-CNN: Towards real-time object detection with region proposal networks [C]. In NIPS, 2015.

[10] 权龙哲, 夏福霖, 姜伟, 等. 基于YOLOv4卷积神经网络的农田苗草识别研究[J]. 东北农业大学学报, 2021, 51(7): 89-98.

Quan Longzhe, Xia Fulin, Jiang Wei, et al. Research on recognition of maize seedlings and weeds in maize mield based on YOLOv4 convolutional neural network [J]. Journal of Northeast Agricultural University, 2021, 51(7): 89-98.

[11] Bochkovskiy A, Wan C Y g, Liao H. YOLOv4: Optimal speed and accuracy of object detection [C]. 2020 IEEE/CVF Conference on Computer Vision and Pattern Recognition (CVPR). IEEE, 2020.

[12] Liu Wei, Anguelov D, Erhan D, et al. SSD: Single shot multibox detector [C]. 2016 IEEE/CVF Conference on Computer Vision and Pattern Recognition (CVPR). IEEE, 2016.

[13] Redmon J, Farhadi A. YOLOV3: An incremental improvement [C]. 2018 IEEE/CVF Conference on Computer Vision and Pattern Recognition (CVPR). IEEE, 2018.

[14] Hu Jie, Shen Li, Sun Gang. Squeeze-and-excitation networks [C]. 2018 IEEE/CVF Conference on Computer Vision and Pattern Recognition (CVPR). IEEE, 2018.

[15] Woo S, Park J, Lee J Y, et al. CBAM: Convolutional block attention module [C]. 2018 IEEE/CVF Conference on Computer Vision and Pattern Recognition (CVPR). IEEE, 2018.

[16] Wang Qilong, Wu Banggu, Zhu Pengfei, et al. ECA-Net: Efficient channel attention for deep convolutional neural networks [C]. 2020 IEEE/CVF Conference on Computer Vision and Pattern Recognition (CVPR). IEEE, 2020.

[17] Rezatofighi H, Tsoi N, Gwak J Y, et al. Generalized intersection over union: A metric and a loss for bounding box regression [C]. 2019 IEEE/CVF Conference on Computer Vision and Pattern Recognition (CVPR). IEEE, 2019.

[18] Zheng Zhaohui, Wang Ping, Liu Wei, et al. Distance-IoU loss: Faster and better learning for bounding box regression [C]. In AAAI, 2020.

[19] Zhang Hongyi, Cisse M, Dauphin Y N, et al. mixup: Beyond empirical risk minimization [C]. In ICLR, 2018.

[20] Hou Qibin, Zhou Daquan, Feng Jiashi. Coordinate attention for efficient mobile network design [C]. 2021 IEEE/CVF Conference on Computer Vision and Pattern Recognition (CVPR). IEEE, 2021.

[21] He Jiabo, Erfani S, Ma Xingjun, et al. Alpha-IoU: A family of power intersection over union losses for bounding box regression [C]. 35th Conference on Neural Information Processing Systems (NeurIPS), 2021.