融合掩模和注意机制的CNN图像分类算法

李 伟,黄鹤鸣

(1. 青海师范大学计算机学院,青海 西宁 810008;2. 藏语智能信息处理与应用国家重点实验室,青海 西宁 810008)

1 引言

近年来,随着大数据和硬件计算能力的发展,神经网络在各个领域不断取得了突破性进展[1]。卷积神经网络(Convolution Neural Networks, CNNs)作为一种带有卷积计算的深层前馈型神经网络(Feedforward Neural Networks),可以更好地获取图像的空间位置等相关特征[2,3]。2017年,陈玉石等人提出使用不同的卷积神经网络提取异构特征的图像分类模型[4];Bartunov等人在2018年将注意力机制应用于卷积神经网络来提取图像特征[5],注意力机制通过引入新的参数来弥补模型的拟合能力;2019年,王培森等人认为单一的注意力机制不能充分提取图像的特征信息[6],故提出多通道视觉注意力机制的全卷积网络分类模型;同年,Li等人提出了双交叉熵损失函数概念,并将其应用到CNNs结构[7],该模型在小样本汽车库上取得了不错的分类效果;2020年9月,Pathak等人将深度迁移学习算法应用于CNNs,搭建出基于深度迁移学习的2019新冠肺炎病毒分类模型,并在此模型中使用十倍交叉验证来防止过拟合现象[8];同年12月,张祥东等人提出了一种结合扩张卷积与注意力机制的三维-二维串联卷积神经网络模型[9],利用三维卷积提取图像特征的同时,并采用二维卷积进一步提取高级空间语义信息,再通过引入扩张卷积增大卷积核感受野,构建了多尺度特征提取结构,最后,利用注意力机制使网络关注到较重要特征,并抑制噪声和冗余信息,有效提高了小样本训练条件下的分类精度。

经过不断地发展研究和改进,CNN具有良好的扩展性和鲁棒性。利用CNN进行图像分类时,能够比较快速且全面地提取空间位置相关特征,但会产生过拟合、梯度爆炸或梯度消失等问题。Dropout技术有效缓解了网络过拟合问题,本研究受图像自身特性的启发,提出了一种融合掩模和注意机制的CNN图像分类算法:使用基于掩模的预训练方法突出前景目标物体和去噪神经网络提取的去噪深度特征,降低了图像背景噪声和深度特征噪声的干扰,从而促使网络模型总框架更加稳定。并使用三种不同注意类型的激活函数进行充分实验,进一步提升了算法的性能。实验结果表明:将其算法应用于Corel-1000图像库时,分类精确度有了较大提升。

2 网络模型

为了更好地读取图像内容信息和提高图像分类精确度,构建了如图1所示的深度CNN网络模型总体框架。该框架模型共有四个卷积层:去噪深度特征层、深度特征解释层、特征抽象表示层、特征高级表示层。卷积层后各跟随一个池化层,池化是缩小高、长方向上的空间运算。后面是三层全连接层,相邻层的神经元全部连接在一起,输出的数量可以任意决定。最后采用应对多分类问题的softmax函数进行分类[10-12],其计算公式如下

图1 深度CNN网络模型总体框架

图2 去噪神经网络结构

(1)

exp(x)是表示ex的指数函数,假设输出层共有n个神经元,计算第k个神经元的输出yk。softmax函数的分子是输入信号ak的指数函数,分母是所有输入信号的指数函数的和。

图1中的去噪深度特征层由一个输入层和两个卷积层构成,用于提取去噪深度特征。CNN的卷积层依赖于网络分层学习上下文不变特征[4]:空间位置信息,这在图像分类和图像检索中都特别有用。

3 融合掩模和注意机制的CNN图像分类算法的核心思想

3.1 基于掩模的预训练方法

在神经网络的学习和训练过程中,由于特征维度比较高而训练样本有限,过拟合问题不可避免。同时,神经网络希望模型对没有包含在训练数据里的未观测数据也可以进行正确的识别。因此,在搭建复杂有效的网络模型时,寻找有效抑制过拟合的方法很重要。

本研究受图像自身特性的启发,提出了一种融合掩模的预训练方法。这种方法通过降低图像背景噪声的干扰,不仅可以对训练过程中出现的过拟合现象起到一定程度的抑制作用,而且更有助于提高算法的稳定性和健壮性。图像掩模处理是将原图中的每个像素和掩膜中的每个对应像素进行与运算。比如1 &1=1,1 &0=0等。一个3×3的图像与3×3的掩模进行运算,得到结果图3。

图3 图像的掩模处理过程图

基于掩模预训练方法的具体步骤是:首先,对图像做掩模处理,去掉背景,突出前景的目标物体,如图4所示;其次,使用掩模后的图像对网络进行首次预训练;最后,使用完整图像对神经网络进行第二次预训练。

图4 图像掩模处理后的效果图

基于掩模预训练方法中掩模图像的算法,用伪代码描述如下:

Begin

原始图像像素值存于矩阵OG;

二值化掩模矩阵数组MA;

掩模后图像像素值存于矩阵MG;

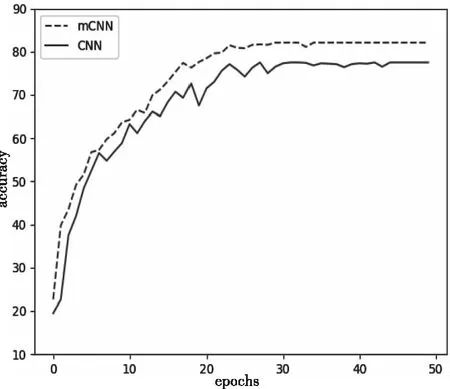

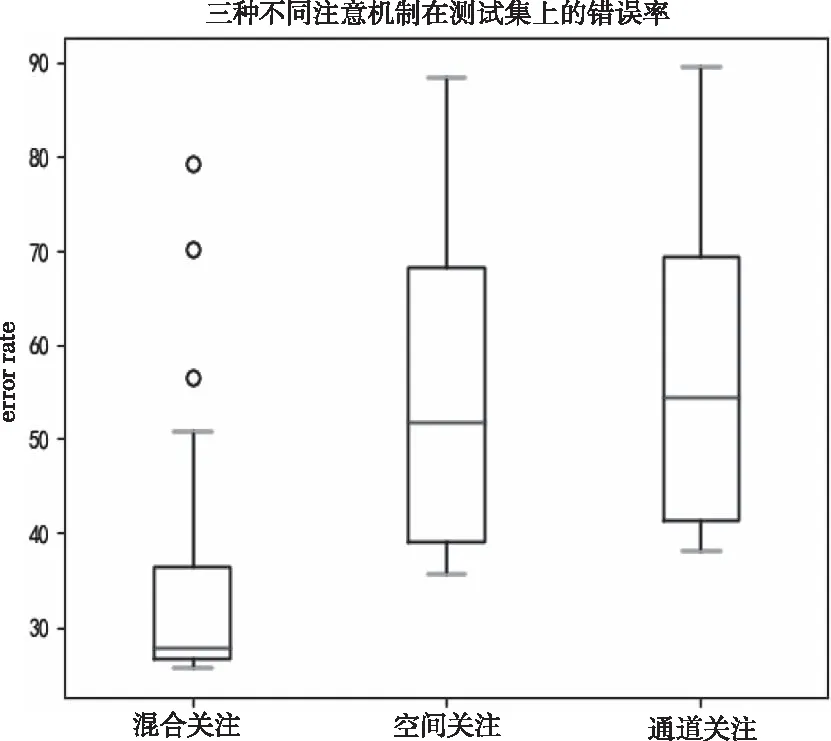

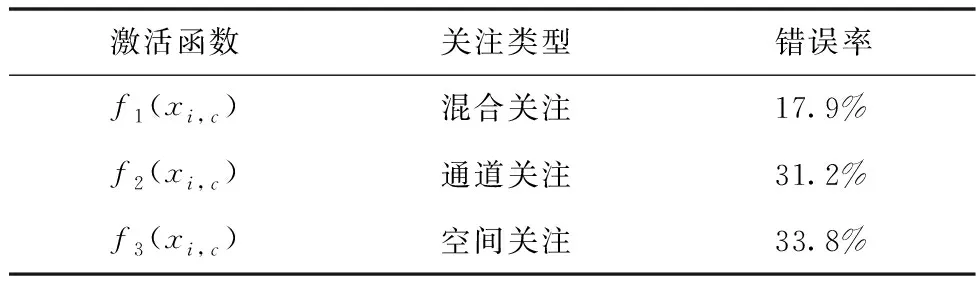

for(i=0;i for(j=0;j MG[i][j]=OG[i][j]*MA[i][j]; end for end for End 比例关注[13]或空间关注[14]只获取一种类型的关注,就需要通过权重共享或归范化对网络结构施加额外的约束。文献[15,16]研究了混合关注。混合关注在没有附加约束的情况下,通过改变不同的关注度,可以获得最佳性能的网络模型。由于ReLU函数具有单侧抑制作用,训练速度快,也能够更好地学习数据特征,所以使用了带有随机失活和数据增强的ReLU[17]混合关注、通道关注和空间关注三种类型的激活函数。混合关注f1是在没有施加额外约束的条件下,针对每一个通道和空间位置,使用激活函数ReLU。f1的计算公式如下 (2) 通道关注f2对所有通道内的每个空间位置的像素点执行L2标准化,达到移除空间信息的目的。f2的计算公式如下 (3) 空间关注f3的作用与通道关注f2相反,对每个通道的所有特征图进行标准化,移除通道信息仅保留空间信息。f3的计算公式如下 (4) 在式(2)-(4)中,i表示所有空间位置,c表示所有通道,meanc和stdc分别表示第c个通道的均值和标准差,xi表示第i个空间位置的特征向量。 实验使用的是Corel公司所提供的标准图像素材库Corel-1000,有10类子集,共包含1000幅图像。并且,网络模型中不同卷积层的参数设置如表1所示。 表1 各卷积层中的参数 在本研究中,使用交叉熵误差函数作为模型的损失函数[18]。同时,要使损失函数最优化,需要用到优化方法,实验采用Adam优化器[19],其更新步长的步骤可总结如下 1) 计算时刻t的梯度 gt=∇θJ(θt-1) (5) 2) 计算梯度的指数移动平均数: mt=β1mt-1+(1-β1)gt (6) 3) 计算梯度平方的指数移动平均数: (7) 4) 对梯度均值mt进行偏差纠正: (8) 5) 对梯度方差vt进行偏差纠正: (9) 6) 更新参数,默认学习率α=0.001: (10) 其中,ε=10-8,避免除数为0。 本研究将使用去噪神经网络提取深度特征作为输入的去噪卷积神经网络(Denoising Convolution Neural Network),称为DCNN;将基于掩模预训练方法的DCNN (mask-based Denoising Convolution Neural Network),称为mDCNN。各算法在测试集上的准确率见表2。 表2 CNN、DCNN和mDCNN在测试集上的准确率 从表2可以看出:由于DCNN使用了去噪深度特征作为输入,所以一定程度上提升了分类准确率。在此基础上,mDCNN在首次预训练时,不仅突出了图像中的目标物体,还降低了背景噪声的干扰。从而较大程度地提升了分类精度,mDCNN比CNN分类准确率提高了5.81%。这是因为mDCNN网络模型不仅使用了去噪深度特征,还掩蔽掉了图像的背景噪声,抑制了训练过程中出现的过拟合现象,从而提升了分类准确率。 为了更明显地展示实验结果,图5给出了mDCNN和CNN在测试集上的曲线精度对比图。从图5中的曲线精度对比图可以看到:首先,和CNN相比,mDCNN有效提高了分类精度;其次,由于mDCNN降低了图像背景噪声的干扰,使得前景目标物体更加突出,比CNN的收敛速度更快;最后,mDCNN网络模型具有更加优良的分类稳定性。 图5 mDCNN和CNN在测试集的曲线精度对比图 为了验证三种不同注意类型的激活函数在不同卷积层上的实验效果,在mDCNN网络模型的第一个卷积层使用不同注意类型的激活函数,实验结果如箱线图6和表3所示。 表3 测试集上注意机制的实验结果 图6 三种不同注意机制在测试集上的错误率 从表3可以得到,由于通道关注和空间关注仅关注了一种类型的信息,分别去除了空间位置信息和通道信息。所以与混合关注的错误率相比,实验数据不够理想:空间关注的错误率比混合关注的错误率提升了7.4个百分点,而通道关注的错误率提升了10.3个百分点。当只在mDCNN模型的第一个卷积层进行实验时,通道关注性能最差,而混合关注同时考虑了空间位置和通道信息,其性能最优。 从图6的箱线图中,可以观察到,混合关注有关错误率的相应数值特性,均小于空间关注和通道关注。此外,混合关注的实验结果比空间关注和通道关注更为紧凑。因此,混合关注不仅有较低的错误率,而且性能也相对稳定。相比通道关注,空间关注性能略有提高。 当mDCNN网络模型的前两个卷积层均使用三种不同注意机制时,在测试集上得到的实验结果见表4。可以看出:当前两层卷积都使用通道关注或空间关注时,与混合关注相比,实验效果差距明显增大。相对于表3的实验性能,表4中的空间关注相比于通道关注,错误率上升了2.6个百分点。 表4 三种不同注意机制的实验结果 本研究提出了基于去噪神经网络的掩模预训练方法,该方法通过掩模预训练消除图像的背景噪声和深度特征噪声的干扰,突出图像的前景目标物体,有效抑制了CNN训练过程中出现的过拟合现象。同时,使用三种不同注意类型的激活函数,在标准图像库Corel-1000上充分进行验证。实验结果表明,基于去噪神经网络的掩模预训练方法不仅对分类效果有较大程度的提升,而且加速了网络模型的收敛速度,增强了算法的稳定性。特别地,加入混合注意机制后,实验效果最优。在未来的研究工作中,尝试多特征数据融合比如加入主颜色特征,弥补CNN只读取图像空间位置信息的不足,使模型性能达到更优。3.2 注意机制

4 实验结果及分析

4.1 实验参数与图像库

4.2 实验结果

5 总结