基于卷积注意力网络的网格质量评价方法

蔡梓豪 姜屹 张来平 邓小刚

摘要:将深度卷积神经网络引入网格质量评价问题有望代替网格工程师完成繁杂的网格质量评价工作,节省计算流体力学数值模拟的人力成本,但现有方法的准确率和效率仍需要提高.因此,本文提出一种基于卷积注意力网络的网格质量评价方法.首先,本文提出在轻量级卷积神经网络模型中嵌入通道注意力的方式以同时提升准确率和效率;其次,设计了一个神经网络模型CANet用于网格质量评价任务;最后,通过Z-Score标准化对数据进行预处理,解决输入数据分布不一致的问题,以进一步提升准确率.实验结果表明,与现有方法相比,CANet可以达到更优的准确率97.06%,并且在效率上也有至少34.9%的提升.

关键词:卷积神经网络; 注意力机制; 网格质量评价; 计算流体力学; 数值模拟

中图分类号: TP391 文献标识码:A DOI:10.19907/j.0490-6756.2023.053003

收稿日期: 2022-11-21

基金项目: 国家重大专项(GJXM92579)

作者简介: 蔡梓豪(1998-), 男, 黑龙江大庆人, 硕士研究生,主要研究领域为深度学习. E-mail: 907575778@qq.com

通讯作者: 姜屹. E-mail: yijiang@mail.ustc.edu.cn

A mesh quality evaluation method based on convolutional attention network

CAI Zi-Hao 1,2 , JIANG Yi 3 , ZHANG Lai-Ping 4 , DENG Xiao-Gang 3

(1.National Key Laboratory of Fundamental Science on Synthetic Vision, Sichuan University, Chengdu 610064, China; 2.Tianfu Engineering-oriented Numerical Simulation & Software Innovation Center, Sichuan University, Chengdu 610064, China; 3.Institute of Systems Engineering, Academy of Military Sciences, Beijing 100082, China; 4.Institute of Defense Science and Technology Innovation, Academy of Military Sciences, Beijing 100071, China)

The introduction of deep convolutional neural network into the mesh quality evaluation problem is expected to replace the engineers in completing the complicated mesh quality evaluations, therby saving the labor cost of computational fluid dynamics numerical simulation. However, the accuracy and efficiency of the existing methods still need improvement. Therefore, a mesh quality evaluation method based on convolutional attention network is proposed in this paper. Firstly, a method of embedding channel attention into the lightweight convolutional neural network model is proposed to improve both accuracy and efficiency. Secondly, a neural network model called CANet is designed for mesh quality evaluation. Finally, Z-Score standardization is used to preprocess the data and solve the problem of inconsistent input data distribution, further improving the accuracy. Experimental results show that, compared with the existing methods, CANet can achieve a better accuracy of 97.06%, and improves the efficiency by at least 34.9%.

Convolutional neural network; Attention mechanism; Mesh quality evaluation; Computational fluid dynamics; Numerical simulation

1 引 言

网格质量一直是影响计算流体力学数值模拟的重要因素之一 [1] .质量较差的网格将降低数值模拟求解的精度 [2] ,甚至导致结果不收敛 [3] .研究表明,即使一套网格中只存在极少部分的网格单元质量较差,这些低质量网格单元也会对数值模拟的结果产生严重影响 [4,5] .事实上,即使是十分先进的网格生成工具,也很难保证生成网格的质量能够完全达到数值求解的要求 [6] .为了获得更可靠的数值模拟结果,在数值模拟求解前执行网格质量评价是十分必要的 [7] .

传统网格质量评价方法往往依赖于网格单元的几何形状参数.例如较早的时候,有研究者提出通过网格单元的面积与边长来计算网格单元的质量 [8] .随着研究的不断深入,大型CAE软件提出更为复杂的评价指标来评价网格的质量 [9,10] ,例如网格单元的长细比、最大内角、扭曲度、翘曲度、雅可比比率、正交质量系数等.通过对这些指标进行加权计算,工程师们可以获得网格中每个网格单元的网格质量及分布.

然而,这些方法仅仅关注于每个网格单元的几何形状,却难以评价网格的整体质量,比如网格光滑性差或分布不合理等.实际中,仍然需要由经验丰富的网格质量工程师通过这些质量评价指标的反馈对网格整体质量进行综合评判,并制定相应的网格优化策略.

深度神经网络有望从网格质量评价工作大量的数据中学习到网格质量评价工作的潜在规律,从而代替人工网格质量评价环节,节省网格质量评价工作的人力成本.参考传统网格质量评价方法和深度学习图像分类问题,Chen等人 [11] 提出基于卷积神经网络的网格质量评价方法,并设计了一个基于VGG-19 [12] 模型的卷积神经网络模型GridNet用于评价二维翼型结构网格的质量.该方法将网格中的每一个网格单元的最大内角、水平长度和竖直长度按网格计算域封装成三维张量矩阵输入卷积神经网络模型,通过卷积神经网络模型进行网格质量的分类.尽管此方法能够在一定程度替代网格质量工程师对网格的整体质量进行评价,但其准确率和效率还有待提升.

为了提高模型准确率,Xu等人 [13] 设计了一个基于残差网络 [14] (ResNet-50)模型的卷积神经网络模型MeshNet用于网格质量评价任务.尽管相较于VGG-19模型,深度残差网络能够提升模型的数据拟合能力,但实验结果表明,该方法对准确率的提升效果比较局限,而且更深的网络模型大幅降低了效率.

为了提高模型效率,Chen等人 [15] 提出了一个基于深度可分离卷积 [16] 的网络模型MQNet用于网格质量的检测.然而实验结果表明,深度可分离卷积在GPU上的表现并没有理想情况那么优越.尽管深度可分离卷积通过将传统卷积过程分解,减小了计算量,但这也相当于增加了计算次数,导致其在GPU上的计算效率不佳.

卷积神经网络模型的复杂度普遍与数据拟合效果成正比,与效率成反比 [12,14,16] .现有工作表明,使用轻量级卷积神经网络会导致准确率不足,而增加卷积神经网络模型复杂度对准确率的提升效果比较局限,而且会导致效率的大幅下降.

引入注意力机制是平衡准确率与效率的一种有效方法.2014年,注意力机制 [17] 被提出并很快被应用于计算机视觉领域 [18,19] .研究证明,注意力机制能够结合卷积神经网络使用,以较小的计算代价有效提升卷积神经网络模型的准确率 [20-24] .通道注意力能够通过建模各个特征通道的重要程度,并且根据任务需求增强或者抑制各个特征通道的信息表达,从而提升模型的数据拟合效果 [25-28] .此外,通道注意力是众多注意力机制中计算代价较小的一种,更加适合于在现有工作的基础上提升效率.因此,在轻量级卷积神经网络模型上嵌入通道注意力,利用通道注意力来弥补卷积神经网络数据拟合能力的不足将是同时提高精度和效率的可行方法.

另外值得注意的问题是,现有方法使用的输入数据中,最大内角与水平长度、竖直长度的分布不一致,这会不利于神经网络模型的数据拟合.因此,需要使用数据标准化对其进行预处理,约束其数据分布.

为此,本文提出了一种基于卷积注意力的网格质量评价方法.本文的主要贡献如下:(1) 提出在轻量级卷积神经网络模型上嵌入通道注意力的方法以同时提高精度和效率的同时,利用通道注意力对卷积神经网络拟合能力的增强来弥补轻量级卷积神经网络拟合能力欠佳的问题;(2) 设计了一种卷积注意力网络模型CANet用于网格质量评价任务,通过该模型验证了所提出方法的有效性,并比较了ECA与经典的Squeeze-and-Excitation [23] 两种通道注意力对准确率提升的效果;(3) 使用Z-Score对输入数据进行预处理,解决输入数据不一致的问题,以进一步提高准确率.

2 相关工作

2.1 残差网络

残差网络是最成熟、应用最广泛的卷积神经网络模型之一.凭借独特的残差连接结构,残差网络的数据拟合能力优于大多数卷积神经网络模型.实验结果表明,即使是层数较少的轻量级残差网络,也有很好的数据拟合能力 [14] .残差连接结构将原始输入与卷积后的输出相加作为最终输出,从而防止了梯度消失和退化问题,获得了较强的数据拟合能力.残差模块第 L+1 层输出 x L+1 和第 L 层输出 x L+1 的关系如式(1)所示.

x L+1 =x L+f(W L+1 x L+b L+1 ) (1)

其中, W L+1 表示第 L+1 层卷积层的权重矩阵; b L+1 层表示第 L+1 层卷积层的bias值; f 为激活函数.

残差网络有很多衍生的网络模型如ResNet-18、ResNet-34、ResNet-50,ResNet-121等.模型名称中的数字代表了模型中卷积层的个数,数字越大则代表模型复杂度越高、计算量越大.

2.2 通道注意力

Squeeze-and-Excitation(SE)是通道注意力中最具代表性的工作.SE通过Squeeze和Excitation两个操作实现对通道信息表达能力的控制.Squeeze利用全局平均池化 [29] 将特征压缩,实现全局上下文信息的融合,如式(2)所示.

g=GAP( Feature )= 1 H×W ∑ H i=1 ∑ W j=1 u(i,j) (2)

其中,Feature表示输入特征; u(i,j) 表示特征矩阵的值; H 和 W 分别表示特征矩阵的高和宽.Excitation则类似于循环神经网络中门的机制,通过全连接层来为每个特征通道生成权重.

高效通道注意力(Efficient Channel Attention,ECA)是对SE的改进,与SE相同,ECA同样利用全局平均池化对特征进行压缩,融合全局上下文信息.而在Excitation部分,ECA将原本SE模块中的两个全连接层替换为一个自适应卷积核的一维卷积层,从而获得了比SE更好的性能,一维卷积层的卷积核大小 k 根据输入特征的通道数 C 自适应,其计算方法如式(3)所示.

k=ψ(C)= log 2(C) γ + b γ odd (3)

其中, γ 和 b 为常数( γ =2, b =1); odd表示离结果最近的奇数(向上取).

3 本文方法及模型

本文提出了一种基于卷积注意力网络方法,即在轻量级卷积神经网络上嵌入通道注意力模块以同时提升准确率和效率.基于这一思想,本文设计了一个卷积注意力网络模型CANet用于网格质量评价,并通过Z-Score数据标准化解决了输入数据分布不一致问题.本节将详细介绍CANet模型的输入输出、模型结构、损失函数及Z-Score数据预处理方法.

3.1 模型输入输出

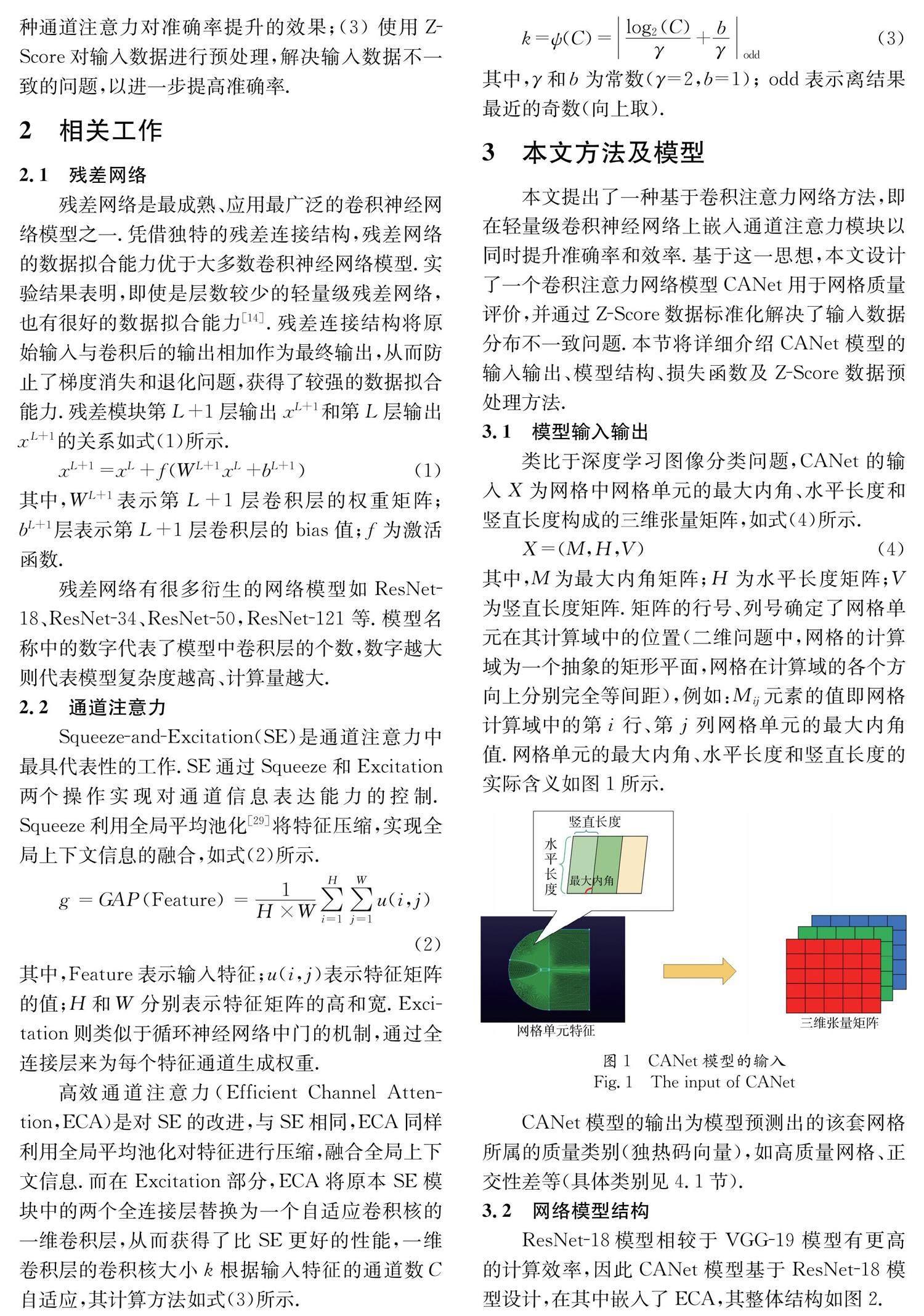

类比于深度学习图像分类问题,CANet的输入 X 为网格中网格单元的最大内角、水平长度和竖直长度构成的三维张量矩阵,如式(4)所示.

X=(M,H,V) (4)

其中, M 为最大内角矩阵; H 为水平长度矩阵; V 为竖直长度矩阵.矩阵的行号、列号确定了网格单元在其计算域中的位置(二维问题中,网格的计算域为一个抽象的矩形平面,网格在计算域的各个方向上分别完全等间距),例如: M ij 元素的值即网格计算域中的第 i 行、第 j 列网格单元的最大内角值.网格单元的最大内角、水平长度和竖直长度的实际含义如图1所示.

CANet模型的输出为模型预测出的该套网格所属的质量类别(独热码向量),如高质量网格、正交性差等(具体类别见4.1节).

3.2 网络模型结构

ResNet-18模型相较于VGG-19模型有更高的计算效率,因此CANet模型基于ResNet-18模型设计,在其中嵌入了ECA,其整体结构如图2.

其中,RB表示残差模块.CANet中包含两种残差模块,即输入通道数与输出通道数相同的同维残差模块(RB1、RB2、RB4、RB6、RB8)和输入通道数与输出通道数不同的异维残差模块(RB3、RB5、RB7),两种残差模块如图3所示.

其中,3×3 conv表示卷积核大小为3×3的卷积; 1×1 conv 同理.conv后的数字表示卷积输出的通道数./2表示卷积的步长为2,没有标注的则表示卷积步长为1.Batch Normalization(BN) [30] 为批归一化,用于对卷积输出进行归一化处理,从而防止梯度消失.CANet中的残差模块输入 x 与输出 O(x) 之间的关系为

O(x)=f(x+BN(W 2f(BN(W 1x+b 1))+b 2)) (5)

其中, W 1 、 W 2 分别表示第1个和第2个卷积层的权重; b 1 , b 2 分别表示第1个和第2个卷积层的bias值.BN为批归一化,其公式为

x ^ = x-E(x) Var(x) (6)

式(5)中的 f 表示ReLU激活函数,其输入 x 与输出 R(x) 之间的关系为

R(x)= 0, (x<0) x, (x>0) (7)

为了防止过拟合,CANet只在RB2、RB4、RB6和RB8中嵌入了ECA模块,嵌入的位置如图4所示.

CANet中的ECA模块由全局平均池化层、一维卷积层和Sigmoid函数实现,其具体结构如图5所示.

GAP表示全局平均池化,用于压缩输入通道特征,压缩后的特征输入一维卷积层,经过激活函数Sigmoid后,与原始输入相乘,得到最终输出Feature′,如式(8)所示.

Feature′=Feature× σ(Wg+b) (8)

其中, W 为一维卷积的权重; b 为bias值; σ 表示Sigmoid激活函数其输入 x 与输出 σ(x) 如式(9)所示.

σ(x)= 1 1+e -x (9)

Maxpool和Avgpool分别表示最大池化和平均池化. 为了防止过拟合,我们在全连接层之后放置了一个dropout层.此外,CANet参考了GridNet和MeshNet模型结构,在模型的尾部加入了一个相同的全局池化结构用于更好地预测模型结果,如图2的reduce mean,1×1 conv 8和squeeze.最后由softmax函数用于将模型的输出转化为概率分布,得到网格所属的质量类别结果,其公式为

P(z i)= e z i ∑ C c=1 e z c (10)

其中, z i 为第 i 个节点的输出值; C 为输出节点的个数,即分类的类别数(本文为8类).

3.3 损失函数

本文使用的损失函数为交叉熵 [31] .交叉熵常被用于深度学习分类问题中,其定义为

cross_entropy =-∑ i P(i) log 2G(i) (11)

其中, P(i) 表示模型预测结果向量的值; G(i) 则为真实标签向量的值,交叉熵损失函数可以衡量预测结果与真实标签之间的相似性,随着预测越来越准确,交叉熵的值越来越小.此外,本文在损失函数中加入 L 2 正则化项以防止过拟合,如式(12)所示.

Loss=cross_entropy +λ∑ ‖w‖ 2 (12)

3.4 数据标准化预处理

由于最大内角的数据值分布在0~180之间,这与水平长度和竖直长度的数据分布不一致,不利于卷积神经网络模型对数据的拟合.为此,本文使用Z-Score标准化对输入数据进行标准化.Z-Score标准化是常用的数据标准化方法之一,能够将原本近似于正态分布的原始数据分布约束到标准正态分布,从而消除最大内角与水平长度、竖直长度的值分布差异,进一步提高模型的准确率如下式.

X M= M-M * S M (13)

X H= H-H * S H (14)

X V= V-V * S V (15)

其中, X M 、 X H 、 X V 分别表示Z-Score标准化后的最大内角、水平长度、竖直长度矩阵; M 、 H 、 V 分别表示原始数据的最大内角、水平长度、竖直长度矩阵; M * 、 H * 、 V * 表示数据的平均值; S M 、 S H 、 S V 表示数据的方差.

4 实验结果与分析

4.1 网格数据集

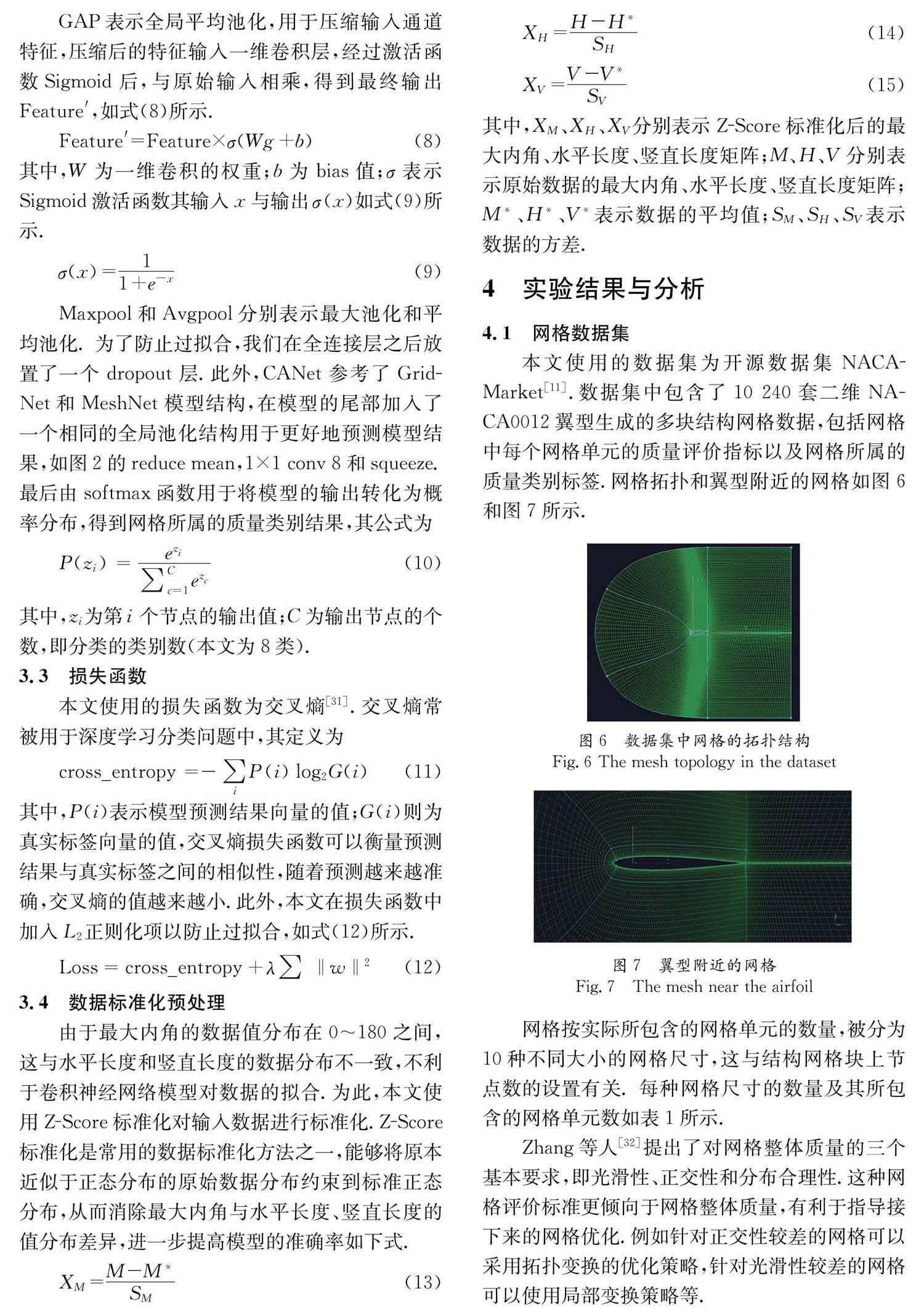

本文使用的数据集为开源数据集NACA-Market [11] .数据集中包含了10 240套二维NACA0012翼型生成的多块结构网格数据,包括网格中每个网格单元的质量评价指标以及网格所属的质量类别标签.网格拓扑和翼型附近的网格如图6和图7所示.

网格按实际所包含的网格单元的数量,被分为10种不同大小的网格尺寸,这与结构网格块上节点数的设置有关. 每种网格尺寸的数量及其所包含的网格单元数如表1所示.

Zhang等人 [32] 提出了对网格整体质量的三个基本要求,即光滑性、正交性和分布合理性.这种网格评价标准更倾向于网格整体质量,有利于指导接下来的网格优化.例如针对正交性较差的网格可以采用拓扑变换的优化策略,针对光滑性较差的网格可以使用局部变换策略等.

数据集中的网格质量类别标签参考了这些基本要求,将网格质量分为8类:高质量网格、正交性差、光滑性差、分布不合理、正交性差且光滑性差、正交性差且分布不合理、光滑性差且分布不合理、低质量网格(三项指标均不合格).每种质量类别包含的网格数量如表2所示.表2中质量类别所代表的实际含义如图8所示.

4.2 实验环境与模型参数设置

本文全部实验所用的显卡为NVIDIA A100,使用的深度学习框架是Tensorflow [33] .此外,本文全部实验使用数据集中每种尺寸网格的前75%作为训练集,后25%作为测试集,即训练集数量为 7 680 ,测试集数量为2 560.

模型参数方面,dropout率设置为0.5,batch size设置为16,学习率随epoch增加而阶梯式降低,其策略如下:

epoch∈(0,20],学习率为0.001;

epoch∈(20,30],学习率为0.0001;

epoch∈(30,50],学习率为0.000 01;

epoch∈(50,100],学习率为0.000 001.

优化器使用Nesterov Accelerated Gradient (NAG) [34] ,momentum设置为0.9.为了更好地对比实验结果,CANet模型同样训练100个epoch,这与现有模型相同.训练过程中,loss和测试准确率随epoch数增加的变化如图9所示.

4.3 评价指标

准确率是深度学习常用的模型评价指标,其定义为所有预测正确(预测结果与真实标签相同)的样本数,占所有参与预测的样本总数的比例,即:

准确率= 正确预测样本数 参与预测样本总数 (16)

我们分别计算模型在10种尺寸的网格测试集上的准确率并计算这些准确率的平均值作为每个epoch准确率的结果,并选择100个epoch中最优的测试集准确率结果作为模型的最终准确率结果.

效率方面,本文使用模型训练一个epoch的时间来衡量模型的效率.为了保证结果的有效性,所有模型运行在相同的硬件环境上.

4.4 注意力模块对准确率的影响

为了探究注意力模块对准确率的影响,我们搭建了一个经典的ResNet-18模型,并在模型后加入相同的全局池化结构用于消融实验.除此之外,我们搭建了一个基于ResNet-18+SE的模型用于比较ECA和SE两种注意力在提升准确率方面的性能.该模型将CANet模型中的所有ECA模块替换为SE模块.三个模型均在输入原始数据的情况下训练100个epoch,准确率对比的结果如图10所示.

从实验结果可以看出,嵌入了注意力模块的两个模型准确率高于未嵌入注意力模块的ResNet-18模型.这说明引入注意力机制的确能够有效提升模型的准确率,证明了本文提出方法的有效性.此外,实验结果显示,相较于嵌入了SE模块的网络模型,嵌入了ECA的CANet模型对准确率的提升效果更好.这说明ECA较SE对卷积神经网络模型数据拟合能力的提升更强.

4.5 注意力模块对准确率的影响

为了探究Z-Score数据标准化对准确率的影响,我们设计了一项消融实验,即Z-Socre标准化后数据和原始数据训练出的模型的准确率结果,比较的结果如图11所示.

通过实验结果可以看出,Z-Score标准化后的数据得到的准确率得到了进一步提升,这说明经过Z-Score标准化后,数据分布不一致的问题得到了有效的解决,准确率得到了进一步的提升.

4.6 本文模型与现有方法准确率的比较

为了与现有方法的准确率进行比较,我们参照相应文献复现了GridNet [11] 、MeshNet [13] 以及MQNet [15] 模型并在相同数据集上比较了与CANet模型的准确率结果,模型参数参照相应文献设置.此外,所有模型均使用Z-Score标准化对输入数据进行了预处理,以消除数据预处理对模型结果的影响.所有模型使用相同的评价指标(见4.3节),比较的结果如图12所示.

从实验结果可以看出,CANet较现有模型在准确率上有着较明显的提升,具体来说,较GridNet模型提升了2.93%,这主要得益于ResNet-18模型较VGG-19模型更为出色的数据拟合能力和ECA对模型数据拟合能力的进一步提升;较MeshNet模型提升了2.61%,这说明在卷积神经模型上嵌入注意力机制比增加网络模型深度更有助于提升模型的数据拟合能力;较MQNet模型提升了4.09%,这主要是因为MQNet模型大量使用深度可分离卷积,为了减少模型计算参数,追求CPU上的计算效率提升,而牺牲了部分准确率.

4.7 本文模型与现有方法效率的比较

为了与现有方法的效率进行比较,我们统计了CANet模型和现有方法模型训练一个epoch所需要的时间,为了得到更有说服力的结果,这些模型运行在相同的硬件条件下,此外,为了消除batch size对训练时间的影响,所有模型的batch size设置为16,对比的结果如表3所示.

经过比较,CANet模型较GridNet模型每轮训练快37 s,效率约提升34.9%,这主要是因为GridNet模型中包含更多的512通道的卷积层以及隐藏神经元更多的全连接层(1个4096个神经元的全连接层和1个1024个隐藏神经元的全连接层),导致计算代价大于CANet模型.此外,CANet模型较MeshNet每轮训练快142 s,效率提升约67.3%,这是因为虽然加入了高效通道注意力模块,但CANet模型的计算量和模型深度仍小于MeshNet模型.最后,CANet模型较MQNet每轮训练快50 s,效率提升约42%,这主要是因为深度可分离卷积在GPU上的表现不佳.

最后,为了印证上述分析,我们计算了CANet模型和现有方法模型的参数量,各模型参数量的计算的结果如表4所示.

从各模型参数量计算的结果,结合各模型训练时间可以看出,CANet模型的参数量明显小于GridNet和MeshNet,这说明CANet模型相较GridNet和MeshNet效率的提升的确得益于模型计算复杂度的减小,同时说明模型参数量在一定程度上决定了模型效率.而MeshNet与GridNet模型计算量相近,但训练时间上却相差较大,这说明网络深度同样在一定程度上决定了模型效率.而CANet模型的参数量大于MQNet模型,但CANet模型在GPU上的训练时间明显更小,说明CANet模型相较MQNet的提升的确是因为深度可分离卷积在GPU上因分解卷积过程而导致了性能欠佳.

5 结 论

本文提出了一种基于卷积注意力网络的网格质量评价方法.首先,提出在轻量级的卷积神经网络模型中加入注意力机制的方法以同时提升准确率和效率.此外,设计了一种神经网络模型用于网格质量评价任务.最后,使用Z-Score数据标准化消除了输入数据分布的差异,进一步提升了准确率.实验结果证明了本文方法和模型在网格质量评价任务中的有效性并较现有方法在准确率和效率方面有着明显的优势.此外,ECA对模型准确率的提升效果优于SE注意力.

尽管基于卷积注意力网络的网格质量评价方法已经达到了较好的准确率和效率,但仍需解决模型泛化性和端到端问题,这也是我们接下来的研究方向.此外,我们将进一步将该方法推广应用与三维结构网格和非结构网格的质量评价,并在质量评价的基础上,针对每一类质量较差的网格采用适当的优化方法对整体网格质量进行优化.

参考文献:

[1] Zint D, Grosso R. Discrete mesh optimization on GPU[C]//International Meshing Roundtable. Cham: Springer, 2018.

[2] Naderi M H, Eivazi H, Esfahanian V. New method for dynamic mode decomposition of flows over moving structures based on machine learning (hybrid dynamic mode decomposition)[J]. Phys Fluids, 2019, 31: 127102.

[3] Tingfan W U, Xuejun L I U, Wei A N, et al . A mesh optimization method using machine learning technique and variational mesh adaptation [J]. Chinese J Aeronaut, 2022, 35: 27.

[4] Katz A, Sankaran V. Mesh quality effects on the accuracy of CFD solutions on unstructured meshes[J]. J Comput Phys, 2011, 230: 7670.

[5] Sarrate J, Palau J, Huerta A. Numerical representation of the quality measures of triangles and triangular meshes [J]. Commun Numer Meth En, 2003, 19: 551.

[6] Gammon M. A review of common geometry issues affecting mesh generation[C]//2018 AIAA Aerospace Sciences Meeting. Florida: AIAA, 2018: 1402.

[7] Delgado-Gutiérrez A, Cárdenas D, Probst O. An efficient and automated method to generate complex blade geometries for numerical analysis [J]. Adv Eng Softw, 2019, 127: 38.

[8] 李笑牛, 袁克杰. 一种三角形表面网格质量综合度量方法[J]. 大连民族学院学报, 2005, 7: 36

[9] Gaikwad S, Arora K, Korivi V, et al . Steady and transient CFD approach for port optimization [J]. SAE Int J Mater Manuf, 2009, 1: 754.

[10] Lam X B, Kim Y S, Hoang A D, et al . Coupled aerostructural design optimization using the kriging model and integrated multiobjective optimization algorithm[J]. J Optimiz Theory App, 2009, 142: 533.

[11] Chen X, Liu J, Pang Y, et al . Developing a new mesh quality evaluation method based on convolutional neural network [J]. Eng Appl Comp Fluid, 2020, 14: 391.

[12] Simonyan K, Zisserman A. Very deep convolutional networks for large-scale image recognition[C]//Proceedings of the International Conference on Learning Representations (ICLR). San Diego: ICLRF, 2015: 1.

[13] Xu Z, Chen X, Chi L, et al . A mesh quality discrimination method based on convolutional neural network [C]//Proceedings of the 2020 IEEE International Conference on Artificial Intelligence and Computer Applications (ICAICA). Dalian, China: IEEE, 2020.

[14] He K, Zhang X, Ren S, et al . Deep residual learning for image recognition[C]//Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition. Las Vegas: IEEE, 2016.

[15] Chen X, Gong C, Liu J, et al . A novel neural network approach for airfoil mesh quality evaluation[J]. J Parallel Distr Com, 2022, 164: 123.

[16] Zhang Y, Tian Y, Kong Y, et al . Residual dense network for image super-resolution [C]//Proceedings of the Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition. Salt Lake City, UT, USA: IEEE, 2018.

[17] Howard A G, Zhu M L, Chen B, et al . Mobilenets: efficient convolutional neural networks for mobile vision applications[C]//Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition (CVPR). Honolulu: IEEE, 2017: 1310.

[18] Guo M H, Xu T X, Liu J J, et al . Attention mechanisms in computer vision: a survey [J]. CVM, 2022, 8: 331.

[19] Han K, Wang Y, Chen H, et al . A survey on vision transformer [J]. IEEE T Pattern Anal, 2022, 45: 87.

[20] Wang Q, Wu B, Zhu P, et al . ECA-net: efficient channel attention for deep convolutional neural networks [C]//Proceedings of the 2020 IEEE/CVF Conference on Computer Vision and Pattern Recognition (CVPR). Seattle: IEEE, 2020.

[21] Hu J, Shen L, Sun G. Squeeze-and-excitation networks [C]//Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition. Salt Lake City: IEEE, 2018.

[22] Vaswani A, Shazeer N, Parmar N, et al . Attention is all you need [C]//Neural Information Processing Systems. Long Beach, California, USA: CPS, 2017: 6000.

[23] Woo S, Park J, Lee J Y, et al . Cbam: Convolutional block attention module [C]//Proceedings of the European conference on computer vision (ECCV). Munich, Germany: Springer, 2018.

[24] Fu J, Liu J, Tian H, et al . Dual attention network for scene segmentation[C]//Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition. Long Beach: IEEE, 2019.

[25] 張攀, 李晓华, 周激流. 一种基于注意力嵌入对抗网络的全色锐化方法[J]. 四川大学学报:自然科学版, 2023, 60: 012001.

[26] 胡向东,张婷.基于时空融合深度学习的工业互联网异常流量检测方法[J].重庆邮电大学学报:自然科学版, 2022, 34: 1056.

[27] 王进,徐巍,丁一,等. 基于图嵌入和区域注意力的多标签文本分类[J].江苏大学学报:自然科学版, 2022, 43: 310.

[28] 朱海琦,李宏,李定文,等. 基于生成对抗网络的单图像超分辨率重建[J]. 吉林大学学报: 理学版, 2021, 59: 1491.

[29] Lin M, Chen Q, Yan S. Network in network [EB/OL]. (2014-03-04)[2022-11-21]. https://arxiv.org/pdf/1312.4400.pdf.

[30] Ioffe S, Szegedy C. Batch normalization: accelerating deep network training by reducing internal covariate shift[C]//Proceedings of the International Conference on Machine learning. Lille: PMLR, 2015.

[31] Rubinstein R Y, Kroese D P. The cross-entropy method: a unified approach to combinatorial optimization, monte-carlo simulation, and machine learning [M]. New York: Springer, 2004.

[32] 张来平, 赫新, 常兴华, 等. 复杂外形静动态混合网格生成技术研究新进展[J]. 气体物理, 2016, 1: 42.

[33] Abadi M, Agarwal A, Barham P, et al . Tensorflow: Large-scale machine learning on heterogeneous distributed systems[EB/OL]. [2022-11-21].https://doi.org/10.48550/arXiv.1603.04467.

[34] Nesterov Y E. A method of solving a convex programming problem with convergence rate O(1/k 2)[J]. Dokl Akad Nauk, 1983, 269: 543.