图像描述技术方法研究

陈耀传,奚雪峰*,崔志明,盛胜利

(1.苏州科技大学 电子与信息工程学院,江苏 苏州 215000;2.苏州市虚拟现实智能交互及应用重点实验室,江苏 苏州 215000)

0 引 言

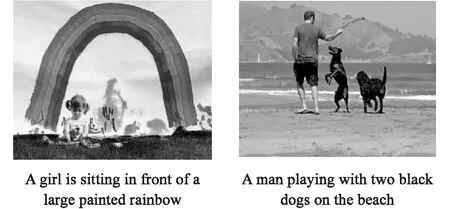

在计算机视觉领域中,目标检测[1-2]与图像分类[3]等技术已经发展的较为成熟,在实际生活中也出现了采用这些技术的应用和产品。图像描述(Image Captioning)作为结合人工智能领域中的计算机视觉(Computer Vision,CV)和自然语言处理(Natural Language Process,NLP)两个领域的任务,也逐渐成为人工智能领域的研究热点,图像描述的目标是生成输入图片的文本描述,整个过程需要使用计算机视觉技术识别图像中的显著目标,并利用自然语言处理技术生成连贯的文本描述,如图1所示。区别于图像分类与目标检测,让计算机理解输入的图像,显然是具有挑战性的任务。计算机不仅需要通过模型提取出图像中的“表层信息”(图像特征),也要提取出图像中的“深层信息”(目标关系),这对计算机来说是十分困难的。

图1 图像描述实例

在图像描述技术发展初期,研究者们主要使用图像处理技术提取图像特征并进行图片分类,分类后得到图像特征中可能存在的对象与目标。获取到的对象与目标通过人为制定的规则生成对应的文本描述。然而这种方法的效果并不理想,原因在于该做法十分依赖对图像的特征提取,并且在生成文本描述时制定的规则也非常重要。随着图像描述技术的发展,研究者们发现了提高生成文本多样性的方法,即基于检索的方法。但是这种方法过于依赖对语料库的训练,并且人力投入过大,因此该方法没有成为目前图像描述技术的主流方法。

深度学习技术的发展,使得图像描述迅速成为人工智能领域的研究热点之一。深度神经网络可以提取图片中的高维语义信息,这种高维语义信息表示了图像中目标与目标的关系,从而使生成的图像描述有不错的准确率。在深度学习技术的支持下,图像描述方法的研究迅速向前发展,在近些年涌现了越来越多的方法,使用深度学习技术完成图像描述任务正在成为未来的主要趋势。

1 图像描述方法研究现状

为了更好地理解和比较图像描述领域中显著的研究贡献,本节将从三个方面介绍分析图像描述的相关工作:模板填充的方法、检索的方法和深度学习的方法。其中深度学习的方法是目前图像描述任务的主流方法。

1.1 模板填充的方法

使用模板填充的图像描述方法在生成文本时有固定的文本模板,在整个过程中,首先通过算法提取出图像的视觉特征,包括图像的对象、动作、场景及属性等其他元素对应的文本。然后检测出这些元素对应的单词,并把这些单词填入模板生成图像描述。

Farhadi等[4]通过支持向量机[5](Support Vector Machines,SVM)构建节点特征,检测图像的三元素,包括场景、对象和行为。生成图像描述时,利用隐马尔可夫模型计算得到最有可能的词语,并且根据检测出的三元素填充制定好的模板中得到图像描述。Mitchell[6]等提出了Midge系统,该系统从计算机视觉的检测中生成类似于人类的自然语言描述。其中,通过统计句法上出现的词汇次数,并通过生成器过滤并约束视觉系统输出的嘈杂检测结果生成的句法树,来说明计算机视觉系统看到的信息。结果显示,该生成系统优于当时最先进的模板填充方法,自动生成了一些自然的图像描述。Kulkarni等[7]提出一种基于文本统计数据和计算机视觉的识别算法,该算法生成的图像描述更符合特定的图像内容。这种方法通过对象和物体检测器找出候选对象,使用属性分类器和介词关系函数处理每个候选对象,计算得到候选对象之间的关系,构建条件随机场预测图像标签,最终根据标签生成文本填入既定的模板得到图像描述。

使用模板填充的方法生成图像描述的优势在于语法正确率很高,这得益于人工制定的填充模板。但也正是因为模板的限制,使得生成的图像描述较为单一,在灵活性和多样性方面表现欠佳。另外,模板的数量问题也是限制这种图像描述方法的一大难点。

1.2 检索的方法

基于检索的图像描述方法是在存有所有图像描述的集合中搜索,找出与输入图像相似性最高的图片后,提取出该图片对应的图像描述,再经过修改得到输入图像的描述。

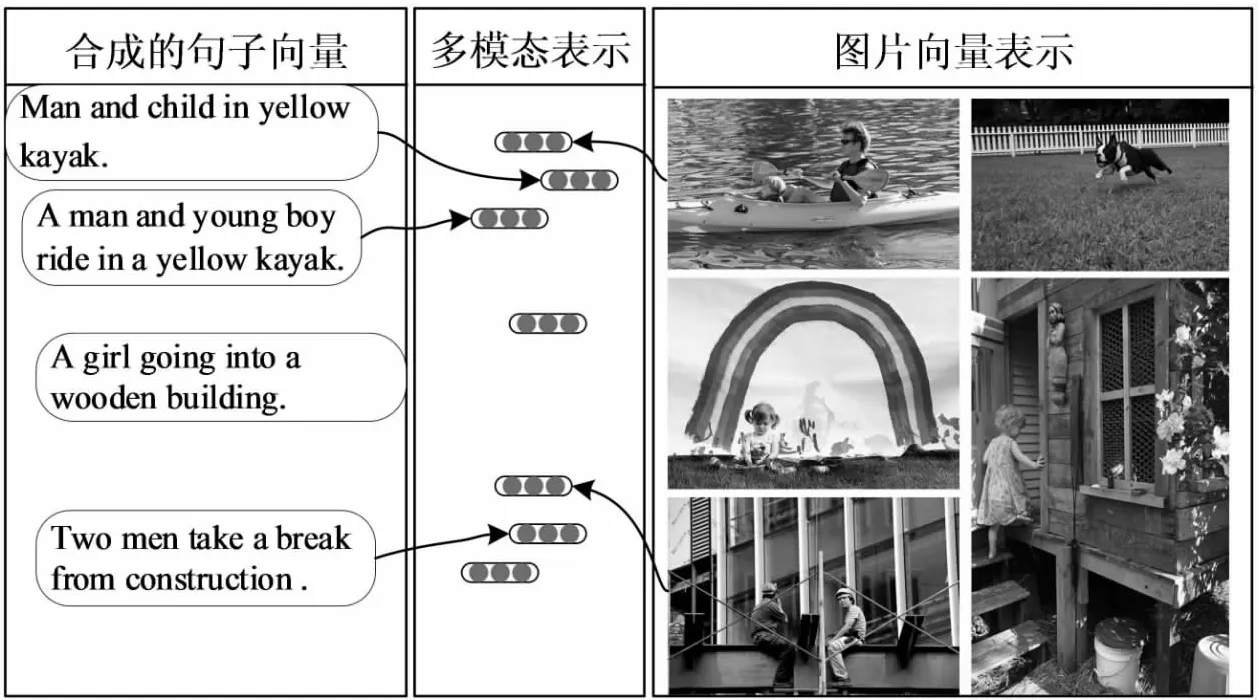

Ordonez等[8]提出了一种自动收集数据的方法,该方法过滤了带有噪音的数据,得到100万张带有视觉描述的图片。在收集到带有视觉描述图片的基础上,通过全局搜索和内容估计检索生成图像描述。Hodosh等[9]提出了KCCA方法,构建捕获语义相似性的核函数与序列核函数,通过搜索找出基于句子的图像描述,再根据规则对候选描述排序,排序结果作为最终的图像描述。这种排序的方法和生成式的方法不同,这种方法不需要考虑生成语句的合理性,而是以排序作为图像描述的方法。Socher等[10]提出DT-RNN模型,该模型使用依赖树将句子嵌入到向量空间,以便检索这些句子描述的图像,如图2所示。与RNN相比,DT-RNN模型更加关注句子中的动作和主体,所以对语法结构和词序的变化更有鲁棒性。Kuznetsova等[11]提出一种文本生成方法,该方法以树形结构为主体,树的片段来自数据库自存的图像描述,从这些片段中筛选出合适的文本,将这些文本重新组合抽取,生成的文本作为最终的图像描述。

图2 DT-RNN模型框架

基于检索的图像描述方法在灵活性和多样性方面表现较好,在生成文本描述时能够保证语句的正确性,但是这种方法对大规模训练语料的依赖性过高,并且受到训练文本的制约,所以难以保证图像描述的语义正确性。

1.3 深度学习的方法

近些年深度学习技术迅速发展,各种基于深度学习的方法相继问世,在各个领域都取得了显著的效果。得益于深度学习技术的发展,图像描述技术也成为多模态学习领域的重要组成部分。使用深度学习的方法,能够生成准确率较高的图像描述,是目前图像描述领域最主流的方法。

作为多模态学习领域中的分支,基于深度学习的图像描述技术有着较高的灵活性,这种灵活性来自于编码器-解码器结构,该结构保证了编码端和解码端能够使用大部分的深度学习模型。Mao等[12]在2014年提出的m-RNN模型,创造性地将CNN和RNN结合,并在图像描述中使用该模型,使得CNN-RNN结构成为编码器-解码器结构的热门结构。然而RNN在学习序列数据时,会出现信息遗忘的现象,这导致生成图像描述的准确率大打折扣。为了解决这个问题,Vinyals等[13]提出了NIC框架,该框架在编码端使用了深度更深的卷积神经网络,并且CNN提取出的图像特征只会在初始阶段输入一次。在解码端,使用LSTM代替了RNN,生成准确率更高的图像描述。

虽然编码器-解码器结构在图像描述任务中表现良好,但是也存在着局限性。在定长的向量中,向量能够保存的信息量往往是有限的,这种限制带来的问题和输入序列的长度呈正比关系。此外,如何在编码端更有效地提取图像特征,如何在解码端完善文本生成的方法,都是提升图像描述准确率需要解决的问题。

1.3.1 注意力机制的方法

生成图像描述时,每一个输出的词语往往关联着图像的不同区域,理想的情况应该是解码端更加关注预测单词对应的图像区域,这种在模型中引入注意力机制的方法,提高了图像描述的准确率。在编码器-解码器结构中融入注意力机制,还可以助力解决序列长度带来的信息遗忘问题。

Xu等[14]最早在图像描述中引入注意力机制,在编码端利用CNN对图像进行特征提取,得到位置特征集合后,使用注意力机制学习位置特征的权重。位置权重使模型在生成图像描述时,更加关注图像的区域特征。Xu等还在工作中借助可视化的方法,表达了融入注意力机制的工作效果。Lu等[15]在Xu的基础上提出了带有视觉标记的自适应注意力机制,该机制在解码端会对不同的词汇使用不同的注意力策略。通过在LSTM中加入视觉标记,将图片信息和文本信息加权组合,从而控制解码器生成与视觉信息无关的词。这种方法使模型在生成图像描述时自行决定依赖于视觉信息还是语义信息,从而生成信息更加丰富的图像描述。Chen等[16]也指出视觉注意在图像描述任务中的重要作用,在使用CNN进行编码时引入空间与通道的注意力机制。该方法通过动态地学习多层特征图中的每一个特征,计算出与隐藏层之间的关系,从而增强图像描述的效果。Tavakoli等[17]提出的自下而上(Top-Down)的视觉注意力机制,是一种基于显著性的注意力模型,该方法处理图像的位置数据效果较好。在Top-Down视觉注意力机制的基础上,Anderson等[18]提出了自上而下(Bottom-Up)和自下而上相结合的视觉注意力机制。在编码端使用Faster R-CNN检测目标区域并提取图像特征,Bottom-Up和Top-Down联合得到图像与文本的注意力权重。在解码端,使用2个LSTM层并结合注意力机制生成图像描述。Huang等[19]提出的AoA模块改进了注意力机制,在传统的注意力基础上增加了另一个注意力。该模块促使编码器和解码器都能了解注意力结果和查询(Query)之间的相关性,作者将AoA模块应用在模型的编码端和解码端,使模型衡量图像中的区域关系以及文本中的有关信息,提高图像描述的准确率。Cornia等[20]在自注意力中加入先验知识,构建记忆增强注意力机制,从而生成更加可控和风格多样的图像描述。在高阶特征交互方面,Pan等[21]提出的X-LAN网络,通过双线性池化选择性地利用视觉信息或进行多模态推理,实现了高阶特征之间的交互。在编码端使用Faster R-CNN检测图像区域后,利用堆叠的X-LAN模块对区域级特征进行编码,经过高阶模内互动得到增强的区域级和图像级特征。根据增强的视觉特征,在解码端利用X-LAN模块,进行多模态推理生成图像描述。这种高阶模态之间交互的方法,在如今的图像描述领域也达到了极好的效果。近些年基于注意力机制的改进方法层出不穷,并且广泛应用于计算机视觉、自然语言处理和多模态技术等领域。在图像描述任务中,注意力机制不仅在编码端可以获取局部图像和全局信息的关系,而且可以提升文本与图像区域的相关性,提高生成图像描述的准确率。上述方法在不同数据集上的实验结果如表1所示。

表1 基于注意力机制的方法在数据集上的实验结果

根据表1数据集的使用来看,随着工作的不断进行,大部分工作都选择使用MS COCO数据集,而Flickr30K数据集的使用相对较少,该问题来自于数据集的规模差异。和MS COCO相比,Flickr30K的数据量较少,涉及领域不够广泛,导致实验结果的说服力不强。从实验效果来看,得益于深度学习技术的创新和注意力机制的改进,新提出的方法在实验上的表现越发出色。在编码器-解码器的基础架构上,自Anderson开始,研究者逐渐将视线转移到改进注意力机制本身,针对注意力机制的改进效果优于其他基于注意力机制的方法。实验效果不断提高的另一个原因是实验设备的优化,算力的提高给实验带来了极大的利好,模型能够处理更复杂的算法,参数量不断增大的同时,使拟合的结果更接近真实结果。

1.3.2 对抗生成网络的方法

近些年,对抗生成网络[22](Generative Adversarial Networks,GAN)在计算机视觉领域发展迅速,由于在图像生成任务中表现良好,GAN开始被广泛应用于机器翻译、文本总结、对话系统、图像描述等自然语言处理任务中。GAN的内部结构包含两个网络,分别是生成网络和判别网络。为了获得强大的生成模型,缩小生成样本和真实样本间的差异,判别器与生成器不断地对抗博弈,直到真假难辨。

Dai等[23]提出的条件生成对抗网络(Conditional GAN)模型,首次在图像描述任务中使用GAN,提升了生成句子的多样性,输出更加自然的图像描述。该模型生成部分的输入由提取的图像特征和随机噪音变量构成,通过LSTM生成伪造的图像描述。在判别部分使用LSTM对句子进行编码,编码后与图像特征计算得到概率值,用于判断生成描述是否可靠以及是否与输入图像相关。最后利用策略梯度算法更新参数,根据得到的最大概率值输出最佳的图像描述。在多样性方面,Shetty等[24]也在图像描述任务上使用了Conditional GAN。不同的是,Dai等主要依赖生成部分的随机噪音输入实现图像描述的多样性;而Shetty等在判别部分使用图像和对应的文本描述作为输入,从而引导生成器生成多样化的图像描述。另外,生成部分新增了Faster RCNN,用于检测目标特征,并用Gumbel-Softmax代替了常用的策略梯度算法,不仅解决生成器采样过程中不可微的问题,而且提升了模型的计算效率。Chen等[25]提出了一种跨领域图像描述的对抗训练,旨在训练样本较少的领域,提升模型生成图像描述的准确性。该方法使用对抗学习网络将未配对的数据应用到新的领域,在多个数据集上表现较好。为了判断图像描述的真实性和自然性,Chen等[26]提出了结合GAN和强化学习的图像描述框架,利用强化学习的自我批判算法对生成模型进行优化,进而衡量图像描述的可靠性。该模型在编码端引入两种判别器结构,得到给定句子真实性的概率值。在解码端的判别器采用了标准的LSTM架构,通过输入的图像特征和单词编码信息,输出图像描述为真的概率值,这种方法生成的图像描述真实性较高。虽然在图像描述任务上使用GAN可以提高生成描述的多样性,但还是无法同时生成多种风格的图像描述。Guo等[27]提出的MSCap模型,通过在输入文本信息时引入风格参数,从而生成多种风格的图像描述,并且引入了一个风格分类器用于区分图像描述的样式。另外模型中还使用了反向翻译模块,确保生成以视觉为基础的风格化图像描述,保证真实的图像描述和风格化描述的一致性。使用GAN的方法能够改善图像描述的多样性,生成风格众多的图像描述。在众多的图像描述方法中,基于GAN的方法最为灵活有趣,然而使用GAN的方法在评估标准上的表现却差强人意。基于GAN的图像描述方法在数据集上的实验结果如表2所示。

根据表2可以看出,基于GAN的图像描述方法的效果略低于基于注意力机制的方法,但是该方法的准确率并不低,而且生成的图像描述更加自然。另外,从表中可以看出相较于仅使用GAN的方法,Chen在模型中引入强化学习的方法大大提升了实验效果,这为研究者们提供了广阔的研究思路,启发研究者们将其他深度学习技术应用在基于GAN的图像描述模型中。

表2 基于对抗生成网络的方法在数据集上的实验结果

1.3.3 强化学习的方法

强化学习[28](Reinforcement Learning)是机器学习领域必不可少的一部分,在图像描述任务中使用强化学习可以提升模型的性能。强化学习又叫鼓励学习、评价学习和增强学习,模型包括智能体、环境、行为和奖励四个元素。

在使用编码器-解码器结构的方法中,训练图像描述模型的损失函数大部分都采用交叉熵函数,这带来了两个问题。第一个问题是在模型训练阶段和测试阶段存在曝光误差(Exposure Bias),这导致了预测单词的错误累计。第二个问题是损失评估不匹配(Loss-Evaluation Mismatching),由于评价标准不可微分,交叉熵函数不能直接对评价函数进行微分计算,可能会造成评价标准对正确图像描述的误判,导致正确的图像描述得分却不高。

为了解决这两个问题,Ranzato等[29]将强化学习技术应用到了自己的模型中。在生成模型中采用交叉熵函数和强化学习同时训练,取代了单独使用交叉熵损失函数训练的方法。针对生成文本阶段的错误累计问题,该模型在解码器的尾部引入强化学习,并直接对评估标准进行优化,取得了不错的效果。在使用策略梯度训练端到端模型的背景下,Rannie等[30]提出了SCST方法,在训练图像描述模型时融入强化学习,改善了使用序列训练的图像描述模型性能,大大提升了实验准确率。同样使用序列训练,Zhang等[31]提出使用Actor-Critic的强化学习方法。该方法在原有序列训练的基础上,新增了价值模型作为强化学习中的baseline,并且在模型中引入自注意力机制,降低采样过程中样本重复出现的概率,实验表明该方法在各项指标上都有不错的效果。Liu等[32]提出使用交叉熵函数和强化学习损失函数协调训练的方法,首先使用交叉熵函数进行训练,随着训练时间的提升,不断提高使用强化学习损失函数训练的时间,直到图像描述都是由强化学习损失函数训练得来。在解决损失评估不匹配的问题上,Gao等[33]从状态值函数与当前状态前一时刻状态动作值函数的关系中,提出了n-step的优势函数。在强化学习的过程中,使用n个时间步逐渐增加状态值函数绝对值的均值,在降低方差的同时重新设置优势的平均值。目前的强化学习有着巨大的发展空间,如何设计出更好的奖励机制和反馈机制是提升强化学习性能的关键所在。并且强化学习算法已经逐渐成为图像描述任务不可缺少的一部分,在不同的评价指标下,使用强化学习的方法显著提升了图像描述效果。使用强化学习的方法在不同数据集上的实验结果如表3所示。

根据表3可以看出,基于强化学习的方法在数据集上的实验结果相差不大,在强化学习技术的使用上,Ranzato、Rannie和Liu在训练阶段引入强化学习;Zhang和Gao引入强化学习的同时,还引入了注意力机制,这种方法和同时代的使用强化强化学习的图像描述方法相比,准确率更高。基于强化学习的方法是图像描述任务的重点,它能够在现有方法的基础上,优化模型训练函数和实验评价指标,提升模型性能,起到锦上添花的效果。

表3 基于强化学习的方法在数据集上的实验结果

2 数据集与评价指标

2.1 数据集

图像描述领域中,已知大约有几十个公开的大型数据集,其中使用最广泛的数据集主要有MS COCO[34]、Flickr30K[35]、Conceptual Captions[36]。

2.1.1 MS COCO数据集

MS COCO(Microsoft Common Objects in Context)数据集主要使用在目标检测、目标追踪和图像描述任务中,在2014年发布了第一个版本。MS COCO数据集共包含16.4万张图像,其中有8.3万张训练图像、4.1万张验证图像以及4.1万张测试图像,每一张图像都有5个对应的图像描述。整个数据集具有80个对象类别,91个物体类别;用于关键点检测的图像超过20万张,带有关键点标注的个体实例图像25万张,带有注释的实例图像5.6万张。2015年,MS COCO数据集发布了补充版本,在原有数据的基础上新增了8.1万张测试图像,包括所有以前的4.1万张测试图像和4万张全新图像。随后在2017年,MS COCO数据集再次更新,更新后的数据集共有超过32万张图像,是目前图像描述任务最主流的数据集之一。

2.1.2 Flickr30K数据集

Flickr30K数据集于2015年发布,图像从Flickr网站上收集而来,包含3.1万张图像与5.1万个实体,其中验证图像和测试图像都为1 000张。与MS COCO数据集相同,每一张图像对应5个参考语句,参考语句均由人工注释。由于Flickr30K数据集图像数量较少,常常在验证模型时使用,和在MS COCO数据集上验证相比,这节省了大量的训练时间。

2.1.3 Conceptual Captions数据集

Conceptual Captions数据集是谷歌2018年发布的大规模图像描述数据集,拥有超过300万张图像。包含330万张测试图像、2.8万张验证图像和2.2万张测试图像,每一张图像对应一个参考语句。这些图像和参考语句均来自于网络,因此代表了更广泛的风格。正是因为数据集中图片的广泛性,Conceptual Captions数据集对大量的图像类型有着更强的适应性。此外,为了保证参考语句的简洁性、信息量、流畅性和学习性之间的平衡,谷歌开发出了用于提取、过滤和转换候选图像-描述对的自动管道。

2.2 评价指标

验证机器学习模型的结果是检验模型有效性的重要手段,使用人工评估模型的结果成本过于昂贵,所以对模型结果进行自动评估尤为重要,本小节将会介绍图像描述领域的评价指标。目前图像描述领域常用的评价指标有BLEU[37]、METEOR[38]和CIDEr[39]。

2.2.1 BLEU

IBM公司在2002年提出BLEU(Bilingual Evaluation Understudy,BLEU),提出初期主要用于机器翻译任务的结果评估。这是一种基于准确率的评价标准,通过比较待评价语句的n-grams和参考语句的n-grams,并且计算二者匹配的数量从而得出评价结果。参考语句和待评价语句n-grams的匹配项是位置独立的,匹配的数量越多,表明待评价语句的翻译质量越高。公式可以表示为:

(1)

其中,Candidates代表所有待评价语句,评估时可能有多个语句,所以ΣC∈{Candidates}代表所有待评价语句;Σn-gram∈C表示统计每个待评价语句的n-gram;Countclip(n-gram)代表随机的一个n-gram在待评价语句中出现的次数;Count(n-gram')代表参考语句中n-gram的总数。另外,BLEU中引入了惩罚因子BP,确保待评价语句必须在语句长度、单词选择和单词顺序上均与参考语句相匹配,有效减少短句的精度过高的问题。

2.2.2 CIDEr

CIDEr(Consensus-based Image Description Evaluation)是图像描述领域的专用评价标准,用来衡量图像生成的文本描述和人类描述的相似性。CIDEr通过计算每个n-gram的TF-IDF权重,得到的权重就是待评价语句和参考语句之间的相似度,根据相似度的高低判断生成的图像描述质量的效果。计算权重的公式表示为:

(2)

其中,gk(sij)代表n元组ωk的TF-IDF加权;hk(sij)代表一个n元组ωk出现在人工标注语句sij中的次数。Ω代表包含所有n-gram的词汇表;I代表数据集中所有图像的集合。简单地说,TF对参考语句中经常出现的n-gram具有更高的权重,而IDF减少了数据集中所有图像中经常出现的n-gram的权重。

CIDEr考虑了自然语句的准确率与召回率,通过计算待评价语句和参考语句的平均余弦相似度, 得到n元组的CIDEr评分,计算公式如下:

(3)

其中,gn(ci)是gk(ci)生成的向量,表示长度为n的所有元组,gn(Sij)则是n元组ωk的TF-IDF权重gk(Sij)生成的向量。‖gn(ci)‖和‖gn(Sij)‖代表相对应的向量的模。与BLEU相比,CIDEr在评估方面的效果更好,因为BLEU认为相匹配的单词重要性相同,但实际情况是个别单词有更高的重要性。

2.2.3 METEOR

METEOR(Metric for Evaluation of Translation with Explicit Ordering)是在BLEU提出后推出的评价标准,最初也是在机器翻译领域中使用,该方法通过计算单个单词的准确率与召回率的加权调和平均数,从而得到最终得分。和BLEU相比,METEOR通过调整相关参数,实现了对训练数据的优化,实验表明,这种优化改善了评估结果与人类判断之间的相关性。METEOR评估得到的分数越高,表明生成的图像描述效果越好。得分公式可以表示为:

score=(1-Pen)·Fmean

(4)

其中,Pen代表惩罚系数,表示两个字符串中匹配的单个语句中单词顺序的相同程度,惩罚系数的公式表示为:

(5)

其中,γ(0≤γ≤1)决定最大惩罚值,ch代表最小的词片段,m代表词库提供的校准值。

3 工作展望

图像描述经过这些年的发展,在技术上取得了巨大的进步,在未来的人工智能领域,图像描述也会逐渐占据十分重要的技术地位。然而目前图像描述技术还面临着几个挑战,本章基于现有的图像描述研究方法,对图像描述工作做出如下展望。

3.1 更好的预训练模型

目前基于预训练模型的图像描述方法受到广大研究者的青睐,近几年在CV领域、NLP领域、多模态领域等出现了效果极好的预训练模型,该方法不需要调整模型结构,只需要在图像描述任务中使用就能获得极高的正确率。然而预训练模型的迁移能力有限,对于数据集规模较小的下游任务,使用预训练模型可能导致高估或低估的问题。并且对于有中间任务的目标任务来说,可能出现遗忘预训练知识的现象,所以更好的预训练模型可以提高图像描述的准确性。

3.2 生成模型的创新

图像描述的解码端用于生成最终的文本输出,高效的生成模型可以大大提高图像描述的准确率,目前许多工作都在解码端对生成模型展开创新,取得优异的效果。良好的生成模型可以提高输入特征的使用效率,在高维空间完成图像与文本特征的匹配。因此,在图像描述任务中,创新生成模型具有很高的研究价值。

3.3 评价指标的更新

近些年图像描述发展迅速,生成的图像描述不仅有正确率的要求,而且也在慢慢向多样化靠拢。然而现有的评价指标已经无法对这些要求做出准确的评估,甚至隐约已经开始制约图像描述技术发展。当前图像描述领域的许多评价指标都是从机器翻译领域借鉴而来,缺乏专门适用于图像描述领域的评价指标,构建图像描述的评价指标是未来的重点任务。

4 结束语

从概述图像描述的发展历程出发,逐一介绍了图像描述的相关数据集、评价标准以及相关方法,并对使用深度学习方法的实验结果进行分析比对。从早期的模板填充、检索,到如今广泛使用的深度学习,方法的创新带来了图像描述效果的显著提高,使用深度学习方法的准确率居高不下。然而即使在深度学习的方法下,图像描述仍然存在着一些问题,在小型数据集上预训练模型的迁移能力受限、图像描述应用领域的狭窄、生成图像描述风格的单一、评价指标的落后等都是亟待解决的问题。在社会生活中,图像描述也有非常重要的社会意义,辅助视障人士、自动生成影像报告、智能家居等技术都为提高社会舒适度做出了重要贡献,在未来,图像描述任务仍然是一个极为重要的研究方向。