数据中心制冷技术探究

王香丽

关键词:数据中心;PUE;间接蒸发制冷;浸没式液冷;冷板式液冷

1引言

在数据中心内部,信息处理设备消耗的电能几乎全部轉换为热量,为了保证设备的正常工作环境,必须将这些热量进行扩散,因此需要根据建设的规模、区域及政策导向选择合适的制冷系统。

PUE值是国际上认可的数据中心能源使用效率的衡量指标。其中,PUE设备总能耗+制冷设备总能耗+供配电损耗

PUE是一个比值,越趋向于1,IT设备的电量占比数据中心总电量越多,说明数据中心电能利用率越高。

对于采用风冷直膨式空调系统的数据中心而言,其全年PUE值大于2:对于采用冷水机组制冷的数据中心而言,其全年PUE值在1.6左右;对于采用带自然冷的冷水机组制冷的数据中心而言,其全年PUE值在1.3~1.45左右。

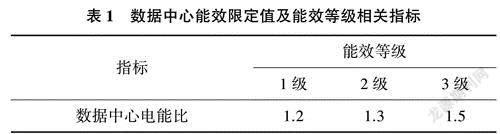

《数据中心能效限定值及能效等级》GB40879-2021相关指标如表1所列。

数据中心能效限定值为能效等级3级。

《数据中心能源效率限额》D811/T1139-2019相关限定值如表2所列。

已稳定运行一个自然年以上的数据中心,其PUE值应符合限定值要求;新立项或改扩建的数据中心,其PUE值应符合准人值的要求。

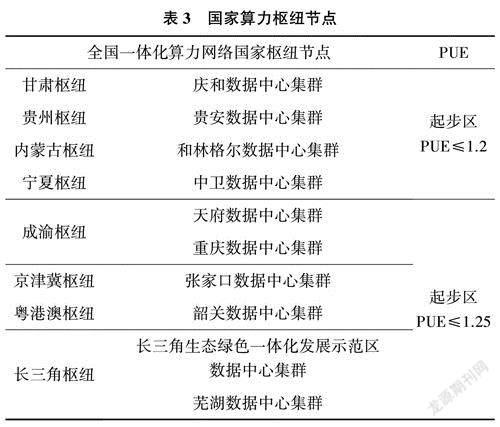

2022年,国家多个部门联合印发通知,同意在京津冀、长三角、粤港澳大湾区、成渝、内蒙古、贵州、甘肃、宁夏等8地启动建设国家算力枢纽节点,并规划了10个国家数据中心集群,同时对该集群的PUE值作了规定。详见表3。

2020年以前,数据中心主要采用的制冷形式为带自然冷的冷水机组制冷,但其PUE值不满足新的政策要求。为了响应国家号召,需采用更节能的制冷形式,目前国内新的制冷形式主要有:间接式蒸发机组制冷、液冷。

2间接式蒸发机组制冷

间接蒸发制冷是利用室外自然冷源,将室外低温空气和室内高温空气在设备内进行热量交换,从而带走室内热量,并把冷量送到数据机房内。

间接蒸发制冷系统是室外进风和室内回风在“空气一空气”换热器内进行热量交换,室内外空气无直接接触,保证了室内空气的洁净度。间接蒸发制冷系统主要有三种运行模式,即干工况自然冷、湿工况自然冷、混合工况。

2.1间接式蒸发制冷系统架构

干工况自然冷即新风间接冷却,当室外干球温度不大于某一温度Tg时,室内外空气在换热器进行热量交换,把数据机房室内的服务器等产生的全部热量通过室内空气传递给室外空气,输送至室外大气。详见图1。

湿工况自然冷即间接蒸发冷却,当室外干球温度大于某一温度Tg时,对室外空气进行喷淋冷却,降低室外空气干球温度,且喷淋冷却后的室外空气干球温度不大于Tg。室内外空气在换热器进行热量交换,把数据机房室内的服务器等产生的全部热量通过室内空气传递给室外空气.输送至室外大气。详见图2。

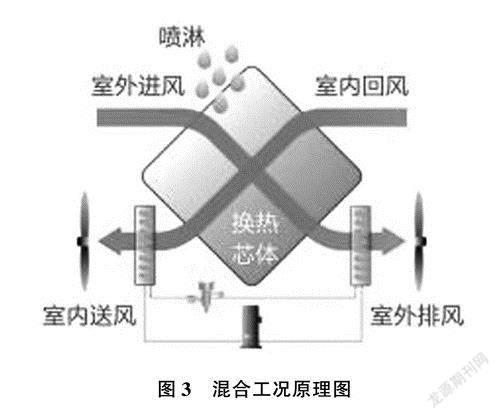

混合工况是在机械制冷的前提下,最大限度地使用混合工况自然冷却。当室外干球温度大于某一温度Tg时,对室外空气进行喷淋冷却,降低室外空气干球温度,且喷淋冷却后的室外空气干球温度大于Tg时,开启混合工况模式。混合工况工作原理是先通过喷淋降低室外空气温度,室内外空气在“空气一空气”换热器内进行热量交换,然后再经过压缩机制冷将室内空气温度降低到需求温度,进而把数据机房室内的服务器等产生的全部热量输送至室外大气。详见图3。

间接蒸发冷技术保证了室内空气不受室外环境的影响,喷淋加湿空气也不会影响室内湿度。与冷水机组制冷相比,其具有耗水量少、节能、便于分区建设、维护方便等优点。

2.2间接式蒸发制冷案例

项目名称:宁夏某数据中心

项目描述:主机房内有560个机柜,单机柜平均功率8 kW。电池间和变配电室均采用分体直膨式房间级空调。

本项目共建设20台间接蒸发冷设备,单台设备制冷量为280 kW,运行模式为18+2。经计算,项目PUE值为1.19。

3液冷

随着大数据、人工智能的发展,数据中心规模也不断扩大,单机架功率不断提升。与此同时,数据中心单机架功率的提升使数据中心热量积聚问题愈发显著,传统风冷制冷方式散热能力不足的缺陷逐渐暴露出来,成为影响单机架功率密度提升的主要因素[1]。

当前,我国处于数据中心发展的关键时期,数据中心算力的需求不断增长,单机柜功率也不断升高,并且绿色数据中心的建设和发展受到社会格外关注。此时,要求数据中心制冷方式必须迎接挑战,新型的制冷技术应运而生——液冷。液冷技术的兴起,全面改变了数据中心基础设施建设[2]。

3.1液冷系统架构

基于不同的液冷技术原理,液冷数据中心发展出不同的解决方案,主要有浸没式液冷、冷板式液冷。

3.1.1浸没式液冷系统架构

浸没式液冷系统工作原理:高密度服务器布置在浸没腔体中,腔体中充满冷却液,高密度服务器产生的热量传递给冷却液,冷却液在冷却子系统中与外部冷却水换热,把热量传递给冷却水,冷却水经室外冷源设备把热量释放到空气中。详见图4。

冷却液的导热系数高于空气,且整个系统主要耗能设备有室外冷源设备的风机、冷却液循环的动力设备,无压缩机,所以整个系统的能效得到了很大的提高。

2017年,阿里巴巴公司建造了浸没式液冷数据中心,能效方面很突出[3]。2018年10月,中科曙光联合上海超级计算中心、国家超级计算深圳中心的E级超级计算机,采用了浸没式液冷技术,系统峰值功耗高达249kW,PUE值仅为1.04,实现了整机系统的高效节能[4]。

由于浸没式液冷系统内服务器是浸没在冷却液内的,对冷却液的品质要求非常高。当前,常用的冷却液是3M公司的氟化液,造价非常高,使得这一技术发展受限。

3.1.2冷板式液冷系统架构

如图5所示,冷却机柜产生的热量由专业冷却液吸收,吸收热量专业冷却液在CDU内和一次侧冷却水进行换热、释放热量与降低温度,再继续在冷却机柜内吸收热量。吸收了热量的一次侧冷却水流经冷却塔,把热量释放至空气中。

在冷却机组内冷却液和服务器无直接接触,仅进行热量交换。现在常用的冷却液为纯水,易获得,且造价低。

冷板式液冷不仅能实现高密度机柜的散热,并且整个系统主要用电设备为冷却塔风机和循环水泵,无压缩机,提高系统能效。

由于冷板式液冷本身的局限性,其不能将高密度机柜的热量全部驱散。剩余的热量需要采用其他辅助方式进行驱散,如间接蒸发机组制冷或者冷水机组制冷等。

3.2液冷案例

项目名称:北京某数据中心

项目信息:主机房内有62个机柜,其中40个机柜采用冷板式液冷系统,单机柜平均功率54.5kW,单机柜95%的热量由液冷负担,剩余部分由冷冻水房间级空调负担:另外22个机柜采用分体直膨式氟泵列间空调,但机柜功率为8.2kW。电池间和UPS间均采用分体直膨式氟泵房间级空调。变压器第一期已建设完成,本期不考虑。

一次侧采用闭式冷却塔,进出水温度为35/49℃,2用1备。CDU二次侧进出水温度为45/55℃,共配置18台CDU,12用6备。经计算,项目全年PUE值为1.18。

4结束语

通过分析,间接蒸发制冷技术符合节能、低碳、绿色的发展趋势,使用间接蒸发冷技术可使数据中心PUE值趋向于1。随着大数据、人工智能等技术的快速发展,单机柜的算力不断提升,液冷技术应运而生。未来,数据中心建设采用何种制冷形式,需根据其规模及其用途而定。但其宗旨是要建设绿色、节能的数据中心。