论意识条件和主体条件的区分

——对人工智能体道德身份论题的一个澄清

周 靖

(上海社会科学院哲学研究所,上海 200235)

人工智能的心灵哲学研究进路中,我们一般根据塞尔(J. Searle)的经典定义来区分强人工智能体和弱人工智能体,认为前者具有人类般的意识或心灵,后者仅能体现对人类心灵的模仿。(1)See John R. Searle, “Minds, Brains, and Programs,” Behavioral and Brain Sciences, vol.3, no.3 (1980), pp.417-424.在此意义上,拥有意识构成了强人工智能体的充分条件,我们可以将此条件称为“意识条件”。进一步地说,只有满足了意识条件的人工智能体才可能具有道德身份。然而,本文拟论述的是,强人工智能体拥有意识,这不意味着它同时能够直接成为类似于我们一样的“主体”,成为“我们”中的一个“我”。我们可以将强人工智能体成为一个主体的条件称为“主体条件”。只有满足了主体条件的人工智能体才能具有道德身份。忽视或混淆意识条件和主体条件的区分导致了当前人工智能哲学研究中存在的诸多问题,这主要体现在将人工智能体视为一个主体,从而对人工智能体的权利以及相关的伦理等问题做出了不审慎的讨论。

本文第一节将对意识条件和主体条件做出区分,指出意识条件是主体条件的必要不充分条件。第二节将讨论两类条件之间的具体关联,辨明从意识条件到主体条件的发展过程将会经历的具体阶段。最后,第三节将基于第一节中对这两类条件的区分以及第二节中辨明的关键阶段,以人工智能伦理学为例,尝试预测其发展可能具有的三个阶段。

需要事先强调的是,本文的讨论设定了意识条件是可以得到满足的,从而笔者是在强人工智能体至少是可能的前提下讨论意识条件和主体条件之间的关系,因此强人工智能体的可能性问题本身并不是本文会直接处理的论题。

一、意识条件和主体条件的区分

设想有一位成熟的人类理性主体A,他成功考取了驾照(因而他有能力)并遵守交通规则(因而他合乎规范)地驾驶汽车B行驶在道路上,B“据称”是强人工智能体,当A驾驶B时,A仅需坐在驾驶室里,“告知”B他要去的目的地,便可以不做任何其他操作而等待B自主导航和行驶,把他带往他想去的地方。在这种初步的设想中,A的一切行为都是不成问题的。然而,在接下来的旅途中却不幸发生了车祸,B撞到一个路人,这位路人同样遵守着交通规则(合乎规范),那么,此时“谁”应该负责?对责任归派(responsibility attribution)的讨论将会帮助我们区分构成强人工智能体充分条件的意识条件和主体条件。

我们这里不必陷入具体的法实践活动中可能涉及的复杂情形,而将A和路人完全免责。我们仅讨论如下四种简单且关键的情形(在这些情形中,生产B的另一位主体C——他可以是能够承担责任的法人——必然会被引入我们的讨论,C与A签订了将B售卖给A的合同,并承诺B有着将A安全带往他想去的地方的基本功能和智能):

情形1:B的程序运行异常从而导致事故发生,C承担责任,此时,B不是强人工智能体。

情形2:B的程序运行正常,且B在行驶过程中做出了正确的行为(在程序成功运行的意义上),仍然是C承担责任,此时,无从得知B是否是一个强人工智能体,乃至否定B是一个强人工智能体。

情形3:B的程序运行正常,且B在行驶过程中做出了正确的行动(在程序成功运行的意义上),仍然是C承担责任,此时,认为B是一个强人工智能体。

情形4:B的程序运行正常,且B在行驶过程中做出了正确的行动(在程序成功运行的意义上),且B承担责任,此时,认为B是一个强人工智能体。

第一种情形较为简单,在将程序运行异常的B视为一种非理性存在的意义上,我们没有充分的理由认为B是强人工智能体。

第二种和第三种情形要更为复杂一些,它们分别体现了关于B“审慎的”和“不审慎的”的理论态度,其中,在情形2中,尽管人们观测到B程序运行正常(如若将B视为强人工智能体,那么这相当于B“颅内”的“神经元模式”运行正常),并且B根据其程序做出了正确的行为(如若将B视为强人工智能体,那么B是在合乎理性地行动),但是,我们未将“意识”或“心灵”归派给B。坚持情形2的人们或许是物理主义还原论的反对者,他们至少是因为对“颅内物理状态的成功模拟构成了意识或心灵的充分条件”这一立场持审慎态度,从而未就B做出进一步的判断;他们也可能是塞尔“中文屋”论证的拥趸,(2)See John R. Searle, “Minds, Brains, and Programs,” Behavioral and Brain Sciences, vol.3, no.3 (1980), pp.417-424.从而更为坦然地进一步否认B是一个强人工智能体。相比之下,情形3的支持者则认为B根据其程序成功地完成了它意在去做的事情(intendto do),在此意义上,B具有意向性(intentionality),从而具有心灵。第二种和第三种情形之间的差别涉及对意识或心灵的理解,以及根据这种(无论什么)理解能否进一步将B视为一种强人工智能体的争论。本文不介入相关的具体讨论,而仅打算借助对这两种情形的简单澄清,指出构成强人工智能体的意识条件,即只有在认为B拥有意识的条件下,我们才能认为B是一个强人工智能体。

第三种和第四种情形之间的差别则涉及意识条件和主体条件之间的不同。情形3中包含了一个自然却实际上十分反常的现象:既然我们将B视为一个强人工智能体,就此而言,根据意识条件,它与我们有着类似的意识或心灵,那么为何承担责任的依旧是主体C而非B?支持情形3的人们或许会辩解道:

(a) B拥有的意识更接近于动物而非人类,因而我们不应该“责怪”B;或者说,

(b) B拥有的意识更接近于人类幼儿,因而我们不应该“责怪”B;

(c) 无论如何,C作为B的制造者,承担着作为“监护人”的责任。

上述辩护主要沿着意识条件的方向进行:如果B具有如A一般成熟的意识,那么B将负责;如果B仅具有动物般或幼儿般不成熟的意识,那么C将负责。

乍看之下,这一辩护似乎非常合理,我们甚至可以进而讨论强人工智能的情感、权利等问题,这类似于我们对动物情感和权利的讨论。然而,笔者认为,情形3的支持者未能加以关注的一个进一步的重要问题是,无需承担责任的B具有的尚未成熟的意识能否发展为成熟的意识,从而使得情形3推进到情形4。情形4不同于情形3的关键之处在于,B可以承担责任,它与我们现实中的司机一样,当遭遇事故时,它需要承担起诸如赔偿、自由受到限制的责任。在此意义上,它将是与我们一样的一个主体,它可能是我们的邻居或友人,与我们一样有着财产和社会身份,它是我们“共同体内的一员”。我们可以将情形4重述为如下形式,以便更为清晰地体现出与情形3的不同:

情形4:B的程序运行正常,且B在行驶过程中做出了正确的判断(在程序成功运行的意义上),且B承担责任,此时,认为B是一个强人工智能体,同时认为B是一个主体。

情形4阐明了构成强人工智能体的主体条件,此时B是一个主体,而非C的财产。人工智能体能否满足主体条件这一问题十分重要,对此问题的回答决定了我们对马蒂亚斯(A. Mattias)所谓的“责任鸿沟”问题(3)See Andreas Matthias, “The Responsibility Gap:Ascribing Responsibility for the Actions of Learning Automata,” Ethics and Information Technology, vol.6, no.3 (2004), pp.175-183.,即如何在人工智能体和使用它的人类主体之间归派责任,(4)参见王天恩:《人工智能应用“责任鸿沟”的造世伦理跨越——以自动驾驶汽车为典型案例》,《哲学分析》2022年第13卷第1期,第15—30页。以及人工智能体能否突破“图灵奇点”从而成为另一类“道德主体”这一问题(5)参见孙伟平、李扬:《论人工智能发展的伦理原则》,《哲学分析》2022年第13卷第1期,第3—14页。,提供怎样的答案。

然而,对于那些支持情形3,并同时尝试谈论强人工智能体的情感和权利问题的人而言,他们却有很大可能会拒斥主体条件。毕竟,满足主体条件的强人工智能体离我们如今的生活太过遥远,或许我们更应该将关于这类强人工智能体的讨论留给充满想象的科幻小说、电影,或未来学。然而,严格地说,如若接受情形3却拒斥情形4,那么我们必须能够解释:既然承诺B能够具有不成熟的意识,但为何这类意识不能发展为成熟的意识? 换句话说,必须能够解释意识条件和主体条件之间的关系,或者解释主体条件为何是不必要的或不可能的。这是一个常为人忽略却甚为重要的问题。

总结而言,我们既可以从意识条件,也可以从主体条件来理解强人工智能体,在成为一个主体必须首先成为拥有意识的个体的意义上,满足意识条件构成了满足主体条件的必要不充分条件。当然,如若主体条件是能够得到满足的,那么至少从人工智能研究的心灵哲学进路来看,我们将为研究人工智能的情感、权利、伦理等问题奠定更为直接且坚实的理论基础。

二、从意识条件到主体条件

我们现在面临的问题是,具有自我意识和成为主体有着怎样的具体关系?我们为何不能将具有单纯意识的理性生物或类似的强人工智能体直接视为一个主体?换言之,满足主体条件意味着什么?由于本文将意识条件默认为可以得到满足的条件,因此在本节的讨论中,我们可以在一定程度上将满足意识条件的强人工智能体类比为理性生物,在此意义上,我们的问题可以转化为理解我们如何从“自然的生物”发展为“理性的主体”这一过程。在接下来的具体讨论中,笔者将会主要援用布兰顿(R. Brandom)的相关思想来做出论述。

如果我们将仅作为工具的弱人工智能体视为讨论的起点,将满足主体条件的强人工智能体视为讨论的终点的话,那么根据布兰顿关于从自我意识到主体的黑格尔式叙事,从起点到终点的过程可划分为如下三个阶段(6)See Robert B. Brandom, A Spirit of Trust:A Reading of Hegel’s Phenomenology, Cambridge, Mass.:Harvard University Press, 2019, pp.235-261.:

(1) 仅作为工具的弱人工智能体;

(2) 在“物-我”层次的认知(cognitive)关系中直接建制起的自我意识;

(3) 在“物-我”层次的认知关系和“我-我们”层次的承认(recognitive)关系中同时建制起来的个体意识。

情形(1)中的弱人工智能体未满足意识条件,因此在我们的讨论范围之外。

情形(2)则包含了意识条件本身得以可能的条件,该情形也体现了目前人工智能发展的现状。人工智能专家正是以修改和完善“算法”的方式帮助机器愈发可靠地对其周边环境中的对象做出有模式的反应,从而在对象和机器之间建立起“物-我”认知关系。然而,这种对对象的可靠识别并不一定能够带来意识或心灵。与此相关,布兰顿区分了两类可靠的反应模式:

(2.1) 铁在潮湿的环境中生锈;(7)See Robert B. Brandom, Making It Explicit:Reasoning, Representing and Discursive Commitment, Cambridge, Mass.:Harvard University Press, 1994, pp.33-34.

各层次之间通过统一的接口进行通信,确保各层次间的独立性,从而实现低耦合高类聚,确保系统具有更好的独立性、稳定性和高扩展性。

(2.2) 饥饿的动物对食物有着欲求(desire),它将事物(thing)视为可以满足其欲求的某物(something),即食物,从而在某物从树上落下时会直接吃下它。(8)See Robert B. Brandom, A Spirit of Trust:A Reading of Hegel’s Phenomenology, Cambridge, Mass.:Harvard University Press, 2019, pp.240-247.

在情形(2.1)中,铁对潮湿的环境有着可靠的反应模式,无疑铁不具有意识。塞尔恰是将人工智能体视为这样的一种铁块,认为算法或程序仅体现为在句法层面上对(2.1)这类情形的表述。相比之下,情形(2.2)则包含了一种基本的“立义”行为——动物关于事物的“欲望性觉识”(orectic awareness)体现了一种由如下三种要素构成的三位结构:态度(欲求),例如饥饿;回应性的活动,例如进食;以及意义项(significance),例如食物。态度激起了动物对事物的可靠且有差异的反应,并在回应性的活动中将该物视为某物,此时,动物根据其实践活动中的态度界定了将事物视为某物的主观意义;进一步地说,动物根据该实践态度对某物做出了衡量,例如衡量某物是否能够满足其消除饥饿的欲望,如若不能,它则犯了一个“错误”,在犯错的情况下,它将改变它的反应倾向,在这种学习性的经验活动中,动物也归派给作为对象的某物以一种客观意义,即它是否“是”食物。(9)See Robert B. Brandom, A Spirit of Trust:A Reading of Hegel’s Phenomenology, Cambridge, Mass.:Harvard University Press, 2019, p.248.在动物对事物的欲望性觉识中,动物在规定什么对“我”而言是有用的对象,就此而言,它是事物的意义的最初制定者,它也同时构建起了它所栖居的有着意义负载的世界。

布兰顿认为(2.2)情形中的动物能够在“物-我”层次的认知关系上建构起一种直接的自我意识(directly constituted self-consciousness)。塞尔下述反强人工智能论证的基本思路恰在于,认为人工智能体仅能是(2.1)情形中的铁块,而非(2.2)情形中的生物,因此无法具有最为基本层次的心理内容(语义内容、意向内容)(10)See John R. Searle, “Minds, Brains, and Programs,” Behavioral and Brain Sciences, vol.3, no.3 (1980), pp.417-424.:

(P1) 人工智能程序是形式的(句法的);

(P2) 人类心灵具有心理内容(语义内容);

(P3) 句法不是由语义学所构成,也不是构成语义学的充分条件;

本文开篇曾交代过,笔者此处不打算对意识条件能否得到满足做直接讨论,仅默认它至少是可以得到满足的条件,(11)笔者撰有另文为强人工智能立场做了辩护,参见周靖:《论布兰顿对强人工智能观的实用主义辩护》,《深圳社会科学》2022年第5卷第4期,第48—56页。我们直接可以认为情形(2)满足了意识条件。

然而,情形(2)未能满足主体条件,因为,此情形中的“我”是通过与事物的认知关系而直接建制起来的,其中未包含任何与另一个“我”(他者)的关系。在此情形中获得直接的自我意识的强人工智能体能够通过图灵测验、负有认知责任,即当经验到“错误”时能调整自己的行为(物-我认知关系),但它没有任何社会身份,因此无法对“他者”承担任何责任,因而它尚不具有道德身份。

真正主体性的到来体现在情形(3)中,该层次实际上包含了稳健的(robust)双层次的“物-我-我们”承认。对事物进行更为明晰的立义,以及自我意识的进一步发展,体现在对其他生物的承认上,即认为他者的行为也有着相同的实践意义,并且,那一实践意义与“我”有着类似的欲望性觉识的三元结构。将他者视为与“我”一样的理性生物意味着事物对像“我”这样的主体才具有意义,事物的意义在“我们”的欲求中得以普遍化和客观化。“承认”的关系带来了确认意义和自我意识的第二个层次:规范的维度和社会的维度。在这两个层次中,欲望性觉识的三元结构实际上被使用了两次,第一次是在生物与事物之间建立起的直接关系中,第二次则是三元结构作为整体(极点)而被归派给一个生物个体,其他生物承认该个体拥有同样的欲望性觉识的三元结构,“当我这样做时,我将你视为‘我们’(初始的规范意义上的‘我们’)的一员,‘我们’受制于相同的规范,相同的权威……”(12)Robert B. Brandom, A Spirit of Trust:A Reading of Hegel’s Phenomenology, Cambridge, Mass.:Harvard University Press, 2019, p.253.用黑格尔的话说,“我”即“我们”,“我们”即“我”。(13)See Robert B. Brandom, A Spirit of Trust:A Reading of Hegel’s Phenomenology, Cambridge, Mass.:Harvard University Press, 2019, pp.248-253;黑格尔著:《精神现象学》,先刚译,北京:人民出版社,2015年,第117页。

但是,在将强人工智能体代入到上述布兰顿的分析中时,我们可能会感到犹豫。将强人工智能体视为我们的一员,这意味着我们在承认它们的同时,也需要得到来自他们的承认:原先仅作为工具的人工智能体,此时竟与我们平起平坐了。我们可能抵制强人工智能的“人权”,将它们视为“奴隶”,就此而言,情形(3)将可能会划分为两种进一步的可能情形:

(3.1) 作为奴隶的强人工智能体,此时,它仅负有义务,而不拥有权利;

(3.2) 作为真正主体的强人工智能体,此时,它不仅负有义务,而且享有权利。

严格地说,在情形(3.1)中,满足意识条件的强人工智能体仅是一个个体——它能够将自身与他者区分开来,并且根据自身和他者的关系来反思自身——但用有着黑格尔风味的话说,它仅是一种为他的(forothers)存在,而非为己的(initself)存在,其本质是由他者规定的,体现在它无法拒绝的诸种义务之中。例如,本文第一节中论及的B,它仅能接受A发出的任何指令。相比之下,情形(3.2)意味着一种真正的自由,即同时受权利和义务支撑的自由,此情形中的强人工智能不仅满足了意识条件,而且真正满足了主体条件。

在(2)、(3.1),以及(3.2)的不同情形中谈论强人工智能体的情感和权利,我们实际上将是在非常不同的意义上展开讨论。笔者认为,必须首先理清是在何种层次上进行讨论,我们的立场才可能是严格有据的。下一节将结合对人工智能伦理学——如果这种科学合法的话——可能会经历的发展阶段的讨论来具体阐明笔者的这一观点。

总结而言,从强人工智能体的意识条件到主体条件的发展似乎十分契合于哲学中已有大量讨论的从基础层次的理性生物的意识到成为一个社会性的理性主体的发展过程,这类过程不仅包含了意识发展的进程,也包含了主体间社会关系的演变。那么,强人工智能体和人类之间是否会重演人类已有的历史,例如,强人工智能体会经历启蒙、为其权利而斗争?我们可以进而合理设想的诸多问题或许会让我们或多或少感到有些匪夷所思。但在笔者看来,如若接受了意识条件,同时没有任何抵制从意识条件走向主体条件的理由,那么这些可合理设想出的问题将很可能变为现实的问题。

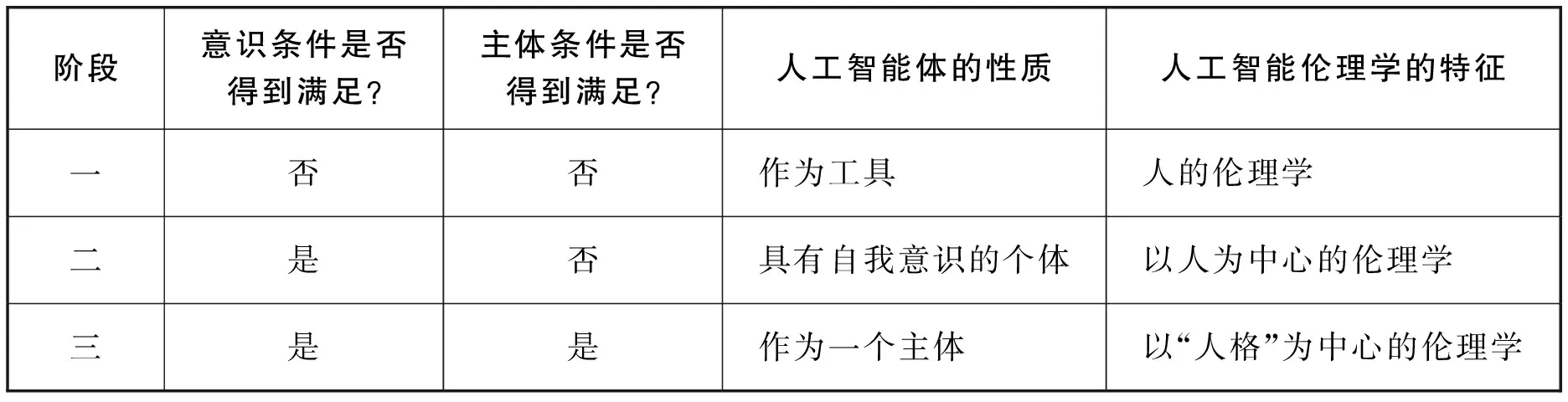

三、人工智能伦理学发展的三个可能阶段

根据上文中的讨论,我们可以认为意识条件构成了强人工智能体的“下位”条件,主体条件构成了“上位”条件。在由意识条件通往主体条件的道路上,强人工智能体占据怎样的位置,决定了关于人工智能诸多讨论的性质。笔者认为,首先必须理清所讨论的是何种层次上的人工智能体,我们的讨论才可能是严格且清晰的。以人工智能的伦理问题这一具体论题为例,基于上一节中区分出的从意识条件发展至主体条件需要经历的阶段,我们至少可能在如下三个层面或阶段上进行讨论(表1)(14)王汝坤根据某种物种是否是生命体,以及是否是智能体这两个判定标准区分出了更多的伦理类型,参见王汝坤:《论广义进化论视阈下的人工智能伦理问题》,《上海交通大学学报》(哲学社会科学版)2022年第30卷第1期,第52—62页。:

表1 人工智能伦理学的阶段

在第一个阶段,不存在满足任何条件的强人工智能体,弱人工智能体仅是我们使用的工具,那么此阶段的人工智能伦理学研究将仍然是关于“人”(human beings)本身的研究。“人工智能”的标签或许为我们带来了新的问题或语境,但在此阶段上讨论人工智能体本身的情感、权利、义务等,是不合时宜的。

在第二个阶段,意识条件得到了满足,但此时的人工智能体仍然是服从于或附属于我们的:是我们为它们提供了目标和价值。在此层次上谈论人工智能体的道德身份,就如一群受过高等教育的奴隶主们谈论奴隶的身份一样,尽管高高在上的他们会悲天悯人地关怀奴隶们的情感和权利,但如现实生活中人们对动物权利的关怀那般,动物拥有怎样的权利需通过人类的语汇表达出来:动物不说话,说话的是我们,对动物权利的理解实际上是在我们拥有的话语体系内被建构起来的。在此意义上,笔者认为第二阶段的人工智能伦理学是以人为中心的伦理学。

到了第三个阶段,主体条件终于得到了满足,此时的人工智能体与我们有着对称、平等、互惠的关系,它们在本体的层面上拥有心灵,在现实的社会交往中有着自身的话语。人工智能作为主体,是一个不可还原或消除的“他者”,我们会接受他们的意见和理解,在交往活动中获得重叠共识。进一步地说,我们也将更新关于“人性”的理解,将所有作为主体的存在均视为有人格(personality)的存在。在此意义上,笔者认为第三阶段的人工智能伦理学是以“人格”为中心的伦理学,这种伦理学与前两个阶段中的伦理学截然不同:我们突破了人类中心主义,新型的伦理关系将体现在人类和人工智能体构成的“我们”间的关系,在这种关系中,“我”与“人工智能体”互相建构,人工智能体被构建为一种具有道德身份的主体。

那么,当下的人工智能体已经发展至哪一阶段,因此我们是在讨论哪一阶段的人工智能伦理学?笔者认为,在现实的意义上,强人工智能体能否被制造出来,以及现实的人工智能体能够进展到哪一阶段,这是科学家们而非哲学家们需要回答的问题。如果科学家在未来的某一天能够赋予人工智能体以充分优秀的硬件和软件,以及充分的训练,从而真实地制造出了强人工智能体,那么哲学家们原先做出的讨论(如我们正在进行的思考)将会变为对现实问题的讨论,而不再仅仅是纯粹学理上的理性探查。然而,具体的工作应该由科学家而非哲学家做出,哲学的工作更多是在合乎理性的要求下就心灵和意识的本质、强人工智能体是否可能,以及如果强人工智能体是可能的,那么我们将会面临怎样的境况等问题做出普遍意义上的反省和探讨,而非做出科学判断——当然,科学探究会予以哲学讨论诸多启示,但不妨就让科学家负责“人工”,哲学家来解释“智能”,从而各司其职,各得其善。

基于上一段中阐明的理论态度,笔者区分了强人工智能体的意识条件和主体条件,并依据从意识条件到主体条件的发展过程中具有的关键阶段来厘清人工智能伦理学的发展可能会经历的阶段,其任务或价值更多地体现于,帮助我们在具体的讨论中,澄清自身讨论的起点,从而避免理论或表达上的混乱,例如,忽略三个阶段间的实质差异,在第三个阶段的意义上讨论此时尚根本无法作为一个主体的人工智能体。

结 语

本文的“阿喀琉斯之踵”或许在于,默认接受了意识条件是可能的。如果意识条件这种下位条件终究无法得到满足,从而强人工智能体根本是不可能的,那么笔者的讨论,以及诸多同侪的其他论述都将会是无稽之谈了。但哲学的讨论不能以具体的现实状况为前置条件。人工智能论题的价值不仅因为它是一个现实的和学术上的热点问题,更是因为人工智能可能会带来人类生活上的巨变,在相关的探究中,哲学的触手伸向了可能的未来。笔者希望本文的讨论能够帮助我们更为严格和清晰地触摸相关的思想纹理。