多视场宽时域仿生极高速成像

朱启凡,蔡懿,曾选科,龙虎,朱永乐,曾亮维,李景镇,陆小微

(1 深圳大学 物理与光电工程学院 深圳市微纳光子信息技术重点实验室,深圳 518060)

(2 深圳大学 物理与光电工程学院 光电子器件与系统教育部与广东省重点实验室,深圳 518060)

0 引言

极高速成像技术可以对皮秒及飞秒领域内瞬态事件的动态进行记录,为极端条件下的生物[1]、物理[2]、化学[3]等领域的基础研究提供重要依据。传统的极高速成像采用重复测量的泵浦探针[4-5]可以获得可重复事件的动态,但对于非重复或随机的瞬态事件,如飞秒激光加工[6]、激光损伤[7]等,必须要采用单次曝光的极高速成像技术。因此,对单次曝光的极高速成像技术的研究已成为研究热点。

直接成像的极高速成像技术可以通过时序图像的空间分离实现动态图像的记录,但存在探测系统复杂的问题。啁啾脉冲技术广泛应用于直接成像技术中,利用光谱与时间的映射实现分幅,其成像的关键在于使不同光谱的图像分离。时序全光映射技术(Sequentially Timed All-optical Mapping Photography,STAMP)[8-9]将啁啾脉冲技术引入极高速成像,通过反射镜阵列和衍射光栅实现了时序图像的空间分离。研究人员在此基础上进一步提出基于光谱滤波的时序全光映射方法(Sequentially Timed All-optical Mapping Photography Utilizing Spectral Filtering,SF-STAMP)[10]和基于透镜阵列的时序全光映射方法(Lens Array Sequential Timed All-optical Mapping Photography,LA-STAMP)[11],通过衍射元件、微透镜阵列等元件使时序图像的空间分离结构小型化。啁啾光谱映射超快成像(Chirped Spectral Mapping Ultrafast Photography,CSMUP)[12]采用高光谱探测器实现了高分辨率成像,但摄影频率低;全光网格超快成像(Ultrafast All-optical Photography with Raster Principle,OPR)技术[13]结合网格成像技术,充分利用像面实现了摄影频率2×1012帧/s 的极高速成像。除了利用光谱空间分离以外,YEOLA S 采用反射镜阵列[14],利用空间角度分离时序图像,但这种方法获得的时序图像具有不同角度的旋转。ZENG X 提出的非线性光参量放大分幅成像技术(Framing Imaging Based on Noncollinear Optical Parametric Amplification,FINCOPA)[15],结合光参量放大技术,实现了83 lp/mm 的高空间分辨率和15×1012帧/s 的摄影频率,但每增加一幅图像需要增加一支光路和探测,使得系统庞大。

极高速成像与算法相结合,可以将时序动态压缩在一幅图像上再通过算法求解多幅时序图像,极大地简化了探测结构,但会存在分辨率下降、视场受限等问题。结合压缩感知算法的极高速成像(Compressed Ultrafast Photography,CUP)[16-19],可以在单次成像中获得数百幅时序图像,但存在分辨率低、有效画幅有限且复原图像存在误差的问题。采用空间角分复用算法和全息技术的极高速成像,是一种稳定和准确的时序图像成像方法。空间角分复用通常利用不同角度的参考光形成不同方向的干涉条纹,实现全息极高速成像[20-22]。之后,HUANG H 利用光栅的角色散特性[23],解决了由于飞秒脉冲脉宽短限制干涉条纹产生区域的问题。但这些全息方法大多采用分光路的方法产生多个时序脉冲,因此其分幅系统庞大。MOON J 提出了显微极高速成像技术(Single-shot Imaging of Microscopic Dynamic Scenes,SSIMDS),利用空间光调制器在4f系统调制面产生点阵[24],并用台阶对点阵进行时间调制,使全息分幅结构紧凑,然而这种方法由于台阶结构改变光程,限制了视场并且只能应用于飞秒时间领域。类似地,采用方向不同的光栅对应不同时刻的图像并通过频率识别算法获取多幅图像的方法(Frequency Algorithm For Multiple Exposures,FRAME)[25],同样需要多个支路对应不同时刻的图像,增加了分幅光路的元件数量和体积。

本文以系统结构紧凑、多视场、宽时间尺度为目标,提出了仿生多视场极高速成像。以条纹结构光照明与空间角分复用作为极高速成像的分幅和探测基础,使探测结构紧凑;针对分幅延迟光路复杂的问题,仿生螳螂虾小眼结构,实现时间图像分幅结构集成化;仿生螳螂虾复眼结构,突破超短脉冲相干区域受限。分离成像照明光路和时间延迟光路,扩展动态事件记录的时间尺度。从而实现一种集成化、高精度、多视场及宽时域的单次曝光极高速成像方法。

1 原理

1.1 螳螂虾复眼和小眼结构

螳螂虾小眼(Ommatidium)如图1(a),从外至内依次由角膜(Cornea)、晶锥(Crystalline cone)和感杆束(Rhabdome)构成,角膜和晶锥用于将外界光汇聚到感杆束上,感杆束用于探测和传感光信息。感杆束由视网膜细胞R1~R7 构成,其中心的方形区域由各个视网膜细胞的微绒毛阵列(Microvilli array)构成,其中心的微绒毛阵列呈正交排列,如图1(c),微绒毛阵列由于其微绒毛排列特性及尺寸特性可以在单位面积内获得偏振和光谱信息。螳螂虾复眼(Compound eyes)如图1(b),由小眼并排排列而成,可以扩展螳螂虾的视野。螳螂虾眼的结构形态特性以及功能特性为极高速成像系统提供了新的思路和灵感。

图1 螳螂虾小眼及复眼结构Fig.1 Stuctures of mantis shrimps' ommatidium and rhabdome

1.2 成像原理

螳螂虾微绒毛阵列结构,其特性在于利用微绒毛阵列中微绒毛排列方向和尺寸特性,可以实现在单位面积内对多种功能探测,如果可以将多幅时序图像压缩在一幅图像上进行探测,再通过算法解码将会极大缩小探测结构的体积。因此,采用空间角分复用即不同方向和间距的条纹图像模拟微绒毛阵列去压缩时序图像,即不同时序图像具有不同频率和方向的条纹图像叠加成像后在频域进行解码,实现时序图像的还原。

仿生极高速成像原理如图2,产生一组时序超短脉冲,相邻脉冲的时间间距大于时序脉冲的脉宽,不同的子脉冲在照明物体时具有不同方向或者频率的条纹图案,如图2(a)(左侧为时序脉冲的图案,右侧为对应照明时刻的动态事件)。探测器在单次曝光中,携带目标事件信息的时序脉冲将会在探测器上叠加成像,如图2(b)。对图2(b)获得的图片进行傅里叶变换至频域,其频域图像如图2(c),具有不同条纹方向的脉冲会呈现为以原点对称并垂直于条纹方向的两个光斑,对其中一个进行傅里叶逆变换既可以获得对应时刻图像,如图2(c)中彩色虚线框中所示,从而获得动态事件不同时刻的图像信息。

图2 仿生极高速成像原理Fig.2 The principle of the bionic ultrafast imaging

1.3 仿生极高速成像系统

仿生极高速成像系统光路如图3(a),入射光采用飞秒或者皮秒脉冲。入射脉冲经过分光棱镜(BS)被分为两束:一束光通过反射镜M1和M2用于激发和同步超快事件(蓝线),另一束光为探测光(红线)。探测光先通过延迟单元(Delay unit)产生时序脉冲序列,再通过结构光照明单元(Structured illumination unit)将带有条纹图案的时序脉冲照明在动态事件(Dynamic event),最后通过成像透镜或透镜组(Limaging)在探测器表面叠加成像,而实现该系统的关键在于结构光照明单元和延迟单元。

1.3.1 仿生小眼极高速成像系统

结构光照明单元仿生了螳螂虾角膜与晶锥构成的光学系统。结构光照明系统中透镜阵列仿生了多瓣的晶锥、汇聚透镜仿生了角膜,实现了单个脉冲在空间上进行分割为多个空间独立的脉冲并通过汇聚透镜在照明面重合,为产生时序结构光脉冲提供了可能。因此建立了如图3(b)所示的仿生小眼结构光照明结构,平行光入射至透镜阵列(ML)实现脉冲分割,通过汇聚透镜(L)可以在其焦平面完全重合,此时照明区域是边长为Devent的正方形区域。

式中,Devents是照明事件视场大小,Dm和fm为透镜阵列子透镜尺寸和焦距,f为汇聚透镜LF的焦距。图3(b)中l表示汇聚透镜与透镜阵列焦点之间的间距,从式(1)中可以看出,只要调整汇聚透镜LF的焦距或改变透镜阵列子透镜的尺寸,便可以实现在LF后焦面不同视场大小的照明。从图3(b)中可以看出,入射光经过且仅经过透镜阵列中任意两个子透镜既可以在LF后焦面形成干涉条纹,干涉条纹的方向垂直于两个微透镜中心连线,当一组子透镜中心距为Di时,条纹间距满足

图3 仿生极高速成像系统结构Fig.3 The structure of the bionic ultrafast imaging system

延迟单元由反射镜阵列(ML)构成,而反射镜阵列位于台阶阵列之上。台阶反射镜阵列在空间上将一个脉冲分割为多对先后不同的脉冲,这些脉冲与透镜阵列中的子透镜一一对应,使每组通过子透镜后在照射到照明面的时间不同,从而在照明面产生一系列空间位置相同但到达时刻不同的子脉冲。反射镜阵列中高度分布如图3(b)所示,以中心点对称的两个反射镜高度相同,相邻高度反射镜高度差相同,可得分幅时间为

式中,h为相邻台阶的高度差,c为光速,要求分幅时间∆t大于脉冲脉宽。此时,以中心对称的任意两个子透镜可以在照明面产生一组干涉条纹,条纹方向与子透镜中心连线垂直,条纹频域与子透镜中心距成正比,从而实现具有不同结构光图案的时序脉冲序列对动态事件进行照明,再通过成像系统和探测器成像并解算获得时序图像。

1.3.2 仿生复眼极高速成像系统

区别于一般的激光脉冲,超短脉冲(皮秒及飞秒脉冲)其脉宽短,导致其相干时间短且两束光相干区域受限,会出现干涉条纹无法充满整个照明区域的情况。螳螂虾复眼结构如图3(c),由小眼紧密排列而成,每个小眼均具有独立的视场范围,通过拼接扩大了视场范围。这一生物学特点为扩展视场提供了灵感。因此建立如图3(c)所示的复眼照明结构,由透镜阵列和汇聚透镜阵列(LAF)构成,可以看做是由多个参数相同的小眼照明系统拼接而成,小眼系统满足式(1)和(2),光路参数及照明视场大小满足以下参数

式中,Dm2和Dm1分别为汇聚透镜阵列和透镜阵列子透镜的口径,fm和f为汇聚透镜阵列和透镜阵列子透镜焦距,Devents_i为复眼结构中等效子眼所照明的视场大小,Devents为复眼透镜照明的视场大小,n为等效子眼结构中透镜阵列某一方向的透镜数。从式(4)中可以看出照明超快事件区域随着小眼系统拼接数量的增加而增加,实现每个区域均覆盖有效条纹,从而突破了由于超短脉冲的脉宽及相干条纹频率对相干条纹产生的区域限制。

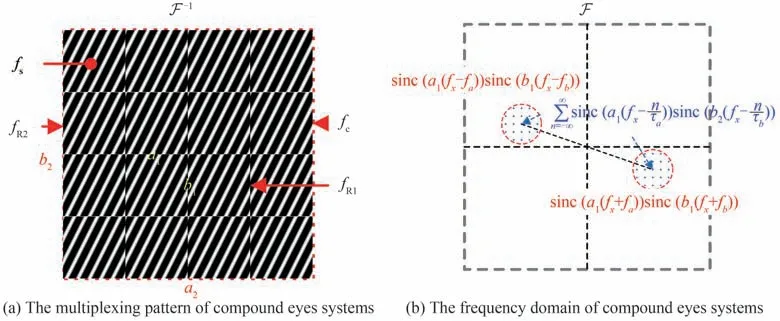

对于拼接图像,重现图像可能会出现不一样的现象。图4(a)为一组照明条纹,其在频域的分布可表示为

式中,Fi表示每一个子脉冲构成的结构光拼接图案,fsi表示条纹函数,fc表示条纹图案分布的梳状函数,fR1和fR2分别表示单位区域和整个照明区域的矩形函数,a1、b1、a2、b2表示整个视场和子视场两个方向的边长,τa和τb表示子视场x和y方向的周期。根据式(5)可以得到该条纹在频域的分布(如图4(b)),与空间频率复用方法类似,只需要对虚线圆圈区域进行取样并进行傅里叶逆变换便可以实现图像的复原。

图4 仿生复眼极高速成像图像还原方法Fig.4 The images restoration method of the bionic compound ultrafast imaging system

2 仿真与实验

仿生极高速成像方法中,要求分幅时间大于每幅图像的曝光时间,不同时刻的动态信息在传播过程中是互相独立的,并在探测器单次曝光中强度叠加,因此在仿真实验中省略了时间形成的过程。为验证仿生多视场极高速成像方法的可行性,采用Zemax 对子眼和复眼系统进行了仿真实验。

2.1 子眼系统仿真实验

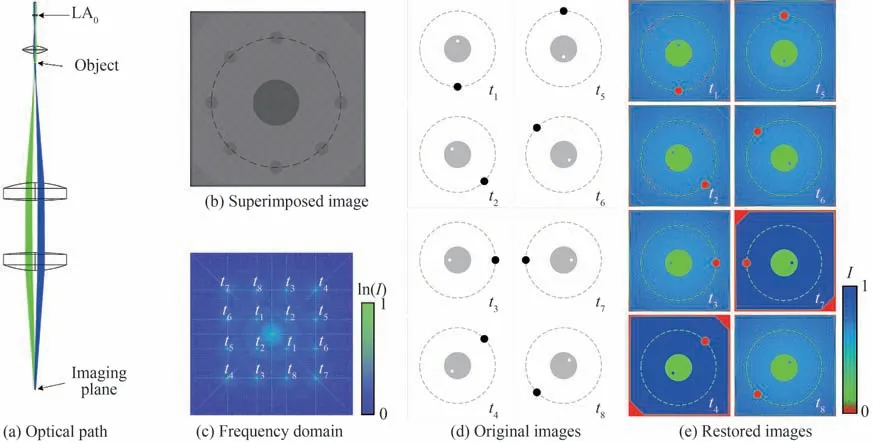

子眼系统仿真结果如图5。仿真光路如图5(a),透镜阵列为4×4 排列,共16 个子透镜分为8 组,可以在单次曝光中获得8 幅图像。透镜阵列中子透镜口径为1 mm×1 mm,焦距为10 mm,汇聚透镜的焦距也为10 mm,成像系统放大倍率为1。因此子眼系统的照明视场为1 mm×1 mm。透镜阵列中的不同组子透镜对应不同的时刻,仿真的动态事件如图5(d)。单次曝光获得的叠加图像如图5(b)。将该图傅里叶变换至频域,为便于观察,图5(c)中的强度分布为ln(I),I表示原频域强度(仿真复眼系统和子眼系统静态实验中的频域分布图像同样使用该方法处理,同时文中所有强度图像均为归一化处理后的结果)。除中心主极大外,不同点对应不同的时刻,通过对区域进行傅里叶逆变换可以还原不同时刻的图像,如图5(e)(为区别于原图,采用了伪彩色处理),与原图像图5(d)相一致,因此证明子眼系统可以精确还原。

图5 子眼系统仿真Fig.5 The simulation of the ommatidium system

2.2 复眼系统仿真实验

复眼系统仿真如图6。光路如图6(a),其中透镜阵列为16×16 排列,汇聚透镜阵列为2×2 排列,在单次曝光中可以获得8 幅图像。透镜阵列中子透镜口径为0.5 mm×0.5 mm,焦距为10 mm,汇聚透镜阵列中子透镜口径为2 mm×2 mm,焦距为40 mm,成像系统放大倍率为1。可以看出照明物面,汇聚透镜阵列以及延迟透镜阵列尺寸大小一致,此时照明的物面大小为4 mm×4 mm。透镜阵列中的不同组子透镜对应不同的时刻,获得的叠加图像如图6(b),可以看出复眼系统照明了四个区域,由于透镜的像差等因素,造成四个区域拼接处存在很小的缝隙。对该叠加图像进行傅里叶变换得图6(c),可以看出形成了8 组点阵,对每一个点进行傅里叶逆变换可以还原图像。复原图像图6(e)与图6(d)一致,因此复眼系统具有可行性。

图6 复眼系统仿真Fig.6 The simulation of the compound eye system

3 讨论

3.1 摄影频率与时域宽度

影响记录瞬态事件的时域宽度(时间长度)的因素为画幅数以及分幅时间,画幅数可以通过增加子透镜数量增加,而分幅时间根据式(3)可以通过改变反射镜阵列之间的台阶高度差改变。针对图3(b)所示的台阶结构产生的时序脉冲进行验证,为便于仿真,将台阶放置于同一平面进行二维仿真。仿真结构如图7(a),图中灰色结构为台阶结构,台阶上方黑色结构为反射镜,每一节台阶对应一个时间监视器位于入射光上方,入射光为中心波长为800 nm,脉宽为35 fs 的超短脉冲。当相邻台阶的高度差为0.01 mm 时,仿真结果如图7(b),可以看出不同台结构产生的子脉冲在时间轴上的位置不同,台阶高度越高的脉冲越先出现在时间轴上,可以获得总长为546 fs 的动态事件。此时子脉冲之间时间间隔(分幅时间)为78 fs、摄影频率为1.2×1013帧/s。进一步仿真了相邻台阶的高度差为0.15 mm 的情况,获得了8 个时间间隔为1 ps 的时序子脉冲(图7(c)),子脉冲宽度均为35 fs,可以记录7 ps 的动态事件。因此可以通过调整或加工不同高度差的台阶阵列获得更长或更短的记录时长和摄影频率。

图7 时间延迟结构仿真验证与方法Fig.7 The simulation of the delay unit and the time delay method

由于延迟结构在照明结构之前,对照明光路没有影响,同样可以采用将探测脉冲啁啾与滤波片阵列的方式替代台阶结构。光路如图7(d),超短脉冲通过色散元件(Dispersion element)进行展宽使不同光谱对应不同的时刻,在透镜阵列前放置滤波片阵列(图7(e))与透镜阵列中的透镜一一对应;透镜阵列中每一组子透镜具有不同的波长即对应不同的时刻,同样可以在照明面产生时序脉冲序列。超短脉冲可以通过不同的色散元件,例如光栅对、玻璃柱、光纤等展宽至飞秒、皮秒甚至纳秒领域,因此,可以利用这种方法可以记录飞秒、皮秒甚至纳秒时间尺度下的动态事件。

因此,仿生极高速成像可以通过选择不同尺寸或不同元件实现飞秒到纳秒时间尺度的瞬态事件的覆盖,可以覆盖多个时间尺度,即具有宽时域的特性。另一方面,分幅时间主要由子脉冲的脉宽所决定,因此随着飞秒脉宽的进一步缩小,仿生极高速成像系统的摄影频率也将进一步提高。

3.2 条纹结构光照明静态实验

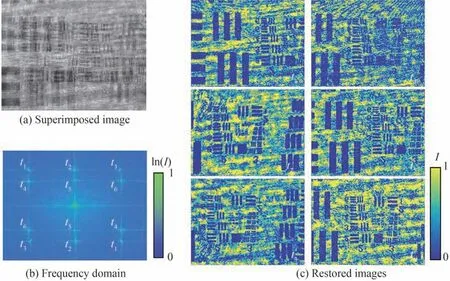

为验证由干涉产生的条纹结构光照明的可行性,对子眼系统进行了静态仿真,以不同位置的分辨率板作为瞬态事件的不同时刻,选取六组不同间距的子透镜进行实验。将每组子透镜照明的图案叠加,获得如图8(a)所示的叠加图案,其傅里叶变换后的频域分布如图8(b),获得了六对点阵,对应不同时刻的图像信息,对不同点分别进行傅里叶逆变换,获得复原图像图8(c),证明子眼系统的可行性。

图8 子眼系统静态实验Fig.8 The statics experiment of the ommatidium system

3.3 空间分辨率

仿生多视场极高速成像系统的空间分辨率取决于两部分,分别为光学系统的成像分辨率和图像还原的分辨率。光学系统的分辨率主要取决于照明面后续的光学结构,即图3(a)中Limaging成像透镜部分,成像系统由一个简单的成像透镜或镜头即可完成。令成像系统的放大倍率为1,同样的光学系统,分别用探测面像素尺寸分别为3 μm 和6 μm 进行仿真,得到图9(a)。当像素尺寸P=6 μm 时,可以分辨USAF1951 分辨率板第6 组第3 对,线宽为6.2 μm;当像素尺寸P=3 μm 时,可以分辨第7 组点3 对,线宽为3.1 μm。结果表明仿生极高速成像系统可以获得极高的空间分辨率,其光学系统空间分辨率主要受限于探测器的像元尺寸。

图9 光学系统分辨率与还原图像分辨率Fig.9 The spatial resolution of the optical system and the restored images

仿生多视场极高速成像系统的最终分辨率取决于图像还原的分辨率,而还原图像的分辨率取决于条纹间距。根据式(2),条纹间距取决于汇聚透镜的焦距f和子透镜对的间距Di。令成像系统的放大倍率为1,汇聚透镜焦距为30 mm,且像素尺寸为3 μm。采用两幅完全相同方向互相垂直的分辨率板图案相互叠加求解还原(图9(b))。分别用子眼间距Di为3,2,1,0.2 mm 进行仿真,均能还原图像,条纹间距越宽,在频域用于还原图像的像素越少,分辨率越低;当Di=2 mm 时,条纹间距刚好满足一对像素,可以获得最多得还原像素,分辨率最高,此时可以分辨第6 组第3 对,本征空间分辨率可以达到80.6 lp/mm。虽然与光学系统分辨率相比有所下降,但仍具有极高的分辨率。

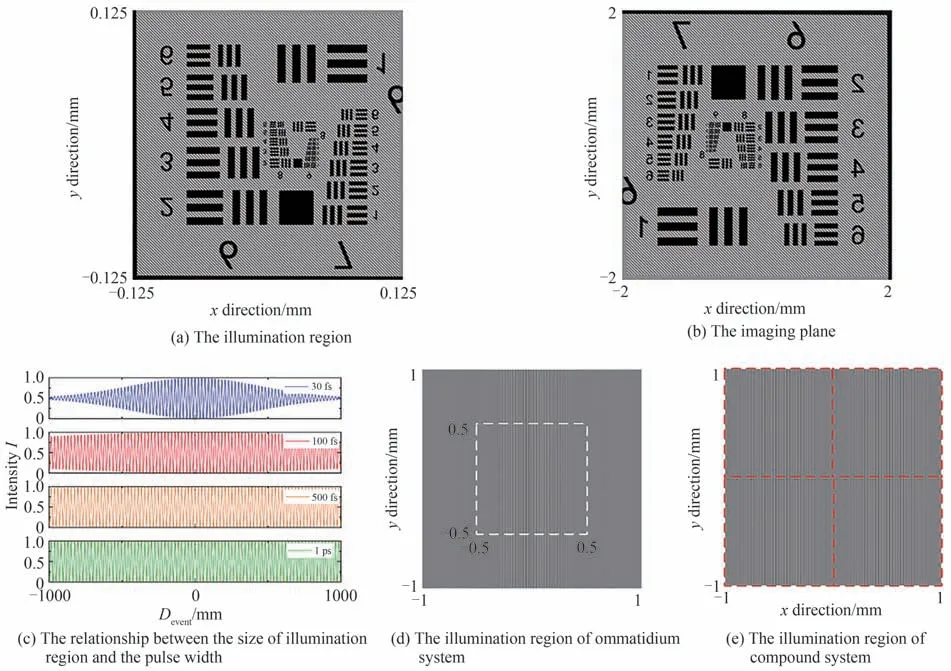

3.4 视场

仿生极高速成像系统可以实现多种视场的成像。令透镜阵列焦距为60 mm、子透镜尺寸为1 mm×1 mm,汇聚透镜焦距为15 mm,成像系统放大倍率为16。可以得到照明视场大小为0.125 mm×0.125 mm,照明分辨率板的6~9 组(图10(a));在探测面获得6~9 组的清晰像(图10(b)),且条纹间距与分辨率板之间的比例不随成像透镜改变。因此仿生极高速成像系统适用于微小视场的成像。

针对大视场,子眼系统的条纹图案在照明面的分布会受脉冲脉宽的影响。仿真了不同脉宽的脉冲在相干角度为1°,2 mm 范围内的干涉情况,如图10(c)。当脉宽较宽时,条纹可以完全覆盖,但随着脉宽的缩小,条纹范围逐渐缩小;如在30 fs 脉宽时,条纹对比度从中心向两边逐渐降低至消失。同样模拟了脉宽为30 fs,子眼系统在2 mm×2 mm 照明视场下的条纹情况,条纹沿x方向分布。结果表明(图10(d))在−0.5~0.5 mm 范围外,条纹几乎不可见,因此也无法求解。如果采用复眼系统,在同样的情况下,将照明子视场限制在0.5 mm×0.5 mm 范围内并通过多个仿生小眼照明系统进行拼接,即可在2 mm×2 mm 内获得有效的条纹(图10(e))。如果采用更多子视场,即汇聚透镜阵列中的子透镜越多,将可以获得更大的视场。

图10 多视场仿真与相干条纹Fig.10 The simulation for multi-field of view and coherence stripes

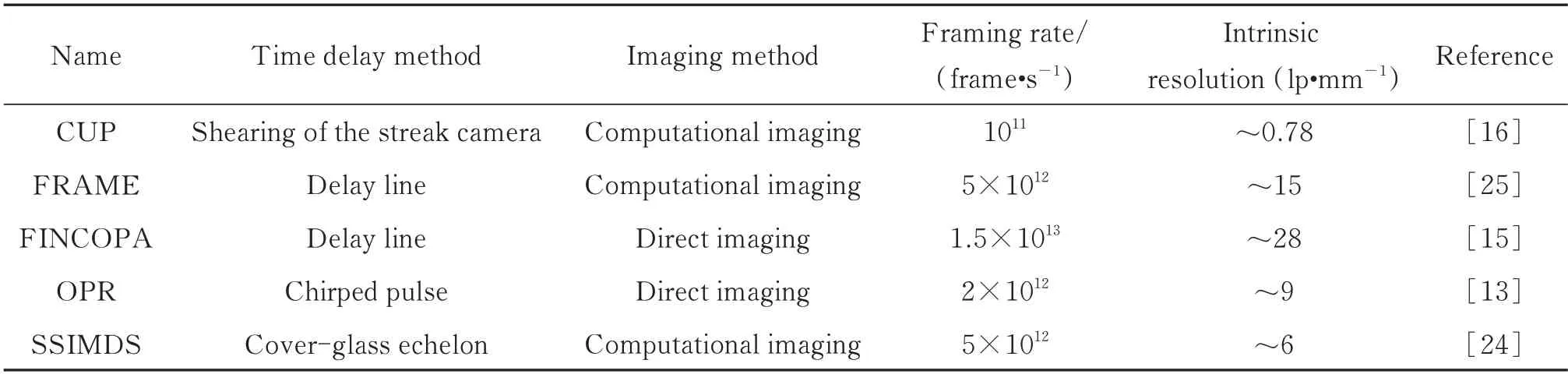

表1 为现有的主要极高速成像技术。基于压缩感知技术的极高速成像CUP,该技术利用压缩感知算法结合条纹相机实现极高速成像,其分幅和探测结构简洁紧凑,但其摄影频率受条纹相机限制且还原图像分辨率低。基于频率识别的FRAME 技术采用计算成像,具有简洁的探测结构,且摄影频率很高,但采用延迟线的方式进行分幅,导致其分幅光路复杂。基于光参量放大技术的FINCOPA 具有高的摄影频率和较高的本征空间分辨率,但其采用了直接成像和延迟线分光的方式,系统庞大且需用多个探测器进行测量。基于网格成像和啁啾脉冲的OPR 技术,其分幅结构和探测结构均很简洁,但由于其属于直接成像,同一探测面上的像素被多幅图像分割且不能全部使用;另一方面,受光谱和画幅数量相互制约的限制,使其摄影频率提升变的困难。SSIMDS 利用台阶结构在4f系统频谱面进行分幅延迟,但这种方法只适用于几个皮秒甚至更短的时间尺度,因为台阶结构影响处于光路的汇聚阶段,越厚的台阶对成像有一定影响。对比现有成像技术,仿生极高速成像系统在保证高摄影频率和空间分辨率的情况下,同时具有紧凑简洁的延迟分幅结构和探测结构;并且由于延迟结构与分幅成像结构相互独立,可以实现多个时间尺度下的动态事件记录,其时间分辨率(分幅时间)仅受脉宽限制,具有宽时域的特性。

表1 极高速成像技术Table 1 Ultrafast imaging methods

4 结论

本文提出了一种多视场宽时域仿生极高速成像方法。仿生极高速成像以条纹结构光照明与空间角分复用作为极高速成像的分幅和探测基础,使探测结构紧凑;针对分幅延迟光路复杂的问题,仿生螳螂虾小眼结构,实现时间图像分幅结构集成化;仿生螳螂虾复眼结构,可以实现大视场的探测且可以根据需求进行延展。延迟结构与照明成像光路相分离,可以实现飞秒至纳秒时间尺度的瞬态事件动态的记录。相比现有极高速成像系统用透明台阶结构在4f系统调制面进行时间延迟,利用反射镜台阶阵列结构,消除了由于台阶色散带来的飞秒脉冲展开且不会由于增加分幅时间而影响照明质量,因此可以用于更宽时间范围。相比于利用光栅作为结构光照图案,利用干涉形成的条纹,不受成像质量的影响,对光路要求更加简单。因此仿生极高速成像方法是一种高精度、多视场、宽时域、结构紧凑的极高速成像系统,可以用于超快激光与物质的相互作用、激光加速电子等高精尖科学技术的研究,为用于重大科学工程中的极高速成像仪器的小型化、轻量化打下理论和实验基础。