使用胸片检测新型冠状肺炎的深度集成网络

朱万鹏,雷秀娟

(陕西师范大学 计算机科学学院,陕西 西安 710119)

0 引 言

2019年,自新型冠状肺炎(Corona Virus Disease 2019,COVID-19)第一次爆发以来,该疾病已经在全球范围内迅速蔓延。COVID-19主要以干咳、发热、乏力等方面为主要表现,此外,还包括了疼痛、鼻塞、流鼻涕、呼吸急促、急性呼吸综合征和腹泻等症状。

由于COVID-19具有很强的传播性,在早期实现对COVID-19的检测具有十分重要的意义。目前作为主要标准的是逆转录聚合酶链反应(Reverse Transcription Polymerase Chain Reaction,RT-PCR)检测方法。然而RT-PCR虽然是一个较好的检测形式,并且准确率、检测能力等方面有了很大的提升,但是RT-PCR技术仍然存在很大的缺点,比如操作要求较高、耗时长、阳性率较低,同时RT-PCR检测高度依赖于检测环境和标本采集程序,灵敏度较低,检测能力有限[1]。因此,开发能够在早期进行合理检测并且具有成本效益的诊断技术对于检测病毒、阻止病毒的传播至关重要[2-3]。

随着全球医疗系统领域技术的逐步发展革新,自动筛查功能已经得到了广泛的应用。快速检测被证明是限制这种疾病传播最有效的方法,在影像学成像方法中,CT扫描提供了肺部的三维视图,能够发现COVID-19在疾病进展的不同阶段的表现。然而,CT筛查费用昂贵,并且患者暴露在辐射中,有一定的危害[4]。相反,胸部X光影像作为较易获得的医学影像,十分适合在紧急状况下进行诊断和检测,是研究肺部及其健康状况的有效方式之一[5]。X光作为基本的诊疗手段,具有耗时短、成本低等特点,有利于更好地筛查新冠肺炎患者[6]。

近年来,深度学习在许多疾病的诊断中应用得越来越广泛[7]。Hu等人提出了一种弱监督深度框架从CT图像中检测。该框架使用VGG-16进行特征提取和多尺度学习,以解决病灶散射和大小变化的问题[8]。Buhmann等人提出的集合模型目前被用于执行预测任务(例如,回归和分类)[9]。方等人使用CT探索了放射组学在筛查COVID-19中的价值[10]。徐等人提出了一种用于肺野分割的优化主动形状模型(Active Shape Model,ASM),与其他ASM相比,该模型的性能有了显著提高[11]。刘等人提出了一种适于非平稳肺音信号的特征提取方法,将4种肺音信号进行了识别,研究表明该算法的识别性能是高效的[12]。在另一项研究中,Shin等人利用深度卷积神经网络(Convolution Neural Network,CNN)解决了胸腹淋巴结检测和肺间质疾病分类的问题。他们开发了不同的CNN架构,并获得了令人满意的结果[13]。A Narin等人创建了一个深度卷积神经网络来自动检测X射线图像上的COVID-19[14]。T.Ozturk等人提出了一种称为DarkCovidNet的深度神经网络,用于自动检测X射线图像上的COVID-19病例,获得了较好的结果[15]。Apostolopoulos和mpesia提供了一种利用胸部X线摄影技术检测COVID-19的模型,该模型是基于深度学习与CNN开发的,准确率达到了96.78%[16]。Souza等人开发了一种胸部X光图像中肺部分割的自动方法。使用了两种基于深层CNN的方法,分割精度达到了94%[17]。

1 材料和方法

该文提出了一种集成网络对COVID-19进行检测,其中1.2.1节是结合深度可分离卷积和基本的深度学习方法提出的基本卷积神经网络,1.2.2节是深度集成网络,1.2.3节是该文提出的深度集成融合网络。

1.1 集成网络

该模型融合深度可分离卷积、卷积自编码器和VGG-16构建集成网络。2017年,Xception网络的提出引出了深度可分离卷积,并且在ImageNet上进行了训练,在减少参数的情况下实现了较好的性能。该文提出的模型同时利用了已经在ImageNet上训练过的VGG-16网络,将它与其他模型进行融合,从而利用了VGG-16已经存在的特征优势。VGG-16由16层网络结构组成,主要用于图像的识别和分类[18]。自编码器(Autoencoder,AE)是一类在无监督学习上能够学习到输入数据高效表示的人工神经网络(Artificial Neural Networks,ANNs),其功能是通过将输入信息作为学习目标,对输入的信息进行表征学习(Representation Learning)[19]。

1.2 提出的模型

1.2.1 深度可分离卷积神经网络

本节阐述了基本深度学习方法的具体细节,包含了两类基本的深度学习方法。提出的深度可分离卷积神经网络分层结构如表1所示。

表1 提出的基础模型CNN

续表1

使用softmax激活函数解释上一层得到的激活函数的可能值,计算文中三分类的概率分布。文中的输出范围是0~1,所有的概率总和是1。softmax函数的定义如下:

(1)

1.2.2 深度融合网络

信息融合是从数据融合出发的,可以分为多传感器信息融合、不同特征图的多特征融合、多种生物源融合、医学信号或医学图像融合[20-21]。对于前文中提出的网络,该文将它们的特征融合,本节将三种特征提取器进行连接。该文提出使用一个融合层,将来自于VGG-16、卷积自编码器和1.2.1节中提出的深度可分离网络的特征进行融合。使用了Concatenate操作,将来自三种特征提取器进行集合,实现了多头特征,之后再将每个分支中提取的特征分别赋给融合层和分类层。

1.2.3 提出的融合模型

特征融合是将不同方法提取的同一样本的特征进行组合的方法。若设G={ξ|ξ∈N}是n个已经带好标签的样本空间,如果目前已经知道向量∂={x|x∈k},β={y|y∈p},…,ζ={m|m∈q},其中∂、β等分别为采用不同深度学习方法提取的相同输入的I样本的特征向量。因而,从不同来源提取的特征融合矢量空间可计算为:

(2)

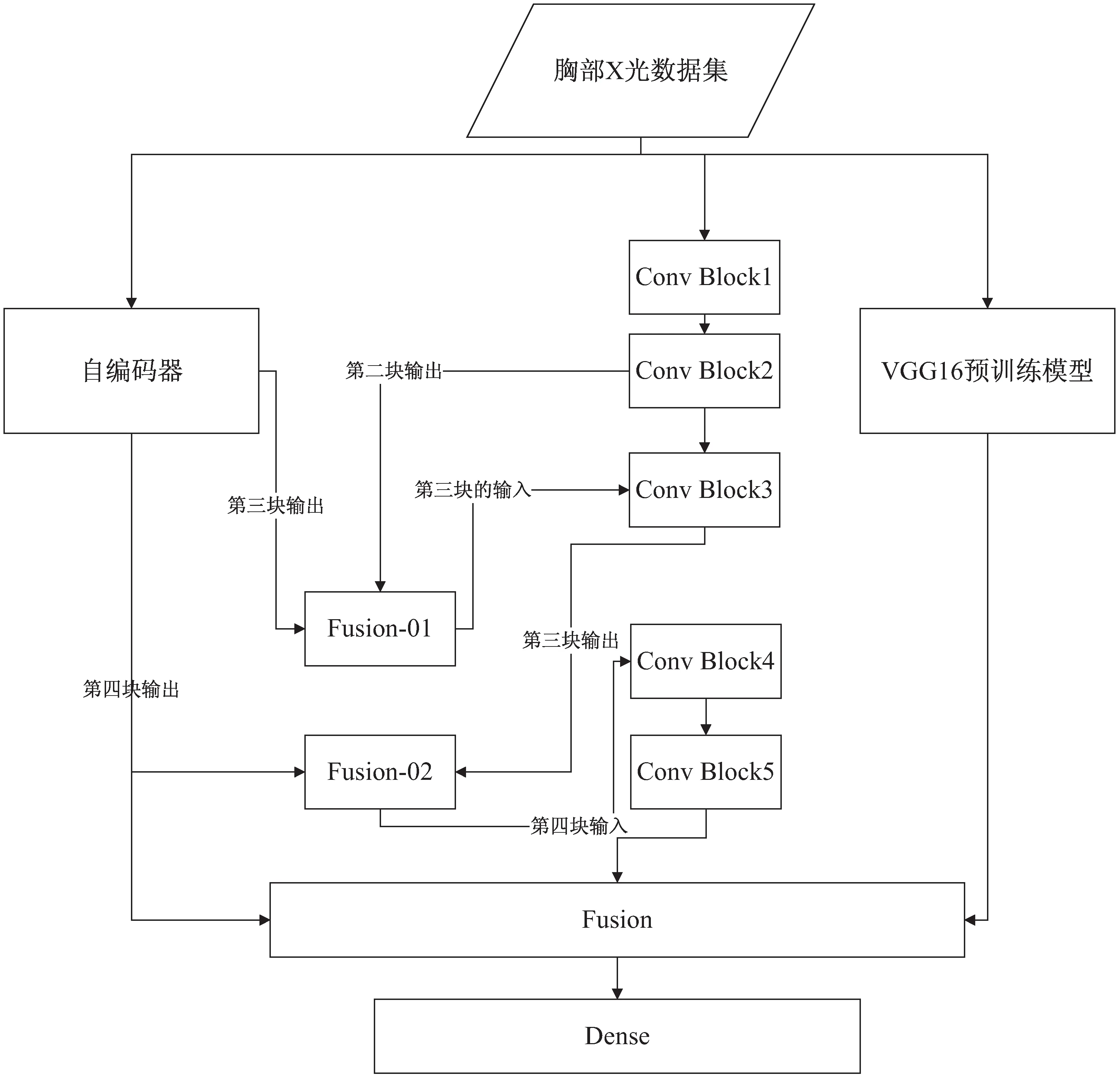

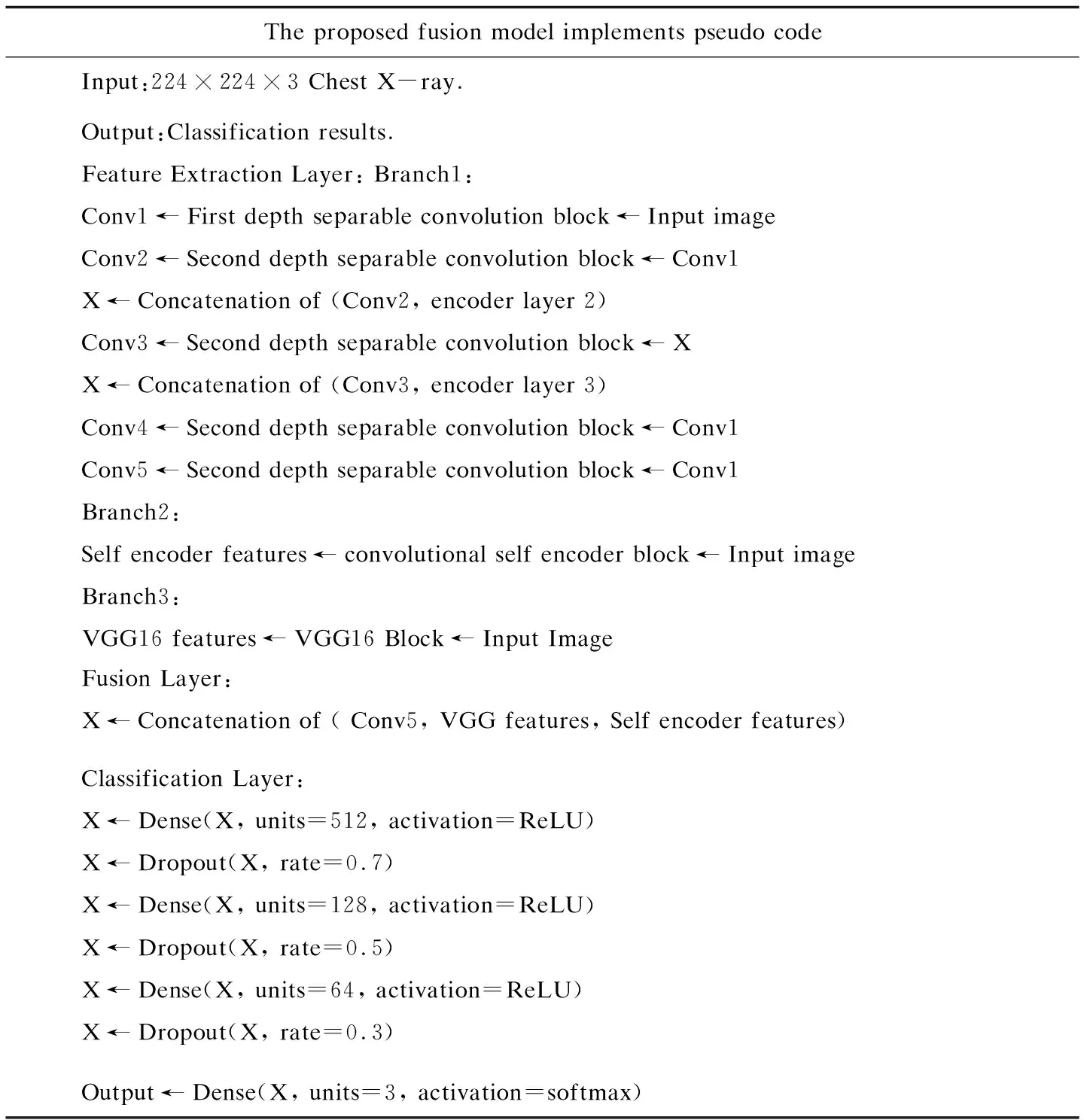

在本研究中,对数据进行预处理后,将数据集提供给模型。该模型由三个主要分支组成:第一个分支有五个卷积块,在1.2.1节当中给出了具体介绍;第二分支是VGG-16迁移学习网络,其输出将用于融合层;第三个分支是自编码器部分,提取自编码器学习到的特征。模型在三个分支之后是融合层,将卷积自编码器的第二层、第三层输出分别与深度可分离卷积网络的第二块和第三块的输出连接起来,作为深度可分离网络的下一层的输入。之后再利用融合层将三个分支的特征进行信息融合。最后,利用全连接层对融合特征进行处理并对数据进行分类。在本部分中,使用了4个密集层,分别是512、128、64和3个具有ReLU激活功能的神经元。前三个密集层的输出在其结果中有一个下降率,分别等于0.7、0.5和0.3。为了提高模型处理数据和提取高质量特征的能力,采用了一种新的来自不同来源的特征融合方法:

(1)选择第二、三个卷积块的输出作为融合源,对数据分布有一个整体的视角。这些特征有助于模型考虑未经处理和原始的信息,并在预测中使用它们。

(2)将深度可分离卷积块和卷积自编码器的第二、三卷积块的输出特征输入到相应的融合层中,以获得更准确的信息。该特性提供了要建模的数据集的详细视图,并帮助模型处理高级分类特性。

(3)由于在最近的研究中,预训练的网络在肺炎检测中得到了广泛的应用,并且可以创建高质量和可泛化的特征,所以在融合层中使用了VGG16的输出。

该文提出的融合模型的整体视图如图1所示,采用的算法伪代码如图2所示。

提出的模型通过将多个模型进行融合,采用了交叉熵损失函数判断模型在整个样本上的表现,它的定义如下:

(3)

其中,M代表类别的数量,yic代表符号函数,如果样本i的真实值类别是c则取1,反之取0,pic表示的是观测的样本i属于c的预测的概率。

1.3 性能评估

本研究采用的性能指标是准确性、精确度、敏感性、特异性和F-1评分等,这些指标使用了以下术语:真阳性(True Positive,TP):表示新冠肺炎、正常和肺炎病例分别被正确预测为COVID-19、正常和肺炎。真阴性(True Negative,TN):表示正常或肺炎病例被正确预测为正常或肺炎。假阳性(False Positive,FP):表示该病例为正常或肺炎感染病例,预计为COVID-19病例。假阴性(False Negative,FN):表示该病例为COVID-19,预计为正常或肺炎病例。

它们的定义分别如下:

Accuracy=(TP+TN)/(TN+FP+TP+FN)

(4)

Sensitivity=TP/(TP+FN)

(5)

Specificity=TN/(TN+FP)

(6)

Precise=TP/TP+FP

(7)

F1-score=(2*TP)/(2*TP+FP+FN)

(8)

图1 融合模型的整体视图

The proposed fusion model implements pseudo codeInput:224×224×3 Chest X-ray.Output:Classification results.Feature Extraction Layer: Branch1:Conv1←First depth separable convolution block←Input imageConv2←Second depth separable convolution block←Conv1X←Concatenation of (Conv2, encoder layer 2)Conv3←Second depth separable convolution block←XX←Concatenation of (Conv3, encoder layer 3)Conv4←Second depth separable convolution block←Conv1Conv5←Second depth separable convolution block←Conv1Branch2:Self encoder features←convolutional self encoder block←Input imageBranch3:VGG16 features←VGG16 Block←Input ImageFusion Layer:X←Concatenation of ( Conv5, VGG features, Self encoder features)Classification Layer:X←Dense(X, units=512, activation=ReLU)X←Dropout(X, rate=0.7)X←Dense(X, units=128, activation=ReLU)X←Dropout(X, rate=0.5)X←Dense(X, units=64, activation=ReLU)X←Dropout(X, rate=0.3)Output←Dense(X, units=3, activation=softmax)

2 实 验

本节描述了使用的实验装置并且将对第一节中提出的深度集成网络使用不同的病例的X射线进行分析,以探索提出的模型的稳健性。

2.1 实验装置

将所获取的数据集,即胸部X光图像转化为224×224×3的像素值,整体的数据集按80%和20%比例分别用于训练和测试。采用了五折交叉验证的办法进行实验。

2.2 数据集

数据集被组织分为3个文件夹(新冠肺炎,肺炎,正常)。由于无法获得大量特定数据集,因此从不同来源获取了COVID-19的X射线样本。首先,使用GitHub存储库、Radiopaedia、意大利放射学会、Figshare数据存储库网站共收集了1 401个COVID-19样本。其次,从Mendeley收集了912个增强图像,而不是明确使用数据增强技术。最后,从Kaggle获得了2 313例正常和肺炎病例的样本。实验中总共使用了6 939个样本,每种情况下使用2 313个样本,将数据集的分辨率调整为224像素,同时将它按80%和20%的比例分别用于训练和测试(数据集可以从https://data.mendeley.com/datasets/mxc6vb7svm获得)。

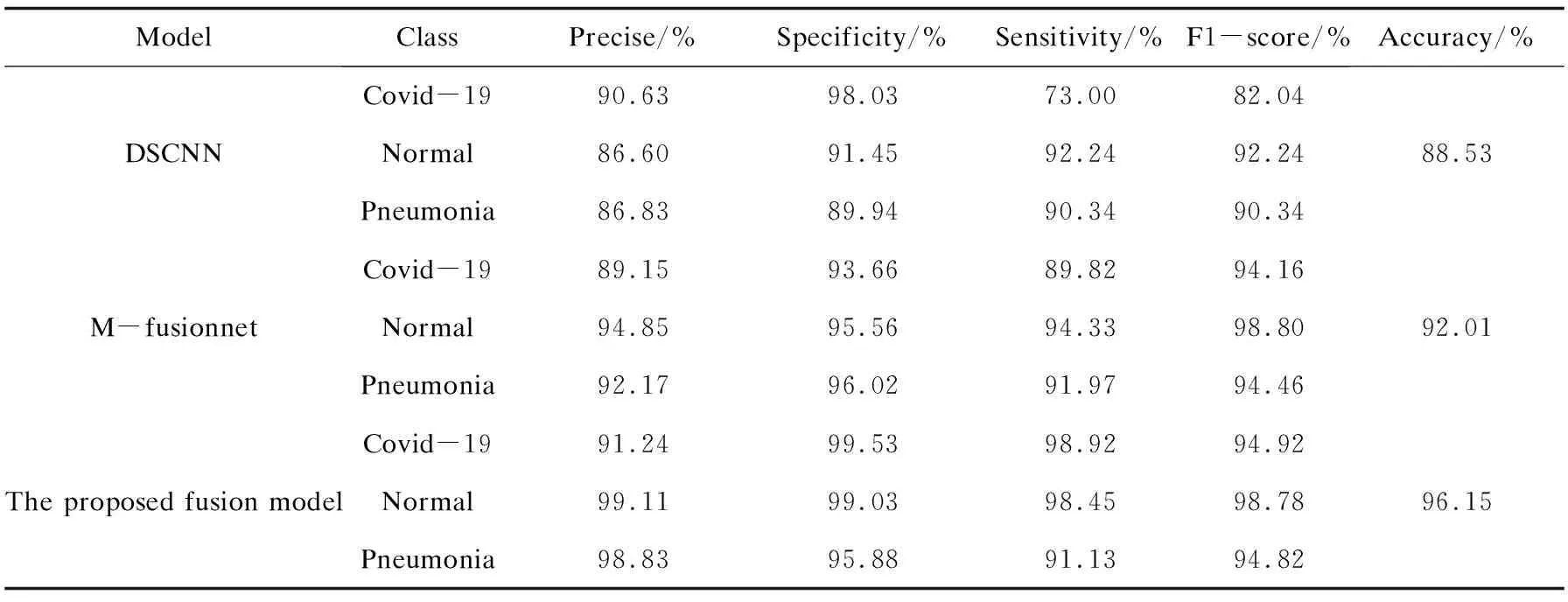

2.3 结果分析

本研究分别将1.2节的三个模型都进行了实验,评价各个模型的性能。表2描述了提出的模型的总体准确率、特异性、灵敏度、精度和F1-score。如表2所示,提出的三种体系当中以1.2.3节中的融合集成模型性能最为优越。对于COVID-19病例的精度、特异性、灵敏度和准确率都为最优。对于COVID-19病例的特异性为97.01%、灵敏度为90.06%、F1-score为92.86%,整体的检验准确率达到了93.10%。

表2 各个体系的性能指标

图3(a)、(b)、(c)分别展示了DSCNN、M-fusionnet和提出融合模型的混淆矩阵。在图3(a)中,在总共的1 380张图片中有189张图片产生了误分类,其中157张被误分类为COVID-19病例。在图3(b)中,在总共的1 380张图片中有139张图片产生了误分类,其中60张被误分类为COVID-19病例。在图3(c)中,在总共的1 380张图片中有52张图片产生了误分类,其中4张被误分类为COVID-19病例。在上述的混淆矩阵当中,该文提出的融合模型可获得比较好的效果,误分类的病例很少,具有更好的真阳性和真阴性。

图3 DSCNN、M-fusionnet和提出融合模型的混淆矩阵

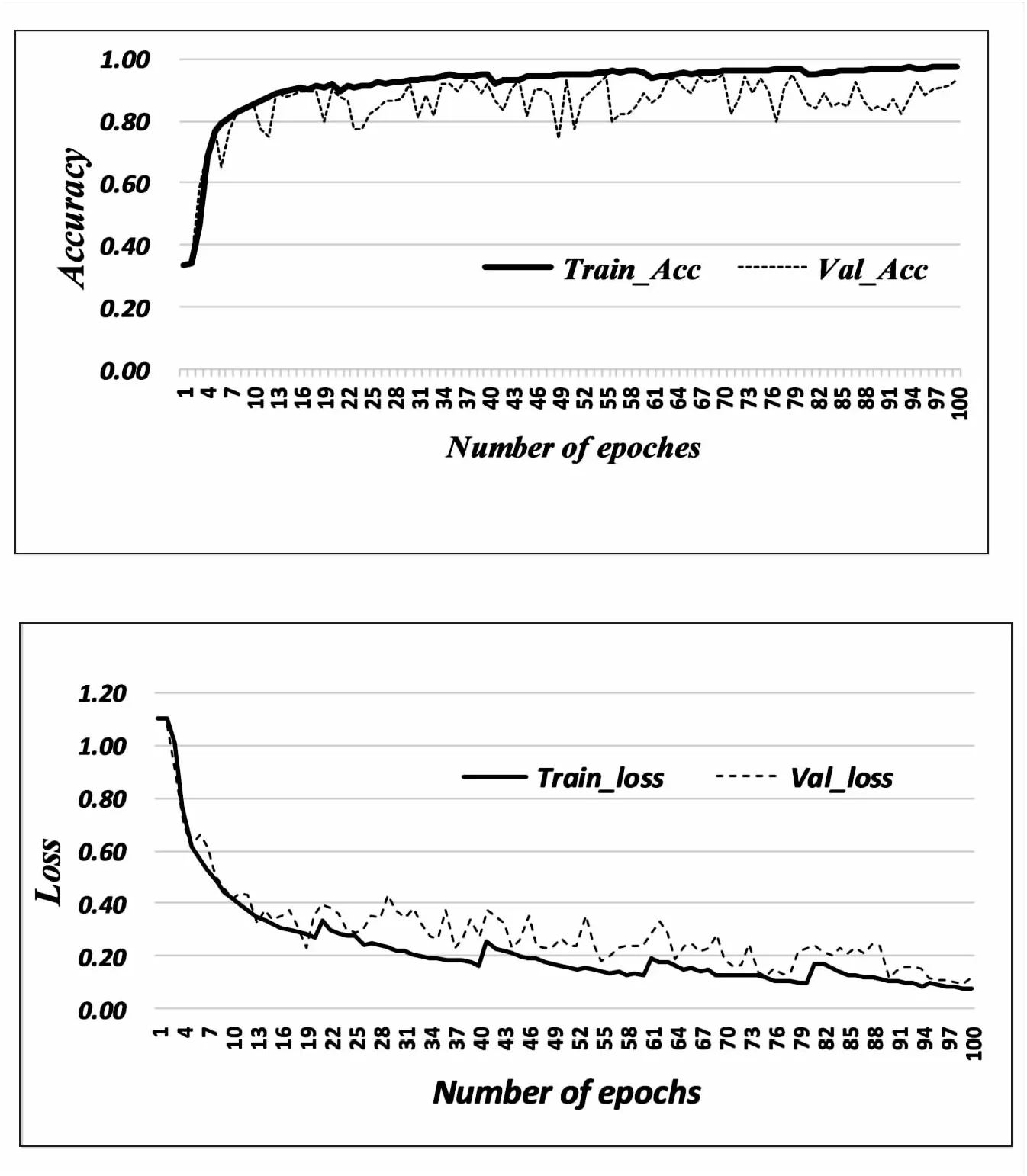

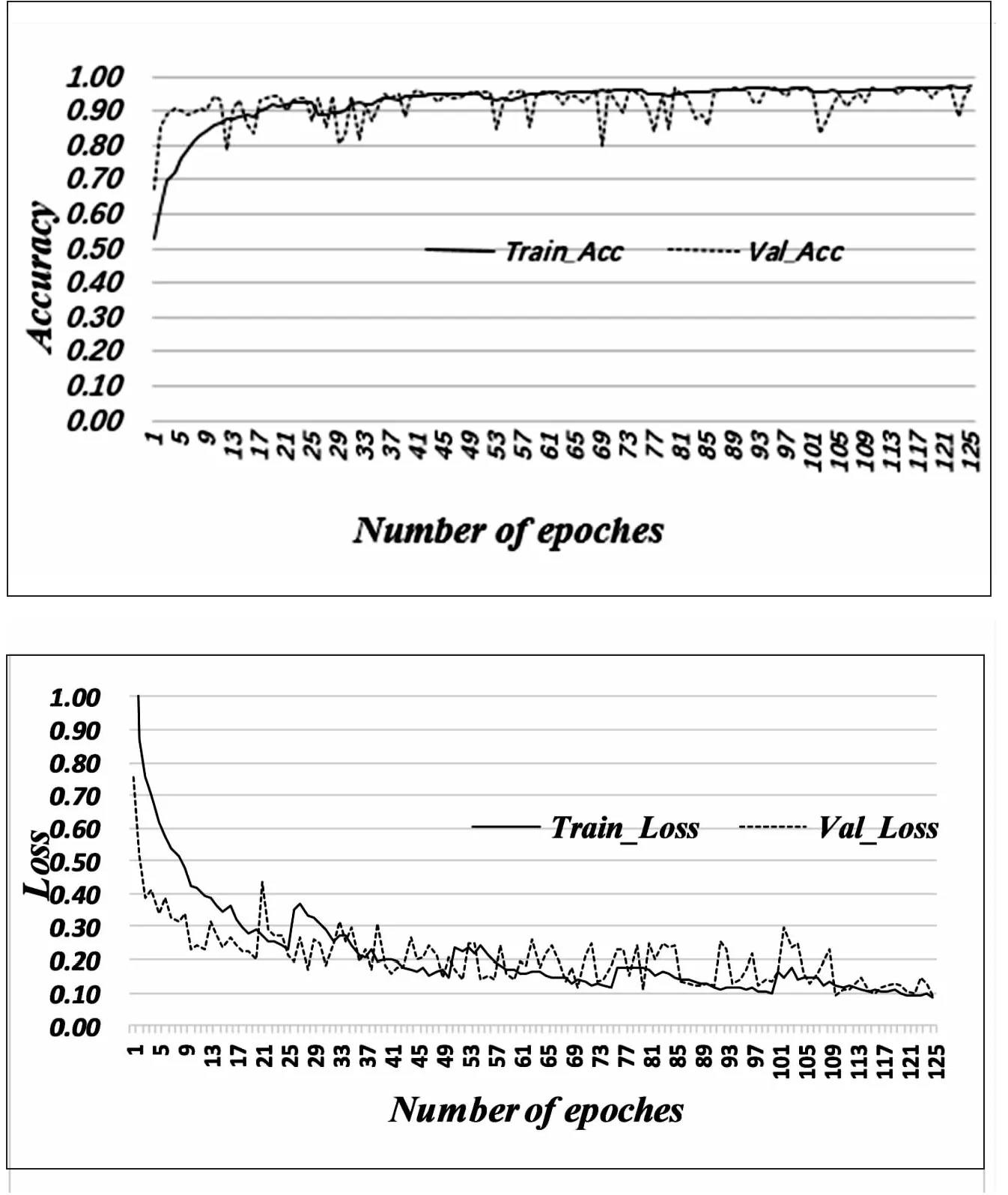

图4~图6分别展示了DSCNN、M-fusionnet和提出的融合模型的准确率和Loss随迭代次数的变化趋势。该文采用的是5折交叉验证,对fusionnet和提出融合模型训练的迭代次数为125。

图4 DSCNN的准确度与Loss

图5 M-fusionnet的准确度与Loss

图6 提出的融合模型的准确度与Loss

从图4~图6中可以看到,DSCNN在训练和验证的准确性分别达到了97.48%和93.18%。M-fusionnet的训练和验证的准确性达到了92.65%和90.52%。而提出的融合模型,它的训练集和验证集的准确率达到了97.29%和96.23%。

在该文提出的体系结构中,DSCNN的交叉熵在训练和验证中分别是0.07和0.11。M-fusionnet的交叉熵在训练和验证中分别是0.08和0.09。而提出的融合模型的交叉熵在训练和验证中分别是0.09和0.11。它们都达到了基本拟合的状态。

图7是DSCNN、M-fusionnet和提出的融合模型的ROC曲线(area under the ROC curve,AUC)。从图像中可以看到,ROC曲线下的面积对于COVID-19、Normal和Pneumonia都超过了97%,其中提出的融合模型的COVID-19的AUC值达到了98.49%。

图7 DSCNN、M-fusionnet、提出的融合模型的ROC曲线下面积

通过上述的实验结果表明,提出的融合模型具有较好的性能,从图像中可以看到,ROC曲线下的面积对于COVID-19、Normal和Pneumonia分别是98.49%、99.73%和98.45%,是最优的。表明提出的融合模型具有很好的鲁棒性。

3 讨 论

第二部分分别对DSCNN、M-fusionnet和提出的融合模型进行了实验。对三种模型都进行了单独的实验,结果以性能指标以及混淆矩阵等形式呈现。从结果分析中可以得知,提出的融合模型获得了最高的准确率,达到了96.15%。并且在图7的ROC曲线也证明了提出的融合模型的优越性,并且在其他性能指数上,该模型也表现了较好的优势。实验结果表明,提出的融合模型具有优良的性能,对于使用胸部X光射线图像去自动区分COVID-19病例与肺炎病例和正常病例具有显著的效果。

同时,将提出的系统与现有的一些系统在精度等方面进行对比,也将现有的提出的各种模型例如VGG16、MobileNetV1、SVM和VGG19等结合文中的实验数据集进行了相关实验,实验性能对比如表3所示。该文使用了6 939张胸部X光射线影像,相比于其他文献中的数据更丰富。提出的融合模型整体的准确率达到了96.15%,对于COVID-19的检测精度达到了91.24%,展现了更好的性能,优于VGG16、MobileNetV1、SVM和VGG19等实验模型。

表3 现存系统与提出的系统对比实验

4 结束语

该文提出了一种多分类器融合的深度集成网络,用于从胸部X光中有效地对COVID-19、其他肺炎和正常进行检测。与传统的卷积网络不同,该文使用了深度可分离神经网络,同时该模型还结合了VGG16、卷积自编码器分支以提高分类网络的性能,确保鲁棒性强、稳健的特性。5折交叉验证结果表明,提出的融合网络相比于单独的深度可分离神经网络等具有较优性能,该模型的三分类准确率达到了96.15%,对于COVID-19的检测精度为91.24%,F1指数为94.92%,敏感性为98.92%,ROC权限的AUC值对于COVID-19、Pneumonia和Normal均超过了0.98。对现有的部分模型进行了对比,提出的体系具有较好的性能,能够帮助医疗从业者减少工作量,为抗击疫情做出贡献。