低视点下遮挡自适应感知的多目标跟踪算法

乐应英,徐丹,贺康建,张浩

1. 云南大学信息学院,昆明 650091; 2. 玉溪师范学院数学与信息技术学院,玉溪 653100

0 引 言

多目标跟踪(multiple object tracking,MOT)是智能监管任务的关键核心技术,广泛应用在视频监控、国防军事、智慧城市和智能交通管理等领域,是计算机视觉领域的重要研究内容之一(刘沛鑫,2020)。MOT致力于在连续图像序列中定位到每一帧中所有待跟踪的目标,并且尽量避免每个目标的ID(identity information)标识在整个跟踪流程中发生切换(李沐雨,2020)。

随着Faster R-CNN(region based convolutional neural network)(Ren等,2017),YOLO(you only look once)(Redmon等,2016)及SSD(single shot multiBox detector)(Liu等,2016)等经典目标检测算法检测性能的显著提高,大多数MOT算法都选择采用基于检测的跟踪(tracking by detection, TBD)方法作为主要跟踪方案(刘沛鑫,2020)。基于最优贪心算法(Pirsiavash等,2011)、基于K最短路径优化(Berclaz等,2011)、基于分层网络流(王雪琴 等,2017)和基于最大权值独立集(Brendel等,2011)的TBD多目标跟踪算法也相继提出。

根据摄像机拍摄角度的高低,TBD存在高视点和低视点两种跟踪场景,本文重点研究低视点下的MOT问题。低视点场景的遮挡问题一直是影响跟踪性能的重要原因,如图1所示。在完全遮挡场景,目标因为暂时消失,导致跟踪失败。目标部分遮挡导致目标的视觉信息受到污染,提取的目标特征不完整,会导致跟踪漂移。因此,在低视点跟踪中,解决好遮挡问题是提升跟踪算法性能的重要举措。

图1 遮挡造成的跟踪漂移现象

为了解决遮挡问题,本文提出低视点跟踪场景下遮挡自动感知的多目标跟踪算法。在MOT16低视点跟踪场景视频上进行实验,与STAM(spatial-temporal attention mechanism)(Chu等,2017)、ATAF(aggregate tracklet appearance features)(Chen等,2019)、STRN(spatial-temporal relation networks)(Xu等,2019)、BLSTM_MTP_O(bilinear LSTM with multi-track pooling)(Kim等,2021)和IADMR(instance-aware tracker and dynamic model refreshment)(Chu等,2019)等典型算法进行对比实验。视频包括部分遮挡、短时全遮挡和长时全遮挡等特殊跟踪场景。实验结果表明,本文提出算法的跟踪性能得到提升,大多数评价指标优于对比算法。

本文主要贡献如下:1)根据每一帧图像的遮挡状态,提出自适应抗遮挡特征,利用全局遮挡信息动态调整关联特征结构,增强特征对遮挡的感知调整能力。2)在新目标判断上,采用级联筛查机制,防止遮挡带来的目标特征剧烈变化而认定为“虚新入目标”的错误跟踪现象。3)提出自适应干扰模板更新机制,根据所有目标的局部遮挡系数,对不同遮挡状态的历史目标模板给予不同权重,根据权重进行自适应模板更新,减少了严重遮挡目标更新时对模板库的干扰。

1 相关工作

1.1 基于数据关联的多目标跟踪算法

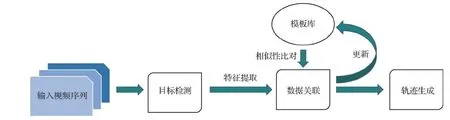

基于数据关联的MOT算法首先在每一帧图像中实现目标检测,然后将跨帧图像中的目标检测结果关联起来,最终获取目标的运动轨迹。该算法可分解为4个步骤,如图2所示。

图2 基于数据关联的多目标跟踪基本框架图

离线的TBD方法利用未来帧处理跟踪问题,将数据关联问题看做全局最佳化问题,专注于设计各种优化算法,例如网络流(Zhang等,2008)、连续能量最小化(Milan等,2014)和最大权独立集(Brendel等,2011)、k部图(Roshan等,2012)、子图多割(Dehghan等,2015)等。然而离线方法不适用于实时、随机跟踪环境,例如自动驾驶。而在线的TBD方法在轨迹生成上不能使用未来帧,大多采用概率推理或优化算法,例如匈牙利算法(Bae和Yoon,2014)。TBD存在的问题是对目标检测结果有严重依赖性,在实时在线跟踪场景下,对噪声检测更加敏感。

1.2 低视点下的遮挡问题

低视点指视频拍摄角度相对较低,拍摄距离相对较近,导致目标较大、较密集,且目标走动过程中尺度变化大,伴有频繁遮挡。低视点拍摄视频的MOT问题,尤其是低视点下的遮挡问题会导致“跟踪漂移”和“虚新入目标”现象,是多目标跟踪中需要重点研究的问题。对此,人们提出了许多处理遮挡的方法。例如,基于人体部分检测和跟踪的算法(Izadinia等,2012)、基于遮挡可感知的检测器的算法(Tang等,2014)、基于在线判别外观学习的分层关联算法(方岚和于凤芹,2020)以及专门针对部分遮挡的多行人检测跟踪算法(Shu等,2012)等。这些算法旨在利用更好的检测器处理局部遮挡,但是因为现实跟踪场景的多变性和复杂性,使用最先进的检测器也有一定程度的虚检、漏检和不精确检测问题。Sort(Bewley等,2016)算法用运动特征作为目标特征,在目标数目不多、间距大的情况下跟踪效果不错,但是在目标密度高、遮挡频度大的情况下跟踪性能下降,ID发生频繁切换。在Sort基础上,Deep sort(Wojke等,2017)引入深度特征来解决这两个问题,降低了遮挡下的ID切换率,取得了很大进展。但是在目标严重遮挡时,遮挡部分融入了别的目标信息,Deep sort提取的目标特征的准确性下降。STAM(Chu等,2017)为了排除目标遮挡部分的干扰,尽量利用遮挡状态下目标剩余的信息,提出目标遮挡可视图和时空注意力机制来关注目标未遮挡部分的信息进行数据关联,在一定程度上提升了遮挡下的特征提取能力,但是可视图的计算增加了计算复杂度,同时在STAM中算法为每个目标建立跟踪器,实时性有待提高。

本文在低视点跟踪场景下做了大量实验,得到了以下两个发现:1)目标相对密集、遮挡严重时,目标框之间存在大量重叠,导致运动特征失效,此时由深度网络提取的特征相较于运动特征更加可靠。2)遮挡较轻时,目标相互距离可区分,运动特征鲁棒性较高,而外观特征偶尔会发生特征漂移。

因此,本文提出自适应抗遮挡特征,增强特征对遮挡目标的可区分度,采用级联筛查机制准确区分新目标和暂时消失目标,提出自适应去干扰模板更新机制,进一步提高模板库的干净度和算法对遮挡的适用性。

2 遮挡自适应感知的多目标跟踪算法

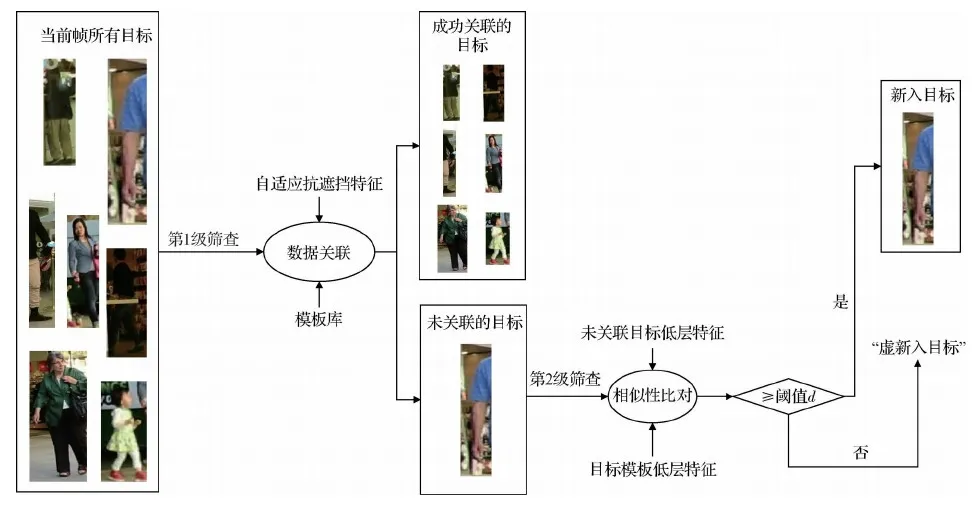

算法涉及的主要参数如表1所示。n1是从开始帧到当前帧已经成功检测跟踪到的目标数量,n2为当前帧中所有检测到的目标数目,f为当前帧编号。i∈{1,2,…,n1},j∈{1,2,…,n2},t∈{1,2,…,f}。

表1 算法涉及的主要参数

2.1 自适应抗遮挡特征

在基于数据关联的多跟踪方法中,关键在于检测目标之间关联特征的度量。目标特征的可区分性对提高跟踪性能起着重要作用。为了更好地阐述自适应抗遮挡特征,首先对3大经常使用特征的优缺点及其适用场合进行分析。1)运动特征包括目标的位置、方向和速度等信息。当摄像机无运动或运动量较小且目标稀疏时,通过运动特征计算IoU(intersection over union)可以得到准确高效的目标关联。但是目标密集时,目标的位置和运动会相互影响,导致特征辨别力下降。2)神经网络提取的外观特征可以显著提高特征辨别力和鲁棒性。然而,当目标的磨损和形状相似时,特征区分度也会降低。3)运动特征和外观特征的固定组合可以有效利用两者的优点,在复杂场景获得更好的跟踪鲁棒性。然而,大多数特征组合方法遵循固定组合方式,并没有考虑遮挡。

通过以上分析,可以发现融合特征比单一特征更容易区分,融合特征的组合方式仍然值得进一步研究。本文仍然使用融合特征的思想,但与之前的工作不同,本文将遮挡考虑在内,使特征结构可以根据目标遮挡状态进行自适应调整。接着,进一步分析不同特征在不同遮挡程度的有效性,并得到两个发现:1)当目标分布稀疏且没有遮挡时,只有基于IoU匹配的运动特征才能获得足够的目标区分度;2)在存在遮挡的情况下,重叠目标的IoU值较大,运动特征没有区分度。尽管如此,深度网络提取的外观特征仍具有一定的鲁棒性,在目标关联中起着决定性作用。

基于以上分析,本文提出一种基于全局遮挡系数的自适应抗遮挡特征。全局遮挡状态用于动态调整关联特征的结构,增强对遮挡的感知和调整能力。自适应抗遮挡特征的获取需要经历目标外观特征获取、目标运动特征获取、全局遮挡系数计算和自适应抗遮挡特征计算等4个步骤。

2.1.1 获取目标外观特征

首先基于ResNet50(He等,2016)使用孪生网络S1获取所有当前帧目标的外观特征s1j,然后计算当前帧目标特征和所有模板库的历史外观特征的欧氏距离Si,j。具体为

(1)

(2)

式中,n3为ID号为i的目标被成功跟踪到的帧数。

2.1.2 获取目标运动特征

计算当前帧目标和上一帧目标的IoU重叠面积,并将其作为运动特征。获取到的运动特征保存在矩阵D里,具体为

(3)

D′i,j=1-Di,j

(4)

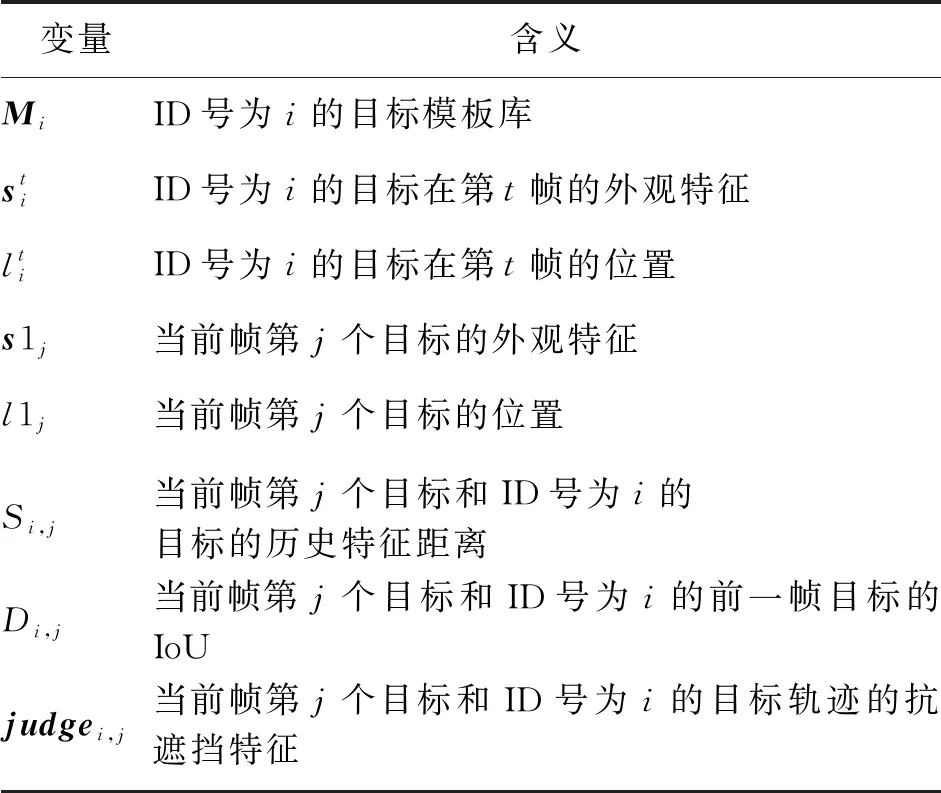

2.1.3 计算全局遮挡系数

根据当前帧目标框的相互覆盖程度,计算全局遮挡系数,具体为

(5)

(6)

图3 全局遮挡系数示例

2.1.4 获取自适应抗遮挡特征

在上述两个特征中,外观特征值越大,差异性越大;运动特征值越大,差异性越小。对两个特征联合使用时,首先需要对运动特征进行归一化,如式(4)所示。接着通过全局遮挡系数∂对当前帧的特征结构进行自适应调整,具体为

(7)

通过∂自适应调整后得到的自适应抗遮挡特征存到矩阵judge。矩阵judge将作为后续数据关联的输入矩阵,是数据关联的唯一依据。当∂值变大时,目标帧的遮挡状态加重,算法自动调整特征结构,加大外观特征比重,减少运动特征比重,当∂值变小时,目标帧的遮挡状态得到缓解,目标之间的重叠减少,算法自动调整特征结构,减少外观特征比重,加大运动特征比重。

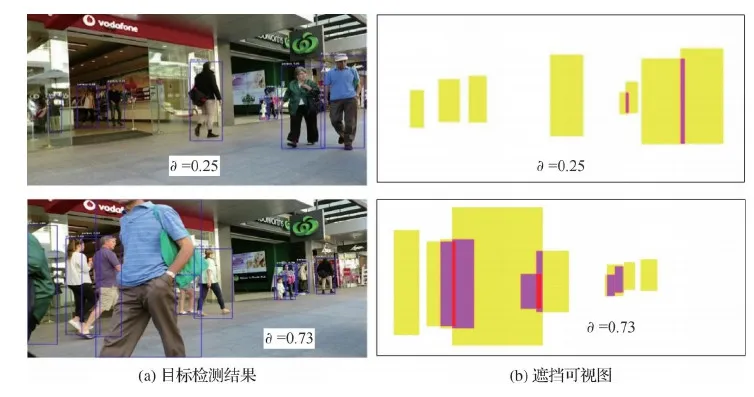

2.2 新目标级联筛查机制

在多目标跟踪中,新目标的界定尤其重要。跟踪场景复杂多变、目标姿态和尺度频繁变化以及密集场景的频繁遮挡都会导致目标不能成功关联。如果将这些因为特殊原因跟踪丢失的目标界定为新目标,则会发生ID切换和轨迹断裂,会直接影响跟踪算法的性能。对此,本文提出级联筛查机制,减少了特殊情况下的“虚新入目标”,如图4所示。

图4 新目标级联筛查机制

第1级筛查在数据关联时进行,自适应抗遮挡特征(结合了运动特征和高层外观特征)在一定程度上降低了“虚新入目标”的数量,使大部分场景中的目标都能成功跟踪到。关联失败的目标可能含有真正新入场景的目标和少量“虚新入目标”,需要再次筛查。第2级筛查利用低层外观特征,采用一个4层的网络S2提取未成功关联的目标特征和模板特征进行距离比对。距离小于阈值d的,认为是已经存在的目标,无需新建目标轨迹;否则,新建并初始化目标和轨迹数据,在后续帧中进行正常跟踪。经过多次试验,本文算法设置d=0.5,此时算法跟踪性能最好。

2.3 自适应去干扰模板更新

目标发生遮挡时,无论是部分遮挡,还是全遮挡,由于目标是采用矩形框区域来表示的,都会或多或少混入别的目标信息。此时,如果将成功关联的目标一视同仁地进行更新,这些遮挡的目标将会给模板库带入噪声,导致后续的关联错误。以长时全遮挡为例,将遮挡过程分为5个阶段:遮挡前(B0)、部分遮挡1(PO1)、完全遮挡(FO)、部分遮挡2(PO2)、无遮挡(NO)。通过分析遮挡过程,得到两个发现。1)发生全遮挡前的目标处于PO1状态,这时目标存在部分遮挡,混入了其他目标信息,可靠性降低。重新出现的目标处于PO2状态,有很大一部分是遮挡的,此时目标特征混入了其他目标信息,背景发生很大变化,如图5所示。2)在低视点跟踪场景下,每一帧都存在大量遮挡,并且大多数目标在视频序列上遮挡的时间超过70%,即使成功跟踪到这些目标,它们的更新给模板库带来的影响也不容小觑。

图5 全遮挡的5个阶段

基于以上两点事实,发现直接将带遮挡目标更新入模板库会给模板库引入大量干扰噪声。因此提出基于局部遮挡状态的自适应模板更新机制。根据所有目标的遮挡状态(可通过计算目标的局部遮挡系数得到),对不同遮挡状态的历史目标模板给予不同权重,并且根据权重进行自适应模板更新。基于局部遮挡系数的自适应去干扰模板更新机制包括局部遮挡系数计算、模板更新权重计算和自适应模板更新3个步骤。

2.3.1 局部遮挡系数计算

根据当前帧中检测到的目标框信息计算每个目标的局部遮挡系数。具体为

(8)

2.3.2 计算模板更新权重

图6 更新权重示例

(9)

2.3.3 自适应模板更新

权重值越大的目标,遮挡越严重,干扰信息较多,不应该更新到模板库中;权重值小的目标,遮挡程度弱,可以更新到目标模板库中。因此对模板进行更新时,阈值设定很有必要。权重值小于阈值W的成功关联目标,可以添加到对应模板库中;大于阈值W的关联目标不做更新。即

(10)

实验表明,W的最优值为0.6。实验结果如图7所示。

图7 W的最优取值

通过更新权重,算法能够根据目标的局部遮挡状态自适应选择可靠性高的关联目标进行模板更新,防止干扰信息较多的关联目标的更新,降低了遮挡严重目标对模板库的影响。图8是MOT16-09中1号目标经过自适应抗噪声模板更新后得到的模板库示例(110—180帧),剔除了严重遮挡目标对模板库的影响。

图8 自适应去干扰模板更新后得到的模板库

2.4 其他算法实现细节

2.4.1 网络结构及训练方法

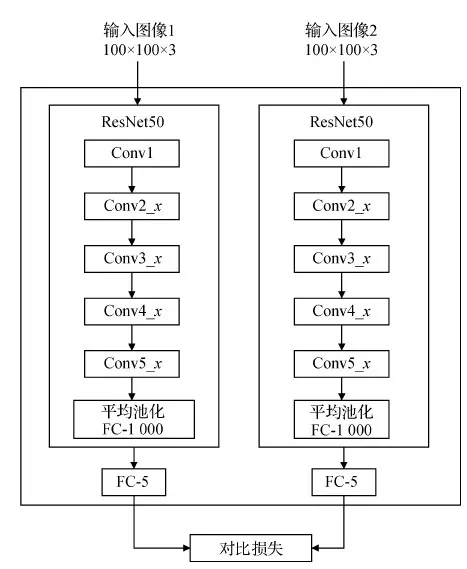

1)孪生网络。孪生网络由两个子网络组成,可以通过大量图像对信息学习到两个可比较的事物之间的相似性(李沐雨,2020)。在TBD跟踪中,算法需要对跨帧之间的检测目标进行大量相似性比对,孪生网络非常适用于这样的相似性度量任务,如图9所示。

图9 用孪生网络进行相似性度量的示例

2)网络结构。算法涉及两个孪生网络S1和S2。S1提取目标的高层特征,在ResNet50(He等,2016)结构的基础上添加FC(fully convolution)层,将输出特征变为1 × 5的向量,用于目标外观特征提取,如图10所示。S2提取目标的低层特征,输出1 × 5的向量来表示目标特征,用于新目标级联筛查,如图11所示。

图10 S1的网络结构

图11 S2的网络结构

3)低维度特征。本文使用小维度的输出特征平衡不同信息的特征长度。众所周知,运动和位置特征通常很短。如果将其与长外观特征结合,就很难充分利用位置和运动特征。本文认为位置和运动信息同等重要,应该通过减少外观特征的维度来强调它们。同时,低维度的输出特征可以降低后续数据关联过程的复杂性,使程序运行更快。

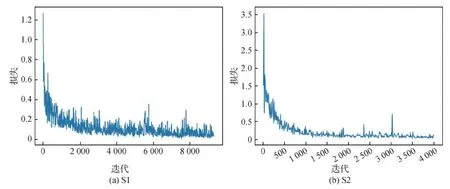

4)网络训练。孪生网络S1和S2均在ReID行人重识别数据集I-LIDS-VID(UK government benchmark datasets for automated surveillance)上训练,如图12所示。S1和S2网络能够快速收敛,学习到了行人在不同场景下的相似性,在光照、视点、背景和遮挡等复杂场景下仍然能获得可区分的目标特征。

图12 S1和S2的训练过程

训练时,S1和S2的损失函数采用对比损失,具体为

(11)

式中,d和y分别代表待比较的两个特征之间的欧氏距离和匹配程度。y= 1和y= 0分别表示样本相似和不相似两种状态。m是设定阈值。当样本对相似时,如果d变大,损失函数促使模型增大损失值;同理,当样本对不相似时,如果d变小,模型增大损失值。

2.4.2 数据关联方法

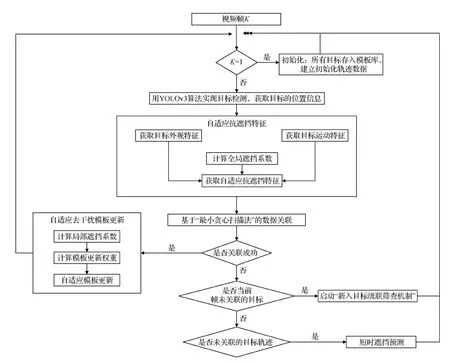

多目标跟踪的数据关联大多采用匈牙利算法(Bae和Yoon,2014)。匈牙利算法可以求得二部图的最大匹配。完美匹配一定是最大匹配,而最大匹配不一定是完美匹配。尤其是在多目标跟踪场景中,关联的准确度比关联的数目更为重要,因此本文采用最小贪心扫描法对抗遮挡特征矩阵judge进行数据关联,以提高关联准确度。

抗遮挡特征矩阵judge行表示目标模板(轨迹)数,用n1表示;列表示当前帧中的目标数,用n2表示。最小贪心扫描法具体步骤如下:

1)选择扫描基准。若n1 2)顺序扫描每一列,找到每一列中最小值的行标,将此行标和对应列标的组合添加到成功关联集合R。 3)在步骤2)得到的关联集合R中,若有相同列标对应多个行标,即同一个当前目标关联了多条轨迹,则选取特征值最小的关联保留,其余的从R中删除。 2.4.3 短时遮挡中的预测 在短时遮挡或目标漏检时,目标在帧间的运动距离很小,运动模型可以预测目标的下一帧位置,方便进行搜索和定位。本文采用线性恒速模型来近似每个物体的帧间位移。每个目标的状态建模为 X=[u,v,r,h,x′,y′,r′,h′] (12) 式中,u和v分别表示目标中心点的横、纵坐标,r和h是目标矩形框的纵横比和高度,x′、y′、r′、h′是前4个变量的变化速度。r在运动模型中是恒定的。当检测目标和目标模板成功关联时,使用检测框信息更新对应目标的轨迹状态。若关联失败,则利用式(12)中目标的历史状态信息得到预测目标的新位置和大小,进而获取预测目标的特征和目标模板特征进行相似性度量。若距离值小于阈值P,则认为找到目标,更新轨迹信息。经多轮实验,本文选取0.8作为P的最佳值。 本文提出的低视点下遮挡和尺度多变自适应感知的多目标跟踪算法整体框架如图13所示。算法的具体步骤如下: 图13 算法流程图 1)初始化。第1帧时,建立目标模板库和初始轨迹数据。 2)目标检测。用YOLOv3(Redmon和Farhadi,2018)算法对当前帧实现目标检测,得到所有目标的位置信息。 3)自适应抗遮挡特征获取。首先获取所有目标的外观特征和运动特征,接着计算全局遮挡系数,最后计算自适应抗遮挡特征,保存在judge矩阵中。 4)数据关联。将特征矩阵judge作为输入,采用最小贪心扫描法实现数据关联。 5)自适应去干扰模板更新。对于成功关联的目标,采用自适应去干扰模板更新方法实现模板库的更新。首先计算局部遮挡系数,接着计算模板更新权重,最后根据模板更新权重,自适应进行模板库更新。处理完后,转步骤2)。 6)当未成功关联时,分两种情况进行处理。如果是未关联的当前帧目标,启动新目标级联筛查机制;如果是未成功关联的目标轨迹,对该轨迹对应的目标根据上一帧位置进行短时遮挡预测。 7)转步骤2),进行下一帧处理。 为了检验提出算法的鲁棒性,选取MOT16(multi-object tracking)(Dendorfer等,2021)数据集中低视点拍摄的视频(存在频繁遮挡的跟踪场景)进行针对性实验。选取的视频为测试集中的MOT16-01、06、12和训练集中的MOT16-05、09、11。 采用MOT16数据集的标准评价指标FP(false positives)、FN(false negatives)、MOTP(multiple object tracking precision)、ML(mostly lost tracklets)、IDF1(ID F1 score)、IDSW(ID switches)、MOTA(multiple object tracking accuracy)、MT(mostly tracked tracklets)、Frag(fragments)和Rcll(recall)衡量算法的跟踪性能。在所有评价指标中,多目标跟踪准确度(MOTA)一直是评价多目标跟踪算法最重要的指标,如果不存在跟踪错误,则MOTA得分为1。 在低视点跟踪场景下,本文算法对遮挡具有自动感知的能力,可以根据全局遮挡系数动态调整目标特征结构进行数据关联,也可以根据局部遮挡系数对模板库进行自适应去干扰更新,多项跟踪指标得到提升。为全面验证本文算法的性能,在MOT16低视点场景下与近年一些算法的跟踪性能进行对比,并对级联筛查机制在新入目标判定上的准确度和有效性进行实验,同时进行了两组消融实验,验证自适应抗遮挡特征和自适应去干扰模板更新机制在跟踪性能中的作用。 3.2.1 MOT16低视点场景下的跟踪性能结果对比 表2为本文算法在MOT16低视点拍摄视频上的总体跟踪性能。表3—表5为本文算法与STAM、ATAF、STRN、BLSTM_MTP_O和IADMR等典型算法在测试集MOT16-01、06、12上的跟踪性能对比。表3中,本文算法的MOTP、FN和MT指标值是6个算法中最好的,真实标注轨迹被成功跟踪的数目以及漏警数都比较理想,MOTA和Rcll仅次于ATAF。表4中,本文算法的MOTA、MOTP、FN、Rcll和MT指标值是6个算法中最好的。表5中,本文算法的MOTA、MOTP、FN、Rcll和ML指标值是6个算法中最好的。从这些指标可以发现,本文算法中提出的自适应抗遮挡特征的区分度得到了一定提升,对遮挡频繁复杂场景具有一定的适应能力。 表2 本文算法在MOT16低视点视频上的跟踪性能 表3 不同方法在MOT16-01测试集上的实验结果对比 表4 不同方法在MOT16-06测试集上的实验结果对比 表5 不同方法在MOT16-12测试集上的实验结果对比 3.2.2 新目标判定准确度 级联筛查机制的主要目的在于减少由遮挡带来的目标特征剧烈变化而认定为“虚新入目标”的错误跟踪现象。目前的多目标跟踪工作中鲜有此项工作,没有可以参考借鉴的评价指标。为了验证级联筛查机制的有效性,本文提出目标正确率作为评价指标。该指标用算法运行后得到的总目标数与实际目标数真值的比值来表示,可在一定程度上度量算法在新入目标判定上的有效性和准确度。表6为本文算法的级联筛查机制的目标正确率。 表6 新目标判定准确度 从表6可知,本文算法的级联筛查机制在MOT16-2、4、5、11号视频上的目标数准确度高,能够在一定程度上抑制遮挡带来的“虚新入目标”现象,在MOT16-9、10、13号视频上的目标准确度仍然有待提高。 3.2.3 消融实验 自适应抗遮挡特征和去干扰模板更新方法的目的在于增强数据关联时所用特征对遮挡的感知和调整能力,以及减少历史模板库中带遮挡模板对多跟踪性能的影响,最终提高算法对遮挡的应变和调节能力。为了验证上述两项主要工作的有效性,在训练集MOT16-05、09、11上进行了两组消融实验。 1)自适应抗遮挡特征消融实验。首先对外观特征、运动特征、固定比例融合特征(0.5 × 外观特征 + 0.5 × 运动特征)和本文提出的自适应抗遮挡特征(外观特征 + 运动特征 + ∂自适应调节)的有效性进行对比,实验结果如表7所示。可以看出,仅使用外观特征或运动特征,MOTA值分别为49.4%和37.6%。通过固定比例融合特征,准确率明显更高,MOTA值为49.3%。通过式(7)计算得到的自适应抗遮挡特征,MOTA达到51.2%。本文提出的抗遮挡特征在MOTA指标上,相比混合特征、外观特征和运动特征分别提升了1.9%、1.8% 和13.6%。值得注意的是,使用抗遮挡特征后,Rcll、FN、MT和ML等指标也得到了改进。这些实验数据对比证明了本文提出的自适应抗遮挡功能的有效性。 表7 自适应抗遮挡特征消融实验 2)自适应去干扰模板更新方法消融实验。不同更新策略在提高跟踪精度方面的效果如表8所示。这部分的消融实验都是在自适应抗遮挡特征的基础上完成的。实验对3种更新方法,即常规更新(不考虑目标遮挡状态)、带权重更新(常规更新+权重更新)和自适应去干扰更新(常规更新+权重更新+自适应去干扰)的效果进行了对比。使用不考虑目标遮挡状态的常规更新策略,MOT为33.5%。使用式(8)的基于局部遮挡系数的带权更新策略,MOTA为40.5%。使用式(9)的自适应去干扰更新策略,准确率明显更高,MOTA为51.2%。 表8 自适应去干扰模板更新消融实验 通过使用本文算法提出的自适应去干扰更新策略,相比带权更新策略和常规更新策略,MOTA分别提升了10.7%和17.7%。值得注意的是,本文提出的更新策略中,ID的切换次数显著减少,从244降到119,表明提出的去干扰更新策略可以提高模板库的清洁度和数据关联的准确性。Rcll、FN、MT、ML 和 Frag 等其他指标也有明显改善,进一步证明了本文更新策略的有效性。 为验证本文算法在低视点频繁遮挡和尺度多变场景下的跟踪能力,对算法在部分遮挡、短时全遮挡和长时全遮挡下的跟踪结果进行定性分析。 3.3.1 部分遮挡下的跟踪结果 本文算法在部分遮挡下的跟踪效果如图14所示。可以看出,第1行的1、28号目标、第2行的70号目标、第3行的19、39号目标在视频序列上均发生了部分遮挡,遗失了部分目标信息,目标特征受到干扰,但本文算法中的自适应抗遮挡机制能够根据视频帧的遮挡状态,动态调整目标特征的结构,使算法能够更有效地利用剩余目标信息,实现连续、准确的定位和数据关联。同时,算法中的自适应去干扰模板更新方法能够去除这些半遮挡目标对模板库的影响,保持了模板库的纯净。 图14 部分遮挡下的跟踪结果 3.3.2 短时全遮挡下的跟踪结果 图15是本文算法在短时全遮挡场景下的跟踪效果。第1行的11号目标,因为车辆经过,发生了25帧的短时全遮挡,在65帧再次出现时,被本文算法成功跟踪到。第2行的215号目标在1 094帧时被208号目标遮挡,发生了16帧的短时全遮挡,在1 110帧重新进入时被算法成功跟踪到。第3行的4号目标,被1号目标遮挡,发生了21帧的短时全遮挡,在第53帧重新进入监控场景时被本文算法成功跟踪到。这些不错的跟踪结果得益于本文提出的自适应抗遮挡特征,使目标特征更加高效、有区分度。 图15 短时全遮挡下的跟踪结果 3.3.3 长时全遮挡下的跟踪结果 图16为本文算法在长时全遮挡下的跟踪结果。第1行的1号目标在111帧后被5、6号目标完全遮挡,直到155帧时才重新出现,其间共消失了44帧,本文提出的自适应抗遮挡特征,仍然能够准确定位、跟踪到了该目标。第2行的8号目标在92帧后被2号目标完全遮挡,直到172帧时才再次出现,其间消失了长达80帧,同时该目标还伴有尺度的不断变化,但本文算法凭借鲁棒的自适应抗遮挡特征,重新找回了该长时全遮挡目标,实现了准确跟踪,保持了轨迹的一致性。同时,在全遮挡发生时,本文提出的自适应去干扰模板更新机制,避免了大量目标在遮挡前和遮挡后出现的半遮挡状态给模板库带来的影响,保证了模板库的干净、准确。 图16 长时全遮挡下的跟踪结果 本文针对低视点跟踪下的遮挡问题,提出遮挡自适应感知的多目标跟踪算法。首先根据每帧图像的全局遮挡状态,采用自适应抗遮挡特征,增强关联特征对遮挡的感知和调整能力。同时,采用级联筛查机制,减少由遮挡引起目标特征剧烈变化而认定为“虚新入目标”的错误跟踪现象。最后,根据目标的局部遮挡状态,提出自适应去干扰模板更新机制,降低了存在遮挡的模板对跟踪性能的影响,进一步提高了算法对遮挡的应变和适应能力。实验结果表明,本文提出的算法在低视点跟踪场景下,跟踪性能得到提升,大多数评价指标优于STAM、ATAF、STRN、BLSTM_MTP_O和IADMR等典型算法,对遮挡具有一定抵御作用。但是,本文算法没有专门针对摄像机刚性运动的运动估计机制,当摄像机快速运动时,目标运动特征可靠性降低,导致跟踪性能下降。同时,本文算法是基于数据关联的跟踪算法,对目标检测算法过度依赖,在目标漏检或误检时,轨迹出现断裂或交叉,这是该算法的两个瓶颈。在今后工作中,将重点解决以上提到的两个问题,进一步提高跟踪算法对实际跟踪场景的适应能力。2.5 算法流程

3 实验结果及分析

3.1 数据集及评价标准

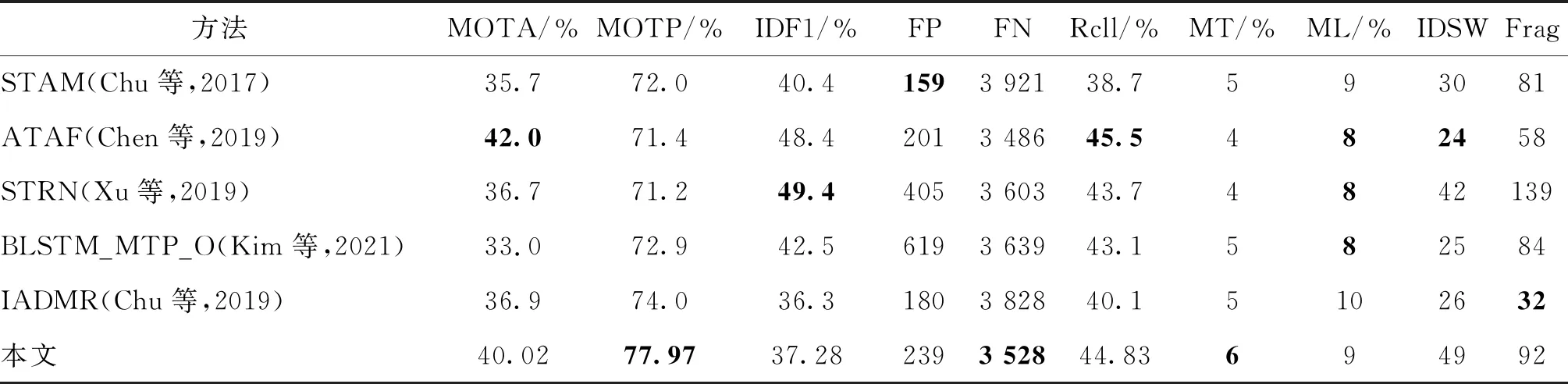

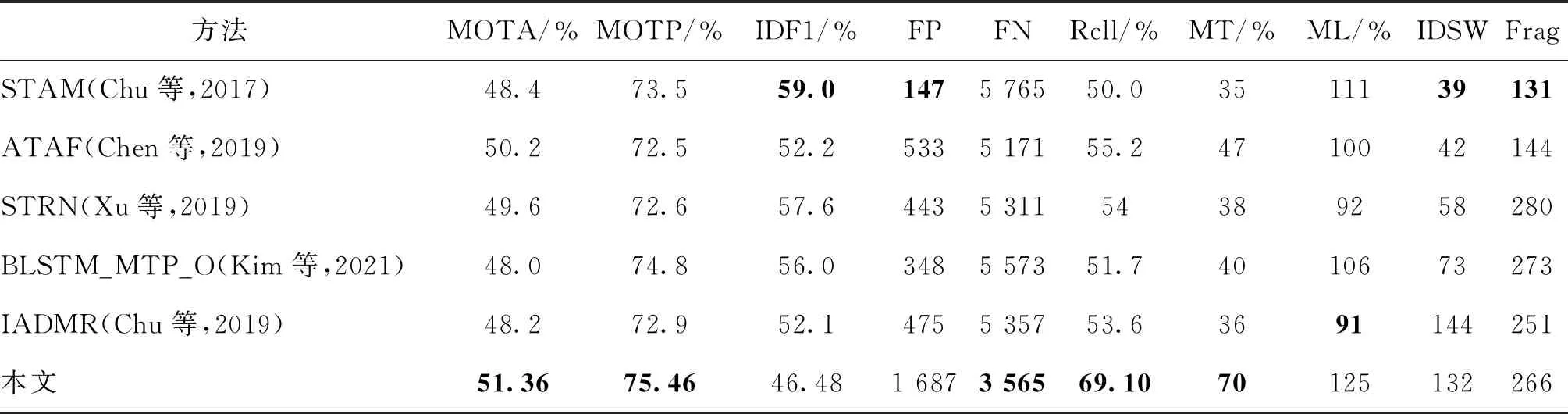

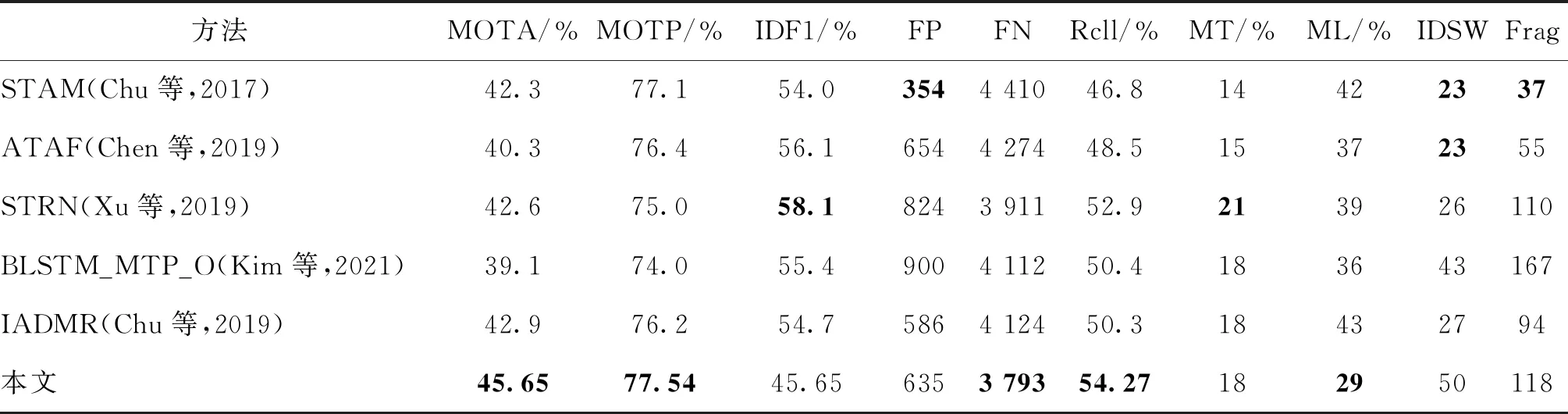

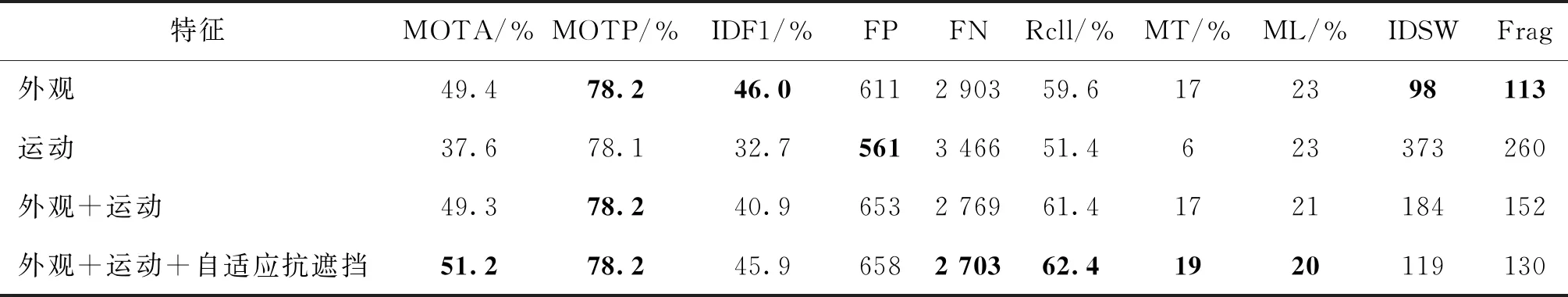

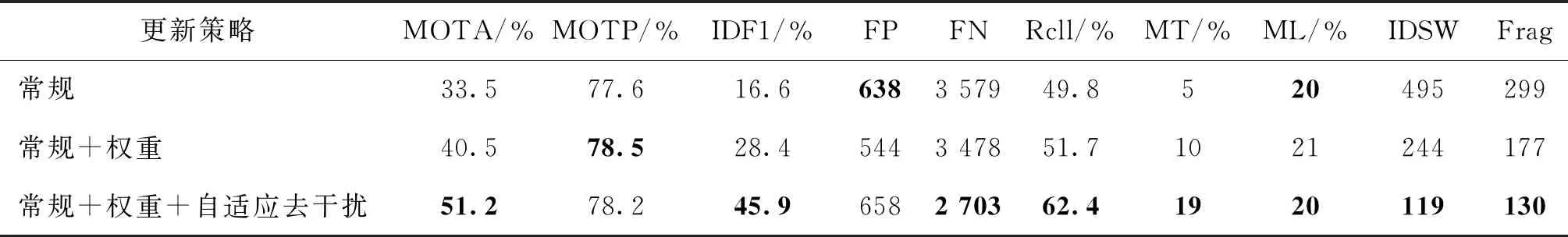

3.2 定量分析

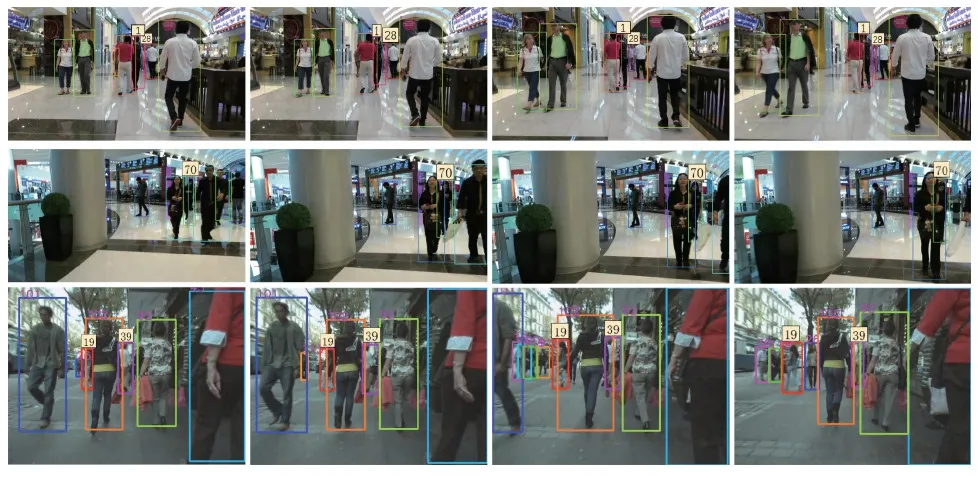

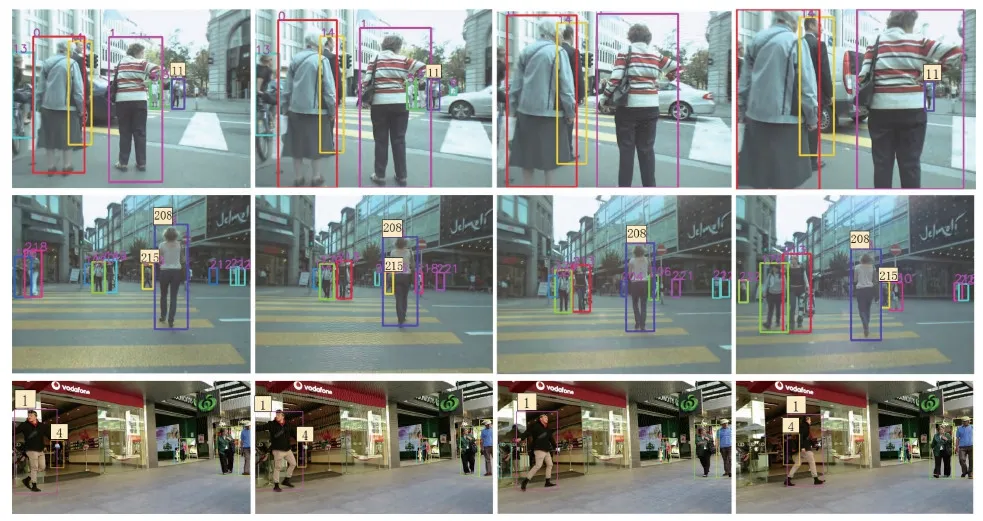

3.3 定性分析

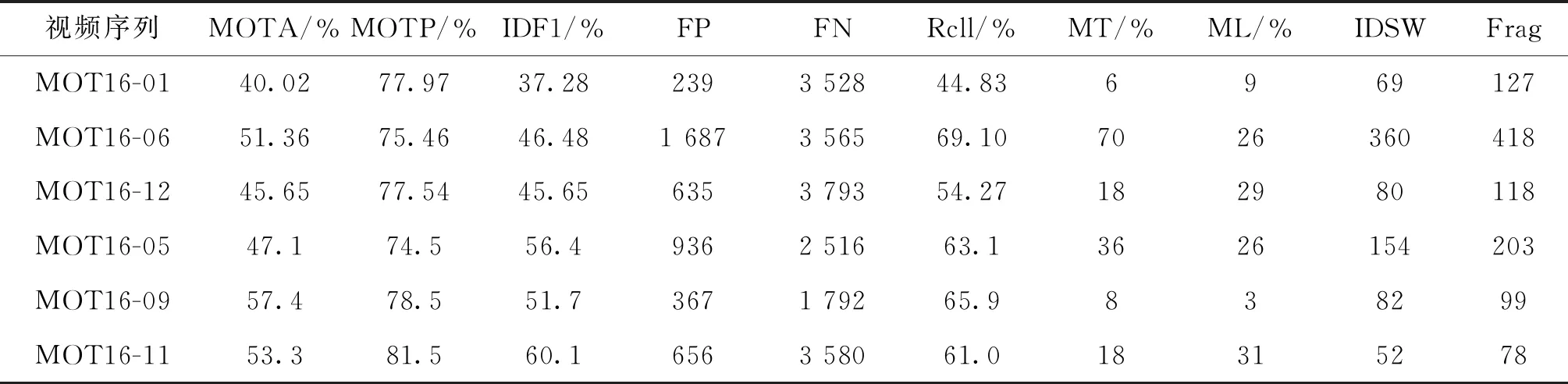

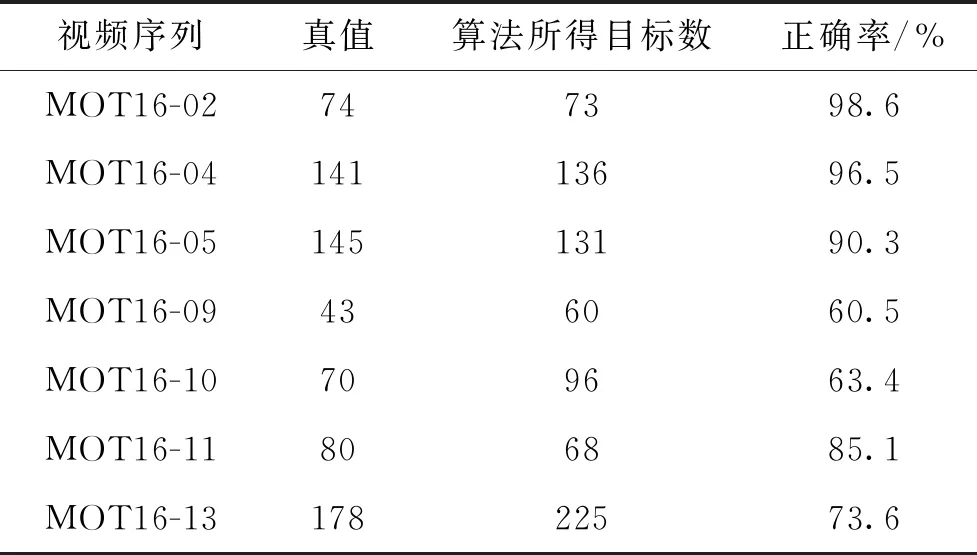

4 结 论