多尺度分解双寻优策略SPCNN的果园苹果异源图像融合模型

刘立群,顾任远,周煜博,火久元

多尺度分解双寻优策略SPCNN的果园苹果异源图像融合模型

刘立群1,顾任远1,周煜博1,火久元2

(1. 甘肃农业大学信息科学技术学院,兰州 730070; 2. 兰州交通大学电子与信息工程学院,兰州 730070)

针对单一的自然场景图像信息不能满足准确识别果实和精准定位目标的要求,提出一种多尺度分解双寻优策略简化脉冲耦合神经网络(Simplified Pulse Coupled Neural Network, SPCNN)的飞行时间(Time of Flight,ToF)与可见光果园苹果图像融合模型。对SPCNN模型引入带参数优化的双寻优策略,对非下采样轮廓波变换(Nonsubsampled Contourlet Transform, NSCT)融合规则进行改进。模型包括配准模块、编码区、多尺度分解模块、单目标SPCNN融合模型、多目标SPCNN融合模型、解码区。模型改进了SPCNN模型的参数优化方式以及迭代次数,模型自适应点火次数较低,在3~7次左右,具有点火次数低、自适应分割、效率高的优点。中光15:00时段点火识别成功率达到了100.00%,点火分割时间达到最低91.91s。与其他融合模型比较,模型在强光12:00、中光15:00、弱光18:20、19:00时段融合图像识别成功率达到100.00%;融合时间低于SPCNN模型,达到最低92.68 s。模型识别精度最优达到了100.00%,融合耗时最低达到了92.68 s,模型大小较SPCNN低一个数量级,可补充和完善图像层次融合理论和方法。

图像识别;模型;非下采样轮廓变换;简化脉冲耦合神经网络;异源图像融合模型;单目标策略;多目标策略

0 引 言

苹果自动采摘中,准确识别出苹果果实对苹果目标的精准定位尤为重要[1]。单一的自然场景图像采集信息已经不能满足准确识别果实和精准定位目标的要求,异源图像融合(Image Fusion, IF)技术应运而生[2]。不同类型传感器采集的图像数据特性不尽相同,其中深度传感器成像系统采用飞行时间(Time of Flight, ToF)技术,通过(850±30)nm近红外光的飞行时间来完成距离计算,已作为可见光相机的有益补充,应用在农业、医疗、质检、视觉等领域,具有广泛的应用前景和研究价值[3]。杨勇等用卷积自编码融合网络针对红外与可见光图像进行融合[4],结果优于其他主流融合方法,但仅适用于红外热度信息丰富的图像融合领域。在自然场景果园条件下,果树、果实本身不具备红外热度感应特性,ToF深度传感器成像系统具备发射近红外光并通过光线发射和反射时间差计算果实距离、产生深度(即距离)信息的条件[5],因此适用于构建本文异源视觉系统。学者们针对ToF深度传感器成像系统采集的深度信息进行了一系列应用研究[6-7],利用ToF深度传感器与可见光相机构建异源视觉系统是可行且必要的,深度图像在融合研究应用中提供了必要的补充信息。

像素级变换域融合模型是目前研究的热点,其中非下采样轮廓波变换(Nonsubsampled Contourlet Transform, NSCT)是一种灵活的多尺度、多方向、平移不变的变换域融合模型分解方法,NSCT变换由非下采样塔式滤波器组(Nonsubsampled Pyramid Filter Bank, NSP)和非下采样方向滤波器组(Nonsubsampled Directional Filter Bank, NSDFB)两部分组成[8]。利用NSCT提取源图像的特征,可以为融合图像提供更丰富的细节信息[8]。部分学者尝试将小波变换应用于图像融合领域[9],但由于离散小波变换(Discrete Wavelet Transform, DWT)仅能分解出有限方向的细节信息,融合结果仍然不够理想[10]。部分学者将多尺度变换、卷积神经网络引入,相继提出了轮廓波图像融合模型[11-12]、深度卷积神经网络多聚焦图像融合模型[13]、多序列深度特征融合模型[14]、变分融合模型[15]。杨风暴等[16-17]提出DWT、NSCT和改进主成分分析(Principal Components Analysis, PCA)的多算法协同组合融合模型。与曲线波和剪切波相比,NSCT能够充分融合源图像信息,融合图像具有较好的相关系数和信息熵,曲线波和剪切波在寻找边缘和轮廓方面具有很好的效果[10,16-17]。但是自然场景下,过多边缘信息并不能用于提取更有效的果实图像。现有融合模型具有各自应用领域的局限性,无法自适应扩展到本研究自然场景果园图像中。因此,曲线波和剪切波更适合医学等图像等背景简单、更需要提取轮廓的图像,NSCT更适用于本项目自然场景采集的图像融合。

简化脉冲耦合神经网络(Simplified Pulse Coupled Neural Network, SPCNN)[18]模型是模拟大脑皮层视觉神经细胞活动建立的神经网络模型,因具有聚集性点亮分割机制,常被用于图像融合领域,具有参数少、模型简单、参数受限于人工经验设置等特点,研究中常被视为多目标参数优化问题。在图像融合的多目标优化领域中,基于优化理论的自适应算法,站在一个更客观的角度去审视图像融合过程,做出最为科学严谨的判断,大大提升了融合图像的可靠性[19]。目前有学者将量子粒子群优化算法[20]、灰狼优化算法[21]、混合蛙跳算法[22]、蚁群算法[23]等应用于SPCNN图像融合的多目标参数求解中,建立了图像处理优化模型,提出了有效的评价指标,取得了较好的效果。

本文针对尚未形成公认的、系统的图像融合理论方法,提出一种多尺度分解双寻优策略SPCNN的ToF与可见光果园苹果图像融合模型。模型在自然场景果园苹果图像融合方面,有效提高ToF与可见光图像融合质量,对补充和完善图像层次融合理论和方法具有重要意义。

1 多尺度分解的异源图像融合模型构建

本文在SPCNN基础上改进,提出多尺度分解双寻优策略SPCNN的ToF与可见光果园苹果图像融合模型对异源视觉系统采集的图像进行融合。

其中,SPCNN表达式如式(1)~式(5)所示[18]。但仍存在参数经验设定、不能自适应终止、易出现过分割的缺陷,尚需进一步改进。

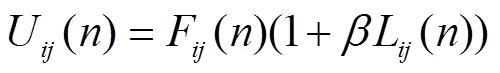

式中I是神经元外部刺激,由输入图像的灰度值表示;F()是反馈输入域,L()是链接输入域;W,kl表示链接系数;表示链接强度,决定耦合链接通道权重大小;U()为模型内部状态信号;表示当前点火次数;θ为神经元的动态阈值,V、V为动态阈值放大系数,控制神经元激活后增加的门限阈值;α和α分别决定了链接通道反馈项和动态阈值的衰减速度;Y()为当前神经元的脉冲输出,是内部活动项与动态阈值在脉冲发生器中进行比较后输出的响应结果。当满足U()>θ()时,就会达成点火条件输出Y()=1。

本文模型具体包括单目标SPCNN融合模型(Single Target SPCNN fusion model, ST-SPCNN)和多目标SPCNN融合模型(Multi-Target SPCNN fusion model, MT-SPCNN)两个模块。利用ToF深度相机与可见光相机构建异源视觉系统,采用变换域NSCT对异源图像进行多尺度多方向分解,将SPCNN模型参数优化问题看作多目标优化问题,采用改进人工蜂群(Artificial Bee Colony, ABC)[24]算法对ST-SPCNN模型和MT-SPCNN模型进行双寻优策略参数优化,包括单目标优化参数策略和多目标参数优化策略,最后利用优化后的SPCNN模型融合异源图像。

1.1 模型结构

多尺度分解的异源图像融合模型结构如图1所示,包括配准模块、编码区、多尺度分解模块、ST-SPCNN、MT-SPCNN、解码区。其中,输入原图像分别为异源视觉系统ToF强度图像、置信图像和对应的可见光图像,配准模块用于两幅图像的像素级精准配准,编码区用于对SPCNN模型的参数进行编码,待优化使用;多尺度分解模块由NSCT分解模块组成,配准后图像分别经过NSP多尺度变换以及NSDFB多方向分解模块,将分解出的高频和低频图像,分别通过ST-SPCNN模型、MT-SPCNN模型不同的融合规则进行融合,将编码区编码的四个参数向量分别作为单目标人工蜂群算法以及多目标优化算法的初始种群,采用改进的人工蜂群策略对参数进行自适应的寻优。融合后,经过NSCT逆变换,融合成一幅图像,最后通过解码区对每一个二进制向量解码为实数参数。

1.1.1 配准模块

1)异源视觉系统的标定

本文采用相机标定法[25],7×8棋盘的标定板对异源视觉系统进行标定,棋盘上的网格为22 mm×22 mm,使用MATLAB摄像机标定工具箱对双目摄像机进行标定。标定时可见光图像是参考图像,ToF图像是浮动图像,用彩色相机去标定ToF相机。计算得出图像坐标与世界坐标系的对应关系,其中ToF相机相对于彩色相机参考坐标系的、、方向的偏移量是一维向量[108.678 15.695 3.800],单位mm。通过以上操作对异源视觉系统完成相机标定操作。

2)异源图像的配准

本文使用外极线约束用于双目图像的立体校正,以形成共面配准。然后将尺度不变特征变换(Scale-Invariant Feature Transform, SIFT)算法[26]应用于校正后的双目图像,实现立体匹配。最后,使用随机抽样一致(Random Sample Consensus, RANSAC)[27]算法消除失配,提高精度。

1.1.2 编码区

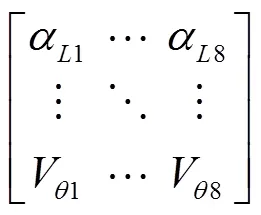

SPCNN模型具有参数不能根据图像信息自适应设定、严重依赖人工参数设置的缺陷。编码区针对SPCNN模型输入链接通道反馈项α、链接强度、动态阈值衰减因子α以及动态阈值放大系数V四个参数进行编码,每一个参数对应于编码区的一个维度的向量,构成以下形式矩阵,如(6)式所示。其中维度为4,每个参数对应向量采用八位二进制编码。

注:NSP代表NSCT变换中非下采样塔式滤波器组;NSDFB代表NSCT变换中非下采样方向滤波器组;NSCT为非下采样轮廓波变换。

Note: NSP represents nonsubsampled pyramid filter bank in NSCT transform; NSDFB represents nonsubsampled directional filter bank in NSCT transform; NSCT represents nonsubsampled contourlet transform.

图1 多尺度分解的异源图像融合模型

Fig.1 Multi-scale decomposition of heterogeneous image fusion model

1.1.3 多尺度分解模块

氟喹诺酮类,抗菌作用佳,但相比其他类型,价格较贵,在泌尿系统病原体诱发的感染及相关病菌中作用明显。然而此类抗菌药会对体内DNA有效合成造成影响,孕妇一般不建议使用,对于儿童,也尽量避免使用,因其可能对儿童的成长及发育造成不良影响[2]。对此,关于氟喹诺酮类抗菌药,临床应用时需注意适用对象。

持这种理论的人,主要认为应区别对待“专门用于执行专利方法的产品”、“专门用于制造专利商品的零部件或设备”和“专利产品”、“依据专利方法直接获得的产品”。这些论者一般都认可权利用尽规则适用于后两者,而对于前两者,最多适用默示许可规则。

经过配准的两幅图像,经过多尺度NSCT分解模块。对图像进行NSP变换,通过nsc级变换后,会生成一个低频子带图像和nsc个高频子带图像,共nsc+1个和原图像大小相等的子带图像。对分解出的高频子带进行q级NSDFB方向分解,可以得到2q个方向子带图像。即对原图像进行NSCT变换,其中NSP变换是nsc级,NSDFB变换是q级,就可以得到1个低频子带图像和nsc个高频子带图像,每个高频子带又包含2q个方向的子带图像,即共个不同方向高频子带图像。

3D打印技术采用增材方式实现制造,在一定程度上能够颠覆传统的减材加工技术。因为它不受设计零件的复杂度影响,所以现代产品设计的思维模式需要改变。基于此,为适应新时代对3D打印技术专业人才的市场需求,开展3D打印技术人才培养的课程体系建设具有一定的探索意义。

本文采用图1所示的NSCT多尺度分解,其中nsc级q个方向的参数选择,nsc和q的值均不宜过大也不宜过小,nsc过大,则导致分解出的高、低频子带数增多,影响后期融合效率,nsc过小,导致分解层数过少,影响融合效果;q过大,导致高频细节信息被划分太细腻,丢失重要的纹理信息,q过小,细节信息未被细分,不利于提供融合质量。因此,本文对两幅图像分别进行3级8方向分解。图1中,nsc=3,q=3,对原图像进行3级NSP多尺度分解,对高频子带进行3级NSDFB方向分解,最终得到了1个低频子带图像和3个高频子带图像,每个高频子带又包含8个方向的子带图像,共24个不同方向高频子带图像。

1.1.4 单目标SPCNN融合模型

对于施工面接缝处的防渗透技术施工主要是对施工材料的处理过程,也分两种情况,一种情况是使用钢板腻子,在处理钢板腻子是要在其接缝处形成止水带这样就可以使接缝处得到密封,若无法使用钢板腻子,就使用遇水膨胀橡胶,用遇水膨胀橡胶对接缝进行填充,填充前要按一定标准处理好接缝的横截面,这样也能起到防渗漏作用,在进行此项目施工时必须要做好测试,确保遇水膨胀橡胶能够起到相应的作用。

经过多尺度分解后的图像,变为高频和低频,采用单目标SPCNN融合规则分别对高频和低频图像进行融合。由于SPCNN模型参数由人工经验手动设定,无法与分割图像自适应匹配,存在将灰度一致性区域点亮误分割的现象。针对ToF图像果实目标在局部通常表现为整体灰度显著,结合ToF图像自身特性对SPCNN模型参数进行寻优,会得到自适应参数,提高融合质量。这里采用改进的单目标人工蜂群算法优化SPCNN参数,将编码区编码的四个参数向量作为单目标人工蜂群算法的初始种群,采用改进的人工蜂群策略对参数进行自适应的寻优。

人工蜂群算法是模拟群体蜜蜂特性提出的一种群体智能优化算法,是一种典型的全局寻优算法。蚁群算法具有收敛速度慢和易陷入局部最优的缺点。模拟退火算法存在收敛速度慢、性能与初始参数敏感等缺点。遗传算法的局部搜索能力较差,导致单纯的遗传算法比较费时,在进化后期搜索效率较低。禁忌搜索算法具有局部开发能力强、全局开发能力弱的缺点。粒子群算法收敛速度快但容易陷入局部最优解;而人工蜂群算法具有全局寻优能力强、参数少、精度高、鲁棒性强的优点,适于本研究中的参数优化策略。ABC算法中,雇佣蜂、观察蜂更新食物源信息策略具有单一性及随机性的缺陷,使得算法存在早熟、收敛停滞等问题,为了加速人工蜂群算法收敛速度,将ABC算法寻优策略进行改进。

1)雇佣蜂更新策略

随机生成NP个食物源信息,一次食物更新进化中,在蜂群中随机选择一个雇佣蜂所依附的食物源Xk=(xk1,xk2,…,xkd),找出此次更新中的全局最优食物源记为Xg=(xg1,xg2,…,xgd),在d维空间中,对食物源信息空间库中每个食物源Xk=(xk1,xk2,…,xkd)随机选择第j维分量xij通过以下雇佣蜂更新策略进行进化,如式(7)所示,得到一个新的食物源。其中,i,k∈[1,2,…,t],i≠k, j∈[1,2,…,d], r∈[−1,1]。

(7)

2)观察蜂更新策略

一次食物更新进化中,找出此次更新中的全局最优食物源作为观察蜂所依附的食物源,记为Xg=(xg1,xg2,…,xgd),对雇佣蜂更新策略进化得到的食物源在d维空间中随机选择第j维分量,通过以下观察蜂更新策略进行进化,如式(8)所示,得到另一个新的食物源。

(8)

3)单目标函数计算方法

B4、C1(有人员死亡)、C2(有人员死亡)、C3、D1(有人员死亡)、D2区域为较大风险区域. 风险水平在一定有条件下可接受,可能导致事故发生,造成人员伤害、财产损失,必须实施有效的风险控制措施;

图像融合质量采用相关系数(Correlation Coefficient,CC)、交叉熵(Cross Entropy, CE)、熵(Entropy, E)、互信息(Mutual Information, MI)共4个评价指标进行评价。由于图像融合后的质量需要4个评价指标共同衡量,四个评价指标在图像融合质量评价中起的作用相当,因此,对于单目标寻优问题,采取权重相加、权重相等的方式计算单目标函数,公式如(9)所示。其中,各指标对应的权重ωi=0.25,i=1,…,4。

(9)

4)SPCNN融合规则

经过分解的高频和低频图像,需要通过SPCNN融合规则进行融合。其中,SPCNN的参数链接域的链接系数Wij,kl采用n×n,n=5的矩阵,其中n代表Wij,kl与周围相邻神经元(k,l)的神经元个数,这里n=5代表当前神经元与周围5×5神经元相邻进行链接,如式(10)所示。

(10)

低频图像通过选取3×3区域,求解对应区域的方差σ,融合规则如式(11)所示。其中,代表融合后的低频分量,代表ToF图像的低频分量,代表可见光(Red Green and Blue, RGB)图像的低频分量。

(11)

高频图像通过选取3×3区域,求解对应区域的区域能量(Regional Energy, RE),融合规则如式(12)所示。代表融合后的高频分量,代表ToF图像的高频分量,代表RGB图像的高频分量。

(12)

1.1.5 多目标SPCNN融合模型

从控制理论的角度讲,异源图像融合本质上可以看作是将多幅图像组合为一幅图像的信息寻优过程。由于图像融合效果的评价指标具有多样性,各种指标之间关系复杂甚至相互矛盾,因此这种寻优过程可以采用多目标优化问题(Multi-Objective Optimization Problems, MOOP)[29]的理论来解决。

在ST-SPCNN模型中,将4个图像融合质量评价函数进行了加权求和的方式,忽略了4个评价指标的多样性。可以把这种寻优过程理解为多目标优化问题,含有多个目标函数,求解时存在多个相互冲突的目标,某个目标的改善可能引起其他目标性能的降低,需要在各个目标之间权衡协调,使所有的目标尽可能达到最优[28],最终得到一个帕雷托最优解集,又称Pareto最优解集。

1)多目标密集度构造方法

在多目标优化问题中,个体的优劣是通过支配关系和密集信息来判断的。为保证Pareto最优解之间的分布不过于密集,本文采用一种新的网格构造方法对Pareto最优解集密集度进行衡量,如式(13)~(14)所示。式中,lowi和uperi分别表示网格的最小和最大边界值,α表示网格扩张系数,α=0.1表示网络的边界值可以在一定范围内动态调整,Target表示目标函数的数量,Target=4代表多目标优化问题有四个目标函数CC,CE,E,MI。因此,对于最优解集中的每一个维度,在非支配解集合中找到它的最大以及最小值。适当放大最大值与最小值之间的区间,以防止非支配解落在网格的边界上。

(13)

(14)

i=1, …, Target, Target=4, α=0.1

2)多目标删除选择概率构造方法

构造非支配解集时,需要一定的概率随机删除多余的非支配解,以便满足最优解集密集度要求,本文采用一种新的删除选择概率方法,使用非支配解同维度网格索引gridW之间距离的L1误差进行度量,公式如(15)所示。

(15)

3)多目标函数计算方法

为解决图像融合质量评价函数多样性的问题,采用单目标中雇佣蜂、观察蜂更新策略,使用新的网格构造方法解集Pareto最优解集密集度问题,采用网格索引距离的L1误差作为非支配解选择删除概率,同时选择上述四个图像融合质量评价函数,形成四个目标的多目标优化问题,公式如(16)所示。

(16)

1.1.6 解码区

利用多尺度SPCNN融合规则对两幅图像融合后,经过NSCT逆变换,融合成一幅图像,经过目标函数的对比,迭代更新后得到融合图像,此时,对改进SPCNN模型输入链接通道反馈项αL、链接强度β、动态阈值衰减因子αθ以及动态阈值放大系数Vθ四个参数进行二进制解码,将每一个二进制向量对应转换成实数参数。

1.2 模型运行流程

模型运行流程是:将编码区编码的四个参数向量作为单目标人工蜂群算法的初始种群,采用改进的人工蜂群算法单目标优化参数策略和多目标参数优化策略对参数进行自适应的寻优。SPCNN模型因迭代终止条件通常人工手动设置为较大次数,具有不能自适应终止的缺陷。将双寻优策略目标函数作为SPCNN模型的迭代终止条件,加快了SPCNN模型点火分割的速度。SPCNN改进模型融合流程见图2所示。具体流程是:配准后图像经过图1的NSP、NSDFB多尺度分解模块,分解出高频和低频图像作为ST-SPCNN模型、MT-SPCNN模型的反馈输入域Fij(n)的输入,图像中每一个像素点与SPCNN中每一个神经元对应。神经元通过链接系数Wij,kl与周围相邻神经元(k,l)的上一次脉冲输出Ykl(n−1)耦合,将编码区中链接通道反馈项αL、链接强度β、动态阈值衰减因子αθ以及动态阈值放大系数Vθ四个参数矩阵作为人工蜂群算法的初始种群,分别采用改进的人工蜂群算法单目标优化参数策略和多目标参数优化策略对参数进行自适应的寻优,将双寻优策略目标函数作为SPCNN模型的迭代终止条件,达成点火条件时输出Yij(n)=1,输出点火分割结果,完成一次点火过程。

注:Fij(n)代表ToF或可见光图像经NSCT分解后的高频或低频分量灰度值;Lij(n)代表链接输入域;αL代表链接通道反馈项;β代表链接强度;αθ代表动态阈值衰减因子;Vθ代表动态阈值放大系数;Ykl(n−1)代表上一次点(k,l)处的脉冲输出;Wij,kl表示与周围相邻神经元的链接系数;(1+βLij)表示通过链接强度β将输入域Lij(n)结合;Uij(n)为模型内部状态信号;Yij(n)为当前神经元的脉冲输出;δ代表SPCNN模型的迭代终止条件。 Note: Fij(n) represents the gray value of high-frequency or low-frequency components of ToF or visible image after NSCT decomposition; Lij(n) represents the link input field; αL represents link channel feedback item; β represents link strength; αθ represents dynamic threshold attenuation factor; Vθ represents dynamic threshold amplification factor; Ykl(n−1) represents the pulse output at the last point (k,l); Wij,klrepresent the link coefficient with surrounding adjacent neurons; (1+βLij) indicates the strength through the link β Combine the input domain Lij(n); Uij(n) is the internal state signal of the model; Yij(n) is the pulse output of the current neuron; δ represents the iteration termination condition of SPCNN model. 图2 多尺度分解的异源图像融合模型运行流程 Fig.2 Multi-scale decomposition of heterogeneous image fusion model operation process

1.3 模型评价指标

1.3.1 双寻优策略SPCNN点火分割评价指标

倒伏对小麦子粒产量的影响情况见表2。由表2可知,4对调查样本倒伏小麦子粒产量均降低,降幅为 5.72%~22.19%。 倒伏小麦平均产量为 5 846.63 kg/hm2,未倒伏小麦平均产量为 6 707.25 kg/hm2,倒伏致小麦减产 860.62 kg/hm2,减产幅度为 12.83%。

试验采用原始SPCNN模型[18],本文ST-SPCNN模型、MT-SPCNN模型测试模型的点火分割性能。分别采用点火次数、分割效果、以及参数寻优结果进行评价。定义识别成功率RSuccess和漏识率RMiss两个指标对分割效果进行评价,两个指标定义表达式为(17)~(18)式。其中Nm为模型分割识别出的总目标数,Nf为人工目视识别的果实数量。为保证分割完整性,视分割出的一个完整无空洞的为一个目标果实,人工目视中忽略遮挡2/3果实、半个果实。

(17)

(18)

1.3.2 图像融合评价指标

试验选择六种模型,包括NSCT模型[8]、基于NSCT的红外和可见光图像融合模型(Fusion method for infrared and visible light images based on NSCT, ImNSCT)[29]、DWT模型[10]、原始SPCNN模型[18]和本文ST-SPCNN模型、MT-SPCNN模型对异源视觉系统图像融合性能进行对比测试。图像融合质量采用(Average Gradient, AG)、相关系数CC、交叉熵CE、熵E、互信息MI、空间频率(Spatial Frequency, SF)等评价指标[30]进行评价。其中CE值越小代表融合图像质量越好,其他评价指标值越大代表融合图像质量越好。融合图像的识别成功率RSuccess和漏识率RMiss两个评价指标延用式(17)~(18)表达式。模型复杂度用时间复杂度和空间复杂度两个指标进行评价,分别衡量模型运行时间效率以及模型所占内存大小。

1.4 模型数据获取

本文建立异源视觉系统,采用德国Basler公司生产的ToF工业深度相机与佳能公司生产的彩色相机。ToF相机能输出四种类型的图像,包括ToF强度图(ToF Intensity Image, ToF_intensity),ToF深度图(ToF Range Data, ToF_range),ToF置信图(ToF Confidence Map, ToF_confidence)以及ToF点云图(ToF Point Cloud Image, ToF_points)[31]。自然场景中的采集地点位于甘肃省天水市秦州区果树研究所试验基地。苹果样品的品种是天旺一号。利用异源视觉系统采集10:00-19:00不同光照条件下ToF强度图像、深度图像、置信图像和彩色图像各1 000余幅。

立体绿化的形式有很多,屋顶花园是其中的一种。屋顶花园的实质就是在建筑物的顶端构建花木、花池、架棚等,从而形成一定的观赏景观。对屋顶花园进行构建时,首先,了解场地情况,结合地面小型花园的布局与设计,合理设计攀援植物。其次,在设计屋顶花园的过程中也要综合考虑屋顶的防水和排水条件以及屋顶的承重能力,并对植物品种进行科学的选择与搭配。目前在植物的选取上,人们大多选择一些喜光、耐寒等生命力强的浅根系植物。例如鸡冠花、月季、爬山虎、月季等。植物种植可以采用盆栽的形式,避免植物根系生长时破坏屋顶。最后,在对屋顶花园进行装饰时,要注意层次与色彩的合理搭配,有效提高其观赏效果[1]。

从果园自然场景中采集的异源图像中选择6组数据作为样本,包括强光12:00、13:00、中光15:00、16:00以及弱光18:20、19:00六个不同时间段的ToF强度图像、置信图像和对应的可见光图像共18幅进行试验。分别设计点火分割试验和图像融合试验对提出的融合模型进行性能测试。

2 结果与分析

2.1 双寻优策略SPCNN点火分割试验结果分析

2.1.1 改进SPCNN点火分割结果分析

以ToF置信图像与可见光图像为例,在强光13:00 、中光15:00 和弱光18:20 条件下的低频分量点火分割效果见表1所示。

表1 改进SPCNN点火分割效果 Table 1 Ignition segmentation effect of improved Simplified Pulse Coupled Neural Network (SPCNN) 光照条件Illumination condition模型Model点火次数Ignition times分割目标数Target numberNm目视果实数Visual fruit numberNf识别成功率Recognition success rateRSuccess/%漏识率Missed recognition rateRMiss/%分割时间Segmentation runtime/s 强光13:00Strong sunlight 13:00SPCNN 503560.0040.00122.01 ST-SPCNN 54580.0020.0091.91 MT-SPCNN 34580.0020.0092.01 中光15:00Medium sunlight 15:00SPCNN 504757.1442.86121.28 ST-SPCNN 677100.00093.32 MT-SPCNN 56785.7114.2996.01 弱光18:20Weak sunlight 18:20SPCNN 503560.0040.00115.18 ST-SPCNN 74580.0020.0094.12 MT-SPCNN 64580.0020.0093.64

结果显示,SPCNN模型不能自主停止迭代,完全依靠人工经验设置。依据经验值,迭代次数一般设置在50~500次之间,具有点火次数长、点火次数固定、不具有自适应性的缺陷。表1表明,随着点火次数增加,SPCNN模型将属于同灰度的果实区域都分割出来,点火次数增加到50次时,果实内部分割出现空洞,出现过分割,不利于提高融合质量。本文提出的ST-SPCNN及MT-SPCNN模型具有自适应点火机制,在点火分割迭代次数满足双寻优策略目标函数条件时,停止迭代,加快了SPCNN模型点火分割的速度。同时,表1结果表明,SPCNN模型点火次数设置为固定次数50次,在13:00 强光、15:00 中光以及18:20 弱光3个时段的分割结果中均不同程度出现过分割现象,这表明固定经验的点火次数对分割结果不利。ST-SPCNN模型在3个时段的自适应点火次数分别为5、6、7次,MT-SPCNN模型自适应点火次数分别为3、5、6次,二者自适应点火次数均较低,在3~7次左右,远低于SPCNN模型固定迭代次数。而且,点火图具有果实分割清晰、无空洞、无过分割的优点。本文模型识别成功率皆高于SPCNN模型结果,在13:00 强光、15:00 中光以及18:20 弱光3个时段ST-SPCNN模型和MT-SPCNN模型对置信图的识别成功率均达到80.00%以上,且15:00 中光时段达到了100.00%。分割时间受点火次数影响,提出的模型分割时间皆低于SPCNN模型,最低达到91.91 s。

2.1.2 改进SPCNN模型参数分割结果分析

SPCNN模型4个参数人工手动设定值分别为。取多目标策略的非支配解集中的4个解作为解集合。其中强光13:00 条件下的寻优结果见表2所示。

SPCNN模型4个参数是通过人工手动设定,具有参数固定、经验取值的缺陷。表2结果显示,ST-SPCNN模型参数寻优简单,运行时间为91.91 s,低于MT-SPCNN模型运行时间92.01 s。MT-SPCNN模型参数寻优后具有多个非支配解,表2是选取Pareto最优解集中4个非支配解作为结果,参数彼此之间均符合寻优要求。SPCNN模型运行时间完全依赖于固定迭代次数的人工设置。双寻优策略寻优依赖于NSCT分解、参数寻优时间以及双寻优策略SPCNN模型融合时间,但是由于自适应迭代次数,使得改进后SPCNN模型点火次数大大减少,提高了效率,在点火几次的情况下就可以达到快速自适应分割,提高了融合效率。

表2 强光下改进SPCNN参数寻优结果 Table 2 Parameter optimization results of improved SPCNN under condition of sunlight with strong ST-SPCNN模型强度+可见光图像Intensity + visible image of ST-SPCNNST-SPCNN模型置信+可见光图像Confidence + visible image of ST-SPCNNMT-SPCNN模型强度+可见光图像Intensity + visible image of MT-SPCNNMT-SPCNN模型置信+可见光图像Confidence + visible image of MT-SPCNN αLβαθVθ分割时间/sαLβαθVθ分割时间/sαLβαθVθ分割时间/sαLβαθVθ分割时间/s 0.090.570.6854.6591.110.390.800.7537.7391.910.870.510.9463.7791.190.540.720.5299.3792.01 0.670.690.0625.470.400.440.3676.35 0.780.670.0160.210.190.130.699.38 0.420.460.7732.240.390.670.7452.00

注:αL代表链接通道反馈项;β代表链接强度;αθ代表动态阈值衰减因子;Vθ代表动态阈值放大系数。MT-SPCNN模型以4个非支配解为例。

Note: αL represents link channel feedback item; β represents link strength; αθ represents dynamic threshold attenuation factor; Vθ represents dynamic threshold amplification factor. Taking four non dominated solutions as examples for MT-SPCNN model.

2.2 图像融合试验结果分析

各时段融合效果比较见表3所示,各时段识别成功率均达到80.00%以上。其中强光12:00 、中光15:00 时段强度图、置信图与可见光融合图像识别成功率达到100%,弱光18:20 时段强度图、19:00 时段置信图的融合图像识别成功率达到100.00%。本文提出的融合模型融合时间低于SPCNN模型,强光12:00 时段强度图、置信图融合时间分别是92.68和93.69 s,达到最低。表4六种融合模型的质量评价指标显示,对于弱光18:20 时段,除相关系数CC(RGB)低于SPCNN模型0.95、互信息MI(RGB)低于SPCNN模型5.73以外,ST-SPCNN模型平均梯度AG值为12.03、相关系数CC(ToF)值为0.85、互信息MI(ToF)值为1.00,MT-SPCNN模型熵E值为7.30、空间频率SF值为23.80,融合指标值均为最大,MT-SPCNN模型交叉熵CE值为0.38,值最小。以上数据说明本文提出的模型图像融合质量高于其他模型。

表3 6种融合模型融合效果比较 Table 3 Comparison of fusion effects of six fusion models 光照条件Illumination condition时间Time模型Model融合图像总目标数Total number of fused images Nm目视果实数Visual fruit numberNf识别成功率Recognition success rateRSuccess/%漏识率Missed recognition rateRMiss/%融合时间Fusion runtime/s 强度+可见光置信+可见光强度+可见光置信+可见光强度+可见光置信+可见光强度+可见光置信+可见光强度+可见光置信+可见光 强光Sunlight with strong12:00NSCT223366.6766.6733.3333.3353.8652.79 ImNSCT223366.6766.6733.3333.3354.3053.81 DWT223366.6766.6733.3333.331.211.01 SPCNN113333.3333.3366.6766.67121.61116.20 ST-SPCNN3333100.00100.000.000.0093.7893.83 MT-SPCNN3333100.00100.000.000.0092.6893.69 13:00NSCT335560.0060.0040.0040.0052.8652.73 ImNSCT335560.0060.0040.0040.0053.8553.96 DWT335560.0060.0040.0040.001.031.03 SPCNN235540.0060.0060.0040.00115.77122.01 ST-SPCNN445580.0080.0020.0020.0094.0091.91 MT-SPCNN445580.0080.0020.0020.0094.1792.01 中光Sunlight with medium、15:00NSCT447757.1457.1442.8642.8652.8452.79 ImNSCT457757.1471.4342.8628.5754.0853.78 DWT447757.1457.1442.8642.861.021.02 SPCNN447757.1457.1442.8642.86122.77121.28 ST-SPCNN7777100.00100.000.000.0095.2893.32 MT-SPCNN677785.71100.0014.290.0095.4596.01 16:00NSCT446666.6766.6733.3333.3352.7352.95 ImNSCT446666.6766.6733.3333.3353.8053.72 DWT446666.6766.6733.3333.331.041.03 SPCNN336650.0050.0050.0050.00122.34121.78 ST-SPCNN556683.3383.3316.6716.6796.0393.50 MT-SPCNN556683.3383.3316.6716.6795.9495.83 弱光Sunlight with weak18:20NSCT445580.0080.0020.0020.0052.9753.35 ImNSCT435580.0060.0020.0040.0053.7653.82 DWT445580.0080.0020.0020.001.021.02 SPCNN335560.0060.0040.0040.00121.02115.18 ST-SPCNN5455100.0080.000.0020.0093.9494.12 MT-SPCNN5455100.0080.000.0020.0094.0193.64 19:00NSCT557771.4371.4328.5728.5752.7752.68 ImNSCT557771.4371.4328.5728.5753.6353.66 DWT557771.4371.4328.5728.571.041.01 SPCNN457757.1471.4342.8628.57116.84122.94 ST-SPCNN677785.71100.0014.290.0093.3496.81 MT-SPCNN677785.71100.0014.290.0096.7495.14

表4 6种融合模型融合质量评价指标比较 Table 4 Comparison of fusion quality evaluation indicators of six fusion models 指标IndexNSCTImNSCTDWTSPCNNST-SPCNNMT-SPCNN 强度+可见光图像置信+可见光图像强度+可见光图像置信+可见光图像强度+可见光图像置信+可见光图像强度+可见光图像置信+可见光图像强度+可见光图像置信+可见光图像强度+可见光图像置信+可见光图像 AG10.109.2911.026.547.698.139.8011.5112.0311.6611.9611.92 CC(ToF)0.480.490.580.720.660.650.180.040.500.850.820.81 CC(RGB)0.840.750.750.500.750.650.840.950.720.200.420.24 CE1.922.610.683.060.791.990.902.340.492.830.382.66 E6.726.506.876.226.836.756.767.107.107.027.307.06 MI(ToF)0.370.340.470.600.590.560.910.660.401.000.930.91 MI(RGB)1.340.990.950.491.291.443.665.731.140.360.570.33 SF20.2719.6720.6114.7515.3617.0819.9922.0622.8623.4522.6723.80

注:AG代表融合图像平均梯度;CC(ToF)代表ToF图像与融合图像之间的相关系数;CC(RGB)代表RGB图像与融合图像之间的相关系数;CE代表ToF图像、RGB图像与融合图像之间的总交叉熵;E代表融合图像的熵;MI(ToF)代表ToF图像与融合图像之间的互信息;MI(RGB)代表RGB图像与融合图像之间的互信息;SF代表融合图像的空间频率。其中CE值越小代表融合图像质量越好,其他评价指标值越大代表融合图像质量越好。

Note: AG represents the average gradient of the fused image; CC(ToF) represents the correlation coefficient between ToF image and fused image; CC(RGB) represents the correlation coefficient between RGB image and fused image; CE represents the total cross entropy between ToF image, RGB image and fused image; E represents the entropy of the fused image; MI(TOF) represents the mutual information between the ToF image and the fused image, MI(RGB) represents the mutual information between the RGB image and the fused image; SF represents the spatial frequency of the fused image. Among them, the smaller CE value means the better quality of the fused image, and the larger the value of other evaluation indicators means the better quality of the fused image.

模型复杂度比较见表5所示。ST-SPCNN及MT-SPCNN模型在时间复杂度上比其他模型分别多出单目标参数寻优时间O(maxCycle×NP×limit+ maxCycle×NP)和多目标参数寻优时间O(maxCycle×(NP×limit×Rep×Rep+ Rep×Target×nGrid+Rep×Rep×Target+NP×Target))。空间复杂度比其他模型分别多出参数寻优存储空间O(NP×d)和O(NP×d×Target+Rep×d×Target+Target×nGrid)。实例分析可知,本文模型时间复杂度比NSCT模型多一个数量级,比SPCNN模型低一个数量级,在空间复杂度上与之对等不变。

表5 6种融合模型复杂度比较 Table 5 Complexity comparison of six fusion models 模型Model时间复杂度Time complexity时间复杂度实例Time complexity instance空间复杂度Spatial complexity空间复杂度实例Spatial complexity instance NSCTO(M·N+nsc·2q)307 224O(M·N+nsc·2q)307 224 ImNSCTO(M2·N2+nsc·2q·M·N)94 379 212 800O(M·N+nsc·2q)307 224 DWTO(M·N)307 200O(M·N)307 200 SPCNNO(n·n+iteration·M·N)15 360 025O(M·N)307 200 ST-SPCNNO(maxCycle·NP·limit+maxCycle·NP+n·n+iteration·M·N)1 843 285O(NP·d+M·N)307 212 MT-SPCNNO(maxCycle·(NP·limit·Rep·Rep+Rep·Target·nGrid+Rep·Rep·Target+NP·Target+n·n+iteration·M·N)1 872 085O(NP·d·Target+Rep·d·Target+Target·nGrid+M·N)307 596

注:nsc代表NSCT分解级数;q代表NSCT分解方向数;M、N代表输入高低频子带图像的长度和宽度;iteration代表点火次数;n代表链接系数Wij,kl与周围相邻神经元(k,l)的神经元个数;NP代表食物源信息;d代表空间维度;maxCycle代表ABC算法最大迭代次数;limit代表食物源的停滞最大次数;Rep表示非支配解的数量;nGrid表示划分的网格的数量,Target表示目标函数的数量。试验中,nsc=3,q=3,M =640,N=480,iteration=50(SPCNN),iteration=6(本文模型),n=5,NP=3,d=4,maxCycle=5,limit=3,Rep=20,nGrid=7,Target=4。

Note: nscrepresents the number of NSCT decomposition levels; q represents the number of NSCT decomposition directions; M and N represents the length and width of the input high and low frequency subband image; iteration represents the number of ignition; n represents the number of neurons between the link coefficient Wij,kl and the surrounding adjacent neurons (k,l); NP stands for food source information; d represents the spatial dimension; maxCycle represents the maximum number of iterations of ABC algorithm; limit represents the maximum number of stagnation of food sources; Rep represents the number of nondominated solutions; nGrid represents the number of divided grids; Targetrepresents the number of objective functions. In the experiment, nsc=3, q=3, M =640, N=480, iteration=50(SPCNN) , iteration=6(proposed model in this paper), n=5, NP=3, d=4, maxCycle=5, limit=3, Rep=20, nGrid=7, Target=4.

3 结 论

本文提出一种多尺度分解双寻优策略简化脉冲耦合神经网络的飞行时间与可见光果园苹果图像融合模型。模型通过双分支融合策略,分别利用多尺度分解单目标简化脉冲耦合神经网络融合模型、多尺度分解多目标简化脉冲耦合神经网络融合模型进行融合。

贾承造:全球天然气贸易非常活跃。2017年,全球天然气贸易量为1.13万亿立方米,与2016年同比增长5.9%。国际上LNG贸易空前活跃及参与LNG国际贸易的国家明显增多,亚太地区是主要的输入国。2017年上半年,国际LNG供应相对宽松,下半年受我国“煤改气”、韩国弃核弃煤等能源政策的影响,LNG需求超过预期,快速增长,国际天然气市场出现了时段性的供需紧张。同时,国际油价上涨还导致了天然气价格的整体上涨。但从中长期来看,全世界天然气市场仍是总体供大于求的态势,使天然气价格不会出现暴涨暴跌。

1)提出的多尺度分解单目标简化脉冲耦合神经网络融合模型以及多尺度分解多目标简化脉冲耦合神经网络融合模型具有自适应点火机制,在点火分割迭代次数满足双寻优策略目标函数条件时,停止迭代,加快了简化脉冲耦合神经网络模型点火分割的速度。同时,相较于简化脉冲耦合神经网络模型固定较大迭代次数,模型自适应点火次数较低,在3~7次左右,点火图果实分割清晰、无空洞、无过分割。

2)多尺度分解的飞行时间与可见光异源图像融合模型动态优化简化脉冲耦合神经网络模型参数,具有自适应迭代次数,使得改进后简化脉冲耦合神经网络模型点火次数大大减少,提高了效率,在点火几次的情况下就可以达到快速自适应分割,提高了融合效率。中光15:00时段点火识别成功率达到了100.00%,点火分割时间达到最低91.91 s。

3)与其他融合模型相比,本文提出的融合模型各时段识别成功率均达到80.00%以上。其中强光12:00、中光15:00、弱光18:20、19:00时段融合图像识别成功率达到100.00%;融合时间低于简化脉冲耦合神经网络模型,达到最低92.68 s。提出模型在弱光18:20时段平均梯度值为12.03、相关系数(飞行时间)值为0.85、互信息(飞行时间)值为1.00、熵值为7.30、空间频率值为23.80,融合指标值均为最大,总交叉熵值为0.38,值最小。模型时空复杂度与简化脉冲耦合神经网络模型相差不大。

本文提出的融合模型在多尺度分解单目标简化脉冲耦合神经网络融合模型的优化策略、多尺度分解多目标简化脉冲耦合神经网络融合模型的帕雷托最优解集的构造方法、以及融合策略上均可进一步深入研究,优化策略尚存在寻找全局最优食物源的冗余操作,增加了一定的时间复杂度,此外,本文模型在强光照条件下融合指标表现不佳,在今后的研究中,可以融合别的群体智能优化算法思想进行改进和提升,对强光照条件下的融合质量有待进一步提升。此外,今后还将利用深度学习方法对果园场景异源图像融合模型进一步研究和探索,以提高图像融合的实时性和批量性。

[参 考 文 献]

[1] 贾伟宽,赵德安,刘晓洋,等. 机器人采摘苹果果实的K-means和GA-RBF-LMS神经网络识别[J]. 农业工程学报,2015,31(18):175-183.

Jia Weikuan, Zhao De’an, Liu Xiaoyang, et al. Apple recognition based on K-means and GA-RBF-LMS neural network applicated in harvesting robot[J]. Transactions of the Chinese Society of Agricultural Engineering (Transactions of the CSAE), 2015, 31(18): 175-183. (in Chinese with English abstract)

[2] Cheng B, Jin L, Li G. Infrared and visual image fusion using LNSST and an adaptive dual-channel PCNN with triple-linking strength[J]. Neurocomputing, 2018, 310: 135-147.

[3] Wang X, Lin T, Jiang X, et al. Reliable fusion of ToF and stereo data based on joint depth filter[J]. Journal of Visual Communication and Image Representation, 2021, 74: 103006.

[4] 杨勇,刘家祥,黄淑英,等. 卷积自编码融合网络的红外可见光图像融合[J]. 小型微型计算机系统,2019,40(12):2673-2680.

Yang Yong, Liu Jiaxiang, Huang Shuying, et al. Convolutional auto-encoding fusion network for infrared and visible image fusion[J]. Journal of Chinese Computer Systems, 2019, 40(12): 2673-2680. (in Chinese with English abstract)

[5] 任恒乐,徐方,邸霈,等. 基于深度相机的移动机器人自主跟随技术[J]. 计算机工程与设计,2020,41(2):562-566.

Ren Hengle, Xu Fang, Di Pei, et al. Autonomous following technology of mobile robot based on depth camera[J]. Computer Engineering and Design, 2020, 41(2): 562-566. (in Chinese with English abstract)

[6] Panigrahy C, Seal A, Mahato N K. MRI and SPECT image fusion using a weighted parameter adaptive dual channel PCNN[J]. IEEE Signal Processing Letters, 2020, 27: 690-694.

[7] Okorie A, Makrogiannis S. Region-based image registration for remote sensing imagery[J]. Computer Vision and Image Understanding, 2019, 189: 102825.

[8] Da C A L, Zhou J P, Do M N. The nonsubsampled contourlet transform: theory, design, and applications[J]. IEEE Transactions on Image Processing, 2006, 15(10): 3089-3101.

[9] Thierry R, Lucien W. The wavelet transform for the analysis of remotely sensed images[J].International Journal of Remote Sensing, 1993, 14(3): 615-619.

[10] Chao R, Zhang K, Li Y. An image fusion algorithm using wavelet transform[J]. Acta Electronica Sinica, 2004, 5: 750-753.

[11] Shah V P, Younan N H, King R L. An efficient pan-sharpening method via a combined adaptive PCA approach and contourlets[J]. IEEE Transactions on Geoscience & Remote Sensing, 2008, 46(5): 1323-1335.

[12] Zhang J, Ma W, Wu Y, et al. Multimodal remote sensing image registration based on image transfer and local features[J]. IEEE Geoscience and Remote Sensing Letters, 2019, 16(8): 1210-1214.

[13] Yu L, Xun C, Hu P, et al. Multi-focus image fusion with a deep convolutional neural network[J].Information Fusion, 2017, 36: 191-207.

[14] Tang F, Liang S, Zhong T, et al. Postoperative glioma segmentation in CT image using deep feature fusion model guided by multi-sequence MRIs[J]. European Radiology, 2020, 30(7): 823-832.

[15] Ying Z, Xiaoqun Z. Variational bimodal image fusion with data-driven tight frame[J]. Information Fusion, 2020, 55: 164-172.

[16] 杨风暴,董安冉,张雷,等. DWT、NSCT和改进PCA协同组合红外偏振图像融合[J]. 红外技术,2017,39(3):201-208.

Yang Fengbao, Dong Anran, Zhang Lei, et al. Infrared polarization image fusion using the synergistic combination of DWT, NSCT and improved PCA[J]. Infrared Technology, 2017, 39(3): 201-208. (in Chinese with English abstract)

[17] Feng B Y , Anran D , Lei Z , et al. Infrared polarization image fusion based on combination of NSST and improved PCA[J]. Journal of Measurement Science and Instrument, 2016, 7(2): 176-184.

[18] Yang Z, Ma Y, Lian J, et al. Saliency motivated improved simplified PCNN model for object segmentation[J]. Neurocomputing, 2018, 275: 2179-2190.

[19] 王佺,聂仁灿,周冬明,等. 多目标粒子群优化PCNN参数的图像融合算法[J]. 中国图象图形学报,2016,21(10):1298-1306.

Wang Quan, Nie Rencan, Zhou Dongming, et al. Image fusion algorithm using PCNN model parameters of multi-objective particle swarm optimization[J]. Journal of Image and Graphics, 2016, 21(10): 1295-1306. (in Chinese with English abstract)

[20] Zhu M, Chen C, Wu X. Infrared and visible image fusion using improved QPSO-PCNN algorithm [C]//2018 8th International Conference on Electronics Information and Emergency Communication (ICEIEC). Beijing: IEEE, 2018: 52-58.

[21] Wang X, Li Z, Kang H, et al. Medical image segmentation using PCNN based on multi-feature grey wolf optimizer bionic algorithm [J]. Journal of Bionic Engineering, 2021, 18(3): 711-720.

[22] Huang C, Tian G, Lan Y, et al. A new pulse coupled neural network (PCNN) for brain medical image fusion empowered by shuffled frog leaping algorithm[J]. Frontiers in neuroscience, 2019, 13: 210.

[23] Dharini S, Jain S. A novel metaheuristic optimal feature selection framework for object detection with improved detection accuracy based on pulse-coupled neural network[J]. Soft Computing, 2021: 1-13.

[24] Karaboga D. An idea based on honey bee swarm for numerical optimization[R]. Kayseri: Erciyes University, 2005.

[25] Zhang Z. A flexible new technique for camera calibration[R]. Washington State: Microsoft Research, 1998.

[26] Lowe D G. Distinctive image features from scale-inavariant keypoints[J]. International Journal of Computer Vision, 2004, 60(2): 91-110.

[27] Leng C, Zhang H, Li B, et al. Local feature descriptor for image matching: A survey[J]. IEEE Access. 2018, 7: 6424-6434.

[28] Deb K. Multi-objective Optimization Using Evolutionary Algorithms[M]. Chichester: John Wiley & Sons, 2001.

[29] Zhang J L, Zhao E. Fusion method for infrared and visible light images based on NSCT[J]. Laser & Infrared, 2013, 43(3): 320-323.

[30] 杨艳春,李娇,王阳萍. 图像融合质量评价方法研究综述[J]. 计算机科学与探索,2018,12(7):1021-1035.

Yang Yanchun, Li Jiao, Wang Yangping. Review of image fusion quality evaluation methods[J]. Journal of Frontiers of Computer Science and Technology, 2018, 12(7): 1021-1035. (in Chinese with English abstract)

[31] Temer A M. Basler ToF camera user’s manual[EB/OL]. (2018-04-09)[2022-02-17]. https://www.baslerweb.com/cn/sales- support/downloads/document-downloads/basler-tof-camera- users-manual/.

Heterologous image fusion with multi-scale decomposition and dual optimization SPCNN in an apple orchard

Liu Liqun1, Gu Renyuan1, Zhou Yubo1,Huo Jiuyuan2

(1. College of Information Science and Technology, Gansu Agricultural University, Lanzhou 730070, China; 2.School of Electronic and Information Engineering, Lanzhou Jiaotong University, Lanzhou 730070, China)

Abstract: Heterologous image fusion has been widely used to integrate multiple images into one. The fused imagesalso present a higher definition, more significant edge intensity, and more information than the source image. There are different characteristics of image data collected by the various types of sensors. Among them, the depth sensor imaging used the Time of Flight (ToF) to realizethe distance calculation using the ToF near-infrared light. The beneficial supplement has been commonly used for the visible light camera.The broad application can also be expected in the agriculture, medical treatment, quality inspection, and vision fields. However, the image acquisition of a single natural scene cannot fully meet the requirements forrapid and accurate identification of the fruits and positioning targets.The image fusion can be extended to the heterologous vision system using multi-objective optimization, particularly in the field of natural scenes. In this study, a multi-scale decomposition and dual optimization strategy was proposed to simplify the ToF and visible-light image fusion in an apple orchardusing the Simplified Pulse Coupled Neural Network (SPCNN). A double strategy with parameter optimization was introduced into the SPCNN model for the fusion of Nonsubsampled Contourlet Transform (NSCT). The model included the registration module, coding area, multi-scale decomposition module, single target SPCNN fusion model, multi-target SPCNN fusion model, and decoding area. The heterologous vision system was also used to accurately register the ToF and visible light images. Four parameters of SPCNN model were encoded, including the link channel feedback term, link strength, dynamic threshold attenuation factor, and dynamic threshold amplification factor. The NSCT was used to decompose the image at multiple scales. The fusion rules in the SPCNN model were adopted with the improved artificial bee colony algorithmand double optimization, including the single- and multi-objective parameter optimization. Each binary vector was converted into the real parameters using the decoding area.The objective function of the double optimization was used as the iteration termination of the SPCNN model. Finally, the heterogeneous image fusion was implemented after the multi-scale inverse transformation. There was improved parameter optimization and iteration times of SPCNN model. The adaptive ignition times of the model were relatively low (about 3-7 times),indicating low ignition times, adaptive segmentation, and high efficiency. The success rate of ignition recognition reached 100.00%, and the minimum duration of ignition division reached 91.91 s at 15:00. Specifically, the success rate of fusion image recognition also reached 100.00% under different periods, including strong,medium, and weak light at 12:00, 15:00, 18:20, and 19:00, compared with the rest fusion models. The fusion time was much lower than that of SPCNN model, with a minimum of 92.68 s. The four fusion indexes were the largest in the weak light period of 18:20, including the average gradient, correlation coefficient, mutual information, entropy, and spatial frequency. The proposed model presented an excellent performance in accuracy, time-consuming, and model size. The finding can provide a supplement to the image hierarchical fusion.

Keywords: image recognition; models; Nonsubsampled Contourlet Transform; Simplified Pulse Coupled Neural Network; heterologous image fusion model; single objective strategy; multi-objective strategy

doi:10.11975/j.issn.1002-6819.2022.17.017

中图分类号:TP301

文献标志码:A

文章编号:1002-6819(2022)-17-0158-10

刘立群,顾任远,周煜博,等. 多尺度分解双寻优策略SPCNN的果园苹果异源图像融合模型[J]. 农业工程学报,2022,38(17):158-167.doi:10.11975/j.issn.1002-6819.2022.17.017 http://www.tcsae.org

Liu Liqun, Gu Renyuan, Zhou Yubo, et al. Heterologous image fusion with multi-scale decomposition and dual optimization SPCNN in an apple orchard[J]. Transactions of the Chinese Society of Agricultural Engineering (Transactions of the CSAE), 2022, 38(17): 158-167. (in Chinese with English abstract) doi:10.11975/j.issn.1002-6819.2022.17.017 http://www.tcsae.org

收稿日期:2022-02-17

修订日期:2022-07-20

基金项目:甘肃农业大学青年导师基金资助项目(GAU-QDFC-2020-08);甘肃省科技计划项目(20JR5RA032)

作者简介:刘立群,副教授,研究方向为计算机技术在农业工程中的应用。Email:llqhjy@126.com。