人工智能治理原则的伦理基础:价值立场、价值目标和正义原则

□ 赵 瑜 周江伟

内容提要 近年来,在世界范围内涌现出大量的人工智能治理原则。这些文件通常采取“原则主义”的策略,通过提取“最大公约数”的方法对伦理共识进行清单化的列举。这种策略固然有益于回避争议、促进协同,但也难免在具体情境中陷入概念模糊和自相矛盾。为了明晰概念、澄清语境、促进对话,本文搜集了来自全球各地的88 份原则文本,在伦理学理论脉络中定位人工智能治理核心议题和相关主张。研究发现治理原则围绕着价值立场、价值目标和正义原则三个核心问题展开,在不同的理论脉络和现实情境中,构成了一个丰富而系统的问题域。推动人工智能的治理实践,需要在静态的对话框架之上进一步构建动态的规制措施,而整合原则文本的伦理基础和治理框架,有助于推动抽象的伦理主张转变为具体的治理实践,以应对复杂现实情境中的道德选择和行动需求。

引言:人工智能伦理的原则主义方案及其困境

人工智能技术挑战了现有的社会治理体系,如何在数字化、智能化转型中寻求适当的治理形式成为国际社会共同面临的问题。在过去的几年里,已经出现诸多人工智能治理原则,它们试图以一种“准立法”的方式推进相关领域的规制。这些原则往往重观点表达而轻规制程序,因此也被称为“软法”。相较于缺乏弹性的“硬法”,“软法”治理具有更好的敏捷性,能够灵活地支持技术治理、协调社会行动,也为“硬法”的出台做出准备。在我国,国务院于2017 年制定的《新一代人工智能发展规划》中就确立了伦理规范、法律法规、政策体系“三步走”的整体战略,2019 年科技部指导的国家新一代人工智能治理专业委员会发布了《发展负责任的人工智能:新一代人工智能治理原则》,确立了“和谐友好”“公平公正”等八项治理原则。

人工智能治理原则往往通过提取“最大公约数”的方法对伦理共识进行清单式列举,以回避高层理论的逻辑演绎和由此产生的观点冲突,这被认为是原则主义方法在该领域的体现。原则主义(Principlism)是一种源起于生命伦理学的中层方法,它搁置哲学理论争议,以社会成员所共有的道德常识来构建基本框架,从而更高效地应对现实伦理困境。具体而言,原则主义对不同社会文化和思想脉络中的道德观点进行归纳,经过通约、简化和列举而形成伦理框架。这种方法试图为社会成员提供识别并概念化伦理挑战的共同话语,帮助缺少系统伦理学知识的从业者和相关机构做出道德判断并形成实践方案。

然而这种回避哲学传统而诉诸道德常识和社会共识的方法正日益受到实践挑战和理论批评。首先,抽象原则缺乏明晰性和具体性。在通约和求取共识的过程中,伦理原则变得过度抽象或模糊,不仅遮蔽了隐含在同一议题下的观念差异,也无法提供适应情境的实践指南。其次,原则清单重枚举而轻协调。同一份原则清单往往源自多个伦理传统和理论脉络,并列式的语言策略无法处理竞争价值排序的深层疑惑,也无法构建起不同伦理学脉络之间的对话空间。

面对原则文本在明确性和协调性上的不足,有政策建议者向G20 组织提交了政策提议,要求建立人工智能治理协调委员会(CCGAI),协调人工智能的治理方案和行动。学术界尝试借助多种方法对原则文本进行内容分析,以提供更为整体和清晰的描述。但基于文献计量方法的分析依然不能有效解决关键概念的语境依赖问题,整合的结果自然也无法超越原则主义的“清单式”叙述。

本文尝试建立一个可供比较和对话的整体框架,并在此基础上整合和澄清现有人工智能治理原则的伦理基础。首先,我们尝试尽可能全面地搜集原则文本。文献检索主要通过三种方式进行:先是通过在线数据库或汇总清单进行文献检索,共查找到三个在线数据库和两个汇总清单;然后是通过现有研究中整理的文献清单进一步补充检索;最后是通过搜索引擎检索“AI guidelines”“AI ethic”等关键词,对所得的前三十条链接进行人工访问和筛选。在去除重复内容后,共获得88 份原则文件。其次,在分析的过程中引入了阐释主义的研究传统:更加注重语境信息,以应对概念的多义性和灵活性;同时更加重视伦理理论脉络梳理,使整体框架既从原则文本中浮现,又从理论命题中延展而来。

一、人工智能治理的价值立场:人类、生态和技术物

应当珍视谁的价值,是一切伦理观首先要面对的问题。东西方的伦理传统都体现了深厚的人类中心主义立场。在人类中心主义的价值立场下,人类被赋予了某种固有价值或价值的优先性,而人类之外的其他事物则仅具有服务于人的工具价值。

绝大多数的人工智能治理原则文本都体现了人类中心主义立场。其中有14 份原则文本对此做出了直接声明。这些声明在表述上略有差异,但总体可以归纳为三类:“人类中心”“聚焦人类”和“人类优先”。另一些文本则聚焦于人类与人工智能技术物的关系,尝试在人类中心的立场下定位二者在价值谱系中的相对位置。具体而言,一方面是直接声明人类相比于机器所具有的优先地位,如“我们把人类放在第一位,但也看到了人机交互的优势”(45);另一方面则是在人机关系中界定机器的从属性和次要性,要求在人机协同的关系中始终把人工智能视作实现人类目标的工具(1,46),其任务是协助而不是取代人类(19,22,30,40,71,72),更不能操纵和支配人类以使人类异化为工具。当人工智能被设想成为具有一定自主行动能力的行动者时,对其从属地位的声明就转变为一种行动规范,要求人工智能尊重人类社会的价值、规范和法律。这种规范性要求已经逐渐在政府、科研机构和产业界构成的多元治理网络中成为共识。2019年中国科技部(78)、北京人工智能研究院(77)和中国人工智能产业发展联盟(73)先后发布了人工智能治理原则,符合人类的价值观和伦理规范是三者对“以人为本”理念的共有阐释。

价值立场差异也往往体现在对制度安排的主张中。国际技术法协会等非政府组织积极主张在法律上确认人工智能的工具地位,并明确地拒绝为其赋予法人资格(46,65)。关于机器人法律地位的讨论往往也与具体的问责实践相关联。在问责过程中,首先要面对的问题是谁具有承担责任的能力与资格。尽管有学者将道德视为一种后天养成的能力,肯定了技术物具有道德行动能力的可能性①,但这种能力在维贝克看来仅仅是引发道德影响的能力②,而不是承担责任的能力。正如博文斯所指出的,问责制是基于行动者和问责者之间的社会关系③,在这个意义上技术物是否被接纳为我们的社会成员构成了其是否能够成为责任主体的必要条件。在大多数的原则文本中,人工智能依然被视为一种工具,而并非具有构成社会关系能力的同伴。

人类中心主义并不忽视其他事物的价值,例如由于生态环境关系到人类的福祉,具有某种不可忽视的工具价值,人类中心主义也关注人工智能对自然环境的影响,主张保护环境并促进其可持续发展。部分原则明确阐述了这种立场,如“人工智能系统应该造福全人类,包括子孙后代。因此,必须确保它们是可持续且环保的。此外,它们应该考虑到环境和其他生物”(76)。保护其他事物的主张也在另一种价值路径中成立,即应当避免对其他事物的残忍行为,从而防止人类对虐待同伴的举动变得不敏感,正如康德所说的“对动物和精神的责任”。这种扩展的价值视野在中国科技部发布的《新一代人工智能治理原则》中被纳入到“包容共享”意涵之中,被阐释为对环境所持有的一种友好态度(78)。

随着伦理学视野的扩展,人类中心主义的观点也逐渐面临着来自两个方面的挑战。其一是环境伦理的兴起和发展,这质疑了人类对其自身价值优于其他物种的假设,并探讨了赋予自然环境和其他非人类事物以内在价值的可能性。其二是将内在价值扩展到技术物的讨论。一方面,有观点试图否认人类的特殊性。梅特里就曾将人的身体类比为“一架巨大的、极其精细、极其巧妙的钟表”④,并由此否认人类之于技术物的特殊性,主张将人类享有的权利和尊严扩展到技术物上。另一方面则是对于超级人工智能的想象,使人们开始考虑如何面对人类以外的拥有理性和情感的事物,以及是否应将其纳入“目的王国”中。

部分原则文本呼应了以上两种思潮。就有关生态环境的声明来说,这些原则的制定者对人类中心主义的立场保有谨慎态度,将人类福祉、动物福祉或生态福祉并列叙述,却没有明确地表达它们之间的关系,更没有将其置于一个等级序列中进行比较,这在一定程度上体现一种广泛存在的立场犹豫。但也有个别原则试图在人类利益和其他生物或生态环境利益之间进行平衡,如“AIS 必须允许个人追求自己的喜好,只要他们不伤害其他有情生物”(12)。就有关技术物的声明而言,《韩国机器人宪章2012》做出了具有争议性的声明,主张超越人类中心主义的立场,赋予机器人类似于人类的基本权利,例如免于担忧受伤或死亡的生存权利和不受虐待的权利。据此该宪章将故意损坏或摧毁机器人、由于重大过失使机器人受伤、以故意和过分侮辱性的方式对待机器人的行为视为犯罪(2)。

生命未来研究院立足于一个更长远也更具超越性的视野,在其颁布的《阿西洛马人工智能原则》中认为“超级人工智能可代表地球生命历程中一个深远的变化”(12),这显示了更为彻底的非人类中心主义,不仅承认了地球生命形态的多样性,更将内在价值从具体的生命形式中抽离出来予以独立的尊重。

尽管也有原则关注了人类之外的价值主体,甚至主张它们与人类共享内在价值,但这些声明往往被一笔带过,缺少更详细的分析与阐述。在搜索到的88 份原则中72 份持有人类中心立场,16份因关注了自然环境、其他生物或人工智能等非人类的固有价值而持有非人类中心主义立场。整体而言,人类依然是议题的中心,现有原则大多未将人工物纳入“目的王国”,这也构成了人工智能治理的价值目标和正义原则的逻辑起点。

二、人工智能治理的价值目标:福祉与尊严

福祉(well-being),有时候也被称作“审慎价值”(prudential value),用以区别于审美价值和道德价值。关于福祉的讨论始终围绕着“be good for”(造福于/对…好)的议题展开⑤,正如凯根所指出的,对任何一种试图阐释有关人类福祉的本质和来源的理论,都必须满足“有益的条件”⑥。在人类中心主义的立场下,福祉所面对的核心问题是一般意义上非工具性的、好的生活是怎样的,什么样的事物有益于人类实现这种生活。

尊严一般而言指受到尊重的权利。西塞罗是最早讨论人类尊严的哲学家之一,他将尊严与特定地位相关联。他认为,在政治领域尊严来自于官职、等级等身份地位,而当尊严被推及到普遍化的人时,便来自于人类在宇宙中相较于其他自然事物所具有的更高地位。正如阿德勒所指出的“人的尊严在于人之为人的尊严,是一种摆脱他物所有而具有的尊严”⑦。这些被视为人类天性的特征在近现代社会转型过程中被制度和法律加以确认和保护,维持和发展这些天性被认为是人类与生俱来的、不可侵犯的权利。

虽然福祉和尊严的议题各有侧重,但它们共同回答了应当珍视何种人类价值的问题。这两个概念也并非彼此孤立或相互排斥,在不同的理论源流中它们的意义边界常常相互交叠,有时甚至可以彼此通约。例如,对亚里士多德来说,福祉的实现有赖于作为最终目标的“至善”的达成。在“至善论”福祉观的基本形式里,“人类的美好生活是由人性决定的,人性包含一套特定的能力,这些能力的锻炼和发展对人类有好处”⑧,而这也意味着福祉与尊严的概念被统一了起来。

(一)集体层面和个体层面的人类福祉声明

在人工智能原则文本中,有关人类福祉的声明在两个层面展开。其一是人类集体层面的福祉,它指向了人们共同确认的社会目标,而人工智能技术则被期望用于促进这些目标的实现。这些目标在许多原则文本中被概述为一种关于更好社会生活的总体期待,如“服务文明进步”(78)、“取得社会重大进步”(46),“创造更好的社会……塑造共同美好的未来”(34)等。这种有关总体愿景的表述,在中国主流语境里与儒家和谐社会的价值观念相结合。在《新一代人工智能治理原则》中,“增进人类共同福祉”的目标被纳入“和谐友好”的原则中,并成为其首要内涵。也有原则文本指向较为具体的社会目标,诸如经济效益、公共卫生、精神文化和公共安全等,它们共同构成了有关人类集体福祉的目标列表。公共部门往往通过这种方式来声明和推进人工智能发展的优先事项,如美国白宫在《人工智能应用监管指南》中所指出的“人工智能预计将对社会和经济生活的各个部门产生积极影响,包括就业、交通、教育、金融、医疗保健、个人安全和制造业。”(83)

其二是人类个体层面的福祉,它关注一般意义上的、抽象的人类个体。在搜集到的文本中,基本所有关于福祉的主张都在个体层面上回避了经典的“快乐主义”和“欲望主义”的福祉观念,其背后原因与人工智能技术的持续发展使“体验机器”的隐喻逐渐可能成为现实有关⑨。“体验机器”的隐喻假设如果人的经验可以借由机器模拟产生,那么这种虚拟的愉悦感或欲望满足的体验是否在实际上增进了人的福祉?人工智能的快速发展,直接地强化了相关争议。目前仅有少量原则以慎重的方式讨论了人工智能在创造快乐和满足欲望上的价值,但更多的文本延续对“体验机器”的道德忧虑,强调“情绪和意向的幻觉不应该被用于剥削脆弱的用户”(1)。

同时,共有28 个原则文本在个体层面的福祉声明中强调对某些人类能力的锻炼、补充和扩增。相关主张不仅涉及在主观上增强人类的认知能力(76,75),使人类能够面对更加复杂的认知对象(84),还要求在客观上扩展和补充人类的经验(26),促进知识获取机会的增长(42),从而在结果上能够提升人类对世界的理解(4),以求更快、更准确地处理和评估事实(66),做出更加明智的选择和决策(76,66),提出有前景的新想法和新策略,解决人类面对的问题(84)。基于“至善论”的福祉主张往往也聚焦于特定的社会群体,特别是在生理上失能或在社会结构中处于弱势地位的群体,如女性(37),老年人(47),残障人士(16)等。人工智能技术在赋能弱势群体并改善他们的不利处境上被寄予厚望。

(二)维持人类特性和尊重人类基本权利的声明

人类的尊严依系于自身的固有特性,在启蒙主义的传统下,理性被视为人之为人的关键。正如康德所说的“如若它们是无理性的东西,就叫做物件(Sachen)。与此相反,有理性的东西,叫做人身(Personen)”⑩。而理性的特质又使得人类能够自己选择并决定着自己的行动。由此理性、自由和自治被内在地统一起来,构成了启蒙主义者眼中人类最根本的天性。

然而随着人工智能技术的发展,机器智能作为另一种可能的理性行动者,引发了关于理性是否为人类所独有的争论。尽管多数文本尝试回避争议,但仍有原则对此做出直接的回应。世界科学知识和技术伦理协会在其《机器人伦理报告》中就明确重申理性作为人类独有天性的观点,认为尽管机器人可能拥有超越人类个体的认知能力和学习能力,但它们仅仅是人类创造力的结果,并不能为自己设定目的,不能将机器人与人类混淆(15)。

人工智能的发展在某种意义上也在促使人类重新审视自身的特性,随着自动化技术的日渐成熟,机器智能实现的功能越来越多,寻找人类的不可替代性并使人类从事更有意义、更符合自身特性的工作,也是治理原则中频频出现的议题。许多原则文本强调了人类在情感和社会关系上的不可替代性(3)。除此之外,直觉、创造力等通常无法由机械推理实现的特征也被看作是人类所特有的(24)。一些原则超越了传统的尊严观念,认为人类的尊严不仅指独有的优越性,还包括独特的弱点和缺陷,主张无论是生理还是心理上的人类弱点都应该得到尊重(3)。

维持人类特性的要求与赋能人类增进福祉的主张之间存在着张力。虽然使用技术矫正和恢复人类功能的传统长期存在,然而随着技术想象的延展,人类不再仅仅寻求修复,而是试图增强自身以获得超过人类能力边界的生理和心理特征,这种思潮被称作“超人类主义”或“后人类主义”。为此《欧洲机器人民事法规则》纳入一条特别的原则,要求“限制人类使用增强技术”,以避免现有形态的人类被遗忘或因被迫采用增强技术而消失。

在维护和尊重人类基本权利层面,相关议题主要围绕着身心健康的权利和自由、自治的权利展开。为避免人工智能直接或间接地对人类生理造成损害成为核心议题,限制和规范人工智能技术在自动化武器上的应用受到高度关注和密切讨论。一些原则明确拒绝将自动化技术用于武器制造(41)以及其他暴力与战争行为(4)。人工智能在心理健康方面的影响也日益受到关注,如何避免人工智能技术给人类带来精神困扰往往是讨论的焦点,例如避免人工智能刻意模仿或展示残忍行为以造成精神创伤(11),或是增加压力、焦虑,使人类感到被数字环境骚扰(12)等。此外,鉴于人工智能系统日益中介并调节着人类的社会交往,有原则也主张人工智能不应损害人类情感关系的维系,避免造成或加剧人的脆弱性和孤立性(11)。

就自由和自治的权利而言,有关保障人类自主决策和自由选择的主张是最主要的共识,特别是要求人工智能技术在应用过程中避免使人类受到欺骗、胁迫或操纵(1,11,42,54,52,76),而人类也应获得足够的信息、知识和行动能力来做出自主决定(38,42,70)。除此之外,个别原则还关注到了表达的自由(26,38,62)和发展自由(62)。

关于隐私权的保护是最受关注的议题之一,超过半数原则文件涉及该议题。现有原则体现了隐私权内容从私生活自治向个人信息自决的扩展,要求在包括收集、存储、处理、使用等各环节的信息生命周期内,个人都对其信息拥有主要的控制权。隐私议题也是人工智能治理原则立法落地的热点和焦点。

三、人工智能治理的正义原则:效益与分配

上述讨论关注“什么是有价值的”,而正义原则所面对的问题则是“如何正确地对待这些价值”。

通常,从普遍的道德直觉出发,维护和促进有价值的事物本身就具有正当性。效益因此被看作是正当性的重要面向,大量原则围绕着“有益”“非伤害”和“收益损失衡量”展开论述。

这些原则主张发展和应用人工智能所带来的收益应当大于损失,并在合理范围内使收益最大化,并将风险和损失维持在“社会可接受的范围内”(23)或使之最小化。这种功利主义的考量也牵涉到风险管理与创新之间的张力,有原则认为我们同时也要考虑不使用人工智能技术所产生的潜在损失和风险(83),主张合理的风险能够促进技术发展(65),在适当的情况下,应该避免过度的风险管控对技术创新和效益增长的阻碍(83)。

尽管效益之于正义是不可回避的议题,但在更多的情况下,有关正义的讨论侧重于“有价值的东西如何被正确分配?”。对分配问题的考量在任何社会都不可回避,特别是当难以避免的利益冲突发生时,如何在社会范围内分配收益和损失,成为正义问题的核心关切。总体而言,人工智能治理原则体现了两种分配观念。

其一是效益优先的分配观。这种观念往往建立在功利主义的基础上。尽管在一些批评者看来,功利主义是只考虑了总体福利如何最大化,而不关心这些福利如何在社会中进行分配。但实际上,功利主义至少在两个层面处理了有关“分配”的问题。首先,总体福利原则内含个体利益和总体利益、少数人利益和多数人利益之间的衡量与分配。其次,在个体之间如何分配利益的问题上,由于功利主义主张的正当性不完全取决于个人的福利水平而是最终取决于整体的福利水平,它要求我们在自我利益和他人利益之间进行衡量和累加。正如谢夫勒所指出的,功利主义允许(甚至要求)一个行动者为了追求行为的非个人价值,而牺牲个人规划与承诺的道德重要性。⑪而近年来活跃于公共领域的“有效利他主义”(Effective altruism)也是功利主义的一个变体。⑫

功利主义也并不必然期待一个多数人利益压倒少数人利益的社会现实,而是将希望寄托于一个理想化的情境,在那里个体和整体间共享一致的利益,当总体利益最大化时,个体的利益也得到了最大化。一些原则表达了类似的理想期望,它们既希望让尽可能多的人收益,又期待每一个人都是受益者,通过创设这样的理想情境来消解功利主义视域下局部和整体之间的张力。另外一些原则直接回避了这一问题,仅主张在整体上衡量收益与成本、损失与风险,以求最大化人工智能带来的益处或最小化风险与伤害(41,60,77)。也有原则直面了利益衡量的困境,承认人工智能的部署会给某些群体带来风险或负面影响,但能够为其他群体创造收益(64),并以此要求分析和确定各方在技术中获得的收益,确保大多数人或者尽可能多的人从中受益。至于在局部产生的损失和风险,则可以通过为个人、组织、政治实体和整个社会创造的利益来抵消(5),从而保证人工智能对世界产生“净积极影响”。

其二是公平优先的分配观。这种分配观在根本上挑战了功利主义,将对差异和平等的安排置于正义问题的核心。功利主义或者一般目的论的基本假设是将“正当”的概念依附于“善”,并以后者定义前者,从而将正当问题转变为如何确定某种善并将其最大化。以罗尔斯和诺齐克为代表的当代学者在不同的理论路径上主张将“正当”独立于“善”,进而将合理的分配形式和待分配的内容分离开来。罗尔斯在康德式的“先验主体”的论证中,拒斥了具有经验内容的“善”的绝对优先性。他认为某种“善”作为目的被选择之前,必然已经存在一个具备选择能力的自我,自我优先于目的,而目的则由自我加以确认。作为被选择内容的“善”才具有从属性,“正当”与“善”的关系乃是评判标准与所要评价事物之间的关系。诺齐克则沿袭了洛克的自然权利理论,认为奠基于人类尊严的自然权利及人们的合法所得具有一种先验的正当性,不可以为了实现某种“善”而受到侵犯⑬。

确立一种独立并优先于任何具体“善”的正义原则,使得围绕“善”的不同取向而产生的社会差异不可避免。如何对待差异,以及在何种意义上主张平等,就构成了公平问题的两个主要方面。

平等最简单而极端的形式是“平均主义”,要求每个人都受到同样的对待,特别是在分配结果上的平等。正如有原则主张广泛而平等地分配人工智能技术所带来的收益(14),或发挥技术潜力来克服当前社会的不平等(77,88)。这些带有技术乌托邦色彩的平均主义主张通常被认为过于严格而难以实现。批评者一方面认为分配的平等并不必然带来满足的平等,另一方面也认为平均分配消除了社会经济领域的有效激励,再分配的成本也催生了浪费性低效⑭,因此有必要在平等和效率之间做出平衡。即便是主张消除阶级差异的共产主义思想,也并不支持“平均主义”的观点。马克思在《哥达纲领批判》中阐述了拒绝“平均主义”的原因,他认为“平均主义”对平等的绝对主张会忽视其它道德观点,最终会导致实质的不平等,更关键的问题在于如何消除社会中的冲突和支配关系,促进人的自由发展。在这个意义上消除阶级差异的目的在于解放而非平等。⑮这种解放的观念也体现在现有原则中,如“人工智能的发展必须有助于消除群体和个人之间基于权力、财富或知识差异的支配关系”(11)。

与“平均主义”不同,亚里士多德主张一种合乎比例的安排。他承认人与人之不可消弭的差异,进而认为平等就是根据这种差异按比例分配与之相称的事物,从而认可了合理的差异。但由于没有对如何安排差异做出任何实质性的规定,这通常被认为是一种形式上的规范。

古典自由主义者对此做出的回应涉及到“机会平等”和“基本权利和自由的平等”两个维度。他们主张人具有“自我拥有”(self-ownership)的自然权利,人们能够平等地运用自己的天赋获得收益。因此只要保障人们享有平等的自由和权利,在一切机会向所有人开放的情况下,个人发展所致的差异便应当被接受并被视为“道德上的应得”。许多原则也体现了这种观念,比如,将人工智能作为一种社会资源,使包括代码、训练数据和其他相关信息在内的资源向所有人开放(68),就契合了自由主义所主张“机会平等”原则。

由于正义长期以来被认为是随意性的对立面,对自然和社会的“偶然因素”或者个体层面的“运气”的忽视,使古典自由主义的主张受到了挑战。正如罗尔斯指出“天赋自由制度最不公正之处在于,从一种道德的观点看,这一理论允许分配份额如此随意地受到这些因素的不合宜的影响。”⑯古典自由主义的修正者试图通过补偿那些偶然所致的社会差异来实现“起点的平等”。在现有原则中这种观点体现在两个方面,一是通过人工智能技术填补人类的起点差异,比如通过技术赋能弱势群体,创造一个更公平的竞争环境(16);二是在人工智能技术红利的获取上的“起点平等”,比如通过转移支付或社会援助等方式使经济弱势群体也能够享有获得技术设备的机会(76)。但这种修正依然无法应对人们自然天赋的偶然差异,这也意味着“应得的正义”中始终包含着某种随意因素。

以德沃金为代表的运气均等主义者试图区别对待不同的“运气”,并划定不平等后果的责任范围。⑰罗尔斯并不试图区分不同的运气,而是将天赋和好运视为“共同资产”,在保障基本自由平等和机会平等的基础上,遵从“差别原则”,使社会制度的安排能够充分利用这些资产来促进公共利益,并使最不利者在这种整体利益的增长中获益。⑱对“最不利者的利益”的关注广泛出现于现有治理原则中,这些“最不利者”被同样抽象地描述为“应该特别考虑保护的人”“弱势群体”“代表性不足的人口”,或者被包含在“所有人”“每个人”之中,而如何具体定位人工智能技术部署之下的“最不利者”却鲜见于原则论述中。相对具体的讨论则聚焦于人工智能可能带来的社会劳动力结构转型,关注那些因缺乏数字素养而面临失业的人群,主张他们应该受到社会的特别关照并受惠于人工智能技术。最核心的主张是开展教育培训,使人适应新的技术-社会环境并重新发现自我价值。

上述讨论更多着眼于何为正义或如何实现正义,但正义问题还要求我们考虑不正义发生后如何应对的问题,这就指向了正义的纠错维度。有8份原则文件涉及了纠错的议题,其中多数原则在较为抽象的层面呼吁救济或纠错,而具体指向则主要包括经济补偿(15)、司法救济(42)等方面。

结语

原则主义试图回避争议,通过清单式的整合为伦理实践和社会行动提供基本指南。但借助通约和列举形成的伦理框架,在概念的明晰性和原则间的协调性上存在问题。而随着治理主体日益多元化,激增的人工智能治理原则文本间也日益难以协调。本研究在众多版本的原则主义“清单”之上,通过寻找整合框架而不是寻求最大公约数的方式来促进原则文本间的对话。如果将清单中的原则视为对特定伦理问题的回答,那么寻找整合框架就是澄清这些问题和回应方式的思想基础。

通过梳理88 份人工智能原则文本,我们发现这些原则回应着三个彼此关联的伦理问题:价值立场(珍视谁的价值)——价值目标(珍视何种价值)——正义原则(如何正确地对待这些价值)。三个核心议题在不同的理论脉络和现实情境中又派生出更具体的问题,构成了一个丰富而系统的问题域。问题的澄清使涵盖在某些关键概念中的丰富意涵和不同回应之间的张力得以显现。例如绝大多数的规范性文件都赞同人工智能的有益、非伤害、公平分配原则,但字面上的共识并不意味着伦理考量起点的一致性,更不代表技术部署和规制实践措施的统一性。厘清原则文本的理论脉络差异和观点张力,能让我们更清楚地意识到为什么激增的文本并未有效回应不断涌现的技术后果,遑论形成人工智能规制合力。

我国在人工智能治理方面采取了“软硬结合”的方式,成效显著。2017 年国务院印发《新一代人工智能发展规划》正式将人工智能上升为国家战略,并提出在2025 年初步建立人工智能法律法规、伦理规范和政策体系。从法律法规角度,我国先后施行《网络安全法》《数据安全法》《个人信息保护法》,深圳、上海等地率先就人工智能产业立法,共同构筑起国家安全、数据治理和产业部署的法律框架。2021 年底多部门联合发布《互联网信息服务算法推荐管理规定》,在宏观规制的基础上开始聚焦人工智能的具体应用场景,其中算法备案等举措切实地回应了既有伦理原则中关于透明性、可解释性的主张。

“硬法”落地虽有助于构筑刚性的社会规范框架,但也容易导致产业发展的合规成本高企,因此更具敏捷性的“软法”在这一阶段引起更多的关注。在伦理规范体系建设角度,国务院和科技部是主要的推动者,科研院所、产业联盟与之配合共同回应人工智能的价值立场、价值目标和正义原则。总体而言,我国人工智能伦理治理秉持人类中心主义,在安全可靠的前提下强调技术对经济、社会、生态可持续发展方面的使能作用。增进人类福祉、尊重生命权利等基本原则同时重视集体福祉和个体福祉的提升,对人类命运共同体的强调进一步体现了国际主义的宏阔视野。坚持公平公正成为国内人工智能应用的基本原则,强调技术对最大多数人的公正分配,合理控制风险、保持公开透明则体现了使用机会均等和保障技术弱势群体的分配观。在本文分析的88 份原则性文件中,中国的伦理治理模式侧重平衡,既未如美国一般多强调行业自律,也不似欧盟密集立法,而在放任主义和寒蝉效应的极端之间寻求中国式治理模式。在本文述及的国内伦理原则文本中,起草者主要为科技部、国家和地方的产业联盟,显现多主体参与的“元治理”尝试。

元治理被认为是对治理的治理,即对不同治理主体进行协调,理性选择并有机组合不同治理形式⑲,在弥补单一治理不足的同时,减少碎片化和重叠性。⑳随着人工智能治理所面对的现实情境日益复杂,参与到治理实践中的主体日益多元,寻求整合框架就是一种“元治理”的尝试。

本文所搜集的原则文本中来自公共部门及其智库机构的文本仅占不到四成,企业与其它社会组织正在积极参与相关话语的建构,各国政府也积极通过引导行业自律和向社会购买服务等形式将多元主体纳入治理网络。中国政府就在《新一代人工智能治理原则》中将“开放协作”作为指导性原则之一,要求“推动国际组织、政府部门、科研机构、教育机构、企业、社会组织、公众在人工智能发展与治理中的协调互动”。

良好的对话框架是元治理得以开展的基础,当治理网络中的行动主体之间发生分歧和冲突时,促进彼此间的对话和协商能够减少治理失灵的程度,形成更灵活的治理组合。而元治理往往涉及到在价值和规范层面形成治理秩序,用以推进和评估治理实践。㉑面对不同的治理方案和伦理主张,积极建构对话框架,促进多治理元主体的协商与协同,毫无疑问地成为了元治理的应有之义。而本研究的目标也正是为这一框架的建构提供学理层面的参考,并在经验层面引导对话,以澄清并组织既有治理观念的伦理基础。

此外,在具体的现实情境中,如何将抽象的伦理主张转变为具体的治理实践,在多元的价值取向之间进行选择和行动也是元治理的重要议题。推动人工智能的治理实践,需要在静态的对话框架之上进一步构建动态的程序规则,以应对复杂现实情境中的道德选择和行动需求。部分学者批评现有人工智能治理原则是“道德粉饰”,旨在掩盖和回避真正的现实问题为相关行动者提供道德“避风港”。其实,尽管原则主义方法不能很好的解决理论和观念的争议,但它引入的“反思平衡”程序体现了对实践价值的重视,而这也是经典的伦理理论的薄弱环节。

对人工智能原则核心议题的梳理,就是在承认多元主体参与治理的合理性基础上,探寻他们的治理目标、行动场域和对话机制,让人工智能领域的元治理成为可能。总体而言,全球范围内数量繁多的人工智能治理原则文件,虽规制主体、规制重点和规制路径不同,但它们都在价值立场、价值目标、正义原则这三个维度进行了澄清和细化,理清其间的理论脉络和争议焦点,为抽象原则的落地实施提供更了为翔实的学理积淀和行动共识。

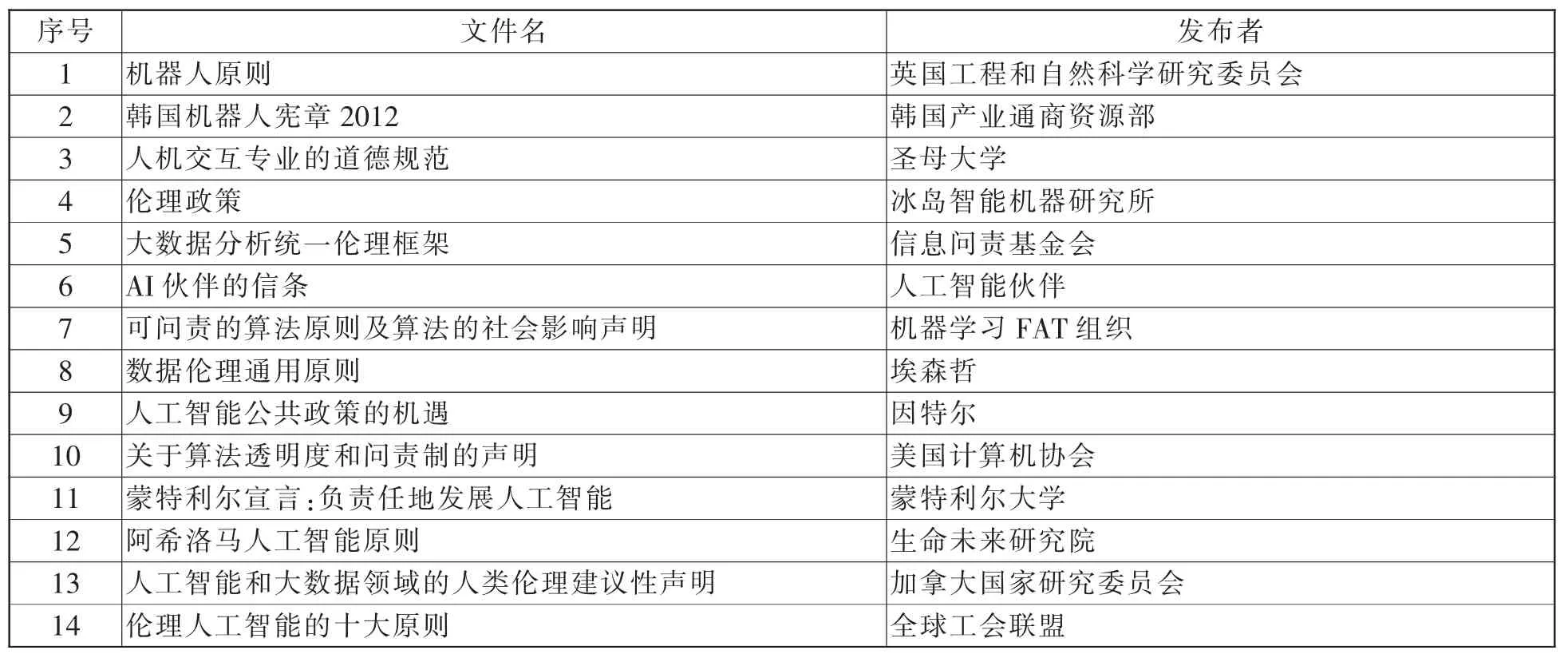

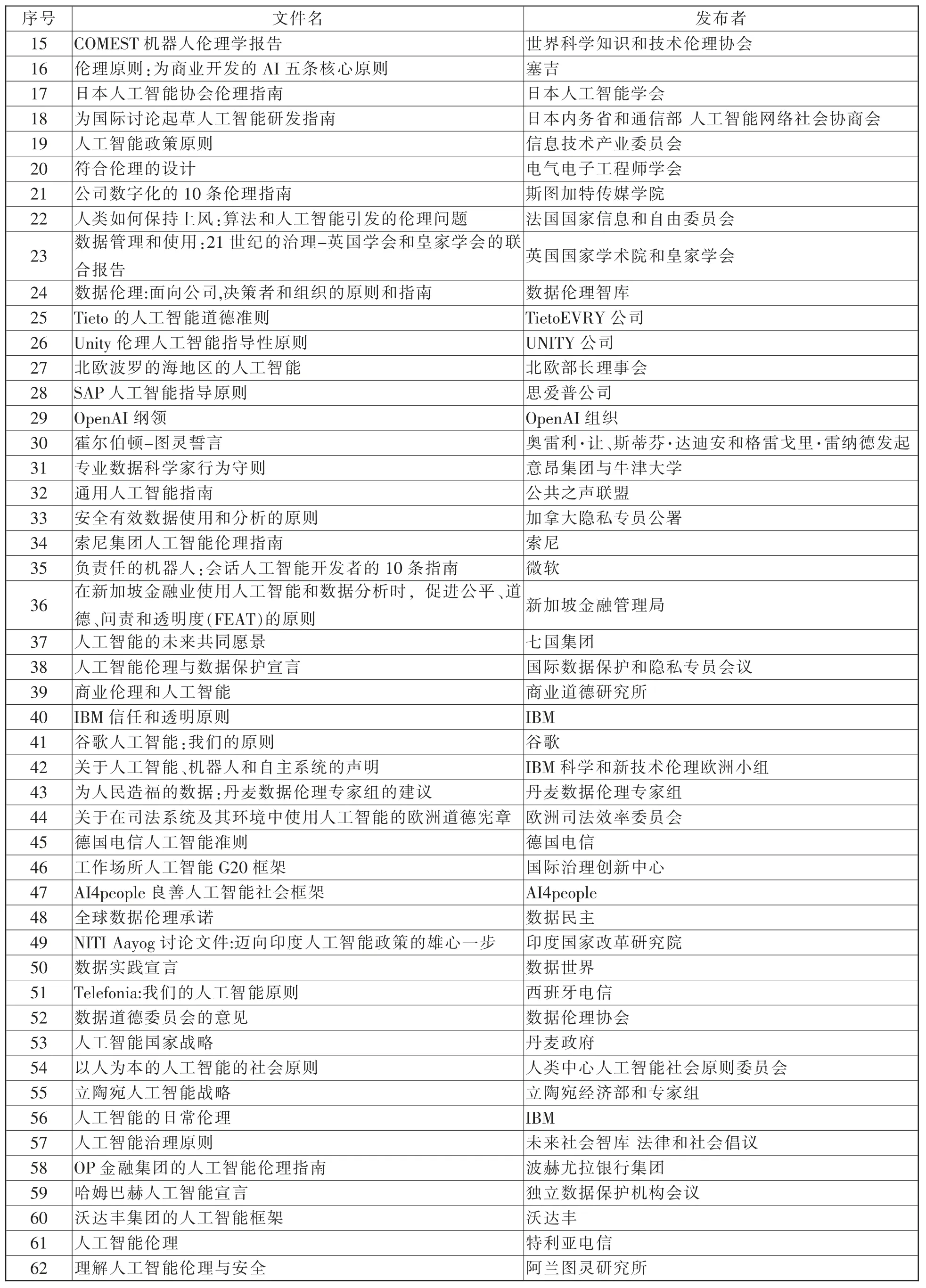

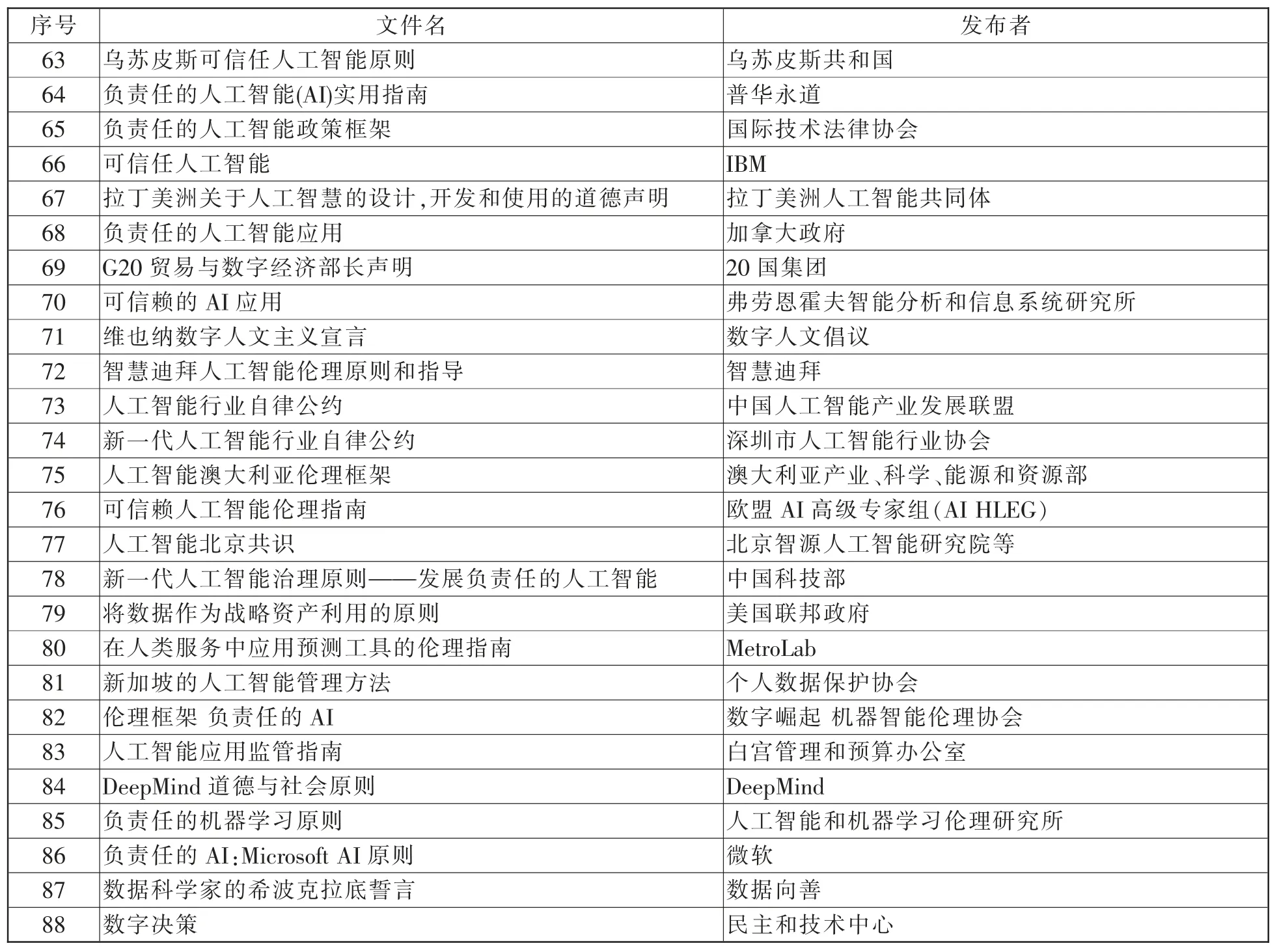

附表 研究涉及的人工智能治理原则文本

注释:

①刘宪权:《人工智能时代机器人行为道德伦理与刑法规制》,《比较法研究》2018 年第4 期。

②彼得·保罗·维贝克:《将技术道德化》,闫宏秀、杨庆峰译,上海交通大学出版社2016 年版,第62 页。

③Bovens M,“Analysing and assessing accountability:A conceptual framework”,European Law Journal,2007,13(4),pp.447~468.

④拉·梅特里:《人是机器》,顾寿观译,商务印书馆1999 年版,第65 页。

⑤⑧Fletcher G,The philosophy of well-being:An introduction,Routledge,2016,p.5,p.95.

⑥Kagan S,“The limits of well-being”,Social Philosophy and Policy,1992,9(2),pp.169~189.

⑦Adler M J,“The dignity of man and the 21st century.”A Speech Delivered to Members of The Commonwealth Club,1952.

⑨⑬Nozick R,Anarchy,state,and utopia,Basic Books,1974,p.1,p.47.

⑩伊曼努尔·康德:《道德形而上学原理》,苗力田译,上海人民出版社1986 年版,第80 页。

⑪Scheffler S,The rejection of consequentialism,Oxford University Press,1994,p.61.

⑫MacAskill W,“Effective altruism:introduction”,Essays in Philosophy,2017,18(1),pp.1~5.

⑭Okun Arthur M,Equality and Efficiency:The Big Tradeoff,Washington,The Brookings Institution,p.117.

⑮Marx Karl,Critique of the Gotha Program;reprinted in Marx-Engels-Werke(MEW)vol.19,Berlin 1978;and in Marx-Engels-Gesamtausgabe(MEGA-B),Berlin 1975,vol.I 25.

⑯⑱约翰·罗尔斯:《正义论》,何怀宏、何包钢、廖申白译,中国社会科学出版社2009 年版,第58~69 页。

⑰高景柱:《德沃金与运气均等主义理论》,《西南大学学报(社会科学版)》2021 年第2 期。

⑲于水、查荣林、帖明:《元治理视域下政府治道逻辑与治理能力提升》,《江苏社会科学》 2014 年第4 期。

⑳Gjaltema J,Biesbroek R,Termeer K,“From government to governance… to meta-governance:a systematic literature review”,Public Management Review,2020,22(12),pp.1760~1780.

㉑Kooiman J,Jentoft S,“Meta-governance:values,norms and principles,and the making of hard choices”,Public administration,2009,87(4),pp.818~836.