基于神经网络和仿真数据的粗糙度分类检测*

易怀安,陆玲莉,舒爱华,路恩会

(1.桂林理工大学a.机械与控制工程学院;b.外国语学院,桂林 541006;2.扬州大学机械工程学院,扬州 225009)

0 引言

表面粗糙度是评定表面质量的一个重要指标。对于接触式表面粗糙度的测量方法主要缺点是测量过程中触控笔可能会划伤工件表面,且该方法不支持在线测量,效率低下[1]。因此基于机器视觉的粗糙度测量方法越来越受到研究者的重视。非接触式测量方法主要包括光学测量,电子测量和机器视觉测量等。其中,机器视觉方法成本低,效率高而广受关注。但是机器视觉的测量方法大多通过人为设计好的评价指标,建立与粗糙度的对应关系,以实现粗糙度的测量[2-5]。人为设计评价指标受限于人的知识水平,达不到自动化测量自提取特征的要求,因而近些年许多学者尝试利用深度学习等方法对粗糙表面进行特征的自动提取。

利用深度学习来预测粗糙度,前人做了大量的工作[6-7]。但是上述基于深度学习的粗糙度测量方法存在着不足:深度卷积神经网络对训练样本的需求量大,单纯通过实际实验建立的粗糙度数据库不够丰富,在缺乏训练数据的情下,训练出较好表现性能的卷积神经网络比较困难。

为弥补训练样本数据不足的问题,利用仿真可得到大量铣削表面图像,但仿真图像与实测图像属于两个不同的域。迁移学习可将某个领域或任务上学习到的知识应用到不同但相关的领域。ZHANG等[8]研究发现随着表面粗糙度的增加,实际图像和模拟图像的红绿混叠效应也随之增加,基于颜色信息设计了混叠区域面积指标,利用迁移学习方法对实际数据和仿真数据进行学习,提高预测的精度。但该方法必须从被红绿色光照射的磨削工件上获得红绿色工件图像,才能通过红绿混叠区域面积指标评估工件的表面粗糙度,这对光源的颜色和亮度都有较为严格的要求,不适用于工业生产中复杂光源环境下的在线视觉检测。与文献[8]类似,铣削表面随着粗糙度的增大,纹理间距呈有规律性的增大,纹理轮廓越来越明显,这种特征在铣削光学仿真图像中也同样体现,因此可以通过迁移学习根据铣削实际图像和光学仿真图像的这些特征加以匹配。

基于上述原因,本文在纹理匹配实验的基础上提出一种采用神经网络结合仿真数据的铣削表面粗糙度分类预测方法。该方法不仅能够弥补数据样本不足的问题,还能对亮度有较好的鲁棒性。

1 纹理匹配模型及预测模型

本节首先介绍边缘提取纹理及匹配过程,然后介绍借助深度迁移学习进行纹理等级分类匹配的Deep CORAL模型的目标函数,结构,以及训练流程,最后介绍铣削表面粗糙度等级预测Xception模型的训练流程。

1.1 边缘提取纹理及匹配过程

由于光学仿真图像和实际图像的差异,直接使用仿真数据训练后的模型对目标域的实际数据进行预测泛化性较差。迁移学习可以将某个领域或任务上学习到的知识应用到不同但相关的领域,能够同时学习仿真域和实际域共有的特征,从而提高目标域的预测精度。因此,本文通过边缘提取Laplace算法来对实际和光学仿真的图像进行纹理提取。当有少量的实际纹理图像时,可将少量实际纹理图像和大量光学仿真纹理图像作为混合域输入到深度迁移学习Deep CORAL模型中进行训练,学习有标签的混合域和无标签的实际域共有的特征,使得来自同一类的特征将更加聚类,最终实现对实际域的匹配精度。实际纹理图像与光学仿真纹理图像如图1所示。

(a) 仿真纹理图像(Ⅰ) (b) 实际纹理图像(Ⅰ) (c) 仿真纹理图像(Ⅱ) (d) 实际纹理图像(Ⅱ)

1.2 用于纹理等级分类匹配的Deep CORAL模型

1.2.1 Deep CORAL网络的目标函数

Deep CORAL网络是在深度神经网络AlexNet[9]中加入改进的CORAL算法[10]。在纹理等级分类匹配任务中,对CORAL算法进行扩展,使用非线性变换,整合到AlexNet的最后一个连接层上,将CORAL的损失直接纳入深层网络中。CORAL是一种简单的无监督自适应方法,它通过调整混合域和实际域数据分布的二阶统计量来最小化领域差异,对实际域和混合域的CORAL 损失优化到最小。描述单个特征层在两个域之间的CORAL损失函数LCORAL被定义为源特征和目标特征的二阶统计特征距离,其表达式为:

(1)

(2)

(3)

式中,1是所有元素均等于1的列向量。

Deep CORAL的目标函数同时包含纹理分类损失和CORAL损失,可表示为:

L=LCLASS+λLCORAL

(4)

式中,λ为用于权衡混合域的分类准确度和实际域上适应性能的一个参数;LCLASS为混合域上的分类损失,按照式(5)计算:

(5)

式中,C为标签类别数;nc为混合域第c个类别的样本数;yi(pi)为第i个混合域样本的真实标签(预测标签)。

1.2.2 Deep CORAL网络的结构

Deep CORAL的结构如图2所示。

图2 基于AlexNet的Deep CORAL

由图可知,该模型将扩展的CORAL算法应用于AlexNet的fc8层,而AlexNet的前7层与普通的AlexNet完全一致。网络最终的目的是要将classification loss和CORAL loss共同优化到最小,即源域的分类更精确,目标域的输出与源域的分布更相似。

1.2.3 Deep CORAL模型的训练流程

在Xception模型中,假设训练集中每一类粗糙度图片的纹理信息非常显著,比如铣削表面的纹理、纹理的宽度、纹理的弧度等,这些信息在模型训练中会被神经网络提取并加以利用,使得模型更加精准、有效[11]。因此,本文首先实现仿真纹理与实际纹理的匹配,然后将仿真图像与实际图像输入到Xception模型中对粗糙度进行预测。

铣削工件纹理等级分类匹配网络整体步骤为:首先将ImageNet数据集通过AlexNet网络进行训练,并整合扩展的CORAL算法,得到预训练模型;其次,将设置好的图像数据输入到预训练好的AlexNet网络进行微调得到纹理等级分类匹配的Deep CORAL模型。Deep CORAL模型主要参数与训练流程如表1和图3所示。

表1 Deep CORAL模型主要参数

图3 Deep CORAL模型训练流程

1.3 基于粗糙度等级预测的Xception模型

基于粗糙度等级预测的Xception网络中的图像特征不需要复杂精准的数学表达,通过大量的样本,网络能学习该数据潜在的映射关系,从而实现特征自提取。模型的主要参数和训练流程如表2和图4所示。

表2 网络主要参数

图4 Xception模型训练流程

2 实验

实验包括铣削样品的制备,图像采集,基于铣削样块边缘提取纹理等级识别匹配的Deep CORAL模型分类和基于粗糙度等级预测的Xception模型分类。

2.1 样块制备

铣削样块的制备包括实际样块的制备和仿真样块的制备。

60×40 mm2的45号钢块铣削样品由FANUC Series Oi Mate-MD型数控机床配合盘形铣刀TAP400R100-32-6T主轴加工而成。用触针式粗糙度测量仪TR210对表面的6个位置采样测量。根据测量结果,本文将粗糙度等级分为6类:(0.4-0.7),[0.7-1),[1-1.4),[1.4-1.8),[1.8-2.2),[2.2-2.6]。

仿真样块是指模拟铣削加工得到的具有不同粗糙度表示的仿真样本实体。数控仿真能够在零件进行加工之前模拟其制造过程,在给定数控程序、加工参数等条件下,得到特定的粗糙度表面,这为分析表面粗糙度提供了一种更有效的方法[12]。本文基于Z-Map算法[13-14]生成铣削表面仿真形貌,构建粗糙度表面成像的仿真模型,获取粗糙度与实际粗糙度相近的仿真图片。生成的仿真表面形貌如图5a所示,仿真表面形貌粗糙度范围从0.3 μm到2.6 μm。最后导入三维建模软件逆向拟合生成虚拟样本实体,如图5b所示。

(a) 仿真表面形貌 (b) 虚拟样本实体

2.2 图像采集

将铣削工件平放于光平台上,并与平台平行;相机的光轴与样块被测面垂直。在实验过程中,样品和光源的相对位置保持不变,相机的位置在离测量平台25 cm处。实验设备如图6所示。

拍摄到的原图尺寸太大,所以将每张铣削工件图像中工件所在区域划分成6个不重叠区域,经过图像预处理后大小均为100×100像素的区域,如图7所示,并按区域进行裁剪后得到6类数据集,每一类数据集都包含72张工件图像,为纹理等级分类匹配与粗糙度分类预测实验建立粗糙度样本数据库。

图6 图像采集装置实物图 图7 剪裁后的铣削工件图像

在图像仿真中,将中生成的虚拟实体样块导入到光学仿真软件tracepro中。该仿真条件包括一个白色光源,并通过Dallmeyer PATENT 3A镜头生成反射图像。仿真实验中成像模型如图8a所示,白色光源设置为1500万条光线。光学仿真图像如图8b所示。

(a) 光学仿真模型图 (b) 光学仿真图像

2.3 Deep CORAL模型纹理等级分类匹配实验

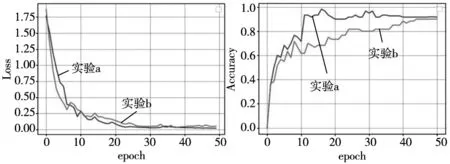

为了验证光学仿真纹理图像与实际纹理图像之间的匹配度,本文设计了以下两个对比实验:

实验a:在制备好的粗糙度样本数据库中,每类随机选择50个图像作为训练集,并提取纹理。在剩余的数据库图像中随机选择50个作为测试集。

实验b:将实验a每类中的40个实际纹理图像换成光学仿真纹理图像,保留10个实际纹理图像,测试集与实验a相同。

2.4 基于粗糙度等级预测的Xception模型分类

深度学习对数据集的数据量有一定的要求,需要将6类铣削工件表面图像(包括实际图像和光学仿真图像)进行数据扩充,然后通过翻转、旋转、调整饱和度、调整对比度、调整色相、平移等方式对图像进行预处理,增强原始数据集。加入仿真数据对分类预测精度的影响由下面3个实验方案进行比较:

实验1:训练集为数据增强后的6类铣削工件表面图像,均是实际拍摄的图像。

实验2:训练集是在实验1基础上加入了光学仿真图像,数据增强后每类实际图像与光学仿真图像比例为2:1。

实验3:在实验2的基础上调整每类实际图像与光学仿真图像比例为1:2。3个实验采用同样的测试集来测试。

实验1~实验3数据增强后样本的分类和数量统计如表3~表5所示。

表3 实验1数据增强后样本的分类和数量统计

表4 实验2数据增强后样本的分类和数量统计

表5 实验3数据增强后样本的分类和数量统计

在粗糙度分类预测Xception模型中,样本集可以划分训练集和验证集。在本次实验中为了均衡训练和验证,将实验1~实验3数据增强后的每类粗糙度图像的训练集和验证集比例设置为8:2。

3 实验结果

3.1 Deep CORAL模型分类结果

根据实验结果,将Deep CORAL模型的损失函数与分类准确率随epoch的变化绘制成如图9所示。

(a) 损失函数曲线 (b) 准确率曲线

可以观察到,实验a和实验b的损失函数在epoch=42后都已基本达到稳定,同时,识别准确率也在一个较小的范围内波动。实验a的准确率为91.665%,实验b的准确率为90%。实验a与实验b的准确率差别不大。在实验b中,加入了大量铣削仿真纹理图片,准确率与实验a相近,这说明了基于深度迁移学习的识别模型提取到了源域混合纹理的图像和目标域实际纹理图像的共同特征,缩小仿真样本与实际样本的特征指标差异。由实验结果可知;铣削图片仿真纹理与实际图片纹理匹配度高。

3.2 Xception模型分类结果

将模型训练和测试保存的数据用Tensorboard可视化工具打开。Xception模型的网络训练损失曲线以及准确率曲线如下,包括训练集和验证集。实验1~实验3的测试集均为没有参与模型训练的111张照片。

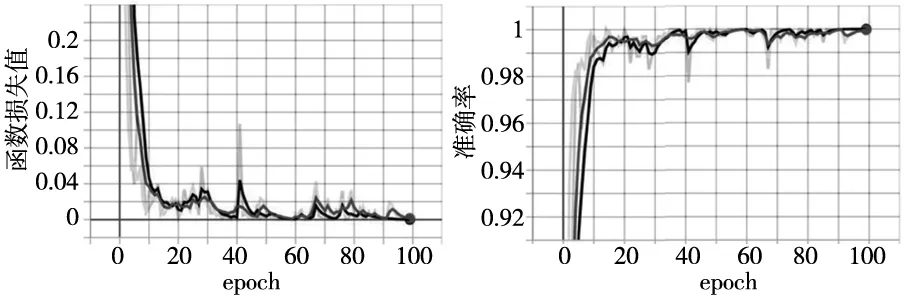

实验1分类结果如图10和表6所示。

图10 实验1Xception模型训练损失函数曲线和准确率曲线

表6 实验1Xception损失函数值和模型准确率

在Xception模型训练过程中,选取迭代次数为100。可以看出,随着迭代次数的增加,粗糙度分类模型的loss曲线整体呈收敛趋势,在第50次迭代之后虽然出现小幅度的波动,但损失值都收敛在0.05以内,这表明本模型已经从铣削样块数据集中学习到了数据特征,模型训练达到预期效果。但网络训练也要结合模型识别正确率,在迭代次数达到50次以后,验证集准确率维持在98%以上,说明模型已经具备有效的分类能力。在进行测试集测试时,准确率达到86.48%。

实验2分类结果如图11和表7所示。

图11 实验2Xception模型训练损失函数曲线和准确率曲线

表7 实验2Xception模型损失函数值和准确率

可以看出,在43次迭代之后模型损失值都收敛在0.04,本模型也已经从铣削样块数据集中学习到了数据特征,验证集准确率维持在99%,同样说明模型已经具备有效的分类能力。在进行测试集测试时,准确率达到92.79%。

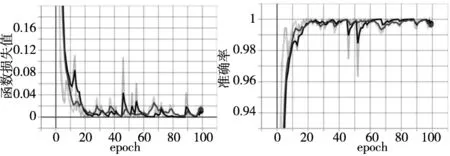

实验3分类结果如图12和表8所示。

图12 实验3Xception模型训练损失函数曲线和准确率曲线

表8 实验3Xception模型损失函数值和准确率

可以看出,在69次迭代之后,模型损失值都收敛在0.03以内,验证集准确率维持99%。在进行测试集测试时,准确率达到92.79%。

4 讨论

基于粗糙度等级预测的Xception模型中,可以从输入的二维图片像素中提取图像的高低频特征,如图像的纹理、颜色等底层细节特征,并在更深层结构中提取一般性的、组合性的特征,整个过程中对目标的特征提取更有针对性。本文分别改变Xception模型训练集的亮度,颜色,纹理,以此来研究哪个因素对于深度卷积神经网络的影响最大。

4.1 亮度与颜色

本文分别改变3.2节实验中训练集的亮度与颜色,来研究亮度与颜色对于Xception模型的影响。改变亮度与颜色之后Xception模型训练损失曲线和准确率曲线如图13和图14所示,损失函数值和准确率如表9和表10所示,包括训练集和验证集。在进行测试集测试时,准确率分别为93.69%,88.28%。

图13 改变亮度之后Xception模型训练损失函数曲线和准确率曲线

图14 改变颜色之后Xception模型训练损失函数曲线和准确率曲线

表9 改变亮度之后Xception模型损失函数值和准确率

表10 改变颜色之后Xception模型损失函数值和准确率

从实验结果可知,从实验结果可知,Xception模型对亮度和颜色具有较好的鲁棒性,证明了文献[11]深度卷积神经网络Xception模型对光源环境鲁棒性的结论,但是Xception模型对颜色信息比亮度较敏感。

4.2 纹理

随着进给速度的增大,铣削纹理间距呈有规律性的增大,纹理轮廓越来越明显。所以在6类粗糙度等级中,铣削表面的纹理特征差异明显。针对这一规律,改变每一类中仿真图片的弧度,但粗糙度的范围仍保持一致。最后将改变的仿真图像的训练集导入到Xception模型进行训练。通过测试结果来研究纹理对于Xception模型的影响。改变仿真纹理之后,Xception模型训练损失函数曲线和准确率曲线如图15所示,损失函数值和准确率如表11所示。在进行测试集测试时,准确率为72.07%。

综上所述,在Xception模型中,纹理对模型预测准确率影响最大,其次是颜色,而对亮度有很好的鲁棒性。3大因素的影响比例如表11所示。

图15 改变纹理之后Xception模型训练损失函数曲线和准确率曲线

表11 改变颜色之后Xception模型损失函数值和准确率

5 结论

(1)基于深度迁移学习的铣削样块纹理等级分类匹配Deep CORAL模型,该模型可以实现铣削仿真纹理与实际纹理的匹配,为粗糙度分类扩充数据集数量做了铺垫。

(2)针对在样本图像较少不能建立较好的预测模型的情况下,加入的仿真图片可以扩充数据量,使模型提取到更多跟粗糙度相关的特征,提高准确率。

(3)在Xception模型的中,纹理对模型预测准确率影响最大,其次是颜色,而对亮度的鲁棒性最好。